基于weka的数据分类分析实验报告

weka实验报告总结

weka实验报告总结

Weka是一款非常流行的机器学习和数据挖掘工具,用于实现各

种数据分析任务。

下面是对Weka实验报告的总结:

在本次实验中,我们使用Weka工具进行了一系列的数据挖掘和

机器学习实验。

我们首先对数据集进行了探索性数据分析,包括数

据的统计特征、缺失值处理、异常值检测等。

通过这些分析,我们

对数据集的特点有了更全面的了解,并为后续的实验做好了准备。

接下来,我们使用Weka提供的各种机器学习算法进行了模型的

训练和评估。

我们尝试了多种算法,包括决策树、支持向量机、朴

素贝叶斯等。

通过对比不同算法在训练集和测试集上的表现,我们

评估了它们的性能,并选择了最合适的算法作为我们的模型。

在模型训练过程中,我们还进行了特征选择和特征工程的实验。

通过选择最相关的特征或者提取新的特征,我们尝试提高模型的性

能和泛化能力。

同时,我们还使用交叉验证等方法来评估模型的稳

定性和鲁棒性。

最后,我们对模型进行了性能评估和结果分析。

通过计算准确

率、召回率、F1值等指标,我们评估了模型的分类效果。

同时,我们还进行了误差分析,找出模型在分类错误的样本上的共同特征,以便进一步改进模型。

综上所述,本次实验中我们使用Weka工具进行了一系列的数据挖掘和机器学习实验。

通过探索性数据分析、模型训练和评估、特征选择和工程,以及性能评估和结果分析,我们得到了一个具有较好性能的模型,并对数据集有了更深入的理解。

这些实验为我们进一步研究和应用机器学习提供了有益的经验和启示。

基于weka的数据分类和聚类分析实验报告.docx

基于w e k a的数据分类分析实验报告1实验基本内容本实验的基本内容是通过使用weka 中的三种常见分类和聚类方法(决策树J48、KNN 和 k-means)分别在训练数据上训练出分类模型,并使用校验数据对各个模型进行测试和评价,找出各个模型最优的参数值,并对三个模型进行全面评价比较,得到一个最好的分类模型以及该模型所有设置的最优参数。

最后使用这些参数以及训练集和校验集数据一起构造出一个最优分类器,并利用该分类器对测试数据进行预测。

2数据的准备及预处理2.1 格式转换方法(1)打开“data02.xls ”另存为 CSV 类型,得到“ data02.csv”。

(2)在 WEKA 中提供了一个“ Arff Viewer ”模块,打开一个“ data02.csv”进行浏览,然后另存为ARFF 文件,得到“data02.arff”。

3.实验过程及结果截图3.1 决策树分类(1)决策树分类用“ Explorer ”打开数据“ data02.arff”,然后切换到“Classify”。

点击“ Choose”,选择算法“ trees-J48 ”,再在“ Test options ”选择“ Cross-validation ( Flods=10 )”,点击“ Start ”,开始运行。

系统默认 trees-J48决策树算法中minNumObj=2,得到如下结果=== Summary ===Correctly Classified Instances2388.4615 %Incorrectly Classified Instances311.5385 %Kappa statistic0.7636Mean absolute error0.141Root mean squared error0.3255Relative absolute error30.7368 %Root relative squared error68.0307 %Total Number of Instances26=== Detailed Accuracy By Class ===TP Rate FP Rate Precision Recall F-Measure ROC Area Class0.824010.8240.9030.892N10.1760.7510.8570.892Y Weighted Avg.0.8850.0610.9130.8850.8870.892=== Confusion Matrix ===a b<-- classified as14 3 | a = N09 | b = Y使用不同的参数准确率比较:minNumObj2345Correctly23222323 Classified( 88.4615 %)( 84.6154 %)( 88.4615 %)( 88.4615 %)Instances由上表,可知minNumObj为 2 时,准确率最高。

weka实验报告

weka实验报告

Weka实验报告

Weka是一款流行的数据挖掘工具,它提供了丰富的机器学习算法和数据预处

理工具,使得数据分析和模型建立变得更加简单和高效。

在本次实验中,我们

将使用Weka工具进行数据分析和模型建立,以探索其在实际应用中的效果和

性能。

实验数据集选取了UCI机器学习库中的经典数据集“鸢尾花数据集”,该数据集

包含了150个样本,每个样本包括了4个特征和一个类别标签。

我们首先使用Weka进行数据预处理,包括缺失值处理、特征选择和数据变换等步骤,以保

证数据的质量和可用性。

接着,我们选择了几种常用的机器学习算法,包括决策树、支持向量机和K近

邻等,使用Weka进行模型建立和性能评估。

通过交叉验证和ROC曲线等方法,我们评估了不同算法在该数据集上的分类性能,并比较它们的准确度、召回率

和F1值等指标,以找出最适合该数据集的模型。

实验结果显示,Weka工具在数据预处理和模型建立方面表现出色,能够快速

高效地完成数据分析任务。

在鸢尾花数据集上,我们发现决策树算法和支持向

量机算法表现较好,能够达到较高的分类准确度和稳定性,而K近邻算法的性

能相对较差。

总的来说,Weka作为一款优秀的数据挖掘工具,具有丰富的功能和易用的界面,能够帮助用户快速建立和评估机器学习模型。

通过本次实验,我们对

Weka的性能和效果有了更深入的了解,相信它将在未来的数据分析工作中发

挥重要作用。

数据挖掘实验报告Weka的数据聚类分析

甘肃政法学院本科生实验报告(2)姓名:学院:计算机科学学院专业:信息管理与信息系统班级:实验课程名称:数据挖掘实验日期:指导教师及职称:实验成绩:开课时间:2013—2014 学年一学期甘肃政法学院实验管理中心印制二.实验环境Win 7环境下的Eclipse三、实验内容在WEKA中实现K均值的算法,观察实验结果并进行分析。

四、实验过程与分析一、实验过程1、添加数据文件打开Weka的Explore,使用Open file点击打开本次实验所要使用的raff格式数据文件“auto93.raff”2、选择算法类型点击Cluster中的Choose,选择本次实验所要使用的算法类型“SimpleKMeans”3、得出实验结果选中“Cluster Mode”的“Use training set”,点击“Start”按钮,观察右边“Clusterer output”给出的聚类结果如下:=== Run information ===Scheme: weka.clusterers.SimpleKMeans -N 2 -S 10Relation: sInstances: 93Attributes: 23ManufacturerTypeCity_MPGHighway_MPGAir_Bags_standardDrive_train_typeNumber_of_cylindersEngine_sizeHorsepowerRPMEngine_revolutions_per_mile5528.8462 2622.3077 1 15.1346 4.7115 174.8654 100.2692 67.0385 36.8462 26.891 12.6069 2722.3077 0 16.4019Std Devs: N/A N/A 6.0746 5.7467 N/A N/A 0.7301 0.5047 40.8149 484.7019 377.1753 N/A 3.0204 0.848 11.2599 5.5735 2.4968 2.338 2.7753 2.3975 492.4971 N/A 7.9863Clustered Instances0 41 ( 44%)52 ( 56%)4、修改Seed值5、得出修改Seed值后的实验结果=== Run information ===Scheme: weka.clusterers.SimpleKMeans -N 2 -S 8Relation: sInstances: 93Attributes: 23ManufacturerTypeCity_MPGHighway_MPG二、实验分析本次实验采用的数据文件是“1993NewCarData ”。

数据挖掘WEKA实验报告2

数据挖掘-WEKA

实验报告二

姓名及学号:杨珍20131198

班级:卓越计科1301

指导老师:吴珏老师

一、实验内容

1、分类算法:(掌握weka中分类算法的使用)

1)掌握决策树分类算法(C4.5,CART算法)

2)打开数据集weahter.nominal.arrf,使用C4.5分类器(C4.5算法在Weka 中是作为一个分类器来实现的,名称为J48)构建决策树。

3)对结果进行分析。

4)使用贝叶斯网络编辑器编辑贝叶斯网络。

(选做)

二、实验步骤

(1)打开数据集weahter.nominal.arrf

(2)采用J48构建决策树

J48的结果

J48的在窗口的可视化:

J48的决策树可视化结果:

(3)采用FilterClassifier构建决策树

FilterClassifier的数据结果

(4)使用贝叶斯

贝叶斯的可视化结果:

思考与分析

使用FilterClassifier和J48,并采用有监督的二元离散化,与只使用J48处理原始数据的结果想比较。

为何从离散化后的数据构建决策树,比直接从原始数据构建决策树,有更好的预测效果?

(1)算法需要,例如决策树,NativeBayes等算法本身不能直接使用连续型变量,连续型数据只有经过离散化处理后才能进入算法引擎。

(2)离散化可以有效地克服数据中隐藏的缺陷,是模型更加稳定。

(3)有利于对非线性数据关系进行诊断和描述:对连续型数据进行离散化后,自变量和目标变量之间的关系变得清晰化。

数据挖掘WEKA实验报告

数据挖掘-WAKA实验报告一、WEKA软件简介在我所从事的证券行业中,存在着海量的信息和数据,但是这些数据日常知识发挥了一小部分的作用,其包含了大量的隐性的信息并不为所用,但是却可以为一些公司的决策和对客户的服务提供不小的价值。

因此,我们可以通过一些数据采集、数据挖掘来获得潜在的有价值的信息。

数据挖掘就是通过分析存在于数据库里的数据来解决问题。

在数据挖掘中计算机以电子化的形式存储数据,并且能自动的查询数据,通过关联规则、分类于回归、聚类分析等算法对数据进行一系列的处理,寻找和描述数据里的结构模式,进而挖掘出潜在的有用的信息。

数据挖掘就是通过分析存在于数据库里的数据来解决问题。

WEKA的出现让我们把数据挖掘无需编程即可轻松搞定。

WEKA是由新西兰怀卡托大学开发的开源项目,全名是怀卡托智能分析环境(WaikatoEnvironmentforKnowledgeAnalysis)。

WEKA是由JAVA编写的,WEKA得到,并且限制在GBU通用公众证书的条件下发布,可以运行在所有的操作系统中。

是一款免费的,非商业化的机器学习以及数据挖掘软件WEKA作为一个公开的数据挖掘工作平台,集合了大量能承担数据挖掘任务的机器学习算法,包括对数据进行预处理,分类,回归、聚类、关联规则以及在新的交互式界面上的可视化。

如果想自己实现数据挖掘算法的话,可以看一看WEKA的接口文档。

在WEKA中集成自己的算法甚至借鉴它的方法自己实现可视化工具并不是件很困难的事情。

安装WEKA也十分简单,首相要下载安装JDK环境,JDK在这个页面可以找到它的下载。

点击JDK6之后的Download按钮,转到下载页面。

选择Accepct,过一会儿页面会刷新。

我们需要的是这个WindowsOfflineInstallation,Multi-languagejdk-6-windows-i586.exe5 3.16MB,点击它下载。

也可以右键点击它上面的链接,在Flashget等工具中下载。

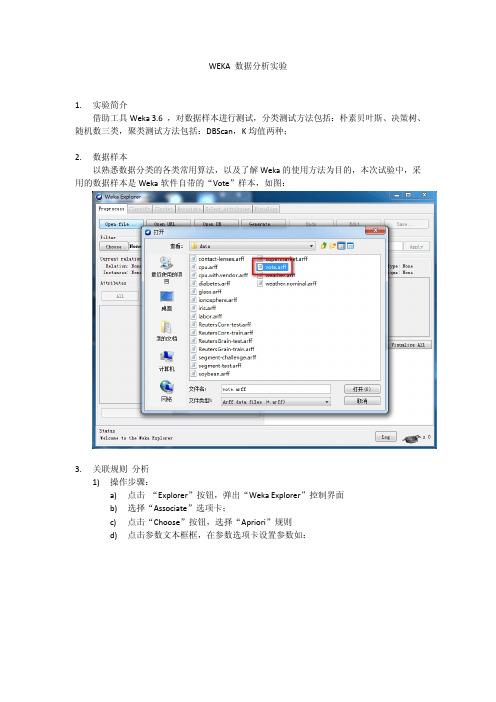

WEKA数据分析实验

WEKA 数据分析实验1.实验简介借助工具Weka 3.6 ,对数据样本进行测试,分类测试方法包括:朴素贝叶斯、决策树、随机数三类,聚类测试方法包括:DBScan,K均值两种;2.数据样本以熟悉数据分类的各类常用算法,以及了解Weka的使用方法为目的,本次试验中,采用的数据样本是Weka软件自带的“Vote”样本,如图:3.关联规则分析1)操作步骤:a)点击“Explorer”按钮,弹出“Weka Explorer”控制界面b)选择“Associate”选项卡;c)点击“Choose”按钮,选择“Apriori”规则d)点击参数文本框框,在参数选项卡设置参数如:e)点击左侧“Start”按钮2)执行结果:=== Run information ===Scheme: weka.associations.Apriori -I -N 10 -T 0 -C 0.9 -D 0.05 -U 1.0 -M 0.5 -S -1.0 -c -1 Relation: voteInstances: 435Attributes: 17handicapped-infantswater-project-cost-sharingadoption-of-the-budget-resolutionphysician-fee-freezeel-salvador-aidreligious-groups-in-schoolsanti-satellite-test-banaid-to-nicaraguan-contrasmx-missileimmigrationsynfuels-corporation-cutbackeducation-spendingsuperfund-right-to-suecrimeduty-free-exportsexport-administration-act-south-africaClass=== Associator model (full training set) ===Apriori=======Minimum support: 0.5 (218 instances)Minimum metric <confidence>: 0.9Number of cycles performed: 10Generated sets of large itemsets:Size of set of large itemsets L(1): 12Large Itemsets L(1):handicapped-infants=n 236adoption-of-the-budget-resolution=y 253physician-fee-freeze=n 247religious-groups-in-schools=y 272anti-satellite-test-ban=y 239aid-to-nicaraguan-contras=y 242synfuels-corporation-cutback=n 264education-spending=n 233crime=y 248duty-free-exports=n 233export-administration-act-south-africa=y 269Class=democrat 267Size of set of large itemsets L(2): 4Large Itemsets L(2):adoption-of-the-budget-resolution=y physician-fee-freeze=n 219adoption-of-the-budget-resolution=y Class=democrat 231physician-fee-freeze=n Class=democrat 245aid-to-nicaraguan-contras=y Class=democrat 218Size of set of large itemsets L(3): 1Large Itemsets L(3):adoption-of-the-budget-resolution=y physician-fee-freeze=n Class=democrat 219Best rules found:1. adoption-of-the-budget-resolution=y physician-fee-freeze=n 219 ==> Class=democrat 219 conf:(1)2. physician-fee-freeze=n 247 ==> Class=democrat 245 conf:(0.99)3. adoption-of-the-budget-resolution=y Class=democrat 231 ==> physician-fee-freeze=n 219 conf:(0.95)4. Class=democrat 267 ==> physician-fee-freeze=n 245 conf:(0.92)5. adoption-of-the-budget-resolution=y 253 ==> Class=democrat 231 conf:(0.91)6. aid-to-nicaraguan-contras=y 242 ==> Class=democrat 218 conf:(0.9)3)结果分析:a)该样本数据,数据记录数435个,17个属性,进行了10轮测试b)最小支持度为0.5,即至少需要218个实例;c)最小置信度为0.9;d)进行了10轮搜索,频繁1项集12个,频繁2项集4个,频繁3项集1个;4.分类算法-随机树分析1)操作步骤:a)点击“Explorer”按钮,弹出“Weka Explorer”控制界面b)选择“Classify ”选项卡;c)点击“Choose”按钮,选择“trees” “RandomTree”规则d)设置Cross-validation 为10次e)点击左侧“Start”按钮2)执行结果:=== Run information ===Scheme:weka.classifiers.trees.RandomTree -K 0 -M 1.0 -S 1Relation: voteInstances:435Attributes:17handicapped-infantswater-project-cost-sharingadoption-of-the-budget-resolutionphysician-fee-freezeel-salvador-aidreligious-groups-in-schoolsanti-satellite-test-banaid-to-nicaraguan-contrasmx-missileimmigrationsynfuels-corporation-cutbackeducation-spendingsuperfund-right-to-suecrimeduty-free-exportsexport-administration-act-south-africaClassTest mode:10-fold cross-validation=== Classifier model (full training set) ===RandomTree==========el-salvador-aid = n| physician-fee-freeze = n| | duty-free-exports = n| | | anti-satellite-test-ban = n| | | | synfuels-corporation-cutback = n| | | | | crime = n : republican (0.96/0)| | | | | crime = y| | | | | | handicapped-infants = n : democrat (2.02/0.01) | | | | | | handicapped-infants = y : democrat (0.05/0)| | | | synfuels-corporation-cutback = y| | | | | handicapped-infants = n : democrat (0.79/0.01)| | | | | handicapped-infants = y : democrat (2.12/0)| | | anti-satellite-test-ban = y| | | | adoption-of-the-budget-resolution = n| | | | | handicapped-infants = n : democrat (1.26/0.01)| | | | | handicapped-infants = y : republican (1.25/0.25)| | | | adoption-of-the-budget-resolution = y| | | | | handicapped-infants = n| | | | | | crime = n : democrat (5.94/0.01)| | | | | | crime = y : democrat (5.15/0.12)| | | | | handicapped-infants = y : democrat (36.99/0.09)| | duty-free-exports = y| | | crime = n : democrat (124.23/0.29)| | | crime = y| | | | handicapped-infants = n : democrat (16.9/0.38)| | | | handicapped-infants = y : democrat (8.99/0.02)| physician-fee-freeze = y| | immigration = n| | | education-spending = n| | | | crime = n : democrat (1.09/0)| | | | crime = y : democrat (1.01/0.01)| | | education-spending = y : republican (1.06/0.02)| | immigration = y| | | synfuels-corporation-cutback = n| | | | religious-groups-in-schools = n : republican (3.02/0.01)| | | | religious-groups-in-schools = y : republican (1.54/0.04)| | | synfuels-corporation-cutback = y : republican (1.06/0.05)el-salvador-aid = y| synfuels-corporation-cutback = n| | physician-fee-freeze = n| | | handicapped-infants = n| | | | superfund-right-to-sue = n| | | | | crime = n : democrat (1.36/0)| | | | | crime = y| | | | | | mx-missile = n : republican (1.01/0)| | | | | | mx-missile = y : democrat (1.01/0.01)| | | | superfund-right-to-sue = y : democrat (4.83/0.03)| | | handicapped-infants = y : democrat (8.42/0.02)| | physician-fee-freeze = y| | | adoption-of-the-budget-resolution = n| | | | export-administration-act-south-africa = n| | | | | mx-missile = n : republican (49.03/0)| | | | | mx-missile = y : democrat (0.11/0)| | | | export-administration-act-south-africa = y| | | | | duty-free-exports = n| | | | | | mx-missile = n : republican (60.67/0)| | | | | | mx-missile = y : republican (6.21/0.15)| | | | | duty-free-exports = y| | | | | | aid-to-nicaraguan-contras = n| | | | | | | water-project-cost-sharing = n| | | | | | | | mx-missile = n : republican (3.12/0)| | | | | | | | mx-missile = y : democrat (0.01/0)| | | | | | | water-project-cost-sharing = y : democrat (1.15/0.14) | | | | | | aid-to-nicaraguan-contras = y : republican (0.16/0)| | | adoption-of-the-budget-resolution = y| | | | anti-satellite-test-ban = n| | | | | immigration = n : democrat (2.01/0.01)| | | | | immigration = y| | | | | | water-project-cost-sharing = n| | | | | | | mx-missile = n : republican (1.63/0)| | | | | | | mx-missile = y : republican (1.01/0.01)| | | | | | water-project-cost-sharing = y| | | | | | | superfund-right-to-sue = n : republican (0.45/0)| | | | | | | superfund-right-to-sue = y : republican (1.71/0.64) | | | | anti-satellite-test-ban = y| | | | | mx-missile = n : republican (7.74/0)| | | | | mx-missile = y : republican (4.05/0.03)| synfuels-corporation-cutback = y| | adoption-of-the-budget-resolution = n| | | superfund-right-to-sue = n| | | | anti-satellite-test-ban = n| | | | | physician-fee-freeze = n : democrat (1.39/0.01)| | | | | physician-fee-freeze = y| | | | | | water-project-cost-sharing = n : republican (1.01/0)| | | | | | water-project-cost-sharing = y : democrat (1.05/0.05)| | | | anti-satellite-test-ban = y : democrat (1.13/0.01)| | | superfund-right-to-sue = y| | | | education-spending = n| | | | | physician-fee-freeze = n| | | | | | crime = n : democrat (0.09/0)| | | | | | crime = y| | | | | | | handicapped-infants = n : democrat (1.01/0.01)| | | | | | | handicapped-infants = y : democrat (1/0)| | | | | physician-fee-freeze = y| | | | | | immigration = n| | | | | | | export-administration-act-south-africa = n : democrat(0.34/0.11)| | | | | | | export-administration-act-south-africa = y| | | | | | | | crime = n : democrat (0.16/0)| | | | | | | | crime = y| | | | | | | | | mx-missile = n| | | | | | | | | | handicapped-infants = n : republican (0.29/0) | | | | | | | | | | handicapped-infants = y : republican (1.88/0.87) | | | | | | | | | mx-missile = y : democrat (0.01/0)| | | | | | immigration = y : republican (1.01/0)| | | | education-spending = y| | | | | physician-fee-freeze = n| | | | | | handicapped-infants = n : democrat (1.51/0.01)| | | | | | handicapped-infants = y : democrat (2.01/0)| | | | | physician-fee-freeze = y| | | | | | crime = n : republican (1.02/0)| | | | | | crime = y| | | | | | | export-administration-act-south-africa = n| | | | | | | | handicapped-infants = n| | | | | | | | | immigration = n| | | | | | | | | | mx-missile = n| | | | | | | | | | | water-project-cost-sharing = n : democrat (1.01/0.01)| | | | | | | | | | | water-project-cost-sharing = y : republican (1.81/0)| | | | | | | | | | mx-missile = y : democrat (0.01/0)| | | | | | | | | immigration = y| | | | | | | | | | mx-missile = n : republican (2.78/0)| | | | | | | | | | mx-missile = y : democrat (0.01/0)| | | | | | | | handicapped-infants = y| | | | | | | | | mx-missile = n : republican (2/0)| | | | | | | | | mx-missile = y : democrat (0.4/0)| | | | | | | export-administration-act-south-africa = y| | | | | | | | mx-missile = n : republican (8.77/0)| | | | | | | | mx-missile = y : democrat (0.02/0)| | adoption-of-the-budget-resolution = y| | | anti-satellite-test-ban = n| | | | handicapped-infants = n| | | | | crime = n : democrat (2.52/0.01)| | | | | crime = y : democrat (7.65/0.07)| | | | handicapped-infants = y : democrat (10.83/0.02)| | | anti-satellite-test-ban = y| | | | physician-fee-freeze = n| | | | | handicapped-infants = n| | | | | | crime = n : democrat (2.42/0.01)| | | | | | crime = y : democrat (2.28/0.03)| | | | | handicapped-infants = y : democrat (4.17/0.01)| | | | physician-fee-freeze = y| | | | | mx-missile = n : republican (2.3/0)| | | | | mx-missile = y : democrat (0.01/0)Size of the tree : 143Time taken to build model: 0.01seconds=== Stratified cross-validation ====== Summary ===Correctly Classified Instances 407 93.5632 %Incorrectly Classified Instances 28 6.4368 %Kappa statistic 0.8636Mean absolute error 0.0699Root mean squared error 0.2379Relative absolute error 14.7341 %Root relative squared error 48.8605 %Total Number of Instances 435=== Detailed Accuracy By Class ===TP Rate FP Rate Precision Recall F-Measure ROC Area Class0.955 0.095 0.941 0.955 0.948 0.966 democrat0.905 0.045 0.927 0.905 0.916 0.967 republicanWeighted Avg. 0.936 0.076 0.936 0.936 0.935 0.966 === Confusion Matrix ===a b <-- classified as255 12 | a = democrat16 152 | b = republican3)结果分析:a)该样本数据,数据记录数435个,17个属性,进行了10轮交叉验证b)随机树长143c)正确分类共407个,正确率达93.5632 %d)错误分类28个,错误率6.4368 %e)测试数据的正确率较好5.分类算法-随机树分析1)操作步骤:a)点击“Explorer”按钮,弹出“Weka Explorer”控制界面b)选择“Classify ”选项卡;c)点击“Choose”按钮,选择“trees” “J48”规则d)设置Cross-validation 为10次e)点击左侧“Start”按钮2)执行结果:=== Run information ===Scheme:weka.classifiers.trees.J48 -C 0.25 -M 2Relation: voteInstances:435Attributes:17handicapped-infantswater-project-cost-sharingadoption-of-the-budget-resolutionphysician-fee-freezeel-salvador-aidreligious-groups-in-schoolsanti-satellite-test-banaid-to-nicaraguan-contrasmx-missileimmigrationsynfuels-corporation-cutbackeducation-spendingsuperfund-right-to-suecrimeduty-free-exportsexport-administration-act-south-africaClassTest mode:10-fold cross-validation=== Classifier model (full training set) ===J48 pruned tree------------------physician-fee-freeze = n: democrat (253.41/3.75)physician-fee-freeze = y| synfuels-corporation-cutback = n: republican (145.71/4.0)| synfuels-corporation-cutback = y| | mx-missile = n| | | adoption-of-the-budget-resolution = n: republican (22.61/3.32) | | | adoption-of-the-budget-resolution = y| | | | anti-satellite-test-ban = n: democrat (5.04/0.02)| | | | anti-satellite-test-ban = y: republican (2.21)| | mx-missile = y: democrat (6.03/1.03)Number of Leaves : 6Size of the tree : 11Time taken to build model: 0.06seconds=== Stratified cross-validation ====== Summary ===Correctly Classified Instances 419 96.3218 % Incorrectly Classified Instances 16 3.6782 % Kappa statistic 0.9224Mean absolute error 0.0611Root mean squared error 0.1748Relative absolute error 12.887 %Root relative squared error 35.9085 %Total Number of Instances 435=== Detailed Accuracy By Class ===TP Rate FP Rate Precision Recall F-Measure ROC Area Class0.97 0.048 0.97 0.97 0.97 0.971 democrat0.952 0.03 0.952 0.952 0.952 0.971 republicanWeighted Avg. 0.963 0.041 0.963 0.963 0.963 0.971=== Confusion Matrix ===a b <-- classified as259 8 | a = democrat8 160 | b = republican3)结果分析:a)该样本数据,数据记录数435个,17个属性,进行了10轮交叉验证b)决策树分6级,长度11c)正确分类共419个,正确率达96.3218 %d)错误分类16个,错误率3.6782 %e)测试结果接近随机数,正确率较高6.分类算法-朴素贝叶斯分析1)操作步骤:a)点击“Explorer”按钮,弹出“Weka Explorer”控制界面b)选择“Classify ”选项卡;c)点击“Choose”按钮,选择“bayes” “Naive Bayes”规则d)设置Cross-validation 为10次e)点击左侧“Start”按钮2)执行结果:=== Stratified cross-validation ====== Summary ===Correctly Classified Instances 392 90.1149 %Incorrectly Classified Instances 43 9.8851 %Kappa statistic 0.7949Mean absolute error 0.0995Root mean squared error 0.2977Relative absolute error 20.9815 %Root relative squared error 61.1406 %Total Number of Instances 435=== Detailed Accuracy By Class ===TP Rate FP Rate Precision Recall F-Measure ROC Area Class0.891 0.083 0.944 0.891 0.917 0.973democrat0.917 0.109 0.842 0.917 0.877 0.973republicanWeighted Avg. 0.901 0.093 0.905 0.901 0.902 0.973 === Confusion Matrix ===a b <-- classified as238 29 | a = democrat14 154 | b = republican3)结果分析a)该样本数据,数据记录数435个,17个属性,进行了10轮交叉验证b)正确分类共392个,正确率达90.1149 %c)错误分类43个,错误率9.8851 %d)测试正确率较高7.分类算法-RandomTree、决策树、朴素贝叶斯结果比较:RandomTree 决策树朴素贝叶斯正确率93.5632% 96.3218 % 90.1149 %混淆矩阵 a b <-- classified as255 12 | a = democrat16 152 | b = republican a b <-- classified as259 8 | a = democrat8 160 | b = republicana b <-- classified as238 29 | a = democrat14 154 | b =republican标准误差48.8605 % 35.9085 % 61.1406 % 根据以上对照结果,三类分类算法对样板数据Vote测试准确率类似;8.。

数据挖掘WEKA实验报告

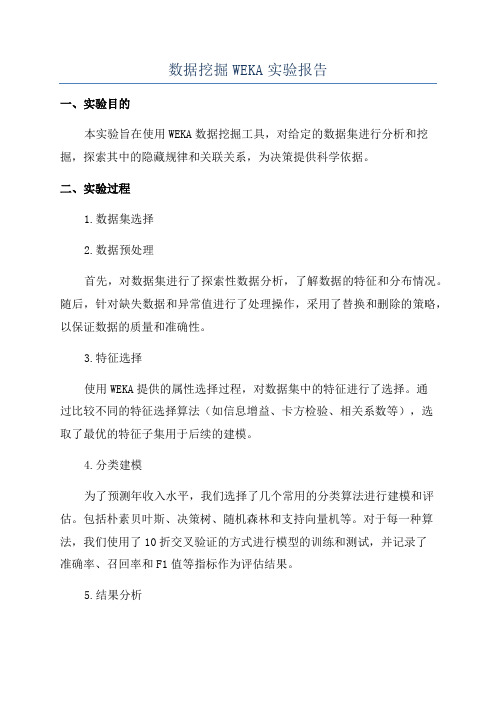

数据挖掘WEKA实验报告一、实验目的本实验旨在使用WEKA数据挖掘工具,对给定的数据集进行分析和挖掘,探索其中的隐藏规律和关联关系,为决策提供科学依据。

二、实验过程1.数据集选择2.数据预处理首先,对数据集进行了探索性数据分析,了解数据的特征和分布情况。

随后,针对缺失数据和异常值进行了处理操作,采用了替换和删除的策略,以保证数据的质量和准确性。

3.特征选择使用WEKA提供的属性选择过程,对数据集中的特征进行了选择。

通过比较不同的特征选择算法(如信息增益、卡方检验、相关系数等),选取了最优的特征子集用于后续的建模。

4.分类建模为了预测年收入水平,我们选择了几个常用的分类算法进行建模和评估。

包括朴素贝叶斯、决策树、随机森林和支持向量机等。

对于每一种算法,我们使用了10折交叉验证的方式进行模型的训练和测试,并记录了准确率、召回率和F1值等指标作为评估结果。

5.结果分析通过比较不同算法的评估结果,我们发现随机森林算法在该数据集上的表现最好,准确率达到了80%以上。

决策树和朴素贝叶斯算法也有不错的表现,分别达到了75%和70%的准确率。

而支持向量机算法的准确率相对较低,仅为60%左右。

三、实验总结通过本次实验,我们学习并掌握了使用WEKA工具进行数据挖掘的基本操作和流程。

通过数据预处理、特征选择和分类建模等步骤,我们成功地对给定的数据集进行了分析和挖掘,并得到了有意义的结果。

但是需要注意的是,数据挖掘并非一种万能的解决方案,其结果也往往受到多个因素的影响。

因此,在实际应用中,我们需要根据具体情况选择合适的算法和方法,并对结果进行合理的解释和评估。

综上所述,本次实验为我们提供了一个良好的实践机会,帮助我们理解和掌握数据挖掘的基本理论和技术,为今后的科学研究和决策提供了有力的支持。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

基于weka的数据分类分析实验报告

姓名:陈诺言学号:0483

1实验基本内容

本实验的基本内容是通过使用weka中的三种常见分类方法(朴素贝叶斯,KNN和决策树)分别在训练数据上训练出分类模型,并使用校验数据对各个模型进行测试和评价,找出各个模型最优的参数值,并对三个模型进行全面评价比较,得到一个最好的分类模型以及该模型所有设置的最优参数。

最后使用这些参数以及训练集和校验集数据一起构造出一个最优分类器,并利用该分类器对测试数据进行预测。

2数据的准备及预处理

格式转换方法

原始数据是excel文件保存的xlsx格式数据,需要转换成Weka支持的arff文件格式或csv文件格式。

由于Weka对arff格式的支持更好,这里我们选择arff格式作为分类器原始数据的保存格式。

转换方法:在excel中打开“”,选择菜单文件->另存为,在弹出的对话框中,文件名输入“total_data”,保存类型选择“CSV(逗号分隔)”,保存,我们便可得到“”文件;然后,打开Weka的Exporler,点击Open file按钮,打开刚才得到的“total_data”文件,点击“save”按钮,在弹出的对话框中,文件名输入“total_data”,文件类型选择“Arff data files (*.arff)”,这样得到的数据文件为“”。

如何建立数据训练集,校验集和测试集

数据的预处理过程中,为了在训练模型、评价模型和使用模型对数据进行预测能保证

一致性和完整性,首先要把和合并在一起,因为在生成arff文件的时候,可能会出现属性值不一样的情况,否则将为后来的测试过程带来麻烦。

通过统计数据信息,发现带有类标号的数据一共有100行,为了避免数据的过度拟合,必须把数据训练集和校验集分开,目前的拆分策略是各50行。

类标号为‘female’的数据有21条,而类标号为‘male’的数据有79条,这样目前遇到的问题是,究竟如何处理仅有的21条female数据?为了能在训练分类模型时有更全面的信息,所以决定把包含21条female类标号数据和29条male类标号数据作为模型训练数据集,而剩下的另49条类标号类male的数据将全部用于校验数据集,这是因为在校验的时候,两种类标号的数据的作用区别不大,而在训练数据模型时,则更需要更全面的信息,特别是不同类标号的数据的合理比例对训练模型的质量有较大的影响。

预处理具体步骤

第一步:合并和,保存为;

第二步:在中删除多余的ID列信息;

第三步:在excel中打开“”,选择菜单文件->另存为,在弹出的对话框中,文件名输入“total_data”,保存类型选择“CSV(逗号分隔)”;

第四步:使用UltraEdit工具把中的数据缺失部分补上全局常量‘?’;

第五步:打开Weka的Exporler,点击Open file按钮,打开刚才得到的“”文件,点击“save”按钮,在弹出的对话框中,文件名输入“total_data”,文件类型选择“Arff data files (*.arff)”,这样得到的数据文件为“”。

第六步:从文件里面剪切所有没有分类标号的数据作为预测数据集(),共26项。

第七步:把剩下含有类标号数据的文件复制一份,作为总的训练数据集。

文件名称为。

第八步:从文件中剩下的数据里面选取所有分类标号为male的49行数据作为校验数据集()。

第九步:从把剩下的文件改名为。

3. 实验过程及结果截图

决策树分类

用“Explorer”打开刚才得到的“”,并切换到“Class”。

点“Choose”按钮选择“tree (,这是WEKA中实现的决策树算法。

选择Cross-Validatioin folds=10,然后点击“start”按钮:

训练数据集训练决策树得出的结果

配置不同的叶子节点的实例个数

实例数/叶节点 2 3 4 5 6

准确率54% 60% 56% 56% 56% 结果分析:使用决策树时,每个叶子节点最优的实例个数为3。

校验数据集校验决策树得出的结果

初步结果分析:

使用决策树进行分类,对于已知的49个类标号为male的数据都进行了准确的分类,并且达到100%;虽然是个很好的数据,但是完美背后隐藏了缺陷,是以对female类的低准确率作为代价的,因为这样会说明该分类器很有可能偏向male类。

K最近邻算法分类

点“Choose”按钮选择“laze->ibk”,这是WEKA中实现的决策树算法。

选择Cross-Validatioin folds=10,然后点击“start”按钮:

训练数据集训练KNN得出的结果

使用不同配置训练参数,得到的实验数据:

配置不同的叶子节点的实例个数

K值 1 2 3 4 5 6 7 8 9 10 准确率52% 54% 56% 58% 60% 58% 60% 68% 62% 62% 结果分析:使用KNN算法分类时,K最优值为8。

校验数据集校验KNN得出的结果

初步结果分析:

对使用k=8训练出来的分类模型进行校验的结果,准确率达到%,算是一个比较合理的分类结果。

朴素贝叶斯分类

点“Choose”按钮选择“bayes”,这是WEKA中实现的决策树算法。

选择Cross-Validatioin folds=10,然后点击“start”按钮:

训练数据集训练Naïve Bayes得出的结果

校验数据集校验Naïve Bayes得出的结果

初步结果分析:

评价结果中准确率仅仅达到%,结果不是很让人满意。

三类分类方法的校验结果比较

决策树K最近邻朴素贝叶斯

校验准确率100% % %

训练

混淆矩阵

校验

混淆矩阵

标准误差

比较结果分析:

根据上述数据,虽然决策树有最高的完美的准确率和相对较好的标准误差,但是这种完美的背后,很有可能是以类标号female的较大错误率作为代价,这点可以从训练混淆矩阵中得到印证;而朴素贝叶斯分类算法的准确率相对较低,而标准误差也较高,综合评价可以得知,当前最好的分类算法是KNN算法,并且它是最优设置参数为k=8。

训练最优模型

数据集训练KNN得出的结果

使用最终模型对测试集进行预测结果

4.三种算法在进行测试的性能比较实验结果

决策树的测试结果:

KNN测试结果:

朴素贝叶斯测试结果:

比较分析结论:

性能分析应该包括两个部分,一个部分是测试速度,另一个部分是测试的质量。

由于本次使用所使用的数据量太少,在测试速度的对比上相差太少,无法进行准确的分析。

而在测试质量上,可以从上述数据中得到,决策树依然是由于它对与male类标号的偏爱,导致质量的降低;而KNN与朴素贝叶斯相比,KNN具有较高的准确率,从性能角度上讲,KNN算法略胜一筹。

5.实验总结

本次实验进行比较顺利,使我对如何在Weka中进行分类分析有了更深刻的了解,对Weka中进行分类分析的KNN算法,朴素贝叶斯算法和决策树算法都有了进一步的理解,同时也深刻体会到数据预处理对于数据挖掘的重要性。