贝叶斯决策理论(英文)--非常经典!

统计决策理论-bayes定理

于是由先验概率 P( j ) 转化为后验概率 P(ωj|x) 。

如果对待分类模式的特征我们得到一个观察值x,经上式计

算出结果 P(1 x)>P(2 x),则判决X属于 1,反之,属 于 2 。

13

2.2 Bayes决策

14

2.2 Bayes决策

例1:在细胞的化验中,要区分正常和异常的两 种类型,分别用w1和w2表示,已知p(w1)=0.85, p(w2)=0.15,现有一待测细胞,其观测值为X,从 类条件概率密度分析曲线上查得p(x/w1)=0.15, p(x/w2)=0.45,试对该细胞进行分类。

2

• 统计学以数据为研究内容,但仅仅收集数据, 决不构成统计学研究的全部。

• 下面介绍几种最常用、也是最基本的统计决策 方法。这些方法是以后各种模式识别方法的基 础。

3

2.1 Bayes定理

贝叶斯决策理论方法是统计模式识别中的一个基本方 法,用这种方法进行分类时要求满足以下两个条件:

(1)各类别总体的概率分布是已知的; (2)要决策的类别数是一定的。

15

所以这次化验的细胞被判断为正常类型细胞。 16

2.2 Bayes决策

2.2.2 最小风险Bayes决策

最小风险Bayes决策是考虑各种错误造成损失不同 而提出的一种决策规则。

例如,通过化验判断细胞是不是癌细胞,可能做 出两种错误判决:一是把癌细胞错判为正常细胞; 一种是把正常细胞错判为癌细胞。这两种错误判 决带来的风险显然是不同的。

5

先验概率 预先已知的或者可以估计的模式识别系统位于某

种类型的概率,即根据大量统计确定某类事物出 现的比例。 如我国理工科大学男女生比例大约为8:2,则在这 类学校一个学生是男生的先验概率为0.8,而为女 生的概率是0.2,两个概率之和为1。

第2章 贝叶斯决策完整版.ppt

最小风险准则

❖ 最小风险贝叶斯决策:考虑各种错误造成损失不

同而提出的一种决策规则。

❖ 条件风险:

精选

最小风险准则

❖ 期望风险:对于x的不同观察值,采取决策αi时,

其条件风险大小是不同的。所以究竟采取哪一种决 策将随x的取值而定。这样,决策α可以看成随机向 量x的函数,记为α(x)。可以定义期望风险Rexp为:

假言:如果鱼的长度 x 大于45cm,则该鱼为 鲈鱼 1,否则该鱼为鲑鱼 2

前提:现在某条鱼 x 38cm

结论:该鱼为鲑鱼 2

❖ 概率推理(不确定性推理)

P i x 精选

最小错误率准则

❖ 例子:

给定

P

y

1

P

y

2

1 2

,类条件概率密度如图。

现有一条鱼 x=38cm, 若采用最小错误率决策,该鱼应该为哪一类?

R2

R1

a p 1 b

❖ 一旦 R1 和 R2 确定,a和b为常数

❖ 一旦 R1 和 R2 确定, R 与 P(ω1) 成线性关系

❖ 选择使 b=0 的R1 和 R2 ,期望风险与P(ω1) 无关!

精选

R* C’ C

最小最大决策准则

D

R1 ,R2不变

A

R*B

D’

B

R1 ,R2改变

b=0

此时最大 风险最小,

P i

x

Px

i P i

Px

则: P1 x P2 x

等价于:

p x 1 P 1 p x 2 P 2

p x 1 p x 2

p 2 p 1

精选

似然比公式

最小错误率准则

❖ 特例1:

贝叶斯统计决策

叶斯统计决策理论是指综合运用决策科学的基础理论和决策的各种科学方法对投资进行分析决策。

其应用决策科学的一般原理和决策分析的方法研究投资方案的比选问题,从多方面考虑投资效果,并进行科学的分析,从而对投资方案作出决策。

涉及到投资效果的各种评价、评价标准、费用(效益分析)等问题。

投资决策效果的评价问题首要的是对投资效果的含义有正确理解,并进行正确评价。

贝叶斯统计中的两个基本概念是先验分布和后验分布。

①先验分布。

总体分布参数θ的一个概率分布。

贝叶斯学派的根本观点,是认为在关于总体分布参数θ的任何统计推断问题中,除了使用样本所提供的信息外,还必须规定一个先验分布,它是在进行统计推断时不可缺少的一个要素。

他们认为先验分布不必有客观的依据,可以部分地或完全地基于主观信念。

②后验分布。

根据样本分布和未知参数的先验分布,用概率论中求条件概率分布的方法,求出的在样本已知下,未知参数的条件分布。

因为这个分布是在抽样以后才得到的,故称为后验分布。

贝叶斯推断方法的关键是任何推断都必须且只须根据后验分布,而不能再涉及样本分布。

贝叶斯统计(Bayesian statistics),推断统计理论的一种。

英国学者贝叶斯在1763年发表的论文《有关机遇问题求解的短论》中提出。

依据获得样本(Xl,X2,…,Xn)之后θ的后验分布π(θ|X1,X2,…,Xn)对总体参数θ作出估计和推断。

它不是由样本分布作出推断。

其理论基础是先验概率和后验分布,即在事件概率时,除样本提供的后验信息外,还会凭借自己主观已有的先验信息来估计事件的概率。

而以R.A.费希尔为首的经典统计理论对事件概率的解释是频率解释,即通过抽取样本,由样本计算出事件的频率,而样本提供的信息完全是客观的,一切推断的结论或决策不允许加入任何主观的先验的信息。

以对神童出现的概率P的估计为例。

按经典统计的做法,完全由样本提供的信息(即后验信息)来估计,认为参数p是一个“值”。

贝叶斯统计的做法是,除样本提供的后验信息外,人类的经验对p 有了一个了解,如p可能取pl与户p2,且取p1的机会很大,取p2机会很小。

第二章 贝叶斯决策理论—第三次课

第2章 贝叶斯决策理论

第2章 贝叶斯决策理论

本章内容

2.1 分类器的描述方法 2.2 最大后验概率判决准则 2.3 最小风险贝叶斯判决准则 2.4 Neyman-Person判决准则 2.5 最小最大风险判决准则 2.6 本章小结

第2章 贝叶斯决策理论

2.2 最大后验概率判决准则 (基于最小错误率的贝叶斯决策准则)

第2章 贝叶斯决策理论

2.5

第2章 贝叶斯决策理论

最小风险贝叶斯判决受三种因素的影响: 类条件概率密度函数p(x|ωi) ; 先验概率P(ωi) ; 损失(代价)函数λ(αj, ωi) 。 在实际应用中遇到的情况: – 各类先验概率不能精确知道; – 在分析过程中发生变动。 这种情况使判决结果不能达到最佳,实际分类器的平均损 失要变大,甚至变得很大。

第2章 贝叶斯决策理论

2.4 Neyman-Person

第2章 贝叶斯决策理论

最小风险贝叶斯判决准则使分类的平均风险最小, 该准则需要什么条件?

最大后验概率判决准则使分类的平均错误率最小, 该准则需要什么条件?

N-P准则在实施时既不需要知道风险函数,也不需 要知道先验概率。

第2章 贝叶斯决策理论

最大后验概率判决准则使分类的平均错误概率最小。 最小风险贝叶斯判决准则使分类的平均风险最小。 可是, 在实际遇到的模式识别问题中有可能出现这样 的问题: 对于两类情形, 不考虑总体的情况, 而只关注某 一类的错误概率, 要求在其中一类错误概率小于给定阈 值的条件下, 使另一类错误概率尽可能小。

因为两类情况下, 先验概率满足:

P(1) P(2 ) 1

第2章 贝叶斯决策理论

R R1 [(1,1)P(1) p(x | 1) (1,2 )P(2 ) p(x | 2 )]dx R2 {(2 ,1)P(1) p(x | 1) (2,2 )P(2 ) p(x | 2 )}dx

Bayes决策理论课件(PPT 67页)

P( j

x)

p( x j )P( j )

5

p( x i )P(i )

i1

j 1, 2, ,5

返回本章首页

第3章 Bayes决策理论

对于刚才的决策表考虑如下的一个条件期望损失,即给

定x ,我们采取决策 i 情况下的条件期望损失(条件风

险) :

5

R(i x) (i , j )P( j x) E (i , j ) i1,2, ,5

R2

R1

P(1)P1(e) P(2 )P2 (e)

返回本章首页

第3章 Bayes决策理论

结 束放映 返回本章首页

第3章 Bayes决策理论

3.2 最小风险的Bayes决策

在上一节我们介绍了最小错误率的Bayes决策, 并且证明了应用这种决策法则时,平均错误概率 是最小的。但实际上有时需要考虑一个比错误率 更为广泛的概念——风险,举例说明。毋庸置疑, 任何风险都会带来一定损失。看一个一般的决策 表。

0

p(x 2 )dx 0

R1

R1 ( t) R2 (t )

与最小错误率的Bayes决策的比较

P(1 x) P(2 x) 1

P(1 x) P(2 x)

2

p(x p(x

1 ) 2 )

p(x p(x

1 ) 2 )

x2 x1

返回本章首页

第3章 Bayes决策理论

3.4 最小最大决策

有时我们必须设计在整个先验概率范围上都能很 好的进行操作的分类器。比如,在我们的有些分 类问题中可能设想尽管模式的有些物理属性恒定 不变,然而先验概率可能变化范围很大,并且以 一种不确定的 方式出现。或者,我们希望在先 验概率不知道的情况下使用此分类器,那么一种 合理的设计分类器的方法就是使先验概率取任何 一种值时所引起的总风险的最坏的情况尽可能小, 也就是说,最小化最大可能的总风险。以二类模 式识别问题为例,进行讨论。

Bayes决策理论课件

3.1 最小错误概率的Bayes决策

1.用先验概率决策

假设某个工厂生产两种尺寸和外形都相同的螺钉, 一种是铁的,一种是铜的,两种产品混在一起,要求 对它们进行自动分类。

设 铁的类别状态用 1 表示;

铜的类别状态用 2 表示;

因为事先类别状态是不确定的,所以 1,2 是随

机变量。假设铁螺钉有7万个,铜螺钉有3万个,

12 22 21 11 即所谓对称损失函数的情况,二者一致。

(2)一般的多类问题中,在0-1损失函数的情况 时,即

( i

|

j

)

0, 1,

i j i j,i, j 1, 2,

,c

条件风险为:

c

R(i | X ) (i | j )P( j | X ) j 1

P( j | X ) 1 P(i | X ) ji

则根据Bayes法则,后验概率

P j 就| X 是

P j

|

X

pX

|j Pj

pX

c

式中, p X p X | i P i

i 1

这时决策与上述二类一维模式相似:

如果 Pi | X pj | X 对于一切 i j成立,则决策 i 。

3.2 最小风险的Bayes决策

1 决策错误的损失与风险 对于两类别决策,存在两种可能的分类错误:

或:

如果 (21 11)P 1 | X (12 22 )P 2 | X ,

则判定 1 为真正的状态;否则 2 为真正的状态。

上式与最小错误概率的Bayes决策比较,有何不同? 在后验概率上分别乘以一个损失差作为比例因子。

最小风险的Bayes决策和最小错误概率的Bayes 决策的关系:

(1)在二类问题中,若有

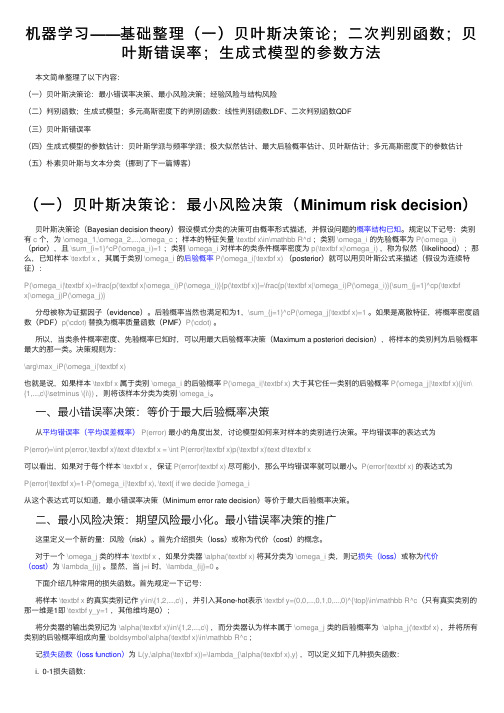

机器学习——基础整理(一)贝叶斯决策论;二次判别函数;贝叶斯错误率;生成式模型的参数方法

机器学习——基础整理(⼀)贝叶斯决策论;⼆次判别函数;贝叶斯错误率;⽣成式模型的参数⽅法本⽂简单整理了以下内容:(⼀)贝叶斯决策论:最⼩错误率决策、最⼩风险决策;经验风险与结构风险(⼆)判别函数;⽣成式模型;多元⾼斯密度下的判别函数:线性判别函数LDF、⼆次判别函数QDF(三)贝叶斯错误率(四)⽣成式模型的参数估计:贝叶斯学派与频率学派;极⼤似然估计、最⼤后验概率估计、贝叶斯估计;多元⾼斯密度下的参数估计(五)朴素贝叶斯与⽂本分类(挪到了下⼀篇博客)(⼀)贝叶斯决策论:最⼩风险决策(Minimum risk decision)贝叶斯决策论(Bayesian decision theory)假设模式分类的决策可由概率形式描述,并假设问题的概率结构已知。

规定以下记号:类别有c个,为\omega_1,\omega_2,...,\omega_c;样本的特征⽮量\textbf x\in\mathbb R^d;类别\omega_i的先验概率为P(\omega_i)(prior),且\sum_{i=1}^cP(\omega_i)=1;类别\omega_i对样本的类条件概率密度为p(\textbf x|\omega_i),称为似然(likelihood);那么,已知样本\textbf x,其属于类别\omega_i的后验概率P(\omega_i|\textbf x)(posterior)就可以⽤贝叶斯公式来描述(假设为连续特征):P(\omega_i|\textbf x)=\frac{p(\textbf x|\omega_i)P(\omega_i)}{p(\textbf x)}=\frac{p(\textbf x|\omega_i)P(\omega_i)}{\sum_{j=1}^cp(\textbfx|\omega_j)P(\omega_j)}分母被称为证据因⼦(evidence)。

后验概率当然也满⾜和为1,\sum_{j=1}^cP(\omega_j|\textbf x)=1。

贝叶斯决策理论

g(x)

判别计算

阈值单元

决策

贝叶斯决策理论

2.3 正态分布时的统计决策

重点分析正态分布情况下统计决策的原因是: ①正态分布在物理上是合理的、广泛的 ②正态分布 数学表达上简捷,如一维情况下只

有均值和方差两个参数,因而易于分析

贝叶斯决策理论

贝叶斯决策理论

目标:所采取的一系列决策行动应该使期 望风险达到最小

手段:如果在采取每一个决策时,都使其 条件风险最小,则对所有的 x 作决策时, 其期望风险也必然达到最小

决策:最小风险Bayes决策

贝叶斯决策理论

最小风险Bayes决策规则:

其中

采取决策

贝叶斯决策理论

最小风险Bayes决策的步骤

2.2.6 分类器设计

要点: • 判别函数 • 决策面(分类面) • 分类器设计

贝叶斯决策理论

决策面(分类面)

对于 c 类分类问题,按照决策规则可以把 d 维特 征空间分成 c 个决策域,我们将划分决策域的 边界面称为决策面(分类面)

贝叶斯决策理论

判别函数

用于表达决策规则的某些函数,则称为判别 函数

E{ xi xj } = E{ xi } E{ xj }

贝叶斯决策理论

相互独立

成立

成立?? 多元正态分布的任

不相关

意两个分量成立!

贝叶斯决策理论

说明:正态分布中不相关意味着协方差矩阵

是对角矩阵

并且有

贝叶斯决策理论

④边缘分布(对变量进行积分)和条件分布(固定变 量)的正态性

⑤线性变换的正态性

y=Ax A为线性变换的非奇异矩阵。若 x 为正态分布,

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

P(Ci) can be estimated by P ( Ci ) =

Si S

where Si is the number of training instances of class Ci, and S is the total number of training instances since naive Bayesian classifier assumes class conditional independence, P(X|Ci) can be n estimated by

• Speed

the computational cost involved in generating and using the model

training time cost vs. test time cost

usually, larger training time cost but smaller test time cost

the level of interpretability of the model

How to estimate accuracy?

two popular methods: • hold-out

partition the data set into two independent subsets, i.e. a training set and a test set

Bayes theorem

P( X | H ) P(H ) P(H | X ) = P( X )

where P(H|X) is the posterior probability of the hypothesis H conditioned on the data sample X, P(H) is the prior probability of H, P(X|H) is the posterior probability of X conditioned on H, P(X) is the prior probability of X

• Robustness

the ability of the model to deal with noise or missing values

• Scalability

the ability of the model to deal with huge volume of data

• Comprehensibility

according to Bayes theorem,

P ( Ci | X ) =

P ( X | Ci ) P ( Ci ) P( X )

since P(X) is a constant for all classes, only P(X|Ci)P(Ci) need be maximized

Naive Bayesian classifier (II)

accuracy

Test Data

Prediction model

Tenured? Unseen Data

Name Tom Merlisa George Joseph

Rank Assistant Prof Associate Prof Professor Assistant Prof

Years Tenured 2 no 7 no 5 yes 7 yes

• stratified cross-validation: the class distribution of the subsets is approximately the same as that in the initial data set • leave-one-out: k equals to the number of instances in the initial data set

(Jeff, Professor, 7)

Supervised vs. Unsupervised learning

Supervised learning

• the training data are accompanied by labels indicating the desired outputs of the observations • the concerned property of unseen data is predicted • usually: classification, regression

usually 2/3 of the data set are used for training while the remaining 1/3 are used for test

• hold-out with random subsampling: repeat hold-out test for k times

Classification vs. Regression

Classification predicts categorical class labels Prediction Regression models continuous-valued functions, i.e. predicts numerical values

How to evaluate prediction algorithms?

• Generalization

the ability of the model to correctly predict unseen instances. usually measured by predictive accuracy

Training Data

Name Mike Mary Bill Jim Dave Anne Rank Assistant Prof Assistant Prof Professor Associate Prof Assistant Prof Associate Prof Years 3 7 2 7 6 3 Tenured no yes yes yes no no

Thomas Bayes (1701?-1761)

Naive Bayesian classifier (I)

also called simple Bayesl independence: assume that the effect of an attribute value on a given class is independent of the values of other attributes

Two step process of prediction (I)

Step 1: Construct a model to describe a training set

• the set of tuples used for model construction is called training set • the set of tuples can be called as a sample (a tuple can also be called as a sample) • a tuple is usually called an example (usually with the label) or an instance (usually without the label) • the attribute to be predicted is called label Training algorithm

class Ci (i = 1, …, m) attribute Ak (k = 1, …, n) feature vector X = (x1, x2, …, xn), where xk is the value of X on Ak

naive Bayesian classifier returns the maximum posteriori hypothesis Ci P(Ci|X) > P(Cj|X) for 1 ≤ j ≤ m, j ≠ i

Sik Si

P ( xk | Ci ) = g xk , μ Ci , σ Ci =

• k-fold cross-validation

partition the data set into k mutually exclusive subsets with approximately equal size. Perform training and test for k times. In the i-th time, the i-th subset is used for test while the remaining subsets are collectively used for training 10-fold cross-validation is often used

before use the model, we can estimate the accuracy of the model by a test set • test set is different from training set • the desired output of a test instance is compared with the actual output from the model • for classification, the accuracy is usually measured by the percentage of test instances that are correctly classified by the model • for regression, the accuracy is usually measured by mean squared error