搜索引擎蜘蛛采用什么抓取策略

搜索引擎spider爬虫(蜘蛛)原理

搜索引擎spider爬⾍(蜘蛛)原理做SEO的⼈应该要对搜索引擎的基本原理有⼀些了解,从搜索引擎发现⽹址到该页⾯拥有排名,以及后续更新整个过程中,搜索引擎到底是怎么⼯作的?你都需要了解。

对于专业的算法不必进⾏深⼊的研究,但是对于搜索引擎⼯作中的⽣命⼒和算法原理要有个简单的认知,这样才能更有效地开展SEO⼯作,知其然也要知其所以然;当然也有⼀些朋友不懂这些,照样做昨有声有⾊,但是有对搜索引擎⼯作原理,懂总⽐不懂好⼀点。

以往的SEO书藉中对这内容讲解都⽐较简单,希望在些能够尝试结合SEO实际⼯作和现象,更进⼀步剖析⼀下搜索引擎的⼯作原理,其实当你了解了搜索引擎的⼯作流程、策略和基本算法后,就可以在⼀定程序上避免因为不当操作⽽带来的不必要处罚,同也可以快速分析出很多搜索引擎搜索结果异常的原因。

有搜索⾏为的地⽅就有搜索引擎,站内搜索、全⽹搜索、垂直搜索等都⽤到搜索引擎;接下来,本⽂会根据从业认知,讨论⼀下全⽂搜索引擎的基本架构。

百度、⾕歌等综合搜索巨头肯定有着更为复杂的架构和检索技术,但宏观上基本原理都差不多的。

搜索引擎的⼤概架构如图2-1所⽰。

可以分成虚线左右两个部分:⼀部分是主动抓取⽹页进⾏⼀系列处理后建⽴索引,等待⽤户搜索;另⼀部分是分析⽤户搜索意图,展现⽤户所需要的搜索结果。

搜索引擎主动抓取⽹页,并进⾏内容处理、索引部分的流程和机制⼀般如下:1.派出spider按照⼀定策略把⽹页抓回到搜索引擎服务器;2.对抓回的⽹页进⾏链接抽离、内容处理,削除噪声、提取该页主题⽂本内容等;3.对⽹页的⽂本内容进⾏中⽂分词、去除停⽌词等;4.对⽹页内容进⾏分词后判断该页⾯内容与已索引⽹页是否有重复,剔除重复页,对剩余⽹页进⾏倒排索引,然后等待⽤户的检索。

当有⽤户进⾏查询后,搜索引擎⼯作的流程机制⼀般如下:1.先对⽤户所查询的关键词进⾏分词处理,并根据⽤户的地理位置和历史检索特征进⾏⽤户需求分析,以便使⽤地域性搜索结果和个性化搜索结果展⽰⽤户最需要的内容;2.查找缓存中是否有该关键词的查询结果,如果有,有为最快地呈现查询,搜索引擎会根据当下⽤户的各种信息判断其真正需求,对缓存中的结果进⾏微调或直接呈现给⽤户;3.如果⽤户所查询的关键词在缓存中不存在,那么就在索引库中的⽹页进⾏调取排名呈现,并将该关键词和对应的搜索结果加⼊到缓存中;4.⽹页排名是⽤户的搜索词和搜索需求,对索引库中⽹页进⾏相关性、重要性(链接权重分析)和⽤户体验的⾼低进⾏分析所得出的。

详解spider爬行抓取策略

详解spider爬行抓取策略我们在做网站优化的时候,SEOer们常常会关注网站的spider的爬行日志,我们会发现spider爬行网站的次数时多时少,那么spider爬行抓取的策略是什么呢?下面担路网小编简单为大家介绍一下spider爬行抓取策略。

在spider眼中,互联网的网页主要可以分成四类:已抓取的页面、待抓取的页面、可抓取的页面、暗网中的页面。

已抓取的页面即spider已经抓取的页面。

待抓取的页面:已经在spider要抓取的队列中,只是还没抓。

可抓取的页面:就是通过互联网现有的链接关系可以找到这些页面,增量型spider随着抓取的深入能发现这些页面。

暗网中的页面:通过现有的链接还是没办法找到的页面。

spider从一个入口进去开始抓取时,这个页面有很多的导出链接,spider会选择其中一个链接进去抓取,进去之后又有很多导出链接。

spider抓取的方式主要有两种:深度优先策略、广度优先策略。

深度优先就是沿着一条路径走下去,直到无路可走。

广度优先就是一个页面上有多个导出链接,先顺着这些链接把链接到的页面都抓过去,然后再抓链接到的页面上的导出链接所到的页面。

理论上只要时间够,spider都能抓完所有的页面,但是搜索引擎的资源也是有限的,它不可能无限制的抓取下去,搜索引擎一般会采用深度和广度策略想结合的方式。

一般情况下,网站的权重越高,spider抓取的频率就越高,抓取的内容也就越多。

以上两种策略都是单纯站在spider抓取的角度上来看的,实际过程中影响spider抓取的较大的因素是:重要页面优先抓取策略以及大站优先抓取。

重要页面的重要程度主要是由该页面的导入链接的数量以及质量决定的。

而所谓大站就是指在搜索引擎眼中,是一个有着良好的用户体验度、稳定的服务器、丰富的内容的网站。

总的来说,一个网站的导入链接越多,导入链接所在的页面权重越高,其被抓取的可能性也就越高,所以SEOer 们在做好网站内部优化的同时,要做好高质量的外链的工作。

搜索引擎Web Spider(蜘蛛)爬取的原理分享

搜索引擎Web Spider(蜘蛛)爬取的原理分享一、网络蜘蛛基本原理网络蜘蛛即WebSpider,是一个很形象的名字。

把互联网比方成一个蜘蛛网,那么Spider就是在网上爬来爬去的蜘蛛。

网络蜘蛛是通过网页的链接地址来寻觅网页,从网站某一个页面(通常是首页)开头,读取网页的内容,找到在网页中的其它链接地址,然后通过这些链接地址寻觅下一个网页,这样向来循环下去,直到把这个网站全部的网页都抓取完为止。

假如把囫囵互联网当成一个网站,那么网络蜘蛛就可以用这个原理把互联网上全部的网页都抓取下来。

对于搜寻引擎来说,要抓取互联网上全部的网页几乎是不行能的,从目前公布的数据来看,容量最大的搜寻引擎也不过是抓取了囫囵网页数量的百分之四十左右。

这其中的缘由一方面是抓取技术的瓶颈,薹ū槔械耐常行矶嗤澄薹ù悠渌车牧唇又姓业剑涣硪桓鲈蚴谴娲⒓际鹾痛砑际醯奈侍猓绻凑彰扛鲆趁娴钠骄笮∥0K计算(包含),100亿网页的容量是100×2000G字节,即使能够存储,下载也存在问题(根据一台机器每秒下载20K计算,需要340台机器不停的下载一年时光,才干把全部网页下载完毕)。

同时,因为数据量太大,在提供搜寻时也会有效率方面的影响。

因此,许多搜寻引擎的网络蜘蛛只是抓取那些重要的网页,而在抓取的时候评价重要性主要的依据是某个网页的链接深度。

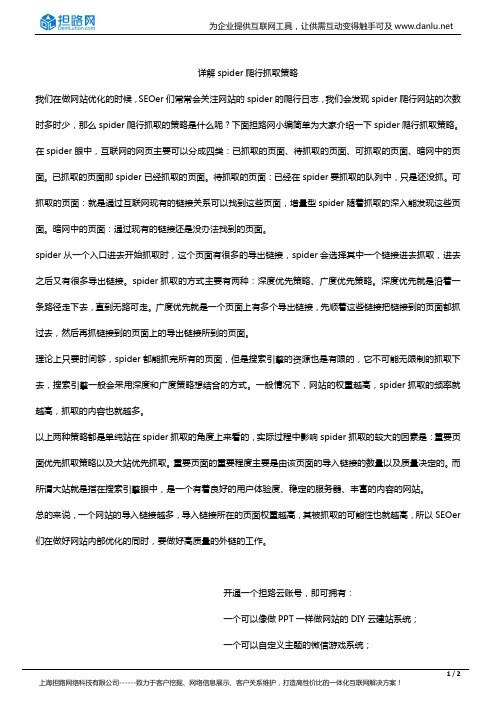

在抓取网页的时候,网络蜘蛛普通有两种策略:广度优先和深度优先(如下图所示)。

广度优先是指网络蜘蛛会先抓取起始网页中链接的全部网页,然后再挑选其中的一个链接网页,继续抓取在此网页中链接的全部网页。

这是最常用的方式,由于这个办法可以让网络蜘蛛并行处理,提高其抓取速度。

深度优先是指网络蜘蛛会从起始页开头,一个链接一个链接跟踪下去,处理完这条线路之后再转入下一个起始页,继续跟踪链接。

这个办法有个优点是网络蜘蛛在设计的时候比较简单。

两种策略的区分,下图的解释会越发明确。

搜索引擎的两种基本抓取策略

搜索引擎的两种基本抓取策略

本文由:xp系统下载提供技术支持

今天我们来说说搜索引擎的收录过程中所采取的收录抓取策略。

蜘蛛在完成对robots.txt文件的访问之后便会开始对所进入的页面进行判断是否符合收录标准,如果符合,那么提取其内容和链接。

这个页面抓取完成之后,还没完,蜘蛛还会顺着所提取的链接探索下去,从这个链接爬到下一个页面,又从下一个页面上的链接爬到再下一个页面......

由于互联网上的页面链接结构异常复杂,蜘蛛需要采用一定的策略才能爬行到网上的所有页面。

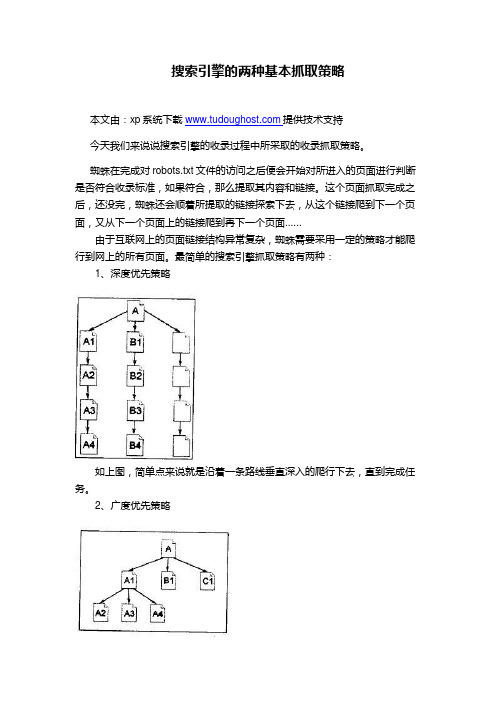

最简单的搜索引擎抓取策略有两种:

1、深度优先策略

如上图,简单点来说就是沿着一条路线垂直深入的爬行下去,直到完成任务。

2、广度优先策略

如上图,简单说就是先把指定的一个页面上的所有链接爬行一遍,然后再从每条链接深入同样平行地进行爬行。

在实际中,这两种策略是同时发生的,理论上只要给予足够的时间,搜索引擎蜘蛛就可以爬完所有的页面。

但是蜘蛛的带宽资源、时间并不是无限的,所以蜘蛛只能爬行一定的时间,权重越高的网站自然爬行的时间越长。

搜索蜘蛛的目的就是探索到有价值的页面并收录,这就是为什么权重高的站爬行时间长,抓取度深的原因。

所以我们建议新站的网站链接层次不要过深,免得蜘蛛在短时间内爬行不到。

在收索引擎蜘蛛爬行完毕之后,便会把搜集到的网页数据交给数据分析系统,整个收录过程便结束了。

好了,今天的seo基础就到这里。

本文由:废品回收价格表提供技术指导。

seo外包技术原理

seo外包技术原理

纵向抓取原理:

就是当蜘蛛进入一个网站的时候,会沿着一个连接逐步的深入,直到无法再向前前进的时候在返回爬行另外一个连接。

横向抓取原理:

就是当蜘蛛进入一个网站的时候,在一个页面上发现有很多的连接的时候,不是顺着各个连接进行一步步的纵向抓取,而是一层层的抓取,比如把第一层的连接全部抓取完成,再沿着第二层连接进行抓取。

一般来说,在搜索引擎蜘蛛进入网站时候,首先是对内部连接纵向抓取,其次是对外部横向抓取,也就是说搜索引擎蜘蛛抓取页面是纵向原则和横向原则想结合的。

但无论是纵向抓取还是横向抓取,只要网站是和蜘蛛的爬行和胃口,蜘蛛就能将你的网站所有网页爬完。

为了培养蜘蛛的访问,站长在发布文章时有固定的时间间隔和一定的规律,这样对蜘蛛的由好处的。

比如站点是每天的上午9点钟到下午的6点发布文章最多。

那么搜索引擎蜘蛛针对这个站点就会在自己的规则里填写上这样一条时间段的规则,以后就按照这样的规则执行,即节省了时间又提高了效率。

查看蜘蛛是否到访站点可以通过网站日志分析,搜索引擎是否已爬行

了网站,爬行了哪些页面以及返回哪些信息给蜘蛛,掌握了这些情况我们才能对网站进行有针对性的优化改良,因此查看蜘蛛爬行日志是一件非常重要的工作。

百度蜘蛛的工作原理

百度蜘蛛是一个程序,其工作原理:第一,搜索引擎构建一个调度程序,来调度百度蜘蛛的工作,蜘蛛在访问网站页面时类似与普通访客浏览,让百度蜘蛛去和服务器建立连接下载网页,计算的过程都是通过调度来计算的,百度蜘蛛抓页面的时候从起始站点(即种子站点指的是一些门户站点)是广度优先抓取是为了抓取更多的网址,深度优先抓取的目的是为了抓取高质量的网页,这个策略是由调度来计算和分配的,百度蜘蛛只负责抓取,权重优先是指反向连接较多的页面的优先抓取,这也是调度的一种策略,百度蜘蛛只是负责下载网页,目前的搜索引擎普遍使用广布式多服务器多线程的百度蜘蛛来达到多线程的目的。

理论上,从一定范围地网页出发,就能搜集到绝大多数地网页。

抓取顺序则是权重优先,门户类或者是反向连接较多的页面的优先抓取,通过百度蜘蛛下载回来的网页放到补充数据区,通过各种程序计算过后才放到检索区,才会形成稳定的排名,所以说只要下载回来的东西都可以通过指令找到,补充数据是不稳定的,有可能在各种计算的过程中给k掉,检索区的数据排名是相对比较稳定的,百度目前是缓存机制和补充数据相结合的,正在向补充数据转变,这也是目前百度收录困难的原因,也是很多站点今天给k了明天又放出来的原因。

一般情况下网页抓取抓到40%是正常范围,60%算很好,100%是不可能的,当然抓取的越多越好。

第二,抓取页面后的处理工作,搜索引擎抓到网页后,还要做大量地预处理工作, 最重要地就是提取关键词,建立索引文件.其他还包括去除重复网页、分析超链接、计算网页地重要度。

百度蜘蛛在从首页登陆后抓取首页后调度会计算其中所有的连接,返回给百度蜘蛛进行下一步的抓取连接列表,百度蜘蛛再进行下一步的抓取,网址地图的作用是为了给百度蜘蛛提供一个抓取的方向,来左右百度蜘蛛去抓取重要页面,如何让百度蜘蛛知道那个页面是重要页面?可以通过连接的构建来达到这个目的,越多的页面指向该页,网址首页的指向,副页面的指向等等都能提高该页的权重,地图的另外一个作用是给百度蜘蛛提供更多的连接来达到抓去更多页面的目的,地图其实就是一个连接的列表提供给百度蜘蛛,来计算你的目录结构,找到通过站内连接来构建的重要页面。

搜索引擎蜘蛛抓取网页规则分析

搜索引擎蜘蛛抓取网页规则分析百度蜘蛛,是百度搜索引擎的一个自动程序。

它的作用是访问收集整理互联网上的网页、图片、视频等内容,然后分门别类建立索引数据库,使用户能在百度搜索引擎中搜索到您网站的网页、图片、视频等内容。

下面是YJBYS 小编整理的搜索引擎蜘蛛抓取网页规则,希望对你有帮助!

一,爬虫框架

上图是一个简单的网络爬虫框架图。

种子URL 入手,如图所示,经过一步步的工作,最后将网页入库保存。

当然,勤劳的蜘蛛可能需要做更多的工作,比如:网页去重以及网页反作弊等。

也许,我们可以将网页当作是蜘蛛的晚餐,晚餐包括:

已下载的网页。

已经被蜘蛛抓取到的网页内容,放在肚子里了。

已过期网页。

蜘蛛每次抓取的网页很多,有一些已经坏在肚子里了。

待下载网页。

看到了食物,蜘蛛就要去抓取它。

可知网页。

还没被下载和发现,但蜘蛛能够感觉到他们,早晚会去抓取它。

不可知网页。

互联网太大,很多页面蜘蛛无法发现,可能永远也找不到,这部份占比很高。

通过以上划分,我们可以很清楚的理解搜索引擎蜘蛛的工作及面临的挑战。

大多数蜘蛛是按照这样的框架去爬行。

但也不完全一定,凡事总有特殊,根据职能的不同,蜘蛛系统存在一些差异。

二,爬虫类型

1,批量型蜘蛛。

这类蜘蛛有明确的抓取范围和目标,当蜘蛛完成目标和任务后就。

百度蜘蛛秒收的技巧

百度蜘蛛秒收的技巧百度蜘蛛秒收的技巧1.习惯性的每天去采集,有的更加懒直接用工具生成内容,这样虽然你的网站看上去硕果满满,但对蜘蛛来说这些东西里面都长满了虫子。

搜索引擎的蜘蛛自然而来是望而却步!所以我们的内容要分两步走,原创内容投A5或其它的原创网,好文章才拿来,但也要进行伪原创一下,变成自己的理解语句,可以更加通俗,更加形象化一些。

比如你改改标题,首尾,内容里面插入你的关键词是有必要的。

2、外链吸引蜘蛛来,个人观点是:新站靠广,老站靠质。

一个新网站的时候,要想让百度蜘蛛关注你,你就要去布置链接诱饵让蜘蛛顺着路来,而老站我们的外链要看注重有权重的链接了。

外链的目的就是帮助我们的蜘蛛大哥进入我们的网站和引导抓取,让蜘蛛大哥每天走同一条路,蜘蛛就越熟悉就会越有感情。

外链越多,蜘蛛就越有兴趣,来你的网站就会越勤快。

也许内容搭建是跟我们蜘蛛刚认识的阶段,而外链搭建则是我们跟蜘蛛相互影响阶段,特别是要找到自己合适的方法,做精做好,PV就会如滔水般源源不断。

有人论坛做外链在行,有人博客做外链在行,有人做问答平台外链在行,有人做分类信息网平台外链在行,有人投稿在行。

总会有一种适合你的。

3、用创新思维让蜘蛛为我们工作。

个人推荐:无论是新站还是老站都要认知这个观点。

一直觉得从内容和外链就已经足够让蜘蛛吃个饱了,但在达到常驻还差一步,就是创新的思维方式来吸引蜘蛛。

那么什么是创新的思维了,就是你网站对事件另外角度的看法,对资源的整合创新思维的目的:让网站成为一个界内的焦点,成为一个界内的热度。

从而提高百度的权重值。

怎么做:就是打造属于自己的有流量的品牌词。

从而让百度免费帮我们去做推广,当然我们一般要借助工具来刷一下,那么百度词库会把这个关键词当成热度词,接着搜索框里面就很容易出现这个词了,当然这个词也要你网站的相关的内容支撑。

参考资料/。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

搜索引擎蜘蛛采用什么抓取策略

搜索引擎蜘蛛简称爬虫,它的主要目的是抓取并下载互联网的网页到本地,同时与切词器、索引器一起共同对网页内容进行分词处理,建立索引数据库,促使最终形成用户查询的结果。

即使对于商业搜索引擎来说,想要抓取互联网的所有网页也是一件很困难的事情,百度为什么没有Google强大?首先百度对于互联网上信息的抓取量与Google是无法相比的;其次对于爬虫的抓取速度和抓取效率也跟不上Google,这些不是说解决就能解决的,一些技术上的问题很可能会很长时间都无法获得解决。

虽然搜索引擎很难抓取到互联网上的所有网页,但是这也是它必然的目标,搜索引擎会尽量增加抓取数量。

那么搜索引擎抓取采用的策略都有什么呢? 目前主要流行的策略有四个:宽度优先遍历策略、Partial PageRank策略、OPIC策略策略、大站优先策略。

一、宽度优先遍历策略

如图所示,宽度优先遍历策略就是将下载完成的网页中发现的链接逐一直接加入待抓取URL,这种方法没有评级网页的重要性,只是机械性地将新下载的网页中URL提取追加入待抓取URL。

这种策略属于搜索引擎早期采用的抓取策略,效果很好,以后的新策略也都以这个为基准的。

上图遍历抓取路径:A-B-C-D-E-F G H I

二、Partial PageRank策略

Partial PageRank策略借鉴了PageRank算法的思想,对于已经下载的网页,连同待抓取URL队列中的URL,形成网页集合,计算每个页面的PageRank值,计算完之后,将待抓取URL 队列中的URL按照PageRank值的大小排列,并按照该顺序抓取页面。

通常搜索引擎会采取每当新下载网页达到一个N值后,就将所有下载过的网页计算一个新的PageRank(非完全PageRank值),然后将待抓取URL跟这个进行重新排序。

这种方法的争议很大,有人说比宽度优先遍历策略的效果:也有人说这样与PageRank的完整值差别很大,依托这种值的排序不准确。

三、OPIC策略

OPIC策略更像是Partial PageRank策略进行的改进。

OPIC策略与Partial PageRank策略大体结构上相同,类似与PageRank评级的网页重要性,每个网页都会有一个10分,然后分别传递给网页上的链接,最后10分清空。

通过网页获得的分值高低,评级一个网页的重要性,优先下载获得评分高的URL。

这种策略不需要每次都要对新抓取URL进行重新计算分值。

四、大站优先策略

大站通常是指网页内容多,内容质量高的网站,这些网站通常存在大量的页面。

则在待抓取URL出现哪个网站等待抓取的页面最多,就优先抓取这些链接。

效果略好于宽度优先遍历策略。

本文由无锡白癜风医院:/ 编辑!。