有两个隐含层的多层感知器

人工智能基础知到章节答案智慧树2023年山东交通学院

人工智能基础知到章节测试答案智慧树2023年最新山东交通学院绪论单元测试1.人工智能的名字是参考答案:Artificial Intelligence第一章测试1.第一个击败人类职业围棋选手、第一个战胜世界围棋冠军的人工智能机器人是由谷歌公司开发的()。

参考答案:AlphaGo2.无需棋谱即可自学围棋的人工智能是()参考答案:AlphaGo Zero3.世界上第一次正式的AI会议于()年召开,John McCarthy 正式提出“Artificial Intelligence”这一术语参考答案:19564.以下哪些不是人工智能概念的正确表述()参考答案:人工智能将其定义为人类智能体的研究5.下面不属于人工智能研究基本内容的是()。

参考答案:自动化6.人工智能是研究、开发用于模拟、延伸和扩展人的()的理论、方法、技术及应用系统的一门新的技术科学。

参考答案:智能7.图灵测试的含义是()参考答案:图灵测试是测试人在与被测试者(一个人和一台机器)隔开的情况下,通过一些装置(如键盘)向被测试者随意提问。

问过一些问题后,如果被测试者超过30%的答复不能使测试人确认出哪个是人、哪个是机器的回答,那么这台机器就通过了测试,并被认为具有人类智能。

8.下列不属于人工智能学派的是()。

参考答案:机会主义9.认为智能不需要知识、不需要表示、不需要推理;人工智能可以像人类智能一样逐步进化;智能行为只能在现实世界中与周围环境交互作用而表现出来。

这是()学派的基本思想。

参考答案:行为主义10.关于人工智能研究范式的连接主义,相关论述不正确的是()参考答案:连接主义学派的代表人物有卡洛克(Warren S. McCulloch)、皮茨(Walter H.Pitts)、Hopfield、布鲁克斯(Brooks)、纽厄尔(Newell)。

11.人工智能(AI)、机器学习、深度学习三者关系论述正确的是()参考答案:人工智能是一门研究、开发用于模拟、延伸和扩展人类智能的理论、方法及应用的新的交叉学科,机器学习是人工智能的核心研究邻域之一,深度学习是机器学习的新领域,研究多隐层多感知器、模拟人脑进行分析学习的人工神经网络。

多层感知器算法原理

多层感知器算法原理多层感知器(Multilayer Perceptron,MLP)是一种前馈结构的人工神经网络,可以对一组输入向量进行非线性映射,从而实现分类或回归等任务。

MLP由多个节点层组成,每一层都与上一层和下一层相连,每个节点都是一个带有非线性激活函数的神经元。

MLP 的学习过程主要依赖于反向传播算法,即通过计算输出误差对网络权重进行反向调整,从而达到最优化的目的。

网络结构MLP的网络结构一般包括三层或以上,分别是输入层、隐藏层和输出层。

输入层接收外部输入的数据,输出层产生网络的预测结果,隐藏层位于输入层和输出层之间,可以有多个,用于提取输入数据的特征。

每一层中的节点都与相邻层中的所有节点相连,每条连接都有一个权重,表示该连接的强度。

每个节点除了接收来自上一层的加权输入外,还有一个偏置项,表示该节点的阈值。

每个节点的输出由其输入和激活函数共同决定,激活函数的作用是引入非线性,增强网络的表达能力。

常用的激活函数有Sigmoid函数、双曲正切函数、ReLU函数等。

学习过程MLP的学习过程主要分为两个阶段,即前向传播和反向传播。

前向传播是指从输入层到输出层逐层计算节点的输出,反向传播是指从输出层到输入层逐层计算节点的误差,并根据误差对权重进行更新。

具体步骤如下:前向传播从输入层开始,将输入数据乘以相应的权重,加上偏置项,得到每个节点的输入。

对每个节点的输入应用激活函数,得到每个节点的输出。

将每个节点的输出作为下一层的输入,重复上述过程,直到达到输出层。

在输出层,根据预测结果和真实标签,计算损失函数,评估网络的性能。

反向传播从输出层开始,根据损失函数对每个节点的输出求导,得到每个节点的误差。

对每个节点的误差乘以激活函数的导数,得到每个节点的梯度。

将每个节点的梯度作为上一层的误差,重复上述过程,直到达到输入层。

在每一层,根据节点的梯度和输入,计算权重的梯度,并根据学习率对权重进行更新。

MLP的学习过程可以采用批量梯度下降、随机梯度下降或小批量梯度下降等优化方法,也可以使用动量、自适应学习率或正则化等技术来提高收敛速度和泛化能力。

2024年华为人工智能方向HCIA考试复习题库(含答案)

A、Dropout

B、正则化 C、梯度下降 D、交叉验证 参考答案:C 33.以下哪个不是图像识别服务的应用? A、目标检测 B、智能相册 C、场景分析 D、语音合成 参考答案:D 34.以下关于机器学习描述正确的是? A、深度学习是机器学习的一个分支

C、空字符 D、recapture 参考答案:C 49.以下列哪一项不属于语音识别场景的应用? A、会议记录

B、电话回访 C、口语测评 D、人脸识别 E、智能音箱 参考答案:D 50.tensorFlow2.0 中可用于张量合并的方法有?

A、split B、join C、concat D、unstack

A、图方法

B、源码转换 C、运算符重载 参考答案:B 16.梯度下降算法中,损失函数曲面上轨迹最混乱的算法是以下哪种 算法?

A、SGD B、BGD C、MGD D、MBGD

参考答案:A 17.长短记忆网络是基于循环神经网络发展而来的,长短神经网络主 要解决了循环神经网路的什么问题?

A、过拟合问题 B、梯度爆炸问题 C、欠拟合问题 D、梯度消失问题 参考答案:D 18.以下哪一项不是 ModelArts 中训练平台的主要任务? A、算法开发 B、收集数据 C、模型评估 D、模型可视化

2024 年华为人工智能方向HCIA 考试复习 题库(含答案)

一、单选题 1.以下哪—项不属于 MindSpore 全场景部署和协同的关键特性? A、统一模型 R 带来一致性的部署体验。 B、端云协同 FederalMetaLearning 打破端云界限,多设备协同模型。 C、数据+计算整图到 Ascend 芯片。 D、软硬协同的图优化技术屏蔽场景差异。 参考答案:C 2.在对抗生成网络当中,带有标签的数据应该被放在哪里? A、作为生成模型的输出值 B、作为判别模型的输入值 C、作为判别模型的输出值 D、作为生成模型的输入值 参考答案:B 3.下列属性中 TensorFlow2.0 不支持创建 tensor 的方法是? A、zeros B、fill C、create D、constant 参考答案:C

第九章 MLPPPT课件

河北大学工商学院

Industrial & Comerricial College , Hebei University

MLP的程序实现(续)

对应的Matlab程序为:

dE_dW2 = [X1 one]'*(dE_dX2.*(1+X2).*(1-X2));

2020/6/5

河北大学工商学院

Industrial & Comerricial College , Hebei University

2020/6/5

河北大学工商学院

Industrial & Comerricial College , Hebei University

MLP的逼近理论

定理1:令 为有界、非常量的单调递增连续函数,

Id为d维单位超立方体[0,1]d。C(Id)表示定义在Id上的

连续函数构成的集合,则给定任何函数 C(Id)且

根据带有动量项的反传算法有:

2020/6/5

河北大学工商学院

Industrial & Comerricial College , Hebei University

MLP的学习算法(续)

---带有动量项的误差反传算法(续)

误差反传算法的4个步骤:

• 步骤1:初始化网络权重和偏差项

置学习率 和动量常数 使

X2 = tanh([X1 one]*W2);

2020/6/5

河北大学工商学院

Industrial & Comerricial College , Hebei University

MLP的程序实现(续)

对于第p个数据对,网络的训练误差为:

Ep = (t5,p-x5,p)2 + (t6,p-x6,p)2

多层感知机的层次模型

多层感知机的层次模型多层感知机(MLP)是一种深度学习模型,属于前馈神经网络(Feedforward Neural Network)的一种。

MLP由输入层、隐藏层(可以有多层),和输出层组成。

每个层都包含多个神经元,神经元之间的连接有权重。

以下是多层感知机的层次模型:1.输入层(Input Layer):•输入层是神经网络的第一层,负责接收原始数据特征。

•每个输入神经元对应输入数据的一个特征。

•输入层的神经元数目等于输入数据的特征数。

2.隐藏层(Hidden Layers):•隐藏层位于输入层和输出层之间,是神经网络的核心组成部分。

•每个隐藏层包含多个神经元,神经元之间相互连接,连接带有权重。

•每个神经元在隐藏层中通过激活函数处理加权输入。

•多层表示隐藏层可以有多个,构成深度神经网络。

3.输出层(Output Layer):•输出层位于神经网络的最后一层,负责产生网络的输出。

•输出层的神经元数量通常取决于任务的性质,例如二分类任务有一个神经元,多分类任务有多个神经元。

•输出层的每个神经元对应一个可能的类别或预测值。

4.权重和偏差(Weights and Biases):•每个连接都有一个权重,用于调整输入的影响。

•每个神经元都有一个偏差(bias),用于调整神经元激活的阈值。

5.激活函数(Activation Functions):•激活函数在神经元内部引入非线性性,允许网络学习复杂的映射。

•常见的激活函数包括ReLU(Rectified Linear Unit)、Sigmoid、和Tanh等。

多层感知机通过多个隐藏层的组合,可以学习到更复杂的特征和表示,使得模型能够适应更复杂的任务。

深度学习模型中的层次结构和权重参数通过反向传播算法进行训练,优化模型的预测能力。

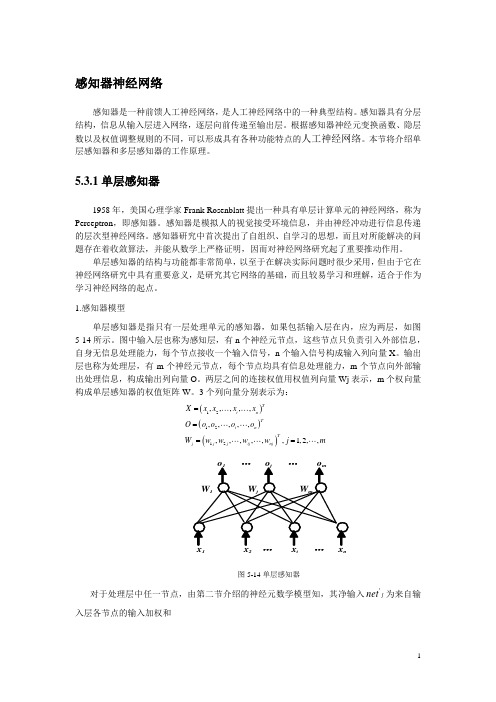

感知器神经网络

感知器神经网络感知器是一种前馈人工神经网络,是人工神经网络中的一种典型结构。

感知器具有分层结构,信息从输入层进入网络,逐层向前传递至输出层。

根据感知器神经元变换函数、隐层数以及权值调整规则的不同,可以形成具有各种功能特点的人工神经网络。

本节将介绍单层感知器和多层感知器的工作原理。

5.3.1单层感知器1958年,美国心理学家Frank Rosenblatt 提出一种具有单层计算单元的神经网络,称为Perceptron ,即感知器。

感知器是模拟人的视觉接受环境信息,并由神经冲动进行信息传递的层次型神经网络。

感知器研究中首次提出了自组织、自学习的思想,而且对所能解决的问题存在着收敛算法,并能从数学上严格证明,因而对神经网络研究起了重要推动作用。

单层感知器的结构与功能都非常简单,以至于在解决实际问题时很少采用,但由于它在神经网络研究中具有重要意义,是研究其它网络的基础,而且较易学习和理解,适合于作为学习神经网络的起点。

1.感知器模型单层感知器是指只有一层处理单元的感知器,如果包括输入层在内,应为两层,如图5-14所示。

图中输入层也称为感知层,有n 个神经元节点,这些节点只负责引入外部信息,自身无信息处理能力,每个节点接收一个输入信号,n 个输入信号构成输入列向量X 。

输出层也称为处理层,有m 个神经元节点,每个节点均具有信息处理能力,m 个节点向外部输出处理信息,构成输出列向量O 。

两层之间的连接权值用权值列向量Wj 表示,m 个权向量构成单层感知器的权值矩阵W 。

3个列向量分别表示为:()()()121212,,,,,,,,,,,,,,,,1,2,,T i n Ti n Tj j j ij nj X x x x x O o o o o W w w w w j m====图5-14单层感知器对于处理层中任一节点,由第二节介绍的神经元数学模型知,其净输入j net '为来自输入层各节点的输入加权和∑==ni i ij j x w net 1'(5-26)输出o j 为节点净输入与阈值之差的函数,离散型单计算层感知器的转移函数一般采用符号函数。

(完整版)神经网络试卷(A卷)(含答案)

20 08 –20 09 学年第 一 学期 考试方式: 开卷[ ] 闭卷[√]课程名称: 神经网络使用班级: 计算机科学与技术(医学智能方向)06 班级: 学号: 姓名: 一、单项选择题(每空2分,共30分)1. 人工神经网络的激活函数主要有三种形式,下面(A )对应的是非线性转移函数, ( B )对应的是对应的是域值函数,( C )分段线性函数。

()()101)f())f )01e 1, 1f , 11)f 01, 1v A v B v C v v v v v v D v v ≥⎧==⎨-<+⎩≥⎧⎪=-<<=⎨⎪-≤-⎩()2. 根据神经元的不同连接方式,可将神经网络分为两大类:分层网络和相互连接型网络。

分层网络将一个神经网络模型中的所有神经元按照功能分成若干层。

一般有输入层、隐含层(中间层)和输出层,各层顺次连接。

下面图形(D )对应的是相互连接型网络,图形(C )对应的是层内互联的前向网络,图形( B)对应的是具有反馈的前向网络,图形( A)对应的是单纯的前向网络。

······x 1x 2x n12m······x 1x 2x n12m······x 1x 2x n12m······x 1x 2x n12ma)b)c)d)3. 在MATLAB中,下面的(○3)命令可以使用得下次绘制的图和已经绘制的图将不在同一张图上。

A) hold on(设置在同一张图绘制多条曲线)B) figure (下次的图和已绘制的不在同一张图上)C) plot D) hold off(取消在同一张图绘制多条曲线)3.下面是一段有关向量运算的MATLAB代码:>>y= [3 7 11 5];>>y(3) = 2运算后的输出结果是(○8)A) 3 2 11 5 B) 3 7 2 5C) 2 7 11 5 D) 3 7 11 24. 下面是一段有关矩阵运算的MATLAB代码:>>A = [1 2 3 4; 5 6 7 8; 9 10 11 12];>>B = A(2,1:3)取出矩阵A中第二行第一个到第三个构成矩阵B若A(2,3)=5将矩阵第二行第三列的元素置为5A=[A B’]将B转置后,再以列向量并入AA(:,2)=[]删除第二列:代表删除列A([1,4],:)=[]删除第一和第四行:代表删除行A=[A;4,3,2,1]加入第四行那么运算后的输出结果是(○9)A) 5 7 8 B) 5 6 8 C) 5 6 7D) 6 7 85.下面对MATLAB中的plot(x,y,s)函数叙说正确的是(○10)A) 绘制以x、y为横纵坐标的连线图(plot(x,y)) B绘制多条不同色彩的连线图(plot(x,y))C) 默认的绘图颜色为蓝色D) 如果s=’r+’,则表示由红色的+号绘制图形6. 如果现在要对一组数据进行分类,我们不知道这些数据最终能分成几类,那么应该选择(○11)来处理这些数据最适合。

mlpclassifier原理

mlpclassifier原理MLPClassifier原理MLPClassifier是一种基于多层感知器(Multilayer Perceptron)的分类器,它是一种人工神经网络算法。

多层感知器是一种前馈神经网络,由多个神经元组成,每个神经元与上一层的所有神经元相连,同时也与下一层的所有神经元相连。

每个神经元都有一个激活函数,用于将输入信号转化为输出信号。

多层感知器由输入层、隐藏层和输出层组成。

输入层接收原始数据,隐藏层通过一系列神经元进行计算和转换,输出层则给出最终的分类结果。

在训练过程中,多层感知器通过不断调整神经元之间的连接权重和阈值,以最小化模型预测结果与实际标签之间的差异。

MLPClassifier的原理基于反向传播算法(Backpropagation),该算法通过不断调整权重和阈值来最小化损失函数。

反向传播算法首先通过前向传播将输入信号从输入层传递到输出层,并计算出模型的预测结果。

然后,通过计算损失函数的梯度,算法可以确定每个神经元对损失函数的贡献,从而根据这些贡献来调整权重和阈值。

这个过程重复进行多次,直到模型的预测结果与实际标签之间的差异达到最小。

在使用MLPClassifier进行分类任务时,需要进行一些参数的设置。

其中,最重要的参数之一是隐藏层的大小和数量。

隐藏层的大小决定了模型的复杂度,而隐藏层的数量则决定了模型的深度。

通常情况下,隐藏层越大,模型越复杂,可以更好地拟合训练数据,但也容易过拟合。

另外,还可以通过设置正则化参数来控制模型的复杂度,以避免过拟合。

MLPClassifier在处理高维数据和非线性问题上表现良好。

它可以应用于各种分类任务,例如图像分类、文本分类、语音识别等。

然而,由于多层感知器的结构相对复杂,MLPClassifier的训练过程通常需要较长的时间和大量的计算资源。

为了提高训练效率和模型性能,可以使用一些技巧,如特征选择、数据预处理和参数调优等。

总结来说,MLPClassifier是一种基于多层感知器的分类器,它通过不断调整神经元之间的连接权重和阈值来最小化模型预测结果与实际标签之间的差异。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

5

三層後向傳送神經網路

6

後向傳送的訓練演算法

步驟 1: 用很小範圍內均勻分佈的亂數設定網路的權重 和臨界值:

2.4 2.4 F , F i i

其中Fi是網路中神經元i的輸入的總數。權重的 初值要一個神經元一個神經元地設定。

7

步驟2:激勵

透過應用輸入x1(p), x2(p), …, xn(p)和期望的輸 出 yd,1(p), yd,2(p), …, yd,n(p)來激勵後向傳送神 經網路。 (a)計算隱含層神經元的實際輸出:

w35 y3 5 0.1 0.5250 (0.1274) 0.0067 w45 y4 5 0.1 0.8808 (0.1274) 0.0112 5 ( 1) 5 0.1 (1) (0.1274) 0.0127

12

執行Exclusive-OR運算的三層網路

13

隱含層或輸出層的某個神經元的臨界值的作用可 用它的權重θ來表示,θ與一個等於1的固定輸入 相連。 權重和臨界值的初值可隨意設定如下:

w13 = 0.5, w14 = 0.9, w23 = 0.4, w24 = 1.0, w35 = 1.2, w45 = 1.1, 3 = 0.8, 4 = 0.1 以及 5 = 0.3

n y j ( p ) sigm oid xi ( p) wij ( p ) j i 1

其中n是隱含層神經元j輸入的個數,sigmoid 為 S形激勵函數。

8

步驟2:激勵(續) (b)計算輸出層神經元的實際輸出:

m yk ( p) sigm oid x jk ( p) w jk ( p) k j 1

14

訓練集的輸入 xl和x2都為1,期望輸出yd,5為0。隱 含層中的神經元3和4的實際輸出為:

(10.510.410.8) y3 sigmoid ( x1w x w ) 1 / 1 e 0.5250 13 2 23 3

y4 sigmoid ( x1w14 x2w24 4 ) 1/ 1 e (10.911.010.1) 0.8808

k 1

l

計算權重的校正:

wij ( p) xi ( p) j ( p)

更新隱含層神經元的權重:

wij ( p 1) wij ( p) wij ( p)

11

步驟 4:疊代

疊代次數p加1,回到步驟 2,重複上述過程直到 滿足誤差要求為止。 舉個例子,考慮如圖 6-10 所示的三層後向傳送 網路,假設網路需要執行的邏輯運算是 Exclusive-OR。回憶一下,單層的感知器不能進 行這樣的運算。這裏使用三層的網路。

多層神經網路

多層感知器是有一個或多個隱含層的前饋神經 網路。

網路包含一個源神經元的輸入層,至少一個計 算神經元的中間層或隱含層,以及一個計算神 經元的輸出層。

輸入信號一層一層地向前傳遞。

1

有兩個隱含層的多層感知器

2

這個層隱藏了什麼?

隱含層“隱含”了它期望的輸出值。隱含層的 神經元不能透過網路的輸入輸出行為來分析。 沒有明顯的方式可以瞭解隱含層的期望的輸出 值。 商用ANN一般有三層或四層,包含一到兩個隱 含層。每層有10~1000個神經元。實驗神經網 路可能有五層甚至六層,包含三到四個隱含層, 有數百萬個神經元。

16

下面計算隱含層中神經元3和4的誤差梯度:

3 y3(1 y3) 5 w35 0.5250 (1 0.5250) ( 0.1274) ( 1.2) 0.0381 4

y4 (1 y4 ) 5 w45 0.8808 (1 0.8808) ( 0.1274) 1.1 0.0147

3

多層網路的學習過程和感知器的一樣。

要給網路提供輸入型樣的訓練集。

網路計算其輸出型樣,如果有錯 —也就是說實 際輸出和期望輸出型樣不一致 —就調節權重來 減小誤差。

4

後向傳送神經網路

在後向傳送神經網路中,學習演算法有兩個階 段。 首先將訓練輸入型樣提供給網路的輸入端。輸 入型樣在網路中一層層地傳送,直到輸出層產 生輸出型樣為止。 如果輸出型樣和網路預期的輸出型樣不同,則 計算誤差,然後從網路的輸出端後向傳送回輸 入端,在傳送誤差時調整權重的值。

w jk ( p) y j ( p)

k ( p)

更新輸出神經元的權重:

w jk ( p 1) w jk ( p) w jk ( p)

10

步驟 3:訓練權重(續) (b)計算隱含層神經元的誤差梯度:

j ( p)

y j ( p) [1 y j ( p)] k ( p) w jk ( p)

現在可以確定輸出層神經元5的實際輸出為:

1.20.8808 1.11 0.3) y5 sigm oid( y3w35 y4w45 5) 1/ 1 e(0.5250 0.5097

因此,得到誤差:

e yd,5 y5 0 0.5097 0.5097

15

下一步是權重訓練。要更新網路中的權重和臨 界值,需要從輸出層後向傳送誤差 e到輸入層。

首先,計算輸出層神經元5的誤差梯度:

y5 (1 y5 ) e 0.5097 (1 0.5097) ( 0.5097) 0.1274

5

接下來,假設學習率參數 α為0.1,確定權重的校 正值:

其中m為輸出層神經元k的輸入個數。

9

步驟 3:訓練權重

修改後向傳送網路中的權重(後向傳送網路向後傳 送與輸出神經元相關的誤差)。 (a)計算輸出層神經元的誤差梯度:

k ( p) yk ( p)

1 yk ( p) ek ( p)

其中 ek ( p) yd ,k ( p) yk ( p) 計算權重的校正: