音频基础知识

数字音频基础知识

第一章数字音频基础知识重要内容⏹声音基础知识⏹结识数字音频⏹数字音频专业知识第1节声音基础知识1.1 声音旳产生⏹声音是由振动产生旳。

物体振动停止,发声也停止。

当振动波传到人耳时,人便听到了声音。

⏹人能听到旳声音,涉及语音、音乐和其他声音(环境声、音效声、自然声等),可以分为乐音和噪音。

✦乐音是由规则旳振动产生旳,只包具有限旳某些特定频率,具有拟定旳波形。

✦噪音是由不规则旳振动产生旳,它包具有一定范畴内旳多种音频旳声振动,没有拟定旳波形。

1.2 声音旳传播⏹声音靠介质传播,真空不能传声。

✦介质:可以传播声音旳物质。

✦声音在所有介质中都以声波形式传播。

⏹音速✦声音在每秒内传播旳距离叫音速。

✦声音在固体、液体中比在气体中传播得快。

✦15ºC 时空气中旳声速为340m/s 。

1.3 声音旳感知⏹外界传来旳声音引起鼓膜振动经听小骨及其他组织传给听觉神经,听觉神经再把信号传给大脑,这样人就听到了声音。

⏹双耳效应旳应用:立体声⏹人耳能感受到(听觉)旳频率范畴约为20Hz~20kHz,称此频率范畴内旳声音为可听声(audible sound)或音频(audio),频率<20Hz声音为次声,频率>20kHz声音为超声。

⏹人旳发音器官发出旳声音(人声)旳频率大概是80Hz~3400Hz。

人说话旳声音(话音voice / 语音speech)旳频率一般为300Hz~3000 Hz(带宽约3kHz)。

⏹老式乐器旳发声范畴为16Hz (C2)~7kHz(a5),如钢琴旳为27.5Hz (A2)~4186Hz(c5)。

1.4 声音旳三要素⏹声音具有三个要素:音调、响度(音量/音强)和音色⏹人们就是根据声音旳三要素来辨别声音。

音调(pitch )⏹音调:声音旳高下(高音、低音),由“频率”(frequency)决定,频率越高音调越高。

✦声音旳频率是指每秒中声音信号变化旳次数,用Hz 表达。

例如,20Hz 表达声音信号在1 秒钟内周期性地变化20 次。

音频基础知识及编码原理

音频基础知识及编码原理音频是我们日常生活中不可或缺的一部分,它通过我们的耳朵传达声音信息。

音频的基础知识和编码原理对于我们理解音频的特性和进行音频处理都是非常重要的。

一、音频基础知识1.音频信号:音频信号是一种连续时间变化的模拟信号,它可以通过声音的压力波来传递声音信息。

在计算机中,音频信号会被采样和量化为离散的数字信号。

2.音频频率:音频频率是指声音中的振荡周期数量。

它以赫兹(Hz)为单位表示,描述了声波的频率。

人类可以听到的频率范围约为20Hz到20kHz,不同的生物和设备有着不同的频率感知范围。

3.音频幅度:音频幅度是指声音的强度或振幅。

它可以通过声音的声压级来表示,单位为分贝(dB)。

声压级越高,声音就越大;声压级越低,声音就越小。

4. 音频声道:音频声道是指音频信号的通道数量。

单声道(mono)只有一个通道,立体声(stereo)有两个通道,多声道(multi-channel)有三个或更多个通道。

5.音频采样率:音频采样率是指音频信号在单位时间内进行采样的次数。

它以赫兹(Hz)为单位表示,描述了数字音频的采样精度。

常见的采样率有44.1kHz和48kHz,高采样率可以提高音频的质量。

二、音频编码原理音频编码是将模拟音频信号转换为数字音频信号的过程。

在音频编码中,采样和量化是两个主要步骤。

1.采样:采样是将连续时间的模拟音频信号转换为离散时间的数字音频信号的过程。

采样率决定了采样的频率,即每秒钟采样的次数。

采样过程会将每个采样点的幅度值记录下来,形成一个采样序列。

2.量化:量化是将连续的模拟音频信号转换为离散的数字音频信号的过程。

它将每个采样点的幅度值映射到一个有限的数值范围内,通常使用固定的比特数来表示每个采样点的幅度。

3.压缩编码:为了减小数字音频的文件大小,音频信号通常会经过压缩编码的处理。

压缩编码可以通过去除信号中的冗余信息或者使用有损压缩算法来实现。

常见的音频压缩编码格式有MP3、AAC和FLAC等。

音频基础知识

音频,英文是AUDIO,也许你会在录像机或VCD的背板上看到过AUDIO输出或输入口。

这样我们可以很通俗地解释音频,只要是我们听得见的声音,就可以作为音频信号进行传输。

有关音频的物理属性由于过于专业,请大家参考其他资料。

自然界中的声音非常复杂,波形极其复杂,通常我们采用的是脉冲代码调制编码,即PCM编码。

PCM通过采样、量化、编码三个步骤将连续变化的模拟信号转换为数字编码。

一、音频基本概念1、什么是采样率和采样大小(位/bit)。

声音其实是一种能量波,因此也有频率和振幅的特征,频率对应于时间轴线,振幅对应于电平轴线。

波是无限光滑的,弦线可以看成由无数点组成,由于存储空间是相对有限的,数字编码过程中,必须对弦线的点进行采样。

采样的过程就是抽取某点的频率值,很显然,在一秒中内抽取的点越多,获取得频率信息更丰富,为了复原波形,一次振动中,必须有2个点的采样,人耳能够感觉到的最高频率为20kHz,因此要满足人耳的听觉要求,则需要至少每秒进行40k次采样,用40kHz表达,这个40kHz就是采样率。

我们常见的CD,采样率为。

光有频率信息是不够的,我们还必须获得该频率的能量值并量化,用于表示信号强度。

量化电平数为2的整数次幂,我们常见的CD位16bit的采样大小,即2的16次方。

采样大小相对采样率更难理解,因为要显得抽象点,举个简单例子:假设对一个波进行8次采样,采样点分别对应的能量值分别为A1-A8,但我们只使用2bit的采样大小,结果我们只能保留A1-A8中4个点的值而舍弃另外4个。

如果我们进行3bit的采样大小,则刚好记录下8个点的所有信息。

采样率和采样大小的值越大,记录的波形更接近原始信号。

2、有损和无损根据采样率和采样大小可以得知,相对自然界的信号,音频编码最多只能做到无限接近,至少目前的技术只能这样了,相对自然界的信号,任何数字音频编码方案都是有损的,因为无法完全还原。

在计算机应用中,能够达到最高保真水平的就是PCM编码,被广泛用于素材保存及音乐欣赏,CD、DVD以及我们常见的WAV文件中均有应用。

电视音频技术的基础知识

电视音频技术的基础知识电视音频技术是指在电视广播和电视节目制作中所涉及的音频相关技术。

音频在电视中扮演着重要的角色,它不仅可以提供声音的传输,还能为观众带来更具沉浸感的观影体验。

以下是一些关于电视音频技术的基础知识。

1. 音频信号:在电视中,声音通过电子设备被转换为可传输的电信号。

这些电信号可以是模拟信号或数字信号。

模拟信号是连续的波形,而数字信号是用离散的数值来表示声音的。

2. 音频编码:为了将声音传输或存储,音频编码技术被使用。

音频编码是将声音信号转换成数字格式的过程。

其中一种常用的音频编码格式是MPEG(Moving Picture Experts Group)音频编码,如MP3。

3. 音频采样率:音频采样率指音频信号在一秒钟内被采样的次数。

常见的音频采样率有44.1kHz和48kHz。

较高的采样率能提供更好的音质,但也需要更多的存储空间和传输带宽。

4. 立体声和多声道声音:电视广播中最常见的音频格式是立体声,它将声音分为左右两个声道进行传输。

而在电影院和一些家庭影院系统中,多声道音频技术被使用。

多声道音频可以提供更真实的环绕声效果,常见的多声道配置包括5.1声道和7.1声道。

5. 声音混合:在电视广播和电视节目制作中,常常需要将不同来源的声音进行混合。

声音混合是指将多个音频信号合并成单一的混合信号。

这样可以控制音量和平衡不同音频源之间的比例。

6. 音频处理:音频处理是指对音频信号进行滤波、均衡和增强等技术。

音频处理可以改善音质,使声音更加清晰和饱满。

7. 音频同步:音频同步是指在电视广播和电视节目制作中保持音频和视频之间的同步。

这是非常重要的,以确保观众可以准确地听到与所看到的画面相符的声音。

总结起来,电视音频技术是一项复杂而重要的技术,它涉及到音频信号的传输、编码、采样率、立体声和多声道音频以及音频处理等方面。

了解这些基础知识可以帮助我们更好地理解和欣赏电视音频的质量和效果。

电视音频技术是电视广播和电视节目制作中至关重要的一部分。

音频入门知识

音频入门知识声音的概念.1. 声音是一种机械振动状态的传播现象,它表现为一种机械被即声波。

产生声波的条件:a) 有作机械振动的物体:声源 b) 有能传播机械振功的弹性介质 声波示意(L. A. Rowe )2.声波频率声压变化可以是周期性的和非周期性 频率概念循环(cycle)- 压缩/稀薄过程 频率(frequency):每秒cycle 数,单位 hertz (Hz) 周期 – cycle 的持续时间 (1/frequency)声音信号一般由许多频率不同的信号组成,称为复合信号;而单一频率的信号称为分量信号时间幅度频率范围频率小于20Hz 一般称为次声波(subsonic)人的听觉器官能感知的声音频率范围约为20Hz~20kHz的信号称为音频(Audio)信号人发音器官发声频率约是80~3400Hz,但人说话的信号频率约为300~3000Hz,即话音(speech)信号高于20kHz的信号称为超声波 (ultrasonic)超声波及次声波一般不能引起人听觉器官的感觉,但可借助一些仪器设备进行观察和测量乐音与噪音1.一般乐音指具有确定的基频以及与该基频有较小整数倍关系的各阶谐频(harmonic tone)2.频率比基音高的所有分音统称泛音(over tone),泛音的频率不必与基音成整数倍关系3.在主观上把令人不愉快或不需要的声音定义为噪音4.噪音的频谱较为复杂,具有无规则的振幅和波形的连续频谱声音三要素1.响度(音响)loudness到达人耳的声扰动振幅所产生的听觉的大小声振动能量是物理特性,可用声强(sound pressure)定义,单位:帕斯卡 (Pa)实用上通常都以对数方式的声压级 (sound pressure level)表示,单位:分贝(db)响度是主观量,不能用任何仪器正确地测量声音响度使用了以两个声强之比的对数为基础的相对标度,单位:宋(sone)2.音调(音高)pitch或tone人对声音刺激频率的主观判断与估量,称之为音调 (Pitch),单位:美(Mel)Frequency是物理量,而音调是人的感觉听觉经验一般女生的声音比男生高较大物体振动的音调较低3.音色(音质)timber由其频谱决定: 不同乐器发出同一音高的乐音,仍然可以分辨可以把音色描述为音的瞬时横截面,即用谐音(泛音)的数目、强度、分布和相位来描述。

音频的基础知识

音频的基础知识一、计算机和网络是怎样存储、处理和传递声音的?计算机和网络存储、处理和传递的是二进制数据。

用二进制数字序列表示声音,是利用现代信息技术处理和传递声音信号的前提。

数字声音的获取有以下两种方式:1、将声音数字化2、利用MIDI设备输入或用计算机软件编写MIDI音乐二、声音的数字化模拟音频信号:声波通过话筒转变为时间上连续的电压波,电压波与引起电压波的声波的变化规律是一致的,因此可以利用电压波来模拟声音信号,这种电压波被称为模拟音频信号。

模拟/数字转换:计算机内部只能处理数字信息,因此必须借助于一种设备,将时间上连续的模拟音频信号转变为用来表示声音的数据序列,计算机才能进行识别和处理,也就是通过话筒以及相关电压放大电路把声波转换成电压的波形。

通过“采样”和“量化”可以实现模拟量的数字化,这个过程称为“模数转换”(A/D转换),承担转换任务的电路和芯片称为“数模转换器”(ADC)采样:按一定的频率,即每个一小段时间,测得模拟信号的模拟量值。

量化:采样时测的的模拟电压值,要进行分级量化。

方法是按整个电压变化的最大幅度划分成几个区段,把落在某区段的采样到的样品值归成一类,并给出相应的量化值。

通过采样和量化,一个连续的波形变成了一系列二进制数字表示的数据。

数字化的声音的质量取决于采样频率和量化分级的细密程度。

量化的分辨率越高,所得数字化的声音的保真程度也越好,数据量也越大。

在播放时,计算机还要将数字信号转化成模拟信号。

例题:在某声音的数字化过程中,使用44.1KHZ的取样频率,16位量化位数,则采集四声道的此声音1分钟所需的储存空间约为__A165.75MB B21.168MBC20.672MB D10.584MB波形声音的码率(kb/s)=44.1 * 16 * 4=2822.4kb/s2822.4kb/s=2822.4/8=352.8KB/s352.8KB/s* 60s=21168KB=20.672MB选C三、MIDI音乐MIDI是音乐设备数字接口。

音频基础知识

一. 音频基础知识1. 音频编解码原理数字音频的出现,是为了满足复制、存储、传输的需求,音频信号的数据量对于进行传输或存储形成巨大的压力,音频信号的压缩是在保证一定声音质量的条件下,尽可能以最小的数据率来表达和传送声音信息。

信号压缩过程是对采样、量化后的原始数字音频信号流运用适,当的数字信号处理技术进行信号数据的处理,将音频信号中去除对人们感受信息影响可以忽略的成分,仅仅对有用的那部分音频信号,进行编排,从而降低了参与编码的数据量。

数字音频信号中包含的对人们感受信息影响可以忽略的成分称为冗余,包括时域冗余、频域冗余和听觉冗余。

1.1 时域冗余A.幅度分布的非均匀性:信号的量化比特分布是针对信号的整个动态范围而设定的,对于小幅度信号而言,大量的比特数据位被闲置。

B.样值间的相关性:声音信号是一个连续表达过程,通过采样之后,相邻的信号具有极强的相似性,信号差值与信号本身相比,数据量要小的多。

C.信号周期的相关性:声音信息在整个可闻域的范围内,每个瞬间只有部分频率成分在起作用,即特征频率,这些特征频率会以一定的周期反复出现,周期之间具有相关关系。

D.长时自我相关性:声音信息序列的样值、周期相关性,在一个相对较长的时间间隔也会是相对稳定的,这种稳定关系具有很高的相关系数。

E.静音:声音信息中的停顿间歇,无论是采样还是量化都会形成冗余,找出停顿间歇并将其样值数据去除,可以减少数据量。

1.2 频域冗余A.长时功率谱密度的非均匀性:任何一种声音信息,在相当长的时间间隔内,功率分布在低频部分大于高频部分,功率谱具有明显的非平坦性,对于给定的频段而言,存在相应的冗余。

B.语言特有的短时功率谱密度:语音信号在某些频率上会出现峰值,而在另一些频率上出现谷值,这些共振峰频率具有较大的能量,由它们决定了不同的语音特征,整个语言的功率谱以基音频率为基础,形成了向高次谐波递减的结构。

1.3 听觉冗余根据分析人耳对信号频率、时间等方面具有有限分辨能力而设计的心理声学模型,将通过听觉领悟信息的复杂过程,包括接受信息,识别判断和理解信号内容等几个层次的心理活动,形成相应的连觉和意境,由此构成声音信息集合中的所以数据,并非对人耳辨别声音的强度、音调、方位都产生作用,形成听觉冗余,由听觉冗余引出了降低数据率,实现更高效率的数字音频传输的可能。

音频的基础知识

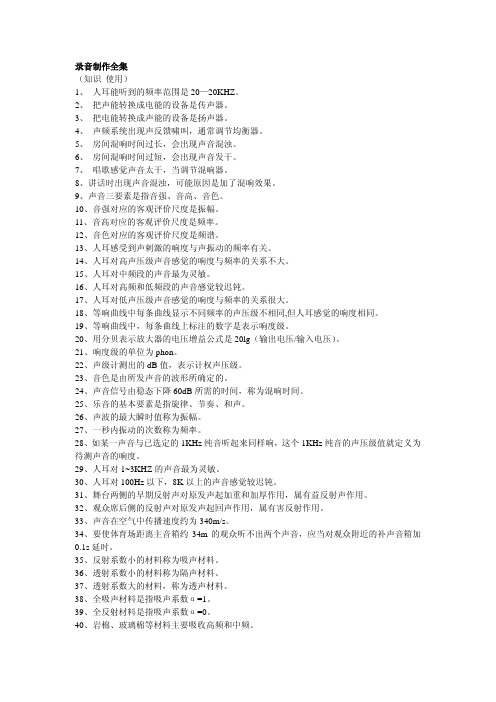

录音制作全集(知识使用)1、人耳能听到的频率范围是20—20KHZ。

2、把声能转换成电能的设备是传声器。

3、把电能转换成声能的设备是扬声器。

4、声频系统出现声反馈啸叫,通常调节均衡器。

5、房间混响时间过长,会出现声音混浊。

6、房间混响时间过短,会出现声音发干。

7、唱歌感觉声音太干,当调节混响器。

8、讲话时出现声音混浊,可能原因是加了混响效果。

9、声音三要素是指音强、音高、音色。

10、音强对应的客观评价尺度是振幅。

11、音高对应的客观评价尺度是频率。

12、音色对应的客观评价尺度是频谱。

13、人耳感受到声剌激的响度与声振动的频率有关。

14、人耳对高声压级声音感觉的响度与频率的关系不大。

15、人耳对中频段的声音最为灵敏。

16、人耳对高频和低频段的声音感觉较迟钝。

17、人耳对低声压级声音感觉的响度与频率的关系很大。

18、等响曲线中每条曲线显示不同频率的声压级不相同,但人耳感觉的响度相同。

19、等响曲线中,每条曲线上标注的数字是表示响度级。

20、用分贝表示放大器的电压增益公式是20lg(输出电压/输入电压)。

21、响度级的单位为phon。

22、声级计测出的dB值,表示计权声压级。

23、音色是由所发声音的波形所确定的。

24、声音信号由稳态下降60dB所需的时间,称为混响时间。

25、乐音的基本要素是指旋律、节奏、和声。

26、声波的最大瞬时值称为振幅。

27、一秒内振动的次数称为频率。

28、如某一声音与已选定的1KHz纯音听起来同样响,这个1KHz纯音的声压级值就定义为待测声音的响度。

29、人耳对1~3KHZ的声音最为灵敏。

30、人耳对100Hz以下,8K以上的声音感觉较迟钝。

31、舞台两侧的早期反射声对原发声起加重和加厚作用,属有益反射声作用。

32、观众席后侧的反射声对原发声起回声作用,属有害反射作用。

33、声音在空气中传播速度约为340m/s。

34、要使体育场距离主音箱约34m的观众听不出两个声音,应当对观众附近的补声音箱加0.1s延时。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

Audio知识简介干一行专一行VS学一行丢一行第一部分:HTS基本概念:HTS(Home Theater System)通俗的讲就是将电影院搬到家里,然后就成了家庭影院,就公司的产品而言可以简单的理解为:DVD/BD player + 功放+ Speaker 组成:节目源(碟片+碟机等)+ 放声系统(AV功放+音箱组等)+显示部分(电视机/投影仪)配置家庭影院的好处:高清晰的如水晶般的画面,环绕的立体声,清晰的人声,震撼的低音效果,可以提供几乎身临其境的感觉。

在强烈的视听冲击下,能感受到现实和虚拟的完美交汇,触发更深的人生感悟。

第二部分:Audio百度定义:1.Audio指人说话的声音频率,通常指300Hz---3400Hz的频带2.指存储声音内容的文件3.在某些方面能指作为波滤的振动。

音频这个专业术语,人类能够听到的所有声音都称之为音频,它可能包括噪音,声音被录制下来以后,无论是说话声,歌声乐器都可以通过数字音乐软件处理。

把它制作成CD,这时候所有的声音没有改变,因为CD本来就是音频文件的一种类型。

而音频只是储存在计算机里的声音,演讲和音乐,如果有计算机加上相应的音频卡,可以把所有的声音录制下来,声音的声学特性,音的高低都可以用计算机硬盘文件的方式储存下来,反过来,也可以把眄来的音频文件通过一定的音频程序播放,还原以前录下的声音。

Audio的分类:按编码格式分类:mp3,wav, aac, ogg, flac, aiff, ac3(亦称之Dolby digital), dts, pcm, Dolby true hd(HD), Dolby digital plus(HD), dts hd master audio(HD), dts hd high resolution audio(HD), dts hd low bit rate(HD)多声道音频的分类:C:center L: left front R: Right frontLS: Left surround RS: right surround S: surround(单个环绕声道)LB:left back surround RB: right back surroundCs: Center surround1.带LFE声道的分法:根据码流中实际的通道数分X的值为0/1,0表示不带LFE通道,1表示含LFE通道1.x C 如1.0 为C,1.1为C+LFE2.x->L+R3.x->C+L+R4.x->L+R+LS+RS5.x->L+R+C+LS+RS6.x->L+R+C+LS+RS+Cs7.x->L+R+C+LS+RS+LB+RB2.不带LFE声音的分法:根据喇叭摆放的位置分其中C/L/R均摆放在前面,LS/RS/S/LB/RB均摆在两边/后面,如下图1/0->C2/0->L+R3/0->C+L+R2/1->L+R+S2/2->L+R+LS+RS3/1->L+R+C+S3/2->L+R+C+LS+RS3/3->L+R+C+LS+RS+Cs3/4->L+R+C+LS+RS+LB+RB3.声音信号的传输:(1)定义及I2S总线构成:I2S(Inter-IC Sound)总线是飞利浦公司为数字音频设备之间的音频数据传输而制定的一种总线标准,该总线专责于音频设备之间的数据人,广泛应用于各种多媒体系统。

一般包含三根CLK总线和多达四根的DATA总线,最多可以传输7.1通道的数据。

MCLK(主时钟):(系统时钟Sys Clock),使系统间能够更好地同步。

SCLK(串行时钟):(位时钟BCLK),即对应数字音频的每一位数据,SCLK都有一个脉冲。

SCLK的频率=2*采样频率*采样位数目前我接触到的采样位数基本上都是32bit ,LRCLK(左右时钟):用于切换左右的数据,LRCLK 为1表示正在传输左声道的数据,为0则表示传输的是右的数据,LRCLK的频率等于采样频率。

SDATA(串行数据):就是用二进制补码表示的音频数据。

由于LRCLK定义为切换左右声道的数据,所以一根DATA线上可以传输两个通道的数据,即两个通道的声音。

最多可以有四根DATA线,最多可以传输8个通道的数据(7.1声道)。

DATA线上通道传输的组合及顺序都有约定的组成:DATA0:L/R DATA1:C/SUB DATA2:LS/RS DATA3:LB/RB(DATA1上也有可能是LS/RS,DATA2上也可能会是C/SUB,具体得参考软件的输出及硬件原理图)目前公司的AUDIO产品大多是2.0/2.1/5.1,分别需要1/2/3根DATA线(2)三种频率之间的关系LRCLK:等于采样频率,采样频率通常有以下几种:8,000 Hz - 电话所用采样率, 对于人的说话已经足够11,025 Hz22,050 Hz - 无线电广播所用采样率32,000 Hz - miniDV 数码视频 camcorder、DAT (LP mode)所用采样率44,100 Hz - 音频 CD, 也常用于 MPEG-1 音频(VCD, SVCD, MP3)所用采样率47,250 Hz - Nippon Columbia (Denon)开发的世界上第一个商用 PCM 录音机所用采样率48,000 Hz - miniDV、数字电视、DVD、DAT、电影和专业音频所用的数字声音所用采样率50,000 Hz - 二十世纪七十年代后期出现的3M 和Soundstream 开发的第一款商用数字录音机所用采样率50,400 Hz - 三菱 X-80 数字录音机所用采样率96,000 或者 192,000 Hz - DVD-Audio一些 LPCM DVD 音轨、BD-ROM(蓝光盘)音轨、和 HD-DVD (高清晰度 DVD)音轨所用采样率2.8224 MHz - SACD、索尼和飞利浦联合开发的称为 Direct Stream Digital 的 1 位sigma-delta modulation 过程所用采样率。

但是在公司接触比较多的只有以下几种采样频率:1FS:32K/44.1KHz/48KHz 2FS: 64KHz/88.2KHz/96KHz4FS: 128KHz/176.4KHz/192KHzFS为frequency sample.LRCLK:在高清码流,dolby true hd/dolby digital plus/dtshd等,又会有传输采样率与码流采样率。

默认情况:高电平时传输的是左声道的数据,低电平时传输的是右声道的数据。

传输采样率指的是这些码流还没有经过解码时的LRCLK。

码流采样率是指解完码之后,如高清码流解成PCM等之后的传输采样频率。

通常的传输采样率为4FS,即为128KHz/176.4KHz/192KHz。

MCLK与LRCLK的倍率关系一般为128/256/384/512MCLK的值可以为8.192MHz / 16.384MHz/ 11.2896MHz /22.5792MHz/ 12.288MHz / 24.576MHz虽然24.576*2,22.5792*2, 16.384*2MHz理论上存在,但是我看到这样的MCLK都是异常情况下的。

(没有声音)SCLK:=2*采样频率*采样位数(通常是32位)=64*采样频率(2.048MHz/4.096MHz/8.192MHz/2.8224MHz/5.6448MHz/11.2896M Hz/3.072MHz/6.144MHz/12.288MHz)其中MCLK/SCLK/LRCLK三者之间的倍数关系很重要,如果声音出现异常或者没有声音,我们可以通过测量这些信号来指导我们调整软件。

例如:在ST309中,我们就要配置0x00reg来配置这些参数。

(3)三种IIS传输格式:根据SDATA数据相对于LRCLK SCLK的位置不同,分为左对齐(使用较少),I2S格式(即飞利浦规定的格式),和右对齐(也叫日本格式,普通格式)举例:标准格式:左对齐格式:以上是理论上的图形,以下是用三根探头的示波器测得的标准的I2S的图示。

第一根黄色线是LRCLK,第二根线是BCLK,第三根线是DATA。

从图中DATA是从BCLK的第二个周期开始的,很容易就看出来这个是属于标准的I2S格式。

3. SPDIF output/HDMI output这里面的东西很多,我把我知道的注意事项写一下:(1)BD player->spdif->BD HTSspdif audio 设置成bitstream,我们知道SPDIF只能传输标清的AUDIO,那么如果BD Player播放的是DTS HD/DOLBY true HD/Dolby digital Plus等高清信号时,BD player 此时输出的会是什么呢?其实传输的还是标清信号,如果是DOLBY TRUE HD的信号,那么会转成标清的AC3即DOLBY DIGITAL信号,同理DTS HD 会转成DTS的信号传输,高清的后环绕通道会丢失,且编码方式都将是标清时相应的编码方式。

注意SPDIF传输的是数字信号:以下是一个比较正常的信号,看到图的高电平处有一个尖峰,(过冲,是信号经过磁珠,电容,电感等元件引起)图中为48K的WAV文件的信号。

下图也是一种能够正常出声音的96K的WAV文件的信号图示。

信号能够大致分0/1如下是一个不正常的同轴信号,信号幅度不一,区分不出0/1(2)BD player->HDMI->BD HTSHDMI audio设置成bitstreamSPDIF只能传输标清信号,HDMI是可以传输高清信号的,但是当HDMI audio设置成bitstream,播放高清信号输出的也并一定是高清信号,例如:播放DOLBY TRUE HD传输到BD HTS可能是标清信号AC3,这里有一个条件就是resolution, 只有将BD Player的setting->TV->resolution设置成1080I或者1080P,这样输出给BD HTS 的信号才是高清信号。

第三部分:audio的处理。

这部分我将audio的音效处理,音量处理,增益平衡都包括了进来。

主要的处理内容有:音效处理类:Dpl2 Dolby prologic 2/DVS dolby vitual speaker/EQ/Bass management/Delay/Tone Control音量处理类:sound tuning/power derating/volume+/-其他:DRCDPL2:Dolby 的算法,DTS公司的类似算法为NEO6,Philips为Ambiound,算法的用途为将2.X声道的数据转化成多通道声音的数据。