最小距离分类法

基于核的最小距离分类法的参数选择方法

参 数பைடு நூலகம் 与类别标准两者在特 征空间里 的距离 ,比较它到各种 类别特征参数 的距离 ,将该像元划并到距离最小的类别。

有多种方法计算空间的距离, 常用的有绝对距离D (, = y嘭)

1- l l  ̄l y 和欧氏距 e , =y 辔 。 离D(辔)1一 1 Y l

在适 当的特 征空间中,核 函数 用人们熟知 的线性分类算

法对非线性关系进行分类。尽管通 过非线性 函数将样本数据 映射到具有高维甚至为无穷位的特征 空间,并在其 中构造最 优分类超平面 ,但在具体求解时并不需要先行计算该线性 函

[ s at T ip p r rp ss e l ersn ih o lsi edt t. h aa tr f ekme fn t ni te sdf cl us o Ab t cI hs a e o oe men aet eg b rocas yt aa esT e r mee e lu c o t i ut q et n r p k t f h s p ot h i s mo i h y i

me o s h t d.

[ ywod lnaet eg b r lsict n d t st; e lu cin Ke r s e sn ih o as ai ; aa e kmefn t r c f o i s o

1 概述

在模式识别 中,最小距离分 类器( N) N 是非常简单并且很 常 用的技术 。目前这种方法演变为基于核函数的最小距离分 类器(NN) K 以应对复杂 的非线性 的方式分类。像其他基于核 的方法一样 , NN也 是受核 函数 的参数 的影响。本文研究使 K 用 目标 函数选择最优 的核 函数参数来提高的 K N 的分类效 N 率 。在众多核函数参 数的选择 方法 中,最经典 的参数 的选择 方法有 2种 : 1选择一系列 的核参数 , () 并且反复地在算法 中运行 。从而选择一个执行效果比较好的参 数来作 为选择 的 参 数。因为参数范 围的原 因,所 以这种方法找不到最优点 。 () 2比较著名 的 “rs—aia o ” ,即把 函数参数 的范 围放 cosvl t n di 到更大的序 列中去 ,但是这种 方法 的时间消耗太大 ,不适用

最短距离法

最短距离法最短距离法是最近年来在分类学习和数据挖掘领域中较为流行的一种机器学习方法。

它的目的是从训练数据集中学习,并形成一种可以从新观察中推断出未知数据的判断方法。

本文介绍了最短距离法的基本概念、原理及其应用,结合例子进一步剖析了这种机器学习方法的核心思想。

一、什么是最短距离法最短距离法(k-nearest neighbors algorithm, k-NN)是一种基本分类算法,它通过测量不同特征值之间的距离来确定实例标签(类别)。

它的工作思路是:先从训练集中找出与当前实例(测试数据)最相似的k个实例,然后统计这k个实例中属于每一类别的实例数目,最后把当前实例分类到实例数目最多的类别中。

最短距离法的计算过程可以概括为:给定一个由N个特征表示的实例X,首先求出它到训练集中每个实例的距离,然后取出距离最小的k个实例,统计这k个实例中各类别的实例数,把X分类到实例数最多的类别中。

二、最短距离法的原理最短距离法的思想是,给定一个实例X,将它与训练集中的实例进行对比,利用距离的大小(越小越相似,越大越不相似)来判断X 的类别。

即:“物以类聚,人以群分”的思想。

最短距离法主要有两种距离计算方式:欧几里得距离(Euclidean Distance)和曼哈顿距离(Manhattan Distance),两者的计算方式不同,欧几里得距离适用于连续型变量,曼哈顿距离适用于离散型变量。

三、最短距离法的应用最短距离法的应用是模式分析的一个重要的挖掘工具,其主要用于分类任务。

它可以用于赛车、机器人、运动视觉系统等多种应用中。

由于最短距离法的简单性和高效的计算,它也被广泛应用于对用户行为分析、文档分类、图像分类、文字处理、计算生物学研究和金融研究等领域。

四、例子分析下面以一个简单的例子来说明最短距离法实例分类的过程:假设我们有一组三维数据,其中存在两类,[A类:[10,20,30], [20,30,40], [30,40,50]],[B类:[50,60,70], [60,70,80], [70,80,90]],现有一个需要分类的新实例:[40,50,60],我们使用最短距离法来确定其类别。

最小距离分类法

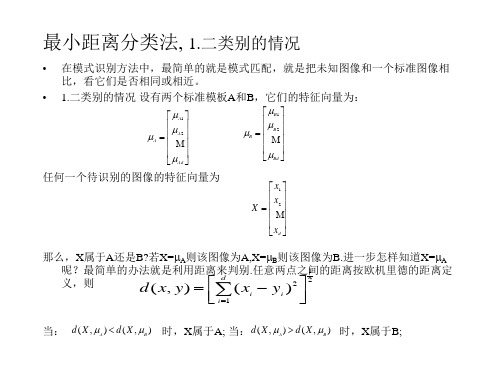

最小距离分类法, 1.二类别的情况

• 在模式识别方法中,最简单的就是模式匹配,就是把未知图像和一个标准图像相 比,看它们是否相同或相近。

• 1.二类别的情况 设有两个标准模板A和B,它们的特征向量为:

A1

A

A2

Ad

B1

B

B

2

Bd

任何一个待识别的图像的特征向量为

x1

X

x2

4.最近邻域分类法

最小距离分类法,是取一个最标准的向量做代表,但是有许多图像,一类中不能只取

一个向量做代表,例如要求识别一类零件中五种相互近似的形状,则一类的代表应该

有五个向量,这样就把最小距离的概念从一个点到一个点的距离扩充到一个点到一组

点之间的距离,如果有m类, 1 2 …m,其向量组分别为1 2… m.每组中有ki个向

则X属于i类

3.决策区域

• 上述分类问题还可以用决策区域来表示,如二类问题,如下图

1

2

R1

R2

对于三类问题,则有三个区:

2 R2

1 R1

3 R3

将模板1 、2做连线,在 做平分线平分线左边为R1 区,右边为R2区,R1,R2 为决策区域。

对于四类问题,则有四个区:

2

R2

1 R1

3 R3

4

R4

上面是针对二维特征向量,界面为线,决策区为平面,对于三维特征向量,界面 为超平面,决策区为空间

类似性的度量,当把分群问题表示成要在一组数据中找出“自然数据群”时,首先应 当确定什么叫“自然数据群”。在某种意义上说,一群里的子样要比其他群的子 样更相像一些。这实质上涉及两个方面,一是如何测定子样之间的类似性,另一 是如何对一组子样分割为一些群的方法进行评价。两个子样之间的类似性(或差 异性)的最显然的一种度量,就是它们之间的距离。首先要定义一个适当的距离 函数,然后计算一对子样之间的距离,距离越小,类似性越大;反之,类似性越 小,若距离是差异的一种好的度量,那么同一群里得子样之间的距离将明显小于 不同群子样之间的距离。因此假定当两个子样之间的距离小于某个阈值0时,就 认为这两个子样属于同一群。显然, 0的选择是很重要的,两个极端, 0太大, 则所有的字样将归于同一群,若太小,则每一群里可能只有一个子样。

试述遥感图像分类的方法,并简单分析各种分类方法的优缺点。

遥感原理与应用1.试述遥感图像分类的方法,并简单分析各种分类方法的优缺点。

答:监督分类:1、最大似然法;2、平行多面体分类法:这种方法比较简单,计算速度比较快。

主要问题是按照各个波段的均值为标准差划分的平行多面体与实际地物类别数据点分布的点群形态不一致,也就造成俩类的互相重叠,混淆不清的情况;3、最小距离分类法:原理简单,分类精度不高,但计算速度快,它可以在快速浏览分类概况中使用。

通常使用马氏距离、欧氏距离、计程距离这三种判别函数。

主要优点:可充分利用分类地区的先验知识,预先确定分类的类别;可控制训练样本的选择,并可通过反复检验训练样本,以提高分类精度(避免分类中的严重错误);可避免非监督分类中对光谱集群组的重新归类。

主要缺点:人为主观因素较强;训练样本的选取和评估需花费较多的人力、时间;只能识别训练样本中所定义的类别,对于因训练者不知或因数量太少未被定义的类别,监督分类不能识别,从而影响分结果(对土地覆盖类型复杂的地区需特别注意)。

非监督分类:1、ISODATA; 2、K-Mean:这种方法的结果受到所选聚类中心的数目和其初始位置以及模式分布的几何性质和读入次序等因素的影响,并且在迭代的过程中又没有调整类别数的措施,因此不同的初始分类可能会得到不同的分类结果,这种分类方法的缺点。

可以通过其它的简单的聚类中心试探方法来找出初始中心,提高分类结果;主要优点:无需对分类区域有广泛地了解,仅需一定的知识来解释分类出的集群组;人为误差的机会减少,需输入的初始参数较少(往往仅需给出所要分出的集群数量、计算迭代次数、分类误差的阈值等);可以形成范围很小但具有独特光谱特征的集群,所分的类别比监督分类的类别更均质;独特的、覆盖量小的类别均能够被识别。

主要缺点:对其结果需进行大量分析及后处理,才能得到可靠分类结果;分类出的集群与地类间,或对应、或不对应,加上普遍存在的“同物异谱”及“异物同谱”现象,使集群组与类别的匹配难度大;因各类别光谱特征随时间、地形等变化,则不同图像间的光谱集群组无法保持其连续性,难以对比。

最大似然法和最小距离法分类边界

最大似然法和最小距离法分类边界示例文章篇一:哎呀,我不太懂什么是最大似然法和最小距离法分类边界呢,这听起来好复杂呀!老师在课堂上讲这些的时候,我感觉脑袋都要晕啦!就好像我在森林里迷路,找不到出去的方向。

我看看啊,最大似然法,这是不是就像我们在一堆水果里猜哪种水果最多?比如说有一堆苹果、香蕉和橙子,我们要根据看到的一部分水果来猜哪种水果是这一堆里数量最多的。

那最小距离法呢,是不是有点像我们找自己的小伙伴,谁离我们最近,我们就先找谁玩?我同桌小明就说:“这最大似然法不就是凭感觉猜嘛!”我赶紧反驳他:“才不是呢,这是有根据的推测!” 可他还不服气,哼!老师说最大似然法是通过一些数据来计算哪种可能性最大。

这就好比我们猜考试谁能考最高分,不能随便瞎猜,得看看平时谁学习最认真,作业完成得最好。

而最小距离法呢,老师举了个例子,就好像我们把不同的动物分类,看哪种动物跟哪种动物长得最像,距离最近,就归为一类。

我跟后桌的小红讨论,我说:“这也太难理解啦,怎么才能分得清楚呀?”小红说:“多想想,多做做题目就懂啦。

”我还是有点迷糊,这两种方法到底有啥用呀?难道只是为了让我们头疼吗?后来我发现,其实在生活中也能用到呢。

比如说我们选衣服,要选适合自己的风格,这是不是也有点像在分类?还有选朋友,跟自己兴趣爱好差不多,性格合得来的,不也是一种分类嘛。

我觉得呀,这最大似然法和最小距离法分类边界虽然一开始让人摸不着头脑,但是仔细想想,还是挺有意思的,能帮我们解决好多问题呢!示例文章篇二:哎呀,这“最大似然法”和“最小距离法”分类边界可真是让人头疼!对于我这个还在上学的小朋友来说,一开始听到这两个词,简直就像掉进了一个充满奇怪符号和公式的迷宫里。

咱先来说说这个最大似然法吧。

就好像我们在玩猜谜语的游戏,要从好多好多的可能性里,找出最有可能的那个答案。

比如说,我们要猜一个盒子里有几个红球几个白球,我们通过一次次地从盒子里拿球,然后根据拿出来球的情况去猜盒子里球的分布,这是不是就有点像最大似然法呀?我们就是要找到那个最有可能的情况。

以各类平均值为类中心的最小距离法 原理csdn

以各类平均值为类中心的最小距离法原理csdn1.引言1.1 概述引言部分是文章的开篇,它主要介绍文章的背景和目的。

对于本篇文章来说,概述部分应该包括以下内容:概述部分旨在介绍以各类平均值为类中心的最小距离法的原理及其在实际应用中的重要性。

在数据分析和模式识别领域,聚类分析是一种常用的数据分析方法。

它通过将相似的数据点划分为不同的簇,从而揭示数据中的隐藏模式和结构。

而各类平均值为类中心的最小距离法作为聚类算法的一种,其原理是基于样本点与类中心之间的距离来划分数据簇。

其中,类中心是指数据簇的中心点,而各类平均值指的是各个数据簇中样本点的平均值。

这种聚类方法有着广泛的应用场景,例如在数据聚类中,可以帮助我们将大量的数据点划分为不同的簇,从而理解和发现数据的内在结构。

此外,在模式识别中,该方法也可以帮助我们识别和分类不同的模式。

通过本文,我们将深入探讨各类平均值为类中心的最小距离法的原理和计算方法,并针对其在数据聚类和模式识别中的应用进行案例分析。

最后,我们将总结该方法的优势和局限性,并探讨其未来的发展方向。

总之,以各类平均值为类中心的最小距离法是一种重要的聚类算法,它在数据分析和模式识别中具有广泛的应用前景。

通过本文的介绍和分析,相信读者能够更深入地理解和应用该方法。

1.2文章结构文章结构部分的内容可以如下所示:1.2 文章结构本文将分为三个主要部分来介绍以各类平均值为类中心的最小距离法的原理和应用。

首先,在引言部分我们将对该方法进行概述,并阐明文章的目的。

接着,在正文部分,我们将详细介绍各类平均值为类中心的最小距离法的原理,包括类中心的定义和作用,以及各类平均值的计算方法。

然后,我们将探讨该方法在数据聚类和模式识别中的应用场景和案例。

最后,在结论部分,我们将总结各类平均值为类中心的最小距离法的优势和局限性,并提出未来的发展方向。

通过这样的文章结构,读者将能够全面了解该方法的基本原理和应用领域,以及对其进行深入思考和讨论。

遥感原理与应用第8章 遥感作业

遥感原理与应用第8章遥感作业遥感原理与应用第8章遥感作业第八章遥感图像自动识别分类名词解释:遥感技术图像自动分类光谱特征向量特征空间特征转换特征选择kl转换哈达玛转换kt转换判别函数辨别规则错分概率最小似然法分类最轻距离法分类监督分类非监督分类k均值聚类混为一谈矩阵用户精度制图精度1、遥感图像自动分类:采用决策理论或统计方法,按照决策理论方法,需要从被识别的模式中提取一组反映模式属性的量测值,称之为特征,并把模式特征定义在一个特征空间中,进而利用决策的原理对特征空间进行划分。

2、光谱特征向量:同名地物点在不同波段图像中亮度的观测量构成一个多维的随机向量x,称为光谱特征向量。

3、特征空间:传感器接收器输入的就是一组n个测量值,这一组几个测量值可以看作就是n维空间,称作特征空间。

4、特征变换:是将原有的m个测量值集合并通过某种变换,产生n个(n<=m)新的特征,这种方法称为特征变换。

5、特征选择:从旧有的m个测量值子集中,按某一准则挑选出来n个特征。

6、kl转换:就是一种线性变换,就是就均方误差最轻来说的最佳正交变换。

能将原来多个波段中的有价值信息尽量分散至数目尽可能少的特征图像组中去,达至数据压缩的目的,同时也能够并使代莱特征图像之间互不有关,并使代莱特征图像涵盖的信息内容不重合减少类别的可分性。

7、哈达玛变换:利用哈达玛矩阵作为变换矩阵新实施的遥感多光谱域变换。

8、kt变换:又称穗帽变换,是一种线性特征变换。

将mss影像通过k-t变换得到不同地物类别的分量值,形成的图形像一个穗帽。

9、判别函数:各个类别的辨别区域确认后,某个特征矢量属哪个类别可以用一些函数去则表示和辨别,这些函数就称作判别函数。

10、判别规则:当计算完某个矢量在不同类别判别函数中的值后,我们要确定该矢量属某类就必须得出一个推论的依据。

如若获得函数值最小则该矢量属最大值对应的类别,这种推论的依据我们称作辨别规则。

11、错分概率:是类别判别分界两侧做出不正确判别的概率之和。

最小距离判别法

最小距离判别法

最小距离判别法是一种分类分析的技术,它也被称为最近邻分类法或最近邻判别法。

最小距离判别法是一种基于距离(特征值)的分类算法,用于分类数据集中的对象。

它将输入对象与训练样本中的每个对象进行比较,以计算输入对象与训练样本中每个对象之间的距离。

然后,将训练样本中的最近的邻居分配给输入对象,以决定其类别。

最小距离判别法的基本原理是将新的对象放入训练样本中,并将它与训练样本中的每个对象进行比较,以计算它们之间的距离。

当计算完所有输入对象与训练样本中每个对象之间的距离后,最小距离法将训练样本中最近的邻居分配给输入对象,以决定其类别。

最小距离判别法的优点包括:它是一种简单的分类算法,不需要任何训练;它能够处理数据集中的缺失值;它可以在高维空间中搜索;它可以处理多类别分类问题;它可以处理变量不平衡的数据集;它具有极高的计算效率,可以在短时间内处理大量的数据;它具有高度可扩展性,可以添加新的样本数据。

最小距离判别法是一种经典的分类算法,它具有计算效率高、易于实现等优点,因此广泛应用于数据挖掘、机器研究等领域。

它可以有效地处理数据集中缺失值、变量不平衡和多类别分类等问题,但也存在一些缺点,例如:容易出现过拟合现象,受到距离度量方法的影响等。

因此,在使用最小距离判别

法时,需要结合自身情况,选择合适的距离度量方法,尽量避免过拟合现象的出现。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

对于三类问题,则有三个区:

2

R2 1 3 1 R1 R3 R1

2

R2

3 R3 4 R4

上面是针对二维特征向量,界面为线,决策区为平面,对于三维特征向量,界面 为超平面,决策区为空间

4.最近邻域分类法

最小距离分类法,是取一个最标准的向量做代表,但是有许多图像,一类中不能只取 一个向量做代表,例如要求识别一类零件中五种相互近似的形状,则一类的代表应该 有五个向量,这样就把最小距离的概念从一个点到一个点的距离扩充到一个点到一组 点之间的距离,如果有m类, 1 2 …m,其向量组分别为1 2… m.每组中有ki个向 量, i=[i1, i2… iki],然后再求距离。求这种距离应该计算最近邻距离,用数学表示就 2 是: d ( x, i ) min x iq , q 1,2,..., ki 若

d ( x, i ) x i ( x i )T x i

2

xT x xT i i x i i

T

T

xT x ( xT i i x i i) 式中 x T x ( x T i i T x i i ) 为特征的线性函数,可作为判别函数:

d ( x, i ) min

则x属于i

用这种方法,决策边界将是片状的,例如,一个二分类问题1 2 .设1有两个代 表, 11, 12,设2有三个代表, 21, 22, 23.决策区域的划分如图所示。 这种方法,概念简单,但分 段边界较复杂。如果是非线 性的边界,可用分段线性来 代替。要针对具体的问题进 行处理 近邻法则是一种次优法则,其 产生的错误率要比最小的贝叶 斯错误率大。但是,当子样数 目较多时,其错误率不会超过 贝叶斯错误率的二倍

x1 x X 2 x d

任何一个待识别的图像的特征向量为

那么,X属于A还是B?若X=A则该图像为A,X=B则该图像为B.进一步怎样知道X=A 1 呢?最简单的办法就是利用距离来判别.任意两点之间的距离按欧机里德的距离定 d ( x y )2 2 义,则 d ( x, y )

T

T

T

Gi ( x ) x T x ( x T i i x i i )

T

T

若

Gi ( x ) min

则X属于i类

3.决策区域

• 上述分类问题还可以用决策区域来表示,如二类问题,如下图

1 2

R1

R2

将模板1 、2做连线,在 做平分线平分线左边为R1 区,右边为R2区,R1,R2 为决策区域。 对于四类问题,则有四个区:

i1 i i 2 id x1 x X 2 x d

对任一被识图像X:

计算距离 d ( X , i ) 找出最小的距离,设为 d ( X , i ) 则X属于i类。具体判别时, 2 可用 x y 代替距离进行计算,即

最小距离分类法, 1.二类别的情况

• • 在模式识别方法中,最简单的就是模式匹配,就是把未知图像和一个标准图像相 比,看它们是否相同或相近。 1.二类别的情况 设有两个标准模板A和B,它们的特征向量为:

A1 A A2 Ad B1 B B2 Bd

i 1

i

i

当: d ( X , A ) d ( X , B ) 时,X属于A; 当: d ( X , A ) d ( X , B ) 时,X属于B;

2.多类别的情况

设有m类,=[1 2 …m],每一类Байду номын сангаас一堆向量,从每一堆向量中,挑出一个最标准的 为代表,称为图像的原型。如i类, 其原型的特征向量为:

11 R1

21

22 R2 23

12 R1

5.聚类分类法

聚类分类法,又名聚合分类法或称群分技术。它与上述方法不同。 (1)聚合分类, 聚合分类是一种分类方法,它是把特征空间中彼此靠近的点归属于 同一类,称为子类,也称为分群技术。实际上就是用一个准则函数,比如说这个 准则函数是数据到各个群的中心距离的平方和,然后找一个使准则函数极小的分 群方法。从这种观点出发,就去找每一类中点与点之间的距离,使其最小化。这 种方法的优点在于简单方便。 类似性的度量,当把分群问题表示成要在一组数据中找出“自然数据群”时,首先应 当确定什么叫“自然数据群”。在某种意义上说,一群里的子样要比其他群的子 样更相像一些。这实质上涉及两个方面,一是如何测定子样之间的类似性,另一 是如何对一组子样分割为一些群的方法进行评价。两个子样之间的类似性(或差 异性)的最显然的一种度量,就是它们之间的距离。首先要定义一个适当的距离 函数,然后计算一对子样之间的距离,距离越小,类似性越大;反之,类似性越 小,若距离是差异的一种好的度量,那么同一群里得子样之间的距离将明显小于 不同群子样之间的距离。因此假定当两个子样之间的距离小于某个阈值0时,就 认为这两个子样属于同一群。显然, 0的选择是很重要的,两个极端, 0太大, 则所有的字样将归于同一群,若太小,则每一群里可能只有一个子样。 若用距离作为差异度的度量,则意味着特征空间是各向同性的,所以由距离确定的群 关于平移和旋转是不变的,但是对于一般的线性变换,这种分群就有可能改变, 为了使其不变,可在分群之前把数据标准化。