2014.信息论.第2章信息的统计度量

合集下载

第二章信息的统计度量

1.2.1互信息量 • 1.定义:对两个离散随机事件集X和Y,事件Yi的出现给出关于

I 事件Xi的信息量定义为互信息量( xi ; yi )

。其定义式为

I ( xi ; yi )def log

p( xi | yi ) p( xi )

(1 4)

互信息量的单位与自信息量的单位一样取决于对数的底。 由式(1-4)又可得到

可见,当事件xi,yi统计独立时,其互信息量为零。这意味着不能 从观测yi获得关于另一个事件xi的任何信息。

3).互信息量可正可负

由于 1 1 I ( xi ; yi )def log log p( xi ) p( xi | yi )

在给定观测数据yi的条件下,事件xi出现的概率P(xi| yi)大于先验 概率P(xi)时,互信息量I(xi; yi)大于零,为正值;当后验概率小 于先验概率时,互信息量为负值。 互信息量为正,意味着事件yi的出现有助于肯定事件xi的出现;反之, 则是不利的。造成不利的原因是由于信道干扰引起的。

式中,xi Yi积事件,p (xi Yi)为元素xi Yi的二维联合概率。

当xi Yi独立时I(xi

Yi)= I(xi)+ I(Yi)

1.1.2 条件自信息量

联合集XY中,对事件Xi和Yi,事件Xi在事件Yi给定的条件下的条件自信息量 定义为

I ( xi | yi )def log p ( xi | yi )

1奈特=log2 e比特≈1.443比特

1哈脱来=log2 10比特≈3.322比特

3)信息量的性质:

a)非负性

b)P=1 I=0

c)P=0 I=

d)I是p的单调递减函数

3)联合自信息量

信息论第二章信息的度量

+ I (u1; ui︱u2 … u i-1)+ … + I (u1; uN︱u2 … uN -1)

(2-10)

2.条件互信息量

三维X Y Z联合集中,在给定条件zk的情况下, xi , yj的互信息量I(xi ;yj︱zk )定义为:

I(xi ; y j

zk ) log

p(xi y j zk ) p(xi zk )

(1)甲找到乙这一事件是二维联合集X Y上的等概分

布

p( xi

y

j

)

1 60

,这一事件提供给甲的信息量为

I(xi yj ) = - log p(xi yj ) = log 60 = 5.907(比特)

(2)在二维联合集X Y上的条件分布概率为 事件提供给甲的信息量为条件自信息量

p( y j

xi

)

1 12

一个事件的自信息量就是对其不确定性的度量。 互信息量则表明了两个随机事件的相互约束程度。

对于随机事件集X = {x1,x2,…,xi,…,xI}中的随机事 件xi,其出现概率记为q(xi),将两个事件xi ,yj同时出现的概率 记为p(xi yj),则q(xi) ,p(xi yj)应满足:

qiI(1xqi )(xi

(2-11)

3.互信息量的性质

(1)互易性 ————对称性

I(xi ;yj )= I(yj ; xi)

(2-12)

(2)可加性:

I(u1;u2u3uN ) I(u1;u2) I(u1;u3 u2) I(u1;ui u2 ui1) I(u1;uN u2 uN1)

(3)当xi ,yj统计独立时,互信息量I(xi ;yj) = 0及条件互

率加权平均值(统计平均值),即平均自信息量 H(X)定义为:

(2-10)

2.条件互信息量

三维X Y Z联合集中,在给定条件zk的情况下, xi , yj的互信息量I(xi ;yj︱zk )定义为:

I(xi ; y j

zk ) log

p(xi y j zk ) p(xi zk )

(1)甲找到乙这一事件是二维联合集X Y上的等概分

布

p( xi

y

j

)

1 60

,这一事件提供给甲的信息量为

I(xi yj ) = - log p(xi yj ) = log 60 = 5.907(比特)

(2)在二维联合集X Y上的条件分布概率为 事件提供给甲的信息量为条件自信息量

p( y j

xi

)

1 12

一个事件的自信息量就是对其不确定性的度量。 互信息量则表明了两个随机事件的相互约束程度。

对于随机事件集X = {x1,x2,…,xi,…,xI}中的随机事 件xi,其出现概率记为q(xi),将两个事件xi ,yj同时出现的概率 记为p(xi yj),则q(xi) ,p(xi yj)应满足:

qiI(1xqi )(xi

(2-11)

3.互信息量的性质

(1)互易性 ————对称性

I(xi ;yj )= I(yj ; xi)

(2-12)

(2)可加性:

I(u1;u2u3uN ) I(u1;u2) I(u1;u3 u2) I(u1;ui u2 ui1) I(u1;uN u2 uN1)

(3)当xi ,yj统计独立时,互信息量I(xi ;yj) = 0及条件互

率加权平均值(统计平均值),即平均自信息量 H(X)定义为:

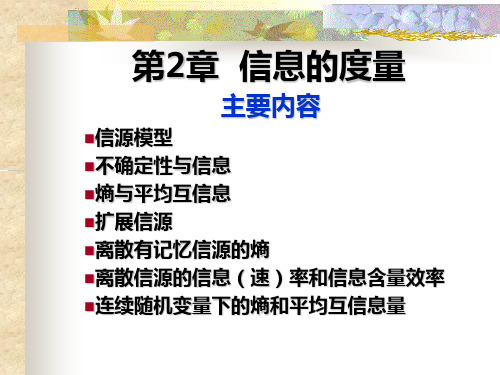

第2章 信息的统计度量

熵函数的数学特性5 可加性

H(X, Y) = H(X) + H(Y|X) 当X、Y相互独立时, H(X, Y) = H(X)+H(Y)

1 0.9

H(p,1-p)

熵函数的数学特性6 极值性

0.8 0.7 0.6 0.5 0.4 0.3 0.2 0.1 0

p( x | y ) I ( x; y ) log 0 正: p( x) y的出现有助于肯定x的出现 p( x | y ) x:张三病了。 1 p ( x | y ) p( x) y:张三没来上课。 p( x) 负: p( x | y ) 0 y的出现有助于否定x的出现 I ( x; y ) log p( x)

规定:0log0 = 0

自信息量的含义

自信息量表示了一个事件是否发生的不确 定性的大小。一旦该事件发生,就消除了 这种不确定性,带来了信息量,即: 自信息量表示了一个事件的发生带给我们 的信息量的大小。 自信息量表示了确定一个事件是否发生, 所需的信息量的大小。 自信息量表示了将事件的信息量表示出来, 所需的二进制位的个数。

p(x):x出现的概率 I(x):x的不确定性 p(x|y):y出现之后 I(x|y):知道y之后仍然保留的关于 x出现的概率 x的不确定性

后验概率

衡量的都是不确定性

条件自信息量的例子

事件:

x=“美国总统的专机发生空难” y=“今天是9.11”

概率:

p(x)= 0.01% p(x|y)=1%

信息论与编码理论 第2章 信息的统计度量

主要内容 从概率的角度研究问题

自信息量 互信息量 平均自信息量 平均互信息量

信息论信息的统计度量

前面已求出自信息量和条件自信息量为:

I ( x) = 13.2877

而x和y的互信息量为:

I ( x | y ) = 6.6439

p( x | y) 1% I ( x; y ) = log = log = log100 = 6.6439 p( x) 0.01% = I ( x) − I ( x | y )

−3×105

log10

−3×105

≈ 106

平均每篇千字文可提供的信息量: 平均

Y = { y1 , y2 ,..., y100001000 }

10 4000 i =1

1 p ( yi ) = = 10 − 4000 100001000

10 4000 i =1

H (Y ) = − ∑ p ( yi ) log p ( yi ) = − ∑10 − 4000 log 10 − 4000 ≈ 1.3 ×10 4

连续信号

时间

插值 离散化

幅度

离散时间信号

时间

离散信号

时间

2.1 自信息量和条件自信息量

定义2.1.1 任意随机事件的自信息量定义为该事件发生概 定义 率的对数的负值。 假设事件xi发生的概率为p(xi),则其自信息定义式为

7 6

I ( xi ) = − log p ( xi )

5

自 信 息 量

4

3

条件自信息量的例子

例2.1.2 设xi表示棋子落入第i行; yj表示棋子落入第 j列, i, j =1,2,…,8,则 (1)

1 p ( xi y j ) = 64

I ( xi y j ) = − log p ( xi y j ) = log 64 = 6 I ( y j | xi ) = − log p ( y j | xi ) = log 8 = 3

第2章信息的度量

P( zl )

1 64

l 1, 2, , 64

P( zl

|

xk

)

1 8

l 1, 2, , 64; k 1, 2, ,8

(1)

I (zl

)

log

P( zl

)

log

1 64

6

bit/符号

(2)

I (zl

|

xk

)

log

P( zl

|

xk

|)

log

1 8

3

bit/符号

4 自信息量的性质和相互关系

KJ

P(xk , y j ) 1

k 1 j1

联合符号 (xk , 的y j )先验不确定性称为联合自信息量 : I (xk , y j ) log P(xk , y j ) bit/二元符号

多元联合符号的联合自信息量

三元符号的自信息量为: I (xk , y j , zl ) log P(xk , y j , zl ) bit/三元符号

统计平均意义下的不确定性有: 熵、条件熵和联合熵。

先介绍各种不确定性的度量方法,然后再引入信息的 度量方法。

1 自信息量

DMS

X

{x1, x2 , , xK }

[ X , PX ] [xk , P(xk ) | k 1 , 2 , , K ]

K

P(xk ) 1

k 1

I (xk ) :xk 的(先验)不确定性 ,也称为 的xk自信息量 。

I (xk

)

log

1 P( xk

)

log

P( xk

)

k 1, 2,, K

注:自信息量与信息有联系,但不是信息,而 是符号的先验不确定性。

信息论与编码第二章信息的度量

14

2.1.1 自信息量

(1)直观定义自信息量为:

收到某消息获得的信息量 = 不确定性减少的量

= 收到此消息前关于某事件发生的不确定性 收到此消息后关于某事件发生的不确定性

15

2.1.1 自信息量

举例:一个布袋中装有对人手感觉完全 一样的球,但颜色和数量不同,问下面 三种情况下随意拿出一个球的不确定程 度的大小。

18

2.1.1 自信息量

应用概率空间的概念分析上例,设取红球的状 态为x1,白球为x2,黑球为x3,黄球为x4,则 概率空间为: x2 (1) X x1

P( x) 0.99 0.01

( 2)

( 3)

X x1 P( x) 0.5

一、自信息和互信息

二、平均自信息

2.1.2 互信息

三、平均互信息

2.1.1 自信息量

信源发出的消息常常是随机的,其状态存在某种 程度的不确定性,经过通信将信息传给了收信者, 收信者得到消息后,才消除了不确定性并获得了 信息。

获得信息量的多少与信源的不确定性

的消除有关。

不确定度——惊讶度——信息量

第二章:信息的度量

自信息和互信息 平均自信息 平均互信息

2.1.1 自信息(量) (续9)

例4:设在一正方形棋盘上共有64个方格,如果甲将一 粒棋子随意的放在棋盘中的某方格且让乙猜测棋子所 在位置。 (1) 将方格按顺序编号,令乙猜测棋子所在的顺序 号。问猜测的难易程度。

(2)将方格按行和列编号,甲将棋子所在方格的列编 号告诉乙之后,再令乙猜测棋子所在行的位置。问猜 测的难易程度。

自信息是事件发生前,事件发生的不确定性。

信息论编码 第二章信息度量1

50个红球,50个黑球

Y

20个红球,其它4种 颜色各20个

Z

问题:能否度量、如何度量??

2.3.2信源熵数学描述

信源熵

• 定义:信源各个离散消息的自信息量的数学期望 (即概率加权的统计平均值)为信源的平均信息 量,一般称为信源的信息熵,也叫信源熵或香农 熵,有时也称为无条件熵或熵函数,简称熵。 • 公式: n 1 H ( X ) = E[ I ( xi )] = E[log2 ] = −∑ p( xi ) log2 p( xi ) p( xi ) i =1 • 熵函数的自变量是X,表示信源整体,实质上是无 记忆信源平均不确定度的度量。也是试验后平均 不确定性=携载的信息 信息量为熵 • 单位:以2为底,比特/符号 • 为什么要用熵这个词,与热熵的区别?

3

( 2)

∑ p ( x ) = 1, ∑ p ( y

i =1 m i j =1

n

m

j

) = 1,∑ p ( xi / y j ) = 1,

i =1 n

n

概 率 复 习

∑ p( y

j =1 n

j

/ xi ) = 1, ∑ ∑ p ( xi y j ) = 1

j =1 i =1 m

m

( 3) ( 4) (5)

1

对天气x1 ,Q p( x1 / y1 ) = 0,∴不必再考虑x1与y1之间 信息量

对天气 x 2 : I ( x 2 : y 1 ) = log

2

p ( x 2 / y1 ) = log p ( x2 )

2

1/ 2 = 1( bit ) 1/ 4

同理 I ( x 3 : y 1 ) = I ( x 4 : y 1 ) = 1( bit ), 这表明从 y 1 分别得到了

信息论第2章 信息的度量

X 晴 阴 大雨 小雨 P( x) 1/4 1/4 1/4 1/4 1 1 1 1 1 1 1 1 H ( X ) log log log log 2(bit / 符号 ) 4 4 4 4 4 4 4 4

结论:等概率分布时信源的不确定性最大,所 以信息熵(平均信息量)最大。

图2.1 自信息量

2.1.1 自信息

自信息量的单位 常取对数的底为 2,信息量的单位为比特( bit, binary unit )。当 p(xi)=1/2 时, I(xi)=1 比特,即 概率等于1/2的事件具有1比特的自信息量。 若取自然对数(对数以 e为底),自信息量的单 位为奈特(nat,natural unit)。 1奈特=log2e比 特=1.443比特 工程上用以10为底较方便。若以10为对数底,则 自信息量的单位为哈特莱( Hartley)。 1哈特莱 =log210比特=3.322比特 如果取以 r 为底的对数 (r>1) ,则 I(xi)=-logrp(xi) 进 制单位 1r进制单位= log2r比特

I [ P( x3 )] log2 1 1(bit) P ( x3 )

第二次测量获得的信息量 = I [P (x2)] - I [P (x3)]=1(bit) 第三次测量获得的信息量 = I [P (x3)] =1(bit)

至少要获得3个比特的信息量就可确切知道哪个灯泡已坏了。

2.1.2 互信息

I (a2) = -log p(a2) = -log0.2 = 2.32 (比特)

平均摸取一次所能获得的信息量为 : H(X)= p(a1) I (a1) + p(a2) I (a2) =0.72(比特/符号)

熵的含义

结论:等概率分布时信源的不确定性最大,所 以信息熵(平均信息量)最大。

图2.1 自信息量

2.1.1 自信息

自信息量的单位 常取对数的底为 2,信息量的单位为比特( bit, binary unit )。当 p(xi)=1/2 时, I(xi)=1 比特,即 概率等于1/2的事件具有1比特的自信息量。 若取自然对数(对数以 e为底),自信息量的单 位为奈特(nat,natural unit)。 1奈特=log2e比 特=1.443比特 工程上用以10为底较方便。若以10为对数底,则 自信息量的单位为哈特莱( Hartley)。 1哈特莱 =log210比特=3.322比特 如果取以 r 为底的对数 (r>1) ,则 I(xi)=-logrp(xi) 进 制单位 1r进制单位= log2r比特

I [ P( x3 )] log2 1 1(bit) P ( x3 )

第二次测量获得的信息量 = I [P (x2)] - I [P (x3)]=1(bit) 第三次测量获得的信息量 = I [P (x3)] =1(bit)

至少要获得3个比特的信息量就可确切知道哪个灯泡已坏了。

2.1.2 互信息

I (a2) = -log p(a2) = -log0.2 = 2.32 (比特)

平均摸取一次所能获得的信息量为 : H(X)= p(a1) I (a1) + p(a2) I (a2) =0.72(比特/符号)

熵的含义

信息论基础及应用第2章 信源及其信息的统计度量(2)_2.4~2.7

◆需要解决的问题: 它们之间的关系、性质等; 如何计算。

2.5.1 离散无记忆序列信源的熵

◆随机序列 X = XN = (X1, X2,…, XN) 中的各分量之间相互独立,

即 X 是 N 维离散无记忆序列信源,则其概率满足

N

P( x) P(x1x2 xN ) Pi (xi )

i 1

定义式为

I ( X ;YZ ) EX ,Y ,Z [I (x; yz)]

P(x y z)

P(xyz)log

X ,Y ,Z

P(x)

2.4.1 平均互信息

定义2.14 离散联合随机变量集 XYZ 上,在给定 Z 条件下,

由 Y 提供的关于 X 的平均互信息为 I(x;y | z) 在 XYZ 上的

概率P(αi)

1/4 1/8 1/8 1/8 1/16 1/16 1/8 1/16 1/16

信源 X 的熵为: H ( X ) 1 log 2 2 1 log 4 1.5 bit/符号

24ຫໍສະໝຸດ 二次扩展信源 X 2 的熵为:

H ( X ) H ( X 2 ) 1 log 4 4 1 log8 4 1 log16 3 bit/符号

2.4 离散信源的平均互信息

本节主要内容

2.4.1 平均互信息 2.4.2 平均互信息的性质 2.4.3 各类熵之间的关系

2.4.1 平均互信息

1.平均互信息的定义与含义

定义2.11 离散联合随机变量集 XY 上,由 Y 中的事件 y = bj 提供的关于 X 的平均互信息为互信息 I(x,y) 在集合 X 中以后验概率加权的平均值,为

数学期望,称为在给定 Z 条件下由 Y 提供的关于 X 的

2.5.1 离散无记忆序列信源的熵

◆随机序列 X = XN = (X1, X2,…, XN) 中的各分量之间相互独立,

即 X 是 N 维离散无记忆序列信源,则其概率满足

N

P( x) P(x1x2 xN ) Pi (xi )

i 1

定义式为

I ( X ;YZ ) EX ,Y ,Z [I (x; yz)]

P(x y z)

P(xyz)log

X ,Y ,Z

P(x)

2.4.1 平均互信息

定义2.14 离散联合随机变量集 XYZ 上,在给定 Z 条件下,

由 Y 提供的关于 X 的平均互信息为 I(x;y | z) 在 XYZ 上的

概率P(αi)

1/4 1/8 1/8 1/8 1/16 1/16 1/8 1/16 1/16

信源 X 的熵为: H ( X ) 1 log 2 2 1 log 4 1.5 bit/符号

24ຫໍສະໝຸດ 二次扩展信源 X 2 的熵为:

H ( X ) H ( X 2 ) 1 log 4 4 1 log8 4 1 log16 3 bit/符号

2.4 离散信源的平均互信息

本节主要内容

2.4.1 平均互信息 2.4.2 平均互信息的性质 2.4.3 各类熵之间的关系

2.4.1 平均互信息

1.平均互信息的定义与含义

定义2.11 离散联合随机变量集 XY 上,由 Y 中的事件 y = bj 提供的关于 X 的平均互信息为互信息 I(x,y) 在集合 X 中以后验概率加权的平均值,为

数学期望,称为在给定 Z 条件下由 Y 提供的关于 X 的

第二章 信息的度量

McMillan 1956

率失真理论 Shannon Gallager Berger

Huffman码(1952)、Fano码 算术码(1976,1982) LZ码(1977,1978)

压缩编码 JPEG MPEG

纠错码 编码调制理论

网络最佳码

第二章 信息的度量

? 2.1 度量信息的基本思路 ? 2.2 信源熵和条件熵 ? 2.3 互信息量和平均互信息量 ? 2.4 多维随机变量的熵

? 它与日常生活中关于信息的理解不矛盾; ? 它排除了对信息一词某些主观性的含义,是纯粹形

式化的概念;

仙农关于信息定义和度量的局限

? 局限

? 这个定义的出发点是假设事物的状态可以用一个以 经典集合论为基础的概率模型来描述,然而实际存 在的某些事物运动状态很难用一个合适的经典概率 模型来描述,甚至在某些情况下不存在这样的模型;

自信息量

? 自信息量的单位

? 自信息量的单位取决于对数的底; ? 底为2,单位为“比特(bit)”; ? 底为e,单位为“奈特(nat)”; ? 底为10,单位为“哈特(hat)”; ? 1 nat = 1.44bit , 1 hat = 3.32 bit;

仙农关于信息定义和度量的优点

? 优点

? 它是一个科学的定义,有明确的数学模型和定量计 算;

? ? En

?

m

Fk

k?1

, pn

?

m

qk , p{Fk } ?

k?1

qk; 则有 q1 ?

q2 ? .. ? qm pn

?1

这时构成的三个概率空间分别具有熵函数:

H1( p1, p2 ,..., pn ); H 2 ( p1,..., pn?1; q1,..., qm ); 它们之间具有关系: H 2 ? H1 ? pn * H 3

率失真理论 Shannon Gallager Berger

Huffman码(1952)、Fano码 算术码(1976,1982) LZ码(1977,1978)

压缩编码 JPEG MPEG

纠错码 编码调制理论

网络最佳码

第二章 信息的度量

? 2.1 度量信息的基本思路 ? 2.2 信源熵和条件熵 ? 2.3 互信息量和平均互信息量 ? 2.4 多维随机变量的熵

? 它与日常生活中关于信息的理解不矛盾; ? 它排除了对信息一词某些主观性的含义,是纯粹形

式化的概念;

仙农关于信息定义和度量的局限

? 局限

? 这个定义的出发点是假设事物的状态可以用一个以 经典集合论为基础的概率模型来描述,然而实际存 在的某些事物运动状态很难用一个合适的经典概率 模型来描述,甚至在某些情况下不存在这样的模型;

自信息量

? 自信息量的单位

? 自信息量的单位取决于对数的底; ? 底为2,单位为“比特(bit)”; ? 底为e,单位为“奈特(nat)”; ? 底为10,单位为“哈特(hat)”; ? 1 nat = 1.44bit , 1 hat = 3.32 bit;

仙农关于信息定义和度量的优点

? 优点

? 它是一个科学的定义,有明确的数学模型和定量计 算;

? ? En

?

m

Fk

k?1

, pn

?

m

qk , p{Fk } ?

k?1

qk; 则有 q1 ?

q2 ? .. ? qm pn

?1

这时构成的三个概率空间分别具有熵函数:

H1( p1, p2 ,..., pn ); H 2 ( p1,..., pn?1; q1,..., qm ); 它们之间具有关系: H 2 ? H1 ? pn * H 3

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

500*600的一个画面比1000个字的文章提供的信息量大。

36

2.3.2 熵函数的数学特性

– 熵函数H(X)只是其概率分布的函数,当X有q个可能 取值时,是q-1元函数。

37

– 对称性:当概率矢量P=(p1,p2,…,pq)中的各分量的次 序任意变更时,熵值不变。 A地天气情况 晴 阴 雨 B地天气情况 晴 阴 雨

43

例:二元熵函数

X P(x)

=

x1 p

x2 1-p p=0.5等概时, 熵最大为1bit。 p=0,1时, 随机变量的不确 定性消失,熵为0。

H(X) = -plogp-(1-p)log(1-p)=H(p) H(p)/bit 1.0

0

0.5 二元熵函数曲线

1.0

p

44

– 上凸性

是概率分布 的严格上凸函数

• 在接到两次电话后,A获得关于B的互信息量为

• 事件E,F的出现有助于肯定事件B的出现。

28

2.2.3 条件互信息量

– 给定条件 下, 与 之间的互信息量

yj zk

xi

– 联合集XYZ上还存在

与

之间的互信息量

29

yj

一对事件yj zk出现后所提供 的有关xi的信息量I(xi;yjzk),

xi

zk

当取xk为一离散信源x的符号,而λk为其相应概率 时,不等式可写成

47

X

Y

– 可加性

如果有两个随机变量X和Y,它们不是相互独立的,则二 维随机变量X和Y的联合熵,等于X的无条件熵加上当X已 给定时Y的条件概率定义的熵。

48

2.3.3条件熵

• 在已知随机变量Y的条件下,随机变量X的熵称为 集X对集Y的条件熵。是联合集XY上条件自信息 量的数学期望。

条件熵小于等于无条件熵,等式成立的条件是集X集Y相 互独立。 X Y

联合熵小于等于各自熵的和,等式成立的条件是集X集Y 相互独立。

55

2.4平均互信息量

– 互信息量 的重要基础。 是定量地研究信息流通问题

• 但只能描述信源发出某个具体消息 ,信宿收 到某具体消息 时流经信道的信息量,是随 和 变化的随机变量。 • 不能从整体上作为信道中信息流通的测度。

A地人口

<20 其他 >60

信源的熵仅与信源总体的统计特性有关。不能描述事 件本身的具体含义和主观价值。

38

– 非负性 确知信源具有最小熵零。

39

– 确定性(不确定性完全消失)

集合X中只要有一个事件为必然事件,则其余事件 为不可能事件。此时,集合中每个事件对熵的贡献 都为0,因而熵为0。

40

– 扩展性

等于事件zk出现后所提供的有关xi的信息量I(xi;zk),加上给 定事件zk的条件下再出现事件yj所提供的有关xi的信息量。 等于事件yj出现后所提供的有关xi的信息量I(xi; yj ),加上给 定事件yj 的条件下再出现事件zk所提供的有关xi的信息量。 30

2.3 离散集的平均自信息量 2.3.1平均自信息量(熵)

51

2.3.4 联合熵(共熵)

• 联合离散符号集合XY上的每个元素对 的联 合自信息量的数学期望。是二元随机变量不确定 性的度量。

52

2.3.5 各种熵的性质

联合熵等于无条件熵加上条件熵。 证明: X Y

53

等式成立的条件是X和Y统计独立 证明:

X

Y

54

联合熵等于无条件熵加上条件熵。 X Y

8

设在一正方形棋盘上共有64个方格,将方格分别按行和列 编号。如果甲将一粒棋子随意地放在棋盘中的某方格且让 乙猜测旗子所在位置; yj

xiyj

xi

9

由于甲是将一粒旗子随意地放在棋盘中某一方格内,因 此,棋子在棋盘中所处位置为二维等概率分布。二维概率 分布函数为p(xiyj)=1/64,故 在二维联合集XY上的元素xiyj的联合自信息量为

• 小概率事件所包含的不确定性大,自信息量大。 • 大概率事件所包含的不确定性小,自信息量小。 • 概率为1的确定性事件,自信息量为零。

2

• 对数基础知识

log(xy)=logx+logy log(x/y)=logx-logy

3

– 自信息量I(xi)的性质

• • • • I(xi)是非负值; 当P(xi) =1时, I(xi)=0; 当P(xi) =0时, I(xi)= ∞ ; I(xi)是P(xi) 的单调递减函数

32

熵的单位

• 信息熵 信息熵的单位与公式中的对数取底有关。 • 通信与信息中最常用的是以2为底,这时单位 为比特 特(bit),H(X); • 理论推导中用以e为底较方便,这时单位为奈 特(nat), He(X) ; • 工程上用以10为底较方便,这时单位为哈特 (hat), H10(X) 。 • 它们之间可应用对数换底公式进行互换。 1 bit = 0.693 nat = 0.301 hat

• 证明:因为 故上式成立。 • 集中一个事件的概率相对于其他事件的概率很 小时,对集合的熵值的贡献可忽略不计。

41

– 极值性

对于离散随机变量,当其可能的取值等概分布时, 其熵达到最大值。即:

42

证明:

先证明不等式:lnx≤x-1 可令f(x)=lnx–(x-1)

结论:等概率分布时熵最大,不确定性最大。故这一 定理又被称为离散信源最大熵定理。

第二章 信息的统计度量

信息的可度量性是信息论建立的基础; 香农的信息论用事件发生概率的对数来 描述事件的不确定性,得到消息的信息 量,建立熵的概念;熵 熵是香农信息论最 基本最重要的概念。

1

2.1 自信息量和条件自信息量

2.1.1自信息量

– 定义2.1.1 任意随机事件的自信息量定义为该 事件发生概率的对数的负值。

19

2.2互信息量和条件互信息量 2.2.1 互信息量

– 定义2.2.1 对两个离散随机事件集X和Y,事件yj的出 现给出关于事件xi的信息量,定义为互信息量,其 定义式为 xi yj

互信息量等于自信息量减去条件自信息量。是获得的 信息量,或消除的不确定性的度量,等于先验的不确 定性减去尚存在的不确定性。

– 平均互信息量

• 从整体的角度出发,在平均意义上度量每通过一 个符号流经信道的平均信息量。

56

• 互信息量I(xi;yj) 在集XY上的概率加权平 均值称为集合Y与集合X间的平均互信息 量。

10

2.1.2条件自信息量

– 定义2.1.3 联合集XY中,对事件xi和yj,事件xi在事 件yj给定的条件下的条件自信息量定义为

– 条件概率对数的负值,在特定条件下(yj已定)随机事 件xi发生所带来的信息量 – 联合自信息量和条件自信息量也满足非负和单调递 减性。

11

甲将棋子所在方格的行告诉乙之后,再令乙猜测棋子 所在列的位置。 在二维联合集XY上,元素xi相对yj的条件自信息量为

xi

yj

27

例:A某已知其三位朋友B,C,D中必定会有一人晚上到他家, 并且这三人来的可能性均相同,其先验概率 p(B)=p(C)=p(D)=1/3。但这天上午A接到D的电话,说因故不 能来了。下午,A又接到C的电话,说他因晚上要出席一个重 要会议不能来A家。 若把上午D电话作为事件E,则p(D/E)=0,p(B/E)=p(C/E) =1/2 若把下午C电话作为事件F,则p(C/EF)= p(D/EF)=0, p(B/EF)=1 • 在接到D的电话后,A获得关于B的互信息量为

一个离散随机变量X,以不同的取值概率有N个可能取值,

是一个随机变量,不能用来作为整个信源的信息测度。

31

– 定义2.3.1 集X上,随机变量I(xi)的数学期望 定义为平均自信息量,又称作集X的信源 熵,简称熵。

• 熵函数的自变量是X,表示信源整体。集X的平均 自信息量表示集X中事件出现的平均不确定性。 即集X中每出现一个事件平均给出的信息量 • 熵这个名词是香农从物理学中的统计热力学借用 过来的,在物理学中热熵是表示分子混乱程度的 一个物理量。

是已知一随机变量,对另一个随机变量的不确定性的量度 当X表示信源的输出,Y表示信宿的输入时,条件熵 H(X/Y)可表示信宿在收到Y后,信源X仍然存在的 不确定度,即信道的损失。 求条件熵为什么要用联合概率?

49

50

例:已知X,Y

,XY的联合概率为:

p(00)=p(11)=1/8,p(01)=p(10)=3/8,计算条件熵H(X/Y)。 解: 根据条件熵公式

其中, Y代表随机变量; 代表随机事件的某一结果。

15

– 同时考虑行和列,涉及两个随机事件,可用两个离散随 机变量来表示。随机变量X,Y分别取值于集合

其中,

16

yj

xi

yj

xi

作业题

• 有12块银元,其中有一块是假的。真假 银元从外观看完全相同,但假银元的重 量与真银元略有不同。

– 求证,用一架天平称3次即可找出假银元, 并知道假银元是轻是重。 – 给出一种称量方法。

24

若信道无干扰

Y=危险X=危险;Y=安全X=安全

25

X

信道故障(设备故障,人员问题)Y=安全X=安全;

X

信道错误,X,Y取值相反

26

– 任何两个事件之间的互信息量不可能大于其 中任一事件的自信息量。

• 自信息量I(xi)是为了确定事件xi的出现所必须提供 的信息量,也是任何其他事件所能提供的最大信 息量。

35

电视屏上约有500×=3×105个点,按每点有10个不同的灰 5 × 3 10 度等级考虑,则共能组成10 个不同的画面。按等概计 算,平均每个画面可提供的信息量为

另有一篇千字的文章,每字从万字表中选择,共有不同的 千字文N=10 0001 000篇=104 000篇,仍按等概计算,平均每 篇千字文可提供的信息量为