Hadoop常见错误和处理方式_光环大数据Hadoop培训

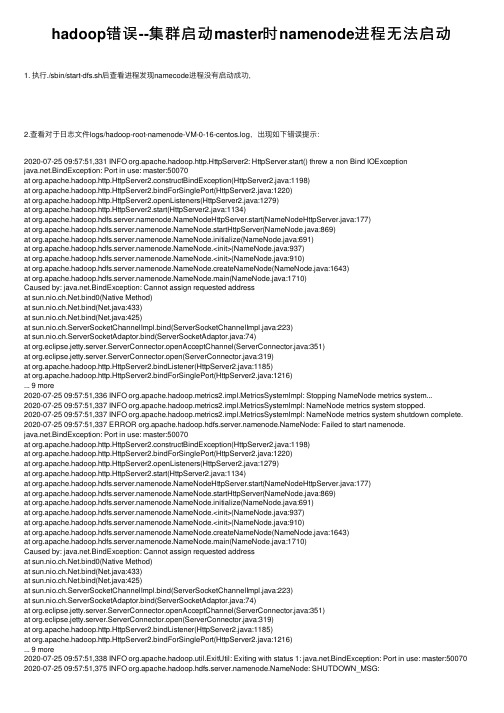

hadoop错误--集群启动master时namenode进程无法启动

hadoop错误--集群启动master时namenode进程⽆法启动1. 执⾏./sbin/start-dfs.sh后查看进程发现namecode进程没有启动成功,2.查看对于⽇志⽂件logs/hadoop-root-namenode-VM-0-16-centos.log,出现如下错误提⽰:2020-07-25 09:57:51,331 INFO org.apache.hadoop.http.HttpServer2: HttpServer.start() threw a non Bind IOException.BindException: Port in use: master:50070at org.apache.hadoop.http.HttpServer2.constructBindException(HttpServer2.java:1198)at org.apache.hadoop.http.HttpServer2.bindForSinglePort(HttpServer2.java:1220)at org.apache.hadoop.http.HttpServer2.openListeners(HttpServer2.java:1279)at org.apache.hadoop.http.HttpServer2.start(HttpServer2.java:1134)at NodeHttpServer.start(NameNodeHttpServer.java:177)at Node.startHttpServer(NameNode.java:869)at Node.initialize(NameNode.java:691)at Node.<init>(NameNode.java:937)at Node.<init>(NameNode.java:910)at Node.createNameNode(NameNode.java:1643)at Node.main(NameNode.java:1710)Caused by: .BindException: Cannot assign requested addressat .bind0(Native Method)at .bind(Net.java:433)at .bind(Net.java:425)at sun.nio.ch.ServerSocketChannelImpl.bind(ServerSocketChannelImpl.java:223)at sun.nio.ch.ServerSocketAdaptor.bind(ServerSocketAdaptor.java:74)at org.eclipse.jetty.server.ServerConnector.openAcceptChannel(ServerConnector.java:351)at org.eclipse.jetty.server.ServerConnector.open(ServerConnector.java:319)at org.apache.hadoop.http.HttpServer2.bindListener(HttpServer2.java:1185)at org.apache.hadoop.http.HttpServer2.bindForSinglePort(HttpServer2.java:1216)... 9 more2020-07-25 09:57:51,336 INFO org.apache.hadoop.metrics2.impl.MetricsSystemImpl: Stopping NameNode metrics system...2020-07-25 09:57:51,337 INFO org.apache.hadoop.metrics2.impl.MetricsSystemImpl: NameNode metrics system stopped.2020-07-25 09:57:51,337 INFO org.apache.hadoop.metrics2.impl.MetricsSystemImpl: NameNode metrics system shutdown complete. 2020-07-25 09:57:51,337 ERROR Node: Failed to start namenode..BindException: Port in use: master:50070at org.apache.hadoop.http.HttpServer2.constructBindException(HttpServer2.java:1198)at org.apache.hadoop.http.HttpServer2.bindForSinglePort(HttpServer2.java:1220)at org.apache.hadoop.http.HttpServer2.openListeners(HttpServer2.java:1279)at org.apache.hadoop.http.HttpServer2.start(HttpServer2.java:1134)at NodeHttpServer.start(NameNodeHttpServer.java:177)at Node.startHttpServer(NameNode.java:869)at Node.initialize(NameNode.java:691)at Node.<init>(NameNode.java:937)at Node.<init>(NameNode.java:910)at Node.createNameNode(NameNode.java:1643)at Node.main(NameNode.java:1710)Caused by: .BindException: Cannot assign requested addressat .bind0(Native Method)at .bind(Net.java:433)at .bind(Net.java:425)at sun.nio.ch.ServerSocketChannelImpl.bind(ServerSocketChannelImpl.java:223)at sun.nio.ch.ServerSocketAdaptor.bind(ServerSocketAdaptor.java:74)at org.eclipse.jetty.server.ServerConnector.openAcceptChannel(ServerConnector.java:351)at org.eclipse.jetty.server.ServerConnector.open(ServerConnector.java:319)at org.apache.hadoop.http.HttpServer2.bindListener(HttpServer2.java:1185)at org.apache.hadoop.http.HttpServer2.bindForSinglePort(HttpServer2.java:1216)... 9 more2020-07-25 09:57:51,338 INFO org.apache.hadoop.util.ExitUtil: Exiting with status 1: .BindException: Port in use: master:50070 2020-07-25 09:57:51,375 INFO Node: SHUTDOWN_MSG:3. 解决⽅案:修改vim /etc/hosts,将本机映射IP修改成内⽹IP(申请的腾讯云主机有内⽹IP和外⽹IP)另外的SecondaryNameNode,资源管理节点等其他slave节点也是同样修改/etc/hosts的本机为当前节点内⽹IP,查看后也恢复 4. 重新执⾏./sbin/start-dfs.sh后查看进程发现namecode进程:。

解决Hadoop使用中常见的问题

解决Hadoop使用中常见的问题在大数据时代,Hadoop已经成为了处理海量数据的重要工具。

然而,随着Hadoop的普及,一些常见的问题也随之出现。

本文将探讨这些问题并提供解决方案,帮助用户更好地使用Hadoop。

一、数据丢失问题在使用Hadoop时,数据丢失是一个常见的问题。

这可能是由于硬件故障、网络问题或软件错误引起的。

为了解决这个问题,我们可以采取以下措施:1. 数据备份:在Hadoop集群中,数据通常会被复制到多个节点上。

这样,即使一个节点发生故障,数据仍然可以从其他节点中恢复。

因此,我们应该确保数据的备份策略已经正确配置。

2. 定期监控:通过监控Hadoop集群的状态,我们可以及时发现并解决数据丢失的问题。

可以使用一些监控工具,如Ambari、Ganglia等,来实时监控集群的健康状况。

二、任务执行时间过长问题在处理大规模数据时,任务执行时间过长是一个普遍存在的问题。

这可能是由于数据倾斜、节点负载不均衡等原因引起的。

为了解决这个问题,我们可以采取以下措施:1. 数据倾斜处理:当某个任务的输入数据不均匀地分布在各个节点上时,会导致某些节点的负载过重,从而影响整个任务的执行效率。

我们可以通过数据倾斜处理算法,如Dynamic Partitioning、Salting等,将数据均匀地分布到各个节点上,从而提高任务的执行效率。

2. 节点负载均衡:通过调整Hadoop集群的配置,我们可以实现节点负载的均衡。

例如,可以使用Hadoop的资源管理器(ResourceManager)来动态分配任务给各个节点,从而使得节点的负载更加均衡。

三、数据安全问题随着大数据的快速发展,数据安全问题变得尤为重要。

在Hadoop中,数据安全主要包括数据的保密性和完整性。

为了解决这个问题,我们可以采取以下措施:1. 数据加密:我们可以使用Hadoop提供的加密功能来保护数据的机密性。

可以使用Hadoop的加密文件系统(HDFS Encryption)来对数据进行加密,从而防止未经授权的访问。

Hadoop基础知识培训

存储+计算(HDFS2+Yarn)

集中存储和计算的主要瓶颈

Oracle IBM

EMC存储

scale-up(纵向扩展)

➢计算能力和机器数量成正比 ➢IO能力和机器数量成非正比

多,Intel,Cloudera,hortonworks,MapR • 硬件基于X86服务器,价格低,厂商多 • 可以自行维护,降低维护成本 • 在互联网有大规模成功案例(BAT)

总 结

• Hadoop平台在构建数据云(DAAS)平台有天 然的架构和成本的优势

成本投资估算:从存储要求计算所需硬件及系统软件资源(5000万用户 为例)

往HDFS中写入文件

• 首要的目标当然是数 据快速的并行处理。 为了实现这个目标, 我们需要竟可能多的 机器同时工作。

• Cient会和名称节点达 成协议(通常是TCP 协议)然后得到将要 拷贝数据的3个数据节 点列表。然后Client将 会把每块数据直接写 入数据节点中(通常 是TCP 协议)。名称 节点只负责提供数据 的位置和数据在族群 中的去处(文件系统 元数据)。

• 第二个和第三个数据 节点运输在同一个机 架中,这样他们之间 的传输就获得了高带 宽和低延时。只到这 个数据块被成功的写 入3个节点中,下一 个就才会开始。

• 如果名称节点死亡, 二级名称节点保留的 文件可用于恢复名称 节点。

• 每个数据节点既扮演者数据存储的角色又 冲当与他们主节点通信的守护进程。守护 进程隶属于Job Tracker,数据节点归属于 名称节点。

hadoop权限错误Permissiondenied:user=root,access=W。。。

hadoop权限错误Permissiondenied:user=root,access=W。

关于不能执⾏Hadoop命令并报权限问题执⾏错误1、Permission denied: user=root, access=WRITE, inode="/":hdfs:supergroup:drwxr-xr-x mkdir: Permission denied: user=root, access=WRITE, inode="/":hdfs:supergroup:drwxr-xr-xput: Permission denied: user=root, access=WRITE, inode="/":hdfs:supergroup:drwxr-xr-x这些类似的权限问题都属于同类问题,他是我说我们的执⾏Hadoop命令的⽤户没有,执⾏权限。

刚开始我想解决问题的思路是,将当前⽤户授权。

(这种想法是不正确的,不要为了简化输⼊命令,就试图修改这些东西)现在的想法:⽤的他指定的⽤户去执⾏[root@cdh1 data]#sudo -u hdfs hadoop fs -mkdir /newFile或者[root@cdh1 data]#sudo -u hdfs dfhs dfs -mkdir /newFile更简单的是,先进⼊这个⽤户,su hdfs然后在这上⾯执⾏相应的命令就ok我顺便说⼀下,为什么会出现这样的问题。

如果你是⽤tar 包解压缩的⽅式,⼿动配置的,肯定不会出现这些问题。

我第⼀次是⽤,cloudera manager 安装,选择的是enterprise 60天的那个。

安装完成也没有问题。

第⼆次是⽤现在这种⽅式安装的。

选择的是第⼀个,免费版。

其实这个也不算是安装上的问题。

因为你⽤yarn安装的时候,他默认会⽤这个⽤户安装,这个就相当于,Linux的超级⽤户,他是Hadoop的超级⽤户组的⽤户。

Hadoop平台上大数据处理的使用教程

Hadoop平台上大数据处理的使用教程大数据处理已经成为当今企业分析和决策制定的关键领域。

Hadoop 作为一个开源的大数据处理平台,提供了一种可靠、可扩展且高效的方式来存储和处理大规模数据。

本教程将为您介绍如何在Hadoop平台上进行大数据处理,并给出详细的操作步骤和示例。

## 第一部分:Hadoop平台的安装和配置1. 下载Hadoop:从Hadoop官方网站获取最新的Hadoop二进制文件,并解压到本地文件夹。

2. 配置Hadoop环境:编辑Hadoop配置文件,设置必要的参数,如文件系统地址、数据节点和任务跟踪器等。

3. 启动Hadoop:通过命令行启动Hadoop集群,可以使用start-all.sh脚本来同时启动所有的Hadoop进程。

## 第二部分:Hadoop中的存储和数据管理1. 分布式文件系统(HDFS):使用Hadoop分布式文件系统来存储大规模数据。

学习如何创建、移动和删除文件,以及如何设置和管理文件的副本。

2. Hadoop YARN:了解Hadoop的资源管理系统,学习如何提交和管理应用程序,并了解如何配置YARN队列来优化任务调度。

3. 数据加载和导入:学习如何将数据加载到Hadoop集群中,可以通过命令行工具或使用Hadoop的数据导入工具,如Sqoop和Flume。

## 第三部分:Hadoop上的数据处理1. MapReduce:学习如何使用MapReduce编写分布式数据处理程序。

使用Java编写Map和Reduce函数,将任务提交到Hadoop集群,并了解如何监视任务的执行。

2. Pig:了解Pig语言,它是一种类似SQL的高级脚本语言,用于高效地进行数据分析和转换。

学习如何编写Pig脚本,并将其提交到Hadoop集群进行执行。

3. Hive:学习如何使用Hive进行数据查询和分析。

了解Hive的数据模型和查询语言(HiveQL),并编写HiveQL脚本来查询和处理数据。

[大数据运维]第28讲:Hadoop平台常见故障汇总以及操作系统性能调优

![[大数据运维]第28讲:Hadoop平台常见故障汇总以及操作系统性能调优](https://img.taocdn.com/s3/m/28f36061b94ae45c3b3567ec102de2bd9605dea2.png)

[⼤数据运维]第28讲:Hadoop平台常见故障汇总以及操作系统性能调优第28讲:Hadoop 平台常见故障汇总以及操作系统性能调优⾼俊峰(南⾮蚂蚁)Hadoop ⽇常运维问题及其解决⽅法1.如何下线⼀个 datanode 节点?当⼀个 datanode 节点所在的服务器故障或者将要退役时,你需要在 Hadoop 中下线这个节点,下线⼀个 datanode 节点的过程如下。

(1)修改 hdfs-site.xml ⽂件如下选项,找到 namenode 节点配置⽂件 /etc/hadoop/conf/hdfs-site.xml:<property><name>dfs.hosts.exclude</name><value>/etc/hadoop/conf/hosts-exclude</value></property>(2)修改 hosts-exclude ⽂件执⾏如下操作,在 hosts-exclude 中添加需要下线的 datanode 主机名:vi /etc/hadoop/conf/hosts-exclude172.16.213.188(3)刷新配置在 namenode 上以 hadoop ⽤户执⾏下⾯命令,刷新 hadoop 配置:[hadoop@namenodemaster ~]$hdfs dfsadmin -refreshNodes(4)检查是否完成下线执⾏如下命令,检查下线是否完成:[hadoop@namenodemaster ~]$hdfs dfsadmin -report也可以通过 NameNode 的 50070 端⼝访问 Web 界⾯,查看 HDFS 状态,需要重点关注退役的节点数,以及复制的块数和进度。

2.某个 datanode 节点磁盘坏掉怎么办?如果某个 datanode 节点的磁盘出现故障,那么该节点将不能进⾏写⼊操作,并导致 datanode 进程退出,针对这个问题,你可以如下解决:⾸先,在故障节点上查看 /etc/hadoop/conf/hdfs-site.xml ⽂件中对应的 dfs.datanode.data.dir 参数设置,去掉故障磁盘对应的⽬录挂载点;然后,在故障节点上查看 /etc/hadoop/conf/yarn-site.xml ⽂件中对应的 yarn.nodemanager.local-dirs 参数设置,去掉故障磁盘对应的⽬录挂载点;最后,重启该节点的 DataNode 服务和 NodeManager 服务即可。

大数据学习踩坑之HADOOP_HOMEandhadoop.home.dirareunset.

⼤数据学习踩坑之HADOOP_HOMEandhadoop.home.dirareunset.问题描述:java.io.FileNotFoundException: HADOOP_HOME and hadoop.home.dir are unset.at org.apache.hadoop.util.Shell.checkHadoopHomeInner(Shell.java:448)at org.apache.hadoop.util.Shell.checkHadoopHome(Shell.java:419)at org.apache.hadoop.util.Shell.<clinit>(Shell.java:496)at org.apache.hadoop.util.StringUtils.<clinit>(StringUtils.java:79)at org.apache.hadoop.fs.FileSystem$Cache$Key.<init>(FileSystem.java:2972)at org.apache.hadoop.fs.FileSystem$Cache$Key.<init>(FileSystem.java:2968)at org.apache.hadoop.fs.FileSystem$Cache.get(FileSystem.java:2830)at org.apache.hadoop.fs.FileSystem.get(FileSystem.java:389)at org.apache.hadoop.fs.FileSystem$1.run(FileSystem.java:171)at org.apache.hadoop.fs.FileSystem$1.run(FileSystem.java:168)at java.security.AccessController.doPrivileged(Native Method)at javax.security.auth.Subject.doAs(Subject.java:422)at erGroupInformation.doAs(UserGroupInformation.java:1844)at org.apache.hadoop.fs.FileSystem.get(FileSystem.java:168)at com.demo.zhulong.utils.FileUtils.uploadToHdfs(FileUtils.java:209)at com.demo.zhulong.controller.ImagesController.upload(ImagesController.java:151)⽇志描述内容很清楚,没有设置 HADOOP_HOME 和 hadoop.home.dir 两项。

Hadoop中的任务失败处理方法探讨

Hadoop中的任务失败处理方法探讨在大数据时代,Hadoop作为一种分布式计算框架,被广泛应用于各个领域。

然而,由于庞大的计算量和复杂的网络环境,Hadoop中的任务失败问题时常出现。

本文将探讨Hadoop中的任务失败处理方法,以提高系统的稳定性和可靠性。

一、任务失败的原因分析Hadoop中的任务失败可以由多种原因引起。

首先,网络故障是常见的原因之一。

由于数据在分布式环境中传输,网络连接的不稳定性可能导致任务失败。

其次,硬件故障也是任务失败的常见原因。

服务器或存储设备的故障可能导致任务无法正常执行。

此外,程序错误、资源不足等因素也可能导致任务失败。

二、任务失败的处理方法1. 任务重试任务重试是最常见的任务失败处理方法之一。

当任务失败时,系统可以自动重新执行该任务,直到成功为止。

任务重试可以通过设置重试次数和时间间隔来控制。

这种方法适用于由于网络故障或临时资源不足导致的任务失败。

2. 容错机制容错机制是一种可以在任务失败时保持系统运行的方法。

Hadoop中的容错机制主要包括备份和故障转移。

备份是指将任务的输入数据和计算结果保存在多个节点上,以防止数据丢失。

故障转移是指当一个节点发生故障时,系统可以自动将任务转移到其他可用节点上继续执行。

容错机制可以提高系统的可靠性和稳定性,但也会增加系统的负载和存储开销。

3. 错误日志和报警及时发现和处理任务失败是保障系统稳定运行的重要环节。

Hadoop中的错误日志和报警机制可以帮助管理员及时发现任务失败,并采取相应的措施。

系统可以记录任务失败的原因和位置,并生成错误日志。

管理员可以通过监控系统的报警机制及时收到任务失败的通知,并进行排查和处理。

4. 自动化监控和调度自动化监控和调度是预防任务失败的重要手段。

Hadoop中的监控系统可以实时监测系统的运行状态和任务执行情况。

当系统出现异常时,监控系统可以自动发出警报,并采取相应的措施。

调度系统可以根据系统负载和资源情况,合理分配任务,避免资源不足和任务失败。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

Hadoop常见错误和处理方式_光环大数据Hadoop培训mysql版本,必须是MYSQL5.1。

查询办法mysqladminversion在建立hive数据库的时候,最好是:createdatabasehive;oozie的数据库,同样:createdatabaseoozie;hadoop采集的字符集问题。

修改/etc/sysconfig/i18n更改字符集为en_US.UTF-8重启机器生效。

重启机器的指令为:在root下敲入如下指令:sync;sync;init6修改mapreduce。

在gateway/性能下修改:MapReduce子Java基础选项、Map任务Java选项库、Reduce 任务Java选项库全部配置成-Xmx4294967296在TASKTRACKER/性能下修改:MapReduce子Java基础选项、Map任务Java选项库、Reduce 任务Java选项库全部配置成-Xmx4294967296必须关注各个任务的详细情况当出现如下的错误的时候,请及时的将下载的进程数调小。

vi/home/boco/oozie_wy/config/lte/mro/ftp/807101.xml将max_thread由原来的6个调整为3个,或者协调厂家加大FTP的最大线程数。

stderrlogs:.ftp.FTPConnectionClosedException:FTPresponse421received.Serv erclosedconnection..ftp.FTP.__getReply(FTP.java:363).ftp.FTP.__getReply(FTP.java:290).ftp.FTP.connectAction(FTP.java:396).ftp.FTPClient.connectAction(FTPClient.java:796).SocketClient.connect(SocketClient.java:172).SocketClient.connect(SocketClient.java:192).SocketClient.connect(SocketClient.java:285)atcom.boco.wangyou.utils.Ftp.connectServer(Ftp.java:550)atcom.boco.wangyou.lte.mro.ftp.tools.FindFileThread.run(FindFileThread.java:67)登录ftp服务器【10.140.177.149】失败,FTP服务器无法打开!.ftp.FTPConnectionClosedException:FTPresponse421received.Serv erclosedconnection..ftp.FTP.__getReply(FTP.java:363).ftp.FTP.__getReply(FTP.java:290).ftp.FTP.connectAction(FTP.java:396).ftp.FTPClient.connectAction(FTPClient.java:796).SocketClient.connect(SocketClient.java:172).SocketClient.connect(SocketClient.java:192).SocketClient.connect(SocketClient.java:285)atcom.boco.wangyou.utils.Ftp.connectServer(Ftp.java:550)atcom.boco.wangyou.lte.mro.ftp.tools.FindFileThread.run(FindFileThread.java:67)登录ftp服务器【10.140.177.149】失败,FTP服务器无法打开!.ftp.FTPConnectionClosedException:FTPresponse421received.Serv erclosedconnection..ftp.FTP.__getReply(FTP.java:363).ftp.FTP.__getReply(FTP.java:290).ftp.FTP.connectAction(FTP.java:396).ftp.FTPClient.connectAction(FTPClient.java:796).SocketClient.connect(SocketClient.java:172).SocketClient.connect(SocketClient.java:192)TASKTRACKER和HDFS组的问题发现部分地方在安装的时候,将所有的机器分组的问题。

如果分组,需要将每个组的参数都要修改。

目前发现很多的地方,TASKTRACKER和HDFS都分了组,但是只修改一组的参数,造成系统大量出问题。

javaheapsize以及tasktracker被拉黑名单的问题。

namenode和datanode的内存配置问题。

建议将使用的内存修改为4G左右。

建议将HIVE2服务放到一个辅节点上。

hive2放到辅节点上,经常出现add_partation挂起报错。

解决HIVE经常挂死的问题修改zookeeper的最大客户端连接数,maxClientCnxns修改为3600或者修改成0不限制自动清空时间间隔,autopurge.purgeInterval修改为1小时厂家XML配置的问题。

如果厂家是这样的:/data/dataservice/mr/ltemro/huawei/20140815/01/362323/TD-LTE_MRO_HUAWEI_010133150 144_362323_20140815011500.xml.gz建议配置成这样的:路径:/data/dataservice/mr/ltemro/huawei/$TIME$/$ENODEB$时间格式:yymmdd/hh在/home/boco/oozie_wy/config/lte/mro/ftp下禁止存放.bak文件有一个省份的mapper数超多,导致解析很长时间没有完成。

进一步发现FTP在合并文件的时候报错,再进一步发现同一个IP地址,同一个OMC启动了三个mapper进程去下载数据导致文件合并失败。

发现是修改了ftp.xml文件,没有删除原来的文件,而是以一个bak文件存放。

删除这些bak文件,mapper数量正常。

原mapper数1731个,删除之后mapper数41个,采集正常。

打开50030看FTP的日志,存在如下的报错:java.io.FileNotFoundException:Filedoesnotexist:/user/boco/cache/wy/ltemro/14110322933 48/xml/155/2014-09-18_11/TD-LTE_MRO_ERICSSON_OMC1_303024_20140918111500.xml.zip node.INodeFile.valueOf(INodeFile.java:39)node.FSNamesystem.getBlockLocationsUpdateTimes (FSNamesystem.java:1341)node.FSNamesystem.getBlockLocationsInt(FSNamesy stem.java:1293)node.FSNamesystem.getBlockLocations(FSNamesyst em.java:1269)node.FSNamesystem.getBlockLocations(FSNamesyst em.java:1242)NodeRpcServer.getBlockLocations(Name NodeRpcServer.java:392)atorg.apache.hadoop.hdfs.protocolPB.ClientNamenodeProtocolServerSideTranslatorPB.getB lockLocations(ClientNamenodeProtocolServerSideTranslatorPB.java:172)atorg.apache.hadoop.hdfs.protocol.proto.ClientNamenodeProtocolProtos$ClientNamenode Protocol$2.callBlockingMethod(ClientNamenodeProtocolProtos.java:44938)atorg.apache.hadoop.ipc.ProtobufRpcEngine$Server$ProtoBufRpcInvoker.call(ProtobufRpcE ngine.java:453)atorg.apache.hadoop.ipc.RPC$Server.call(RPC.java:1002)atorg.apache.hadoop.ipc.Server$Handler$1.run(Server.java:1701)atorg.apache.hadoop.ipc.Server$Handler$1.run(Server.java:1697)atjava.security.AccessController.doPrivileged(NativeMethod)或者:org.apache.hadoop.ipc.RemoteException(node.LeaseE xpiredException):Leasemismatchon/user/boco/cache/wy/ltemro/1411032293348/xml/155/2014-09-18_11/T D-LTE_MRO_ERICSSON_OMC1_3030_20140918.xmlownedbyDFSClient_NONMAPREDUCE_ -1274827212_1butisaccessedbyDFSClient_NONMAPREDUCE_-216613905_1node.FSNamesystem.checkLease(FSNamesystem.java :2459)node.FSNamesystem.checkLease(FSNamesystem.java :2437)pleteFileInternal(FSNamesy stem.java:2503)pleteFile(FSNamesystem.ja va:2480)plete(NameNodeRpc Server.java:535) plete(ClientNamenodeProtocolServerSideTranslatorPB.java:337)atorg.apache.hadoop.hdfs.protocol.proto.ClientNamenodeProtocolProtos$ClientNamenode Protocol$2.callBlockingMethod(ClientNamenodeProtocolProtos.java:44958)atorg.apache.hadoop.ipc.ProtobufRpcEngine$Server$ProtoBufRpcInvoker.call(ProtobufRpcE ngine.java:453)atorg.apache.hadoop.ipc.RPC$Server.call(RPC.java:1002)REDIS故障解析时候报错,错误如下:redis.clients.jedis.exceptions.JedisConnectionException:Couldnotgetaresourcefromthepool atredis.clients.util.Pool.getResource(Pool.java:22)atcom.boco.wangyou.utils.JedisUtils.getJedis(JedisUtils.java:47)atcom.boco.wangyou.utils.JedisUtils.getTableValues(JedisUtils.java:119)atcom.boco.wangyou.lte.mro.tdl.tools.LteMroXMLParser.此问题一般是因为REDIS没有启动导致。