Matlab PSO优化RBF的程序

RBF神经网络:原理详解和MATLAB实现

RBF神经⽹络:原理详解和MATLAB实现RBF神经⽹络:原理详解和MATLAB实现——2020年2⽉2⽇⽬录RBF神经⽹络:原理详解和MATLAB实现 (1)⼀、径向基函数RBF (2)定义(Radial basis function——⼀种距离) (2)如何理解径向基函数与神经⽹络? (2)应⽤ (3)⼆、RBF神经⽹络的基本思想(从函数到函数的映射) (3)三、RBF神经⽹络模型 (3)(⼀)RBF神经⽹络神经元结构 (3)(⼆)⾼斯核函数 (6)四、基于⾼斯核的RBF神经⽹络拓扑结构 (7)五、RBF⽹络的学习算法 (9)(⼀)算法需要求解的参数 (9)0.确定输⼊向量 (9)1.径向基函数的中⼼(隐含层中⼼点) (9)2.⽅差(sigma) (10)3.初始化隐含层⾄输出层的连接权值 (10)4.初始化宽度向量 (12)(⼆)计算隐含层第j 个神经元的输出值zj (12)(三)计算输出层神经元的输出 (13)(四)权重参数的迭代计算 (13)六、RBF神经⽹络算法的MATLAB实现 (14)七、RBF神经⽹络学习算法的范例 (15)(⼀)简例 (15)(⼆)预测汽油⾟烷值 (15)⼋、参考资料 (19)⼀、径向基函数RBF定义(Radial basis function——⼀种距离)径向基函数是⼀个取值仅仅依赖于离原点距离的实值函数,也就是Φ(x)=Φ(‖x‖),或者还可以是到任意⼀点c的距离,c点称为中⼼点,也就是Φ(x,c)=Φ(‖x-c‖)。

任意⼀个满⾜Φ(x)=Φ(‖x‖)特性的函数Φ都叫做径向基函数。

标准的⼀般使⽤欧⽒距离(也叫做欧式径向基函数),尽管其他距离函数也是可以的。

在神经⽹络结构中,可以作为全连接层和ReLU层的主要函数。

⼀些径向函数代表性的⽤到近似给定的函数,这种近似可以被解释成⼀个简单的神经⽹络。

径向基函数在⽀持向量机中也被⽤做核函数。

常见的径向基函数有:⾼斯函数,⼆次函数,逆⼆次函数等。

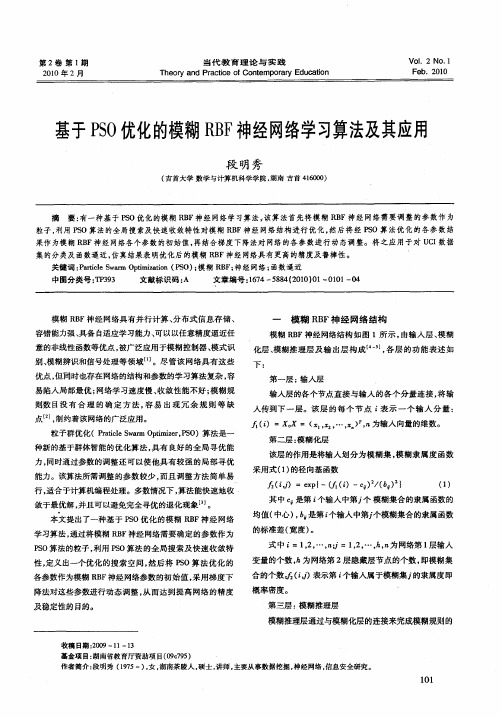

基于PSO优化的模糊RBF神经网络学习算法及其应用

信息 , 即群体共享信息。标准 P O算 法的粒子进化 方程如 S

式( ) ( ) 4 、5 所示 :

枷

则, 完成模糊规则到输 出空间的映射 , 每个节点的输 出为该

节点所有输入信 号的乘积 , : 即

()= . 『 ( () 2

=埘×

+c l×rn ( ad )X( bs —P Pe t ~)+c 2×

下:

意的非线 性函数等优点 , 被广泛应用于模 糊控制器 、 模式识 别、 模糊 辨识 和信 号处理等 领域… 。尽 管该 网络具有 这些 优点 , 但同时也存在网络的结构和参 数的学习算法复杂 , 容

易陷入局部最优 ; 网络学 习速度慢 、 收敛性 能不好 ; 糊规 模

第一层 : 入层 输 输入层的各个节点直 接与输 入 的各个分 量连接 , 输 将 入传到下 一 层。该 层 的 每个 节 点 i 示 一个 输 入 分 量 : 表 ()=X。 = ( , , , ) 9 X l … 1n为输 入 向量的维数 。 "

第 2卷 第 1 期

21 00年 2月

当代 教 育 理 论 与 实 践

T e  ̄ a d Prcie o ne p r r d c t n h o n a t fCo t m o ay E u a i c o

V .2 No. o1 1 F b 00 e .2 1

基于P0 S 优化的 模糊RF B 神经网 络学习 算法及其应用

模糊 R F神 经 网络具 有并行计 算 、 B 分布式信 息存 储 、 容错 能力强、 具备 自适应学习能力、 以以任意精度逼近任 可

一

模糊 R F神 经 网络 结构 B

模糊 R F神经网络结构 如 图 1所 示 , B 由输入层 、 糊 模 化层 、 模糊 推理层 及 输 出层 构成 引, 层 的功 能表 述 如 各

如何优化Matlab程序性能

如何优化Matlab程序性能引言Matlab是一种强大的数学软件,广泛应用于科学计算、数据处理、图像处理等领域。

然而,由于Matlab的解释性质和动态类型,其性能可能受限,特别是在处理大规模数据时。

因此,本文将探讨如何优化Matlab程序的性能,以提高其运行效率。

1. 向量化运算在Matlab中,向量化运算是提高性能的重要手段之一。

通过使用矩阵运算和内置函数,能够减少循环和条件判断的使用,从而加速代码执行。

例如,在计算两个向量的点积时,可以使用内置函数dot()而不是进行循环运算。

此外,还可以使用矩阵运算代替循环计算,如使用矩阵相乘代替逐元素相乘。

2. 预分配内存在编写Matlab代码时,预分配内存可以提高程序的效率。

Matlab在动态分配内存时需要不断重分配和复制数据,这会产生额外的时间开销。

因此,尽量在循环之前确定数组的大小,并使用函数如zeros()或ones()进行预分配,以避免动态分配内存。

3. 使用矩阵运算代替循环Matlab的内置函数和工具箱提供了很多矩阵运算的功能,能够有效减少循环的使用。

通过使用这些函数,能够简化代码,提高程序的可读性和运行效率。

例如,在对矩阵进行转置操作时,可以使用transpose()或者'转置运算符',而不是使用循环逐元素进行转置。

4. 减少内存访问Matlab中的内存访问是一种相对较慢的操作,因此减少内存的访问次数是优化程序性能的关键。

可以通过使用局部变量、避免不必要的数组拷贝等方式减少内存访问。

此外,还可以通过调整数据存储的方式优化内存访问。

例如,将多维数组转换为线性存储的向量,以便减少内存访问的开销。

5. 避免重复计算在Matlab程序中,重复计算是一种常见的性能浪费。

如果某个计算结果在循环中多次使用,可以将其保存在变量中,避免重复计算。

此外,还可以通过使用函数如cumsum()、cumprod()等实现累计计算,避免重复计算累加或累乘的结果。

matlab中的pso算法

粒子群优化(Particle Swarm Optimization,PSO)是一种优化算法,它模拟了鸟群、鱼群等生物的社会行为。

PSO通过迭代搜索来找到最优解。

在MATLAB 中,可以使用pso函数来实现PSO 算法。

以下是一个简单的例子,展示了如何在MATLAB 中使用PSO 算法来找到函数f(x) = x^2的最小值:matlab复制代码% 定义粒子数量和维度numParticles = 20;dim = 1;% 定义搜索空间minPosition = -10;maxPosition = 10;% 定义加速常数c1 = 2;c2 = 2;% 初始化粒子群particles = (minPosition:maxPosition) + rand(numParticles, dim) - minPosition;velocities = zeros(numParticles, dim);scores = zeros(numParticles, 1);% 定义迭代次数numIterations = 500;% 进行迭代for iteration = 1:numIterations% 计算每个粒子的当前适应度值(函数值)scores = psfcn(particles, dim);% 更新粒子的速度和位置velocities = velocities + c1 * rand * (particles(bestIndices, :) - particles) + c2 * rand * (scores(bestIndices, :) - particles);particles = particles + velocities;particles(particles < minPosition) = minPosition;particles(particles > maxPosition) = maxPosition;% 记录每个粒子的历史最佳适应度值和位置bestScores = particles(bestIndices, :);bestPositions = scores(bestIndices, :);end% 输出结果disp('最优位置:');disp(bestPositions);disp('最优函数值:');disp(bestScores);在这个例子中,我们使用了一个简单的函数f(x) = x^2,并希望找到该函数的最小值。

pso算法matlab程序 -回复

pso算法matlab程序-回复主题:PSO算法MATLAB程序PSO(粒子群优化)算法是一种模拟鸟群觅食行为的优化算法,它能够在搜索空间中寻找最优解。

在本文中,将详细介绍如何使用MATLAB 编写PSO算法程序,并进行一步一步的解释。

首先,我们需要明确PSO算法的基本原理。

PSO算法通过模拟鸟群搜索食物的行为,来搜索问题的最优解。

其中,群体中的每个粒子代表一个潜在的解,而每个粒子都有自己的位置和速度。

粒子根据自身经验和整个群体的经验来调整自己的位置和速度,以寻找最优解。

接下来,我们可以开始编写MATLAB程序来实现PSO算法。

第一步,我们需要定义问题的目标函数。

目标函数是确定问题最优解的函数,根据具体问题的不同而不同。

在本文中,以最小化函数为例进行讲解。

假设我们要最小化的函数为f(x),其中x为待求解的参数。

第二步,我们需要定义粒子的初始位置和速度。

粒子的初始位置可以是随机分布在搜索空间中的任意值,而速度可以初始化为零。

我们可以使用MATLAB的随机函数来生成初始位置。

第三步,定义粒子的个体和群体最优位置。

个体最优位置是指粒子自身搜索到的最优解,而群体最优位置是根据整个群体的搜索结果得到的最优解。

第四步,编写主循环。

在主循环中,我们更新每个粒子的速度和位置,直到满足一定的停止条件。

更新速度和位置的公式如下:速度更新公式:v(t+1) = w * v(t) + c1 * rand() * (pbest - x(t)) + c2 * rand() * (gbest - x(t))位置更新公式:x(t+1) = x(t) + v(t+1)其中,v(t)表示t时刻的速度,x(t)表示t时刻的位置,w为惯性权重,c1和c2分别为加速因子1和2,pbest表示粒子的个体最优位置,gbest 表示群体最优位置。

第五步,更新个体和群体最优位置。

对于每个粒子而言,如果t时刻的位置优于个体最优位置,则更新个体最优位置;如果个体最优位置优于群体最优位置,则更新群体最优位置。

板球系统的PSO优化模糊RBF神经网络PID参数研究

板球系统的PSO优化模糊RBF神经网络PID参数研究作者:王长正向凤红毛剑琳来源:《软件导刊》2018年第07期摘要:板球系统是一个典型的多变量、非线性控制系统。

针对板球系统在PID控制中震荡大、精度低、实时性差等问题,应用拉格朗日方程对板球系统在忽略干扰因素条件下进行数学建模,采用粒子群算法对模糊RBF神经网络初始参数进行优化,并设计RBF神经网络与模糊PID控制相结合的控制方法。

在MATALB环境下完成板球系统定位实验,仿真结果表明,经粒子群优化模糊RBF神经网络的PID参数后,提高了板球系统的定位精度,并增强了系统控制的实时性。

关键词:板球系统;粒子群算法;模糊RBF神经网络;MATLAB;PIDDOI:10.11907/rjdk.173124中图分类号:TP301文献标识码:A文章编号:1672-7800(2018)007-0014-05Abstract:Ballandplatesystemisamultivariable,nonlinearandcomplexunderactuateddynamicsystem.Accordingtothefixed-pointcontrolofballandplatesystem,weestablishthemathematicalmodeloftheLagrangeequationignoringtheinterferencefactorsofballandplate system.Aimingattheproblemsinballandplatefixed-pointcontrolsystem,suchasconcussion,lowprecisionandpoorreal-time,wedesignthecontrolmethodbycombiningRBFneuralnetworkwithfuzzyPIDcontrol,andtheinitialparametersoffuzzyRBFneuralnetworkareoptimizedbyparticleswarmoptimization.Thepositi oningcontrolsimulationexperimentofballandplatesystemiscompletedinMATLABenvironment,thesimulationresultsshowthatPIDparametersoffuzzyRBFneuralnetworkwhichoptimizedbyparticleswar moptimizationcanimprovetheprecisionoftheballandplatesystemfixed-pointcontrolandthereal-timenessofthesystem.KeyWords:ballandplatesystem;particleswarmoptimization;fuzzyRBFneuralnetwork;MATLAB;PID0引言板球系统是一个典型的非线性系统,具有强耦合、欠驱动和无约束的特点,是球杆系统的二维扩展,可用于验证控制算法的有效性。

pso算法matlab程序

pso算法matlab程序PSO(粒子群优化)算法是一种启发式优化算法,用于解决各种优化问题。

在Matlab中实现PSO算法可以通过以下步骤进行:1. 初始化粒子群:首先,定义需要优化的目标函数,然后确定粒子群的规模、搜索空间的范围、最大迭代次数等参数。

在Matlab中可以使用数组或矩阵来表示粒子群的位置和速度。

2. 计算适应度:根据目标函数,计算每个粒子的适应度值,以便评估其在搜索空间中的位置的好坏程度。

3. 更新粒子的速度和位置:根据PSO算法的公式,更新每个粒子的速度和位置。

这个过程涉及到调整粒子的速度和位置,使其朝着适应度更高的方向移动。

4. 更新全局最优解:在整个粒子群中找到最优的粒子,即具有最佳适应度值的粒子,然后更新全局最优解。

5. 循环迭代:重复步骤3和步骤4,直到满足停止迭代的条件(如达到最大迭代次数或达到精度要求)。

在Matlab中,可以使用循环结构和数组操作来实现上述步骤。

以下是一个简单的PSO算法的Matlab程序示例:matlab.% 定义目标函数。

function z = objective_function(x)。

z = x(1)^2 + x(2)^2; % 以x1和x2为变量的目标函数示例(可根据实际情况修改)。

% 初始化粒子群。

n = 30; % 粒子数量。

max_iter = 100; % 最大迭代次数。

c1 = 2; % 学习因子。

c2 = 2; % 学习因子。

w = 0.7; %惯性权重。

x = rand(n, 2); % 随机初始化粒子的位置。

v = rand(n, 2); % 随机初始化粒子的速度。

pbest = x; % 个体最佳位置。

pbest_val = zeros(n, 1); % 个体最佳适应度值。

gbest = zeros(1, 2); % 全局最佳位置。

gbest_val = inf; % 全局最佳适应度值。

% 迭代优化。

for iter = 1:max_iter.for i = 1:n.% 计算适应度。

pso算法 matlab程序

pso算法 matlab程序PSO算法,即粒子群优化算法(Particle Swarm Optimization),是一种启发式优化算法,常用于解决搜索和优化问题。

在Matlab中实现PSO算法可以通过以下步骤:步骤1,初始化粒子群。

首先,需要初始化一群粒子,每个粒子都代表了搜索空间中的一个候选解。

每个粒子都有自己的位置和速度。

可以使用随机数函数在搜索空间内随机生成粒子的初始位置和速度。

步骤2,计算适应度。

接下来,需要计算每个粒子的适应度,适应度函数根据具体问题而定。

适应度函数可以是需要最小化或最大化的目标函数。

步骤3,更新粒子的速度和位置。

根据PSO算法的原理,需要根据当前位置和速度以及个体最优位置和全局最优位置来更新粒子的速度和位置。

这个过程可以通过一些数学公式来实现,通常包括学习因子、惯性权重等参数。

步骤4,更新个体和全局最优位置。

在更新粒子的过程中,需要不断更新个体最优位置和全局最优位置。

如果某个粒子找到了比之前更好的位置,就需要更新个体最优位置;如果整个粒子群中出现了更好的位置,就需要更新全局最优位置。

步骤5,重复迭代。

以上步骤需要进行多次迭代,直到满足停止迭代的条件。

通常可以设置迭代次数或者适应度达到某个阈值时停止迭代。

在Matlab中,可以使用循环结构来实现迭代过程,同时根据上述步骤编写相应的代码来实现PSO算法。

常用的Matlab函数和工具包如“fmincon”、“Global Optimization Toolbox”等也可以用来实现PSO算法。

总结来说,实现PSO算法的关键在于理解其基本原理,正确地编写粒子的更新规则和适应度函数,并进行合适的迭代和终止条件设置。

希望这些信息能帮助你在Matlab中实现PSO算法。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

Matlab PSO优化RBF的程序。

找了很久,凡是能找到的都找到了。

网上就没有对的。

自己写的一直有问题。

我有个不完整的。

大家看看能不能补全:

AllSamIn=[];

AllSamOut=[];

%前向通道数据预设

global minAllSamOut;

global maxAllSamOut;

% 从总样本中抽取10%的样本作为测试样本,其余作为训练样本

[AllSamInn,minAllSamIn,maxAllSamIn,AllSamOutn,minAllSamOut,maxAllSamOut] = premnmx(AllSamIn,AllSamOut);

TesSamIn=[];

TestSamOut=[];

TargetOfTestSam=[]; %测试样本目标

TrainSamIn=AllSamInn;

TrainSamOut=AllSamOutn;

%样本评估:

EvaSamIn=[]; %样本评估输入

EvaSamInn=tramnmx(EvaSamIn,minAllSamIn,maxAllSamIn); %归一化处理

global Ptrain;

Ptrain= TrainSamIn;

global Ttrain;

Ttrain=TrainSamOut;

Ptest = TestSamIn;

Ttest = TestSamOut;

spread=1.2;

vmax=0.5; %最大速率

minerr=0.001; %适应度阈值

wmax=0.90; %惯性权重的最大值

wmin=0.30; %惯性权重的最小值

global itmax;

itmax=300; %允许的最大迭代步数

c1=2; %学习因子

c2=2; %学习因子

for iter= 1:itmax

W(iter)=wmax-((wmax-wmin)/itmax)*iter; %惯性权重下降

end

%粒子在a,b之间随机初始化:

a=-1;

b=1;

m=-1;

n=1;

global N; %粒子种群数目

N=40;

global D; %粒子群长度

D=(indim+1)*hiddennum+(hiddennum+1)*outdim;

%粒子群位置初始化:

rand('state',sum(100*clock)); %产生0-1之间的随机数,粒子在a,b(-1,1)之间初始化

X=a+(b-a)*rand(N,D,1); %产生N行D列由0-1之间的矩阵

V=m+(n-m)*rand(N,D,1); %粒子群速度在m,n即-1和1之间初始化

%粒子群优化RBF神经网络的适应度值

global fvrec;

MinFit=[]; %最小适应度

BestFit=[]; %最大适应度

global net; %建立一个待初始化的神经网络

net=newrbe(P,T,spread);

%调用fitcal函数

fitness=fitcal();

fvrec(:,1,1)=fitness(:,1,1);

[C,I]=min(fitness(:,1,1));

MinFit=[MinFit C];

BestFit=[BestFit C];

L(:,1,1)=fitness(:,1,1); %记录每次反复的例子的适应度函数

B(1,1,1)=C; %记录粒子的最小适应函数

gbest(1,:,1)=X(I,:,1); %全局极值

%粒子群优化RBF神经网络的例子速度和位置计算

V(:,:,2)=W(1)*V(:,:,1)+c1*rand*(pbest(:,:,1)-X(:,:,1))+c2*rand*(G(:,:,1)-X(:,:,1));

%用vmax限制粒子的速度,如果V>vmax则V=vmax,如果V<-vmax则V=-vmax

for ni=1:N

for di=1:D

if V(ni,di,2)>vmax

V(ni,di,2)=vmax;

elseif V(ni,di,2)<-vmax

V(ni,di,2)=-vmax;

else

V(ni,di,2)=V(ni,di,2);

end

end

X(:,:,2)=X(:,:,1)+V(:,:,2);

%粒子群优化RBF神经网络的粒子适应度值更新

fitness=fitcal(X,net,indim,hiddennum,outdim,D,Ptrain,Train,minAllSamout,maxAllSamOut);

fvrec(:,1,j)=fitness(:,1,j);

[C,I]=min(fitness(:,1,j));

MinFit=[Minfit C];

BestFit=[BestFit min(MinFit)];

L(:,1,j)=fitness(:,1,j);

B(1,1,j)=C;

gbest(1,:,j)=X(I,;,j);

[C,I]=min(B(1,1,;));

%保存gbest是已经出现过的最好粒子

if B(1,1,j)<=C

gbest(1,:,j)=gbest(1,:,j)

else

gbest(1,:,j)=gbest(1,:,I);

end

%粒子群优化RBF神经网络的速度和位置更新

V(:,:,j+1)=W(j)*V(:,:,j)+c1*rand*(pbest(:,:,j)-X(:,:,j))+c2*rand*(G(:,:,j)-X(:,:,j))。