最小二乘估计量

最小二乘法估计

机器学习领域应用

线性回归模型

在机器学习中,最小二乘法是线性回归模型的核心算法之一。通过最小化预测值与实际值之间的平方误差,可以 训练出预测精度较高的线性回归模型。

特征选择

最小二乘法也可以用于特征选择,通过计算特征的系数大小,可以判断哪些特征对模型的预测结果影响较大,从 而进行特征筛选和优化。

06 最小二乘法的未来发展与 研究方向

用于研究社会现象和人类行为 ,如市场调查、人口统计等。

最小二乘法的历史与发展

历史

最小二乘法最早由法国数学家勒让德 于1805年提出,并广泛应用于天文、 物理和工程领域。

发展

随着计算机技术的进步,最小二乘法 在数据处理和统计分析方面得到了广 泛应用和改进,出现了多种扩展和变 种,如加权最小二乘法、广义最小二 乘法等。

加权最小二乘法(WLS)

总结词

详细描述

加权最小二乘法是一种改进的线性回 归分析方法,通过给不同观测值赋予 不同的权重来调整误差的平方和。

加权最小二乘法(Weighted Least Squares,WLS)是对普通最小二乘法 的改进,通过给不同观测值赋予不同 的权重来调整误差的平方和。这种方 法适用于存在异方差性的数据,即误 差项的方差不恒定的情况。通过合理 地设置权重,WLS能够更好地拟合数 据并提高估计的准确性。

广泛的应用领域

最小二乘法适用于多种统计模型 和回归分析,是线性回归分析中 最常用的方法之一。

缺点

假设限制

01

最小二乘法要求数据满足线性关系和误差项独立同分布等假设,

这些假设在实际应用中可能难以满足。

对异常值敏感

02

虽然最小二乘法相对稳健,但仍然容易受到异常值的影响,可

能导致估计结果偏离真实值。

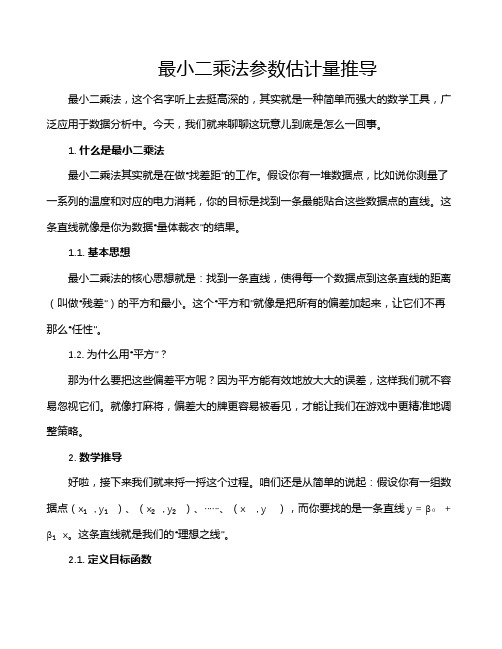

最小二乘法参数估计量推导

最小二乘法参数估计量推导最小二乘法,这个名字听上去挺高深的,其实就是一种简单而强大的数学工具,广泛应用于数据分析中。

今天,我们就来聊聊这玩意儿到底是怎么一回事。

1. 什么是最小二乘法最小二乘法其实就是在做“找差距”的工作。

假设你有一堆数据点,比如说你测量了一系列的温度和对应的电力消耗,你的目标是找到一条最能贴合这些数据点的直线。

这条直线就像是你为数据“量体裁衣”的结果。

1.1. 基本思想最小二乘法的核心思想就是:找到一条直线,使得每一个数据点到这条直线的距离(叫做“残差”)的平方和最小。

这个“平方和”就像是把所有的偏差加起来,让它们不再那么“任性”。

1.2. 为什么用“平方”?那为什么要把这些偏差平方呢?因为平方能有效地放大大的误差,这样我们就不容易忽视它们。

就像打麻将,偏差大的牌更容易被看见,才能让我们在游戏中更精准地调整策略。

2. 数学推导好啦,接下来我们就来捋一捋这个过程。

咱们还是从简单的说起:假设你有一组数据点(x₁, y₁)、(x₂, y₂)、……、(xₙ, yₙ),而你要找的是一条直线y = β₀ + β₁x。

这条直线就是我们的“理想之线”。

2.1. 定义目标函数我们的目标就是最小化所有这些点到直线的距离平方和。

用数学的语言来描述,就是要最小化目标函数:[ S(beta_0, beta_1) = sum_{i=1}^n (y_i beta_0 beta_1 x_i)^2 ]。

这里面,(y_i beta_0 beta_1 x_i)就是每一个点到直线的距离,平方了之后就能让误差更加明显。

2.2. 求导数为了找到最小值,我们需要对目标函数进行求导数,然后让导数等于零。

这个过程就像是找到山顶的最低点一样。

我们分别对β₀和β₁求偏导数,然后设定这些偏导数为零,得到两个方程:[ frac{partial S}{partial beta_0} = 0 ]。

[ frac{partial S}{partial beta_1} = 0 ]。

最大似然估计(MLE)与最小二乘估计(LSE)的区别

最⼤似然估计(MLE )与最⼩⼆乘估计(LSE )的区别最⼤似然估计与最⼩⼆乘估计的区别标签(空格分隔): 概率论与数理统计最⼩⼆乘估计对于最⼩⼆乘估计来说,最合理的参数估计量应该使得模型能最好地拟合样本数据,也就是估计值与观测值之差的平⽅和最⼩。

设Q 表⽰平⽅误差,Y i 表⽰估计值,ˆY i 表⽰观测值,即Q =∑n i =1(Y i −ˆY i )2最⼤似然估计对于最⼤似然估计来说,最合理的参数估计量应该使得从模型中抽取该n 组样本的观测值的概率最⼤,也就是概率分布函数或者似然函数最⼤。

显然,最⼤似然估计需要已知这个概率分布函数,⼀般假设其满⾜正态分布函数的特性,在这种情况下,最⼤似然估计与最⼩⼆乘估计是等价的,也就是估计的结果是相同的。

最⼤似然估计原理:1. 当给定样本x 1,x 2,...,x n 时,定义似然函数为L (θ)=f (x 1,x 2,...,x n ;θ);2. L (θ)看做是θ的函数,最⼤似然估计就是⽤使L (θ)达到最⼤值的ˆθ去估计θ,这时称ˆθ为θ的最⼤似然估计;MLE 的步骤:1. 由总体分布导出样本的联合概率函数(或联合密度);2. 把样本联合概率函数的⾃变量看成是已知常数,⽽把θ看做是⾃变量,得到似然函数L (θ);3. 求似然函数的最⼤值(常常取对数,然后求驻点);4. ⽤样本值带⼊得到参数的最⼤似然估计。

例题设⼀个有偏的硬币,抛了100次,出现1次⼈头,99次字。

问⽤最⼤似然估计(ML )和最⼩均⽅误差(LSE )估计出现⼈头的概率哪个⼤?LSE设使⽤LSE 估计,出现⼈头的概率为θ, 则出现字的概率为1−θ。

已知观测量为:(观测到的)出现⼈头的概率为1100, (观测到的)出现字的概率为99100,则由最⼩⼆乘估计:Q (θ)=argmin θ∑1001(θ−ˆθ)2=argmin θ{(1100−θ)2+[99100−(1−θ)]2∗99}令∂Q (θ)∂θ=0,解得θ=1100;ML设使⽤ML 估计,所以x 服从伯努利分布,x ∼B (朝上,θ),则概率密度函数为:P (x |θ)=θ,if x ⼈头朝上1−θ,if x 字朝上则连续100次试验的似然函数为:P (x 1,x 2,..x 100|θ)=C 1100θ1∗(1−θ)99=100∗θ1∗(1−θ)99最⼤化似然函数,则θ⾄少为驻点,对似然函数取对数并求偏导:ln P (x 1,x 2,..x 100|θ)=ln100+ln θ+99ln(1−θ)对θ求偏导为0,得到:∂ln P (x 1,x 2,..x 100|θ)∂θ=1θ−991−θ=0, 解得θ=1100.{两者虽然得到的估计值是⼀样的,但是原理完全不同,要对他们的推导过程⾮常清楚。

二.2.用最小二乘法求参数估计量.

2. (1)用最小二乘法,求参数估计量.由于21^)(∑-=ni iy yQ ,=21^1^0)]([∑+-ni ix yββ(i i x y ^1^0^ββ+= )我们可以知道,Q 是^1^0,ββ的二次函数并且是非负数.所以Q 的极小值总是存在的.(为什么?) 根据极值存在的必要条件知,⎪⎪⎩⎪⎪⎨⎧=∂∂=∂∂001^0^ββQ Q(为什么不是充分条件?)由此,不难推得:⎪⎩⎪⎨⎧=-+=-+∑∑0)(0)(^1^0^1^0i i i i i x y x y x ββββ(4) 进而得到:⎪⎩⎪⎨⎧+=+=∑∑∑∑∑2^1^0^1^0i i i i i i x x x y x n y ββββ(5)于是解得(怎么解?)⎪⎪⎩⎪⎪⎨⎧--=--=∑∑∑∑∑∑∑∑∑∑∑22^1222^0)()(i i i i i i i i i i i i i x x n x y x y n x x n x y x y x ββ(6)另外,可以将公式(6)简化变形得⎪⎪⎩⎪⎪⎨⎧-==∑∑∙∙∙__^1__^02^1xy x y x i i i βββ(7)其中,____;yy y x x x i i i -=-=∙∙ny y nx x ii∑∑==____;(2)求随机误差项方差的估计量.记^i i i y y e -=为第i 个样本观测值的残差.即被解释变量的观测值与估计值之差.则随机误差项方差的估计量为:222-=∑n ie μσ(8)证明从略.至此, 普通最小二乘法一元线性回归模型的参数估计问题得到解决.。

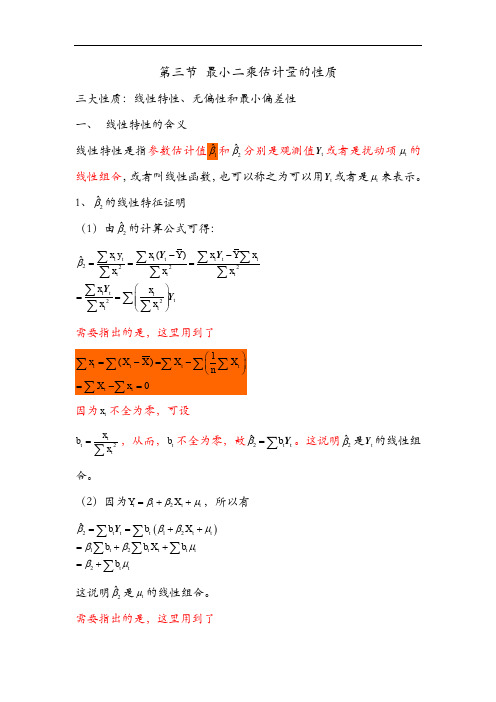

第三节最小二乘估计量的性质

第三节 最小二乘估计量的性质三大性质:线性特性、无偏性和最小偏差性 一、 线性特性的含义线性特性是指参数估计值1ˆβ和2ˆβ分别是观测值t Y 或者是扰动项t μ的线性组合,或者叫线性函数,也可以称之为可以用t Y 或者是t μ来表示。

1、2ˆβ的线性特征证明 (1)由2ˆβ的计算公式可得: 222222()ˆt tttt ttttttt tt tt x y x Y x Y xxx xx x x x β--===⎛⎫== ⎪ ⎪⎝⎭∑∑∑∑∑∑∑∑∑∑∑Y Y Y Y需要指出的是,这里用到了因为t x 不全为零,可设2tt tx b x =∑,从而,t b 不全为零,故2ˆt t b β=∑Y 。

这说明2ˆβ是t Y 的线性组合。

(2)因为12t t t Y X ββμ=++,所以有()212122ˆt t t t t t t t t t t tb b X b b X b b βββμββμβμ==++=++=+∑∑∑∑∑∑Y这说明2ˆβ是t μ的线性组合。

需要指出的是,这里用到了220t t t t t x x b x x ===∑∑∑∑∑以及 ()2222222201t t tt t t tt ttttttttx x X x b X X x x x x X x X x x x x x⎛⎫+⎪== ⎪⎝⎭++==+=∑∑∑∑∑∑∑∑∑∑∑∑∑2、1ˆβ的线性特征证明 (1)因为12ˆˆY X ββ=-,所以有 ()121ˆˆ1t t t t tY X Y X b nXb n ββ=-=-⎛⎫=- ⎪⎝⎭∑∑∑Y Y这里,令1a Xb n=-,则有1ˆt a β=∑Y 这说明1ˆβ是t Y 的线性组合。

(2)因为回归模型为12t t t Y X ββμ=++,所以()11212ˆt t t t t t t t t ta a X a a X a βββμββμ==++=++∑∑∑∑∑Y因为111t t t a Xb X b nn⎛⎫=-=-=⎪⎝⎭∑∑∑∑。

回归系数的最小二乘估计

: 冬季积雪期限(单位为周), : 每年化雪日期(以 2 月 1 日为 1), : 二月份平均气温(℃), : 三月份平均气温(℃), : 二化螟发生总量(头),

,

,

体重( )

28 39 41 44 43 50 51 57 63 66 70 76 80 81

,

,

,

,

, 于是正规方程组为

解此方程组得 ,

又

因此所求预测回归方程为

, ,

,

回归方程中系数 与 的含义是体长 每增加 1cm, 则猪体重毛重平均增加 0.522kg, 胸围 每增 加 1cm, 则猪体重毛重平均增加 0.475kg。

, (2.6)

, (2.7)

因此正规方程(2.6)的矩阵形式为 , (2.9)

或 , (2.10)

, (2.8)

其中 有

为正规方程中待定的未知实数向量, 如果系数矩阵 满秩, 则 存在, 此时

, (2.11) (2.11)式即为多元线性回归模型(1.2)式中参数的最小二乘估计。

正规方程组(2.6)亦可表达为下述另一种形式, 如果记

立 与 及 的预测方程。

序号

1 2 3 4 5 6 7 8 9 10 11 12 13 14

经计算:

体长( )

41 45 51 52 59 62 69 72 78 80 90 92 98 103

,

,

表 2.1

胸围( )

49 58 62 71 62 74 71 74 79 84 85 94 91 95

第三讲普通最小二乘法

普通最小二乘法(OLS) (Ordinary Least Squares)

eyyˆ 1. OLS的基本思想

ei yi yˆi

y ˆiˆ0ˆ1 x i (i 1 ,2 , ,n )

m in ei2m in (Yiˆ1ˆ2Xi)2

普通最小二乘法(OLS) (Ordinary Least Squares)

表 2.2.1 参数估计的计算表

X i Yi

xi

yi

xi yi

x

2 i

y

2 i

X

2 i

Yi 2

1 2 3 4 5 6 7 8 9 10 求和 平均

800 1100 1400 1700 2000 2300 2600 2900 3200 3500 21500 2150

594 638 1122 1155 1408 1595 1969 2078 2585 2530 15674 1567

计性质。 ●模型中有随机扰动项,估计的参数是随机变量,显然参数

估计值的分布与扰动项的分布有关,只有对随机扰动的分 布作出假定,才能比较方便地确定所估计参数的分布性质, 也才可能进行假设检验和区间估计等统计推断。 假定分为:◆对模型和变量的假定◆对随机扰动项的假定

14

对模型和变量的假定

例如对于 Yi 12Xiui

假定2:同方差假定

Var(Yi Xi)2

假定3:无自相关假定 Cov(Yi,Yj)0

假定5:正态性假定

Yi ~N(12Xi,2)

19

OLS回归线的数学性质

●剩余项 e i 的均值为零 e ei 0

n

●OLS回归线通过样本均值

Y

(由OLS第一个正规方程直接得到)

●估计值 Y ˆ i 的均值等于实际观测 Y 值 Y i 的均值 Y ˆ1ˆ2X

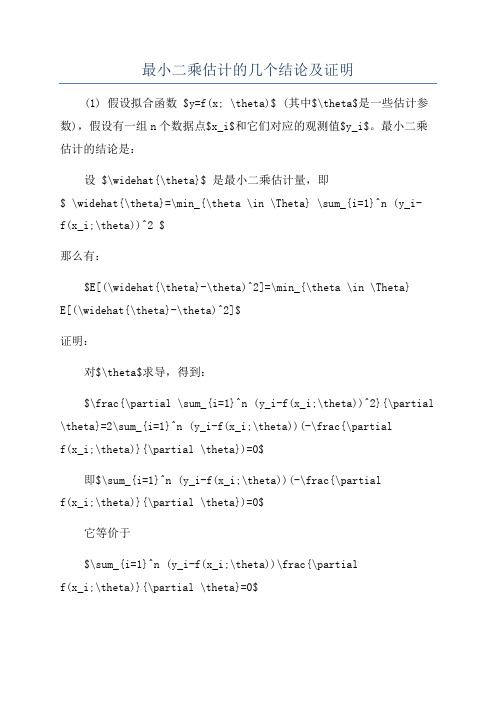

最小二乘估计的几个结论及证明

最小二乘估计的几个结论及证明(1) 假设拟合函数 $y=f(x; \theta)$ (其中$\theta$是一些估计参数),假设有一组n个数据点$x_i$和它们对应的观测值$y_i$。

最小二乘估计的结论是:设 $\widehat{\theta}$ 是最小二乘估计量,即$ \widehat{\theta}=\min_{\theta \in \Theta} \sum_{i=1}^n (y_i-f(x_i;\theta))^2 $那么有:$E[(\widehat{\theta}-\theta)^2]=\min_{\theta \in \Theta}E[(\widehat{\theta}-\theta)^2]$证明:对$\theta$求导,得到:$\frac{\partial \sum_{i=1}^n (y_i-f(x_i;\theta))^2}{\partial \theta}=2\sum_{i=1}^n (y_i-f(x_i;\theta))(-\frac{\partialf(x_i;\theta)}{\partial \theta})=0$即$\sum_{i=1}^n (y_i-f(x_i;\theta))(-\frac{\partialf(x_i;\theta)}{\partial \theta})=0$它等价于$\sum_{i=1}^n (y_i-f(x_i;\theta))\frac{\partialf(x_i;\theta)}{\partial \theta}=0$也就是说$\frac{\partial \sum_{i=1}^n (y_i-f(x_i;\theta))^2}{\partial \theta}=0$,即极值解$\widehat{\theta}$ 满足$\sum_{i=1}^n (y_i-f(x_i;\widehat{\theta}))^2=min$。

令$f_0(x;\theta)=\sum_{i=1}^n (y_i-f(x_i;\theta))^2$,则$E[(\widehat{\theta}-\theta)^2]=E[f_0(\widehat{\theta}-\theta)]$是$\theta$的二阶凸函数,这样$E[(\widehat{\theta}-\theta)^2]$的局部最小值就是全局最小值,即$E[(\widehat{\theta}-\theta)^2]=\min_{\theta \in \Theta} E[(\widehat{\theta}-\theta)^2]$。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

这三个准则也称作估计量的小样本性质。

拥有这类性质的估计量称为最佳线性无偏估计 量(best liner unbiased estimator, BLUE)。 当不满足小样本性质时,需进一步考察估计量的 大样本或渐近性质: (4)渐近无偏性,即样本容量趋于无穷大时,是 否它的均值序列趋于总体真值; (5)一致性,即样本容量趋于无穷大时,它是否 依概率收敛于总体的真值; (6)渐近有效性,即样本容量趋于无穷大时,是 否它在所有的一致估计量中具有最小的渐近方差。

k

i

X

2

x i 2 xi

2

2

1 n

X

2 xi

2

2

xi nX

2

n xi

2

2

X n x

2 i 2 i

(2)证明最小方差性

ˆ* 1 是 其 他 估 计 方 法 得 到 的 关 于 1 的 线 性 无 偏 估 计 量 : 假设

2

和 ˆ 1 的 方 差 和 标 准 差 的 估 计 量 分 别 是 :

ˆ

1

的样本方差: 样本标准差:

2 S ˆ ˆ

1

2

xi

2

2

ˆ 1 的

ˆ 0

ˆ 0

S ˆ ˆ

1

xi

的样本方差: 的样本标准差:

2 S ˆ ˆ

0

2

X

X

2 i

2 i

n xi

n xi

2

2

S ˆ ˆ

高斯—马尔可夫定理(Gauss-Markov theorem)

在给定经典线性回归的假定下,最小二乘估计 量是具有最小方差的线性无偏估计量。

ˆ 证 : 1

xy x

i 2 i

i

x i (Yi Y )

xi

2

xY x

i 2 i

i

Y

x x

2 i

i

ˆ ˆ 2、 无 偏 性 , 即 估 计 量 0 、 1 的 均 值 ( 期 望 ) 等 于 总 体 回 归

二、参数估计量的概率分布及随机干扰 项方差的估计

ˆ ˆ 1、 参 数 估 计 量 0 和 1 的 概 率 分 布

ˆ 1 ~ N (1,

2 2 i

)

x

ˆ 0 ~ N ( 0 ,

n

X x

2 i 2 i

2

)

ˆ 12源自/ xi2

ˆ 0

n x

2

X

2 i

(1 )先 求 ˆ 0 与 ˆ 1 的 方 差

ˆ var( 1 ) var(

k iYi )

2

k i var( 0 1 X i i )

2

k i var( i )

2

ˆ var( 0

) var( w Y

i

2

xi

2 xi

§2.2

最小二乘估计量的性质

一、最小二乘估计量的性质 二、参数估计量的概率分布及随机干 扰项方差的估计

一、最小二乘估计量的性质

当模型参数估计出后,需考虑参数估计值的 精度,即是否能代表总体参数的真值,或者说需 考察参数估计量的统计性质。 一个用于考察总体的估计量,可从如下几个方 面考察其优劣性: (1)线性性,即它是否是另一随机变量的线性 函数; (2)无偏性,即它的均值或期望值是否等于总 体的真实值; (3)有效性,即它是否在所有线性无偏估计量 中具有最小方差。

参 数 真 值 0 与 1

证:

易知 故

ˆ 1

kY k

i i

i

( 0 1 X i i ) 0 ki 1 ki X i

k

i

i

ki

x x

i 2 i

0

ki X

i

1

ˆ 1 1

kii

ˆ E (1) E (1

kii ) 1

k i E ( i ) 1

同样地,容易得出

ˆ E ( 0 ) E ( 0

wi i ) E ( 0 )

wi E ( i ) 0

3、 有 效 性 ( 最 小 方 差 性 ) 即 在 所 有 线 性 无 偏 估 计 量 ,

ˆ ˆ 中 , 最 小 二 乘 估 计 量 0 、 1 具 有 最 小 方 差 。

0

2 i

ˆ 1的 概 率 分 布 :

2、随机误差项的方差2的估计 2又称为总体方差。

由于随机项i不可观测,只能从i的估计——残 差ei出发,对总体方差进行估计。

可以证明,2的最小二乘估计量为

ˆ

2

ei

2

n2

ˆ 2 是 2的 无 偏 估 计 量 可以证明

在 随 机 误 差 项 的 方 差 估 计 出 后 , 参 数ˆ 0

ˆ* 1

cY

i

i

其中,ci=ki+di,di为不全为零的常数

则容易证明

ˆ* ˆ var( 1 ) var( 1 )

同 理 , 可 证 明 0 的 最 小 二 乘 估 计 量 ˆ 0 具 有 最 的 小 方 差

普通最小二乘估计量(ordinary least Squares Estimators)称为最佳线性无偏估计量(best linear unbiased estimator, BLUE)

) i

2

2 2

2

xi

w i var( 0 1 X i i )

2

(1 / n X k i )

2

2

2

1 1 2 2 2 X k i X k i n n

1 2 X n n

2