神经网络实现函数逼近

BP神经网络逼近非线性函数

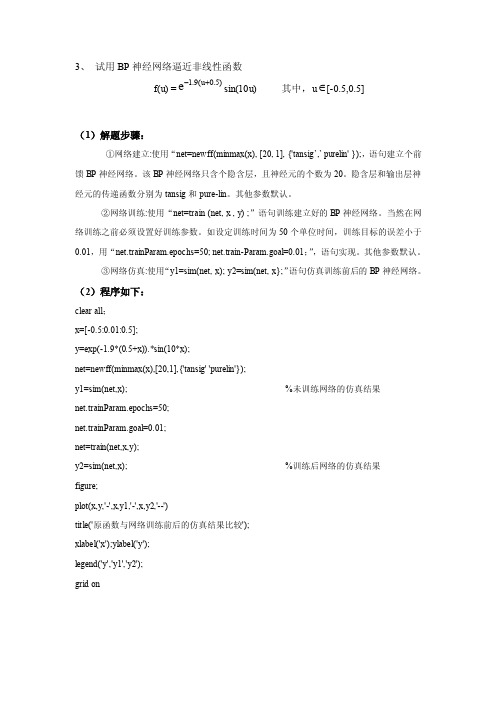

3、 试用BP 神经网络逼近非线性函数f(u) =)5.0u (9.1e+-sin(10u) 其中,u ∈[-0.5,0.5](1)解题步骤:①网络建立:使用“net=newff(minmax(x), [20, 1], {'tansig ’,’ purelin' });,语句建立个前馈BP 神经网络。

该BP 神经网络只含个隐含层,且神经元的个数为20。

隐含层和输出层神经元的传递函数分别为tansig 和pure-lin 。

其他参数默认。

②网络训练:使用“net=train (net, x , y) ;”语句训练建立好的BP 神经网络。

当然在网络训练之前必须设置好训练参数。

如设定训练时间为50个单位时间,训练目标的误差小于0.01,用“net.trainParam.epochs=50; net.train-Param.goal=0.01;”,语句实现。

其他参数默认。

③网络仿真:使用“y1=sim(net, x); y2=sim(net, x};”语句仿真训练前后的BP 神经网络。

(2)程序如下:clear all ;x=[-0.5:0.01:0.5];y=exp(-1.9*(0.5+x)).*sin(10*x);net=newff(minmax(x),[20,1],{'tansig' 'purelin'});y1=sim(net,x); %未训练网络的仿真结果 net.trainParam.epochs=50;net.trainParam.goal=0.01;net=train(net,x,y);y2=sim(net,x); %训练后网络的仿真结果 figure;plot(x,y,'-',x,y1,'-',x,y2,'--')title('原函数与网络训练前后的仿真结果比较');xlabel('x');ylabel('y');legend('y','y1','y2');grid on(3)仿真结果如图:图1图1为原函数y与网络训练前后(y1,y2)的仿真结果比较图。

卷积神经网络逼近非线性函数

卷积神经网络逼近非线性函数卷积神经网络(Convolutional Neural Network,简称CNN)是一种在深度研究领域广泛应用的神经网络模型,能够有效地逼近非线性函数。

1. 简介卷积神经网络由多个卷积层、池化层和全连接层组成。

通过卷积层和池化层的运算,CNN能够从输入数据中提取特征,并逐步抽象出更高级别的特征。

最后,通过全连接层对提取的特征进行分类或回归,实现对非线性函数的逼近。

2. 卷积层卷积层是卷积神经网络的核心部分。

通过卷积操作,卷积层能够有效地捕捉输入数据中的局部特征。

卷积操作使用一组可研究的卷积核对输入数据进行滑动窗口计算,生成卷积特征图。

卷积层可以通过增加卷积核的数量和尺寸来增加特征维度和感知野的范围,从而提取更丰富的特征。

3. 池化层池化层用于减小特征图的尺寸,减少计算量,并保留重要的特征。

最大池化是一种常用的池化操作,它通过在特定区域内选择最大值来表示该区域的特征。

池化层的使用能够提高模型的平移不变性和鲁棒性。

4. 全连接层全连接层是卷积神经网络的最后一层,用于将提取到的特征映射到最终的输出。

全连接层中的每个神经元都与前一层中的所有神经元连接,通过研究权重来实现特征的组合和分类。

全连接层的输出可以用于分类任务或回归任务,实现对非线性函数的逼近。

5. 总结卷积神经网络是一种强大的机器学习模型,能够逼近非线性函数。

通过卷积层、池化层和全连接层的组合,CNN能够自动提取输入数据中的特征,并使用这些特征进行分类或回归。

在实际应用中,我们可以通过调整网络结构和参数来优化卷积神经网络的性能,以更好地逼近非线性函数。

深度学习神经网络逼近非线性函数

深度学习神经网络逼近非线性函数深度研究神经网络是一种强大的机器研究模型,被广泛应用于各个领域,包括图像识别、自然语言处理等。

它通过多层神经元来建模复杂的非线性函数关系,可以实现对非线性函数的逼近。

神经网络基础神经网络由输入层、隐藏层和输出层组成。

输入层接收输入数据,隐藏层负责对输入进行加工和提取特征,输出层则生成最终的预测结果。

每个神经元在隐藏层和输出层都会进行激活函数的运算,将线性变换后的结果转化为非线性的输出。

非线性函数逼近深度研究神经网络能够逼近非线性函数的原因在于其多层结构。

每一层的神经元都可以研究到不同级别的特征表示,通过多层的组合与堆叠,神经网络能够模拟和逼近非常复杂的非线性函数。

激活函数的重要性激活函数是神经网络中非常重要的组成部分,它引入了非线性因素,使得神经网络能够处理非线性问题。

常见的激活函数有Sigmoid函数、ReLU函数等,它们可以将线性变换的结果映射到非线性的输出,增强神经网络的表达能力。

深度研究的训练深度研究神经网络的训练过程通常使用反向传播算法。

该算法通过计算实际输出与期望输出之间的误差,然后根据误差调整神经网络的权重和偏置,以逐渐提高网络的预测准确性。

通过反复迭代训练,神经网络可以逐渐优化和逼近目标非线性函数。

应用领域深度研究神经网络广泛应用于图像识别、语音识别、自然语言处理等领域。

例如,在图像识别中,神经网络可以通过研究大量图像样本来识别物体、人脸等;在自然语言处理中,神经网络可以对文本进行分类、情感分析等任务。

深度研究神经网络的强大逼近能力使得它在这些领域具有很高的应用价值。

结论深度学习神经网络通过多层神经元和非线性激活函数的组合,能够逼近非线性函数。

它是一种强大的机器学习模型,在各个领域都有广泛的应用。

随着深度学习技术的不断发展,我们相信神经网络将会在更多领域展现出强大的能力和应用前景。

函数逼近的几种算法及其应用

函数逼近的几种算法及其应用

一、神经网络

神经网络(neural network)是一种用于模仿人类神经系统的计算模型,它使用多层层次的神经元组成的网络结构来进行复杂的计算,并以调整连接强度的方式来实现学习。

它主要应用于图像识别、语音识别、自动驾驶、推荐系统以及机器翻译等领域。

1.应用于图像识别

2.应用于语音识别

神经网络在语音识别方面也是十分重要的,它可以识别用户说的话,并且做出相应的回应,大大提升了用户的体验。

此外,神经网络也可以用来实现语音识别,从而实现对用户语音输入的理解,从而将用户输入的文本转换成机器可以理解的文本。

3.应用于自动驾驶

神经网络也可以用于自动驾驶,例如它可以帮助自动驾驶车辆在公路上行驶,并在行驶过程中识别路面障碍物,从而避免发生危险。

神经网络在函数逼近中的应用

二 基于BP神经网络逼近函数 基于BP神经网络逼近函数

步骤1:假设频率参数k=1,绘制要逼近的非线性 步骤1:假设频率参数k=1,绘制要逼近的非线性 函数的曲线。函数的曲线如图1 函数的曲线。函数的曲线如图1所示 k=1; p=[p=[-1:.05:8]; t=1+sin(k*pi/4*p); plot( plot(p,t,'-'); '); title('要逼近的非线性函数'); title('要逼近的非线性函数'); xlabel('时间'); xlabel('时间'); ylabel('非线性函数'); ylabel('非线性函数');

图3 训练过程 从以上结果可以看出,网络训练速度很快,很 快就达到了要求的精度0.001。 快就达到了要求的精度0.001。

步骤4 步骤4: 网络测试 对于训练好的网络进行仿真: y2=sim(net,p); figure; plot(p,t,'plot(p,t,'-',p,y1,':',p,y2, '--') '--') title('训练后网络的输出结果'); title('训练后网络的输出结果'); xlabel('时间'); xlabel('时间'); ylabel('仿真输出'); ylabel('仿真输出'); 绘制网络输出曲线,并与原始非线性函数曲线以 及未训练网络的输出结果曲线相比较,比较出来 的结果如图4 的结果如图4所示。

BP网络在函数逼近中的应用 BP网络在函数逼近中的应用

RBF网络应用—逼近非线性函数 神经网络控制课件(第三版)

1

RBF网络应用—逼近非线性函数

Matlab程序

m265a.m

4

RBF网络应用—逼近非线性函数

m265a.m执行结果

构造3个高斯RBF

5

RBF网络应用—逼近非线性函数

m265a.m执行结果

构造非线性函数d=f(u)

6

RBF网络应用—逼近非线性函数

12

RBF网络应用—逼近非线性函数

m265b.m执行结果

网络输出

13

RBF网络应用—逼近非线性函数

m265b.m执行结果

非线性函数d(o) 、网络输出y(*)

14

RBF网络应用—逼近非线性函数

m265b.m执行结果

与m265a.m 执行 结果 比较: 相同

非线性函数d(o) 、网络输出y(*)

m265a.m执行结果

设计的网络输出 y逼近d=f(u)

7

RBF网络应用—逼近非线性函数

m265a.m执行结果

Command Window:

w1 = 0.7000

-1.7000

2.1000

-0.1000

2.7000

-1.4000

3.0000

b1 = 26

1. 设计的RBFNN结构。 2. RBFNN的所有参数。 由m265b.m程序,仿真N1,7,1 逼近非线性函数d=f(u)的过程。

10

RBF网络应用—逼近非线性函数

m265b.m执行结果

7个隐层节点的输出

11

RBF网络应用—逼近非线性函数

m265b.m执行结果

7个隐层节点输出的加权、网络输出

15

RBF网络应用—逼近非线性函数

人工智能开发中的函数逼近技术解析

人工智能开发中的函数逼近技术解析人工智能(Artificial Intelligence,简称AI)作为当今科技领域的热门话题,正在以惊人的速度发展和应用。

AI的广泛应用领域之一就是函数逼近技术。

函数逼近技术是指利用计算机算法来近似表示和模拟复杂的函数关系。

本文将对人工智能开发中的函数逼近技术进行深入解析。

函数逼近技术在人工智能开发中起着举足轻重的作用。

随着科技的不断进步,我们需要解决越来越多的复杂问题,这些问题的关系往往非常复杂。

传统的数学方法往往难以精确地表示这些复杂关系,而函数逼近技术通过构建合适的数学模型,能够通过对已知数据的学习和拟合,得到一个近似的函数关系,从而解决实际问题。

函数逼近技术的应用包括模式识别、数据压缩、图像处理、声音合成等等。

在函数逼近技术的应用中,最常用的方法之一就是神经网络。

神经网络是通过模拟人脑的神经元网络来实现人工智能的一种方法。

神经网络在函数逼近中的应用主要是通过构建多层的神经元网络,从而将输入数据转化为期望的输出结果。

神经网络通过反向传播算法,不断调整神经元之间的权重和阈值,从而实现对函数关系的逼近。

另一个常用的函数逼近方法是支持向量机(Support Vector Machine,简称SVM)。

支持向量机是一种基于统计学习理论的机器学习方法,广泛应用于分类和回归问题。

支持向量机通过构建一个最优的分割超平面,将不同类别的数据分隔开来。

通过在分割超平面附近选择支持向量进行函数逼近,支持向量机能够在高维空间中有效地解决非线性函数逼近问题。

除了神经网络和支持向量机之外,还有其他一些函数逼近技术被广泛应用于人工智能开发中。

例如,基于决策树的方法能够通过构建一棵决策树来近似表示函数关系。

决策树通过对已知数据的划分和分类,从而得到一个与实际函数关系相似的模型。

此外,基于遗传算法的函数逼近方法也得到了广泛应用。

遗传算法通过模拟进化过程,通过不断迭代和选择,从而得到一个最优的函数逼近结果。

小波模糊神经网络在非线性函数逼近中的应用

l 引 言

对于非线性 函数 的逼近一直是数学 和工程 研究人员所

关 注 的热 门 问题 之 一 , 研 究 非 线 性 函数 的 逼 近 方 法 也 是 多

NN去模糊化 , 从 而 得 到准 确 的输 出 , 一 旦 确定 了输入 的 数 目, 每 个输 入 的 规则 和模 糊 集 , WF N N 的结 构 就 确 定

总第 2 7 9 期 2 0 1 3年 第 1 期

计算机 与数字 工程

Co mp u t e r& Di g i t a l En g i n e e r i n g

Vo l _ 4l No . 1

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

仿真的结果

目标曲线 25 25 逼近曲线

20

20

15 15 10 10 5

500ຫໍສະໝຸດ 0246

-5

0

2

4

6

基于小脑神经网络的函数逼近

模型的建立

输入:单输入 输出:单输出

CMAC模型与映射

11

程序实现

clear clc max=5000;%%%%×î ´óÑ» · ´Î Ê ý c=5;%%%%%Ö Ø ¸ ´¸ ² ¸ ǵÄÇøÓ òµÄÄÚ´æ ¸ öÊ ý data=72;%%%%ÐèÒ ª Ê äÈ ëµÄÊ ý ¾Ý¸ öÊ ý mem=77;%%%%ÐèÒ ª µÄÄÚ´æ ¸ öÊ ý error=0.0001;%%%Î ó² î ¾« È · ¶È alpha=0.3;%%%%µ÷Õ û² ½³ ¤ A=uint8(zeros(data,c));%%%Ó ÃÓ Ú´æ ´¢ ÿ¸ öÊ ý ¾ÝË ù¼¤ » î µÄÄÚ´æ ¿Õ ¼äµØ Ö · w=rand(1,22);%%%%³ õÊ ¼» ¯ 鬅 µ %%%%%%%%Çó³ öѵÁ· Ê ý ¾ÝµÄÔ ¤ ² âÖ µ%%%%%%%% for i=1:data x(i)=i/360*pi*10; d(i)=x(i).*x(i); end %%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%% for i=1:data sw(i)=i; end for i=1:c for j=1:data temp=0; for k=1:i-1 temp=ceil(k/c+1)+temp; end A(j,i)=temp+(j-i)/c+1;

网络模型

隐层

输出 输入

模型的实现

close all clear echo on clc P = [0:0.02:5]; randn('seed',10000); T = P.*P; subplot(1,2,1),plot(P,T,'k--'); title('Ä¿±êÇúÏ ß ') hold on; grid on; plot(P,P.*P,':'); net=newff(minmax(P),[10,1],{'tansig','purelin'}); net.trainFcn='trainlm'; net.trainParam.epochs = 300; net.trainParam.goal = 1e-6; net=init(net); [net,tr]=train(net,P,T); A = sim(net,P); E = T - A; MSE=mse(E) % » æ Ö Æ Æ ¥Åä½á¹ ûÇúÏ ß subplot(1,2,2);plot(P,A,P,T,'r*',P,P.*P,':'); title('±Æ ½üÇúÏ ß ') hold on; grid on;

仿真结果

目标曲线 25 40 35 20 30 25 15 20 15 10 10 5 0 0 -5 逼近曲线

5

0

2

4

6

0

20

40

60

80

神经网络实现函数逼近

目标与要求

基于BP神经网络的函数逼近

模型的建立

输入:单输入 输出:单输出 隐层数:1层 隐层神经元个数:10

BP神经网络简介

BP(Error Back Propagation Network)是目前应用最为广泛和成功的神经网 络之一。它是在1986年,由Rumelhant和Mcllelland提出的。是一种多层网络 的“逆推”学习算法。其基本思想是,学习过程由信号的正向传播与误差的 反向传播两个过程组成。正向传播时,输入样本从输入层传入,经隐层逐层 处理后,传向输出层。若输出层的实际输出与期望输出(教师信号)不符, 则转向误差的反向传播阶段。误差的反向传播是将输出误差以某种形式通过 隐层向输入层逐层反传,并将误差分摊给各层的所有单元,从而获得各层单 元的误差信号,此误差信号即作为修正各单元权值的依据。这种信号正向传 播与误差反向传播的各层权值调整过程,是周而复始地进行的。权值不断调 整过程,也就是网络的学习训练过程。此过程一直进行到网络输出的误差减 少到可以接受的程度,或进行到预先设定的学习次数为止。