神经网络作业(函数逼近)

BP神经网络逼近非线性函数

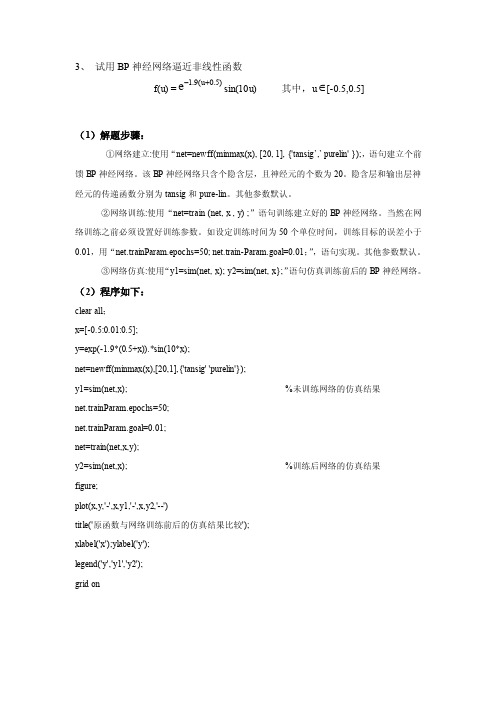

3、 试用BP 神经网络逼近非线性函数f(u) =)5.0u (9.1e+-sin(10u) 其中,u ∈[-0.5,0.5](1)解题步骤:①网络建立:使用“net=newff(minmax(x), [20, 1], {'tansig ’,’ purelin' });,语句建立个前馈BP 神经网络。

该BP 神经网络只含个隐含层,且神经元的个数为20。

隐含层和输出层神经元的传递函数分别为tansig 和pure-lin 。

其他参数默认。

②网络训练:使用“net=train (net, x , y) ;”语句训练建立好的BP 神经网络。

当然在网络训练之前必须设置好训练参数。

如设定训练时间为50个单位时间,训练目标的误差小于0.01,用“net.trainParam.epochs=50; net.train-Param.goal=0.01;”,语句实现。

其他参数默认。

③网络仿真:使用“y1=sim(net, x); y2=sim(net, x};”语句仿真训练前后的BP 神经网络。

(2)程序如下:clear all ;x=[-0.5:0.01:0.5];y=exp(-1.9*(0.5+x)).*sin(10*x);net=newff(minmax(x),[20,1],{'tansig' 'purelin'});y1=sim(net,x); %未训练网络的仿真结果 net.trainParam.epochs=50;net.trainParam.goal=0.01;net=train(net,x,y);y2=sim(net,x); %训练后网络的仿真结果 figure;plot(x,y,'-',x,y1,'-',x,y2,'--')title('原函数与网络训练前后的仿真结果比较');xlabel('x');ylabel('y');legend('y','y1','y2');grid on(3)仿真结果如图:图1图1为原函数y与网络训练前后(y1,y2)的仿真结果比较图。

卷积神经网络逼近非线性函数

卷积神经网络逼近非线性函数卷积神经网络(Convolutional Neural Network,简称CNN)是一种在深度研究领域广泛应用的神经网络模型,能够有效地逼近非线性函数。

1. 简介卷积神经网络由多个卷积层、池化层和全连接层组成。

通过卷积层和池化层的运算,CNN能够从输入数据中提取特征,并逐步抽象出更高级别的特征。

最后,通过全连接层对提取的特征进行分类或回归,实现对非线性函数的逼近。

2. 卷积层卷积层是卷积神经网络的核心部分。

通过卷积操作,卷积层能够有效地捕捉输入数据中的局部特征。

卷积操作使用一组可研究的卷积核对输入数据进行滑动窗口计算,生成卷积特征图。

卷积层可以通过增加卷积核的数量和尺寸来增加特征维度和感知野的范围,从而提取更丰富的特征。

3. 池化层池化层用于减小特征图的尺寸,减少计算量,并保留重要的特征。

最大池化是一种常用的池化操作,它通过在特定区域内选择最大值来表示该区域的特征。

池化层的使用能够提高模型的平移不变性和鲁棒性。

4. 全连接层全连接层是卷积神经网络的最后一层,用于将提取到的特征映射到最终的输出。

全连接层中的每个神经元都与前一层中的所有神经元连接,通过研究权重来实现特征的组合和分类。

全连接层的输出可以用于分类任务或回归任务,实现对非线性函数的逼近。

5. 总结卷积神经网络是一种强大的机器学习模型,能够逼近非线性函数。

通过卷积层、池化层和全连接层的组合,CNN能够自动提取输入数据中的特征,并使用这些特征进行分类或回归。

在实际应用中,我们可以通过调整网络结构和参数来优化卷积神经网络的性能,以更好地逼近非线性函数。

深度学习神经网络逼近非线性函数

深度学习神经网络逼近非线性函数深度研究神经网络是一种强大的机器研究模型,被广泛应用于各个领域,包括图像识别、自然语言处理等。

它通过多层神经元来建模复杂的非线性函数关系,可以实现对非线性函数的逼近。

神经网络基础神经网络由输入层、隐藏层和输出层组成。

输入层接收输入数据,隐藏层负责对输入进行加工和提取特征,输出层则生成最终的预测结果。

每个神经元在隐藏层和输出层都会进行激活函数的运算,将线性变换后的结果转化为非线性的输出。

非线性函数逼近深度研究神经网络能够逼近非线性函数的原因在于其多层结构。

每一层的神经元都可以研究到不同级别的特征表示,通过多层的组合与堆叠,神经网络能够模拟和逼近非常复杂的非线性函数。

激活函数的重要性激活函数是神经网络中非常重要的组成部分,它引入了非线性因素,使得神经网络能够处理非线性问题。

常见的激活函数有Sigmoid函数、ReLU函数等,它们可以将线性变换的结果映射到非线性的输出,增强神经网络的表达能力。

深度研究的训练深度研究神经网络的训练过程通常使用反向传播算法。

该算法通过计算实际输出与期望输出之间的误差,然后根据误差调整神经网络的权重和偏置,以逐渐提高网络的预测准确性。

通过反复迭代训练,神经网络可以逐渐优化和逼近目标非线性函数。

应用领域深度研究神经网络广泛应用于图像识别、语音识别、自然语言处理等领域。

例如,在图像识别中,神经网络可以通过研究大量图像样本来识别物体、人脸等;在自然语言处理中,神经网络可以对文本进行分类、情感分析等任务。

深度研究神经网络的强大逼近能力使得它在这些领域具有很高的应用价值。

结论深度学习神经网络通过多层神经元和非线性激活函数的组合,能够逼近非线性函数。

它是一种强大的机器学习模型,在各个领域都有广泛的应用。

随着深度学习技术的不断发展,我们相信神经网络将会在更多领域展现出强大的能力和应用前景。

函数逼近的几种算法及其应用

函数逼近的几种算法及其应用

一、神经网络

神经网络(neural network)是一种用于模仿人类神经系统的计算模型,它使用多层层次的神经元组成的网络结构来进行复杂的计算,并以调整连接强度的方式来实现学习。

它主要应用于图像识别、语音识别、自动驾驶、推荐系统以及机器翻译等领域。

1.应用于图像识别

2.应用于语音识别

神经网络在语音识别方面也是十分重要的,它可以识别用户说的话,并且做出相应的回应,大大提升了用户的体验。

此外,神经网络也可以用来实现语音识别,从而实现对用户语音输入的理解,从而将用户输入的文本转换成机器可以理解的文本。

3.应用于自动驾驶

神经网络也可以用于自动驾驶,例如它可以帮助自动驾驶车辆在公路上行驶,并在行驶过程中识别路面障碍物,从而避免发生危险。

神经网络在函数逼近中的应用

二 基于BP神经网络逼近函数 基于BP神经网络逼近函数

步骤1:假设频率参数k=1,绘制要逼近的非线性 步骤1:假设频率参数k=1,绘制要逼近的非线性 函数的曲线。函数的曲线如图1 函数的曲线。函数的曲线如图1所示 k=1; p=[p=[-1:.05:8]; t=1+sin(k*pi/4*p); plot( plot(p,t,'-'); '); title('要逼近的非线性函数'); title('要逼近的非线性函数'); xlabel('时间'); xlabel('时间'); ylabel('非线性函数'); ylabel('非线性函数');

图3 训练过程 从以上结果可以看出,网络训练速度很快,很 快就达到了要求的精度0.001。 快就达到了要求的精度0.001。

步骤4 步骤4: 网络测试 对于训练好的网络进行仿真: y2=sim(net,p); figure; plot(p,t,'plot(p,t,'-',p,y1,':',p,y2, '--') '--') title('训练后网络的输出结果'); title('训练后网络的输出结果'); xlabel('时间'); xlabel('时间'); ylabel('仿真输出'); ylabel('仿真输出'); 绘制网络输出曲线,并与原始非线性函数曲线以 及未训练网络的输出结果曲线相比较,比较出来 的结果如图4 的结果如图4所示。

BP网络在函数逼近中的应用 BP网络在函数逼近中的应用

RBF网络应用—逼近非线性函数 神经网络控制课件(第三版)

1

RBF网络应用—逼近非线性函数

Matlab程序

m265a.m

4

RBF网络应用—逼近非线性函数

m265a.m执行结果

构造3个高斯RBF

5

RBF网络应用—逼近非线性函数

m265a.m执行结果

构造非线性函数d=f(u)

6

RBF网络应用—逼近非线性函数

12

RBF网络应用—逼近非线性函数

m265b.m执行结果

网络输出

13

RBF网络应用—逼近非线性函数

m265b.m执行结果

非线性函数d(o) 、网络输出y(*)

14

RBF网络应用—逼近非线性函数

m265b.m执行结果

与m265a.m 执行 结果 比较: 相同

非线性函数d(o) 、网络输出y(*)

m265a.m执行结果

设计的网络输出 y逼近d=f(u)

7

RBF网络应用—逼近非线性函数

m265a.m执行结果

Command Window:

w1 = 0.7000

-1.7000

2.1000

-0.1000

2.7000

-1.4000

3.0000

b1 = 26

1. 设计的RBFNN结构。 2. RBFNN的所有参数。 由m265b.m程序,仿真N1,7,1 逼近非线性函数d=f(u)的过程。

10

RBF网络应用—逼近非线性函数

m265b.m执行结果

7个隐层节点的输出

11

RBF网络应用—逼近非线性函数

m265b.m执行结果

7个隐层节点输出的加权、网络输出

15

RBF网络应用—逼近非线性函数

人工神经网络设计作业

人工神经网络设计作业一、利用感知机神经网络完成真值表中的操作设有一个M-P模型神经元有两个输入P1和P2,其输出为a,让其完成下列的真值表功能:1、具体的程序及其说明如下:clcP=[0 0 1 1;0 1 0 1];T=[0 1 1 1];%提供两组输入一组输出的训练集C=[-2 3 -2 3];%设置坐标轴的范围plotpv(P,T,C)%绘制样本点的坐标pause;[R,Q]=size(P);%R个输入[S,Q]=size(T);%S个输出[W,B]=rands(S,R);%随机获得权值plotpc(W,B)%绘制出初始的决策线pause;A=hardlim(netsum(W*P,B));%计算感知器神经元的输出E=T-A;SSE=sumsqr(E);%计算初始决策线的误差for epoch=1:100if(SSE==0)%若误差为零,画出决策线,并停止训练plot(W,B,'r-')disp('训练成功');breakend[dW,dB]=learnp(P,A,T)%感知器的学习W=W+dW;%修正权值B=B+dB;%调整偏差plotpc(W,B); %绘制决策线pause;a=epoch(1);hold onA=hardlim(netsum(W*P,B));%计算感知器神经元输出E=T-A;%计算误差SSE=sumsqr(E);endA %输出最后的训练结果a %输出训练次数2、具体的训练过程如图所示:样本点P(1)P (2)初始决策线P(1)P (2)训练中的决策线P(1)P (2)训练结束P(1)P (2)3、训练结果:训练结束后我们可知道A=[0 1 1 1],训练次数a=4次。

二、利用BP 网络逼近一个非线性函数1、函数选择为指数衰减函数2*2p te -=*,隐层采用对数正切S 型,输出层采用线性型,具体的程序及其说明如下:clcn=5;%隐层神经元的个数 lr=0.1;%学习率 mc=0.9;%动量因子 p=0:0.05:3; t=2*exp(-2.*p);[r,l]=size(p);%r 输入层的维数 [s,l]=size(t);%s 输出层的维数 w1=0.2*rand(n,r);%隐层的权值 deltaw1=zeros(n,r); B1=0.2*rand(n,1);%隐层的偏移量 deltaB1=zeros(n,1); w2=0.2*rand(s,n);%输出层权值 deltaw2=zeros(s,n);B2=0.2*rand(s,1);%输出层的偏移量 deltaB2=zeros(s,1); A1=tansig(w1*p,B1);A2=purelin(w2*A1,B2);plot(p,t,'r+',p,A2,'b:');xlabel('输入样本p');ylabel('输出样本t');axis([0 3 -1 2])title(['样本点和未经训练的曲线']);legend('样本点');pause;epoch=1;sse=1;for epoch=1:10000 %最大训练圈数为1000w1=w1+deltaw1;%权值及其偏移量的调整B1=B1+deltaB1;w2=w2+deltaw2;B2=B2+deltaB2;[A1,A2]=simuff(p,w1,B1,'tansig',w2,B2,'purelin');E=t-A2;sse(epoch)=sumsqr(E);%计算误差if(sse(epoch)==0.001)%达到期望误差退出逼近breakendD2=deltalin(A2,E);D1=deltatan(A1,D2,w2);[deltaw2,deltaB2]=learnbpm(A1,D2,lr,mc,deltaw2,deltaB2); [deltaw1,deltaB1]=learnbpm(p,D1,lr,mc,deltaw1,deltaB1); if(sse(epoch)<=0.001)breakendend;epochplot(p,t,'r+',p,A2,'b:');xlabel('输入样本p');ylabel('输出样本t');title(['训练',num2str(epoch),'次后的曲线']);legend('样本点');axis([0 3 -1 2])pauseFF=1:epoch;plot(FF,sse(FF),'r-');xlabel('训练次数');ylabel('误差');title(['SSE误差曲线']);pause;%泛化能力测试[A1,A2]=simuff(p,w1,B1,'tansig',w2,B2,'purelin');p=0:0.05:3;t=2*exp(-2.*p);%训练后逼近的曲线plot(p,A2,'-');xlabel('输入样本p');ylabel('输出样本t');legend('逼近的曲线'); axis([0 3 -1 3]) hold on ; pt=0:0.1:3;tt=2*exp(-2.*pt); plot(pt,tt,'ro'); title(['检验泛化能力']); axis([0 3 -1 3]) pause; hold off ; epoch %输出训练次数2、具体的逼近过程如下图形显示:0.511.522.53输入样本p输出样本t样本点和未经训练的曲线0.511.522.53输入样本p输出样本t训练113后的曲线由训练结果显示:完成很好的逼近功能,训练次数为113次,误差曲线如下图,我们可以看到误差是收敛的。

基于Gaussian型RBF神经网络的一元函数逼近性能研究

0 引 言

尽 管 经典 的 函数 逼近 理论分 析严 格 , 但 其诸 多算 法存 在计 算 量 大 、 适 应 性 差 等缺 点 . 而 人工 神 经 元 网 络( A r t i i f c i a l N e u r a l N e t w o r k s , A N N) 具 有 很 强 的非线 性 映射 能力 、 自学 习性 和 容错 性 , 因此在 对 于非 线性 函数 逼近 时 , A N N与经典 的方 法有 着很 大 的不 同 , 这 就使 得 带 有 一个 隐 层 的神 经元 网络 的逼 近性 能 问题

G a u s s i a n型 R B F神 经 网络和 B P神 经 网络 , 并 以正 弦 函数 、 指 数 函数 、 阶跃 函数 三 种 典 型 的一 元

非 线性 函数 为例 , 分别 用 两种 神 经 网络 对其 进行 逼 近 . 仿 真 结 果表 明 , 相 对 于传 统 B P神 经 网络

收稿 日期 : 2 0 1 3— 0 4— 0 1 .

基金项 目: 国家 自然 科 学 基 金 ( N o : 6 1 1 0 4 0 7 1 ) .

作 者简介 : 丁硕 ( 1 9 7 9一 ) , 男, 讲师 , 主要从事动态检测 、 测试信号处理 、 虚拟仪器方面研究

通讯作者 : d i n g s h u o 2 0 0 4 @s i n a . t o m.

计 起来 更 为方便 . 1 G a u s s i a n型 R B F N N 的逼 近定 理

对 任 意一个 输入 一输 出 映射 函数 ) , 存在 一个 R B F N N, 其 中心集 合 为 { t } , 公 共 宽度 为 > 0, 使 得 由该 R B F N N实现 的输 入输 出映射 函数 F( ) 在L p ( p∈[ 1 , ∞] )范数 下 接近 于 ) . 显然 函数 ( )= 1 / ( 1+e x p (一 ) ) 满 足上 述定 理 的条 件 , 可见 一 个 三层 的 A N N足 以逼近 任 何种 类 的非 线性 问题 , 因此 可

BP神经网络函数逼近论文

本科毕业论文(设计)题目指数型(对数型)函数的改进BP神经网络逼近学院数学与统计学院专业数学与应用数学年级2008级学号22200831 4011姓名陈曦指导教师王建军成绩2012年4月16日目录第一章引言 (1)1.背景介绍 (1)2. BP神经网络介绍 (1)2.1 BP网络模型 (1)2.2 BP网络的主要能力: (2)2.3 BP学习算法 (3)2.3.1信号的正向传播 (3)2.3.2BP学习算法的误差反向传播与权值阈值更新增量 (3)2.3.3网络权值阈值跟新公式 (4)2.4 BP网络的局限 (5)2.4.1 局部极小点 (5)2.4.2 学习/收敛速度慢 (6)2.5 标准BP算法的改进 (6)2.5.1 增加动量项的BP学习算法 (6)2.5.2 可变学习率的BP算法 (7)2.5.3 弹性BP学习算法 (7)2.5.4 LM算法 (8)第二章指数(对数)函数的神经网络逼近 (9)3 . 指数(对数)函数逼近区间的确定 (9)4. BP网络设计基础 (9)4.1 输入输出量的选择 (9)4.2 隐含层节点数设计 (9)4.3 改进的BP算法 (10)5. BP神经网络逼近对指数(对数)函数 (10)5.1 传统BP神经网络逼近一元指数和对数函数 (10)5.2 利用改进的BP神经网络逼近指数函数和对数函数 (13)5.2.1 利用改进的BP神经网络逼近一元和二元指数函数 (13)5.2.2 利用改进的BP神经网络逼近一元和二元对数函数 (16)第三章总结与展望 (19)参考文献 (20)致谢 (20)指数型(对数型)函数的改进BP神经网络逼近陈曦西南大学数学与统计学院,重庆 400715摘要: BP(Back-Propagation)网络的职能是对非线性可微分函数进行权值训练,是一种多层前馈网络,它采用最小均方差的学习方式,应用广泛。

大量应用于模式识别、函数逼近、数据压缩以及分类。

基于BP神经网络工具箱实现函数逼近

VoI . 38 No 9

湖

南

农

¥t J、

2 01 1年 9 月

Sep. 2011

HUNAN AG刚CUUr URAL 数逼近

王 丽 萍

( 安大 学 , 长 陕西 西安 70 5 ) 1 0 4

摘 要 : 用计算机 高级语 言编程对神 经 网络 B 模 型进行仿真和辅助设计是件 十分麻烦的事情, 了解决这个 运 P 为 矛盾, aa 神 经网络工具箱 中专 门编制 了大量有 关设计 B 网络模型的工具 函 。 M tb l P 数 文章分析 了 M fb aa 软件 包中人工 l 神 经网络 工具箱 的有 关 B P网络的工具函数,结合一个 实际的例 子详细阐述 了基 于 B P神 经网络 的函数逼近过程及其

l ⅣG - i g Li p n

(h n " nvri, ' hn i7 05 ,hn) C aga U i sy Xin S ax 1 0 4 i n e t a C a

Ab t a t T e h - e e o u e a g a e p o r mmi g o h P n u a ewo k smu ai n a d mo e - i e sr c h ih l v l c mp tr ln u g r g a g n n t e B e rl n t r i l t n d l a d d o

p c a e o ri ca e r l n t r o l o ft e B ew r t i u c in , o i e t ea ld p a t a x m— a k g fa t i ln u a ewo k to b x o h P n t o k u i t f n t s c mb n d wi a d ti r c i le a i f ly o h e c p e b s d o P n u a ewo k f n t n a p o i t n p c s n l a e n B e r l n t r u c i p r x mai r e s a d MAT AB i lme t t n o o o L mp e n ai . o Ke wo d : t b y r s Ma l ;BP n u a ew r ; o l o a e r ln t o k t ob x

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

神经网络作业(函数逼近)

智能控制理论及应用作业

1资料查询

BP 神经网络的主要应用:

人脸识别、风电功率预测、短时交通流混沌预测、高炉熔渣粘度预测、汇率预测、价格预测、函数逼近等

Rbf神经网络的主要应用:

函数逼近、短时交通流预测、模式识别、降水预测、民航客运量预测、遥感影像分析、声纹识别、语言识别、人脸识别、车牌识别、汇率预测

Hopfield网络应用:

车牌识别、图像识别、遥感影像分类、字母识别、交通标志识别、优化计算中的应用、联想记忆存储器的实现、

2 BP编程算法:

T=[1 1 1 ;1 1 1];

%X=-1:0.1:1; %输入范围

%T=sin(pi*X);

%X=[]

q=3; %隐含层的节点数自己定义,在此给3个

%初始化

[M,N]=size(X); %输入节点个数为M,N为样本数

[L,N]=size(T); %输出节点个数为L

wij=rand(q,M); %先给定加权系数一组随机值

wki=rand(L,q);

wij0=zeros(size(wij)); %加权系数矩阵的初始值

wki0=zeros(size(wki));

for epoch=1:max_epoch %计算开始

NETi=wij*X; %各个隐含层的净输入

for j=1:N

for i=1:q

Oi(i,j)=2/(1+exp(-NETi(i,j)))-1; %再输入作用下,隐含层的输出

end

end

NETk=wki*Oi; %各个输出层的净输入

for i=1:N

for k=1:L

Ok(k,i)=2/(1+exp(-NETk(k,i)))-1; %在输入作用下,输出层的输出

end

end

E=((T-Ok)'*(T-Ok))/2; %性能指标函数,就是误差

if(E<error_goal)

break; %判断是否满足

误差,满足的话就直接跳出计算

%不满足的话,就要修正加权系数

else

deltak=Ok.*(1-Ok).*(T-Ok); %计算△k

w=wki;

wki=wki+lr*deltak*Oi'+a*(wki-wki0);

wki0=w;

deltai=Oi.*(1-Oi).*(deltak'*wki)'; %计算△i

w=wij;

wij=wij+lr*deltai*X'+a*(wij-wij0);

wij0=w;

end

epoch

%当前是第多少步

X1=X; %保护当前的输入

NETi=wij*X1; %再一次计算隐含层的输入输出

for j=1:N

for i=1:q

Oi(i,j)=2/(1+exp(-NETi(i,j)))-1; %

end

end

NETk=wki*Oi; %再一次计算输出层的输出

for i=1:N

for k=1:L

Ok(k,i)=2/(1+exp(-NETk(k,i)))-1;

end

end

%直到误差满足要求才跳到此步,输出修正的输出值

Oi %

Ok %最终满足误差要求下的输出

wij %输出输入层与隐含层的最终修改后的权值

wki %输出隐含层与输出层之间的取值end

仿真结果:

epoch = 8

Oi =

0.9690 -0.4804 0.9995

0.9995 0.9244 0.9989

0.9734 0.9991 0.9356

Ok =

1.0000 1.0000 1.0000

0.9982 0.9658 0.9981

wij =

3.5796 2.0282 2.5985

5.3497 -0.4644 2.5773

5.5337 -0.4516 -1.6788

wki =

1.5490 6.1430 5.8803

2.0593 1.3288

3.8144

由仿真结果可以看出,网络在第八步就可以得到满足误差函数的输出,输出时OK。

由于初始权值是随机给定的,因此每次运行结果可能有所差异。

2.2用BP网路逼近sin函数:

function [ output_args ] = BP1( input_args ) %UNTITLED Summary of this function goes here % Detailed explanation goes here

%P=[0 1 2 3 4 5 6 7 8 9 10];

%T=[0 1 2 3 4 3 2 1 2 3 4];

P=-1:0.1:1; %输入范围

T=sin(pi*P); %样本值

net=newff([0

10],[5,1],{'tansig','purelin'}); %建立网络

%net=newff([0

10],[5,1],{'tansig','purelin'},'traingd', 'learngd','msereg');

%net=newff([0

10],[5,1],{'tansig','purelin'},'traingdx'

,'learngd','msereg');

net.trainParam.epochs=200; %训练步长为200

net=train(net,P,T); %开始训练 figure;

Y=sim(net,P); %输入下网络的输出

plot(P,T,'+',P,Y,'o') %将样本与实际输出作图显示

end

逼近结果:

-1-0.8-0.6-0.4-0.200.20.40.60.81-1.5-1

-0.5

0.5

1

1.5

其中+为目标值,O为实际输出值,从逼近小姑来看,效果还是比较理想的。

3 GUI作业:

MATLAB工具箱中常用的几类函数:

前向网络创建函数:

newcf 创建级联前向网络

newff 创建前向BP网络

newffd 创建存在输入延迟的前向网络

传递函数:

logsig S型的对数函数

dlogsig logsig的导函数

tansig S型的正切函数

dtansig tansig的导函数

purelin 纯线性函数

dpurelin purelin的导函数

学习函数:

learngd 基于梯度下降法的学习函数learngdm 梯度下降栋梁学习函数

训练函数:

trainbrBayes 规范化BP训练函数

trainc 循环顺序渐增训练函数

traincgb Powell-Beale连接梯度BP训练函数

traincgf Fletcher-Powell连接梯度BP训练函数

traincgp Polak-Ribiere连接梯度BP训练函数

traingda 自适应lrBP的梯度递减训练函数traingdx 动量及自适应lrBP的梯度递减训练函数

trainlm Levenberg-Marquardt BP训练函数trainoss 一步正切BP训练函数

trainr 随机顺序递增更新训练函数

trainrp 带反弹的BP训练函数

trains 顺序递增BP训练函数

trainscg 量化连接梯度BP训练函数

性能函数:

mse 均方误差函数

msereg 均方误差规范化函数

显示函数:

plotperf 绘制网络的性能

plotes 绘制一个单独神经元的误差曲面plotep 绘制权值和阈值在误差曲面的位置errsurf 计算单个神经元的误差曲面

GUI的应用:

我选择的是建立BP网络逼近sin 函数

首先在MATLAB主窗口输入nntool即可进入神经网络工具箱点击下方的creat network or data即可进行输入、目标输出及网络的选择。

1首先输入一个输入X:[-1:0.1:1];

再输入期望输出T:[sin(pi*(-1:0.1:1))];

2然后建立BP网络如下图所示:

命名为BP1

选取网络形式中选择:前馈BP网络,输入选择X,期望输出选择T,

训练函数选

择:TRAINLM(Levenberg-Marquardt BP训练函数)

学习函数选择:LEARNGD(基于梯度下降法的学习函数)

误差计算函数选择MSE(均方误差函数),

神经元传输函数选择:TANSIG( S型的正切函数)

单击creat即可建立网络。

3建立好后进行训练

进入训练界面,选择输入和期望输出,即可进行训练。

训练结果如下:

性能如下所示:

可以看出,当系统训练6步时,系统输出即可满足性能要求,此时停止训练。

再此图,我们可以清楚的看清系统的期望输出、实际输出和二者的误差。

从误差可以看出,逼近的sin函数误差是很小的。

同理可利用RBF网络逼近SIN 函数建立网络如图所示:

训练结果如下图所示:

此图显示了利用RBF网路逼近sin函数,总共进行了27步逼近,最后的误差要优于BP网络。

原理清晰之后,可进行多种神经网络的训练,比较不同算法以及不同训练规则及误差计算函数不同对逼近效果的影响,优于时间关系,在此不一一罗列。