信源编码

第6章_信源编码.

2.作用:

设法减少码元数目和降低码元速率,即通常把说的数据压缩 将信源的模拟信号转化成数字信号,实现模拟信号的数字化传输。

3.基本途径:

①使序列中的各个符号尽可能地互相独立--------解除相关性 ②使序列中各个符号的出现概率尽可能地相等--------概率均匀化

清华大学出版社

第6章 信源编码 4.分类: (1) 二元码 若码符号集为X={0,1},所得码字都是二元序列。 (2) 等长码(或称固定长度码) 若一组码中所有码字的码长都相同,即li=l(i=1,2,…,q) (3) 变长码 若一组码中所有码字的码长各不相同, 即任意码字由不同长度li的码符号序列组成 (4) 非奇异码 若一组码中所有码字都不相同, 即所有信源符号映射到不同的码符号序列

M ( n

S

)

清华大学出版社

第6章 信源编码

m (t )

×

ms (t)

ms (t)

低通 滤波器

m (t )

T (t )

(a)抽样

(b)恢复

ms (t ) m(t ) T (t ) m(nTs ) T (t nTs )

n

1 M S ( ) H ( ) M ( ) Ts

量化是指幅度的离散化 利用预先规定的有限个电平来表示模拟抽样值的过程就称为量化。 即用一组规定的电平值,将瞬时抽样值用最接近的电平值来表示。

量化电平 1.5

2

1

V m (t )

0.5

0

-0.5

Ts

2Ts

3Ts 4Ts 5Ts t

1

-1.5

2

清华大学出版社

第6章 信源编码

量化前后模拟信号电平会有误差,而接收端解码后只能还原出量化值,

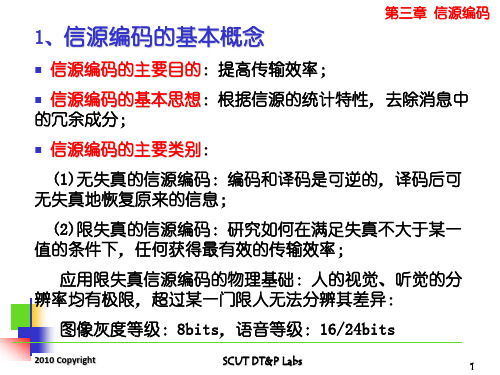

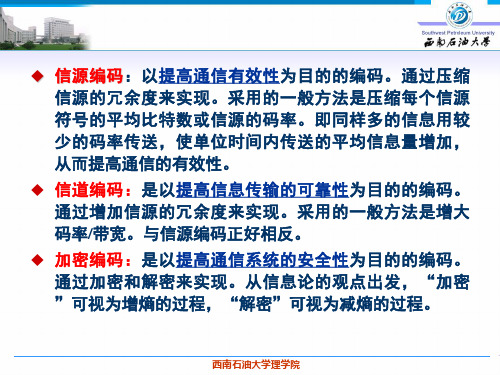

信源编码与信道编码

信源编码与信道编码⼀.信源编码和信道编码的发展历程信源编码:最原始的信院编码就是莫尔斯电码,另外还有ASCII码和电报码都是信源编码。

但现代通信应⽤中常见的信源编码⽅式有:Huffman编码、算术编码、L-Z编码,这三种都是⽆损编码,另外还有⼀些有损的编码⽅式。

信源编码的⽬标就是使信源减少冗余,更加有效、经济地传输,最常见的应⽤形式就是压缩。

相对地,信道编码是为了对抗信道中的噪⾳和衰减,通过增加冗余,如校验码等,来提⾼抗⼲扰能⼒以及纠错能⼒。

信道编码:1948年Shannon极限理论→1950年Hamming码→1955年Elias卷积码→1960年 BCH码、RS码、PGZ译码算法→1962年Gallager LDPC(Low Density Parity Check,低密度奇偶校验)码→1965年B-M译码算法→1967年RRNS码、Viterbi算法→1972年Chase⽒译码算法→1974年Bahl MAP算法→1977年IMaiBCM分组编码调制→1978年Wolf 格状分组码→1986年Padovani恒包络相位/频率编码调制→1987年Ungerboeck TCM格状编码调制、SiMonMTCM多重格状编码调制、WeiL.F.多维星座TCM→1989年Hagenauer SOVA算法→1990年Koch Max-Lg-MAP算法→1993年Berrou Turbo码→1994年Pyndiah 乘积码准最佳译码→1995年 Robertson Log-MAP算法→1996年 Hagenauer TurboBCH码→1996MACKay-Neal重新发掘出LDPC码→1997年 Nick Turbo Hamming码→1998年Tarokh 空-时卷格状码、AlaMouti空-时分组码→1999年删除型Turbo码虽然经过这些创新努⼒,已很接近Shannon极限,例如1997年Nickle的TurboHamming码对⾼斯信道传输时已与Shannon极限仅有0.27dB相差,但⼈们依然不会满意,因为时延、装备复杂性与可⾏性都是实际应⽤的严峻要求,⽽如果不考虑时延因素及复杂性本来就没有意义,因为50多年前的Shannon理论本⾝就已预⽰以接近⽆限的时延总容易找到⼀些⽅法逼近Shannon 极限。

信源编码的实验报告

一、实验目的1. 理解信源编码的基本原理和过程。

2. 掌握几种常见的信源编码方法,如哈夫曼编码、算术编码等。

3. 分析不同信源编码方法的编码效率。

4. 培养动手实践能力和分析问题、解决问题的能力。

二、实验环境1. 操作系统:Windows 102. 编程语言:Python3.73. 实验工具:PyCharm IDE三、实验内容1. 哈夫曼编码2. 算术编码四、实验步骤1. 实验一:哈夫曼编码(1)读取信源数据,统计每个字符出现的频率。

(2)根据字符频率构建哈夫曼树,生成哈夫曼编码表。

(3)根据哈夫曼编码表对信源数据进行编码。

(4)计算编码后的数据长度,并与原始数据长度进行比较,分析编码效率。

2. 实验二:算术编码(1)读取信源数据,统计每个字符出现的频率。

(2)根据字符频率构建概率分布表。

(3)根据概率分布表对信源数据进行算术编码。

(4)计算编码后的数据长度,并与原始数据长度进行比较,分析编码效率。

五、实验结果与分析1. 实验一:哈夫曼编码(1)信源数据:{a, b, c, d, e},频率分别为{4, 2, 2, 1, 1}。

(2)哈夫曼编码表:a: 0b: 10c: 110d: 1110e: 1111(3)编码后的数据长度:4a + 2b + 2c + 1d + 1e = 4 + 2 + 2 + 1 + 1 = 10(4)编码效率:编码后的数据长度为10,原始数据长度为8,编码效率为10/8 = 1.25。

2. 实验二:算术编码(1)信源数据:{a, b, c, d, e},频率分别为{4, 2, 2, 1, 1}。

(2)概率分布表:a: 0.4b: 0.2c: 0.2d: 0.1e: 0.1(3)编码后的数据长度:2a + 2b + 2c + 1d + 1e = 2 + 2 + 2 + 1 + 1 = 8(4)编码效率:编码后的数据长度为8,原始数据长度为8,编码效率为8/8 = 1。

六、实验总结1. 哈夫曼编码和算术编码是两种常见的信源编码方法,具有较好的编码效率。

信源编码

信息工程学院通信工程系

4.1 信源编码基本概念

信源编码模型

信源编码是对信源发出的符号按一定的数学规则进行的 一种变换。 为了分析方便和突出研究的重点,当研究信源编码时, 将信道编码和译码看成是一个整体,以突出信源编码的研究。 X=X1X2… Xi …XK

信源序列

信源编码器

Y=Y1Y2…Yj …YL

信息工程学院通信工程系

4.1 信源编码Leabharlann 本概念N次扩展码 信源符号集

S {s1 , s2 , , sq }

C {W1 ,W2 , ,Wq }

码字符号集 N次扩展信源符号集

N次扩展码字集

S N {1 , 2 , , q N }, j s j1 s j2 s jN

二元码 若码符号集为 {0,1} ,所得码字都是二进制序列,则称为二 元码。二元码是数字通信和计算机系统中最常用的一种码。 等长码(固定长度码) 若一组码中所有码字的码长都相等,称为等长码。 变长码(非固定长度码) 若一组码中码字的码长不完全相同,则称为变长码。

信息工程学院通信工程系

4.1 信源编码基本概念

C N {W1 ,W2 , ,Wq N }, W j W j1W j2 W jN

信息工程学院通信工程系

4.1 信源编码基本概念

唯一可译码

若码的任意一串有限长的码符号序列只能被唯一的译成其 对应的信源符号序列,则此码称为惟一可译码或单义可译码, 否则则称为非惟一可译码或非单义可译码。 若要所编的码是唯一可译码,不但要求编码时不同的信源 符号序列变换成不同的码序列,而且还要求任意有限长的信源 序列所对应的码符号序列各不相同。只有任意有限长的信源序 列所对应的码符号序列各不同,才能将该码符号序列惟一的分 割成一个个对应的信源序列,从而实现惟一的译码。 即时码 在译码过程中只要接收到每个码字(码序列)的最后一个 符号就可立即将该码字译出,这样的码称为即时码;否则称为 非即时码。

信源编码

S {S1, S2 ,..., Sq}

编码器

C :{W1,W2 ,...,Wq}

X {x1, x2,..., xr}

wi 称为码字,Li为码字wi 的码元个数,称为码字wi 的码字 长度,简称码长。

第二节 码的分类

1、二元码: 码符号集X={0,1},如果要将信源通过二元信道传输,必

须将信源编成二元码,这也是最常用的一种码。 2、等长码:

第八章 信源编码

1 引言 2 等长信源编码定理、变长信源编码定理

3 各种编码 4 有噪信道编码定理

5 联合信源信道编码定理

第五章 有噪信道编码

第一节 错误概率与译码规则 第二节 错误概率与编码方法 第三节 有噪信道编码定理 第四节 联合信源信道编码定理 第六节 纠错编码的基本思想 第七节 常用编码方法

l H (S) 2

N log r

则不可能实现无失真编码,当N趋向于无穷大是,译码错 误率接近于1。

第三节 等长信源编码定理

•定理4.3的条件式可写成: l log r NH (S)

左边表示长为 l 的码符号所能载荷的最大信息量, 而右边代表长为N的序列平均携带的信息量。因此, 只要码字传输的信息量大于信源序列携带的信息量, 总可以实现无失真编码 。

信源编码的分类:离散信源编码、连续信源编码和相关信源编 码三类。 离散信源编码:独立信源编码,可做到无失真编码; 连续信源编码:独立信源编码,只能做到限失真信源编码; 相关信源编码:非独立信源编码。

第二节 码的分类

编码器可以看作这样一个系统,它的输入端为原始信

源S,其符号集为S {S1, S2,..., Sq};而信道所能传输的符号集 为 X {x1, x2,..., xr} 编码器的功能是用符号集X中的元素,将 原始信源的符号 Si 变换为相应的码字符号wi ,所以编码器 输出端的符号集为 C :{W1,W2,...,Wq}

数字通信原理3信源编码

2 q/ 2 e2 p(e)de q/ 2 e2 1 de q2

q/2

q q / 2

12

2010 Copyright

SCUT DT&P Labs

27

均匀量化(续)

第三章 信源编码

量化信噪比与量化电平数M之间的关系

设量化范围为:-VP -- +VP,量化电平数 M=2b

量化间隔:q=2VP/M=2VP/2b

3

= 1

12

M i 1

p(mk )q3

q2 12

M i 1

p(mk )q

2010 Copyright

SCUT DT&P Labs

26

均匀量化(续) 利用概率的性质

M

p(mk )q 1

i 1

进一步可得量化噪声功率的简化计算公式

2 q2

12

第三章 信源编码

如假设量化噪声服从均匀分布,亦可得

第三章 信源编码

量化误差

2010 Copyright

SCUT DT&P Labs

24

标量量化(续) (3)有偏型

第三章 信源编码

(4)非均匀型(对小信号误差小)

量化误差

2010 Copyright

SCUT DT&P Labs

25

均匀量化

第三章 信源编码

模拟信号的取值范围:a -b,

量化电平数为M

量化噪声功率:

2 q

q2 12

= VP2 3M 2

1 12

2VP 2b

2 1 12

2VP

2 2 2b

信号功率:

2 x

信噪比:

VP VP

x2

信源编码

a4

1000 0001

异前缀码(即时码):码集中任何一个码不是其他码的前缀。 即时码必定是唯一可译码, 唯一可译码不一定是即时码。 5°有实用价值的分组码 分组码:将信源符号集中的每个信源符号固定地映射成一个码字。

是非奇异码、唯一可译码、即时码 。

六、码树图 1°码树图: 用码树来描述给定码集中各码字的方法。

码字Y i 的码元个数 Ki 称为Y i的码长。 所有码字Y i 的码长 Ki 均相等称为码长为 K 定长码。 码字Y i 的码长 Ki 不全相等称为变长码。

西南石油大学理学院

三、 编码与译码

1°信源编码:将信源符号xi 或符号序列XLi 按一种规则映像成码字 Yi的过程。 2°无失真编码:信源符号到码字的映射必须一一对应。 3°译码:从码符号到信源符号的映射。

x2 x1 x3 x2 x1 x1

x1→1 x2→10 x3→11 则无法唯一分割。

4°按译码的即时性分类

非即时码:接收端收到一个完整的码字后,不能立即译码,还需 要等到下一个码字开始接收后才能判断是否可以译码。

即时码:接收端收到一个完整的码字后,就能立即译码,即时码 又称为非延长码或异前缀码。 即时码与唯一可译码

信源符号 xi 对应的码字为Yi (i = 1, 2, … , n),码字Yi 对应 的码长为 K i(i = 1, 2, …, n ) 。 所有的 K i 相等为定长码,记为 K, 不相等时为变长码。

3°按译码唯一性分类

唯一可译码:对于多个码字组成的有限长码流,只能唯一

地分割成一个个的码字。唯一可译码又称为单义码。

非唯一可译码:对有限长码流,不能唯一地分割成一个个

的码字。

西南石油大学理学院

【例】 码流 100111000 … 码1 码2

信源编码的基本功能

信源编码的基本功能

信源编码是一种将离散型信源的符号序列转换成二进制码的过程。

其基本功能包括:

1. 压缩:信源编码可将原始信源中的冗余信息消除或减少,从而实现对信源数据的压缩。

通过利用信号符号出现的统计规律和概率分布,将出现频率较高的符号用较短的二进制码表示,而将出现频率较低的符号用较长的二进制码表示,以达到数据压缩的目的。

2. 解码:信源编码在进行压缩后,需进行解码以恢复原始信源信息。

解码过程即将经过编码的二进制码转换为原始的符号序列。

解码器根据所使用的编码规则,将编码后的二进制码映射到相应的符号或符号序列,从而还原原始信源信息。

3. 码长控制:信源编码还可以根据不同的需求和应用场景,灵活地设置码长,用于控制编码后的码长。

码长的设置需要平衡数据压缩效果和解码的复杂性。

在需要高压缩比时,可采用码长较短的编码方式;而在需要快速解码和较低的解码器资源消耗的情况下,可采用码长较长的编码方式。

4. 错误检测和纠错:某些信源编码方式还具备一定的错误检测和纠错能力。

通过在编码过程中引入冗余信息,可以在解码阶段检测和纠正一定数量的传输或存储错误,提高信号传输的可靠性。

总之,信源编码的基本功能是将离散型信源符号序列进行压缩,解码,进行码长控制和提供一定的错误检测和纠错能力。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

H(X ) 1 lo g 2 D L

n

H(X ) lo g 2 D

L

可见, 当L 时, lim n

H(X ) lo g 2 D

[注]:(1) 该定理只是一个极限定理,必须在L为无穷时才能达 到理论情况; (2)某些信源(如语音、图象等)在实际应用中往往允许 一定的失真(不研究)。

Ry 1 0.125

• 信源编码的必要性:

实际信源往往含有大量冗余, 比如,英文字母表(含空格 符)共27个符号, 若等概出现,则每个符号的信息量为4.76bit, 而在无记忆情况下实际信源熵只有4.076bit/符号, 若考虑两 个字母之间的相关性,则实际熵只有3.32bit/符号;若考虑 100个字母之间的相关性,则实际信源熵只有1bit/符号,此时 编码剩余度为79%!

W4=111

用码树图编码的步骤: • 从顶点(树根)出发,画出两条(D=2)分枝,一条代表 “0”,另一条代表“1”。选取其中的一个终点作为码字,如 w1=0; • 从未被选用的终点再画出两枝,选其中的一个终点作为码字 w2; • 继续下去,直至W中所有的码字都有一个终点来表示为止; • 从树根出发到各个终点,依次读出各枝代表的符号(0,1), 便得到相应的码字。

例 已知信源S由两个符号S1, S2组成, 其概率分别为3/4和1/4, 试用{0, 1}进行编码. 解 : H (S )

i 1

2

1 3 4 pi log pi log4 log 0.811 bit/符号 4 4 3

(1)单符号编码 : 令S1 0, S2 1 n

n p 1

码效率为100%。

1963年Abramson 发现,若符号出现的概率为 ,取码字长度为ni, 便能编出紧致即时码。

1 pi 2

( )

ni

例 设信源四个符号出现的概率分别为1/2,1/4,1/8,1/8

,试编成紧致即时码,并将其平均码长与信源熵进行比较。 解:由

(2)即时码(非续长码):收到一个码字就能译出,不必等 待与观察后面接收的是什么符号。

例 (1)C1={S1,S2,S3,S4}={0,01,011,111}

接收序列:0111101101

• 若边收边译:0,111,1 译不下去了 • 若收完后再译(从后往前):01,111,011,01 唯一可译,但需要等待 (2)C2={S1,S2,S3, S4,S5}={00,01,10,110,111} 接收序列:110101110100 110,10,111,01,00 (唯一可译 码)

(1)最小平均码长

H(X ) nmin log 2 D

若D=2,则 (2)编码效率:

n

min

H(X )

n min H ( X ) n n log 2 D

(3)编码剩余度:

Ry 1

例 一个离散信源输出为4个长度均为1的符号,每个符号出现的 概率分别为1/2,1/4,1/8。1/8,求平均码长与编码效率。

• 如何编码才能使平均码长最短?

一般离散信源各符号出现的概率并不相等, 由

n pi ( xi ) ni

i 1

m

可知, 概率大的符号编短码,概率小的编长码, 就可以使平均码 长最短. Morse电报就采用这种方法.

字母 E T A ...... J Q Z

pi 0.1073 0.0856 0.0668 0.00108 0.00099 0.00063

x1, x 2, x 3, x 4 X 1 1 1 1 , , , 2 4 8 8

解:

H ( X ) pi logpi 1.75 (bit/符号)

i 1

4

n pi ( xi ) ni 1

i 1

m

n min H ( X ) 1.75 0.875 n n log2 D log24

i i i 1

2

(二进符号/信源符号)

H(S) 81.1%, n log D

R y 1 - 18.9%

(2)二次扩展(L 2) :由S的两个符号构成二次扩 展信源 S2 的一个符号 a 2 S 1S 2 a 3 S 2 S 1 a1 S 1S 1 2 3 1 3 3 3 ( ) 4 4 16 16 4 0 10 110 a4 S 2S 2 2 1 1 16 4 111 (编码)

(4) 须立即可译. 4 变长编码定理:

(1) 若离散信源的熵为H(X),每个信源符号用D进制符号进行编 码,则存在某种编码方法, 其码字平均长度满足

H(X ) H(X ) 1 n log 2 D log 2 D

对于二进制编码(D=2), 则有

1 H(X ) n H(X )

(2) 对于L次扩展信源, 则有以下关系

码(2):等长码,唯一可译,效率较低;

码(3):每码字均以0结尾,称为逗点码,唯一可 译,且可随收随译;

码(4):以0开头,须等待下一个0到来时才能开始 译; 码(5):立即可译。

编码的一般原则: (1) 须唯一可译; (2) 概率大的用短码, 概率小的用长码;

(3) 码字之间不用空格符就能区分;

=R/C

对于无干扰(无噪声)信道,

=实际信源熵/最大信源熵= H (X)/max H(X)

0

问: 能达到多大?

2 [仙农第一定理]:设离散无记忆信源熵为H(X),经容量为 C(bit/符号)的无干扰信道传输,则总可以找到某种编码方 法对信源的输出进行编码,使其在信道中的传信率任意地接 近于信道容量C(正定理)。(证明略)

(3)即时码与唯一可译码(单义码)之间的关系: 即时码一定是唯一可译码(单义码),但唯一可译码(单 义码)不一定是即时码。

2 即时码存在的充要条件

(1)即时码存在的充要条件(从结构上):即时码中任何一 个码字都不能是另一个码字的开头(前缀),或者说任何 一个码字都不能是另一个码字的延续(延长),因而这种 码又称为非续长码。 (2)即时码存在的充要条件(从码长上):存在N个码长为ni (i=1,2,…,n)的即时码的充要条件是

5

0.96875 1

存在即时码

例 设wi表示码长为i的码字数目, 且w1=0, w2=3, w3=0, w4=5, 求:能编成即时码的D的最小值。 解: 3 D 2 5 D 4 1

令x D 2 , 得 3

5 x 2 3 x 1 0,

9 20 即 x , D 2 4.192872 10 即 D 2.05, 故取D 3时可编成即时码 .

逆定理:不存在任何编码方法,使传信率R大于等于C。

使 1, 1的过程就是使信源最佳化的过程。 3 信源编码器的作用:改造信源,使H(X)最大化,从而 信源编码又称为使信源与信道匹配的最佳编码。 类比:

信源又分为有记忆信源与无记忆信源: 有记忆信源-信源发出的符号前后有关连,一个符号 的出现会影响另一个符号的出现。 无记忆信源-符号之间是独立的,一个符号出现的概 率与前面出现的符号有关。

5 霍夫曼(Huffman)法

*6 数据压缩的分类与国际标准简介

§1

1

基本

例 汉字电报 汉字符号标准电码五单元电码, 即 {汉字} {0,1,2,…,9} {0,1}(5位0、1表示一个数字)

0 01101,1 01011,2 11001,…,4 11010,…,

• Efficiency

– Average code length as small as possible

• Reliability

– The ability to recover from errors in the transmission

提要

1 基本概念 2 基本定理:变长编码定理 3 即时码(非续长码) 4 仙农-费诺(Shannon-Fano)法

8 01110,9 10011 中(0022) 01101 01101 1101 1101 国(0948) 01101 10011 11010 01110

2 信源编码:又称数据(语音、图象、文本)压缩,目的在于 减少数字信息中的冗余度,提高通信或存储的有效性

连续信源编码: (A)A/D转换(不讨论); (B)去冗余度。 离散信源的统计特性: 离散消息-在有限符号集中选取若干个符号组成的随机序列; 形成消息时,各符号出现的概率不同;

Morse 码 ----- -

3 编码方法

例 一个离散信源由4个符号S1, S2, S3, S4组成,其出现的概率分 别为0.6, 0.2, 0.2, 0.1和0.1, 试用不同的方法编码,并加以比较.

码(1):若发S4S1=(110),接收时既可译成11, 0=S4S1,

也可译成110=S3, 不唯一可译;

第3篇(戴书第8章,p.114)

信源编码

Source Coding

Efficiency vs. Reliability

Coding Information source Source coding Channel coding Information channel Destination Source decoding Channel decoding Decoding

• H(X)最大化包含两个步骤:

(1)符号独立化,除符号之间的相关性;

(2)各符号概率均匀化。

本章只考虑无记忆离散信源的编码,不考虑步骤 (1)。

§ 3 编码效率及变长编码定理

1 最小平均码长与编码效率 平均码长:

n pi ( xi ) ni

i 1

m

可以证明,码字的平均长度

H(X ) n log 2 D

要求:• 唯一可译;