储层预测技术

储层预测技术详解

LPM 储层预测技术LPM 是斯伦贝谢公司GeoFrame 地震解释系统中最新推出的储层预测软件,利用地震属性体来指导储层参数(如砂岩厚度)在平面的展布,以此来实现储层参数的准确预测。

LPM 预测储层砂体可分两步进行:首先,它是将提取的地震属性特征参数与井孔处的砂岩厚度、有效厚度进行数据分析,将对储层预测起关键作用的地震属性特征参数优选出来,根据线性相关程度的大小,建立线性或非线性方程。

线性方程的建立主要采用多元线性回归方法;非线性方程的建立主要采用神经网络方法;其次,根据建立的方程,利用网格化的地震属性体来指导储层参数(如砂岩厚度)在平面的成图。

4.1.1多元线性回归基本原理设因变量y 与自变量x 1, x 2 ,…,x m 有线性关系,那么建立y 的m元线性回归模型:ξβββ++++=m m x x y 110其中β0,β1,…,βm 为回归系数;ξ是遵从正态分布N(0,σ2)的随机误差。

在实际问题中,对y 与x 1, x 2 ,…,x m 作n 次观测,即x 1t , x 2t ,…,x mt ,即有:t mt m t t x x y ξβββ++++= 110建立多元回归方程的基本方法是:(1)由观测值确定回归系数β0,β1,…,βm 的估计b 0,b 1, …,b m 得到y t 对x 1t ,x 2t ,…,x mt ;的线性回归方程:t mt m t t e x x y ++++=βββ 110其中t y 表示t y 的估计;t e 是误差估计或称为残差。

(2)对回归效果进行统计检验。

(3)利用回归方程进行预报。

回归系数的最小二乘法估计根据最小二乘法,要选择这样的回归系数b 0,b 1, …,b m 使∑∑∑===----=-==nt n t mt m t t t t n t tx b x b b y y y e Q 11211012)()( 达到极小。

为此,将Q 分别对b 0,b 1, …,b m 求偏导数,并令0=∂∂bQ ,经化简整理可以得到b 0,b 1, …,b m ,必须满足下列正规方程组:⎪⎪⎩⎪⎪⎨⎧=+++=+++=+++my m mm m m y m m y m m S b S b S b S S b S b S b S S b S b S b S22112222212111212111 m m x b x b x b y b ----= 22110其中∑==nt t y n y 11 m i x n x nt it i ,,2,111==∑= ),,2,1())((1))((1111m i x x n x x x x x x S S nt n t jt it jt n t it j jt i n t it ji ij =-=--==∑∑∑∑==== ),,2,1())((1))((1111m i y x n y x y y x x S nt n t t it n t t it t i n t it iy =-=--=∑∑∑∑====解线性方程组,即可求得回归系数i b ,将i b 代入式可求出常数项0b 。

储层弹性参数预测方法及其核心技术优化研究

储层弹性参数预测方法及其核心技术优化研究引言:储层弹性参数是地球物理学中重要的一项参数,对于油气勘探与开发具有重要的意义。

准确预测储层弹性参数能够有效地指导油气勘探工作,在提高开发效率和降低风险方面起到关键作用。

本文旨在研究储层弹性参数预测方法及其核心技术的优化,为油气勘探和工程应用提供支持。

储层弹性参数预测方法:1. 基于孔隙结构的预测方法:该方法依赖于储层的孔隙结构特征,通过分析孔隙度、孔隙连接性等指标来预测储层的弹性参数。

这种方法具有简单、直观的特点,但对孔隙结构的精确描述和理解要求较高。

2. 基于地心引力的预测方法:该方法利用地心引力场对储层密度分布的影响,通过重力测量数据来反演储层弹性参数。

这种方法适用范围广,但需要准确的重力测量数据,并且对地质模型的约束较高。

3. 基于地震数据的预测方法:该方法利用地震波在不同介质中传播速度变化对储层的弹性参数进行预测。

常用的方法包括层析成像、波动方程反演等。

这种方法具有较高的分辨率和灵敏度,但对地震数据质量和处理方法要求较高。

储层弹性参数预测核心技术优化研究:1. 数据质量优化:地球物理勘探数据中常常存在噪音和不确定性,对数据进行质量优化是保证预测结果准确性的关键。

应采用合适的滤波、去噪和补偿方法,提高数据信噪比和分辨率。

2. 弹性参数反演与模型约束:在进行弹性参数预测时,反演方法和地质模型的约束是关键因素。

优化反演方法的选择和参数设置,结合地质模型约束,能够提高预测结果的可靠性和准确性。

3. 多源数据融合:利用不同来源的地球物理数据,如地震数据、重力数据、电磁数据等,进行多源数据融合可提高预测结果的精度。

通过合理权衡不同数据的优势和缺点,融合各种数据来源能够克服单一数据的局限性。

4. 机器学习与人工智能技术:近年来,机器学习和人工智能技术在储层弹性参数预测中得到广泛应用。

通过建立数据驱动的预测模型,利用机器学习算法进行特征提取和预测,能够更加高效地解决储层弹性参数预测问题。

地球物理与优质储层预测技术及其在复杂岩性储层评价中的应用

地球物理与优质储层预测技术及其在复杂岩性储层评价中的应用地球物理是研究地球内部及其周围的物理现象和性质的学科,而优质储层是指具有较高油气赋存能力和开发潜力的储层。

地球物理与优质储层预测技术结合起来,可以在复杂岩性储层评价中发挥重要作用。

本文将从地球物理与优质储层预测技术的基本原理入手,讨论其在复杂岩性储层评价中的应用。

首先,地球物理与优质储层预测技术的基本原理。

地球物理方法主要包括地震、电磁、重力和磁法等多种方法,这些方法能够探测地下储层的性质和分布。

其中,地震方法是最常用的一种方法,通过观测地震波的传播和反射特征,可以获取岩层的构造和岩性信息。

电磁方法利用电磁场的变化来探测地下储层的电性特征,可以识别出含油气的地层。

重力和磁法则利用地球引力和地磁场的变化来推断储层的密度和磁性特征。

这些地球物理方法可以提供储层的地质属性、物理属性和构造属性等信息,从而帮助预测优质储层。

其次,地球物理与优质储层预测技术在复杂岩性储层评价中的应用。

复杂岩性储层通常具有岩性变化大、孔、隙、裂缝等不连续性的特点,传统的岩性预测方法往往无法准确预测复杂储层的分布和性质。

地球物理方法可以通过获取储层的物理属性来间接推断其岩性特征,从而解决传统方法的局限性。

例如,地震方法可以通过分析地震波在不同岩性界面上的反射特征,识别出储层的岩性变化和流体存在情况。

电磁方法可以通过测量电磁场的变化,识别出具有高电导率的储层,从而预测储层的岩性和含油气性质。

重力和磁法可以通过测量地球引力和地磁场的变化,推断储层的密度和磁性特征,进而预测岩性的分布。

地球物理方法通过获取储层的物理属性,为复杂岩性储层的评价提供了可靠的数据支持。

最后,地球物理与优质储层预测技术在复杂岩性储层评价中的应用还有一些亟待完善的方面。

由于复杂岩性储层具有多样性和多尺度性的特点,地球物理方法在解决其评价难题时还存在一些困难。

例如,岩性变化和流体存在情况对地震波的传播和反射特征产生复杂影响,如何准确解释地震数据并识别出储层的岩性特征仍然是一个挑战。

精细储层预测技术在陈官庄地区沙四下红层勘探中的应用

对研究区钻穿沙四下亚段的 19 口井的测井曲线进行 重处理。在处理过程中对 SP、GR、IMP 曲线进行基线校 正,曲线全部标准化,基线校正至 0.5 ;同时为了岩性解释 方便,将 GR 与 SP 曲线偏转,正向指向砂 ;确定增益值, 将砂层对应曲线最大增益到 1。处理前,SP 曲线对薄砂层 基本无检测能力,而重处理后,SP 曲线与薄砂层非常好的 对应关系,SP 曲线弧度值 >0.55(弧度曲线)以上曲线对 应为砂层(图 3)。

图 2 测井曲线特征重处理算法流程图

比 ;其次,通过曲线特征调整,突出了曲线反映薄夹层组合 特征,使 IMP、GR、SP 对薄砂层有良好对应,有利于后期 的地震属性反演 ;最后,突出不同曲线对不同岩性薄层的响 应能力。总的来说,重处理后的曲线,SP 对砂岩薄层具有最 好的检测能力,GR 对云、灰岩薄层有较好的检测能力,IMP 介于两者之间。对测井曲线进行交汇分析,得到 GR 与 DEN 交汇能准确识别岩性,不同岩性薄层电性区间明显,分出 6 个子区对岩性进行识别。

2.3.1 反演基本原理

基于地质统计学理论的储层随机反演(GSINV)是一种 利用测井岩性、物性资料,并应用地质统计学(克里金、协 克里金)理论,以密度函数为控制,求取地震 - 地质(岩 性)相关关系,进行岩性随机反演的一种方法。常用的随机 反演是基于变差函数的随机反演 :以三维地震道为网格,利 用地质统计学中建模的方法作为模型扰动,以实钻井波阻抗 为条件,利用层位控制,求取空间变差函数作为空间约束, 得到其他位置的波阻抗序列。在这个过程中,一方面要取得 合理的模型是很困难的 ;另一方面,如果在工区内井资料较 少、钻井分布不均匀的情况下,求取的变差函数变得极不稳 定,也难求得比较合理的模型,就必然会影响解的可靠性。

油气储层预测与优化开发技术研究

油气储层预测与优化开发技术研究第一章油气储层预测技术1.1 概述油气储层预测是油气勘探和开发过程中的关键环节,它涉及到确定储层的存在性、类型、分布、厚度和气水储集条件等。

准确的油气储层预测能够为油气勘探和开发提供重要的指导,降低勘探风险,提高资源开发效率。

1.2 直接预测方法直接预测方法是利用地球物理勘探技术和测井资料进行储层预测。

常用的直接预测方法包括地震反射法、地电阻率法、电磁法、重力法和磁法等。

这些方法可以通过记录和解释地下构造和储层的物理特征,来推断储层的存在和性质。

1.3 间接预测方法间接预测方法是通过对储层相关因素的认识和分析,从而推断出储层信息。

常用的间接预测方法有地质学方法、地球化学方法和数学统计方法等。

地质学方法主要是通过对构造形态、沉积环境和岩石特征等进行分析,来预测储层的存在性和分布情况。

地球化学方法则是通过研究储层中的化学成分和物理特性等,来推断储层的特征。

数学统计方法是利用数学统计学原理和方法,通过建立数学模型来分析储层的存在和性质。

第二章油气储层优化开发技术2.1 概述油气储层优化开发技术是指通过合理的开采方式和方法,最大限度地提高储层的采收率,并降低开发成本。

油气储层优化开发技术是油气开发过程中的关键环节,对于提高勘探开发的效益具有重要意义。

2.2 增注技术增注技术是指通过注入压裂液、蒸汽、气体等物质来改变储层的物理特性,从而提高储层的渗透性和采收率。

常用的增注技术包括水平井、压裂、CO2注入、蒸汽驱和聚合物驱等。

这些技术可以改变储层的渗透性和压力分布,提高油气的采集效率。

2.3 EOR技术EOR(Enhanced Oil Recovery)技术是指通过注入CO2、化学药剂、微生物或其他物质,来提高储层中的原油采收率。

常用的EOR技术包括水驱、聚合物驱、聚合物-水驱、CO2驱、溶剂驱和微生物驱等。

这些技术能够改变原油-储层相互作用,提高油气的采集效率。

2.4 数据管理与动态监测数据管理与动态监测是油气储层优化开发中的重要环节。

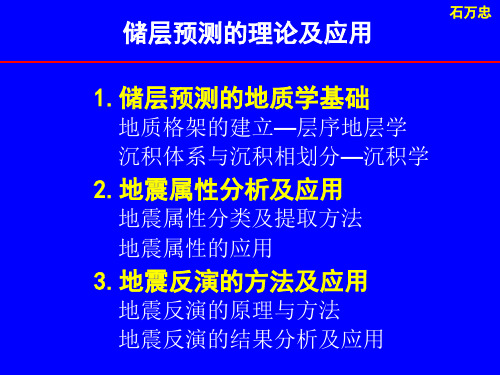

储层预测的理论及应用

准

层

序

准层序组(parasequence set) 则是由成因上相关的若干小层序所组成 的序列,其垂向上构成一个特征的叠加 型式。 准层序(parasequence)是由相 对整合、成因上相关的层或层组所组成 的序列,它们以海(湖)泛面和与之可以 对比的面为界。相当于四级或五级沉积 旋回。

准层序组类型及其特征

层序地层单元基本展布特征示意图

三、 层序分级

表 2 -1 沉 积 层 序 级 次 itc h u m & P.R .Va il 时 间 跨 度 /M a >50 5~ 50 0 .5 ~ 5 0 .1 ~ 0 .5 0 .0 1 ~ 0 .1 叠加层序(组) 复 合 层 序 ,层 序 高 频 层 序 ,准 层 序 高 频 层 序 ,准 层 序 层序性质 R .K .G o ld h a m m e r 时 间 跨 度 /M a >100 10~ 100 1~ 10 0 .1 ~ 1 0 .0 1 ~ 0 .1 超层序 层序 准层序组 准层序 层序命名 M .E .T u c k e r 时间跨度 >100 10~ 100 1~ 10 0 .1 ~ 1 0 .0 1 ~ 0 .1 层序机理 全球大地构造 拉张和热沉降 全球海面变化 板内应力 全球冰川期

基准面与地表的关系

岩性地层剖面及侵蚀作用、沉积物的路过、沉积作用和非补偿沉积作用的时 空迁移对比图(据Wheeler图解法)

7、沉积物供应与可容纳空间的充填

河流搬运是碎屑物质从大陆内部向沉积 盆地搬运的主要方式。现代河流研究显示沉 积物对大陆边缘的供应与分配有巨大的变化。 据Summerfield(1991)的统计70%的沉积物被 沉积在10%的大陆面积中。亚洲的三大河流: 黄河,布拉马普特拉河,恒河的沉积物输送 量便可占全球河流总负载的20%.

储层预测技术详解

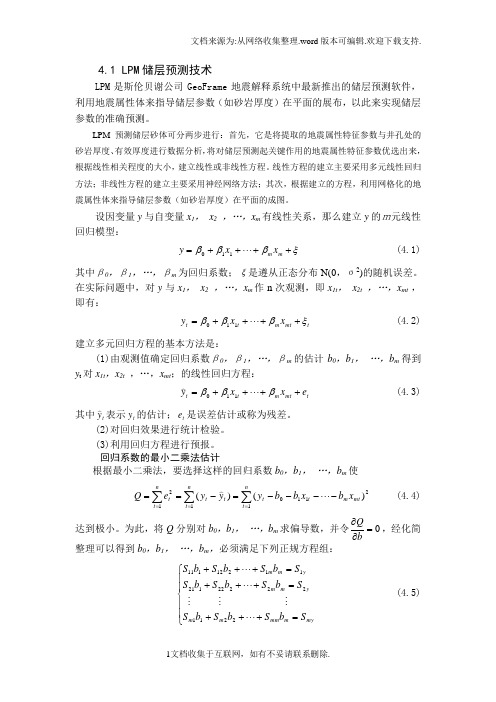

4.1 LPM 储层预测技术LPM 是斯伦贝谢公司GeoFrame 地震解释系统中最新推出的储层预测软件,利用地震属性体来指导储层参数(如砂岩厚度)在平面的展布,以此来实现储层参数的准确预测。

LPM 预测储层砂体可分两步进行:首先,它是将提取的地震属性特征参数与井孔处的砂岩厚度、有效厚度进行数据分析,将对储层预测起关键作用的地震属性特征参数优选出来,根据线性相关程度的大小,建立线性或非线性方程。

线性方程的建立主要采用多元线性回归方法;非线性方程的建立主要采用神经网络方法;其次,根据建立的方程,利用网格化的地震属性体来指导储层参数(如砂岩厚度)在平面的成图。

设因变量y 与自变量x 1, x 2 ,…,x m 有线性关系,那么建立y 的m元线性回归模型:ξβββ++++=m m x x y 110 (4.1)其中β0,β1,…,βm 为回归系数;ξ是遵从正态分布N(0,σ2)的随机误差。

在实际问题中,对y 与x 1, x 2 ,…,x m 作n 次观测,即x 1t , x 2t ,…,x mt ,即有:t mt m t t x x y ξβββ++++= 110 (4.2)建立多元回归方程的基本方法是:(1)由观测值确定回归系数β0,β1,…,βm 的估计b 0,b 1, …,b m 得到y t 对x 1t ,x 2t ,…,x mt ;的线性回归方程:t mt m t t e x x y ++++=βββ 110 (4.3)其中t y 表示t y 的估计;t e 是误差估计或称为残差。

(2)对回归效果进行统计检验。

(3)利用回归方程进行预报。

回归系数的最小二乘法估计根据最小二乘法,要选择这样的回归系数b 0,b 1, …,b m 使∑∑∑===----=-==nt n t mt m t t t t n t tx b x b b y y y e Q 11211012)()( (4.4) 达到极小。

6-提高地震储层预测精度的技术方法与实例-雍学善

二、储层预测主要技术

通过技术调研,了解到国内外储层预测技术发展动 态。 主要调研8家单位: 兰德马克公司北京代表处(LandMark) 帕拉代姆公司北京办事处(Paradigm) 斯伦贝谢科技服务(北京)有限公司(Schlumberger) 北京协成正科技有限公司(Veritas Hampson-Russell) 辉固地球科技有限公司(Fugro-Jason) 地模科技有限公司(Geomodeling) GNT国际公司北京代表处( GNT ) 美国APEX技术公司北京代表处( APEX )

前 言

关键环节与主要技术

层位解释

构造解释

储层横向预测主要技术

层位解释 断裂分析 地震相分析

断裂分析 三维可视化 地震相分析

储层预测环节

沉积分析

属性分析 三维可视化 属性分析 三维可视化 属性分析 地震反演 AVO技术

储层预测

地震反演 三维可视化 AVO技术

油气检测

属性分析 三维可视化

题

纲

一、前言 二、储层预测主要技术 三、逐级控制的技术方案 四、提高精度的思考与启示 五、储层预测研究实例 六、储层预测技术展望

流体 识别

Hydrocarbon Detection

技术 地球 物理 石油

储层预测

构造成像

据姚逢昌

前 言

地震资料中包含的主要地质信息

构造信息:层位、速度、相干体、相位; 沉积信息:地层厚度、地震波形; 储层信息:振幅、波形、频率; 油气信息:频率、速度、AVO ; 特征:低频、低速+AVO异常。

二、储层预测主要技术

地震相分析技术

Stratimagic对地震 层段进行地震相分析, 所使用技术的基础是用 于地震道波形识别的神 经网络技术。在选取的 目的层段对波形进行神 经网络分类,通过迭代 计算模型道,然后将模 型道与实际地震道进行 对比,通过自适应试验 和误差处理在模型道与 实际地震道之间寻找最 佳的相关性,从而得到 地震相平面图。 (帕拉代姆公司)

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

4.1 LPM 储层预测技术LPM 是斯伦贝谢公司GeoFrame 地震解释系统中最新推出的储层预测软件,利用地震属性体来指导储层参数(如砂岩厚度)在平面的展布,以此来实现储层参数的准确预测。

LPM 预测储层砂体可分两步进行:首先,它是将提取的地震属性特征参数与井孔处的砂岩厚度、有效厚度进行数据分析,将对储层预测起关键作用的地震属性特征参数优选出来,根据线性相关程度的大小,建立线性或非线性方程。

线性方程的建立主要采用多元线性回归方法;非线性方程的建立主要采用神经网络方法;其次,根据建立的方程,利用网格化的地震属性体来指导储层参数(如砂岩厚度)在平面的成图。

4.1.1多元线性回归基本原理设因变量y 与自变量x 1, x 2 ,…,x m 有线性关系,那么建立y 的m元线性回归模型:ξβββ++++=m m x x y 110 (4.1)其中β0,β1,…,βm 为回归系数;ξ是遵从正态分布N(0,σ2)的随机误差。

在实际问题中,对y 与x 1, x 2 ,…,x m 作n 次观测,即x 1t , x 2t ,…,x mt ,即有:t m t m t t x x y ξβββ++++= 110 (4.2)建立多元回归方程的基本方法是:(1)由观测值确定回归系数β0,β1,…,βm 的估计b 0,b 1, …,b m 得到y t 对x 1t ,x 2t ,…,x mt ;的线性回归方程:t m t m t t e x x y ++++=βββ 110 (4.3)其中t y 表示t y 的估计;t e 是误差估计或称为残差。

(2)对回归效果进行统计检验。

(3)利用回归方程进行预报。

回归系数的最小二乘法估计根据最小二乘法,要选择这样的回归系数b 0,b 1, …,b m 使∑∑∑===----=-==nt n t mt m t t t t n t tx b x b b y y y e Q 11211012)()( (4.4) 达到极小。

为此,将Q 分别对b 0,b 1, …,b m 求偏导数,并令0=∂∂bQ ,经化简整理可以得到b 0,b 1, …,b m ,必须满足下列正规方程组:⎪⎪⎩⎪⎪⎨⎧=+++=+++=+++my m mm m m y m m y m m S b S b S b S S b S b S b S S b S b S b S22112222212111212111 (4.5) m m x b x b x b y b ----= 22110 (4.6)其中∑==nt t y n y 11 (4.7) m i x n x nt it i ,,2,111==∑= (4.8) ),,2,1())((1))((1111m i x x n x x x x x x S S nt n t jt it jt n t it j jt i n t it ji ij =-=--==∑∑∑∑==== (4.9) ),,2,1())((1))((1111m i y x n y x y y x x S nt n t t it n t t it t i n t it iy =-=--=∑∑∑∑==== (4.10)解线性方程组(4.5),即可求得回归系数i b ,将i b 代入(4.6)式可求出常数项0b 。

4.1.2 BP 网络网络基本原理多层感知器具有独特的学习算法,该学习算法就是著名的BP 算法,所以多层感知器常常被称为BP 网络。

BP 网络是一种层状结构的前馈神经网络,它是由输入层、隐含层(一层或者多层)和输出层构成(图4-3);输入层神经元的个数为输入信号的维数,隐含层个数视具体情况而定,输出层神经元个数为输入信号维数。

BP 神经网络输入层中的每个源节点的激励模式(输入向量)单元组成了应用于第二层(如第一隐层)中神经元(计算节点)的输入信号,第二层输出信号称为第三层的输入,其余层类似。

网络每一层神经元只含有作为他们输入前一层的输出信号,网络输出层(终止层)神经元的输出信号组成了对网络中输入信号(起始层)源节点产生激励模式的全部响应。

即信号从输入层输入,经隐层传给输入层,由输出层得到输出信号。

BP 学习过程可以描述如下:工作信号正向传播:输入信号从输入层经隐单元传向输出层,在输出端产生输出信号,这是工作信号的正向传播。

在信号向前传递过程中网络的权值是固定不变的,每一层神经元的状态只影响下一层神经元的状态。

如果输出层不能得到期望的输出,则转入误差信号的反向传播。

误差信号的反向传播:网络实际输出与期望输出之间的差值即为误差信号,误差信号由输出端开始逐层向前传播,这是误差信号的反向传播。

在误差信号反向传播过程中,网络权值由误差反馈进行调节。

经过权值的不断修正使网络实际输出更接近期望输出。

误差反传播算法(BP 算法)利用梯度下降技术使实际输出y (t)与期望输出d (t)的误差能量最小。

∑-=2/)(2)()()(t t t y d e (4.11)网络学习时,开始取一小的随机数作为网络权值和内部阈值的初值,然后反复输入训练样本,计算实际输出与期望输出的差值,据此调整权值,直至权值收敛,并使代价函数降至可接受值。

对训练样本集中第P 个输入及其期望输出,网络的第j 个节点与第i 个节点的联接权修正量p ji W ∆可用下式计算ij pj pj W O ηδ∆=∙∙ (4.12)式中 η—学习率pi δ—误差项图4-1 BP 人工神经元模型pi O —节点i 的输出其中误差信号δ对输出层和隐含层分别为:)()1()2()()()2()()2()(2t t t t t O d O O -∙-∙=)(δ (4.13)∑-=++∙-∙=10)1()1()()()()()()1(k n i k jik t i k t j k t j k t W O O δδ)( (4.14) 调整后的权值与阈值分别为:)()()()()()1(k t ij k t ij k t ij W W W ∆+=+ (4.15))()()()()()1(k t j k t j k t j δηθθ∙-=+ (4.16)节点输出O 由前向传播算得:)()0()(t j t j x O = (4.17)()⎪⎪⎭⎫ ⎝⎛-∙=∑-=-10)(1)()1()(k n i k j k i k ij t j O W f O θ (4.18) (2)()()t j t y O = (4.19)以上各式中k =0,1,2代表输入层、第一隐层和输出层;N k 为第k 层节点个数;j=0,1,…,(N k -1)。

BP 算法的步骤可归纳为第一步 设置变量和参量:X k =[x k1,x k2,…,x kM ],(k =1,2, …,N )为输入向量,或称训练样本,N 为训练样本个数。

Y k (n)=[y k1(n), y k2(n),…,y kM (n)],(k =1,2, …,N )为第n 次迭代时网络的输出。

η为学习率n 为迭代次数第二步 初始化,赋给初始权值和初始阈值较小的随机非零值。

第三步 随机输入样本X k ,n =0。

第四步 对输入样本前向计算BP 网络每层神经元的输入信号u 和输出信号o 。

第五步 由期望输出d k 和上一步求得的实际输出Y k (n )计算误差E (n ),判断是否满足要求,若满足转至第八步;不满足转至第六步。

第六步 判断n +1是否大于最大迭代次数,若大于转至第八步,若不大于,对输入样本X k ,反向计算每层神经元的局部梯度δ。

第七步 计算权值修正量Δw ,并修正权值;n =n +1,转至第四步。

第八步判断是否学完所有的训练样本,是则结束,否则转至第三步。

上述BP学习过程中要注意几点:(1)BP学习时权值的初始值是很重要的。

初始值过大,过小都会影响学习速度,因此权值的初始值应选为均匀分布的小数经验值,大概为(-2.4/F,2.4/F)之间(也有人建议在(F为所连单元的输入端的个数,另外,为避免每一步的权值的调整方向是同向的(即权值同时增加或同时减小),应将初始权值设为随机数。

(2)神经元的激励函数是Sigmoid函数,如果Sigmoid函数的渐近值为+α和-α,则期望值只能趋近于+α和-α,而不能达到+α和-α。

为避免学习算法不收敛,提高学习速度,应设期望输出为相应的小数,若逻辑函数渐进值为1和0,此时设相应的期望输出为0.99和0.01等小数,而不应设为1和0。

(3)用BP算法训练网络时有两种方式:一种是顺序方式,即每输入一个训练样本修改依次权值;另一种是批处理方式,即待组成训练周期的全部样本都一次输入网络后,以总的平均误差能量为学习目标函数的修正值的训练方式。

顺序方式所需的临时存储空间较批处理方式小,但顺序方式的误差收敛条件难以建立,而批处理方式能够精确的计算出梯度向量,收敛条件非常简单,易于并行处理。

(4)BP学习中,学习步长η的选择比较重要。

η值大权值变换就大,则BP学习的收敛速度就快,但是η值过大引起振荡即网络不稳定;η值小可避免网络不稳定,但是收敛速度就慢了。

要解决这一矛盾最简单的方法就是加入“动量项”。

(5)要计算多层感知器局部梯度δ,需要知道神经元的激励函数f(·)的导数。

(6)在BP算法第五步需要判断误差E(n)是否满足要求,这里的要求是:对顺序方式,误差小于我们的设定值,即E(n)<ε;批处理方式,每个周期的平均误差其变E av化量在0.1%到1%之间,我们就认为满足误差要求了。

(7)在分类问题中,我们会碰到同一类的的训练样本有几组,在第一步设置变量时,一般使用同一类的训练样本其期望输出相同。

4.1.3 LPM储层预测步骤1、油层标定为了分析储层砂体在地震剖面上的反射特征,必须将油层在地震剖面上进行准确的标定。

油层的标定是岩性解释的基础,标定是否准确直接影响到岩性预测的精度。

本次资料解释工作共预测4个油层组,即扶I油层、扶I油层上、中、下部油层的砂岩厚度。

这四个油层分别对应于地震时间剖面上的T2层至T2层+45ms时窗内的反射波。

以T2为基点,将13口井的合成地震记录与时间剖面进行对比,从而确定四个油层组在时间剖面上的反射位置(见图4-2)。

最后,我们根据各油层在时间剖面上占的范围确定各油层岩性预测的时窗长度,使时窗长度既包括了各油层的完整波形,又最大限度地减少了相邻油层波形的进入,保证了砂岩预测的准确性。

2、地震属性参数的提取地震属性参数是从GeoFrame地震解释系统中提取出来的,它是下一步进行储层预测的关键。

根据井孔的目的层的厚度开时窗,读取时窗内的地震数据,进行地震特征参数的提取。

可供提取的地震参数有能量、频谱、波形等三大类32种参数。