Spark大数据商业实战三部曲:内核解密_商业案例_性能调优

Spark大数据处理框架解读与实践案例

Spark大数据处理框架解读与实践案例随着大数据应用的不断增长,高效的大数据处理框架成为了企业和研究机构的关注焦点。

Spark作为一种快速、通用的大数据处理框架,已经成为了业界的热门选择。

本文将对Spark进行深入解读,并通过一个实践案例来展示其强大的大数据处理能力。

Spark是一个基于内存计算的大数据处理框架,由于其强大的计算引擎和丰富的功能,成为了大数据处理领域的佼佼者。

与传统的MapReduce框架相比,Spark 具有以下几个显著优势:首先,Spark充分利用内存计算,大大提高了处理速度。

传统MapReduce框架需要将数据存储在磁盘上,而Spark将数据存储在内存中,从而避免了频繁的I/O 操作,极大地提高了计算效率。

其次,Spark支持多种语言,包括Java、Scala和Python等,使得开发者可以根据自己的偏好和实际应用场景选择最合适的编程语言。

同时,Spark提供了丰富的API和库,如Spark SQL、Spark Streaming和MLlib等,使得开发者可以在同一框架下完成各种不同类型的大数据处理任务。

另外,Spark还支持交互式查询和实时流处理。

通过Spark的交互式Shell,开发者可以快速地进行数据查询和分析,对于业务场景下需要即时响应的数据处理需求非常有用。

而Spark Streaming则提供了实时流处理的功能,使得开发者可以对即时数据进行流式处理和分析。

为了更好地理解Spark的强大能力,我们接下来将通过一个实践案例来演示其在大数据处理中的应用。

假设我们要对一个电子商务网站的用户行为数据进行分析,以了解用户的购买行为和喜好。

首先,我们需要从网站的服务器日志中提取所需的数据。

通过Spark 的强大文件读取功能,我们可以快速地读取和处理大量的日志文件。

接下来,我们可以使用Spark的数据处理和分析功能对提取到的日志数据进行清洗和转换。

比如,我们可以筛选出某一时间段内的用户购买记录,并进行聚合分析,以确定最受欢迎的商品和购买次数最多的用户。

Spark大数据商业实战三部曲:内核解密、商业案例、性能调优

第17章 Spark在通信运营商生产环境中的应用案例

17.1 Spark在通信运营商融合支付系统日志统计分析中的综合应用案例 17.2 Spark在光宽用户流量热力分布GIS系统中的综合应用案例 17.3本章总结

第18章使用Spark GraphX实现婚恋社交网络多维度分析案例

18.1 Spark GraphX发展演变历史和在业界的使用案例 18.2 Spark GraphX设计实现的核心原理 18.3 Table Operator和Graph Operator 18.4 Vertices、edges和triplets 18.5以最原始的方式构建Graph 18.6第一个Graph代码实例并进行Vertices、edges和triplets操作实战 18.7数据加载成为Graph并进行操作实战 18.8图操作之Property Operators实战 18.9图操作之Structural Operators实战

第20章 Spark算子调优最佳实践

20.1使用mapPartitions或者mapPartitionWithIndex取代map操作 20.2使用foreachPartition把Spark数据持久化到外部存储介质 20.3使用coalesce取代rePartition操作 20.4使用repartitionAndSortWithinPartitions取代repartition和sort 的联合操作 20.5使用treeReduce取代reduce的原理和源码 20.6使用treeAggregate取代Aggregate的原理和源码 20.7 reduceByKey高效运行的原理和源码解密 20.8使用AggregateByKey取代groupByKey的原理和源码 20.9 Join不产生Shuffle的情况及案例实战

如何利用Spark大数据技术优化数据处理和分析

如何利用Spark大数据技术优化数据处理和分析随着互联网和技术的快速发展,大量数据的产生和存储已经成为现实。

对于企业或组织来说,如何高效地处理和分析海量数据已成为一项关键任务。

而Spark大数据技术作为一种高性能和灵活的数据处理和分析工具,被越来越多的企业所采用。

本文将重点讨论如何利用Spark大数据技术优化数据处理和分析的方法和技巧。

首先,使用Spark进行数据处理时,可以使用其强大的内存计算能力来提高数据处理的速度和效率。

与传统的磁盘计算相比,Spark将数据存储在内存中,可以避免磁盘读写的瓶颈,快速地对数据进行处理。

为了充分利用Spark的内存计算能力,我们可以通过对数据进行合理的分区和缓存来优化数据处理过程。

分区可以将数据按照某个属性进行划分,使得每个分区都可以在单独的节点上并行处理,提高处理效率。

缓存可以将经常使用的数据存储在内存中,减少磁盘读取的次数,加快数据处理的速度。

其次,利用Spark的分布式计算能力可以实现并行处理和分析大规模数据。

Spark采用Resilient Distributed Dataset(弹性分布式数据集)作为数据的抽象表示,可以将数据分布存储在集群的多个节点上,并利用集群的计算资源并行处理。

通过并行处理,可以大大缩短数据处理和分析的时间。

此外,Spark还提供了丰富的并行操作和函数库,如map、reduce、filter等,可以方便地对数据进行转换和计算。

利用这些操作和函数库,可以轻松地实现各种复杂的数据处理和分析任务。

此外,Spark还提供了一种叫做Spark Streaming的组件,可以实时处理和分析数据流。

与传统的批处理方式不同,Spark Streaming可以将数据流实时切分为小批量数据,并利用Spark的分布式计算能力进行实时处理和分析。

Spark Streaming可以处理各种类型的数据流,如日志数据、网络数据、传感器数据等。

通过实时处理和分析数据流,可以实时监控和控制业务流程,及时发现和处理异常情况,提高业务的响应速度和效率。

spark应用场景与案例

spark应用场景与案例Spark应用场景与案例。

Spark作为当前最流行的大数据处理框架之一,具有高速、通用、容错和强大的特点,被广泛应用于各行各业的大数据处理和分析中。

本文将介绍Spark的应用场景及相关案例,以帮助读者更好地了解Spark在实际工作中的应用情况。

1. 金融行业。

在金融行业,大数据处理是至关重要的。

Spark可以帮助金融机构处理海量的交易数据、用户信息和市场数据,进行实时的风险分析、交易监控和推荐系统。

例如,美国的一家大型投资银行利用Spark构建了实时风险管理系统,能够在毫秒级别内处理数十亿条交易数据,并及时发出预警。

2. 零售行业。

零售行业也是Spark的重要应用领域之一。

大型零售商可以利用Spark处理来自各个渠道的销售数据,进行实时的库存管理、销售预测和个性化推荐。

例如,亚马逊利用Spark构建了一个实时的推荐系统,能够根据用户的浏览和购买记录,为其推荐个性化的商品,提高销售转化率。

3. 电信行业。

电信行业的数据量庞大,包括用户通话记录、基站数据、网络流量等。

Spark 可以帮助电信运营商分析用户行为、优化网络资源分配和预防欺诈行为。

中国移动利用Spark构建了一个实时的通话质量监控系统,能够及时发现通话异常和网络故障,提高通信质量。

4. 医疗保健行业。

在医疗保健行业,大数据分析可以帮助医院管理患者信息、优化医疗资源配置和进行疾病预测。

Spark可以处理医疗影像数据、基因组数据和临床数据,帮助医生进行诊断和治疗。

例如,美国的一家医疗科技公司利用Spark构建了一个基于患者数据的个性化治疗平台,能够为医生提供个性化的治疗方案。

5. 互联网行业。

互联网行业是Spark的重要应用领域之一。

大型互联网企业可以利用Spark处理用户行为数据、广告数据和日志数据,进行实时的个性化推荐、广告投放和用户分析。

例如,Facebook利用Spark构建了一个实时的广告投放系统,能够根据用户的兴趣和行为,为其推荐相关的广告,提高广告点击率。

Spark性能优化之开发调优篇

Spark性能优化:开发调优篇1、前言在大数据计算领域,Spark已经成为了越来越流行、越来越受欢迎的计算平台之一。

Spark的功能涵盖了大数据领域的离线批处理、SQL类处理、流式/实时计算、机器学习、图计算等各种不同类型的计算操作,应用范围与前景非常广泛。

在美团?大众点评,已经有很多同学在各种项目中尝试使用Spark。

大多数同学(包括笔者在内),最初开始尝试使用Spark的原因很简单,主要就是为了让大数据计算作业的执行速度更快、性能更高。

然而,通过Spark开发出高性能的大数据计算作业,并不是那么简单的。

如果没有对Spark作业进行合理的调优,Spark作业的执行速度可能会很慢,这样就完全体现不出Spark 作为一种快速大数据计算引擎的优势来。

因此,想要用好Spark,就必须对其进行合理的性能优化。

Spark的性能调优实际上是由很多部分组成的,不是调节几个参数就可以立竿见影提升作业性能的。

我们需要根据不同的业务场景以及数据情况,对Spark作业进行综合性的分析,然后进行多个方面的调节和优化,才能获得最佳性能。

笔者根据之前的Spark作业开发经验以及实践积累,总结出了一套Spark作业的性能优化方案。

整套方案主要分为开发调优、资源调优、数据倾斜调优、shuffle调优几个部分。

开发调优和资源调优是所有Spark作业都需要注意和遵循的一些基本原则,是高性能Spark 作业的基础;数据倾斜调优,主要讲解了一套完整的用来解决Spark作业数据倾斜的解决方案;shuffle调优,面向的是对Spark的原理有较深层次掌握和研究的同学,主要讲解了如何对Spark作业的shuffle运行过程以及细节进行调优。

本文作为Spark性能优化指南的基础篇,主要讲解开发调优以及资源调优。

2、开发调优Spark性能优化的第一步,就是要在开发Spark作业的过程中注意和应用一些性能优化的基本原则。

开发调优,就是要让大家了解以下一些Spark基本开发原则,包括:RDD lineage设计、算子的合理使用、特殊操作的优化等。

Spark技术的应用和案例

Spark技术的应用和案例Spark技术是目前最流行的大数据处理技术之一,它能够处理海量的数据,并能在分布式环境下进行多节点计算。

在业界,Spark技术被广泛应用于数据分析、机器学习、推荐算法、图计算、实时处理等领域。

本文将介绍Spark技术的应用和案例。

一、数据分析Spark技术在数据分析方面的应用非常广泛,从传统的数据仓库、ETL、数据挖掘到现在的深度学习、自然语言处理等都有涉及。

Spark SQL是Spark生态系统中的一个可伸缩的SQL查询引擎,它能够将结构化数据集与RDD无缝集成。

Spark SQL能够实现SQL查询、数据汇总、子查询、表连接等操作,并支持复杂的数据类型和JSON数据处理。

Spark SQL支持将数据存储在Hive、Hbase等数据存储中心,同时还支持许多数据库连接器的使用。

二、机器学习Spark技术在机器学习方面的应用也非常广泛。

MLib是Spark生态系统中的机器学习库,它提供了常见的机器学习算法,如分类、回归、聚类、推荐系统等,并且能够在Spark的分布式环境下执行。

同时,MLib还支持模型调优、特征转换、模型持久化、模型运行等功能。

根据欧洲中央银行(ECB)的最新报告,Spark MLlib是市场上最快的大规模机器学习库之一,并且在不能卡住的情况下能处理超过50亿个样本。

三、推荐系统Spark技术在推荐系统方面的应用也非常广泛。

Spark中的推荐系统库MLib中提供了常见的协同过滤算法,如基于用户的协同过滤、基于物品的协同过滤等。

并且,Spark能够并行计算用户和物品之间的相似性,从而获得更好的推荐效果。

在Netflix、Amazon 等云计算巨头的推荐系统中,Spark也被广泛应用。

四、图计算Spark GraphX是Spark生态系统中的图计算库,它支持大规模的图计算和图分析。

Spark GraphX能够处理大规模的图形结构,并提供高效的迭代图计算算法,例如PageRank、SSSP、Triangle Counting等。

Spark在数据分析中的应用案例剖析

Spark在数据分析中的应用案例剖析数据分析已经成为现代企业决策过程中不可或缺的一部分。

为提高数据分析的效率和准确性,许多企业开始使用Spark这个快速通用的大数据处理引擎。

本文将通过分析几个真实的案例来展示Spark在数据分析中的应用。

1. 电子商务数据分析电子商务行业的快速发展导致海量的数据产生,传统的数据处理方法无法满足分析和决策的需求。

一家电子商务公司使用Spark进行数据分析,他们首先使用Spark Streaming进行实时数据的收集和处理,包括用户点击数据和购买数据。

接着,他们使用Spark SQL对原始数据进行清洗和转换,得到符合分析需求的结构化数据。

最后,他们使用Spark MLlib进行用户行为分析和个性化推荐。

通过使用Spark,该公司能够更好地理解用户行为,提升网站的转化率和用户体验。

2. 金融风险管理金融风险管理需要处理大量的交易数据和历史数据,以评估投资组合的风险和收益。

一家国际银行使用Spark进行金融风险管理分析。

他们使用Spark GraphX构建投资组合的关联图,通过分析图的结构和特征来评估风险。

同时,他们使用Spark SQL对历史数据进行查询和统计,以识别异常行为和风险因素。

通过使用Spark,该银行能够更准确地识别潜在的风险,并做出相应的决策和调整。

3. 健康数据分析健康领域的数据分析对于优化医疗流程、提升医疗质量具有重要意义。

一家医疗机构使用Spark进行健康数据分析。

他们使用Spark Streaming收集和处理实时的生理数据,如心率、血压等。

接着,他们使用Spark MLlib进行疾病风险预测和个性化治疗建议。

他们还使用Spark SQL对患者的历史数据进行查询和分析,以识别患者的疾病模式和治疗效果。

通过使用Spark,这家医疗机构能够实现个性化医疗,提高治疗效果和患者满意度。

4. 媒体内容分析媒体行业需要对大量的用户行为数据和内容数据进行分析,以理解用户喜好和预测流行趋势。

Spark详解(09)-Spark调优

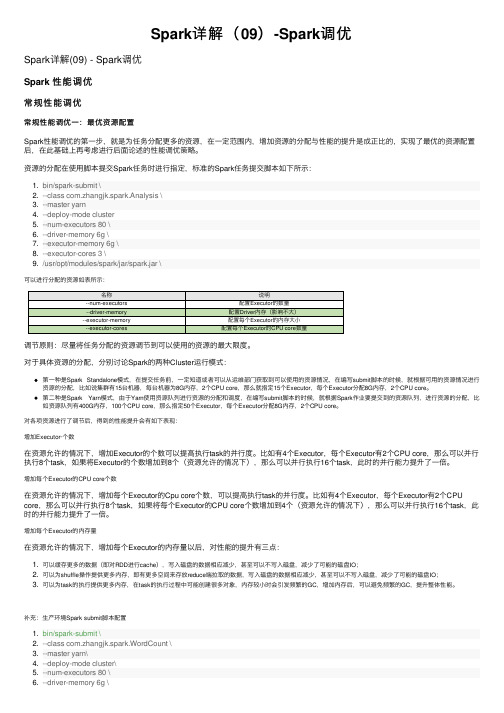

Spark详解(09)-Spark调优Spark详解(09) - Spark调优Spark 性能调优常规性能调优常规性能调优⼀:最优资源配置Spark性能调优的第⼀步,就是为任务分配更多的资源,在⼀定范围内,增加资源的分配与性能的提升是成正⽐的,实现了最优的资源配置后,在此基础上再考虑进⾏后⾯论述的性能调优策略。

资源的分配在使⽤脚本提交Spark任务时进⾏指定,标准的Spark任务提交脚本如下所⽰:1. bin/spark-submit \2. --class com.zhangjk.spark.Analysis \3. --master yarn4. --deploy-mode cluster5. --num-executors 80 \6. --driver-memory 6g \7. --executor-memory 6g \8. --executor-cores 3 \9. /usr/opt/modules/spark/jar/spark.jar \可以进⾏分配的资源如表所⽰:名称说明--num-executors配置Executor的数量--driver-memory配置Driver内存(影响不⼤)--executor-memory配置每个Executor的内存⼤⼩--executor-cores配置每个Executor的CPU core数量调节原则:尽量将任务分配的资源调节到可以使⽤的资源的最⼤限度。

对于具体资源的分配,分别讨论Spark的两种Cluster运⾏模式:第⼀种是Spark Standalone模式,在提交任务前,⼀定知道或者可以从运维部门获取到可以使⽤的资源情况,在编写submit脚本的时候,就根据可⽤的资源情况进⾏资源的分配,⽐如说集群有15台机器,每台机器为8G内存,2个CPU core,那么就指定15个Executor,每个Executor分配8G内存,2个CPU core。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

11.3 Spark与 Job Server整合

原理与实战

11.4 Spark与 Redis整合原理与

实战

11 Spark与大数据其他经典组 件整合原理与实战

02

中篇 商业案例

中篇 商业案例

12 Spark商业案例之大数据电影点评 系统应用案例

14 Spark商业案例之电商交互式分析 系统应用案例

nt实战解析 Spark

RDD内部机 制

上篇 内核解密

01

02

03

4.1 Spark Driver Program剖析

04

4.2 DAGScheduler 解析

4 . 3 Ta s k S c h e d u l e r 解析

05

06

4.4 SchedulerBackend

解析

4.5 打通Spark系统运 行内幕机制循环流程

解析

上篇 内核 解密

3 Spark的灵魂: RDD和DataSet

https:///

3.7 Spark RDD 中Runtime流程

解析

01

3.9 基于 D a t a S e t 的 03 代码到底是 如何一步步

转化成为 RDD的

3.8 通过 02 W o r d C o u

何被Driver管理的

8 Job工作原理和源码详解

8.1 Job到底在 什么时候产生

8.3 Task全生 命周期详解

9.1 Spark中Cache原理和 源码详解

9.2 Spark中checkpoint原 理和源码详解

上篇 内核解密

9 Spark中Cache和checkpoint原理和源码详解

01

6.4 从Application提 交的角度重新审视 Executor

6.5 Spark 1.6 RPC内幕 解密:运行机制、源码详

解、Netty与Akka等

6.6 本章总结

7.1 概述

7.3 Hash Based Shuffle 7.5 Tungsten Sorted Based

Shuffle

上篇 内核解密

上篇 内核解密

01

02

03

3.1 为什么说RDD和 DataSet是Spark的灵

魂

04

3.2 RDD弹性特性七 个方面解析

05

3.3 RDD依赖关系

06

3 Spark的灵魂:RDD和 DataSet

3.4 解析Spark中的 DAG逻辑视图

3.5 RDD内部的计算 机制

பைடு நூலகம்

3.6 Spark RDD容错 原理及其四大核心要点

16 电商广告点击大数据实时流处理系 统案例

13 Spark 2.2实战之Dataset开发实战 企业人员管理系统应用案例

15 Spark商业案例之NBA篮球运动员 大数据分析系统应用案例

17 Spark在通信运营商生产环境中的 应用案例

中篇 商业案例

18 使用Spark GraphX实现 婚恋社交网络多维度分析案例

5 Spark集群启动原理和源码 详解

上篇 内核解密

01

02

03

6.1 Spark Application到底是如

何提交给集群的

04

6.2 Spark Application是如何向

集群申请资源的

05

6.3 从Application提 交的角度重新审视 Driver

06

6 Spark Application提交给 集群的原理和源码详解

01

1.1 通过RDD实战 电影点评系统入门

及源码阅读

2.1 Spark 2.2综述

2.4 Spark 2.2 Streaming

上篇 内核解密

2 Spark 2.2技术及原理

2.2 Spark 2.2 Core

2.5 Spark 2.2 MLlib

2.3 Spark 2.2 SQL

2.6 Spark 2.2 GraphX

Spark大数据商业实战三部曲:内 核解密|商业案例|性能调优

演讲人 2021-11-11

目录

01. 上篇 内核解密 02. 中篇 商业案例 03. 下篇 性能调优

01

上篇 内核解密

上篇 内核解密

1 电光石火间体验 Spark 2.2开发实战

1

6 Spark

Application提交给集

6

群的原理和源码详解

4.6 本章总结

4 Spark Driver启动内幕剖析

上篇 内核解密

5.1 Master启动原理和 源码详解

06

5.6 本章总结

01

02

5.2 Worker启动原理和 源码详解

5.5 Executor执行结果 的处理方式

05

04

03

5.3 ExecutorBackend 启动原理和源码详解

5.4 Executor中任务的 执行

7 Shuffle原理和源码详解

7.2 Shuffle的框架

7.4 Sorted Based Shuffle

7.6 Shuffle与Storage模块 间的交互

上篇 内核解密

7 Shuffle原理和源码详解

7.7 本章总结

上篇 内核解密

8.2 Stage划分 内幕

8.4 ShuffleMapTask和 ResultTask处理结果是如

10.1 Spark中Broadcast原理和源 码详解

02

10.2 Spark中Accumulator原理 和源码详解

上篇 内核解密

10 Spark中Broadcast和Accumulator原理和源码详解

上篇 内核解密

11.1 Spark组 件综合应用

11.2 Spark与 Alluxio整合原理

和Accumulator原理和

4

源码详解

2

8 Job工作原理和源 码详解

9 Spark中Cache

3

和checkpoint原理

和源码详解

上篇 内核解密

03

1.3 Spark 2.2源

码阅读环境搭建及

源码阅读体验

02

1.2 通过DataFrame

和DataSet实战电影点

评系统

1 电光石火间体验Spark 2.2 开发实战

5 Spark集群启动原 理和源码详解

5

2

2 Spark 2.2技术及 原理

3

3 Spark的灵魂: RDD和DataSet

4

4 Spark Driver启 动内幕剖析

上篇 内核解密

7 Shuffle原理和源 码详解

1

11 Spark与大数据

其他经典组件整合原

5

理与实战

10 Spark中Broadcast

中篇 商业案例

01

12.1 通过RDD实现分析电影的用户行为信息

02 1 2 .2 通过RDD实现电影流行度分析

03

12.3 通过RDD分析各种类型的最喜爱电影TopN及性能优化技 巧

04

12.4 通过RDD分析电影点评系统仿QQ和微信等用户群分析及广 播背后机制解密