支持向量回归参数的混合选择

支持向量机模型的参数选择技巧(八)

支持向量机(SVM)是一种用来解决分类和回归问题的强大的机器学习模型。

在实际应用中,选择合适的参数对于SVM模型的性能和准确性至关重要。

本文将讨论支持向量机模型的参数选择技巧,并探讨如何优化模型的性能。

首先,我们来讨论支持向量机模型的两个关键参数:C和gamma。

C是正则化参数,控制了分类器的复杂度。

较小的C值将导致更多的数据点被错误分类,但可以提高模型的泛化能力。

相反,较大的C值将导致更多的数据点被正确分类,但可能导致过拟合。

因此,选择合适的C值是至关重要的。

另一个关键参数是gamma,它影响了核函数的影响范围。

较小的gamma值将导致核函数具有较大的影响范围,从而使得决策边界更加平滑。

相反,较大的gamma值将导致核函数具有较小的影响范围,从而使得决策边界更加复杂。

因此,选择合适的gamma值也是十分重要的。

为了选择合适的参数,我们可以使用交叉验证技术来评估不同参数对于模型性能的影响。

交叉验证将数据集分成训练集和测试集,然后重复多次训练模型并评估性能,以获取更加准确的性能评估。

在不同的C和gamma值下,我们可以通过交叉验证选择能够最大化模型性能的参数。

此外,网格搜索技术也是一种常用的参数选择方法。

网格搜索通过在给定的参数范围内尝试所有可能的组合,并选择具有最佳性能的参数组合。

这种方法虽然计算量较大,但能够在给定的参数空间内找到最优的参数组合。

除了C和gamma参数外,选择合适的核函数也是影响模型性能的重要因素。

支持向量机模型通常使用线性核、多项式核和径向基核函数。

在实际应用中,我们需要根据数据集的特点选择合适的核函数。

例如,对于线性可分的数据集,可以选择线性核函数;对于非线性可分的数据集,可以选择多项式核函数或者径向基核函数。

选择合适的核函数能够显著提高模型的性能。

此外,数据预处理也是提高支持向量机模型性能的关键步骤。

对数据进行标准化、归一化、缩放等预处理操作,可以使得模型更加稳定和准确。

支持向量机模型的超参数调优技巧

支持向量机模型的超参数调优技巧支持向量机(Support Vector Machine,SVM)是一种常用的机器学习算法,广泛应用于分类和回归问题。

然而,SVM模型的性能很大程度上依赖于超参数的选择。

本文将介绍一些常用的SVM模型的超参数调优技巧,帮助读者提高模型性能。

首先,我们需要了解SVM模型的超参数。

SVM模型有两个重要的超参数:惩罚参数C和核函数参数gamma。

惩罚参数C控制了误分类样本对模型的影响程度,较大的C值会使模型更加关注误分类样本,可能导致过拟合;较小的C值则会使模型更加关注泛化能力,可能导致欠拟合。

核函数参数gamma控制了模型在训练数据中的拟合程度,较大的gamma值会使模型更加关注局部特征,可能导致过拟合;较小的gamma值则会使模型更加关注全局特征,可能导致欠拟合。

在调优SVM模型的超参数时,我们可以使用交叉验证的方法。

交叉验证将训练数据划分为多个子集,每次使用其中一部分作为验证集,其余部分作为训练集。

通过对不同超参数组合进行交叉验证,选择模型性能最好的超参数组合。

一种常用的调优方法是网格搜索(Grid Search)。

网格搜索通过指定超参数的候选值范围,遍历所有可能的超参数组合,并计算每个组合的交叉验证准确率。

最终选择准确率最高的超参数组合作为最优模型的超参数。

然而,网格搜索方法存在一个问题,即计算量较大。

当超参数的候选值范围较大时,网格搜索需要尝试大量的超参数组合,导致计算时间过长。

为了解决这个问题,我们可以使用随机搜索(Random Search)方法。

随机搜索通过指定超参数的候选值范围和搜索次数,随机选择超参数组合,并计算每个组合的交叉验证准确率。

最终选择准确率最高的超参数组合作为最优模型的超参数。

相比于网格搜索,随机搜索可以在较短的时间内找到较好的超参数组合。

除了网格搜索和随机搜索,还有一些其他的超参数调优技巧。

例如,我们可以使用贝叶斯优化(Bayesian Optimization)方法。

支持向量机及支持向量回归简介

3.支持向量机(回归)3.1.1 支持向量机支持向量机(SVM )是美国Vapnik 教授于1990年代提出的,2000年代后成为了很受欢迎的机器学习方法。

它将输入样本集合变换到高维空间使得其分离性状况得到改善。

它的结构酷似三层感知器,是构造分类规则的通用方法。

SVM 方法的贡献在于,它使得人们可以在非常高维的空间中构造出好的分类规则,为分类算法提供了统一的理论框架。

作为副产品,SVM 从理论上解释了多层感知器的隐蔽层数目和隐节点数目的作用,因此,将神经网络的学习算法纳入了核技巧范畴。

所谓核技巧,就是找一个核函数(,)K x y 使其满足(,)((),())K x y x y φφ=,代替在特征空间中内积(),())x y φφ(的计算。

因为对于非线性分类,一般是先找一个非线性映射φ将输入数据映射到高维特征空间,使之分离性状况得到很大改观,此时在该特征空间中进行分类,然后再返会原空间,就得到了原输入空间的非线性分类。

由于内积运算量相当大,核技巧就是为了降低计算量而生的。

特别, 对特征空间H 为Hilbert 空间的情形,设(,)K x y 是定义在输入空间nR上的二元函数,设H 中的规范正交基为12(),(),...,(),...n x x x φφφ。

如果221(,)((),()),{}k k k k k K x y a x y a lφφ∞==∈∑,那么取1()()k k k x a x φφ∞==∑即为所求的非线性嵌入映射。

由于核函数(,)K x y 的定义域是原来的输入空间,而不是高维的特征空间。

因此,巧妙地避开了计算高维内积(),())x y φφ(所需付出的计算代价。

实际计算中,我们只要选定一个(,)K x y ,并不去重构嵌入映射1()()k k k x a x φφ∞==∑。

所以寻找核函数(,)K x y (对称且非负)就是主要任务了。

满足以上条件的核函数很多,例如● 可以取为d-阶多项式:(,)(1)dK x y x y =+ ,其中y 为固定元素。

支持向量机回归的参数选择方法

支持向量机回归的参数选择方法支持向量机(Support Vector Machine,简称SVM)是一种非常强大且广泛应用于机器学习领域的算法。

它不仅适用于分类问题,还可以用于回归任务。

本文将深入探讨支持向量机回归的参数选择方法,并分析其优势和应用场景。

SVM回归的目标是通过拟合一个最优的超平面来预测连续变量的输出。

与分类任务不同的是,SVM回归关注的是给定输入样本点的输出数值。

在SVM回归中,参数选择方法对模型性能的影响非常重要。

我们来讨论SVM回归的核函数选择。

核函数是SVM中的一个关键概念,它可以将输入样本从原始特征空间映射到高维特征空间。

常见的核函数包括线性核函数、多项式核函数和高斯核函数等。

针对回归任务,一般常用的是高斯核函数,它能更好地处理非线性关系。

接下来,我们讨论SVM回归的惩罚参数C选择。

惩罚参数C控制着模型对误差的容忍程度,其值的选择对模型的求解和泛化能力都会产生较大影响。

当C的值较小时,模型会容忍更多的误差,从而产生较宽泛的超平面;相反,当C的值较大时,模型会更严格地拟合训练样本,但可能会导致过拟合现象。

在参数选择过程中,需要权衡模型的拟合能力和泛化能力。

另外,核函数的超参数γ也是SVM回归中需要选择的重要参数。

γ决定了高斯核函数的带宽,即决定了样本点对决策边界的影响程度。

当γ较大时,样本点之间的距离对决策边界的影响减小,决策边界可能变得更加平滑;相反,当γ较小时,样本点之间的距离对决策边界的影响增大,决策边界可能更加对训练样本敏感。

在选择参数C和γ时,通常使用交叉验证的方法来评估模型的性能。

交叉验证将数据集划分为训练集和验证集,在不同的参数组合下训练模型,并在验证集上计算模型的性能指标,如均方误差(Mean Squared Error,简称MSE)。

根据验证集上的性能表现,选择使MSE最小的参数组合作为最终的模型参数。

支持向量机回归的参数选择方法涉及到核函数选择、惩罚参数C的确定和高斯核函数的超参数γ的选择。

使用支持向量机进行回归分析的方法与技巧

使用支持向量机进行回归分析的方法与技巧支持向量机(Support Vector Machine,SVM)是一种常用的机器学习算法,广泛应用于分类和回归问题。

在回归分析中,SVM可以通过寻找最优超平面来建立输入变量和输出变量之间的非线性关系。

本文将介绍使用支持向量机进行回归分析的方法与技巧。

一、数据预处理在进行回归分析之前,首先需要对数据进行预处理。

这包括数据清洗、特征选择和数据标准化等步骤。

数据清洗可以去除异常值和缺失值,确保数据的质量。

特征选择可以通过相关性分析和特征重要性评估等方法来选择最相关的特征变量。

数据标准化可以将不同尺度的特征变量转化为相同的尺度,避免不同变量之间的差异对回归结果的影响。

二、选择合适的核函数在支持向量机中,核函数的选择对回归结果有很大的影响。

常用的核函数包括线性核函数、多项式核函数和径向基核函数等。

线性核函数适用于线性可分的回归问题,多项式核函数可以处理非线性关系,而径向基核函数则可以处理更加复杂的非线性关系。

根据具体的问题和数据特点,选择合适的核函数可以提高回归分析的准确性。

三、调整模型参数在支持向量机回归中,有两个重要的参数需要调整,分别是惩罚参数C和核函数的参数。

惩罚参数C控制了模型的复杂度,较小的C值会产生较简单的模型,较大的C值则会产生较复杂的模型。

核函数的参数可以控制模型的灵活性,不同的参数值会导致不同的模型拟合效果。

通过交叉验证等方法,可以选择最优的参数组合,提高回归模型的性能。

四、模型评估与优化在建立支持向量机回归模型后,需要对模型进行评估和优化。

常用的评估指标包括均方误差(Mean Squared Error,MSE)和决定系数(Coefficient of Determination,R-squared)等。

均方误差衡量了模型的预测误差大小,值越小表示模型的拟合效果越好。

决定系数则衡量了模型对观测值的解释能力,值越接近1表示模型的解释能力越强。

根据评估结果,可以对模型进行优化,如增加样本量、调整模型参数等。

基于遗传算法的回归型支持向量机参数选择法

维普资讯

C m ue nier g ad A pi t n 算机 工 程 与 应 用 o p t E gnei n p l aos计 r n ci

基于遗传算法 的回归型支持 向量机参数选择法

李 良敏 。温广瑞 !王 生 昌 3 , ,

支持向量机中正则化参数的选择方法

支持向量机中正则化参数的选择方法支持向量机(Support Vector Machine,简称SVM)是一种常用的机器学习算法,广泛应用于分类和回归问题。

在SVM模型中,正则化参数是一个重要的超参数,它用于控制模型的复杂度和泛化能力。

选择合适的正则化参数对于模型的性能至关重要。

本文将介绍支持向量机中正则化参数的选择方法。

一、正则化参数的作用正则化参数在SVM中起到了平衡模型复杂度和泛化能力的作用。

正则化参数越大,模型的复杂度越低,容易过拟合训练数据;正则化参数越小,模型的复杂度越高,容易欠拟合训练数据。

因此,选择合适的正则化参数可以使模型在训练数据和未知数据上都有较好的表现。

二、交叉验证方法交叉验证是一种常用的模型选择方法,可以用于选择正则化参数。

交叉验证将训练数据划分为若干个子集,然后将其中一个子集作为验证集,其余子集作为训练集。

通过不断调整正则化参数,计算模型在验证集上的性能指标,如准确率、精确率、召回率等,选择性能最好的正则化参数作为最终的选择。

三、网格搜索方法网格搜索是一种常见的参数选择方法,也可以用于选择正则化参数。

网格搜索将正则化参数的取值范围划分为一个网格,然后遍历网格中的每个参数组合,计算模型在验证集上的性能指标。

最终选择性能最好的正则化参数。

网格搜索方法简单直观,但是计算复杂度较高,需要遍历所有的参数组合。

四、启发式方法除了交叉验证和网格搜索方法,还有一些启发式方法可以用于选择正则化参数。

例如,可以通过观察模型在训练集上的拟合程度来判断正则化参数的选择。

如果模型在训练集上过拟合,可以增大正则化参数;如果模型在训练集上欠拟合,可以减小正则化参数。

此外,还可以使用正则化路径方法,通过逐步增大或减小正则化参数的方式选择最优参数。

五、经验法则在实际应用中,还存在一些经验法则可以用于选择正则化参数。

例如,在SVM中,常用的正则化参数选择范围是10^-3到10^3之间。

如果数据量较小,可以选择较大的正则化参数;如果数据量较大,可以选择较小的正则化参数。

支持向量回归算法公式例子

支持向量回归算法公式例子支持向量回归(Support Vector Regression,SVR)是一种机器学习算法,用于预测连续型变量。

它基于支持向量机(SVM)算法,通过寻找最大化间隔的方式来进行回归分析。

SVR的公式可以用数学符号来表示,下面是SVR的公式以及一个简单的例子。

SVR的基本公式如下:给定训练样本集合 {(x1, y1), (x2, y2), ..., (xn, yn)},其中xi是输入特征,yi是对应的输出。

SVR的目标是找到一个函数f(x)来预测输出y,使得预测值f(xi)与实际输出yi之间的误差尽可能小,并且在允许的误差范围内最大化间隔。

SVR的优化问题可以用以下的数学公式表示:minimize: (1/2) ||w||^2 + C Σ(max(0, |yi f(xi)| ε))。

subject to: |f(xi) y| <= ε, for all i = 1, 2, ..., n.其中,w是模型的权重向量,C是正则化参数,ε是允许的误差范围。

上述公式的目标是最小化权重向量w的大小,并且使得所有训练样本的预测值与实际输出之间的误差都在ε范围内。

这里的Σ表示对所有训练样本求和。

现在来看一个简单的例子来说明SVR的应用。

假设我们有一个数据集,包括一系列的(x, y)数据点,我们希望使用SVR来拟合这些数据并进行预测。

我们可以选择一个合适的核函数(如线性核或高斯核),设置正则化参数C和误差范围ε,然后通过SVR算法来训练模型。

训练完成后,我们就可以使用训练好的模型来进行新数据点的预测。

总之,支持向量回归算法的公式可以用数学符号来表示,通过最小化权重向量和最大化间隔来进行回归分析。

在实际应用中,我们需要选择合适的参数和核函数,并通过训练数据来拟合模型,从而进行预测。

SVR是一种强大的回归算法,在许多实际问题中都有着广泛的应用。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

Gtrain = {( xi , yi )}i 和测试样本集 Gtest = {( xi , yi )}i ,其中, m 和 l

m

l

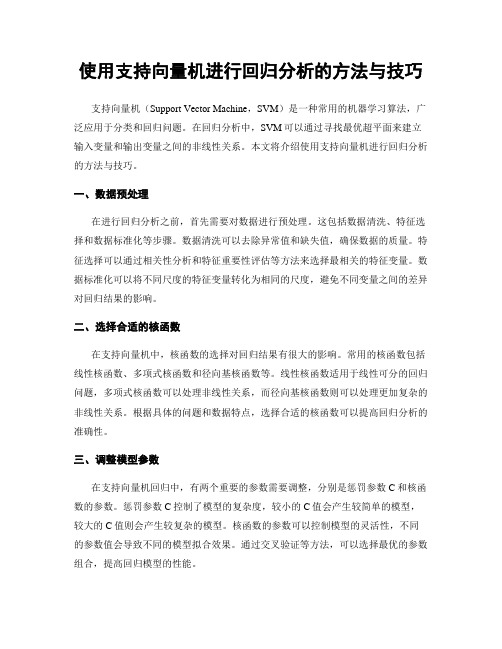

SVR 参数的混合选择算法具体操作步骤如下 (见图 1): Step1 确 定 参 考 模 型 。 输 入 SVR 的 学 习 样 本 集 n G = {( xi , yi )}i , 在 G 中 随 机 选 取 样 本 , 构 成 训 练 样 本 集

—40—

其中, u、 v 为输入空间的两个向量; p 和 σ 分别为多项式和 RBF 核函数的参数。 根据最优化的充要条件( KKT条件)知,二次规划问题 式 (5)的解中只有少数样本的系数 (α i − α i* ) 不为 0,与之对应的 样本 (xi , yi ) 称为支持向量。设支持向量的个数为 S ,得到式 (1) 的回归函数为 [1]

(10)

Step3 更新参数 C, ε 和 θ,最小化参数选择准则 T:

(C , ε ,θ ) = min T (α , b , C , ε ,θ )

0 0 0 0 0 C , ε ,θ

分别为训练集和测试集的样本数, m + l = n 。训练样本集用 于建立 SVR 回归函数, 而测试样本集用于评价参数选择准则 T,从而检验回归函数的泛化能力。算法采用测试样本集的方 均误差( mean squared error, MSE)作为参数选择准则 T。

f ( x, α i , α i∗ ) = ∑ (α i − α i∗ ) K ( x, xi ) + b

i =1 s

确 定 SVR 参 数 的 范 围 , 再 用 免 疫 遗 传 算 法 (immune genetic algorithm, IGA)[11]来搜索最佳的参数值。

输入学习样本集G 确定参数取值范围 编码 产生初始群体 SVR进行训练和测试评价适应度F(i) 群体进行遗传操作 No

K (u , v ) = e

− u−v 2σ

2 2

(6)

(7)

(3)

作者简介:王 强(1971-),男,博士研究生,主研方向:管理决策 技术,信息系统数据挖掘,机器学习;陈英武,教授、博士生导师; 邢立宁,博士研究生 收稿日期:2006-08-20 E-mail:wq7504@

在式 (2)的风险函数中,第 1 项 C (1 / n)∑i =1 Lε ( yi , f ( x) i ) 表

(5)

值, n是样本数 ), SVR回归函数为 (1) f ( x ) = ωφ ( x ) + b φ ( x ) 是将数据变换到高维特征空间的非线性映射; 其中, ω和 b 为系数。 SVR 依据结构风险最小化准则,来确定系数 ω 和 b ,即 1 n 1 2 (2) RSVMs (C ) = C ∑ Lε ( yi , f ( x ) i ) + ω n i =1 2

f α ,b ,C ,ε ,θ ( n>Nev Yes 优秀个体免疫操作 No

进化代数ng>N Yes 输出最佳参数组合(C*, e ,θ ) 获得最优回归函数 结束

* *

图 1 SVR 参数的混合选择算法

∑ (α

i =1

s

i

− α i∗ ) K θ ( x , x i ) + b

(国防科技大学信息系统与管理学院,长沙 410073) 摘 要:为提高支持向量回归算法的学习能力和泛化性能,提出了一种优化支持向量回归参数的混合选择算法。根据训练样本的规模和噪 声水平等信息,确定支持向量回归参数的取值范围,用实数编码的免疫遗传算法搜索最佳参数值。混合选择算法具有较高的精度和效率, 在选择支持向量回归参数时,不必考虑模型的复杂度和变量维数。仿真实验结果表明,该算法是选择支持向量回归参数的有效方法,应用 到函数逼近问题时具有优良的性能。 关键词:支持向量回归;参数选择;训练样本信息;免疫遗传算法

Hybrid Selection of Parameters for Support Vector Regression

WANG Qiang, CHEN Ying-wu, XING Li-ning

(College of Information Systems and Management, National University of Defense Technology, Changsha 410073) 【Abstract】In order to improve support vector regression(SVR) learning ability and generalization performance, a hybrid selection algorithm for optimizing SVR parameters is proposed. The ranges of the parameters are set according to the information about the training data size and noise level in training samples, and a real-coding based immune genetic algorithm is employed to search the optimal parameters. Hybrid selection algorithm is a precise and efficient method and it need not to consider SVR dimensionality and complexity. Simulation experiments show that the proposed method is an effective approach for SVR parameters selection with good performance on function approximation problem. 【Key words】support vector regression; parameters selection; training samples information; immune genetic algorithm

示经验风险,由式 (3)中的 ε 不敏感损失函数来衡量。损失函 数使得人们可以用稀疏的数据来描述式 (1)中的回归函数;第

1 2 2 项 2 ω 是正则化项; C 是正则化参数。

约束条件不可实现时,引入松弛变量 ζ i 和 ζ i ,这样式 (2)

*

改写为

min s.t. RSVMs (ω , ζ (∗) ) =

i =1 i=1 n n

1 n n ∑∑(αi −αi∗ )(α j −α ∗j )K(xi , x j ) 2 i=1 j =1

s.t.

∑(α −α ) = 0

i =1 i ∗ i

n

0 ≤ αi ≤ C 0 ≤ αi∗ ≤ C

1

支持向量回归算法 对于样本集 G = {( xi , yi )}in (xi 是输入向量, yi 是对应的目标

第 33 卷 Vol.33

第 15 期 No.15

计 算 机 工 程 Computer Engineering

文章编号:1000—3428(2007)15—0040—03 文献标识码:A

2007 年 8 月 August 2007

中图分类号: TP18

·博士论文·

支持向量回归参数的混合选择

王 强,陈英武,邢立宁

支持向量机 (support vector machine, SVM)是 Vapnik等学 者在统计学习理论基础上提出的一种新型机器学习方法 [1]。 SVM建立在 VC维理论和结构风险最小化准则基础上, 与神经 网络等传统机器学习方法相比, SVM 具有小样本学习、泛 化能力强等特点, 能有效地避免过学习、 局部极小点以及 “维 数灾难”等问题。通过引入 ε 不敏感损失函数, Vapnik等将 SVM 推广到非线性系统的回归估计,建立了支持向量回归 算法 (support vector regression, SVR)。目前,SVR已广泛地应 用于函数估计、非线性系统建模等多个领域 [2]。 SVR 具有优良的学习能力和泛化能力, 然而其性能依赖 于参数的选取。针对参数选择问题,一些学者从不同的角度 进行了研究和探讨 [3~10] 。本文提出一种 SVR 参数的混合选择 算法,利用学习样本信息,确定 SVR 参数的一个较小范围, 再用随机优化算法搜索最佳参数值,为应用 SVR 解决实际问 题提供了一种高精度的参数选择方法。

σ y 为标准偏差。

ε = 3σ noise

在目前常用的 SVR参数选择方法中, 参数估计方法 [5~8]不 需要显式求解 SVR,计算简便快捷,但只能确定部分参数值, 且获得的参数往往只是近似值,其精确程度不高。组合优化 方法 [9,10] 无需考虑 SVR 模型的复杂度和变量维数,不需要寻 找参数选择准则 T与参数间的显式表达式, 能够得到较为精确 的参数取值,而且不受核函数类型的限制。但算法受初始解 的影响较大,且时间开销大。因此,本文提出一种 SVR 参数 的混合选择算法 (hybrid selection algorithm, HAS),结合上述 两种方法的优点,为应用 SVR解决实际问题提供一种高精度 的参数选择方法。 算法的基本思想是以最小化参数选择准则 T 为目标,根据学习样本信息,将 SVR 参数很快锁定在一个较 小的范围,再采用随机优化算法在此参数范围内对参数进行 微调,搜索最佳参数值。具体地,采用文献 [8]提出的基于学 习样本集噪声估计 (noise estimation, NE) 的参数选择方法来

n 1 2 ω + C ∑ (ζ i + ζ i∗ ) 2 i =1 yi − ωφ ( xi ) − bi ≤ ε + ζ i ,