2.ubuntu下配置hbase环境

HBASE安装及客户端编程配置

HBASE 安装一、安装指南二、常见问题一、安装指南Hadoop+Hbase安装配置实录2010-10-12 22:53生产环境:3台机器:master(192.168.0.61),slave1(192.168.0.62),slave2(192.168.0.63) 注意:hostname设置为master/slave1/slave2操作系统:rhel5.4 x86_64master做为namenonde,将slave1和slave2做为datanode1.在master:(在slave1和slave2上操作和以下相同)vi /etc/hosts192.168.0.61 master192.168.0.62 slave1192.168.0.63 slave22.用root操作3.免密码登录#ssh-keygen -t rsa #建立ssh目录,敲回车到底 ,这一步需要先在每台机器上执行。

在master上#scp ~/.ssh/id_rsa.pub root@slave1:/root/.ssh/id_rsa.pub_m将master 上的密钥传到slave1的/home/hadoop下在slave1上#cat /root/.ssh/id_rsa.pub_m >> ~/.ssh/authorized_keys#chmod 644 ~/.ssh/authorized_keys反复操作第3步,完成master<-->slave1 master<-->slave2的免密码登录这样主节点和从节点之间就可以不用密码直接ssh访问,另外,在启动hadoop 时需要master ssh master,因此,在master的~/.ssh下,也执行下cat id_rsa.pub >> authorized_keys 即可。

4.安装JDK到/usr/local下命名为jdk6然后:编辑三台机器的/etc/profile,增加如下内容export JAVA_HOME=/usr/local/jdk6export CLASSPATH=$CLASSPATH:$JAVA_HOME/lib:$JAVA_HOME/jre/libexport HADOOP_HOME=/hadoop/hadoopexport HBASE_HOME=/hadoop/hbasePATH=$PATH:$JAVA_HOME/bin:$HADOOP_HOME/bin:$HBASE_HOME/bin#vi /root/.bashrc增加export HADOOP_CONF_DIR=/hadoop/hadoop-configexport HBASE_CONF_DIR=/hadoop/hbase-config5、防火墙各机器加入iptables策略:#iptables -I INPUT -s 192.168.0.0/255.255.255.0 -j ACCPET#service iptables save-----------------------------------------hadoop配置:1.下载安装#cd /hadoop#wget/apache-mirror//hadoop/core/hadoop-0.20.2/hadoo p-0.20.2.tar.gz#tar -zxvf hadoop-0.20.2.tar.gz#ln -s hadoop-0.20.2 hadoop由于上述目录中hadoop的配置文件和hadoop的安装目录是放在一起的,这样一旦日后升级hadoop版本的时候所有的配置文件都会被覆盖,因此将配置文件与安装目录分离,一种比较好的方法就是建立一个存放配置文件的目录,/hadoop/hadoop-config/,然后将 /hadoop/hadoop/conf/目录中的core-site.xml,slaves,hadoop-env.sh,masters, hdfs-site.xml,mapred-site.xml,这6个文件拷贝到 /hadoop/hadoop-config/目录中,并指定环境变量$HADOOP_CONF_DIR指向该目录。

HBase的安装、配置、管理与编程

46. NavigableMap<byte[],NavigableMap> columnMap = nMap.get(Bytes.toBytes("description"));

在namenode节点执行bin/hbase-daemon.sh,启动master。执行bin/start-hbase.sh和bin/stop-hbase.sh 脚本启动和停止HBase服务。

接口说明

HBase按列存储结构化数据,支持建表、插入记录、查询记录、删除记录和索引操作等等,不支持连接和更新操作。

(1),在namenode节点新建zookeeper目录,在该目录下新建myid文件。

(2),在zookeeper-3.2.1/conf目录下,拷贝zoo_sample.cfg为zoo.cfg。在zoo.cfg中将dataDir改为/home/hdfs/zookeeper,在文件末位添加所有的主机:

31. config.set("hbase.zookeeper.quorum", "10.192.1.1");

32.

33. HTable table = new HTable(config, "commodity");

34.

35. System.out.println("Get Spin's commodity info");

PC-4 Suse Linux 9 10.192.1.4

hbase连接参数

HBase是一种分布式的、可伸缩的、大数据存储服务,使用Hadoop的HDFS作为底层存储。

要连接HBase,需要配置一些参数,以下是一些常见的连接参数:

1.hbase.zookeeper.quorum: 指定ZooKeeper集群的地址,HBase通过

ZooKeeper进行协调。

2.hbase.zookeeper.property.clientPort: 指定ZooKeeper的端口号,默认

为2181。

3.hbase.master: 指定HBase主服务器的地址和端口号,格式为

hostname:port。

4.hbase.zookeeper.session.timeout: 指定ZooKeeper的会话超时时间,单

位为毫秒。

5.hbase.client.scanner.caching: 指定扫描器缓存大小,可以提高扫描性

能。

6.hbase.client.keyvalue.maxsize: 指定单个键值对的最大大小,超过此大

小的键值对将不会被存储。

7.hbase.client.retries.number: 指定客户端重试次数,当与HBase服务器

通信失败时可以尝试重新连接。

这些参数可以在连接HBase时进行配置,以便更好地控制连接和通信的行为。

具体的参数值取决于实际需求和环境配置。

Ubuntu搭建SSH_WEB环境

一、Ubuntu搭建SSH的WEB环境所需软件:1、ubuntu-9.10-server-i386.iso;2、jdk-6u7-linux-i586.bin;3、apache-tomcat-6.0.18.tar.gz。

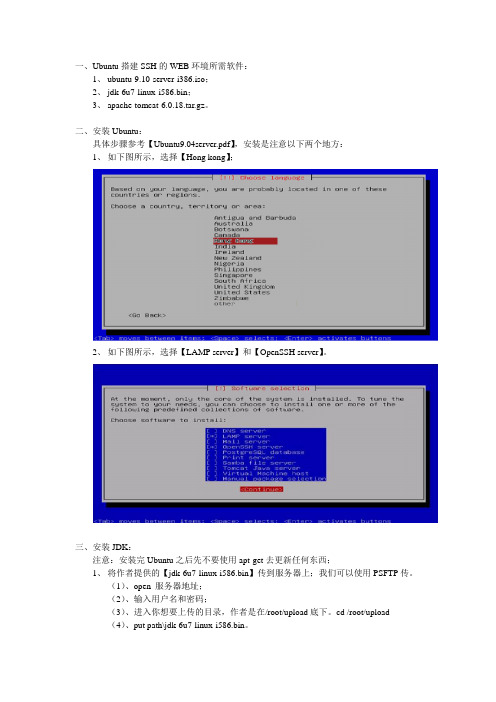

二、安装Ubuntu:具体步骤参考【Ubuntu9.04server.pdf】,安装是注意以下两个地方:1、如下图所示,选择【Hong kong】;2、如下图所示,选择【LAMP server】和【OpenSSH server】。

三、安装JDK:注意:安装完Ubuntu之后先不要使用apt-get去更新任何东西;1、将作者提供的【jdk-6u7-linux-i586.bin】传到服务器上;我们可以使用PSFTP传。

(1)、open 服务器地址;(2)、输入用户名和密码;(3)、进入你想要上传的目录,作者是在/root/upload底下。

cd /root/upload(4)、put path\jdk-6u7-linux-i586.bin。

2、安装JDK:(1)、# chmod +x jdk-6u7-linux-i586.bin;(2)、# ./ jdk-6u7-linux-i586.bin;说明:安装JDK(3)、# mv jdk-6u7-linux-i586.bin /usr/local/ 说明:移动位置(4)、# cd /usr/local/ 说明:切换目录(5)、# mv jdk-6u7-linux-i586.bin jdk1.6 说明:文件夹改名3、配置环境变量:(1)、# cp /etc/profile /etc/profile_back 说明:备份profile文件(2)、# vi /etc/profile 说明:用vi打开profile文件(3)、在末尾追加【注意此处是用“冒号”隔开而不是用“分号”】#Java environmexport JA V A_HOME=/usr/local/jdk1.6exportCLASSPATH=.:$JA V A_HOME/jre/lib:$JA V A_HOME/lib:$JA V A_HOME/lib/tools.jar(4)、输入【:wq】保存退出。

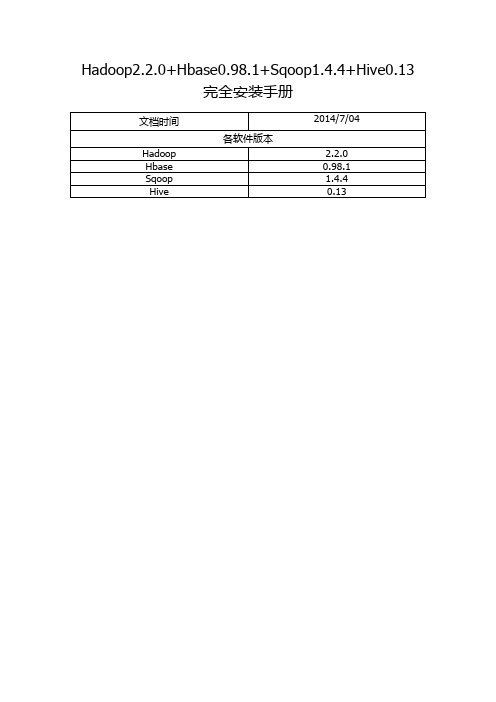

Hadoop2.2.0+Hbase0.98.1+Sqoop1.4.4+Hive0.13完全安装手册

Hadoop2.2.0+Hbase0.98.1+Sqoop1.4.4+Hive0.13完全安装手册前言: (3)一. Hadoop安装(伪分布式) (4)1. 操作系统 (4)2. 安装JDK (4)1> 下载并解压JDK (4)2> 配置环境变量 (4)3> 检测JDK环境 (5)3. 安装SSH (5)1> 检验ssh是否已经安装 (5)2> 安装ssh (5)3> 配置ssh免密码登录 (5)4. 安装Hadoop (6)1> 下载并解压 (6)2> 配置环境变量 (6)3> 配置Hadoop (6)4> 启动并验证 (8)前言:网络上充斥着大量Hadoop1的教程,版本老旧,Hadoop2的中文资料相对较少,本教程的宗旨在于从Hadoop2出发,结合作者在实际工作中的经验,提供一套最新版本的Hadoop2相关教程。

为什么是Hadoop2.2.0,而不是Hadoop2.4.0本文写作时,Hadoop的最新版本已经是2.4.0,但是最新版本的Hbase0.98.1仅支持到Hadoop2.2.0,且Hadoop2.2.0已经相对稳定,所以我们依然采用2.2.0版本。

一. Hadoop安装(伪分布式)1. 操作系统Hadoop一定要运行在Linux系统环境下,网上有windows下模拟linux环境部署的教程,放弃这个吧,莫名其妙的问题多如牛毛。

2. 安装JDK1> 下载并解压JDK我的目录为:/home/apple/jdk1.82> 配置环境变量打开/etc/profile,添加以下内容:export JAVA_HOME=/home/apple/jdk1.8export PATH=$PATH:$JAVA_HOME/binexport CLASSPATH=.:$JAVA_HOME/lib/tools.jar:$JAVA_HOME/lib/dt.jar执行source /etc/profile ,使更改后的profile生效。

Cloud computing理论测试部分习题答案

云计算课程理论试题部分答案1. ___执行文件系统命名空间操作()B. Namenode2. 关于基于Hadoop的MapReduce编程的环境配置,下面哪一步是不必要的()C. 安装Eclipse3.下列说法错误的是()A. MapReduce中maper conbiner reducer 缺一不可4..下面那个选项正确配置了HBASE的分布式环境。

B. 在hbase-site.xml文件中设置hbase.cluster.distributed为true5..hbase如何更新列值?C. 表格中增加新版本的值6..Hive是建立在__之上的一个数据仓库。

D. Hadoop7..Hive提供了基于SQL并使得熟悉SQL的用户能够查询数据的__。

A. QL8..对于最小粒度的任务,Hive查询的反应时间约为___。

D. 几分钟9. 按粒度大小的顺序,Hive数据被组成为:数据库,表格,__和桶。

C. 分隔10. INT整数型有多少个字节__。

C. 4 byte11.下面哪一个关于内置操作符的描述是错误的__。

C. A REGREXP B:如果字符串A与简单的SQL规则表达式B不匹配,值为TRUE,否则FALSE12..下面哪种操作是不被Hive查询语言所支持的__。

C. 在一个表格中添加索引。

13..在Ubuntu上安装Cassandra的命令是什么?C. sudo apt-get install Cassandra14..下列哪项在Cassandra中充当排序因子的角色?C. row15..作为一款分布式存储平台,你知道客户是如何通过客户端与服务器连接的吗?A. 是通过把分布在多台(或一台)服务器上卷挂载到客户端上的文件夹的方式实现客户端与服务器相连16.下列说法错误的是(D)A. MapReduce框架提供了作业队列机制B. Counters是由多个MapReduce框架或应用程序定义的全局计数器C. DistributedCache可将具体应用相关的、大尺寸、只读的文件进行有效的分布放置。

Cloudcomputing_理论测试题目答案(最新更新)

Cl oud computing 理论测试题目答案说明:1、搜索时如果找不到可先尝试去掉英文部分,只搜索中文,可能是中英文间空格问题。

2、如果碰到“下面说法错误的是()”,直接搜索选项,也仅有此类题可搜索任意选项,绿色部分为正确选项。

3、红色部分为错误选项,本人到100后就没心情继续刷了,后继者继续努力吧,据说现有300-400道题,助教打算近期再添加100多题……4、改进后上传前,你可以在此部分表明更新信息、姓名和日期,但不要抹杀前人的努力,切记!(10-本-白玉欣2012/4/20)1. 请问在Hadoop体系结构中,按照由下到上顺序,排列正确的是()mon MapReduce Pig2. 关于Datanode的描述错误的是()D.文件的副本系数由Datanode 储存3.关于MapReduce的描述错误的是()D. 一个MapReduce任务(Task)通常会把输入集切分成若干独立的数据块4. Hive查询语言和SQL的一个不同之处关于HDFS 命令错误的是()C. cp:返回到上一级目录5. 配置hbase过程中,下面那个文件没有改动。

A.hbase-default.xml6. hbase表格中行关键字对应的列值最少有几个?D.任意个7. 客户端发现域服务器崩溃之后与__交互来处理问题.B.hbasemaster8. Hive最重视的性能是可测量性,延展性,__和对于输入格式的宽松匹配性。

B. 容错性9. hbase中存储的数据类型是__。

B.byte10. INT整数型有多少个字节__。

NOT D. 8 byteNot bc11. Hive提供了基于SQL并使得熟悉SQL的用户能够查询数据的__。

A.QL12. 下面哪一个对于Hive查询语言的命令的描述是错误的__。

C.SHOW PARTITIONS page_view:列出表格page_view 的所有的分隔。

如果该表格没有被分隔,那么什么也不做。

测试一下:HBase 40道测试题,你能答对几道

测试一下:HBase 40道测试题,你能答对几道2016-08-02 10:43 来源:未知编辑:admin 点击: 145 次分享到第一部分:基础能力1. HBase来源于哪篇博文?CA The Google File SystemB MapReduceC BigTableD Chubby2. 下面对HBase的描述哪些是正确的?B、C、DA 不是开源的B 是面向列的C 是分布式的D 是一种NoSQL数据库3. HBase依靠()存储底层数据AA HDFSB HadoopC MemoryD MapReduce4. HBase依赖()提供消息通信机制AA ZookeeperB ChubbyC RPCD Socket5. HBase依赖()提供强大的计算能力DA ZookeeperB ChubbyC RPCD MapReduce6. MapReduce与HBase的关系,哪些描述是正确的?B、CA 两者不可或缺,MapReduce是HBase可以正常运行的保证B 两者不是强关联关系,没有MapReduce,HBase可以正常运行C MapReduce可以直接访问HBaseD 它们之间没有任何关系7. 下面哪些选项正确描述了HBase的特性?A、B、C、DA 高可靠性B 高性能C 面向列D可伸缩8. 下面与Zookeeper类似的框架是?DA ProtobufB JavaC KafkaD Chubby9. 下面与HDFS类似的框架是?CA NTFSB FAT32C GFSD EXT310. 下面哪些概念是HBase框架中使用的?A、CA HDFSB GridFSC ZookeeperD EXT3第二部分:HBase核心知识点11. LSM含义是?AA 日志结构合并树B 二叉树C 平衡二叉树D 长平衡二叉树12. 下面对LSM结构描述正确的是?A、CA 顺序存储B 直接写硬盘C 需要将数据Flush到磁盘D 是一种搜索平衡树13. LSM更能保证哪种操作的性能?BA 读B 写C 随机读D 合并14. LSM的读操作和写操作是独立的?AA 是。

hbase常用命令及使用方法

hbase常用命令及使用方法一、HBase简介HBase是一个基于Hadoop的分布式列存储系统,可以用来存储海量的结构化数据。

它是一个开源的、高可靠性、高性能、可伸缩的分布式数据库,具有强大的数据处理能力和卓越的扩展性。

二、HBase常用命令1.启动和停止HBase服务启动HBase服务:在终端输入start-hbase.sh命令即可启动HBase 服务。

停止HBase服务:在终端输入stop-hbase.sh命令即可停止HBase 服务。

2.创建表创建表:在HBase shell中使用create命令来创建表,语法如下:create 'table_name', 'column_family'3.删除表删除表:在HBase shell中使用disable和drop命令来删除表,语法如下:disable 'table_name'drop 'table_name'4.添加数据添加数据:在HBase shell中使用put命令来添加数据,语法如下:put 'table_name', 'row_key', 'column_family:column_qualifier','value'5.查询数据查询数据:在HBase shell中使用get命令来查询数据,语法如下:get 'table_name', 'row_key'6.扫描全表扫描全表:在HBase shell中使用scan命令来扫描全表,语法如下:scan 'table_name'7.删除数据删除数据:在HBase shell中使用delete命令来删除数据,语法如下:delete 'table_name', 'row_key', 'column_family:column_qualifier'8.修改表修改表:在HBase shell中使用alter命令来修改表,语法如下:alter 'table_name', {NAME => 'column_family', VERSIONS =>version_num}9.查看表结构查看表结构:在HBase shell中使用describe命令来查看表结构,语法如下:describe 'table_name'10.退出HBase shell退出HBase shell:在HBase shell中输入exit命令即可退出。

hbase基本操作

hbase基本操作HBase是一个分布式开源数据库,是Apache Hadoop项目的一部分。

它是一个面向列的NoSQL数据库,可以在非常大的数据集上进行实时读写操作。

HBase有许多不同的用途,包括在大型网站中存储日志数据、高速数据分析、批量处理数据以及许多其他用途。

在本文中,我们将探讨一些基本的HBase操作。

1. 安装和启动HBaseHBase的安装非常简单,您只需要下载并解压HBase软件包即可。

安装完成后,您可以通过以下命令启动HBase:```bin/start-hbase.sh```此命令将启动所有必要的进程以及HBase的主服务器,也称为“RegionServer”。

2. 创建表在HBase中创建表与关系数据库中创建表的过程非常相似。

以下是一个基本的示例:```create 'myTable', 'myColumnFamily'```其中,“myTable”是表名,“myColumnFamily”是列族名。

列族是列的集合。

3. 插入数据注意,HBase使用列族名称和列名来唯一标识列。

在上面的示例中,“myColumnFamily”是列族名称,“column1”是列名,“value1”是列值。

您还可以插入多个列和一行中的多个值。

4. 获取数据此命令将返回表“myTable”中行键为“row1”的所有列。

5. 扫描表扫描表是获取表中所有行的一种简单方法。

以下是一个基本的示例:6. 删除数据要删除HBase表,您可以使用以下命令:此命令将禁用和删除表“myTable”。

总结:HBase是一个非常强大的分布式数据库,可以在大型数据集上进行快速读写操作。

在本文中,我们介绍了一些基本的HBase操作,包括创建表、插入数据、获取数据、扫描表、删除数据和删除表。

这些操作是使用HBase时非常常见的操作。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

南昌大学实验报告

学生姓名: 学 号: 59------028 专业班级: -----------1班

实验类型:□ 验证 □ 综合 ■ 设计 □ 创新 实验日期: 实验成绩:

实验一:hbase 的安装和启动

一、实验目的

1. 掌握hbase 的安装方法;

2. 掌握启动hbase 和停止hbase 的操作。

二、实验要求

1.掌握hbase 单机、伪分布安装方法或完全分布方法;

2.

启动hbase 和停止hbase 。

;

3.独立完成实验内容,并提交书面实验报告。

三、实验内容 1、安装准备

1)下载好HBASE 0.20.5版本:hbase-0.20.5.tar.gz

2)JDK 版本:已经安装好

3)操作系统:Linux 12.04LTS

4)已经安装完hadoop 0.20.2版本: hadoop 的配置文件core-site.xml 内容:

<configuration> <property>

<name></name>

<value>hdfs://localhost:9000</value> </property> </configuration>

2、操作步骤

1)、拷贝下载好的文件hbase-0.20.5.tar.gz 到要安装的目录下。

2)、解压hbase 到安装目录下。

tar -zxvf hbase-0.20.5.tar.gz

Edi ted w ith the trial version of Foxit Advanced PDF Editor T o remove this notice, visit:

w /shopping

4)、修改HBASE_HOME/conf/hbase-env.sh文件。

指定本地的JDK安装路径:export JAVA_HOME=/usr/java/jdk1.6.0_20(记得改成自己的路径)

5)、修改/my/hbase-0.20.5/conf/hbase-site.xml。

内容如下:

(hdfs://localhost:9000要与hadoop的配置文件core-site.xml相同!)

<property>

<name>hbase.rootdir</name>

<value>hdfs://localhost:9000/hbase</value>

</property>

<property>

<name>hbase.cluster.distributed</name>

<value>true</value>

</property>

6)、修改/etc/profile文件,在文件末尾加上环境变量:(可以省略此步) export HBASE_HOME=/myhbase/hbase-0.20.5

export PATH=$PATH:$HBASE_HOME/bin

在控制台输入:source /etc/profile,使之生效。

7)、修改/etc/hosts文件,如下:

127.0.0.1 localhost

三、启动HBase

1、通过shell脚本启动hbase。

start-hbase.sh若没有配置HBASE_HOME等环境变量则需要进入到安装目录,再运行bin/start-hbase.sh

2、进入/my/hbase-0.20.5/bin目录,执行hbsae shell命令,进入hbase控制台,显示如下。

3、在hbase控制台输入list命令,如果正常执行,表示hbase启动成功。

如下:

4、WEB查看hbase

查看Master http://localhost:60010/master.jspᄃ

查看Region Server http://localhost:60030/regionserver.jspᄃ

查看ZK Tree http://localhost:60010/zk.jspᄃ

四、实验结果

1.core-site.xml

2.hbase-site.xml

3.启动hbase

4.查看状态

master:

regionServer:。