基于Heritrix和HTMLParser的网页商品信息提取的研究

基于HTMLParser的BT种子网页信息抽取

表 述 的 we b页面 经浏览 器分 析后 只适 合浏 览 , 不适 合 作 为一 种数 据交换 的方式 由机器 处理 。为 了有 效地 利 用 互联 网上 的信 息 , 息抽 取技术 应 运而 生 。 信

③ 包 含种 子信 息 的<tbe a l>块 中只有 一行 一列 ,

互 联 网上信 息 量 的激增 , 迫切 需 要一 些 自动 化 的 工具 帮助人 们 在海 量信息 源 中迅速 找到 真正需 要 的信

息 , 标 题 、 接 、mal 图 片 等 , HTML语 言 所 如 链 e i和 而

① 种 子 信息 网页 大部分趋 于结构化 ;

② 大部 分 的种 子信 息 内容 几 乎都集 中在 hml t 的

网页结 构 的完善 。 本 文 利 用 HTML asr 析 技 术 抽 取 相关 种 子 P re 解……; J 来自…一 相对路径结合 I 1 i

;

… …

k

—

节点内容特 征 I ;

J

—

0 … . HmlP r r . t as I e

… …

…

…

{ 数 库l 参 特征 一 一 !

2 1 信 息 抽 取 模 型 .

HTML asr HTML 1a e P re 、 C e n r等 , 主 要 功 能 是 信 息 其 的提 取和 信息 的转 化 。

目前 , 解析 器 的信息 提取 功能被 广 泛应用 , 过与 通

B 种 子 信 息 抽 取 模 型 主要 分 为信 息 定 位 、 构 T 结 预处 理 、 息抽 取 和信息 重构存 储 4个模 块 , 信 如图 1 所

对定位 的信 息块 进行 预处 理 ,总结 出抽取 规 则 ,实现 了B 种子 网页信 息抽取 , 以此建 立 了一种针 对 B 种 子 T 并 T

基于HTMLParser视频信息抽取系统的设计与实现

基于HTMLParser视频信息抽取系统的设计与实现作者:史诚来源:《科技传播》2011年第22期摘要目前视频网站成为人们上网时不可或缺的娱乐途径,但现在的视频网站对视频的分类以及描述参差不齐,其主要原因就是没有构建统一的视频信息知识库,而构建知识库的核心技术就是网络爬虫的设计。

本文针对视频类网站进行了详细研究。

通过深入分析视频类网站页面的树形结构的构架,并基于HTMLParser 的信息提取方法,从种子页面中提取出相关的视频信息用于视频信息知识库的构建。

关键词网络爬虫;视频爬取;HTMLParser中图分类号TP39 文献标识码A 文章编号 1674-6708(2011)55-0207-02随着互联网的普及,越来越多的人们把自己的娱乐时间投入到网络视频上,而面对海量的视频人们只能通过视频网站的介绍决定自己是否感兴趣,而往往各个视频网站对同一视频的描述以及分类会有不同,这使得用户不能得到关于视频的准确描述信息,为了应对这样的挑战,我们需要构建一个统一的视频信息知识库,而构建知识库的核心技术就是网络爬虫的设计。

视频信息抽取系统在这样的研究背景下产生,目前信息抽取的关键技术有:命名实体识别,句法分析,篇章分析与推理,知识获取。

针对视频网站页面的特点,我们需要直接抽取相关标签中的视频信息。

1 HTMLParser与Node1.1 HTMLParser爬虫程序中,对于HTML网页的处理是核心的一个环节。

对于Java来说,HTMLParser是比较著名并且得到广泛应用的一个。

HTMLParser的主页是http:///,最后的更新是2006年9月的1.6版。

HTMLParser具有小巧,快速的优点,缺点是相关文档比较少,很多功能需要自己摸索。

HTMLParser的核心模块是org.htmlparser.Parser类,这个类实际完成了对于HTML页面的分析工作。

这个类有下面几个构造函数:public Parser ();public Parser (Lexer lexer, ParserFeedback fb);public Parser (URLConnection connectionParserFeedback fb) throws ParserException;public Parser (String resource,ParserFeedback feedback) throws ParserException;public Parser (String resource) throws ParserException;public Parser (Lexer lexer);public Parser (URLConnection connection) throws ParserException;和一个静态类 public static Parser createParser (String html, String charset);对于大多数使用者来说,使用最多的是通过一个URLConnection或者一个保存有网页内容的字符串来初始化Parser,或者使用静态函数来生成一个Parser对象。

基于Heritrix的网络爬虫研究与应用

摘 要 : 主要介 绍 了主题搜 索引擎、 网络爬 虫的基 本概念 和 He r i t r i x系统 的体 系结构 , 分析 了 He r i t r i x的工作 流程 ,

在 He r i t r i x框 架 的基 础 上 进 行 扩展 和优 化 。通 过 一 个 实例 , 实现 了对 京 东 网 图 书信 息 r a wl Or d e r , 是 整个抓取 工作 的起始点 , 在 一 次 抓 取 过 程 中通 常 需 要 设 置 许 多 属 性 值 , 最 简 洁 实 用

是用来不停地抓取不 同的网页 , 可 以使 用 它从 网 络上 抓 取

丰 富 的信 息 资 源 。 He r i t r i x最 出 色 之 处 是 它 具 有 良好 的 可 扩 展 性 和可 自定 义 开发 , 开发 者 可 以在 它 的组 件 模 块 上 加 人 自己 的业 务 逻 辑 进 行 二 次 开发 , 以实 现 自己特 有 的 抓

服务功能 , 再将检索 到的相关 信息 呈现 给用户 , 供 用 户 使 用 ] 。搜 索 引 擎 一 般 由 网络 爬 虫 程 序 部 件 、 索 引 数 据 库 部

件 和 用 户 查 询 接 口部 件 3部 分 组 成 ] 。

1 He r i t r i x体 系结 构

He r i t r i x是 由 J a v a语 言 开 发 的 一 种 开 放 源 代 码 的 网

取 目标 。

中, 如 何 才 能 快 速 有 效 地 找 到 自己想 要 的某 个 主 题 信 息 是

用 户 面 临 的 一 个 难 题 。搜 索 引 擎 是 指 根 据 相 关 的 搜 索 策 略 与 算 法 从 互 联 网上 采 集 网页 资 源 , 然 后 对 网 页信 息 进 行 选择、 过滤 、 处 理 后 保 留有 用 的信 息 资 源 , 为用 户 提供 查 询

HtmlParser提取网页信息的设计与实现

Absr c : er p d g o ao e o t n si r a e hen e o o u o tcto st l e p efn h t a t Th a i r  ̄d ft W b c n e t nce s st e d frs mea tmai o l ohep p o l d t e he i if r to mo g t e ma n n mo si o a in s ure uc stde ,i k e is pc u e t. n o main a n h g a i u n r t o c ss h a i s ln s, mal , it r sec TheW e a s f m o b p ge e pr s e y HTML, f ra ay e y I t r tEx lr r a eo l u tb ef rbrws b tn tfrma hie p o e s x e sdb at lz d b n e ne po e , r ny s ia l o e, u o c n r c s — e n o o ig a h y o aa e c a g .T e p p re pa n o t s ml r e o e ta th peln n o ain fo n st e wa fd t x h n e h a e x l i sh w o u e Ht Pa s rt xr c y rik i r to r m f m

文章编 号 :0 7 1 2 (0 7 0 — 0 6 0 10 — 2 9 2 0 )6 0 2 — 3

Ht P re 提 取 网页信 息 的设 计 与 实现 mlasr

黄 颖 黄 治平 ,

(. 1 江西理工大学信息工程学 院, 江西 赣州 3 10 ;. 4002 赣南师范学 院, 江西 赣州 3 10 ) 4 0 0

基于HTML Parser的WEB信息提取系统的设计和实现

2 提取 E a 信 息 模块 ) mi l 首 先 利 用 H M asr P 将 所 有 U L页 面 的 文 本 内容 存 入 文 本 文 件 中 , 后 利用 正则 表 达 式 提 取 该 文 本 文 档 中 的 E i信 T LP r I eA R 然 ma l

息 , 着对 其 余 页 面 做 同样 处 理 。 接 3 存 储模 块 1

3 将 提 取 到 的 U L信 息存 人数 据 库 ; 1 R 4 分 析 所有 U L对 应 的 页 面并 提 取 电子 邮件 信 息 , 提取 到 的 电 子 邮件 信 息 存 人数 据 库 。 1 R 将

1 . 统构 成 2系

1提 取 U L模 块 1 R

系统 的 核 心之 一 , 实 现 的 主要 功 能 是利 用 H ML P re A I 提取 初 始 U L页 面 D e 它 T as r P , R e p层 上 的所 有 U L R 。

Vo . ,No4 Fe r r 01 , p 9 0 9 2 1 7 . , b uay 2 p . 7 — 7 1

基于 H MLP re 的 WE T as r B信 息提取系统 的设计和实现

曾 佳 维

( 庆大学 计算机学院, 庆 404 ) 重 重 0 0 5

摘 要 : e 信 息 的急 剧 增 长 , 信息 的有 效 使 用提 出 了 巨大挑 战 , 何 快 速 、 确 地 从 W e W b 给 如 准 b中获 取 所 需 信 息 己经成 为亟 待 解 决 的 问 题 。 于 H MLPr r 的 W e 基 T a e 包 s b页 面信 息 提取 系统 能 够 准确 的提 取 用 户感 兴趣 的 信息 用 于进 一 步分 析 , 加 充 分有 效 地利 用 W e 更 b 这 个 巨大 的信 息 源 。 这种 方 法 可 以普 遍 适 用 于 W E 页 面的 信 息提 取 。 B

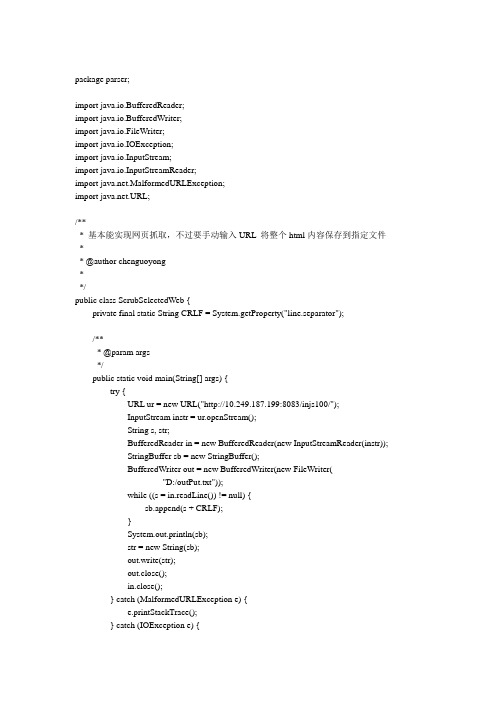

htmlParser从网页上抓取数据讲解

package parser;import java.io.BufferedReader;import java.io.BufferedWriter;import java.io.FileWriter;import java.io.IOException;import java.io.InputStream;import java.io.InputStreamReader;import .MalformedURLException;import .URL;/*** 基本能实现网页抓取,不过要手动输入URL 将整个html内容保存到指定文件** @author chenguoyong**/public class ScrubSelectedWeb {private final static String CRLF = System.getProperty("line.separator");/*** @param args*/public static void main(String[] args) {try {URL ur = new URL("http://10.249.187.199:8083/injs100/");InputStream instr = ur.openStream();String s, str;BufferedReader in = new BufferedReader(new InputStreamReader(instr));StringBuffer sb = new StringBuffer();BufferedWriter out = new BufferedWriter(new FileWriter("D:/outPut.txt"));while ((s = in.readLine()) != null) {sb.append(s + CRLF);}System.out.println(sb);str = new String(sb);out.write(str);out.close();in.close();} catch (MalformedURLException e) {e.printStackTrace();} catch (IOException e) {e.printStackTrace();}}}如上是基本能实现网页抓取,不过要手动输入URL,此外没有重构。

基于HTML Parser的BBS信息抽取系统的设计与实现

P re 的一些基础类 , 中最 为重要 的是 P re 。P re asr 其 a sr asr

是 HT asr ML P r 的最 核心的类。og hmlasrb a s e r . t p r .en e 包对 V s o 和 F l r ii r t i e 的方法进行 了封装 , t 定义 了针对一 些常用 HT ML元素操作 的 Jv B a , a a en 简化对常用元素 的 提取操 作 。o g. t p r e . o e 包 定义 了基 础的 r h ml a s r n d s nd, o e 包括 : srcNo e e r No e a No e Ab ta t d 、R ma k d 、T g d 、 T x No e 。o g h ml as rt g 包 定义了 HT et d 等 r . t p re . s a ML P r e 进行解析 的网页 中的各种标签 【。 asr l 1

定 向采集各 BB S上开放 数据信 息源 , 将数据 经过分析 、 整理后得到作者信 息、发帖信息 、回复数 、正文 内容等 信息 , 并存人 数据 库 , 以备后 期查询 等用户 应用 。 BBS信 息抽 取 系统 主要 模 块结 构包 括 4个 : 息 信 抓取 模块 、信 息 解析 模块 、数 据库 存 储模 块 、结果 显

以 B S站点 URL为输入 , 此过程 中, B 在 加入正则 匹配方

法 , 到各个 网页 信息 , 得 交给信 息解析 模块 。信 息抓 取 模块分 为三部分 : 版块 信息抓取 部分 、帖子基 本信息 抓

取部 分 、正 文信 息抓取 部分 。

版块信息抓取部分根据输入的站点 URL 通过 HT , ML

3 2 信 息解析模块 .

基于Heritrix的商品信息搜索的网络爬虫系统的设计

基于Heritrix的商品信息搜索的网络爬虫系统的设计

袁小洁

【期刊名称】《电脑编程技巧与维护》

【年(卷),期】2012(000)022

【摘要】探讨以开源软件Heritrix体系构建的获取商品信息爬虫系统,针对Heritrix开源爬虫项目存在的问题和商品采集的特点,项目设计了定向抓取包含某一特定内容的网页的类,从而改进Heritrix,并引入ELFHash算法进行URL散列中,以提高抓取效率,为面向商品的搜索系统以及数据挖掘提供可靠的数据源.

【总页数】2页(P74,81)

【作者】袁小洁

【作者单位】贵州大学计算机科学与信息学院,贵阳550025;贵州省贸易经济学校,贵阳550018

【正文语种】中文

【相关文献】

1.基于Heritrix的主题网络爬虫设计与实现 [J], 高伟锋

2.基于Heritrix的网络爬虫研究与应用 [J], 刘高军;夏景隆;

3.一种基于Heritrix的网络定题爬虫算法——以渔业信息网络为例 [J], 孙庚;冯艳红;于红;史鹏辉

4.一种基于Heritrix的网络定题爬虫算法——以渔业信息网络为例 [J], 孙庚;冯艳红;于红;史鹏辉

5.一种基于Heritrix的网络定题爬虫算法——以渔业信息网络为例 [J], 孙庚;冯艳红;于红;史鹏辉

因版权原因,仅展示原文概要,查看原文内容请购买。

HtmlParser提取网页信息的设计与实现

算法实现. 输入:某一网站首页地址(uRL). 输出:网站内部页面上的“nk信息. 算法:详细过程见图1. (1)提取首页uRL信息(n个); (2)分析所有uRL对应的页面并提取Link信 息,将所得Link; (3)信息清洗后存人数据库. 图l可知,信息提取分为3个模块:①网页内 部LirIl【提取模块,②清洗已提取unk模块,③存 储模块.模块的具体功能如下. (1)网页内部Link提取模块,该模块是系统的 核心之一,它实现的主要功能是利用HtnIIP—er 包,基于上述算法的递归处理部分,提取页面上的 所有Link. (2)清洗已提取L-mk模块.之前提取的大量 unk数据还含有很多“脏数据”,不能直接拿来使

的所有的标签xxxlk给解析出来放到一个特定 的文档当中去,一般是.眦文件.几乎HTML的标签 都有一个对应的类,比如“nkng、ImageTag、

Fom汀%Input Tag、APPlct耽等等。这些标签类都

在。弭hcⅡdpmer tags包中.根据要处理不同的标 签传人不同的类,这种做法可以很方便地处理其他 类型的标签.返回的文档中每个元素都是传人类的 一个实例,通过这个实例可以访问到当前这个标签 的起始位置、结束标签的位置以及包含在标签中 的文本信息,同时也可以访问其父标签以及所有 的子标签等等;而且还可以通过砸HⅡl:IL方法来对 标签中包含的HTML信息进行清洗,HtndPa一”会 自动把一些没有关闭的标签加上,这样所生成的字 符串中就包含着完整的格式控制信息,在页面上显 示这样的信息也不会破坏版面布局,达到了预期的 效果.

日t口Bb.gub岫g(日hn’end);

基于人工智能的网页信息提取与分析

基于人工智能的网页信息提取与分析随着互联网的普及和信息爆炸式增长,人们需要越来越多的工具来帮助他们从海量的网络信息中提取有用的知识和洞察力。

人工智能技术的快速发展为网页信息提取和分析提供了新的解决方案。

基于人工智能的网页信息提取与分析技术能够自动从网页中抽取特定的信息,并对这些信息进行分析和处理,从而提供更加有针对性和准确的信息。

一、网页信息提取技术1. 自然语言处理技术自然语言处理技术是人工智能领域的一个重要分支,它可以帮助计算机理解和处理人类语言。

在网页信息提取中,自然语言处理技术能够帮助识别和提取网页中的关键信息,如标题、摘要、作者、时间等。

通过自然语言处理技术,可以构建一个智能的网页信息抽取系统,能够自动地从海量的网页中提取有用的信息。

2. 深度学习技术深度学习技术是人工智能领域的热门技术之一,它通过构建深层神经网络模型,实现对复杂数据的学习和理解。

在网页信息提取中,深度学习技术可以帮助识别和提取网页中的结构化信息,如表格、图像、链接等。

通过深度学习技术,可以建立一个智能的网页信息提取系统,能够自动地解析网页的结构,从而准确地提取出需要的信息。

二、网页信息分析技术1. 文本分类技术文本分类技术是人工智能领域的常用技术之一,它可以将文本按照一定的分类规则进行分类和归类。

在网页信息分析中,文本分类技术可以帮助将提取出的信息按照一定的分类标准进行分类和组织,从而实现对网页信息的有效分析和处理。

通过文本分类技术,可以建立一个智能的网页信息分析系统,能够自动地对网页信息进行分类和归类,从而为用户提供更加有用的洞察和分析结果。

2. 情感分析技术情感分析技术是人工智能领域的新兴技术之一,它可以分析文本中蕴含的情感和情感倾向。

在网页信息分析中,情感分析技术可以帮助分析网页中的评论、评论、社交媒体上的发言等文本信息中的情感倾向,从而揭示用户对某个话题的态度和观点。

通过情感分析技术,可以建立一个智能的网页信息分析系统,能够自动地分析用户的情感倾向和观点,从而为用户提供更加准确和全面的网页信息。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

、

( l g a l o u e )构成 。核心类可 以配置 ,但不 能被覆 p u gb em d l s f r it i: 0 o (n :i < sr 1n t 0 :i + { t.egh + ) 盖, 插件模块可 以由第三方模块取代 。 以我们就可 以用 实现 所 h s = (a h < 4 + s r c a A () ah hs < ) t.hrti : 了特定抓取逻辑 的第 三方模块 来取 代默认的插件 模块 , 从而满 i (x : h s & 0 F 0 0 0 L ! 0 { f( ah x 0 0 0 0 ) = ) 足 自己的抓取需要 。 h s = ( > 2 ) ah x > 4: hs & x a h = :) ) C a lo to lr ( rw C n r l e 下载控制器 )整个下载过程 的总控制 ( )爬取 网页信息 三 者 ,整个抓 取工作的起点 ,决定整个抓取任务的开始和结束。 每个 U I都有一个独立 的线程 , R 它从边界控制器 (r n ir Fote ) 运 行 Hrt i e ir x, 新 建 任 务 后 在 配 置 选 项 中 加 入 获取新 的 U I R ,然后传递给 P o e sr c a n 处理链 )经 E t a t r o P O ln , r c s o h is( x r c oF r c n i e 在主 界面运行结果如 图 1所示 , 爬取 过 一系列 P o e sr ( r c s o 处理器 )处理 。 结束后 结果如 图 2所示 。

计 算机 光盘 软件 与应 用

多媒体技术及应用

C m u e D S f w r n p lc t o s o p t r C o t a e a d A p i a i n 2 1 第 8期 0 2年

基于 H r r 和 HT P re 的网页商品信息提取的研究 ei i tx ML asr

二 、 扩 展 H r t i e ir x ( )扩 展 爬 取 逻 辑 一

Ps e  ̄t s

L a o d

4 9 U I / c (. v ) . R g s c 1 7 a g

2 4 ̄ / e (5 v ) 3 s e 1 1 a g

T - i

9 a t y 0 tre d c l e of 2 0 h a s l cag s i n r t o c e t 口 a i l 6 ep s uu 0dee lqe e

刘 文 浩 ,谢 韬 , 吴进

( 四川大 学软件学院 ,成都

60 2 ) 125 来自摘要 :主要介 绍 He tx网络爬 虫,分析 了其 系统结构。通 过扩展 He tx rf i rr ,使其 能抓取 太平 洋电脑 网站上 的商 ii 品信息 。在此基础上 。利 用 E F s L Ha h对效率抓 取进 行优 化。最后 ,利用 HT P r r ML a e 提取收 集到 的网页商品信 息, s 为建 立垂 直搜 索引擎提供信 息源。 ’

9ae ae  ̄ t v r s d p h

以 太 平 洋 电 脑 网 站 h t :/ o i e p o l n . o . n t p / m b l. c n ie c m c / 手机商品页面为例 ,修改模块 H r t i e i r x能准确抓取商品网页 信 息 。 在 包 o g a c i e c a l r e t a t r 中 添 加 类 r . r h v . r w e .x r c o E tatroPOln x r c o F r cn i e解析网页 内容并选出候选地址 。其核

关键词 :Heii;HT P r r rr tx ML as ;网络爬 虫;信息提取 ;垂直搜 索 e

中图分类号 : P 9. 文献标识码 : T 31 1 A 文章 编号 :10— 5921)8 09- 2 07 99 ( 20- 10 0 0

N d F t r o e i e i p o u t r Fi t r rdcUl e i : 随着信 息多元化的发展。 向所有用户 的通用搜 索引擎 己 面 经不 能满 足特 定用户的更深入、专业 、详细的查询需求 。垂直 H st r b t F le (c a s , a e) a A t iu e i tr l s nm : N d L s oeit p 0 u t r1 i t r d cU L s 搜索 引擎 氤氲而生,它是相对通 用搜索引擎的信息 量大 、 查询 不准 确、深度 不够 等提 出来的新 的搜索引擎服务模式 。 网络 爬 D o u P r e U 1a 8r p r e p o u t r F e ) r d t a s 士 r Pr 6 . a s (r d cU l i t r : l nw e

T ga e i tr ’ a N m F e I i g r F t r m U l i e l = nw e 虫在垂 直搜索 中对于信 息收集起 到了重要韵作 用 。Hrti eirx a N m F i e (i g ) /图片 U L列表 R 是一个 由 Jv aa开发 的一个开源 的网络爬虫 , 它拥有着高可扩 T ga e i tr m :/ ( )改进爬取 效率 二 展性和 高效率 ,是进 行 网页信息 收集 的有 利工具 ,通过 配合 对于 同一个 H s ,e ir x爬虫采用一个线程进行爬取 , o tH r t i HMPre TL asr对 网页 内容进行解析 ,可 以有效地提取商 品网页 爬取效率不高。 通过扩展扩展 qe ea sgmn—o iy uu—s inetp lc 实现 ’ 键信息 。 关 对 同一个 H s o t多线程抓取 。在这里使用 E FA H算法使得不 LHS H rt i e ir x介绍 R Hrt i e i r X采用 了模块化 的设计 ,用户可 以在运行时选择 同的 U L能大致平均分配到不同的线程中。 l n 0: o gx 要 用 的 模 块 。 它 由核 心 类 ( o e l s e ) 和 插 件 模 块 c r c a s s