综述:视频去隔行算法简介

视频图像处理算法与应用

视频图像处理算法与应用随着科技的不断进步,视频图像处理技术已经越来越成熟,应用场景也越来越广泛。

视频图像处理算法是指运用一系列的图像处理技术,将人类能够感知的视觉信息转化为各种计算机能够处理的格式,识别信息,抽取信息等。

本文将介绍视频图像处理算法的基本概念、应用领域、算法分类等,以及它们对我们生活的影响与作用。

一、视频图像处理算法的基本概念视频图像处理算法是一种将视频或图像数据进行运算处理的技术。

其基本流程可分为图像数据采集、处理、编码、存储和解码等多个步骤。

其中,图像数据采集是使用相机等采集图像数据,处理则是对采集到的图像数据进行处理和优化,编码可将处理后的数据编码为可播放的格式,存储则是将编码后的数据储存到本地或云端,解码则是将编码后的数据解码为原始格式进行播放。

二、应用领域视频图像处理算法的应用非常广泛,其中最常见的领域包括:智能安防、医疗、娱乐等。

智能安防:智能安防领域使用视频图像处理算法识别与分析监控图片,并对捕捉到的动态图像数据实现实时识别、跟踪、分析和控制。

该技术广泛应用于人脸识别、车牌识别、智能门禁、安全监控等领域。

医疗:视频图像处理技术在医疗行业领域中的应用主要集中在图像识别、医学图像仿真等方向,如CT、X光、磁共振等医学检查常见体征参数提取和三维重建等。

娱乐:视频图像处理技术在娱乐领域中的应用主要集中在提高影片与游戏的表现力和交互性方面。

如动画、电影、三维建模、视觉特技等领域中都涉及到视频图像处理技术。

三、算法分类根据处理图像数据的方式可将视频图像处理算法分类为基于过滤器的算法和基于变换的算法。

基于过滤器的算法是指通过滤波器对数字图像进行处理,它的思路类似于图像上使用笔刷进行画线。

常用的滤波方式有高斯滤波、中值滤波等。

高斯滤波能够消除图像中的高频噪声,而中值滤波能够消除图像中的低频噪声。

在实际应用中,基于过滤器的算法通常用于图像去噪、平滑等处理领域。

基于变换的算法是指将数字图像通过特定的变换进行处理。

视频编码概念和主要编码算法

视频编码概念和主要编码算法视频编码是将数字视频信号转换为数字视频的过程,它使用编码算法来减少视频数据的冗余,并在保持视觉质量的同时减小文件大小。

视频编码对于视频传输、存储和分享非常重要。

视频编码的主要目标是通过移除冗余和统计特性来降低视频信号的数据率,而同时保持所需质量的最佳可视效果。

视频编码算法通常包含两个主要阶段:预处理和压缩编码。

预处理阶段是对视频信号进行处理和转换,以突出其中的重要信息,并减少冗余。

这些预处理技术包括空间和时间滤波、亮度和色彩空间转换等。

压缩编码阶段是将预处理后的视频数据压缩为尽可能小的比特流,通常使用有损压缩算法。

下面是几种主要的视频编码算法:1. MPEG(Moving Picture Experts Group)算法:MPEG是一组用于压缩和传输视频和音频数据的标准。

MPEG算法基于空间和时间冗余的概念,通过运动估计、运动补偿和离散余弦变换等技术来压缩视频数据。

2. H.264/AVC(Advanced Video Coding)算法:H.264是一种广泛使用的视频编码标准,具有高效的压缩性能。

它采用了运动估计、变换编码和熵编码等多种技术,并引入了一些新的特性,如帧内预测和熵编码上下文建模,以提高编码效率。

3. VP9算法:VP9是Google开发的一种开放源码视频编解码器,用于实现高效的视频压缩。

VP9算法采用了类似于H.264的技术,并引入了一些新的特性,如可变块大小和有损连续运动估计,以提高编码效率和视频质量。

4. AV1算法:AV1是一种由Alliance for Open Media开发的新一代开放源码视频编解码器。

AV1采用了先进的编码技术,如双向预测、变换编码和可变块大小等,以提供更好的压缩效率和视频质量。

这些视频编码算法的选择取决于具体的应用需求和技术要求。

不同的编码算法有不同的性能和兼容性,用户需要根据实际情况选择最适合的算法。

总之,视频编码是对数字视频信号进行处理和压缩的过程。

视频稳像算法综述

视频稳像算法综述视频稳像是一种用来减少视频中抖动的技术,其主要目的是提高视频质量和观看体验。

视频稳像算法是实现视频稳定的关键,它可以通过对视频进行处理,消除由于手持摄像、运动或其他因素引起的抖动,从而使视频画面显得更加平稳和清晰。

随着移动设备的普及和视频内容的增多,视频稳像技术越来越受到关注,各种视频稳像算法也不断得到改进和创新。

目前视频稳像算法主要分为机械稳像和软件稳像两大类。

机械稳像通过物理设备来进行抖动补偿,例如利用机械稳像仪器或者云台来调整镜头位置,从而实现视频的稳定。

而软件稳像则是通过对视频进行数字处理来实现稳定效果,减少抖动的同时保持视频内容的完整性。

软件稳像算法可以应用于各种类型的摄像设备和视频处理软件中,成为目前视频稳像技术的主流。

视频稳像算法在不同应用场景下有不同的技术原理和方法。

下面将针对不同视频稳像算法进行综述和分析,探讨它们的优劣势及适用范围。

1. 传统的视频稳像算法传统的视频稳像算法主要通过数字图像处理来实现抖动的消除,其中比较典型的方法是基于运动补偿和区域重叠的技术。

这些算法通过识别视频中的运动对象,通过补偿运动矢量来实现视频的稳定。

而在区域重叠技术中,通过对视频进行适当的裁剪或者重叠,从而实现对抖动部分的遮挡和修复。

传统视频稳像算法的优势是技术成熟、应用广泛,且能够较好地处理一般的抖动场景。

但传统算法也存在一些问题,例如无法处理复杂的抖动、对计算资源和存储空间的要求较高等。

由于目前视频抖动场景多样化,传统的视频稳像算法在某些场景中可能无法满足需求,因此也为进一步推动视频稳像技术的发展提出了挑战。

近年来,基于深度学习的视频稳像算法得到了快速的发展和应用。

深度学习通过人工神经网络和大量的数据训练可以提取特征,学习到更复杂的规律和模式,因此在视频稳像领域有着广阔的应用前景。

基于深度学习的视频稳像算法能够更加准确地识别视频中的抖动部分,快速地进行补偿和修正。

通过深度学习模型的训练,算法可以不断地优化自身的性能,适应不同场景和要求。

视频稳像算法综述

视频稳像算法综述视频稳像技术是一项将摄像机拍摄的视频图像进行处理,使图像能够呈现出稳定的状态,以此提高视频画面质量和观看体验的技术。

近年来,随着智能手机、无人机、运动相机等拍摄设备的普及,视频稳像技术也越来越得到关注和应用。

本文将综述现有的视频稳像算法,并分析各种算法的优缺点。

1. 基于物体运动的稳像算法基于物体运动的稳像算法是目前应用最广泛的一种稳像算法。

该算法是建立在图像中物体的运动变化基础之上,通过对连续的视频帧进行分析,计算出相邻帧之间的相对运动,从而实现对视频图像的稳定。

该算法能够有效地抑制由于手持摄像机抖动带来的图像震动变形等问题,提高视频的清晰度和流畅度。

基于传感器的稳像算法是通过直接利用拍摄设备本身的传感器信息来进行稳像处理。

该方法可以直接获取设备的加速度、陀螺仪等信息,实现对拍摄设备的姿态变化进行实时跟踪和计算,从而达到对视频图像的稳定效果。

该算法具有计算速度较快、稳定性较好等优点,但受到传感器精度、信噪比等限制,需要对传感器的噪声进行抑制和滤波等处理。

基于深度学习的稳像算法是近年来发展起来的一种新型稳像算法。

该算法通过利用神经网络的映射能力,将连续帧之间的像素信息进行特征提取和匹配,实现对图像运动的估计和修正,达到稳定视频图像的效果。

该算法能够在保证易实现、计算速度快等条件下,实现对视频画面的高质量稳定,但需要大量的视频数据和深度学习算法的训练。

综上所述,每种稳像算法都有其优缺点,需要在不同的应用场景下选择适合的算法,来实现对视频图像的稳定和优化。

未来随着计算机视觉、深度学习等技术的发展,视频稳像技术将在视频拍摄、视频压缩、视频分析等领域里发挥越来越大的作用。

视频处理算法范文

视频处理算法范文一、视频去抖动算法视频去抖动是指消除视频中由于相机抖动或者拍摄器材不稳定导致的图像抖动。

常见的视频去抖动算法包括基于均值滤波、位移算法、卷积神经网络等。

其中,位移算法通过分析图像上的像素位移信息,计算抖动量,并根据计算结果对图像进行修复,能够有效地减少抖动现象。

二、背景建模算法背景建模是指对视频中的背景进行建模和分析,通过提取背景信息,可以实现目标检测、目标跟踪和背景减除等功能。

常见的背景建模算法包括基于高斯模型、自适应混合高斯模型、基于学习的方法等。

其中,自适应混合高斯模型是一种广泛使用的背景建模算法,它可以根据背景变化自动适应调整高斯分布的参数,从而更好地适应不同场景下的背景变化。

三、运动目标检测算法运动目标检测是指对视频中的移动目标进行检测和定位。

常见的运动目标检测算法包括帧差法、光流法、背景模型法和基于深度学习的方法。

帧差法通过比较相邻帧之间的像素差异,判断是否为运动目标,是一种简单高效的方法。

而光流法则通过分析相邻帧之间的像素位移,进一步计算运动目标的速度和方向。

基于深度学习的方法则通过卷积神经网络对视频图像进行特征提取,进而实现高精度的运动目标检测。

四、视频编码算法视频编码是指将视频信号经过压缩编码处理,以减少视频数据的存储空间和传输带宽。

常见的视频编码算法包括MPEG系列标准、H.264、H.265等。

其中,H.264是一种广泛使用的视频编码标准,它通过在空间和时间域上对图像进行预测和差分编码,并采用变换和量化等方法进行数据压缩,从而实现高效的视频编码。

topaz video enhance原理

topaz video enhance原理Topaz Video Enhance AI 的原理主要基于深度学习技术和机器学习算法,它专门设计用来提升视频的质量和分辨率。

以下是关于其原理的详细解释:首先,Topaz Video Enhance AI 会分析输入视频的每一帧。

它不仅仅查看单一的帧,而是会查看周围的帧,这样可以从多个帧中提取信息。

这种方法使得算法能够理解视频中的运动模式、色彩分布、纹理细节等,为后续的增强操作提供了丰富的数据基础。

其次,该算法会尝试提高视频的分辨率。

这并不仅仅是简单地将每个像素放大,而是通过机器学习模型预测并填补缺失的细节。

例如,如果视频中有一个模糊的物体,Topaz Video Enhance AI 可能会通过查看周围帧中的相似物体来推测这个物体的真实形状和细节。

此外,Topaz Video Enhance AI 还可以进行去噪处理。

视频中的噪点可能是由于录制设备的质量、环境光线等因素造成的。

该算法会分析每一帧中的噪点模式,并尝试去除或显著减少这些噪点,从而使视频看起来更加清晰。

同时,Topaz Video Enhance AI 还可以处理视频的隔行扫描问题。

一些老的视频可能使用隔行扫描的方式录制,这会导致图像质量下降。

该算法可以识别并修复这种扫描方式带来的问题,使视频看起来更加流畅。

最后,Topaz Video Enhance AI 还能确保增强后的视频在动作上保持一致。

这意味着,即使在提高分辨率或去除噪点的过程中,视频中的运动物体也会看起来更加自然和连贯。

总之,Topaz Video Enhance AI 的原理是基于深度学习和机器学习技术,通过分析多帧信息,提高视频的分辨率、去除噪点、修复隔行扫描问题,并确保动作一致性,从而为用户提供高质量的视频增强体验。

《FFmpegBasics》中文版-18-隔行视频

《FFmpegBasics》中文版-18-隔行视频写在前面如果您对音视频技术感兴趣,可以订阅我的专题:音视频专辑也可以关注我的简书账户:张芳涛,我后期会发布更多的音视频以及图像处理方面的文章。

正文隔行扫描是在单色模拟电视开发过程中发明的技术,可以消除旧CRT显示器的闪烁。

视频帧被水平划分为规则线,然后划分为2个场,其中第一个场包含奇数行,第二个场包含偶数行。

NTSC, PAL和SECAM电视标准。

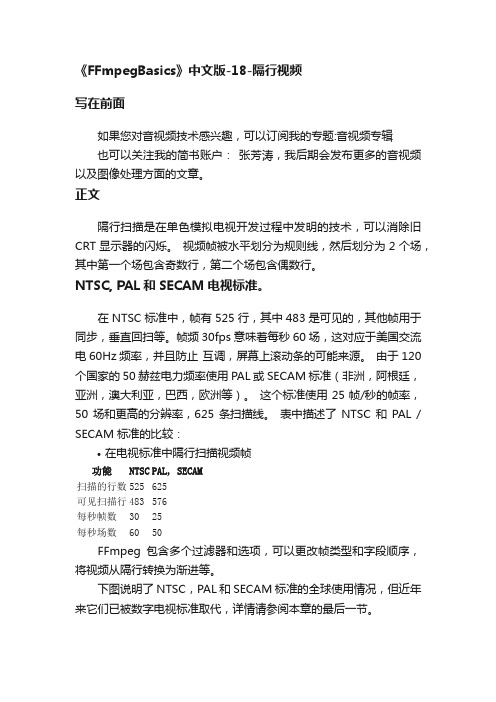

在NTSC标准中,帧有525行,其中483是可见的,其他帧用于同步,垂直回扫等。

帧频30fps意味着每秒60场,这对应于美国交流电60Hz频率,并且防止互调,屏幕上滚动条的可能来源。

由于120个国家的50赫兹电力频率使用PAL或SECAM标准(非洲,阿根廷,亚洲,澳大利亚,巴西,欧洲等)。

这个标准使用25帧/秒的帧率,50场和更高的分辨率,625条扫描线。

表中描述了NTSC和PAL / SECAM标准的比较:•在电视标准中隔行扫描视频帧功能NTSC PAL, SECAM扫描的行数525 625可见扫描行483 576每秒帧数30 25每秒场数60 50FFmpeg包含多个过滤器和选项,可以更改帧类型和字段顺序,将视频从隔行转换为渐进等。

下图说明了NTSC,PAL和SECAM标准的全球使用情况,但近年来它们已被数字电视标准取代,详情请参阅本章的最后一节。

隔行帧类型设置当使用本章描述的fieldorder和yadif过滤器时,在使用多个过滤器进行复杂转码时,使用setfield过滤器设置输出帧的字段类型可能很有用:描述在输出帧中标记隔行场的类型,帧的内容不变,只更新其属性。

对于下一个使用fieldorder和yadif等过滤器进行处理的过滤链非常有用。

语法setfield=type类型的数值auto 不要标记任何东西,默认值bff 帧首先是底部的场tff 帧首先是顶部的场prog 帧是渐进的例如,要首先将字段类型设置为顶部字段,我们可以使用以下命令:ffmpeg -i input.vob -vf setfield=tff output.mov我的测试命令:ffmpeg -i /Users/zhangfangtao/Desktop/test.mp4 -vf setfield=tff /Users/zhangfangtao/Desktop/test2.mp4•看不出来有啥不一样。

separation算法

Separation算法1. 简介Separation算法是一种用于图像处理和计算机视觉领域的算法,主要用于将图像中的前景和背景进行分离。

通过这种分离,我们可以更好地理解和分析图像中的对象,并对其进行进一步处理。

Separation算法通常用于图像分割任务,其中目标是将输入图像划分为多个区域,每个区域代表不同的对象或物体。

这些区域可以是基于颜色、纹理、形状等特征来定义的。

2. 常见的Separation算法以下是几种常见的Separation算法:2.1 GrabCut算法GrabCut算法是一种基于图割(Graph Cut)和高斯混合模型(Gaussian Mixture Model)的前景背景分割算法。

它通过迭代优化来估计前景和背景之间的边界,并根据这些边界将图像中的像素标记为前景或背景。

GrabCut算法首先需要用户提供一个包含前景目标的矩形框,然后通过迭代过程逐渐优化初始估计。

该算法结合了颜色、纹理和位置信息来进行分割,因此在复杂场景中表现良好。

2.2 Mean-Shift算法Mean-Shift算法是一种基于核密度估计的非参数聚类算法,也可以用于图像分割。

该算法通过不断迭代来寻找像素密度最大的区域,并将其作为前景。

Mean-Shift算法首先选择一个种子点作为初始估计,然后通过计算梯度向量迭代地移动该点,直到达到停止条件。

在每次迭代中,该算法会根据像素之间的颜色和空间距离来更新梯度向量。

2.3 Watershed算法Watershed算法是一种基于图论的分水岭分割算法,它将图像视为一个地形图,并使用水流模拟来进行分割。

该算法通过模拟水从高处流向低处的过程来确定图像中的区域边界。

Watershed算法首先将图像中的灰度值作为高程信息,并根据灰度值之间的梯度构建一个梯度图。

然后,该算法使用洪水填充(Flood Fill)技术来模拟水流,并根据水流路径确定区域边界。

3. Separation算法在实际应用中的应用Separation算法在许多实际应用中发挥着重要作用:3.1 图像分割Separation算法可以用于图像分割任务,例如将图像中的前景和背景进行分离。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

目录1 非运动补偿的去隔行算法 (3)1.1 线性滤波去隔行 (3)1.1.1 空间滤波(Spatial Filtering) (3)1.1.2 时间滤波(Temporal Filtering) (3)1.1.3 时空滤波(Spatial-Temporal Filtering) (4)1.2 非线性算法 (4)1.2.1运动自适应算法(Motion-Adaptive Algorithms) (4)1.2.2边缘自适应算法(Edge-Adaptive Algorithms) (5)1.2.3中值滤波算法 (5)2 运动补偿的算法(Motion-Compensated Algorithms) (6)2.1 加权平均的运动自适应去隔行算法 (6)2.1.1 运动估计权值α的计算 (7)2.1.2 综合结果的计算 (7)2.2 基于运动检测和自适应加权滤波的去隔行算法 (7)2.2.1 算法基本思想 (7)2.2.2 运动估计 (8)2.3 用运动自适应加边缘检测的两级加权求和算法 (8)2.3.1 算法基本思想 (8)2.3.2 Cubic 内插值算法 (8)2.3.2 加权系数的计算 (9)2.4 一种新型易于FPGA实现的去隔行算法 (9)2.4.1 算法基本思想 (10)2.4.2运动估计 (10)2.4.3 改进的场内差值算法 (10)2.5 基于运动检测的去隔行中值滤波算法 (10)2.5.1 算法基本思想 (10)2.5.2运动估计 (11)2.5.3 场内中值滤波算法 (11)2.6 基于运动检测的去隔行11阶低通滤波算法 (11)2.6.1 算法基本思想 (11)2.6.2 动态图像场内11阶低通滤波差值 (11)2.6.3 场内插值加权系数的计算 (11)2.7 基于FPGA优化运动检测去隔行算法的设计 (12)2.7.1 算法基本思想 (12)2.7.2 动态图像的场内插值加权系数的计算 (12)2.8 基于运动补偿的自适应视频去隔行算法 (12)2.8.1 算法基本思想 (13)2.8.2 场内插值加权系数的计算 (13)2.9 Altera基于运动检测和自适应加权滤波的去隔行算法 (13)2.9.1 算法基本思想 (13)2.9.2 运动估计 (14)视频去隔行处理综述去隔行处理的基本原理是根据图像序列在时间和空间的相关性,产生出空缺位置处的像素点。

通过这种处理,可以最大限度的恢复出逐行扫描图像,改善电视画面的质量;同时也生成了点阵显示设备可以接受的逐行格式。

去隔行的任务就是将隔行扫描的输入场(包括奇场和偶场)转换成帧。

这些帧表示与输入相同的图像,但包括所有行的采样。

下文为描述方便,定义如下:F I(x,y,t):输入的当前第t场,当前像素坐标位置为x行,y列F i(x,y,t):待插的当前第t场,当前像素坐标位置为x行,y列F O(x,y,t):输出的当前第t场,当前像素坐标位置为x行,y列一般定义去隔行输出帧如下:F I(x,y,t) x mod 2 == t mod 2 (即奇场的奇行或偶场的偶行)F O(x,y,t) =F i(x,y,t) 其它去隔行算法主要分为非运动补偿(Non-Motion Compensation)和运动补偿(Motion Compensation)两大类。

非运动补偿算法是早期比较简单,且硬件实现比较容易的算法,主要包括线性和非线性两种算法。

运动补偿类算法是目前最先进的去隔行算法,与非运动补偿算法相比,运动补偿算法极大的提高了去隔行运算的准确度,但同时由于加大了硬件实现的难度,这种算法一直停留在理论研究阶段,直到九十年代中期随着vLsI技术的发展和算法的改进,面向普通消费类市场的单芯片运动估计器的出现,运动补偿类的格式转换算法才开始成为研究的热点。

下面将分别对非运动补偿算法和运动补偿算法以及运动估计算法做简要介绍。

1 非运动补偿的去隔行算法基于非运动补偿的去隔行算法分为两种:线性类算法和非线性类算法。

这两种算法中都包括空间(场内)、时间(场间)和时空算法。

1.1 线性滤波去隔行线性滤波算法具有简单易实现的优点,目前仍在一些低端视频格式转换领域内被广泛应用。

其基本思想是:各场中需要补齐的像素点等于它的若干相邻点的加权和。

线性滤波的相邻点包括两类,即同一场上的相邻像素(空间相邻点)以及相邻场上的像素(时间相邻点)。

对于相邻点的分类就引出了三种不同的滤波器类型:空间滤波(Spatial Filtering),时间滤波(Temporal Filtering),以及时一空滤波(Spatial—Temporal Filtering)。

1.1.1 空间滤波(Spatial Filtering)所谓空间滤波,就是在求取未知点的时候只使用同一场内相邻点的信息。

最简单的空间滤波就是扫描线重复(Line Repetition),即一场中未知的像素点直接取它上面相邻点的值,简称场内行复制算法。

用公式的形式来表示如下:F I(x,y,t) x mod 2 == t mod 2 (即奇场的奇行或偶场的偶行)F O(x,y,t) =F I(x-1,y,t) 其它(即取上一行同一列的像素值)另一种稍微复杂一点的形式为线平均(LineAveraging),即未知的像素点等于其上下两个相邻已知的点的值的平均,简称场内行平均算法。

公式表示如下。

F I(x,y,t) x mod 2 == t mod 2 (即奇场的奇行或偶场的偶行)F O(x,y,t) =[F I(x-1,y,t)+ F I(x+1,y,t)]/2 其它即取上一行和下一行同一列的像素值均值)上述两个空间滤波有一个共同的特点,即它们在时间频率方向上是全通的,这说明使用空间滤波器不会造成视频运动信息上的损失。

但是,由于其频谱在垂直方向上的低通形状,使得视频信号在垂直方向上的一些高频分量被抑制,从而降低了图像在垂直方向上的清晰度。

1.1.2 时间滤波(Temporal Filtering)与空间滤波正好相反,时间滤波就是利用了待插值点在时间轴上的相关性,使用所有相邻场内的点来求取当前场的未知像素。

最简单的时间滤波就是场重复(Field Repetition),即一场中未知的像素点用上一场对应的已知像素值来代替,简称场复制法。

公式表示如下:F I(x,y,t) x mod 2 == t mod 2 (即奇场的奇行或偶场的偶行)F O(x,y,t) =F I(x,y,t-1) 其它(即取上一场同行同列的像素值)另一种改进的时间滤波算法是将当前场的像素值采用上一场和下一场同行同列像素均值,公式表示如下:F I(x,y,t) x mod 2 == t mod 2 (即奇场的奇行或偶场的偶行)F O(x,y,t) =[F I(x,y,t-1)+ F I(x,y,t+1)]/2 其它即取上一场和下一场同行同列的像素值均值)如果视频中没有运动的话,这一滤波器就是最优滤波器。

时间滤波器在垂直方向上是全通的,因此不会造成图像垂直清晰度上的损失,但其在时间频率上的频谱的衰降,会造成视频运动信息的损失。

1.1.3 时空滤波(Spatial-Temporal Filtering)所谓时空滤波,就是在计算像素点的值的时候综合考虑空间邻点与时间邻点,它结合了上述两种滤波算法的特性,利用时间空问三维邻域内的信号相关性来重构待插信号。

从理论上说,如果视频信号满足采样定理,即其频谱没有混叠的话,那么使用时空滤波器就能完美地从隔行信号恢复出逐行信号。

由于具有较好的处理品质,此类滤波算法在早期的去隔行芯片中得到广泛运用,一个常用的时空滤波器的待插像素值为:F i(x,y,t)=[F I(x-3,y,t)+ 8*F I(x-1,y,t)+ 8*F I(x+1,y,t)+ F I(x+3,y,t)-5* F I(x-2,y,t-1) +10* F I(x,y,t-1) -5* F I(x+2,y,t-1)]/18该算法表示当前场的4个像素(上一行、上三行、下一行、下三行)和上一场的三个像素值(同行、上两行、下两行)的加权均值,各像素的加权系数分别为8/18、1/18、8/18、1/18、10/18、-5/18、5/18。

该滤波器也称为VT滤波器(参见《对隔行采样的视频信号及去隔行技术的分析》介绍)。

线性类格式变换算法结构简洁,规则易于芯片实现,处理品质比较稳定。

但线性滤波器也存在诸多缺陷,如通带和止带的频率很难选择和所设计的低通滤波器不够理想等。

1.2 非线性算法线性空间滤波类算法会引入图像混叠,而线性时间滤波对于运动场景会引入运动模糊。

随着对多种算法的特性和由此引起的图像退化现象的深入理解,人们开始考虑设计能够根据场景内容在不同算法和不同系数间进行自动调整的算法,以综合不同算法的优势。

这样在上世纪80年代后期和90年代早期出现了很多非线性类的自适应变换算法。

1.2.1运动自适应算法(Motion-Adaptive Algorithms)在没有运动的情况下,时间滤波器的性能最好。

而在有运动,但没有过多的垂直细节的情况下,空间滤波的效果最好,很自然地,我们想到能否将前面已有算法结合起来。

根据情况,有选择地使用时间滤波或空间滤波。

运动自适应算法就是根据上述思想发展起来的。

运动自适应算法需要一个检测图像中是否存在运动的模块,称为运动检测模块(Motion Detector),根据运动检测模块的输出来调整相应的内插策略。

为了保证运动检测的有效性,必须假定运动检测算法所必需满足的条件:a)相对信号来说,噪声必须足够小;b)信号中的低频部分的能量必须大于噪声与频率混叠部分;c)视频中的物体大小必须大于像素点的大小。

运动检测的算法有许多,当检测出运动的可能性很大时,结果将会倾向于采用运动最优滤波器。

反之则会倾向于静止最优滤波器,从而达到了自适应的目的。

待插值点公式可表示为:F i(x,y,t)=α*F S(x,y,t)+ (1-α)*F M(x,y,t)其中:F S(x,y,t)为静止图像部分;F M(x,y,t)为运动图像部分;α为加权系数,由运动检测模块输出的运动等级设定。

1.2.2边缘自适应算法(Edge-Adaptive Algorithms)边缘自适应算法的基本思想是:当视频中存在运动,而必须采用帧内内插算法时,我们就尽量选择一条边,使沿着这条边方向上的内插失真最少。

对45°、90°、135°三个方向进行边缘检测, 如上图所示, 取所在方向上的两个像素的绝对差值最小的方向作为边缘保护方向, 边缘保护插值点则为相应边缘保护方向的两个像素点的平均值。

定义k和m,使得 | F I(x-k,y-m,t)- F I(x+k,y+m,t)|最小,其中,k= -1,0,1,m= -1,0,1则F M(x,y,t) = [F I(x-k,y-m,t)+ F I(x+k,y+m,t)]/2与线性滤波类算法相比,边界自适应滤波器在保留边界信息的同时减少了运算量(--维滤波降为一维滤波),是性价比很高的一类格式变换算法。