Hadoop源代码分析(完整版)

基于Hadoop数据分析系统设计(优秀毕业设计)

第一章 某某企业数据分析系统设计需求分析

某某企业成立于 1999 年,其运营的门户网站每年产生大概 2T 的日志信息, 为了分析网站的日志,部署了一套 Oracle 数据库系统,将所有的日志信息都导 入 Oracle 的表中。 随着时间的推移,存储在 Oracle 数据库中的日志系统越来越 大, 查询的速度变得越来越慢, 并经常因为查询的数据量非常大而导致系统死机。 日志信息的分析成为了 XX 企业急需解决的问题,考虑到单机分析的扩展性与成 本问题,且 XX 企业当前有一部分服务器处于闲置状态,最终决定在现有服务器 的基础上部署一套分布式的系统来对当前大量的数据进行分析。 结合淘宝目前已 经部署成功的数据雷达系统,同时由于 XX 企业预算有限,为了节约资金,决定 采用开源的 Hadoop 来部署公司的数据分析系统。 采用 Hadoop 集群优势:

1. 采用单 master 的设计,单 master 的设计极大地简化了系统的设计和实现, 由此带来了机器规模限制和单点失效问题。 2. 编程复杂,学习曲线过于陡峭,让许多人难以深入。 3. 开源性,在广大社区维护不断推进 Hadoop 的发展的同时,一旦代码出现漏 洞并未被发现, 而又被有心的人利用, 将会对数据的安全造成毁灭性的后果。 4. 缺乏认证,Hadoop 并没有对使用 Hadoop 的权限进行细致的划分。

3.8.1 Hive 安装...................................................................................................... 33 3.8.2 使用 MySQL 存储 Metastore..................................................................... 33 3.8.3 Hive 的使用.................................................................................................. 36 3.9 HBASE 安装与配置.......................................................................................... 37

hadoop 原理

hadoop 原理Hadoop原理Hadoop是一个开源的分布式计算框架,它能够处理大规模数据集并且能够提供高可靠性、高可扩展性和高效率的计算能力。

本文将详细介绍Hadoop的原理。

一、Hadoop的概述1.1 Hadoop的定义Hadoop是一个基于Java语言编写的分布式计算框架,它由Apache 基金会开发和维护。

1.2 Hadoop的特点- 可以处理大规模数据集- 具有高可靠性、高可扩展性和高效率- 支持多种数据存储方式- 支持多种计算模型和编程语言- 易于部署和管理1.3 Hadoop的组件Hadoop由以下几个组件组成:- HDFS(Hadoop Distributed File System):分布式文件系统,用于存储大规模数据集。

- MapReduce:分布式计算框架,用于对大规模数据进行并行处理。

- YARN(Yet Another Resource Negotiator):资源管理器,用于协调整个集群中各个应用程序之间的资源使用。

二、HDFS原理2.1 HDFS概述HDFS是一个分布式文件系统,它可以在集群中存储大规模数据集。

它采用了主从架构,其中NameNode作为主节点,负责管理整个文件系统的元数据,而DataNode作为从节点,负责存储数据块。

2.2 HDFS文件存储原理HDFS将一个文件分成多个数据块进行存储。

每个数据块的大小默认为128MB,可以通过配置进行修改。

当一个文件被上传到HDFS中时,它会被分成多个数据块,并且这些数据块会被复制到不同的DataNode上进行备份。

2.3 HDFS读写原理当客户端需要读取一个文件时,它会向NameNode发送请求。

NameNode返回包含该文件所在DataNode信息的列表给客户端。

客户端根据这些信息直接与DataNode通信获取所需的数据。

当客户端需要上传一个文件时,它会向NameNode发送请求,并且将该文件分成多个数据块进行上传。

hadoop核心组件概述及hadoop集群的搭建

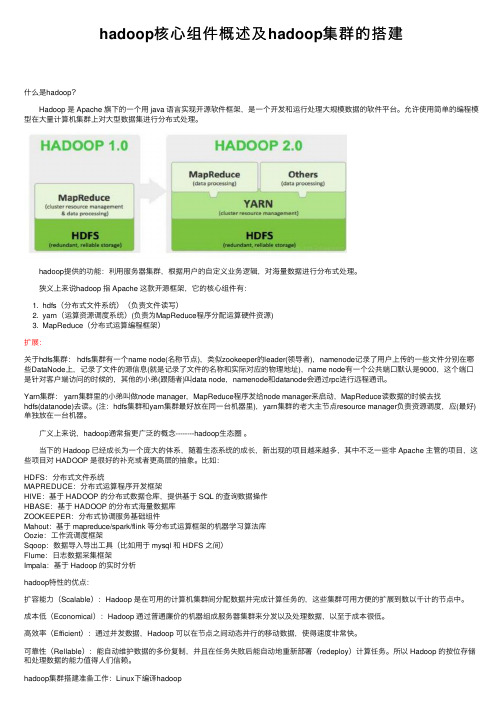

hadoop核⼼组件概述及hadoop集群的搭建什么是hadoop? Hadoop 是 Apache 旗下的⼀个⽤ java 语⾔实现开源软件框架,是⼀个开发和运⾏处理⼤规模数据的软件平台。

允许使⽤简单的编程模型在⼤量计算机集群上对⼤型数据集进⾏分布式处理。

hadoop提供的功能:利⽤服务器集群,根据⽤户的⾃定义业务逻辑,对海量数据进⾏分布式处理。

狭义上来说hadoop 指 Apache 这款开源框架,它的核⼼组件有:1. hdfs(分布式⽂件系统)(负责⽂件读写)2. yarn(运算资源调度系统)(负责为MapReduce程序分配运算硬件资源)3. MapReduce(分布式运算编程框架)扩展:关于hdfs集群: hdfs集群有⼀个name node(名称节点),类似zookeeper的leader(领导者),namenode记录了⽤户上传的⼀些⽂件分别在哪些DataNode上,记录了⽂件的源信息(就是记录了⽂件的名称和实际对应的物理地址),name node有⼀个公共端⼝默认是9000,这个端⼝是针对客户端访问的时候的,其他的⼩弟(跟随者)叫data node,namenode和datanode会通过rpc进⾏远程通讯。

Yarn集群: yarn集群⾥的⼩弟叫做node manager,MapReduce程序发给node manager来启动,MapReduce读数据的时候去找hdfs(datanode)去读。

(注:hdfs集群和yarn集群最好放在同⼀台机器⾥),yarn集群的⽼⼤主节点resource manager负责资源调度,应(最好)单独放在⼀台机器。

⼴义上来说,hadoop通常指更⼴泛的概念--------hadoop⽣态圈。

当下的 Hadoop 已经成长为⼀个庞⼤的体系,随着⽣态系统的成长,新出现的项⽬越来越多,其中不乏⼀些⾮ Apache 主管的项⽬,这些项⽬对 HADOOP 是很好的补充或者更⾼层的抽象。

hadoop实验报告

hadoop实验报告为了更好地理解和应用大数据处理技术,我们在实验室完成了一次Hadoop实验。

本文将介绍我们的实验内容、使用的方法、数据分析结果及经验分享。

1.实验内容本次实验以获取HTTP请求日志为主要数据源,通过Hadoop 技术对这些数据进行统计和分析,得出有意义的结论。

我们的目标是:- 把这些日志数据解析成可读、可处理的格式;- 通过MapReduce框架,统计HTTP请求中不同字段的访问情况,分析访问量、热点内容等;- 通过Hive和Pig工具,进一步深入数据,进行数据挖掘和预测分析。

2.方法为了使实验过程更高效,我们采用了虚拟机技术,并在其中搭建好了Hadoop集群环境。

具体操作步骤如下:- 在虚拟机中安装Ubuntu操作系统;- 安装Java、Hadoop;- 将HTTP请求日志导入Hadoop分布式文件系统(HDFS)中;- 利用Hadoop的MapReduce框架处理数据,将结果保存到HDFS;- 通过Hive和Pig分别进行数据查询和分析。

3.数据分析结果在实验中,我们使用了相应的程序和工具,最终得出了以下数据分析结果:- 不同的HTTP请求方法中,最高访问量的为GET请求,占总访问量的80%以上;- 在所有请求中,占比最高的页面为“/”,占总访问量的60%左右;- 分析出前十个访问量最多的网页,可以进一步了解用户访问兴趣和热点内容。

同时,我们也利用Hive和Pig工具进行了数据挖掘和预测分析。

在Hive中,通过对HTTP请求的数据进行透视,可以发现一个趋势:随着时间的推移,对不同请求方式的访问比例出现了较大变化;在Pig中,我们则进行了关联查询,得出了各个网页之间的关系和可能的用户行为。

4.经验分享在本次实验中,我们深入了解了Hadoop技术和大数据处理的方法,也得到了一些有益的经验和建议:- 在配置Hadoop集群时,需注意不同组件的版本和兼容性;- 在编写MapReduce程序时,应根据实际需要和数据特点,合理设计算法和逻辑;- 在使用Hive和Pig工具时,应熟悉数据的类型和查询语言,避免出现语法错误和数据倾斜。

hadoop技术、方法以及原理的理解

hadoop技术、方法以及原理的理解Hadoop技术、方法以及原理的理解Hadoop是一个开源的分布式计算框架,它能够存储和处理海量的数据。

它由Apache基金会开发和维护,是目前最流行的大数据处理解决方案之一。

Hadoop的技术、方法以及原理是构成Hadoop 的核心部分,下面我们将对其进行详细的解析。

一、Hadoop的技术1. HDFSHadoop分布式文件系统(HDFS)是Hadoop的核心组件之一。

它是一种高度容错的分布式文件系统,具有高可靠性和高可用性。

该文件系统将海量数据分散存储在多个节点上,以实现快速访问和处理。

2. MapReduceMapReduce是Hadoop的另一个核心组件,它是一种编程模型和处理数据的方式。

MapReduce将数据分成小的块,然后在分布式计算机集群上处理这些块。

MapReduce将任务分为Map和Reduce两个阶段。

在Map阶段,数据被分割并分配给不同的节点进行计算。

在Reduce阶段,计算的结果被合并起来并输出。

3. YARNHadoop资源管理器(YARN)是另一个重要的组件,它是一个分布式的集群管理系统,用于管理Hadoop集群中的资源。

YARN允许多个应用程序同时运行在同一个Hadoop集群上,通过动态管理资源来提高集群的使用效率。

二、Hadoop的方法1. 大数据存储Hadoop通过HDFS实现对海量数据的存储和管理。

HDFS的设计目标是支持大型数据集的分布式处理,它通过多个节点存储数据,提供高可靠性和高可用性。

2. 数据处理Hadoop通过MapReduce实现对海量数据的处理。

MapReduce 将数据分成小的块,然后在分布式计算机集群上处理这些块。

在Map阶段,数据被分割并分配给不同的节点进行计算。

在Reduce 阶段,计算的结果被合并起来并输出。

3. 数据分析Hadoop通过Hive、Pig和Spark等工具实现数据分析。

这些工具提供了高级查询和数据分析功能,可以通过SQL和其他编程语言来处理海量数据。

hadoop基本架构和工作原理

hadoop基本架构和工作原理Hadoop是一个分布式开源框架,用于处理海量数据。

它能够使用廉价的硬件来搭建集群,同时还提供了高度可靠性和容错性。

Hadoop基本架构包括Hadoop Common、Hadoop Distributed File System (HDFS)和Hadoop MapReduce三个部分,下面将详细介绍Hadoop的工作原理。

1. Hadoop CommonHadoop Common是整个Hadoop架构的基础部分,是一个共享库,它包含了大量的Java类和应用程序接口。

Hadoop集群的每一台机器上都要安装Hadoop Common,并保持相同版本。

2. HDFSHadoop Distributed File System(HDFS)是Hadoop的分布式文件存储部分。

它的目的是将大型数据集分成多个块,并且将这些块在集群中的多个节点间分布式存储。

HDFS可以实现高度可靠性,因为它将每个块在存储节点之间备份。

HDFS可以在不同的节点中进行数据备份,这确保了数据发生故障时,可以轻松恢复。

3. MapReduceHadoop MapReduce是一种编程模型,用于处理大型数据集。

它将处理任务分成两个主要阶段,即Map阶段和Reduce阶段。

在Map阶段,MapReduce将数据集分成小块,并将每个块分配给不同的节点进行处理。

在Reduce阶段,结果被聚合,以生成最终的输出结果。

总的来说,MapReduce作为Hadoop的核心组件,负责对数据集进行处理和计算。

它充当的角色是一个调度员,它会将不同的任务分发到集群中的不同节点上,并尽力保证每个任务都可以获得足够的计算资源。

Hadoop采用多种技术来提供MapReduce的分布式计算能力,其中包括TaskTracker、JobTracker和心跳机制等。

TaskTracker是每个集群节点的一个守护程序,负责处理MapReduce任务的具体实现。

Hadoop知识点总结

Hadoop知识点总结Hadoop知识点总结1.什么是hadoop?hadoop是⼀个开源软件框架,⽤于存储⼤量数据,并发处理/查询在具有多个商⽤硬件(即低成本硬件)节点的集群上的那些数据。

总之Hadoop包括⼀下内容:HDFS(Hadoop分布式⽂件系统):允许以⼀种分布式和冗余的⽅式存储⼤量数据。

例如:1GB(即1024MB)⽂本⽂件可以拆分为16*128MB⽂件,并存储在Hadoop集群中的8个不同节点上。

每个分裂可以复制三次,以实现容错,以便如果⼀个节点出现错误的话,也有备份。

HDFS适⽤于顺序的"⼀次写⼊,多次读取"的类型访问。

MapReduce:⼀个计算框架。

它以分布式和并⾏的⽅式处理⼤量的数据,当你对所有年龄>18的⽤户在上述1GB⽂件上执⾏查询时,将会有"8个映射"函数并⾏运⾏,以在其128MB拆分⽂件中提取年龄>18的⽤户,然后"reduce"函数将将会运⾏以将所有单独的输出组合成单个最终结果。

YARN(⼜⼀资源定位器):⽤于作业调度和集群资源管理的框架。

Hadoop⽣态系统,拥有15多种框架和⼯具,如Sqoop,Flume,Kafka,Pig,Hive,Spark,Impala等以便将数据摄⼊HDFS,在HDFS中转移数据(即变换、丰富、聚合等),并查询来⾃HDFS的数据⽤于商业智能和分析。

某些⼯具(如Pig和Hive)是MapReduce上的抽象层,⽽Spark和Impala等其他⼯具则是来⾃MapReduce的改进架构/设计,⽤于显著提⾼延迟以⽀持近实时和实时处理2.为什么组织从传统的数据仓库⼯具转移到基于Hadoop⽣态系统的智能数据中⼼?1.现有数据基础设施:主要使⽤存储在⾼端和昂贵硬件中的"structured data,结构化数据"主要处理为ETL批处理作业,⽤于将数据提取到RDBMS和数据仓库系统中进⾏数据挖掘,分析和报告,以进⾏关键业务决策主要处理以千兆字节到兆字节为单位的数据量2.基于Hadoop的更加智能的数据基础设施,其中:结构化(例如RDBMS),⾮结构化(例如images,PDF,docs)和半结构化(例如logs,XMLs)的数据可以以可扩展和容错的⽅式存储在⽐较便宜的商⽤机器中数据可以存储诸如Spark和Impala之类的⼯具以低延迟的能⼒查询可以存储以兆兆字节到千兆字节为单位的较⼤数据量3.基于Hadoop的数据中⼼的好处是什么?随着数据量和复杂性的增加,提⾼量整体服务⽔平协议。

hadoop常用命令详细解释

hadoop常⽤命令详细解释hadoop命令分为2级,在linux命令⾏中输⼊hadoop,会提⽰输⼊规则Usage: hadoop [--config confdir] COMMANDwhere COMMAND is one of:namenode -format format the DFS filesystem#这个命令⽤于格式化DFS系统:hadoop namenode -formatesecondarynamenode run the DFS secondary namenode#运⾏第⼆个namenodenamenode run the DFS namenode#运⾏DFS的namenodedatanode run a DFS datanode#运⾏DFS的datanodedfsadmin run a DFS admin client#运⾏⼀个DFS的admin客户端mradmin run a Map-Reduce admin client#运⾏⼀个map-reduce⽂件系统的检查⼯具fsck run a DFS filesystem checking utility#运⾏⼀个DFS⽂件系统的检查⼯具fs run a generic filesystem user client#这个是daoop⽂件的系统的⼀级命令,这个⾮常常见稍后详细讲解这个命令:例如hadoop fs -ls /balancer run a cluster balancing utility#作⽤于让各个datanode之间的数据平衡,例如:sh $HADOOP_HOME/bin/start-balancer.sh –t 15%oiv apply the offline fsimage viewer to an fsimage#将fsimage⽂件的内容转储到指定⽂件中以便于阅读,oiv⽀持三种输出处理器,分别为Ls、XML和FileDistribution,通过选项-p指定 fetchdt fetch a delegation token from the NameNode#运⾏⼀个代理的namenodejobtracker run the MapReduce job Tracker node#运⾏⼀个MapReduce的taskTracker节点pipes run a Pipes job#运⾏⼀个pipes作业tasktracker run a MapReduce task Tracker node#运⾏⼀个MapReduce的taskTracker节点historyserver run job history servers as a standalone daemon#运⾏历史服务作为⼀个单独的线程job manipulate MapReduce jobs#处理mapReduce作业,这个命令可以查看提交的mapreduce状态,杀掉不需要的jobqueue get information regarding JobQueues#队列管理,在后续版本中这个命名取消了version print the version#打印haoop版本jar <jar> run a jar file#运⾏⼀个jar包,⽐如mapreduce可以通过hadoop-streaming-1.2.1.jar进⾏开发distcp <srcurl> <desturl> copy file or directories recursively#distcp⼀般⽤于在两个HDFS集群中传输数据。

【原创HadoopSpark动手实践6】Spark编程实例与案例演示

【原创 HadoopSpark动手实践 6】 Spark编程实例与案例演示

【原创 Hadoop&Spark 动手实践 6】Spark 编程实例与案例演示 Spark 编程实例和简易电影分析系统的编写 目标: 1. 掌握理论:了解Spark编程的理论基础 2. 搭建开发环境:自己可以搭建Spark程序开发的环境 3. 动手实践简单的示例:完成一些简单的动手实验,可以帮助Spark的深入理解 4. 完成一个完整的小项目:完成简易电影分析系统的编写1. 掌源自理论:了解Spark编程的理论基础

Hadoop开发者第四期--北风网

Hadoop 技术论坛

网址

本期主编

《Hadoop 开发者》第四期 何忠育 ( Spork )

编辑

皮冰锋 ( 若冰 ) 易剑 ( 一见 ) 贺湘辉 ( 小米 ) 王磊 ( beyi ) 代志远 ( 国宝 ) 柏传杰 ( 飞鸿雪泥 ) 何忠育 ( Spork ) 秘中凯

Hadoop 开发者第四期

mooon

二、 分层结构

三、 基础类库

四、 公共组件

-2-

Hadoop 开发者第四期

mooon

五、 分布式平台

Mooon 的源代码放在 GoogleCode 网站上,可通过 SVN 下载,或直接在浏览器上查看,网址 是: /p/mooon。同时,我也会在 上输出 mooon 的一 些情况。

作者简介:jamesqin(覃武权),负责各种运营支撑和管理平台的架构及开发,致力于运维支撑体系的数据化、自动 化、流程化建设。 联系方式:jamesqin at -4-

Hadoop 开发者第四期

海量数据处理平台架构演变

grep、 sort、 uniq、 awk、 sed 等系统命令, 完成了很多的统计需求, 比如统计访问频率较高的 client_ip, 某个新上线的的页面的 referer 主要是哪些网站。 嗯,不错,老大如果问起这个网站的一些数据,回答起来绝对是游刃有余。^_^ 看书看得小有成就的小 Q 暗自窃喜,这时候王 sir 走过来关心下徒弟,小 Q 一激动,就把刚学 的东东向王 sir 汇报了一番。王 sir 边听边点点头,称赞小 Q 懂的还真不少啊! “如果你的网站数据 量再翻 10 倍,达到日志总行数 1 亿/天,这个架构还能支撑吗?” “这个,这……”突然一问,问 懵了小 Q,露馅了不是? 小 Q 赶紧认了, “这个还真不知道,求师傅详解。 ” 王 sir 看这徒弟如此积极好学,心里很是安慰,拿着笔在小 Q 的笔记本上边划边耐心讲道。 当业务的迅猛发展, 网站流量爆发增长, 产品经理如果想从中获取更多的用户特征和用户信息, 就需要我们这些数据分析人员从不同的日志中找到令他们满意的答案。如果 (1) 日志总行数:1 亿/天 (2) 每天日志大小:450Byte/行 * 1 亿 = 42G, (3) 日志种类:5 种 那么之前采用的 LogBackup 服务器就会出现短板,虽然 LogBackup 服务器不会有空间不足的 风险,但是它这样单机独立存储,在一堆数据之中执行一次 grep,都需要等上几分钟,串行操作直 接导致性能瓶颈。 这时候细心观察 LogBackup 服务器上的 cpu 利用率数据, 就会发现日志存储服务 器大部分的时间都是闲置状态,而一些临时的 linux 命令或脚本运行的时候, cpu 利用率也不高, 如下图: