搜索引擎垃圾网页检测模型研究

个性化网络信息检索模型及其应用研究

【 关键 词】 :搜 索引擎; 个性化服 务 ; 个性化检 索; 个性化检 索模型 ; 代理技 术

1 .引言

Y ho 的 目录更 具 有 科 学 性 。 ao ! 网站 收 录 丰 富 , 索 结果 精 确 度 较 检

在 众 多 检索 工 具 中 .搜 索 引 擎是 一 种 被 众 多 网 站所 推 崇 的 也是 深受 广 大 网 民喜 爱 的 网络 检 索 工 具 某 种 角度 而 言 . 索 从 搜 引擎的出现确实使广大 网民在 繁杂 的网络信息 中能够方便 、 快 捷的查找到 自己所需要 的信息 , 并且 目前也被广泛应用。 但是 由 于 目前 多 数搜 索 引 擎 都 通 过 对 WWW 页 面 进行 索 引 和关 键 词 匹 配来满 足用户的检索请求 , 于克服 以下两个缺点 : 难 其一 , 何 任 个 搜 索 引 擎 的索 引也 无 法 覆 盖 整 个 网络 资 源 . 即其 检 全 牢 是 不 完 全 的 ; 二 。 于 采 用 简单 的关 键词 匹 配 方 法 , 索 引 擎 对 其 由 搜 条 检 索 请求 可能 返 回数 以千 计 的 结 果 .而 且 有 一 大 部 分 是 与 检 索 主题 无关 的链 接 . 需要 用 户 在这 个 基 础 上 再一 次进 行 筛 选 , 增 加 了 用 户 的上 网时 间 与 处 理 效 率 。 因而 . 建立 新 一 代 的 网络 信 息个 性 化 检索 系统 是 人 们 所 期 待 的

提 供 域 名检 索 、 闻 搜 索 等 检 索服 务 。 度 另一 个 相 当 有 特 色 的 新 百

功能是能够 根据用户的检索结果 , 自动 地生成一份 关键词表 . 用 网络信息个性化检索系统实现个性化检索服务 .关键是进 户 可 以 借此 选 择 自己所 需 或 不 需 要 的关 键 词 . 以此 来 提 高 检 索

基于改进用户浏览行为个性化搜索引擎系统研究

基于改进用户浏览行为个性化搜索引擎系统研究摘要:提出了一种改进用户浏览行为的用户兴趣模型,该模型综合考虑了用户对页面的浏览行为、用户的长期兴趣和短期兴趣。

将这种改进的用户兴趣模型应用于个性化搜索引擎系统中,详述了系统的基本框架、系统基本功能模块,开发了一个演示系统IUBPSES。

模拟实验显示:利用该改进用户兴趣模型的搜索引擎系统进行关键词搜索,其搜索效果优于当前主流搜索引擎系统。

最后,指出了需要改进和进一步研究方向。

关键词:用户浏览行为;个性化服务;搜索引擎;用户兴趣模型;IUBPSES系统0引言用户兴趣模型是存储用户的兴趣偏好、存储和管理用户的行为历史、存储学习用户行为的知识和进行相关推导知识的功能集合<sup>[1]</sup>。

近年来学者对个性化搜索引擎系统中的用户兴趣模型进行了广泛深入的研究,林国<sup>[2]</sup>分析了现有用户兴趣模型的不足,指出了用户兴趣模型的基本结构,提出了个性化搜索引擎中用户兴趣模型的工作过程。

刘东飞<sup>[3]</sup>提出了一种基于群用户兴趣模型的加权全局相关度查询排序算法,改进了搜索引擎的排序结果,为用户提供了较准确的搜索服务。

王微微<sup>[4]</sup>提出了一种基于用户行为的兴趣度模型,分析了用户的行为模式,结合用户的浏览内容发现用户兴趣。

刘文杏<sup>[5]</sup>根据用户的兴趣和喜好提出了一种挖掘用户兴趣的路径浏览模型和算法,使Web 服务器能更快地反馈信息,能够为用户提供更好的信息服务。

郝水龙<sup>[6]</sup>提出一种基于层次向量空间模型(VSM)的用户兴趣模型表示及更新处理机制,采用基于用户浏览行为来计算用户对网页的兴趣度,快速估计网页兴趣度。

郭力军<sup>[7]</sup>改进了基于RSS数据源的用户兴趣模型,模拟实验表明该改进的用户兴趣模型个性化程度较高,对用户兴趣更新及时、准确。

个性化搜索引擎技术研究

个性化搜索引擎技术研究摘要:个性化搜索引擎是一种用户驱动网页排名结果的优化方式。

基于本体和语义网,用户建模可以作出准确的查询结果,它包括:限定搜索方式、过滤搜索结果,以及成为搜索过程等3种方式。

因此,个性化搜索引擎用户模型可被视为用户驱动个性化搜索服务的模型。

研究结论是整合前人研究并且提出“用户行为(用户兴趣、用户偏好、用户查询记录)-用户文档(用户行为与关键词组)-用户建模(相关性算法与排名算法)-个性化服务”的新模型,可作为数字图书馆发展个性化搜索引擎的指引。

关键词:信息检索;信息搜索;信息搜寻行为; 用户参与;个性化数字图书馆1 技术:优化搜索引擎的方法1.1 用户建模限定搜索方式一个简单(或直接的)实现个性化搜索引擎的方式,就是在用户搜索之前,预设它们的用户兴趣(interest)或用户偏好(preferences)。

当用户登入系统后,系统在用户先前所指定的主题领域内,或者文献类型内,或者文献/网页发布时间内等,有范围地进行检索。

这是一般数字图书馆信息检索系统所采用的个性化系统模式。

目前,这种方式在个性化搜索引擎系统中的应用不多,但是具有两个重要趋势,值得数字图书馆参考。

(1)整合用户兴趣的表单、用户偏好的设定以及网页排名算法,进行个性化搜索服务。

具体技术线路为:结合经典的平面排名名单和搜索引擎,让用户通过选择具有层次结构的文件夹标签(主题),以交互方式查询,在浏览过程中进行知识提取、查询优化和搜索结果个性化。

这种服务模式与个性化数字图书馆相似,但是更着重用户在浏览过程中的二次查询、根据结果进一步查询,以及结合其它情报分析系统的辅助查询等设计。

可说是个性化数字图书馆的进化版本。

(2)从用户行为中,建立用户文档,将用户文档与领域本体(关键词组的关联设定)结合,进行个性化搜索服务。

具体技术线路为:分析用户的点击记录、估计用户兴趣建立本体、利用本体替代用户当前查询的词汇。

当计算用户兴趣以优化查询过程时,需要能够有效地识别用户喜好以及为每个用户建立一个配置文件,一旦这样的配置文件是可用的,还需要在众多查询相匹配方案中确定用户兴趣集。

个性化元搜索引擎模型的研究与设计

Re e r h a d De i n o r o a i e e a s a c g ne M o l s a c n s g fPe s n lz d M t - e r h En i de

L nj n ,D N uh i U A - ag O G X —u i

mea s a c n i eOl h n omain c l cin a d p o e sn r c s .T ep ro aie t— e rh e gn a e ti p l t—e r h e gn i t e if r t ol t n r c s i g p o e s h es n l d mea s ac n i e h s ac r n a p i o e o z a —

( eat et f o ue S i c n fr ai , uzo nvr t, uyn 50 5 C ia D pr n o C mpt c neadh om t n G i uU i sy G i g 0 2 , hn ) m r e o h ei a 5

Absr c : ih p o l Sc ni ual n r a i g d ma d fs a c f ce c n mp o ig qu lt frqu rm e t t a t W t e pe’ o tn ly ic e sn e n so e r h e in y a d i r vn aiyo e ie ns,t e ta ii — i h r d t on a e r h e g n s h v ee u a l O i e o e’ e . To s h, ti p o l , t s pa e nr du e t —e r h e g n ls a c n i e a e b n n b e t ne tpe pl S ne ds o e hs r bem hi p ri to c s me a s a c n i e tc noo a e s aiain tc noo y,a d t o bn in o h wo fc s son te p ro al e n t s ac n i e mo l e h l ̄ nd p ron lz to e h l g n hec m iat fte t o u e h e s n i d lea—e r h e g n de , o z ic u i e s n lz d mea s a c ngn v r l s se a c ie t r u e n ee tmo la d t a i tu t r o e s n lt n l dng p ro a ie t— e r h e ie o e al y t m r h tc u e, s r it rs de n he b sc sr c u e fp ro a i y

基于行为模式进行网络搜索信息过滤

・

CnNw e noea o c hae c ogsnPd t i T h li d rus

信 息 技 术

基Байду номын сангаас行 为模 式进 行 网络搜索信 息过滤

贺 维 。 刘 彬 田 学志

(、 1 黑龙 江 农业 工程 职 业 学院 , 黑龙 江 哈 尔滨 10 0 2 泰 山学 院 , 东 泰安 2 10 ) 5 00 、 山 70 0

摘 要 : 网络信 息搜 索过 程 中会 经 常 出现 大量垃圾 信 息, 在 这些 垃圾 信 息 , 高 了用户查 询 有效信 息的 难度 , 费 了用户查 询有 效信 提 浪 息 的时 间。本 文提 出一种 利 用行 为模 式识别技 术 , 网络搜 索引擎获得 信息 结果进 行过 滤 的方 式 , 对 通过 这种 方 式来提 高 网络 搜 索信

息 的准确 率。 关键 词 : 网络搜 索 ; 息过 滤 ; 为模 式 信 行

要是针对相关 WE 信 息的数据挖掘 。 B 主要包含 建立模型需要解 决的关键问题 : 随着互联 网普及 ,网络搜 索成为一种最快 WE B内容 挖掘 , B结 构挖 掘 , B用法 挖 WE WE 垃圾信息的收集是 否全 面 , 能否采集到准 捷、 最有效的信息获得 手段 , 用户可 以通过登 录 掘 。 确, 真实的数据来是研究基础 ; 垃圾信 息中得到 WE B内容挖掘 :针对垃圾 信息 WE B的内 的数据适应性 ,是否能对这一类垃圾 信息真实 网络搜索平台 ,键入查询 关键字搜索 和收集需 数据 、 发现共 同信 息 , 资源查询 角度 全 面反应 ; 文梢 从 对垃圾信息的行为模 式进 行数据挖 要 的信息。 在享受 网络搜索技术便利的 同时 , 搜 容 、 掘时采用 的算法 ;提取垃圾信 息各种行 为中的 索结果 中的大量垃圾信 息也给用 户带来 极大的 挖掘非结构化 的文档 。 不便 ,用户经常需 要大量点击搜索结果来获得 WE B结构挖掘 : b We 结构挖 掘的对象是垃 主要元素 的方法 ;对垃圾信息的行为模 式特征 有效信息Ⅲ 。 圾信 息 WE B的超连接 ,即对 We 文档 的结 构 的分析 , b 产生垃圾信 息 过滤的规则集。 利用行为模式技术 , 搜索平 台通过对垃圾 进行 挖掘 :对于给定 的 we 文档集合 , 能 b 应该 3信息过滤系统 信息统计出的不 同行为特征 ,对搜索结果信息 够通过 算法发 现他 们之 间连接 情况 的有 用信 如图 1 所示 , 为信息过滤系统结构图 , 在原 进行过滤 , 强信息搜索的准确率 。 来增 息, 文档之间 的超连接反映 了文档之问 的包 含 、 有的网络搜索引擎系统中 , 通过将文本索引 中 1网络搜索引擎技术 引用或者从属关系 ,引用文档对被引用文卡 的 包含的索引信息发送给过滤服务器 , 当 通过索引 1 搜索器 . 1 说 明往往更客观 、 更概括 、 更准确 。 信息中链 接查询相关 WE , B 分析该 WE B的行 衡量搜索引擎 的一条很重要 的标准 ,就是 WE 用法挖掘 : b B We 使用记 录挖掘 ,对垃 为特征 ,与垃圾信息行为特征库 中不 同类型 的 搜索到信 息的海量性。 了实现这一 条标准 , 为 通 圾信息 wE 使 用记录数据 除 了服务器 的 日志 垃圾 信 息的行为特征进行 比较 ,清理掉被判定 B 常需要一种强大的搜索器作为支撑 , 一般称 为 记录外还包括代理服务器 日志 、 浏览器端 日志 、 为垃圾信 息的搜索结果信息 ,将正常行为信息 为“ 网络蜘蛛” 。 注册信息 、用户会话 信息 、ok 中的信息 、 Coi e 用 存 人索引数据库。 “ 网络蜘蛛” we p e, 即 bSi r d 是通 过 网页 的 户查询 、鼠标 点击流等一切 用户与站点之间可 链接地址来寻找网页 , 网站 的某一个 页面开 能的交互 记录。 从 来发现用户访 问 We 页面的模 b 始, 读取网页的内容 , 找到在网页 中的其它链接 式 , 分析垃圾信息 WE B的规 律。 地址 , 然后通过这些链接地址寻找下一个 网页 , 23主元分析 . 这样循环下 去 , 直到把这个网站所有的 网页都 它是一种对数据 进行分 析的技 术 , 最重要 抓取完为止 。 在抓取 网页的时候 , “ 网络蜘蛛 ” 一 的应用是 对原 有数 据进 行简 化 。正 如它 的 名 般有两种策略深度优先 、 广度优先 。 通过 内容提 字—— 主元分 析 , 这种方法可 以有效 的找 出数 取技术获取网页上文本信息目 。 据 中最 “ 主要 ” 的元素和结构 , 去除噪音 和冗余 , 1 . 2搜索结果中垃圾信息 将原有 的复杂数据降维 ,揭示隐藏在复杂数据 在用 户通过 定义 的关键 字实 施信 息搜 索 背后的简单结构 。 它的优 是简单 , 而且无参数 时, 经常会获得大量的搜索结果 , 从这些 海量信 限制 , 以方便的应用 与各 个场合目 可 。利用 主元 息 中提取有效信息经常会 浪费用户 大量 的时问 分析技术对于垃圾信息的不同行为模式 , 用 利 回收站 和精力。 对于用户来说 , 没有利用价值的信息可 应用线形代数知识进行科学求解 , 大程 度去 最 以认为是无效搜索信息 , 而在这其 中还存在很 掉冗余和十扰 , 找到垃圾信息 的主要行为模 式。 图 1信 息 过 滤 系统 大一部分由于某些 网站为增加点击率而故 意篡 2 . 4基于行为模式 的垃圾过滤模型 其 中, 过滤服务器需要完成 4 方面的工作 , 改信息产生 的垃圾信息。 通过行为模式识别技术对 网络搜 索结果 中 包括信息采样 、 行为解析 、 特征 比较 、 信息过滤。 搜索 引擎 Ik m 认为是垃圾 信息的主要 的垃圾 信息进 行过滤 , nt i o 其思想是对大量垃圾 信 信息采样 : 提取文本索 引中 的信 息 , 包括链 接 , 内容为 : 隐藏 的 、 欺骗性 的 、 以及 与网页 内容不 息样本进行分析 , 建立垃圾信 息行为特征模 型 , 文本 信 息 等信 息。 行为解析 : 同信息进行分 对不 相关 的文字 ; T ME A标签 中的 内容并 非 网页内 利 用这个 特征模 型 对搜索 的结 果信 息进 行分 析 , 提取主要行 为特征 。 征比较 : 同 WE 特 将不 B 容的真实描述 ;没有明确的 目的有意设 计重新 析 、 , 判断 过滤其中的垃圾信息。整个垃圾信息 中信息的行 为特征 与垃圾信 息的行 为特征进行 指向的 U L R ;利用程序使得在搜索结果中出现 过滤模型 ,基于信 息 —— 知识——智能理论指 比较 。 信息过滤 : 过滤到与垃圾信息的行 为特征 大量 同样 的网页 ; 有意设置让人 误解 的链接 ; 并 导,采用数据挖掘方法提取垃圾信息的行为规 相同的信 息。 不反 映网站真实 内容的入门网页或者隐藏的网 则 , 而建立垃圾信息过滤模 型。 从 信息表示事物 4信 息 过滤系统的托 页; 自动产生大量无关的垃圾链接 。 状态变化方式 , 知识表示事 物状态变化规律 , 智 提高搜索的准确性 :由于垃圾信息和正常 2行为模 式识别技术实施 信息过滤 能表示根据已知事物变化规律指定对未知事物 信息在特征上存在很多差别 , 利用行 为模 式识 2 行为模 式识别技术 l 检测的规则 。 别技 术实 现信息 过滤 可提 高信息 搜 索的准 确 行为模式是从大量实 际行为 中概括 出米作 智能模型建立步骤 : 性 。系统部署方便 : 于文本 索引中的信息 , 对 进 为行为的理论抽象 、 基本框架或标准口 。行为模 首先大量收集不同搜 索结 果中包 含的垃圾 行信 息过滤 , 改变原有 网络搜 索引擎结构 , 不 相 式识别技术 的思想是通过基 于对大量信息样本 信息; 根据 Ik m 对垃圾 信息定 义对搜 索的信 对独立 , nt i o 易于升级维护。搜索结 果相 对公平 : 由 进行的统计 、 分析和计算 , 建立行为模式数学模 息进 行分类 整理 , 并进行垃圾信息预处理 , 过 于过滤系统相对独立 ,可由第三方 开发商 设计 通 型, 利用这种具有极高行为特征的模型 , 对新的 数 据格式 和内容调整使数 据更符合数据挖掘 的 指定 , 避免 网络搜索 提供商 出于 自 身利益 等考 信息进行分析判定H 。 需要 ;根据数据挖掘算法对垃圾信息行为模式 虑而为媚户 提供 的搜索结果 。节省用户信息搜 2 . 2数据挖掘 进行挖掘 ; 利用主元分析理论 , 对垃圾 信息的行 索时间 : 由于垃圾信息减少 , 节省 了用户需要大 数据挖掘就是从海量的数据 中挖掘出可能 为特 进行计算分析 ,找到数据 中最主要的元 量打开不同链接查询信息 的时间 。先进的过滤 有潜在价值 的信 息的技术 。这些信息是可能有 素 和结构 ;将垃圾信息的主要行为进行知 识表 技 术 : 传统采用 内容关键字过滤时 , 由于某些网 �

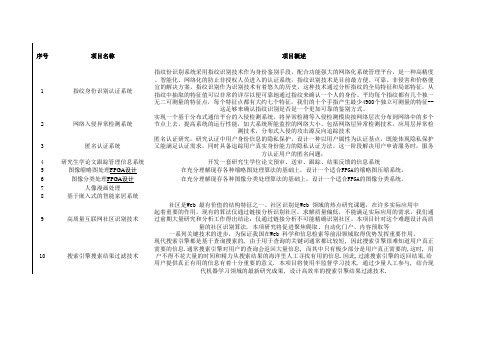

大学生软件创新项目

序号项目名称项目概述1指纹身份识别认证系统指纹份识别系统采用指纹识别技术作为身份鉴别手段,配合功能强大的网络化系统管理平台,是一种高精度、智能化、网络化的防止非授权人员进入的认证系统,指纹识别技术是目前最方便、可靠、非侵害和价格便宜的解决方案。

指纹识别作为识别技术有着悠久的历史,这种技术通过分析指纹的全局特征和局部特征,从指纹中抽取的特征值可以非常的详尽以便可靠地通过指纹来确认一个人的身份。

平均每个指纹都有几个独一无二可测量的特征点,每个特征点都有大约七个特征,我们的十个手指产生最少4900个独立可测量的特征--这足够来确认指纹识别是否是一个更加可靠的鉴别方式。

2网络入侵异常检测系统实现一个基于分布式通信平台的入侵检测系统,将异常检测等入侵检测模块按网络层次分布到网络中的多个节点上去,提高系统的运行性能,加大系统所能监控的网络大小。

包括网络层异常检测技术,应用层异常检测技术,分布式入侵的攻击源反向追踪技术3匿名认证系统匿名认证研究,研究认证中用户身份信息的隐私保护,设计一种以用户属性为认证基点,既能体现隐私保护又能满足认证需求,同时具备追踪用户真实身份能力的隐私认证方法。

这一阶段解决用户申请服务时,服务方认证用户的匿名问题;4研究生学论文跟踪管理信息系统开发一套研究生学位论文预审、送审、跟踪、结果反馈的信息系统5图像缩略图处理FPGA设计在充分理解现存各种缩略图处理算法的基础上,设计一个适合FPGA的缩略图压缩系统。

6图像分类处理FPGA设计在充分理解现存各种图像分类处理算法的基础上,设计一个适合FPGA的图像分类系统。

7人像漫画处理8基于嵌入式的智能家居系统9高质量互联网社区识别技术社区是Web 最有价值的结构特征之一。

社区识别是Web 领域的热点研究课题,在许多实际应用中起着重要的作用。

现有的算法仅通过链接分析识别社区,求解质量偏低,不能满足实际应用的需求。

我们通过前期大量研究和分析工作得出结论:仅通过链接分析不可能精确识别社区。

改进的基于布尔模型的网页查重算法

计数法的检测算法, 增加向量维数并不能降低错误率。改进属

性 计 数 法 的 措施 就 是 加 入 程序 的结 构 信 息 , 合 结 构度 量 结

( t c r tc ) 也称 为控 制流 ( ot l o 来检 测剽 窃 。 S ut eMe is , r u r C n o— w) r f l

维普资讯

・

3 6・

计算机应用研究

20 07正

ቤተ መጻሕፍቲ ባይዱ

改进 的基 于布尔模型 的网页查重算 法

连 浩 , 刘 悦 许洪波 程学旗 , ,

( .中国科学院 计算技术研究所 , 1 北京 108 ; .中国科学院 研究生院 信息学院, 000 2 北京 104 ) 009

例, 据可靠估 计 , 其增 长 速度可 以达 到每六 个 月 翻一 番 ,04 20

年年底, 最大的搜索引擎可以索引到的 We b网页的数 目大概

为 8 亿 一 0 , 还只是 We 数据 的一 小部 分。 0 1 0亿 这 b 微软 曾作 过 一个 试验 , 网 络 中下载 了 1 000 网 从 50 个 00 0 页, 下载这些 网页耗费 了 1 周的 时间。实验发 现这些 网页中 1 有 2.%是相似 网页 , 且这些 相似 网页 中还 有 2.%是 完 92 而 22 全重复 的( 一字不差 )另外相似 网页十分稳 定地存在 , 相 ; 一对 似的 网页在 1 O个星期 以后极有可能还是相似 的网页。从该实 验可 以看 出 , 中存 在大量 的相似 网页 , 网络 它们 降低 了网页采 集器 的工作效 率 , 了一些数据 挖掘 工具 的资源 , 浪费 使用 户 的 工作效率 下降 , 如何能够尽 可能准确地去除这些重复 的网页就 是我们所 面临的问题 。

基于ASP.NET搜索引擎模型的实现

Ab t a t W i h a td v lp n f I t r c e h oo y e r h e g n s b c me o e o o n n e c a iain tos sr c : t t e fs e eo me to n e ttc n lg ,s ac n ie e o n f i  ̄a tI tr tn vg t o l. h a mp a o Wh l e s a c n i e o e a e n to e e O w dd i t e r h e g n s c d o p n d t o ,whc s n tg o o e p e t t d . I h s p p r n o e — o e eh r ih i o o d f rp o l o su y n t i a e ,a p n c d d

个原型基础。

关键 词 : 索引擎模型 ; 索信 息 ;索引保存 ;A P N T; # 搜 检 S.E c

中 图 分 类 号 :P9 T 33 文献标识码 : A d i 1 .99 ji n 10 - 7 .0 11 .5 o : 03 6 /. s.0 62 5 2 1 . 10 1 s 4

网络 机器 人 ( oo) 序 自动进 行 的 。网络机 器人 程 R bt程 序又 称 sie、r l 、om 等 , 核 心 目的是 为获 取 pdrca e w r w r 其

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

2011年1O月 第3O卷第5期 重庆文理学院学报(自然科学版)

Journal of Chongqing University of Arts and Sciences(Natural Science Edition) 0ct..2011

V01.30 No.5

搜索引擎垃圾网页检测模型研究 贾志洋 ,夏幼明 ,高 炜 ,王勇刚 (1.云南大学旅游文化学院,云南丽江674100;2.云南师范大学信息学院,云南 昆明650092)

[摘要]搜索引擎垃圾网页的检测已经成为近年来机器学习领域的研究热点.在对搜索引擎 垃圾网页及其使用的各种作弊技术进行介绍的基础上,针对各种垃圾网页检测模型进行综述, 分别介绍和分析基于网页内容特征的检测模型、基于链接结构的检测模型、结合网页内容特征 和链接特征的检测模型以及各种其它类型的检测模型,并对搜索引擎垃圾网页检测的未来研 究方向进行了展望. [关键词]搜索引擎;垃圾网页;垃圾网页检测;反作弊 [中图分类号]TP393.083 [文献标志码]A [文章编号]1673—8012(2011)05—0053—05

随着互联网各种网页数量爆炸式增长,用户 使用搜索引擎查找信息已经成为了最近几年信 息检索的主要方式.大多数网站管理者都希望他 们的网站在搜索引擎的搜索结果中排名靠前,很 多的网站管理者会采取合理的搜索引擎优化技 术(SEO) 11,通过在网页中提供给用户更多、更 有效的信息,以提升他们的网站在搜索引擎的搜 索结果中的排名.而有些网站则通过一些“不道 德”的方式来提升在搜索引擎的搜索结果中的排 名.更有甚者,为了吸引访问量,手动或自动地制 造一些网页.这些网页没有提供给用户任何有效 信息.这些网页是直接针对搜索引擎的,但是在 搜索引擎的搜索结果中获得了很高的排名,当用 户查询某些关键词的时候,就有可能访问这些搜 索引擎垃圾网页(Web Spare) . 搜索引擎垃圾网页导致的主要后果为:搜索 引擎检索结果质量下降,搜索引擎公司的资源的 消耗和用户体验的降低.为解决数量日益增长的 垃圾网页产生的各种问题,国内外学者对垃圾网 页及垃圾网页检测都进行了深人的研究.为方便 各国学者进行对比研究,Castillo C.等 组织志愿 者收集整理了WEBSPAM—Ul<2006垃圾网页集. WEBSPAM—UK2006于2006年5月开始,收集了 150 000个UK域名下的总计77 900 000个网页, 其中的垃圾网页都由志愿者手工挑选出,提供给 相关实验研究免费使用.大量的学者都使用WEB— SPAM—UK2006作为其实验样本集.

1 垃圾网页常见检测模型 国内外的学者提出了各种基于机器学习的 垃圾网页检测模型.大多数基于机器学习的垃圾 网页检测模型都将垃圾网页的检测视为一个二 元分类问题.它首先需要学习一个网页分类器, 这个网页分类器可以预测网页的类别:正常网页 或垃圾网页.其分类原理为:首先模拟搜索引擎 的网络爬虫从Web爬行一定数量的网页,然后 手工识别已下载的网页是否为垃圾网页.下载的 网页集被划分为训练网页集和测试网页集,根据 机器学习的算法,使用训练网页集学习分类器, 然后使用分类器对测试网页集中的每一个网页 进行分类预测,以测试分类器的分类效果 . 1.1 基于内容的垃圾网页检测模型 基于网页内容特征分析的垃圾网页检测模 型主要针对采用了关键词堆砌技术的垃圾网页, 其典型为Alexandros Ntoulas等 设计的垃圾网 页检测模型.Alexandros Ntoulas等根据正常网页 和垃圾网页的内容差别,对网页的内容特征进行 了提取,统计了数据集中网页的语言相关和语言

[收稿日期]2011—05—07 [基金项目]国家自然科学基金项目(60903131);云南省教育厅科学研究基金项目(2010Y108) [作者简介]贾志洋(1980一),男,吉林市人,讲师,硕士,主要从事信息检索方面的研究. 53 无关的各种内容特征,并根据统计结果分析可以 作为构建网页分类器的内容特征.为了检测网页 中是否采用了关键词堆砌等作弊技术,Alexan— dros Ntoulas等将数据集中的网页压缩并计算其 被压缩前后所占空间大小的比值,这个比值被称 为网页压缩率(Compression ratio)Ls J,并计算了 数据集中每个网页的压缩率,统计得出网页压缩 率的分布如图1 .从图l中可以观察到,网页 压缩率的分布服从正态分布,在2.0位置达到最 高点,在压缩率大于4.0时,网页是垃圾网页的 可能性大于70%,故网页压缩率为判定网页是否 作弊的一个较好的特征.除了网页压缩率特征 外,Alexandros Ntoulas等还统计分析了网页单词 数量、标题单词数量、单词平均长度、链接数量、 可视文本率、常用词出现率、n—gram相似度、网 页URL长度等内容特征.根据提取的网页内容 特征,然后将垃圾网页的检测看成一个二元分类 问题,基于C4.5决策树算法通过训练网页集学 习一个分类器,对测试网页集的网页的类别进行 预测.由于忽略了网页之间的链接关系,这种基 于网页内容的垃圾网页检测模型在检测关键词 堆砌类型的垃圾网页时具有较好的效果,而对链 接堆砌类型的垃圾网页检测效果则不佳,故此基 于内容特征的垃圾网页检测模型的准确率有限. 图1 网页压缩率的分布与垃圾网页 1.2基于链接结构的垃圾网页检测模型 大多数垃圾网页都采用了链接堆砌技术以 提高其在搜索结果中的排名.基于链接结构的垃 圾网页检测模型可以有效地检测此类垃圾网页. 这类垃圾网页检测模型都基于某一个假设:正常 网页只指向(被指向)正常网页或垃圾网页指向 (被指向)垃圾网页.这类算法的原理都很类似, 都是可信度(不可信度)传播算法,从一个已经 54 标定为可信(垃圾)网页的集合开始(种子网页 集),通过可信度或不可信度传播的原则对所有 的网页节点进行可信度和不可信度的计算,其中 经典模型为可信度正向传播的TmstRank算 法 . 1.2.1 TmstRank检测模型 TrustRank模型是PageRank" 算法的一个变 形,区别在于TrustRank算法从种子集合起始向 其他网页传播可信度,而PageRank算法在全局 根据链接信息进行PageRank值的计算.Trus— tRank算法的前提假设是:“可信网页的链接所 指向的网页通常也是可信网页”。。 .TmstRank算 法分为两个步骤: 第一步,它根据逆向PageRank计算的数值 向量,对所有节点进行从高到低的排序,挑选出 一定数量的PR值较高的网页节点,形成种子集 合,通过专家评测这些种子网页节点,把他们标 记为垃圾网页(spam)和可信网页(reputable).经 过人工评测后的种子集合才可以作为真正的种 子集合被TrustRank所使用.所有选出的种子节 点在评测后形成向量d,如公式(1) 所示. d㈩:f ,if pag 。Pu bl , (1) 【O.ifpage i is spam 第二步,为了利用PageRank的算法传播信 任值,需要对d进行归~化操作,如公式(2) 所示. d=d/l d I. (2) 然后将d替换为均一向量f ,利用同样的算 法进行迭代计算,直至算法收敛,TrustRank的计 算公式为。。 : t=(1一 )×T×t+ ×d. (3) 公式(3)中,t是TrustRank值向量,d偏向于 在种子集中的可信网页,而在PageRank算法中 随机跳转的向量元素皆为1/N.因为在网络中普 通的链接并不都具有可信任性,而TrustRank中 评测的可信网页所发出的链接常具有可信任性, 进而比PageRank算法更加的可靠,因为它利用 了人工评测的可信信息,并将这些信息通过链接 结构进行传播.与PankRank算法类似,TrustRank 的可信度进行可信度传播时采取了衰减和分裂 策略,即距离种子网页越远(从链接的层次考 虑),其从种子网页获取到的可信度就越小.假如 一个网页从种子网页集中的一个网页的出链接 获取到可信度IB,那么这个网页的出链接指向的 网页可以从这个网页获取到可信度为卢X ,这 种策略称之为可信度衰减(Trust dampening)。。 . 假如一个可信网页只有一个出链接,那么这个链 接指向的网页应具有较高的可信度;相反,如果

一个可信网页具有上百个出链接,那么这些链接 中的某一个就可能指向垃圾网页.这是基于这样

一个假设:“TrustRank算法在网页的可信度进行 传播的时候将自身的可信度分裂(Trust splitting). ” TrustRank可以有效地区分垃圾网页和可信 网页,因为它使用了人工评测的信息(种子网页 集),这些信息不容易被垃圾网页(制造者)所影 响.因此同PageRank相比,TrustRank通过种子 集合和链接结构能够赋予可信网页较高的Trus- tRank值,而给作弊节点较低的TrustRank值,从 而有效地检测作弊行为.但是TrustRank所依赖 的种子集合的质量和数量会对它的算法性能产 生影响.首先,如果种子网页集合的可信网页数 量比较小,或者其中可信网页的比例比较小,根 据TrustRank定义的衰减传播方法,种子网页集 合对于其他网页的影响会较小,因此就失去了 TrustRank算法的传播可信度的意义.此外,如果 种子网页集合只隶属于少数的话题或者领域, TmstRank的排序结果会把没有出现的话题和领 域的网页排名靠后,而提升那些同种子集中相同 话题或领域的网页.再次,如果网页集合中的网 页含有从可信网页到垃圾网页的链接,这样的种 子集合也不适用于做种子网页,因为它们不符合 可信网页指向可信网页的前提.TrustRank算法 的效率会依赖于种子集合的质量和数量,若要较 好地发挥TrustRank算法的垃圾网页检测效果, 就要能保证找到一个合适的种子集合.此外,此 类基于链接结构的迭代算法都具有类似的弱点, 即忽略了网页本身的内容信息,而且会对部分垃 圾网页造成误判.针对以上问题,Baoning Wu 等_8 提出了Topical TrustRank算法,其主要思想 是:首先使用主题信息将种子子集进行分类,然 后针对每个主题单独计算可信度.这一算法克服 了TrustRank的缺点. 1.2.2类TrustRank检测模型 BadRank 与Anti—TrustRank No 3检测模型 十分类似,皆为不可信度的传播算法.以 BadRank为例,BadRank基于这样一个假设:如 果一个网页的一个出链接指向了一个BadRank