特征选择算法综述20160702

特征选择方法综述

控制与决策 2012.2

●问题的提出

●特征选择框架

●基于搜索策略划分特征选择方法

●基于评价准则划分特征选择方法

●结论

一、问题的提出

特征选择是从一组特征中挑选出一些最有效的特征以降低特征空间维数的过程,是模式识别的关键问题之一。对于模式识别系统,一个好的学习样本是训练分类器的关键,样本中是否含有不相关或冗余信息直接影响着分类器的性能。因此研究有效的特征选择方法至关重要。

特征选择算法的目的在于选择全体特征的一个较少特征集合,用以对原始数据进行有效表达按照特征关系度量划分,可分为依赖基尼指数、欧氏距离、信息熵。

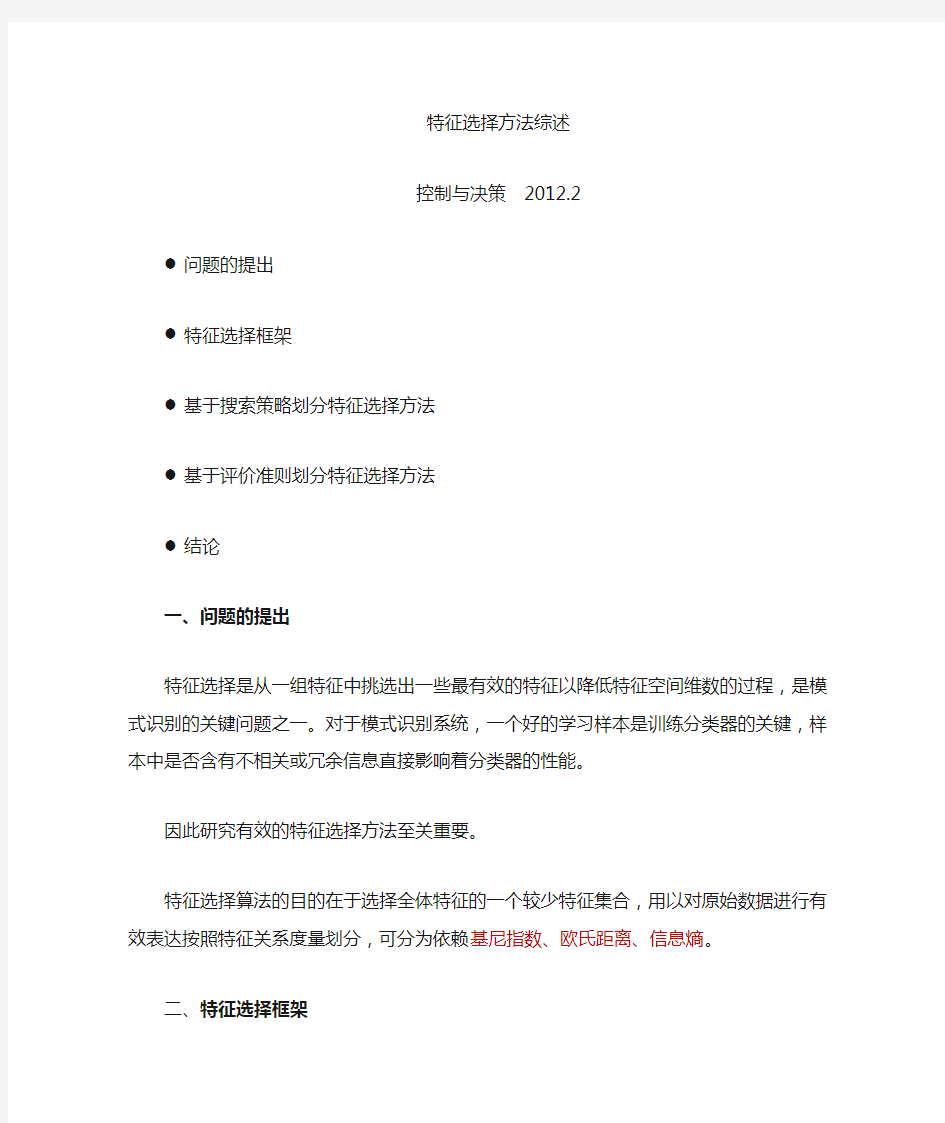

二、特征选择框架

由于子集搜索是一个比较费时的步骤,一些学者基于相关和冗余分析,给出了下面一种特征选择框架,避免了子集搜索,可以高效快速地寻找最优子集。

从特征选择的基本框架看出,特征选择方法中有4个基本步骤:候选特征子集的生成(搜索策略)、评价准则、停止准则和验证方法。目前对特征选择方法的研究主要集中于搜索策略和评价准则。因而,本文从搜索策略和评价准则两个角度对特征选择方法进行分类。

三、基于搜索策略划分特征选择方法

基本的搜索策略按照特征子集的形成过程,形成的特征选择方法如下:

图3基于搜索策略划分特征选择方法

其中,全局搜索如分支定界法,存在问题:

1)很难确定优化特征子集的数目;

2)满足单调性的可分性判据难以设计;

3)处理高维多类问题时,算法的时间复杂度较高。

随机搜索法如模拟退火、遗传算法、禁忌搜索算法等,存在问题:

1)具有较高的不确定性,只有当总循环次数较大时,才可能找到较好的结果。

2)在随机搜索策略中,可能需对一些参数进行设置,参数选择的合适与否对最终结果的好坏起着很大的作用。

启发式搜索如SFS、SBS、SFFS、SFBS等,存在问题:

1)虽然效率高,但是它以牺牲全局最优为代价。

每种搜索策略都有各自的优缺点,在实际应用过程中,根据具体环境和准则函数来寻找一个最佳的平衡点。例如,特征数较少,可采用全局最优搜索策略;若不要求全局最优,但要求计算速度快,可采用启发式策略;若需要高性能的子集,而不介意计算时间,则可采用随机搜索策略。

四、基于评价准则划分特征选择方法

图4基于评价准则划分特征选择方法

(一)考虑单个特征对分类的贡献,特征选择方法依据其与分类器的关系分为:Filter方法、Wrapper方法和Embedded方法3类。

封装式算法作为一种经典的特征选择算法类型采用学习算法进行特征选择,其选择过程复杂耗时,目前多与过滤式特征选择算法结合,辅助特征选择;嵌入式算法则分多步骤采用不同选择方式,算法繁琐,其代表算法是基于稀疏多项式逻辑回归模型理论的SBMLR算法等;过滤式算法不需其他学习算法,主要考察特征间计量关系,方法简单,时间复杂度相对较低,代表算法包括:基于特征权重的Relief F、Fisher、SPEC以及基于互信息的MRMR算法等。

(1)Filter方法:通过分析特征子集内部的信息来衡量特征子集的好坏,不依赖于分类器。Filter实质上属于一种无导师学习算法。

常用:基于特征权重的Relief F、Fisher、SPEC以及基于互信息的MRMR算法

Filter 特征选择方法一般使用评价准则来增强特征与类的相关性,削减特征之间的相关性。将评价函数分成4类:

1)距离度量。距离度量通常也认为是分离性、差异性或者辨识能力的度量。最为常用的一些重要距离测度:欧氏距离、S阶Minkowski测度、Chebychev 距离、平方距离等。

2)信息度量。信息度量通常采用信息增益(IG)或互信息(MI)衡量。

信息增益:有无这个特征对分类问题的影响的大小。

互信息:描述两个随机变量之间相互依存关系的强弱。

泛化的信息度量函数标准:

其中,C:类别;f:候选特征;S:已选特征;g(C,f,S):C,f,S之间的信息量;

?:调控系数;δ:惩罚因子

①BIF (best individual feature)是一种最简单最直接的特征选择方法。

评价函数:

I():互信息降序排序前k个

优缺点:这种方法简单快速,适合于高维数据。没有考虑到所选特征间的相关性,会带来较大的冗余。

②MIFS (mutual information feature selection):互信息特征选择。使用候选特征f与单个已选特征s相关性对f进行惩罚的方法。

β:调节系数。β在[0.5,1]时,算法性能较好。

③mRMR (minimal-redundancy and maximal-relevance)方法。思想:最大化特征子集和类别的相关性,最小化特征之间的冗余。

④ FCBF (fast correlation-based filter)。基于相互关系度量给出的一种算法。对于线性随机变量,用相关系数分析特征与类别、特征间的相互关系。对于非线性随机变量,采用对称不确定性(SU)来度量,对于两个非线性随机变量X 和Y ,它们的相互关系表示为:

H ():信息熵

基本思想:根据所定义的C-相关(特征与类别的相互关系)和F-相关(特征之间的相互关系),从原始特征集合中去除C-相关值小于给定阈值的特征,再对剩余的特征进行冗余分析。

⑤ CMIM (conditional mutual information maximization)。利用条件互信息来评价特征的重要性程度,即在已知已选特征集S 的情况下通过候选特征f 与类别C 的依赖程度来确定 f 的重要性,其中条件互信息)|;(I S f C 值越大,f 能提供的新信息越多。

3)依赖性度量。有许多统计相关系数被用来表达特征相对于类别可分离性间的重要性程度。如:Pearson 相关系数、概率误差、Fisher 分数、先行可判定分析、最小平方回归误差、平方关联系数、t-test 、F-Statistic 等。

Hilbert-Schmidt 依赖性准则(HSIC)可作为一个评价准则度量特征与类别的相关性。核心思想是一个好的特征应该最大化这个相关性。

t:所选特征个数上限;F :特征集合;S :已选特征集合;J(S):评价准则

从式中可知需要解决两个问题:一是评价准则J(S)的选择;二是算法的选择。

4)一致性度量

给定两个样本,若他们特征值均相同,但所属类别不同,则称它们是不一致的;否则,是一致的。试图保留原始特征的辨识能力,找到与全集有同样区分类别能力的最小子集。典型算法有Focus 、LVF 等。

Filter 方法选择合适的准则函数将会得到较好的分类结果。

优点:可以很快地排除很大数量的非关键性的噪声特征,缩小优化特征子集

搜索的规模,计算效率高,通用性好,可用作特征的预筛选器。

缺点:它并不能保证选择出一个优化特征子集,尤其是当特征和分类器息息相关时。因而,即使能找到一个满足条件的优化子集,它的规模也会比较庞大,会包含一些明显的噪声特征。

2)Wrapper法:评价函数是一个分类器,采用特定特征子集对样本集进行分类,根据分类的结果来衡量该特征子集的好坏。Wrapper实质上是一种有导师学习算法。

训练集测试集

优点:准确率高

缺点:1)为选择出性能最好的特征子集,Wrapper算法需要的计算量巨大;

2)该方法所选择的特征子集依赖于具体学习机;

3)容易产生“过适应”问题,推广性能较差

(3)Embedded方法。将特征选择集成在学习机训练过程中,通过优化一个目标函数在训练分类器的过程中实现特征选择。

优点:相对于Wrapper方法,不用将训练数据集分成训练集和测试集两部分,避免了为评估每一个特征子集对学习机所进行的从头开始的训练,可以快速地得到最佳特征子集,是一种高效的特征选择方法。

缺点:构造一个合适的函数优化模型是该方法的难点。

通常,将Filter方法的高效与Wrapper方法的高准确率进行结合,可得到更优的特征子集。混合特征选择过程一般由两个阶段组成:

1)使用Filter方法初步剔除大部分无关或噪声特征,只保留少量特征,从而有效地减小后续搜索过程的规模。

2)将剩余的特征连同样本数据作为输入参数传递给Wrapper选择方法,以进一步优化选择重要的特征。

(二)依据特征之间的联合作用对分类的贡献,分为:CFS(Correltion based Feature Selector)、CFSPabs(CFS based on the absolute of Perons’s correlation coefficient)、DFS(Discernibility of Feature Subset s)。

(1)CFS:基于关联特征的特征选择。CFS计算整个特征子集的类间区分能力实现特征选择,使得被选特征子集中的特征之间尽可能不相关,而与类标高度相关。

Ms:度量了包含k个特征的特征子集S的类别辨识能力。

:特征f(f )与类别C的相关系数的均值

:特征之间相关系数的均值

分子:特征子集S的类预测能力

分母:特征子集S中特征的冗余程度

适合于二分类

(2)CFSPabs:基于皮尔森相关系数的绝对值的相关特征选择。

(3)DFS:特征子集区分度量。

:当前i个特征的特征子集在整个数据集上的均值向量

:当前i个特征的特征子集在第j类数据集上的均值向量

:第j类中第k个样本对应当前i 个特征的特征值向量

分子:l个类别中各类别对应包含当前i个特征的特征子集的样本中心向量与整个样本集对应当前i个特征的中心向量的距离平方和,其值越大,类间越疏。

分母:各个类别对应包含当前i个特征的特征子集的类内方差。方差越小,类内越聚

五、结论

现有特征选择研究主要着眼于选择最优特征子集所需要的两个主要步骤:特征子集搜索策略和特征子集性能评价准则。将Filter方法和Wrapper方法两者结合,根据特定的环境选择所需要的度量准则和分类器是一个值得研究的方向。

特征选择方法在建模中的应用

特征选择方法在建模中的应用 ——以CHAID树模型为例 华东师范大学邝春伟

特征选择是指从高维特征集合中根据某种评估标准选择输出性能最优的特征子集,其目的是寻求保持数据集感兴趣特性的低维数据集合,通过低维数据的分析来获得相应的高维数据特性,从而达到简化分析、获取数据有效特征以及可视化数据的目标。 目前,许多机构的数据均已超载,因此简化和加快建模过程是特征选择的根本优势。通过将注意力迅速集中到最重要的字段(变量)上,可以降低所需的计算量,并且可以方便地找到因某种原因被忽略的小而重要的关系,最终获得更简单、精确和易于解释的模型。通过减少模型中的字段数量,可以减少评分时间以及未来迭代中所收集的数据量。 减少字段数量特别有利于Logistic 回归这样的模型。

SPSS Modeler是一个非常优秀的数据挖掘软件。它的前身是SPSS Clementine及PASW Modeler。该软件 的特征选择节点有助于识别用于预测特定结果的最重要的字段。特征选择节点可对成百乃至上千个预测变量进行筛选、排序,并选择出可能是最重要的预测变量。最后,会生成一个执行地更快且更加有效的模型—此模型使用较少的预测变量,执行地更快且更易于理解。 案例中使用的数据为“上海高中生家庭教育的调查”,包含有关该CY二中的304名学生参与环保活动的信息。 该数据包含几十个的字段(变量),其中有学生年龄、性别、家庭收入、身体状况情况等统计量。其中有一个“目标”字段,显示学生是否参加过环保活动。我们想利用这些数据来预测哪些学生最可能在将来参加环保活动。

案例关注的是学生参与环保活动的情况,并将其作为目标。案例使用CHAID树构建节点来开发模型,用以说明最有可能参与环保活动的学生。其中对以下两种方法作了对比: ?不使用特征选择。数据集中的所有预测变量字段 均可用作CHAID 树的输入。 ?使用特征选择。使用特征选择节点选择最佳的4 个预测变量。然后将其输入到CHAID 树中。 通过比较两个生成的树模型,可以看到特征选择如何产生有效的结果。

个人研究综述

个人研究综述 我的研究过程:首先确定了我的研究课题,我校学生睡眠情况的调查研究。因为在我每天的上课中,总有许多同学在课堂上睡觉,打瞌睡。导致上课注意力不集中,听课效率下降,最终导致学习成绩的下降。为此,我决定对我校学生的睡眠情况进行调查研究。我知道,睡眠对于大脑健康是极为重要的。人一般需要有8个小时以上的睡眠时间,并且必须保证高质量。如果睡眠的时间不足或质量不高,那么对大脑就会产生不良的影响,大脑的疲劳就难以恢复,严重的可能影响大脑的功能。如果睡眠不足或睡眠质量差,就应适当增加睡眠的时间,并且要设法改善睡眠状况等。使学生们明白睡眠的重要性,调整作息时间,保持身体健学生正处于生理发育的高峰期,为满足生理需求,一天的睡眠时间应为9~10小时.如果睡眠不足,不仅疲劳得不到缓解,还会影响到第二天的大脑运行工作,适得其反,反而降低了学习效率.此外,熬夜还会导致精神恍惚,情绪低落,在心理上造成不良影响.专家建议:学生最佳就寝时间为21:00~22:00,这段时间内人体生长激素分泌最旺盛按照一般的观点,睡眠是消除大脑疲劳的主要方式。如果长期睡眠不足或睡眠质量太差,就会严重影响大脑的机能,本来是很聪明的人也会变得糊涂起来。很多人患上了神经衰弱等疾病,很多时候就是因为严重睡眠不足引发的。 总之,一个人的一生,有三分之一多的时间是在睡眠中度过的。政党的良好睡眠,可调节生理机能,维持神经系统的平衡,是生命中重要的一环。睡眠不良、不足,第二天就会头痛脑胀、全身无力。睡

眠与健康工作和学习的关系甚为密切。我采用调查问卷的方法调查了361名学生行课和休息期间,各年级同学的睡眠时间和睡眠质量,调查研究睡眠情况对学生学习,生活的影响。因为在长时间的教学过程中,我对我对同学们的作息规律做出的不可磨灭的贡献有了一个初步了解。并渴望进行一次更深入的调查。在我全票通过后,我开始忙碌。查找资料总结整理收获。我主要采用查阅资料和问卷调查的形式,我基本得出了一些结论。首先是目前我校学生睡眠不足已经成了普遍现象。根据所调查的资料来看,而结果显示80%以上的同学没有足够的睡眠时间,其中71.5%的同学睡眠时间远远低于合理的睡眠时间8小时,以至于87%的同学对现在的睡眠不满意,即便有70%的同学有午睡的习惯,但仍有近86%下午上课精神不佳。 根据调查结果我得出以下几点结论: (一).影响睡眠的因素 1.学习负担太重 2.人际交往遇到的问题 3.环境的影响 (二)。睡眠不足的危害 1.影响大脑创造性思维 2.影响青少年生长发育 3.影响皮肤健康 4.导致疾病发生 (二)对我我校学生睡眠的建议和总结

常见的特征选择或特征降维方法

URL:https://www.360docs.net/doc/e33191002.html,/14072.html 特征选择(排序)对于数据科学家、机器学习从业者来说非常重要。好的特征选择能够提升模型的性能,更能帮助我们理解数据的特点、底层结构,这对进一步改善模型、算法都有着重要作用。 特征选择主要有两个功能: 1.减少特征数量、降维,使模型泛化能力更强,减少过拟合 2.增强对特征和特征值之间的理解 拿到数据集,一个特征选择方法,往往很难同时完成这两个目的。通常情况下,选择一种自己最熟悉或者最方便的特征选择方法(往往目的是降维,而忽略了对特征和数据理解的目的)。 在许多机器学习的书里,很难找到关于特征选择的容,因为特征选择要解决的问题往往被视为机器学习的一种副作用,一般不会单独拿出来讨论。本文将介绍几种常用的特征选择方法,它们各自的优缺点和问题。 1 去掉取值变化小的特征Removing features with low variance 这应该是最简单的特征选择方法了:假设某种特征的特征值只有0和1,并且在所有输入样本中,95%的实例的该特征取值都是1,那就可以认为这个特征作用不大。如果100%都是1,那这个特征就没意义了。当特征值都是离散型变量的时候这种方法才能用,如果是连续型变量,就需要将连续变量离散化之后才能用,而且实际当中,一般不太会有95%以上都取某个值的特征存在,所以这种方法虽然简单但是不太好用。可以把它作为特征选择的预处理,先去掉那些取值变化小的特征,然后再从接下来提到的特征选择方法中选择合适的进行进一步的特征选择。

2 单变量特征选择Univariate feature selection 单变量特征选择能够对每一个特征进行测试,衡量该特征和响应变量之间的关系,根据得分扔掉不好的特征。对于回归和分类问题可以采用卡方检验等方式对特征进行测试。 这种方法比较简单,易于运行,易于理解,通常对于理解数据有较好的效果(但对特征优化、提高泛化能力来说不一定有效);这种方法有许多改进的版本、变种。 2.1 Pearson相关系数Pearson Correlation 皮尔森相关系数是一种最简单的,能帮助理解特征和响应变量之间关系的方法,该方法衡量的是变量之间的线性相关性,结果的取值区间为[-1,1],-1表示完全的负相关(这个变量下降,那个就会上升),+1表示完全的正相关,0表示没有线性相关。 Pearson Correlation速度快、易于计算,经常在拿到数据(经过清洗和特征提取之后的)之后第一时间就执行。 Pearson相关系数的一个明显缺陷是,作为特征排序机制,他只对线性关系敏感。如果关系是非线性的,即便两个变量具有一一对应的关系, Pearson相关性也可能会接近0。 2.2 互信息和最大信息系数Mutual information and maximal information coefficient (MIC)

理性选择制度主义研究综述

理性选择制度主义研究综述 谢嘉元 (东北大学文法学院,辽宁沈阳 110004) 摘要:通过比较系统考察理性选择制度主义理论产生的理性选择制度主义是一种制度分析“典范”,在美国政治学界中占主导地位,但在我国政治学界的研究和运用才刚刚起步背景及特征、国外理性选择制度主义者的主要观点、理论发展中存在的问题以及国内学者对理性选择制度主义的研究、理论的发展现状,对理性选择制度主义做一个简单的梳理,对理性选择制度主义具有重大意义。 关键词:理性选择制度主义;新制度主义;特点;主要观点 自詹姆斯·马奇和约翰·奥尔森于1984年在《美国政治科学评论》杂志上发表“新制度主义:政治生活中的组织因素”一文,“新制度主义”一词在政治科学中的出现频率便越来越高。按照被接受最广的霍尔和泰勒的观点,新制度主义可划分为三种不同的流派:历史制度主义、理性选择制度主义和社会学制度主义。所有这三种流派都是针对二十世纪六、七十年代盛行的行为主义研究方法而发展起来的,并试图重新阐释制度在决定社会和政治产出中所发挥的作用。尽管这三种流派出现的时间起点相近,并且都强调了制度的重要性,但它们之间存在着明显的差异,并且彼此的发展也呈现了相对的独立性。 一、理性选择制度主义理论的背景 理性选择从方法论层面看在某种意义上可以追溯到霍布斯

和休谟。但是,作为现代理性选择理论则产生于 20 世纪50年代。理性选择理论诞生之初,仅是政治科学学科中的一个很小的分支,没有受到太大的关注。经过几十年的研究和发展,现在的理性选择理论较之过去更加成熟。当理性选择理论运用严格的预设假定前提来研究美国国会的投票行为时,发现一个重大的矛盾,即如果传统理性选择的模型正确的话,美国国会的立法就很难保持稳定的多数。因为立法者们众多的偏好顺序和问题本身的多维特征都将会导致这样一种现象,即新的多数往往会倾向于推翻任何已经通过的议案,从而使得从一个议案到另一个议案都会出现阿罗循环的现象。然而事实表明,美国国会投票结果保持了相当大的稳定性。正是在解答这一令传统理性选择理论者感到迷惑的问题的过程中,理性选择开始对制度进行研究。国会的制度降低了事务处理的交易成本,使得在议员之间能够达成交易,从而使得法案的稳定通过成为可能。此时,理性选择理论也被称为理性选择制度主义。 理性选择范式目前在美国政治学中占据着主导地位,现代政治学家们一般都把“理性选择理论”视为公共选择理论、社会选择理论、博弈论、理性行动模式、实证政治经济学等的同义词。按照盖伊·彼得斯的分析,理性选择制度主义又可以分为若干分支。第一个分支是印地安那学派,以美国学者奥斯特罗姆夫妇为代表,主要关注如何用制度来解决公共池塘的治理问题,即如何克服公共池塘资源治理中个体理性与集体理性的不一致问题。第二个分支是公共选择学派,即把现代经济学的逻辑和方法用于研究政治学的问题,以微观经济学的基本假设(尤其是理性人假设)、原理和方法作为分析工具来研究和刻画政治市场上的主体的行为和政治市场的运行。公共选择“是将经济学应用于政治科学,

文献综述要求

文献综述 文献综述简称综述,是对某一领域,某一专业或某一方面的课题,问题或研究专题搜集大量相关资料,通过分析,阅读,整理,提炼当前课题,问题或研究专题的最新进展,学术见解或建议,做出综合性介绍和阐述的一种学术论文。 中文名 文献综述 外文名 Review of the literature 文献综述基本解释 文献综述是在确定了选题后,在对选题所涉及的研究领域的文献进行广泛阅读和理解的基础上,对该研究领域的研究现状(包括主要学术观点、前人研究成果和研究水平、争论焦点、存在的问题及可能的原因等)、新水平、新动态、新技术和新发现、发展前景等内容进行综合分析、归纳整理和评论,并提出自己的见解和研究思路而写成的一种不同于毕业论文的文体。它要求作者既要对所查阅资料的主要观点进行综合整理、陈述,还要根据自己的理解和认识,对综合整理后的文献进行比较专门的、全面的、深入的、系统的论述和相应的评价,而不仅仅是相关领域学术研究的“堆砌”。 《怎样做文献综述——六步走向成功》 文献综述是研究者在其提前阅读过某一主题的文献后,经过理解、整理、融会贯通,综合分析和评价而组成的一种不同于研究论文的文体。

检索和阅读文献是撰写综述的重要前提工作。一篇综述的质量如何,很大程度上取决于作者对本题相关的最新文献的掌握程度。如果没有做好文献检索和阅读工作,就去撰写综述,是绝不会写出高水平的综述的。 好的文献综述,不但可以为下一步的学位论文写作奠定一个坚实的理论基础和提供某种延伸的契机,而且能表明写本综述的作者对既有研究文献的归纳分析和梳理整合的综合能力,从而有助于提高对学位论文水平的总体评价。 在《怎样做文献综述——六步走向成功》中,劳伦斯·马奇和布伦达·麦克伊沃提出了文献综述的六步模型,将文献综述的过程分为六步:选择主题、文献搜索、展开论证、文献研究、文献批评和综述撰写。 文献综述根据研究的目的不同,可分为基本文献综述和高级文献综述两种。基本文献综述是对有关研究课题的现有知识进行总结和评价,以陈述现有知识的状况;高级文献综述则是在选择研究兴趣和主题之后,对相关文献进行回顾,确立研究论题,再提出进一步的研究,从而建立一个研究项目。 文献综述相关格式 文献综述 总的来说,一般都包含以下四部分:即摘要、引言、主体和参考文献。 这是因为研究性的论文注重研究的方法、结果、动态和进展。 文献综述摘要和关键词 摘要限200字以内。摘要要具有独立性和自含性,不应出现图表、冗长的公式和非公知的符号、缩略语。摘要后须给出3-5个关键词,中间应用分号“;”分隔。 文献综述引言部分

文本分类中的特征提取和分类算法综述

文本分类中的特征提取和分类算法综述 摘要:文本分类是信息检索和过滤过程中的一项关键技术,其任务是对未知类别的文档进行自动处理,判别它们所属于的预定义类别集合中的类别。本文主要对文本分类中所涉及的特征选择和分类算法进行了论述,并通过实验的方法进行了深入的研究。 采用kNN和Naive Bayes分类算法对已有的经典征选择方法的性能作了测试,并将分类结果进行对比,使用查全率、查准率、F1值等多项评估指标对实验结果进行综合性评价分析.最终,揭示特征选择方法的选择对分类速度及分类精度的影响。 关键字:文本分类特征选择分类算法 A Review For Feature Selection And Classification Algorithm In Text Categorization Abstract:Text categorization is a key technology in the process of information retrieval and filtering,whose task is to process automatically the unknown categories of documents and distinguish the labels they belong to in the set of predefined categories. This paper mainly discuss the feature selection and classification algorithm in text categorization, and make deep research via experiment. kNN and Native Bayes classification algorithm have been applied to test the performance of classical feature detection methods, and the classification results based on classical feature detection methods have been made a comparison. The results have been made a comprehensive evaluation analysis by assessment indicators, such as precision, recall, F1. In the end, the influence feature selection methods have made on classification speed and accuracy have been revealed. Keywords:Text categorization Feature selection Classification algorithm

社会科学研究中的文献综述:原则、结构和问题

社会科学研究中的文献综述:原则、结构和问题 【内容提要】 文献综述是对文献进行查找、阅读、分析,并对它们进行总结、归纳和评论的完整过程。本文对文献综述的性质与作用予以说明,并对查找、选择和阅读文献等撰写的前期准备工作进行了介绍。明确文献综述的内容与要求、撰写原则和基本结构是决定撰写成功与否的关键所在。 【关 键 词】文献综述 撰写原则 撰写过程 基本结构 批判性 文献综述是从事社会科学研究和学术论文撰写的基础环节,在整个学术研究过程中占据十分重要和关键的地位。文献综述的质量和水平的高低,直接影响着相关学术研究的总体水平以及研究者个人的学术发展。本文对于文献综述的撰写原则、基本结构和可能出现的问题进行初步介绍和说明,以使读者对进行文献综述撰写过程有比较准确的理解和认识。 一、文献综述的性质和作用 (一)文献综述的定义与性质 文献综述(literaturereview)是对目前为止的、与某一研究问题相关的各种文献进行系统查阅和分析,以了解该领域研究状况的过程。或者说,就是一个系统地识别、寻找、考察和总结那些与我们的研究有关的文献的过程。从具体形式来看,文献综述分为以下两种:(1)完整的、可直接发表的文献综述。它通常包括引言、概述、正文、目前研究的不足和建议、参考文献等组成部分。(2)学术(学位)论文中的文献综述。它的篇幅和结构可以进行调整和压缩。这里主要讨论的是后一种文献综述。社会学学者风笑天将文献综述(回顾)分为两种类型:“作为过程的文献回顾”和“作为结果的文献回顾”。前一种主要是指围绕某一主题,对相关文献进行系统搜索、查找、阅读、分析的过程;后一种则指以总结和综述的形式将上述过程的结果表达出来。实际上,文献综述是一个既包括对文献进行查找、阅读和分析,又包括对这些文献进行归纳、总结和评论的完整过程。文献综述中的核心问题是参考文献的选择。这不仅要看文献的数量,更为关键的是要包括最重要、最经典的著述和最新的、有价值的研究成果,并能从中分析并总结出前人研究的不足之处及存在的问题。 (二)文献综述的目的与作用 一般说来,文献综述的写作目的是:(1)通过评估分析已有的研究贡献和局限,凸显自己研究问题的价值。(2)寻找自己的专业(问题)定位——它和理论传统的关系,以便阐明自己的研究在这一领域中的位置。(3)寻找自己不同于前人之处,阐明其研究的进展和特点,让其研究发现尽可能具有原创性。进一步说,文献综述的目的可以表述为:概述“大问题”;选择适合研究的文献;总结其他人的研究;评估他人的研究;提供作研究的语境;发现研究中的空白;加强对理论和方法的理解等。也有学者认为,文献综述需要起到以下四个方面的作用:(1)识别研究的起源。这就将研究放到了现有的理论和实践范围之内。(2)表现对感兴趣领域的观点、信息和实践行为的了解。(3)证明研究题目和方法的选择是必要和适时的。(4)提炼并发展研究的问题和目标。文献综述不

特征选择算法综述20160702

特征选择方法综述 控制与决策2012.2 问题的提出 特征选择框架基于搜索策略划分特征选择方法基于评价准则划分特征选择方法结论 一、问题的提出特征选择是从一组特征中挑选出一些最有效的特征以降低特征空间维数的过程,是模式识别的关键问题之一。对于模式识别系统,一个好的学习样本是训练分类器的关键,样本中是否含有不相关或冗余信息直接影响着分类器的性能。因此研究有效的特征选择方法至关重要。 特征选择算法的目的在于选择全体特征的一个较少特征集合,用以对原始数据进行有效表达按照特征关系度量划分,可分为依赖基尼指数、欧氏距离、信息熵。 、特征选择框架 由于子集搜索是一个比较费时的步骤,一些学者基于相关和冗余分析,给出了下面一种特征选择框架,避免了子集搜索,可以高效快速地寻找最优子集。 从特征选择的基本框架看出,特征选择方法中有4 个基本步骤:候选特征子集的生成(搜索策略)、评价准则、停止准则和验证方法。目前对特征选择方法的研究主要集中于搜索策略和评价准则。因而,本文从搜索策略和评价准则两个角度对特征选择方法进行分类。 三、基于搜索策略划分特征选择方法 基本的搜索策略按照特征子集的形成过程,形成的特征选择方法如下:

图3 基于搜索策略划分特征选择方法 其中,全局搜索如分支定界法,存在问题: 1)很难确定优化特征子集的数目; 2)满足单调性的可分性判据难以设计; 3)处理高维多类问题时,算法的时间复杂度较高。 随机搜索法如模拟退火、遗传算法、禁忌搜索算法等,存在问题: 1)具有较高的不确定性,只有当总循环次数较大时,才可能找到较好的结果。 2)在随机搜索策略中,可能需对一些参数进行设置,参数选择的合适与否对最终结果的好坏起着很大的作用。 启发式搜索如SFS、SBS、SFFS、SFBS等,存在问题: 1)虽然效率高,但是它以牺牲全局最优为代价。 每种搜索策略都有各自的优缺点,在实际应用过程中,根据具体环境和准则函数来寻找一个最佳的平衡点。例如,特征数较少,可采用全局最优搜索策略;若不要求全局最优,但要求计算速度快,可采用启发式策略;若需要高性能的子集,而不介意计算时间,则可采用随机搜索策略。 四、基于评价准则划分特征选择方法

特征选择综述

特征选择常用算法综述 一.什么是特征选择(Featureselection ) 特征选择也叫特征子集选择 ( FSS , Feature SubsetSelection ) 。是指从已有的M个特征(Feature)中选择N个特征使得系统的特定指标最优化。 需要区分特征选择与特征提取。特征提取 ( Feature extraction )是指利用已有的特征计算出一个抽象程度更高的特征集,也指计算得到某个特征的算法。 特征提取与特征选择都能降低特征集的维度。 评价函数 ( Objective Function ),用于评价一个特征子集的好坏的指标。这里用符号J ( Y )来表示评价函数,其中Y是一个特征集,J( Y )越大表示特征集Y 越好。 评价函数根据其实现原理又分为2类,所谓的Filter和Wrapper 。 Filter(筛选器):通过分析特征子集内部的信息来衡量特征子集的好坏,比如特征间相互依赖的程度等。Filter实质上属于一种无导师学习算法。 Wrapper(封装器):这类评价函数是一个分类器,采用特定特征子集对样本集进行分类,根据分类的结果来衡量该特征子集的好坏。Wrapper实质上是一种有导师学习算法。 二.为什么要进行特征选择? 获取某些特征所需的计算量可能很大,因此倾向于选择较小的特征集特征间的相关性,比如特征A完全依赖于特征B,如果我们已经将特征B选入特征集,那么特征A 是否还有必要选入特征集?我认为是不必的。特征集越大,分类器就越复杂,其后果就是推广能力(generalization capability)下降。选择较小的特征集会降低复杂度,可能会提高系统的推广能力。Less is More ! 三.特征选择算法分类 精确的解决特征子集选择问题是一个指数级的问题。常见特征选择算法可以归为下面3类: 第一类:指数算法 ( Exponential algorithms ) 这类算法对特征空间进行穷举搜索(当然也会采用剪枝等优化),搜索出来的特征集对于样本集是最优的。这类算法的时间复杂度是指数级的。

常见的特征选择或特征降维方法

URL:https://www.360docs.net/doc/e33191002.html,/14072.html 特征选择(排序)对于数据科学家、机器学习从业者来说非常重要。好的特征选择能够提升模型的性能,更能帮助我们理解数据的特点、底层结构,这对进一步改善模型、算法都有着重要作用。 特征选择主要有两个功能: 1.减少特征数量、降维,使模型泛化能力更强,减少过拟合 2.增强对特征和特征值之间的理解 拿到数据集,一个特征选择方法,往往很难同时完成这两个目的。通常情况下,选择一种自己最熟悉或者最方便的特征选择方法(往往目的是降维,而忽略了对特征和数据理解的目的)。 在许多机器学习的书里,很难找到关于特征选择的内容,因为特征选择要解决的问题往往被视为机器学习的一种副作用,一般不会单独拿出来讨论。本文将介绍几种常用的特征选择方法,它们各自的优缺点和问题。 1 去掉取值变化小的特征 Removing features with low variance 这应该是最简单的特征选择方法了:假设某种特征的特征值只有0和1,并且在所有输入样本中,95%的实例的该特征取值都是1,那就可以认为这个特征作用不大。如果100%都是1,那这个特征就没意义了。当特征值都是离散型变量的时候这种方法才能用,如果是连续型变量,就需要将连续变量离散化之后才能用,而且实际当中,一般不太会有95%以上都取某个值的特征存在,所以这种方法虽然简单但是不太好用。可以把它作为特征选择的预处理,先去掉那些取值变化小的特征,然后再从接下来提到的特征选择方法中选择合适的进行进一步的特征选择。 2 单变量特征选择 Univariate feature selection

文献综述格式及写作技巧(附文献综述范文)

文献综述格式及写作技巧(附文献综述范文) 文献综述是在对文献进行阅读、选择、比较、分类、分析和综合的基础上,研究者用自己的语言对某一问题的研究状况进行综合叙述的情报研究成果。文献的搜集、整理、分析都为文献综述的撰写奠定了基础。文献综述格式一般包括: 文献综述的引言: 包括撰写文献综述的原因、意义、文献的范围、正文的标题及基本内容提要; 文献综述的正文: 是文献综述的 主要内容,包括某一课题研究的历史 (寻求研究问题的发展历程)、现状、基本内容 (寻求认识的进步), 研究方法的分析(寻求研究方法的借鉴),已解决的问题和尚存的问题,重点、详尽地阐述对当前的影响及发展趋势,这样不但可以使研究者确定研究方向,而且便 于他人了解该课题研究的起点和切入点,是在他人研究的基础上有所创新; 文献综述的结论: 文献研究的结论,概括指出自己对该课题的研究意见,存在的不同意见和有待解决的问题等; 文献综述的附录: 列出参考文献,说明文献综述所依据的资料,增加综述的可信度,便于读者进一步检索。 一、文献综述不应是对已有文献的重复、罗列和一般性介绍,而应是对以往研究的优点、不足和贡献的批判性分析与评论。因此,文献综述应包括综合提炼和分析评论双重含义。 文献综述范文1:“问题——探索——交流”小学数学教学模式的研究... ...我们在网上浏览了数百种教学模式,下载了二百余篇有关教学模式的文章,研读了五十余篇。概括起来,我国的课堂教学模式可分三类: (1) 传统教学模式——“教师中心论”。这类教学模式的主要理论根据是行为主义学习理论,是我国长期以来学校教学的主流模式。它的优点

是... ...,它的缺陷是... ... (2) 现代教学模式——“学生中心论”。这类教学模式的主要理论依据是建构主义学习理论,主张从教学思想、教学设计、教学方法以及教学管理等方面均以学生为中 心,20世纪 90年代以来,随着信息技术在教学中的应用,得到迅速发展。它的优点是... ...,它的缺陷是... ... (3) 优势互补教学模式——“主导——主体论”。这类教学模式是以教师为主导,以学生为主体,兼取行为主义和建构主义学习理论之长并弃其之短,是对“教师中心 论”和“学生中心论”的扬弃。“主导——主体论”教学模式体现了辩证唯物主义认识论,但在教学实践中还没有行之有效的可以操作的教学方法和模式。 以教师为中心的传统小学数学教学模式可表述为“复习导入——传授新知——总结归纳——巩固练习——布置作业”。这种教学模式无疑束缚了学生学习主体作用的 发挥。当今较为先进的小学数学教学模式可表述为“创设情境,提出问题——讨论问题,提出方案——交流方案,解决问题——模拟练习,运用问题——归纳总结, 完善认识”。这种教学模式力求重视教师的主导作用和学生的主体作用,为广大教师所接受,并在教学实践中加以运用。但这种教学模式将学生的学习局限于课堂, 学习方式是为数学而数学,没有把数学和生活结合起来,没有把学生学习数学置于广阔的生活时空中去,学生多角度多途径运用数学知识解决问题的能力受到限制, 尤其是学生运用数学知识创造性地解决生活中的数学问题的能力发展受到限制,不利于培养学生的创新精神和实践能力。为此,我们提出“‘问题——探索——交流 ’小学数学教学模式研究”课题。 文献综述范 文1中,研究者对有关研究领域的情况有一个全面、系统的认识和了解,对相关文献作了批判性的分析与评论。对于正在从事某一项课题的研究者来说,查阅文献资 料有助于他们从整体上把握自己研究领域的发展历史与现状、已取得的主要研究成果、存在争议的地方、研究的最新方向和趋势、被研究者忽视的领域、对进一步研 究工作的建议等。 文献综述范文2: 农村中学学生自学方法研究 1.国外的研究现状 国外的自学方法很多。美国心理学家斯金纳提出程序学习法... ...,程序学习使学习变得相对容易,有利于学生自学。美国心理学家桑代克所创设的试误学习法... ...,它主要解决学习中的问题。还有超级学习法,查、问、读、记、复习法、暗示法等。 2.国内的研究状况 我国古代就非常重视自学方法的研究,有“温故而知新”,“学而时习

有关特征选择内容

特征选择和集成学习是当前机器学习中的两大研究热点,其研究成果己被广泛地应用于提高单个学习器的泛化能力。 特征选择是指从原始特征集中选择使某种评估标准最优的特征子集。其目的是根据一些准则选出最小的特征子集,使得任务如分类、回归等达到和特征选择前近似甚至更好的效果。通过特征选择,一些和任务无关或者冗余的特征被删除,简化的数据集常常会得到更精确的模型,也更容易理解。 滤波式(filter)方法的特征评估标准直接由数据集求得,而无需学习算法进行反馈,其优点是运行效率高,因此非常适用于集成学习.假设用于集成的特征选择算法有k种,,抽取产生m 个子训练集,在每个训练集上利用其中一种特征选择算法选出满足条件的属性作为个体svm训练的输入空间,并训练得到m个svm个体,然后对其他的特征选择算法重复执行上述过程,最后将得到的k*m 个子svm的预测结果集成. 特征选择是从一组数量为D 的原始特征中选出数量为d(D>d)的一组最优特征采用遗传退火算法进行特征选择.随机生成长度为 D 的二进制串个体其中1 的个数为d 。连续产生这样的个体M 个M 为种群规模其大小影响着遗传算法的最终结果及其执行效率M。 特征选择的目的是找出分类能力最强的特征组合需要一个定量准则来度量特征组合的分类能力。度量特征选择算法优劣的判据很多各样本之所以能分开是因为它们位于特征空间的不同区域如果类间

距离越大类内各样本间的距离越小则分类效果越好。 各种新搜索算法和评估标准都应用到特征选择算法中。如粗糙集算法,神经网络剪枝法,支持向量机的评估标准,特征集的模糊嫡评价,马尔可夫算法等

入侵检测系统的数据含有大量的冗余与噪音特征,使得系统耗用的计算资源很大,导致系统训练时间长,实时性差,检测效果不好,引入特征选择算法能够去除高维数据中无用和冗余的信息,保留对分类效果起关键作用的信息,在不影响分类效果的同时减少数据量,降低了数据存储复杂度,减轻系统负荷,提高入侵检测系统的检测速度,增强入侵检测系统的健壮性。 入侵检测问题从机器学习的角度看实际上是一个分类问题,分类器的性能不仅与分类器设计算法有关,而且与选择的特征子集有关。一个高度相关的特征子集可有效改进分类器的性能,因而特征选择(属性约简)具有重要的理论意义和应用价值。 集成学习(Ensemble Learning)是通过将一组学习器以某种方式组合在一起可以显著提高学习系统的泛化能力(有监督的分类器集成和半监督的分类器集成)。 神经网络集成可以显著地提高神经网络系统的泛化能力,被视为

分支界定算法及其在特征选择中的应用研究

分支界定算法及其在特征选择中的应用研究作者:王思臣于潞刘水唐金元 来源:《现代电子技术》2008年第10期 摘要:分支界定算法是目前为止惟一既能保证全局最优,又能避免穷尽搜索的算法。他自上而下进行搜索,同时具有回溯功能,可使所有可能的特征组合都被考虑到。对分支界定算法进行研究,并对其做了一些改进;最后对改进前后的算法在特征选择领域进行比较,选择效率有了明显的提高。 关键词:分支界定算法;特征选择;特征集;最小决策树;局部预测 中图分类号:TP31 文献标识码:A 文章编号:1004-373X(2008)10-142- (Qingdao Branch,Naval Aeronautical Engineering Institute,Qingdao, Abstract:Branch&Bound Algorithm is the only method which can ensure best of all the vectors,and it can avoid endless searching.It searches from top to bottom and has the function that from bottom to top,so it can include all of the feature vectors.The Branch&Bound Algorithm is studied in the paper,and it is improved,the two algorithms are compared by the feature seclection,the Keywords:branch&bound algorithm;feature selection;feature vector;minimum solution 随着科学技术的发展,信息获取技术的不断提高和生存能力的提升,对于目标特征能够获得的数据量越来越大,维数越来越高,一方面可以使信息更充分,但在另一方面数据中的冗余和无关部分也会相应的增多。特征选择[1,2]就是为了筛选出那些对于分类来说最相关的特征,而去掉冗余和无关的特征。 分支界定算法[1,3,4]是一种行之有效的特征选择方法,由于合理地组织搜索过程,使其有可能避免计算某些特征组合,同时又能保证选择的特征子集是全局最优的。但是如果原始特征集的维数与要选择出来的特征子集的维数接近或者高很多,其效率就不够理想。基于此,本文对分支界定算法做了一定的改进,经过实验验证,与改进前相比其效率有明显的提高。 1 分支界定算法的基本原理

研究综述

文献综述(研究综述)格式:按照某一逻辑线索,把课题有关的研究成果的主要观点有机地串起来,使读者能够清楚地了解所选课题当前的研究的现状、主要的观点、重点问题,在此基础上找到自己的研究方向和主要问题 你的研究综述不过关,就把别人的一篇论文当做研究现状不符合要求,研究现状如何写,看看下面一篇研究综述。多看一些文献,尽快把文献综述再交给我 研究综述 1.4.1国外研究综述 从国外研究房地产信贷问题的文献来看,国外对于房地产信贷风险的研究历史己经很久了,房地产业的商业化程度较高,对信贷风险度量技术的研宄也较多,但大部分也是集中在宏观经济环境和微观经济行为两个方面的研宄。 Collyns and Senhadji (2002)研究发现在20世纪90年代,大部分亚洲国家存在着资产价格泡沫,在房地产市场上,银行借贷和资产价格膨胀有很大的关系。1Davis and Zhu (2004)利用17个国家的相关数据,通地实证来分析银行贷款和房地产价格之间的关系,发现房地产价格的与银行信贷规模的成正相关关系。2Gerlach and Peng (2005)利用香港1982年1季度到2001年4季度的季度数据,通过实证来分析房地产价格、银行贷款、GDP等变量之间的长期均衡与波动关系,发现房地产价格的波动是导致银行的信贷扩张的原因。3Winston and Roberto et al. (2005)通过研究发现,房地产价格在发生信贷危机之前会大幅上涨,房地产市场非常繁荣,接下来就是危机的爆发和房价的爆跌,虚高的房价己成为商业银行房地产信贷风险的明显一个标志。4Robinson and Stone (2005)认为房地产泡沫所导致的问题不仅仅在经济周期的波动,而且使中央银行在发生泡沫时处于被 1Charles Collyns and Abdelhak Senhadji. Lending Booms, Real Estate Bubbles and The Asian Crisis[Z]. IMF Working Paper,2002. 2Davis,E.Philip and Haibin Zhu. Bank Lending and Commercial property cycles:some cross-country evidence[Z]. BIS Working Papers,2004,N0150:l -37. 3Stefan Gerlach and Wensheng Peng. Bank lending and property prices in HongKong[J]. Journal of Banking & Finance,2005(29):461-481. 4Winston T.H.Koh, Roberto S. Mariano, Aridrey Pavlov, et al. Bank Lending and Real Estate in Asia: Market Optimism and Asset BubbIes[J]. Journal of Asian Economics,2005(6):1103-1118.

特征选择算法综述20160702

特征选择方法综述 控制与决策 2012.2 ●问题的提出 ●特征选择框架 ●基于搜索策略划分特征选择方法 ●基于评价准则划分特征选择方法 ●结论 一、问题的提出 特征选择是从一组特征中挑选出一些最有效的特征以降低特征空间维数的过程,是模式识别的关键问题之一。对于模式识别系统,一个好的学习样本是训练分类器的关键,样本中是否含有不相关或冗余信息直接影响着分类器的性能。因此研究有效的特征选择方法至关重要。 特征选择算法的目的在于选择全体特征的一个较少特征集合,用以对原始数据进行有效表达按照特征关系度量划分,可分为依赖基尼指数、欧氏距离、信息熵。 二、特征选择框架 由于子集搜索是一个比较费时的步骤,一些学者基于相关和冗余分析,给出了下面一种特征选择框架,避免了子集搜索,可以高效快速地寻找最优子集。 从特征选择的基本框架看出,特征选择方法中有4个基本步骤:候选特征子集的生成(搜索策略)、评价准则、停止准则和验证方法。目前对特征选择方法的研究主要集中于搜索策略和评价准则。因而,本文从搜索策略和评价准则两个角度对特征选择方法进行分类。

三、基于搜索策略划分特征选择方法 基本的搜索策略按照特征子集的形成过程,形成的特征选择方法如下: 图3基于搜索策略划分特征选择方法 其中,全局搜索如分支定界法,存在问题: 1)很难确定优化特征子集的数目; 2)满足单调性的可分性判据难以设计; 3)处理高维多类问题时,算法的时间复杂度较高。 随机搜索法如模拟退火、遗传算法、禁忌搜索算法等,存在问题: 1)具有较高的不确定性,只有当总循环次数较大时,才可能找到较好的结果。 2)在随机搜索策略中,可能需对一些参数进行设置,参数选择的合适与否对最终结果的好坏起着很大的作用。 启发式搜索如SFS、SBS、SFFS、SFBS等,存在问题: 1)虽然效率高,但是它以牺牲全局最优为代价。 每种搜索策略都有各自的优缺点,在实际应用过程中,根据具体环境和准则函数来寻找一个最佳的平衡点。例如,特征数较少,可采用全局最优搜索策略;若不要求全局最优,但要求计算速度快,可采用启发式策略;若需要高性能的子集,而不介意计算时间,则可采用随机搜索策略。 四、基于评价准则划分特征选择方法

理性选择制度主义研究综述

理性选择制度主义研究综述 嘉元 (东北大学文法学院,110004) 摘要:通过比较系统考察理性选择制度主义理论产生的理性选择制度主义是一种制度分析“典”,在美国政治学界中占主导地位,但在我国政治学界的研究和运用才刚刚起步背景及特征、国外理性选择制度主义者的主要观点、理论发展中存在的问题以及国学者对理性选择制度主义的研究、理论的发展现状,对理性选择制度主义做一个简单的梳理,对理性选择制度主义具有重大意义。关键词:理性选择制度主义;新制度主义;特点;主要观点 自詹姆斯·马奇和约翰·奥尔森于1984年在《美国政治科学评论》杂志上发表“新制度主义:政治生活中的组织因素”一文,“新制度主义”一词在政治科学中的出现频率便越来越高。按照被接受最广的霍尔和泰勒的观点,新制度主义可划分为三种不同的流派:历史制度主义、理性选择制度主义和社会学制度主义。所有这三种流派都是针对二十世纪六、七十年代盛行的行为主义研究方法而发展起来的,并试图重新阐释制度在决定社会和

政治产出中所发挥的作用。尽管这三种流派出现的时间起点相近,并且都强调了制度的重要性,但它们之间存在着明显的差异,并且彼此的发展也呈现了相对的独立性。 一、理性选择制度主义理论的背景 理性选择从方法论层面看在某种意义上可以追溯到霍布斯和休谟。但是,作为现代理性选择理论则产生于20 世纪50年代。理性选择理论诞生之初,仅是政治科学学科中的一个很小的分支,没有受到太大的关注。经过几十年的研究和发展,现在的理性选择理论较之过去更加成熟。当理性选择理论运用严格的预设假定前提来研究美国国会的投票行为时,发现一个重大的矛盾,即如果传统理性选择的模型正确的话,美国国会的立法就很难保持稳定的多数。因为立法者们众多的偏好顺序和问题本身的多维特征都将会导致这样一种现象,即新的多数往往会倾向于推翻任何已经通过的议案,从而使得从一个议案到另一个议案都会出现阿罗循环的现象。然而事实表明,美国国会投票结果保持了相当大的稳定性。正是在解答这一令传统理性选择理论者感到迷惑的问题的过程中,理性选择开始对制度进行研究。国会的制度降低了事务处理的交易成本,使得在议员之间能够达成交易,从而使得法案的稳定通过成为可能。此时,理性选择理论也被称为

特征选择算法综述及基于某weka的性能比较

数据挖掘中的特征选择算法综述及基于WEKA的性能比较 良龙 (大学信息科学与工程学院) 摘要:自进入21世纪以来,随着信息技术的飞速发展,产生了海量的具有潜在应用价值的数据,将这些数据转换成有用的信息和知识的需求也越来越迫切,因此数据挖掘引起了信息产业界和整个社会的极大关注。特征选择作为一种常见的降维方法,在数据挖掘中起到不可忽视的作用。本文首先介绍了数据挖掘处理对象的趋势,然后概述了特征选择算法,最后通过数据挖掘软件WEKA比较了分别基于Filter和Wrapper方法的特征选择算法的性能。 关键词:数据挖掘;特征选择;WEKA;Filter;Wrapper;性能比较 A survey of feature selection algorithm in Data Mining and the performance comparison based on WEKA Abstract: As the mass of data which have potential application and value have been created by the rapid development of information technology since the 21st century, the needs to transferring these data into useful information and knowledge are being more and more urgent, so the Data Mining caused the whole society and the information industry of great concern. Feature selection is critical to Data Mining for that it is a common method to reduce dimensions. The tendency of Data Mining’s