MPI程序进程间的通信

超性能计算mpi课件详解

超性能计算MPI课件详解什么是超性能计算和MPI?超性能计算(High Performance Computing,HPC)是一种高速、高效的计算方式,通过使用并行计算技术和大规模计算资源,能够快速处理复杂的科学、工程和商业计算问题。

而MPI(Message Passing Interface)是一种并行编程模型和消息传递标准,常用于超级计算机集群上。

MPI的基本概念和特点MPI 是基于消息传递的并行计算模型,其核心思想是将计算任务分解为多个子任务,每个子任务在不同的处理器上执行,通过消息传递进行通信和同步。

MPI 提供了一套标准的 API,可以在不同的编程语言中使用。

MPI 的核心概念包括以下几个方面:1.进程:MPI 系统中的基本执行单元,每个进程都有一个唯一的标识符(rank),可以通过该标识符进行消息传递和通信。

2.通信域:进程集合,常用的通信域是 MPI_COMM_WORLD,包含所有的进程。

3.点对点通信(Point-to-Point Communication):进程之间直接的消息传递,包括发送者和接收者两个进程。

4.集体通信(Collective Communication):多个进程之间的消息传递,包括广播、散射、聚集等操作。

MPI 的特点主要有以下几个方面:1.可移植性:MPI 是一个开放标准,可以在不同的硬件平台和操作系统上使用。

只要安装了相应的 MPI 实现,就可以运行相同的 MPI 程序。

2.发送/接收模型:MPI 提供了灵活的发送和接收消息的函数,可以根据需要进行点对点的通信或集体的通信。

3.异步通信:MPI 的通信操作可以与计算操作并行进行,能够充分利用计算资源,提高并行计算效率。

4.可扩展性:MPI 支持从几个进程到上千个进程的规模,可以有效地利用大规模计算资源。

MPI 的编程模型和基本操作在使用 MPI 编程时,通常需要进行以下几个基本操作:1.初始化MPI:使用MPI_Init 函数初始化MPI 环境,创建进程通信域。

MPI综合实验报告

MPI综合实验报告一、实验目的本次实验旨在探究MPI并行计算技术在多节点集群中的应用,并通过编写相关代码实现一个简单的并行计算任务,验证MPI的计算能力和效果。

二、实验原理MPI(Message Passing Interface)是一种并行计算中进程间通信的标准接口。

MPI通过发送和接收消息来实现进程之间的通信,协调各个计算节点的工作。

一般而言,MPI程序由多个进程组成,每个进程可以独立地执行计算任务,当需要进行通信时,进程可以通过MPI提供的接口来发送和接收消息。

三、实验过程1.配置MPI环境在实验开始前,需要在多个节点上安装MPI环境,并确保各节点之间能够正常通信,可以互相发送和接收消息。

2.编写代码首先,需要编写一个主进程(通常为进程0)和多个子进程参与计算的代码。

主进程负责将计算任务分配给子进程,并收集子进程的计算结果。

子进程则负责进行具体的计算任务。

以下是一个简单的示例代码:```pythonfrom mpi4py import MPIif rank == 0:#主进程负责任务分配data = [i for i in range(size-1)] # 分配给每个子进程的数据for i in range(1, size):#主进程接收结果result = []for i in range(1, size):print("Result:", result)else:#子进程接收任务数据#子进程进行计算result = data * 2#子进程发送计算结果```以上代码使用了mpi4py库来实现MPI的功能。

在主进程中,首先准备要分配的数据,然后将每个子进程的数据发送给相应的子进程,并接收子进程的计算结果。

在子进程中,首先接收来自主进程的数据,然后进行计算,并将计算结果发送给主进程。

3.运行实验在配置好MPI环境和编写好代码后,将代码保存并上传到各个节点上。

然后,在主节点上执行以下命令来运行程序:``````其中,`-np 5`表示使用5个进程来进行计算。

mpi_allreduce原理

MPI_Allreduce是Message Passing Interface(MPI)标准中的一个集合通信操作,用于将每个进程中的数据累加(或者执行其他集合操作)并将结果分发给所有进程。

它的原理是实现了分布式计算环境下的全局归约操作。

全局归约是指在一个分布式系统中,将各个节点上的部分数据合并为一个全局的数据。

MPI_Allreduce具体实现如下:

1.数据分发:初始时,每个进程都有一份局部数据。

MPI_Allreduce将这些局部数据

分发到其他进程。

2.局部归约:每个进程在本地执行一个归约操作,将局部数据进行归约。

归约操作可

以是求和、求积、最大值、最小值等,取决于MPI_Allreduce的参数。

3.通信:进程之间通过消息传递机制交换局部结果。

这可以是点对点通信、广播、或

其他通信方式,根据具体实现而定。

4.全局归约:每个进程收到其他进程的局部结果后,再次进行本地的归约操作,将所

有局部结果汇总为一个全局结果。

5.结果分发:最后,每个进程都能够获得全局的结果。

这样,所有进程都拥有了对所

有局部数据进行归约后的最终结果。

MPI_Allreduce的一个重要特性是,它保证了在通信结束时,所有进程都能够获得相同的全局结果。

这是通过MPI 库的集体通信机制来实现的,确保进程之间的同步和一致性。

这个操作的性能和效率可能取决于底层MPI 实现的具体细节,如通信机制、算法选择等。

在实际应用中,了解MPI 库的具体实现对于优化和调优非常重要。

intel mpi原理

intel mpi原理Intel MPI是一种基于消息传递接口(Message Passing Interface,MPI)的编程库,用于在Intel架构上实现并行计算。

它提供了一套高性能的通信和同步机制,使得并行应用程序能够在多个处理器之间进行消息传递,并实现并行计算的任务划分和负载均衡。

本文将介绍Intel MPI的原理和工作机制。

Intel MPI的原理基于MPI标准,该标准定义了一系列的函数和语义规范,用于在分布式内存系统中进行并行计算的消息传递。

MPI 标准的目标是提供一种统一的编程接口,使得不同的并行计算环境能够实现互操作性。

Intel MPI作为一种基于MPI标准的实现,提供了对Intel架构的优化和支持,以提供更高的性能和可扩展性。

Intel MPI的工作机制主要包括进程通信、进程管理和任务调度三个方面。

进程通信是Intel MPI的核心功能之一。

在并行计算中,不同的进程之间需要进行消息传递,以实现数据的交换和协同计算。

Intel MPI通过提供一系列的通信函数,如发送(send)、接收(receive)和同步(synchronize)等,来支持进程之间的消息传递。

这些通信函数可以根据应用程序的需要进行灵活的调用,以实现不同的通信模式,如点对点通信、广播通信和规约通信等。

此外,Intel MPI 还提供了高效的通信协议和算法,如基于RDMA(Remote DirectMemory Access)的通信方式,以提高通信性能和可扩展性。

进程管理是Intel MPI的另一个重要功能。

在并行计算中,需要对多个进程进行管理和调度,以实现任务的分配和负载均衡。

Intel MPI通过提供一系列的进程管理函数,如进程创建(create)、进程销毁(destroy)和进程同步(synchronize)等,来支持进程的管理和协同。

这些函数可以根据应用程序的需要进行灵活的调用,以实现不同的进程管理策略,如静态进程划分和动态进程迁移等。

mpi 过程 -回复

mpi 过程-回复什么是MPI?MPI,全称为Message Passing Interface,即消息传递接口,是一种用于并行计算的通信标准。

MPI定义了一套接口和语义,允许多个并行进程在分布式内存系统中相互通信和协同工作。

MPI被广泛应用于高性能计算领域,特别是在大规模科学和工程计算中,以提高计算性能和效率。

MPI实现了一系列的函数和语义,用于在多个进程之间进行信息的传递和同步。

这些进程可以在同一台计算机上,也可以在分布式内存系统中的不同计算节点上。

MPI借助点对点通信、广播、约减、收集等操作,提供了一种并行计算领域通用、高效的通信机制。

MPI可以用于编写并行程序,在同一份代码中定义了各个进程的任务和交互方式。

在使用MPI编写并行程序时,首先需要初始化MPI环境。

在程序的起始处调用MPI_Init函数,这个函数会为每个进程分配一些必要的资源,并建立通信通道。

随后,每个进程可以通过调用MPI_Comm_rank函数获取自己的进程标识符,以便对不同的进程进行区分。

调用MPI_Comm_size函数可以获取整个并行程序中进程的总数。

进程间的通信是MPI的核心功能。

MPI中的通信模型主要有点对点通信和集体通信两类。

点对点通信是指两个进程之间直接的双向信息传递,包括发送和接收操作。

调用MPI_Send函数可以将数据发送给指定的进程,而调用MPI_Recv函数可以接收其他进程发送的数据。

集体通信是指多个进程之间进行的协作和通信,包括广播、约减、收集等操作。

调用MPI_Bcast函数可以将数据广播给所有其他进程,而调用MPI_Reduce函数可以将多个进程的数据约减为一个结果,调用MPI_Gather函数可以收集多个进程的数据。

MPI还提供了进程的同步机制,以保证并行计算的正确性和一致性。

最常用的同步操作是MPI_Barrier函数,调用该函数的进程会在该位置等待,直到所有其他进程也都调用了MPI_Barrier函数后,才会继续执行。

MPI消息传递MPI_Sendrecv的用法

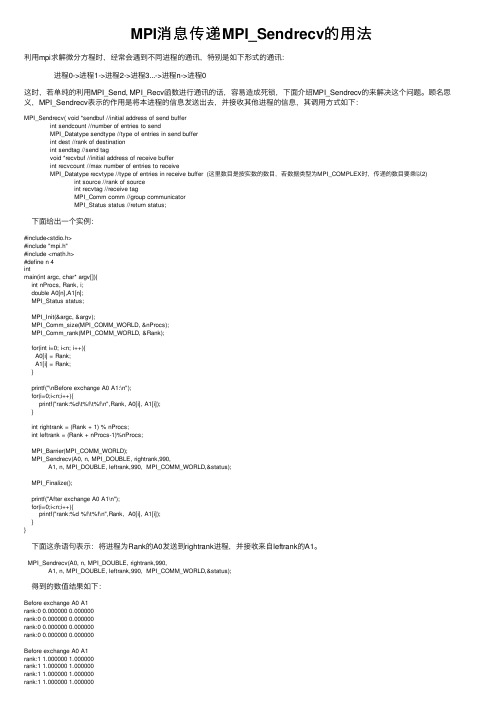

MPI消息传递MPI_Sendrecv的⽤法利⽤mpi求解微分⽅程时,经常会遇到不同进程的通讯,特别是如下形式的通讯: 进程0->进程1->进程2->进程3...->进程n->进程0这时,若单纯的利⽤MPI_Send, MPI_Recv函数进⾏通讯的话,容易造成死锁,下⾯介绍MPI_Sendrecv的来解决这个问题。

顾名思义,MPI_Sendrecv表⽰的作⽤是将本进程的信息发送出去,并接收其他进程的信息,其调⽤⽅式如下:MPI_Sendrecv( void *sendbuf //initial address of send bufferint sendcount //number of entries to sendMPI_Datatype sendtype //type of entries in send bufferint dest //rank of destinationint sendtag //send tagvoid *recvbuf //initial address of receive bufferint recvcount //max number of entries to receiveMPI_Datatype recvtype //type of entries in receive buffer (这⾥数⽬是按实数的数⽬,若数据类型为MPI_COMPLEX时,传递的数⽬要乘以2) int source //rank of source int recvtag //receive tag MPI_Comm comm //group communicator MPI_Status status //return status; 下⾯给出⼀个实例:#include<stdio.h>#include "mpi.h"#include <math.h>#define n 4intmain(int argc, char* argv[]){int nProcs, Rank, i;double A0[n],A1[n];MPI_Status status;MPI_Init(&argc, &argv);MPI_Comm_size(MPI_COMM_WORLD, &nProcs);MPI_Comm_rank(MPI_COMM_WORLD, &Rank);for(int i=0; i<n; i++){A0[i] = Rank;A1[i] = Rank;}printf("\nBefore exchange A0 A1:\n");for(i=0;i<n;i++){printf("rank:%d\t%f\t%f\n",Rank, A0[i], A1[i]);}int rightrank = (Rank + 1) % nProcs;int leftrank = (Rank + nProcs-1)%nProcs;MPI_Barrier(MPI_COMM_WORLD);MPI_Sendrecv(A0, n, MPI_DOUBLE, rightrank,990,A1, n, MPI_DOUBLE, leftrank,990, MPI_COMM_WORLD,&status);MPI_Finalize();printf("After exchange A0 A1\n");for(i=0;i<n;i++){printf("rank:%d %f\t%f\n",Rank, A0[i], A1[i]);}} 下⾯这条语句表⽰:将进程为Rank的A0发送到rightrank进程,并接收来⾃leftrank的A1。

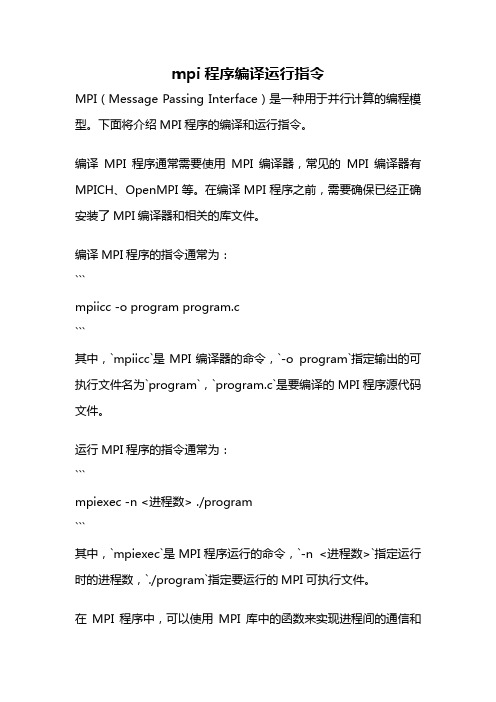

mpi程序编译运行指令

mpi程序编译运行指令MPI(Message Passing Interface)是一种用于并行计算的编程模型。

下面将介绍MPI程序的编译和运行指令。

编译MPI程序通常需要使用MPI编译器,常见的MPI编译器有MPICH、OpenMPI等。

在编译MPI程序之前,需要确保已经正确安装了MPI编译器和相关的库文件。

编译MPI程序的指令通常为:```mpiicc -o program program.c```其中,`mpiicc`是MPI编译器的命令,`-o program`指定输出的可执行文件名为`program`,`program.c`是要编译的MPI程序源代码文件。

运行MPI程序的指令通常为:```mpiexec -n <进程数> ./program```其中,`mpiexec`是MPI程序运行的命令,`-n <进程数>`指定运行时的进程数,`./program`指定要运行的MPI可执行文件。

在MPI程序中,可以使用MPI库中的函数来实现进程间的通信和协调。

常用的MPI函数包括`MPI_Init`、`MPI_Finalize`、`MPI_Comm_size`、`MPI_Comm_rank`、`MPI_Send`、`MPI_Recv`等。

这些函数可以实现进程的初始化、获取进程数和进程编号、发送和接收消息等功能。

MPI程序的运行流程一般为:1. 所有进程调用`MPI_Init`进行初始化。

2. 调用`MPI_Comm_size`获取进程总数,调用`MPI_Comm_rank`获取当前进程编号。

3. 根据进程编号的不同,执行不同的代码逻辑。

4. 进程间需要通信时,使用`MPI_Send`和`MPI_Recv`进行消息的发送和接收。

5. 所有进程执行完毕后,调用`MPI_Finalize`进行清理工作。

MPI程序的并行计算模型是基于消息传递的,即进程之间通过发送和接收消息来实现数据的交换和协同计算。

mpirun原理

mpirun原理

mpirun是MPI程序的启动命令,它可以启动多个进程,各进程之间可以进行通信和协作,以完成某一特定任务。

mpirun的原理如下:

1. 确定需要启动的进程数和进程的位置:mpirun根据用户设定的进程数和进程位置,确定需要启动的进程数量和每个进程在哪台机器上运行。

2. 创建通信通道:每个进程都需要一个通信通道,以便与其他进程通信。

mpirun会在所有进程之间创建一条通信通道,以确保数据可以快速传递。

3. 启动进程:mpirun启动所有进程,并在每个进程中初始化MPI环境,以确保所有进程可以相互通信和协作。

4. 进行通信和协作:进程之间可以通过MPI库进行通信和协作。

通过收集计算结果和汇总进程间数据等方式,实现MPI并行计算。

5. 结束进程:计算结束后,mpirun会向所有进程发送终止信号,以便各进程可以完成清理操作并退出MPI环境。

综上,mpirun通过创建通信通道和启动多个进程,实现MPI并行计算,有效地提升了计算效率和可扩展性。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

– 从进程:

• 计算所分到的行与一维矩阵的积 • 当从进程计算完成时如果矩阵还有行没有被分配继续向主进程 提起分配请求

二 进程间通信的程序设计

四 实验步骤

2 通过mpicc编译和链接生成可执行文件

– $mpicc -o matvec.o -l m matvec1.c

3 通过mpirun运行matvec.o查看输出结果

二 进程间通信的程序设计

35~57MPI程序的初始化

• 35 MPI_Init ( &argc, &argv ); – MPI程序初始化 • 37 elapsed_time = -MPI_Wtime(); – 记录程序开始的时间以便以后统计程序运行时间 • 41 ierr = MPI_Comm_rank ( MPI_COMM_WORLD, &my_id ); – 获取本进程的id • 45 ierr = MPI_Comm_size ( MPI_COMM_WORLD, &num_procs ); – 获取进程数

一 MPI进程间通信基本概念

• 基础函数

– 同步

int MPI_Barrier(MPI_Comm comm) comm 进程所在通信域

MPI_BARRIER阻塞所有的调用者直到所有的组成员 都调用了它,各个进程中这个调用才可以返回。

一 MPI进程间通信基础

• 预定义数据类型

MPI预定义数据类型 C数据类型

– 一类进程的集合,且在该集合内,进程间可以 相互通信; – 任何MPI通信函数均必须在某个通信域内发生; – MPI缺省的通信域MPI_COMM_WORLD,所 有启动的MPI进程通过调用函数MPI_Init(),包 含在该通信域内; – 各进程通过函数MPI_Comm_size()获取通信域 包含的(初始启动)的MPI进程个数;

一 MPI进程间通信基本概念

• 基础函数

– 消息发送 int MPI_Send(void* buf, int count, MPI_Datatype datatype, int dest, int tag, MPI_Comm comm)

buf 发送缓冲区的起始地址 count 将发送的数据的个数 datatype 发送数据的数据类型 dest 目的进程标识号 tag 消息标志 comm 通信域

一 MPI进程间通信基本概念

• 基础函数 – 通信域包含的进程数

int MPI_Comm_size(MPI_Comm comm, int *size)

comm 进程所在通信域 size 返回通信域内进程数

这一调用返回给定的通信域中所包括的进程的个数,不同的进程 通过这一调用得知在给定的通信域中一共有多少个进程在并行执 行。

– 主进程分配矩阵,及运算结果的内存空间

二 进程间通信的程序设计

– 主进程:

• • • • • • • • • • 71 for ( i = 1; i <= m; i++ ) 72 { 73 for ( j = 1; j <= n; j++ ) 74 { 75 a[k] = sqrt ( 2.0 / ( double ) ( n + 1 ) ) 77 * ( ( double ) ( i * j ) * pi / ( double ) ( n + 1 ) ); 79 fflush(stdout); 80 k = k + 1; 81 } 82 } – 初始化矩阵的值

M*1

按行分解

二 进程间通信的程序设计

三 实验原理

矩阵乘法被分 解为了M个任 务,可以分别 交给各个进程 运算然后进行 汇总

a

b . c ×

d

e .

f ×

. . .

a b c . . d a b c . . d

一 MPI进程间通信基础

• 程序设计模式

– 对等模式

• 对等模式中,各个进程的地位相同。功能和代码基 本一致,只是处理的数据或对象不同 ,比如我们之 前看到的helloworld程序

– 主从模式

• 有一个进程居于主导地位,由它控制、协调其他. 进 程完成计算. 比如本实验要设计的程序。

二 进程间通信的程序设计

实验三 MPI程序进程间的通信

一 MPI进程间通信基本概念

• MPI是一种消息传递模型,驻留在不同处理 器上的进程通过传递消息相互通信,从而 实现不同进程间的数据互访。 • MPI是一种标准或规范,它的实现包括 MPICH、LAM、IBM MPL等多个版本 • MPI虽然很庞大,但是它的最终目的是实现 进程间的通信

MPI_CHAR

MPI_SHORT MPI_INT

signed char

signed short int signed int

MPI_LONG

MPI_FLOAT MPI_DOUBLE MPI_LONG_DOUBLE

signed long int

float double long double

一 MPI进程间通信基础

MPI_Finalize是MPI程序的最后一个调用,它结束MPI 程序的运行,它是MPI程序的最后一条可执行语句。

一 MPI进程间通信基本概念

• 基础函数

– 当前进程标识 int MPI_Comm_rank(MPI_Comm comm, int *rank)

comm 进程通信域 rank 返回进程在通信域中的标识 这一调用返回调用进程在给定的通信域中的进程标识 号,有了这一标识号不同的进程就可以将自身和其它 的进程区别开来,实现各进程的并行和协作。

一 MPI进程间通信基本概念

• 基础函数 – MPI初始化

int MPI_Init(int *argc, char ***argv)

MPI_Init是MPI程序的第一个调用,它完成MPI程序所 有的初始化工作,所有MPI程序 的第一条可执行语 句都是这条语句。

– MPI结束

int MPI_Finalize(void)

一 MPI进程间通信基本概念

•

基础函数

– 消息接收 int MPI_Recv(void* buf, int count, MPI_Datatype datatype, int source, int tag,MPI_Comm comm, MPI_Status *status)

buf 接收缓冲区的起始地址 count 最多可接收的数据的个数 datatype 接收数据的数据类型 source 接收数据的来源即发送数据的进程的进程标识号 tag 消息标识与相应的发送操作的表示相匹配相同 comm 本进程和发送进程所在的通信域 status 返回状态

– $mpirun –np 4 ./matvec.o

二 进程间通信的程序设计

五 进程间通信的示意图

MPI_Init 主进程 生成矩阵 从进程 从进程

…

从进程

将用于相乘的一维矩 阵广播給各从进程

二 进程间通信的程序设计

主进程 从进程

.

.

. .

从进程

发送矩阵的 一行

运算与一维矩阵的积并返回给主进程 Y 是否还有未 发送的行? N: 发送 带完成标 记的消息 打印结果

一 实验目的 • 1 理解MPI程序设计中进程的通信方式 • 2 运用MPI的计时器功能测定程序运行时间 二 实验要求 设计两个矩阵相乘的并行程序,通过对矩 阵按行分解实现并行计算。

二 进程间通信的程序设计

三 实验原理

a b . d e . . . . h i l

M*N

矩阵乘法

c f k j

• 预定义数据类型

MPI预定义数据类型 MPI_UNSIGNED_CHAR C数据类型 unsigned char

MPI_UNSIGNED_SHORT unsigned short int MPI_UNSIGNED MPI_UNSIGNED_LONG unsigned int unsigned long int

一 MPI进程间通信基本概念

• 消息的构成

– MPI消息包括信封和数据两个部分

• • • • 信封指出了发送或接收消息的对象及相关信息而 数据是本消息将要传递的内容 信封:<源/目><标识><通信域> 数据:<起始地址><数据个数>数据类型>

一 MPI进程间通信基本概念

• 通信域(Communicator):

MPI_Finalize()

二 进程间通信的程序设计

六 参考程序简要说明:

1~32声明头文件及变量:

• • • • • • • • double *a 声明矩阵 double *a_row 矩阵里面的一行 double ans 缓存被乘数矩阵一行与一维矩阵的积 double *x 声明一维矩阵 double *b 矩阵相乘的结果 int dest 发送消息的目的进程标识 int master = 0 主进程 MPI_Status status 声明MPI_status类型由于记录消息传递状 态信息 • Int tag 声明消息标记 • int tag_done = 1000 将标记1000作为任务完成的标记 •

a b c . . d

a b c . . d

矩阵乘法

z2

d*a+e*b+….+f*d =

d

e .

f ×

zm

h*a+i*b+….+j*d

=

h

i l

×

a b c . . d

N*1

=