百度蜘蛛

两招教你如何分辨百度蜘蛛

3、 在mac os平台下,您可以使入dig xxx.xxx.xxx.xxx(IPaidu.jp 即为冒充。

其实站长可以通过DNS反查inux/win dows/os三种平台下的验证方法分别如下: 1、在linux平台下,您可以使用hs平台或者IBM OS/2平台下,您可以使用nsloo 入nslookup xxx.xxx.xxx.xxx(IP是网上流传的一所谓的降权蜘蛛, 和沙盒蜘蛛,这些也是一些子无须有的一些东西, 官方曾经也说过,这些东西是不存在的。

ຫໍສະໝຸດ 通过网站日志可以直接看出网站是不是有蜘蛛进 行抓取了,抓取多少,抓取状态码是多少。 如上图中就可以看见spider蜘蛛对网站进 行了爬取。

结合网络日志和蜘蛛的爬取情况可以对网站的内 容进行适当的调整,对于整个seo来说有着相当 重要的作用。

搜索引擎蜘蛛是一种通俗的叫法,一般指的是一 种小程序,这种小程序是用来抓取网上的资源的。

搜索引擎不同蜘蛛的名称也不同,有的叫做蜘蛛, 有的叫做机器人,不下是看不到 蜘蛛的踪影的,但是通过一些手段或者是工具就 可以看到蜘蛛的一些情况,便于更好的掌握搜索 引擎对于网站的抓取情况。

百度蜘蛛爬行原理

百度蜘蛛爬行原理百度蜘蛛,是百度搜索引擎的一个自动程序。

它的作用是访问收集整理互联网上的网页、图片、视频等内容,然后分门别类建立索引数据库,使用户能在百度搜索引擎中搜索到您网站的网页、图片、视频等内容。

(1)通过百度蜘蛛下载回来的网页放到补充数据区,通过各种程序计算过后才放到检索区,才会形成稳定的排名,所以说只要下载回来的东西都可以通过指令找到,补充数据是不稳定的,有可能在各种计算的过程中给k掉,检索区的数据排名是相对比较稳定的,百度目前是缓存机制和补充数据相结合的,正在向补充数据转变,这也是目前百度收录困难的原因,也是很多站点今天给k了明天又放出来的原因。

(2)深度优先和权重优先,百度蜘蛛抓页面的时候从起始站点(即种子站点指的是一些门户站点)是广度优先抓取是为了抓取更多的网址,深度优先抓取的目的是为了抓取高质量的网页,这个策略是由调度来计算和分配的,百度蜘蛛只负责抓取,权重优先是指反向连接较多的页面的优先抓取,这也是调度的一种策略,一般情况下网页抓取抓到40%是正常范围,60%算很好,100%是不可能的,当然抓取的越多越好。

百度蜘蛛在从首页登陆后抓取首页后调度会计算其中所有的连接,返回给百度蜘蛛进行下一步的抓取连接列表,百度蜘蛛再进行下一步的抓取,网址地图的作用是为了给百度蜘蛛提供一个抓取的方向,来左右百度蜘蛛去抓取重要页面,如何让百度蜘蛛知道那个页面是重要页面?可以通过连接的构建来达到这个目的,越多的页面指向该页,网址首页的指向,副页面的指向等等都能提高该页的权重,地图的另外一个作用是给百度蜘蛛提供更多的链接来达到抓去更多页面的目的,地图其实就是一个链接的列表提供给百度蜘蛛,来计算你的目录结构,找到通过站内连接来构建的重要页面。

补充数据到主检索区的转变:在不改变板块结构的情况下,增加相关连接来提高网页质量,通过增加其他页面对该页的反向连接来提高权重,通过外部连接增加权重。

如果改变了板块结构将导致seo的重新计算,所以一定不能改变板块结构的情况下来操作,增加连接要注意一个连接的质量和反向连接的数量的关系,短时间内增加大量的反向连接将导致k站,连接的相关性越高,对排名越有利。

蜘蛛形态特征

蜘蛛形态特征一、外形特征蜘蛛是节肢动物中的一种,它们有着独特的外形特征。

首先,蜘蛛的身体通常分为两个部分:前体和后体。

前体是蜘蛛的头部,它上面有一对复眼和一对小型的简单眼,用于感知周围的环境。

蜘蛛的嘴部位于头部的前端,可以用来咀嚼食物。

后体是蜘蛛的背部,上面有一个背板,可以提供保护作用。

二、腿部结构蜘蛛有八条腿,这是它们最明显的特征之一。

腿部是蜘蛛用来行走和捕捉猎物的重要工具,因此它们的结构非常精巧。

蜘蛛的腿部由七个关节组成,每个关节之间都可以自由弯曲。

在蜘蛛的腿部上,还有一些细小的毛发,这些毛发可以帮助它们感知周围的环境和捕捉猎物。

三、蜘蛛网蜘蛛网是蜘蛛的标志性特征之一,它们用来捕捉猎物和筑巢。

蜘蛛网的形状和结构因蜘蛛的种类而异,但总体上都是由丝线组成的。

蜘蛛的腹部上有一对腺体,可以分泌出丝线。

蜘蛛用丝线在空气中拉扯,形成网状结构。

蜘蛛网的丝线非常坚韧,可以承受很大的拉力。

四、体色和斑纹蜘蛛的体色和斑纹也是它们的形态特征之一。

不同种类的蜘蛛体色和斑纹各不相同,有的蜘蛛身上呈现出明亮的颜色,有的则相对暗淡。

斑纹的形状和颜色也因蜘蛛的种类而异,有的蜘蛛身上有明显的斑点和条纹,有的则呈现出复杂的花纹。

这些体色和斑纹对于蜘蛛的保护和伪装起着重要的作用。

五、触角和口器蜘蛛的头部上有一对触角和一对口器,它们是蜘蛛用来感知和获取食物的重要工具。

触角帮助蜘蛛感知周围的环境,口器则用来咀嚼食物。

蜘蛛的口器通常由一对螯肢和一对小型的螯肢组成,可以用来抓取和咀嚼猎物。

六、大小和体重蜘蛛的大小和体重因种类而异。

有的蜘蛛非常小,只有几毫米长,而有的则非常大,体长可达数厘米。

体重也因蜘蛛的大小和种类而有所不同,有的蜘蛛非常轻盈,有的则相对较重。

蜘蛛的大小和体重对于它们的生活习性和捕食方式有着重要的影响。

七、生殖器官蜘蛛的生殖器官也是它们的形态特征之一。

蜘蛛的雄性和雌性生殖器官通常位于腹部的末端。

雄性蜘蛛的生殖器官较小,常常呈现出特殊的形状。

百度蜘蛛七大特性

百度蜘蛛七大特性想要做好百度优化就必须先养好百度蜘蛛!那么如何饲养百度蜘蛛呢?!下面小李子和大家分享百度蜘蛛七大特性!第一:蜘蛛人嗅觉很强而且非常在乎第一印象。

一般空间开通以后只要里面有了内容蜘蛛人就会嗅到,并且前来拜访.所以新站会很快在百度中搜到,虽然这个时候排名不好但是说明蜘蛛人开始注意你了所以要有耐心。

关键字是蜘蛛认识你的网站的第一印象,就是你的网站的门牌号,网站关键自定下来就是板上钉钉,除了地球灭亡以外不要轻易改动。

蜘蛛第一次来到你的网站就会记下这个门牌号,但是他不会进你家大门,顶多是只会收录你的首页。

因为这个时候蜘蛛对你这个新面孔不熟悉.像人一样不会轻易去一个陌生的人家做客,只有常来常往彼此熟悉了才能获得彼此信任,蜘蛛人虽然又走了,但是他记下了你的门牌号,还拍了照,因为他还会来的,蜘蛛人什么时候回来直接取决于你的更新频率和内容如何。

第二:蜘蛛人一根筋而很容易生气比如我的网站关键字是“潍坊培训网”蜘蛛人对你的网站的第一印象是“潍坊培训网”那么他就会牢牢记住这个词,但是这个期间你发现关键字想修改一下于是改成了“潍坊教育培训网”,当蜘蛛人在来到你的网站时候发现和他所记住的不一样了,但是地址是对的,你的网址不变,那么你的网站就会给蜘蛛人造成了可以磨灭但是不友好印象,他会认为你三心二意,这么短的时间内旧换掉了门牌号是不是不喜欢让我记住呢?蜘蛛人会很生气,后果很严重,但是他也会记住这个“潍坊教育培训网”,因为这是他的职责,但是和第一次不同的是之主要压低你的排名,观察一段时间,防止你再次改动,等你稳定了他才会放松对你的警惕。

第三,蜘蛛人喜欢猎奇和分享和人一样如果一家经常出一些新鲜事那么就会吸引很多好奇的人来你们家看热闹,而蜘蛛恰恰是最喜欢猎奇的,他没见过的事物会很快收入囊中。

蜘蛛人整天游荡在互联网上有很大一部分工作就是在猎奇,找一些他以前没见过的东西摆在自己的货架上。

当然,蜘蛛人最主要的爱好还是与他人分享,一般新找到的好东西都会排在货架的靠前位置,为了让自己的新发现尽快让其他人知道,当有人搜索相关事物信息时蜘蛛人就会将他认为最匹配的比较新的事物靠前放从而呈献给需要他的人,这也是蜘蛛人最大的快乐和职责所在!第四:蜘蛛人记忆功能很强当蜘蛛人猎奇回来他会讲他所猎获的内容一字不差的背下来,以防止下次猎到相同的内容浪费了资源和精力,所以蜘蛛人的记忆力是很强的,过多的毫无异样的重复内容会使蜘蛛人反感,他会认为这些重复的内容都是从他第一次猎奇的地方抄袭过来的,所以他只会推荐第一次猎奇所去过的网站,当然蜘蛛人也不是死记硬背的,随着蜘蛛人的不断发育健全,你即使做一下修改他也会觉察到的!但是总比一字不差的抄袭强很多!第五:蜘蛛人很有耐性而且喜欢开玩笑路遥知马力日久见站心!别看蜘蛛人年纪轻轻但是他很有耐性,蜘蛛人不是那么容易哄的,不要以为你的网站上线好几个月了而且都是新鲜内容蜘蛛就会请来你把你排名靠前,如果你没有做蜘蛛人反感的事情,那你就耐心点,只要你的内容让蜘蛛人抓去起来匹配度较高而且方便快捷又新鲜那么蜘蛛人会安排你的站向前靠!蜘蛛人有时会和你开玩笑,而且还是很大的玩笑,今天早上你的网站关键字居然排到了首页,你好一阵高兴,但是第二天早上你回发现排名跑道了第四页!不要灰心,着说明你已经具备了冲击第一页甚至是排名第一的潜力,继续按制定计划努力,和快你就会稳定的出现在第一页了!第六:蜘蛛人也是势利眼同样一篇文章,发到你的网站上和发到新浪网上不论是搜索排名还是收录时间你都不如新浪好,所以你要傍上这棵大树,因为大树底下好乘凉!那么目前最好的办法就是在这些网站建立博客,吸引蜘蛛人,因为蜘蛛人也是势利眼!这么大牌的门户网站蜘蛛可不敢怠慢.一般一篇文章在博客上不要写完,写前面一部分但是这一部分要加上关键字,然后加上你的网站完整文章的连接,这样蜘蛛人就会顺藤摸瓜找到你的站!第七:蜘蛛人相信群众的眼睛当用户搜索关键词的时候蜘蛛人会快速反映,在抓取得过程中蜘蛛人发现某一个网址出现的次数很多而且出现的场合覆盖面很广甚至在一些著名的网站上也出现了,那么蜘蛛人就会认为这个网站肯定很受欢迎,要不怎么会有这么多网站留下了他的网只同时指向着个网站呢,所以他也会将这个网站向前提名,以符合网民的需求.其实这就是我们常说的外链.所以我们要在我们去过的地方尽量留下痕迹这样也会吸引蜘蛛来我们的网站做客!。

百度搜索引擎蜘蛛IP大全

SEO进阶:各类百度蜘蛛IP到访的意义虽然百度近期表态百度并没有降权蜘蛛这一说,但是据优骑士旗下多个站点的百度蜘蛛抓取日志及众多网友的讨论,感觉不同的百度蜘蛛IP代表的意义还是有所不同的,另外近期多个站长工具的IP也冒充百度蜘蛛,引起SEO新人不必要的恐慌与浪费不必要的经历,本文就详细说明下大部分百度蜘蛛IP的区别!123.125.68.*这个蜘蛛经常来,别的来的少,表示网站可能要进入沙盒了,或被者降权。

220.181.68.*每天这个IP 段只增不减很有可能进沙盒或K站。

220.181.7.*、123.125.66.* 代表百度蜘蛛IP造访,准备抓取你东西。

121.14.89.*这个ip段作为度过新站考察期。

203.208.60.*这个ip段出现在新站及站点有不正常现象后。

210.72.225.*这个ip段不间断巡逻各站。

125.90.88.* 广东茂名市电信也属于百度蜘蛛IP 主要造成成分,是新上线站较多,还有使用过站长工具,或SEO综合检测造成的。

220.181.108.95这个是百度抓取首页的专用IP,如是220.181.108段的话,基本来说你的网站会天天隔夜快照,绝对错不了的,我保证。

220.181.108.92 同上98%抓取首页,可能还会抓取其他(不是指内页)220.181段属于权重IP段此段爬过的文章或首页基本24小时放出来。

123.125.71.106 抓取内页收录的,权重较低,爬过此段的内页文章不会很快放出来,因不是原创或采集文章。

220.181.108.91属于综合的,主要抓取首页和内页或其他,属于权重IP 段,爬过的文章或首页基本24小时放出来。

220.181.108.75重点抓取更新文章的内页达到90%,8%抓取首页,2%其他。

权重IP 段,爬过的文章或首页基本24小时放出来。

220.181.108.86专用抓取首页IP 权重段,一般返回代码是304 0 0 代表未更新。

百度蜘蛛爬行原理

百度蜘蛛爬行原理百度蜘蛛,是百度搜索引擎的一个自动程序。

它的作用是访问收集整理互联网上的网页、图片、视频等内容,然后分门别类建立索引数据库,使用户能在百度搜索引擎中搜索到您网站的网页、图片、视频等内容蜘蛛抓取第一步爬行和抓取爬行到你的网站网页,寻找合适的资源。

蜘蛛它有一个特性,那就是他的运动轨迹通常都是围绕着蜘蛛丝而走的,而我们之所以将搜索引擎的机器人命名为蜘蛛其实就是因为这个特性。

当蜘蛛来到你的网站之后,它就会顺着你网站中的链接(蜘蛛丝)不断的进行爬行,因此如何让蜘蛛能够更好的在你的网站中进行爬行就成为了我们的重中之重。

抓取你的网页。

引导蜘蛛的爬行这只是一个开始,一个好的开始意味着你将有一个高起点。

通过自己的内链设计,使得网站中不存在任何死角,蜘蛛可以轻松的到达网站中的每一个页面,这样蜘蛛在进行第二步工作——抓取的时候,将会事半功倍。

而在这一步抓取的过程中我们又需要注意的就是要精简网站的结构,将那些不必要、不需要的多余代码去掉,因为这些都将会影响蜘蛛抓取网页的效率与效果。

另外还需要大家注意的事情就是通过我们都不建议网站中放入FLASH,因为蜘蛛对于FLASH是不好抓取的,过多的FLASH会导致蜘蛛放弃抓取你网站的页面。

蜘蛛抓取第二步存储抓取了链接所对应的页面,会把这些页面的内容存储到搜索引擎的原始数据库里面。

会抓取一些文本内容。

网站在优化的时候不要盲目的给网站添加一些图片或者动画flash文件。

这样不利搜索引擎的抓取。

这类对排没有太大价值,应该多做内容。

抓取到搜索引擎原始数据中,不代表你的网站内容就一定会被百度采纳。

搜索引擎还需要再进行下一步处理。

蜘蛛抓取第三步预处理搜索引擎主要还是以(文字)为基础。

JS,CSS程序代码是无法用于排名。

蜘蛛将第一步中提取的文字进行拆分重组,组成新的单词。

去重处理(去掉一些重复的内容,搜索引擎数据库里面已经存在的内容)要求我们在做SEO优化的人员在优化网站内容的不能完全抄袭别人的站点内容。

百度蜘蛛抓取规则

百度蜘蛛抓取规则百度蜘蛛抓取规则要想网站排名得让网站收录,要想网站收录得让百度蜘蛛抓取,要想让百度蜘蛛抓取得懂百度蜘蛛抓取规则,下面是YJBYS店铺整理的百度蜘蛛抓取规则详解介绍,希望对你有帮助!一、百度蜘蛛抓取规则1、对网站抓取的友好性百度蜘蛛在抓取互联网上的信息时为了更多、更准确的获取信息,会制定一个规则最大限度的利用带宽和一切资源获取信息,同时也会仅最大限度降低对所抓取网站的.压力。

2、识别url重定向互联网信息数据量很庞大,涉及众多的链接,但是在这个过程中可能会因为各种原因页面链接进行重定向,在这个过程中就要求百度蜘蛛对url重定向进行识别。

3、百度蜘蛛抓取优先级合理使用由于互联网信息量十分庞大,在这种情况下是无法使用一种策略规定哪些内容是要优先抓取的,这时候就要建立多种优先抓取策略,目前的策略主要有:深度优先、宽度优先、PR优先、反链优先,在我接触这么长时间里,PR优先是经常遇到的。

4、无法抓取数据的获取在互联网中可能会出现各种问题导致百度蜘蛛无法抓取信息,在这种情况下百度开通了手动提交数据。

5、对作弊信息的抓取在抓取页面的时候经常会遇到低质量页面、买卖链接等问题,百度出台了绿萝、石榴等算法进行过滤,据说内部还有一些其他方法进行判断,这些方法没有对外透露。

上面介绍的是百度设计的一些抓取策略,内部有更多的策略咱们是不得而知的。

二、百度蜘蛛抓取过程中涉及的协议1、http协议:超文本传输协议。

2、https协议:目前百度已经全网实现https,这种协议更加安全。

3、robots协议:这个文件是百度蜘蛛访问的第一个文件,它会告诉百度蜘蛛,哪个页面可以抓取,哪个不可以抓取。

三、如何提高百度蜘蛛抓取频次百度蜘蛛会根据一定的规则对网站进行抓取,但是也没法做到一视同仁,以下内容会对百度蜘蛛抓取频次起重要影响。

1、网站权重:权重越高的网站百度蜘蛛会更频繁和深度抓取。

2、网站更新频率:更新的频率越高,百度蜘蛛来的就会越多。

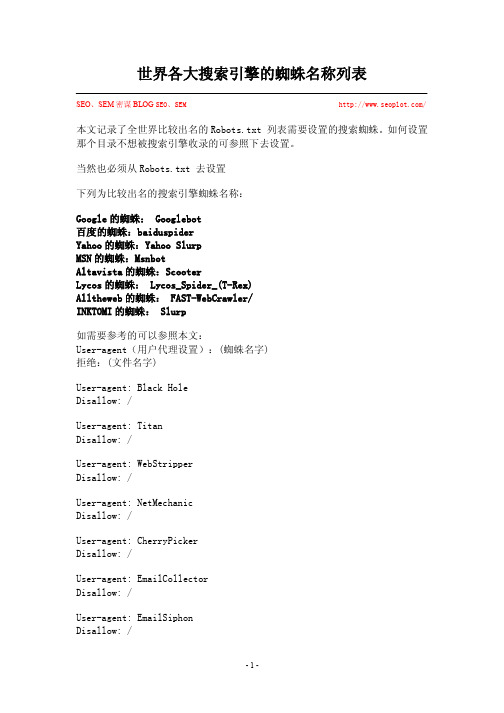

世界各大搜索引擎的蜘蛛名称列表

世界各大搜索引擎的蜘蛛名称列表SEO、SEM密谋BLOG SEO、SEM /本文记录了全世界比较出名的Robots.txt 列表需要设置的搜索蜘蛛。

如何设置那个目录不想被搜索引擎收录的可参照下去设置。

当然也必须从Robots.txt 去设置下列为比较出名的搜索引擎蜘蛛名称:Google的蜘蛛: Googlebot百度的蜘蛛:baiduspiderYahoo的蜘蛛:Yahoo SlurpMSN的蜘蛛:MsnbotAltavista的蜘蛛:ScooterLycos的蜘蛛: Lycos_Spider_(T-Rex)Alltheweb的蜘蛛: FAST-WebCrawler/INKTOMI的蜘蛛: Slurp如需要参考的可以参照本文:User-agent(用户代理设置):(蜘蛛名字)拒绝:(文件名字)User-agent: Black HoleDisallow: /User-agent: TitanDisallow: /User-agent: WebStripperDisallow: /User-agent: NetMechanicDisallow: /User-agent: CherryPickerDisallow: /User-agent: EmailCollectorDisallow: /User-agent: EmailSiphonDisallow: /Disallow: /User-agent: EmailWolfDisallow: /User-agent: ExtractorProDisallow: /User-agent: CopyRightCheckDisallow: /User-agent: CrescentDisallow: /User-agent: NICErsPRODisallow: /User-agent: WgetDisallow: /User-agent: SiteSnaggerDisallow: /User-agent: ProWebWalkerDisallow: /User-agent: CheeseBotDisallow: /User-agent: mozilla/4Disallow: /User-agent: mozilla/5Disallow: /User-agent: Mozilla/4.0 (compatible; MSIE 4.0; Windows NT) Disallow: /User-agent: Mozilla/4.0 (compatible; MSIE 4.0; Windows 95) Disallow: /User-agent: Mozilla/4.0 (compatible; MSIE 4.0; Windows 9 Disallow: /Disallow: /User-agent: ia_archiver/1.6 Disallow: /User-agent: Alexibot Disallow: /User-agent: Teleport Disallow: /User-agent: TeleportPro Disallow: /User-agent: WgetDisallow: /User-agent: MIIxpc Disallow: /User-agent: Telesoft Disallow: /User-agent: Website Quester Disallow: /User-agent: WebZip Disallow: /User-agent: moget/2.1 Disallow: /User-agent: WebZip/4.0 Disallow: /User-agent: WebStripper Disallow: /User-agent: WebSauger Disallow: /User-agent: WebCopier Disallow: /User-agent: NetAntsDisallow: /User-agent: Mister PiXDisallow: /User-agent: WebAutoDisallow: /User-agent: TheNomadDisallow: /User-agent: WWW-Collector-EDisallow: /User-agent: RMADisallow: /User-agent: libWeb/clsHTTPDisallow: /User-agent: asteriasDisallow: /User-agent: turingosDisallow: /User-agent: spannerDisallow: /User-agent: InfoNaviRobotDisallow: /User-agent: Harvest/1.5Disallow: /User-agent: ExtractorProDisallow: /User-agent: Bullseye/1.0Disallow: /User-agent: Mozilla/4.0 (compatible; BullsEye; Windows 95) Disallow: /User-agent: Crescent Internet ToolPak HTTPOLE Control v.1.0 Disallow: /User-agent: CherryPickerSE/1.0Disallow: /User-agent: CherryPickerElite/1.0Disallow: /User-agent: WebBandit/3.50Disallow: /User-agent: NICErsPRODisallow: /User-agent: Microsoft URL Control - 5.01.4511 Disallow: /User-agent: DittoSpyderDisallow: /User-agent: FoobotDisallow: /User-agent: WebmasterWorldForumBotDisallow: /User-agent: SpankBotDisallow: /User-agent: BotALotDisallow: /User-agent: lwp-trivial/1.34Disallow: /User-agent: lwp-trivialDisallow: /User-agent: BunnySlippersDisallow: /User-agent: Microsoft URL Control - 6.00.8169 Disallow: /User-agent: URLy WarningDisallow: /User-agent: WgetDisallow: /User-agent: Wget/1.5.3 Disallow: /User-agent: LinkWalker Disallow: /User-agent: cosmosDisallow: /User-agent: mogetDisallow: /User-agent: hloaderDisallow: /User-agent: humanlinks Disallow: /User-agent: LinkextractorPro Disallow: /User-agent: Offline Explorer Disallow: /User-agent: Mata Hari Disallow: /User-agent: LexiBotDisallow: /User-agent: Offline Explorer Disallow: /User-agent: Web Image Collector Disallow: /User-agent: The Intraformant Disallow: /User-agent: True_Robot/1.0 Disallow: /User-agent: True_RobotDisallow: /User-agent: BlowFish/1.0Disallow: /User-agent: JennyBotDisallow: /User-agent: MIIxpc/4.2Disallow: /User-agent: BuiltBotToughDisallow: /User-agent: ProPowerBot/2.14Disallow: /User-agent: BackDoorBot/1.0Disallow: /User-agent: toCrawl/UrlDispatcherDisallow: /User-agent: WebEnhancerDisallow: /User-agent: TightTwatBotDisallow: /User-agent: suzuranDisallow: /User-agent: VCI WebViewer VCI WebViewer Win32 Disallow: /User-agent: VCIDisallow: /User-agent: Szukacz/1.4Disallow: /User-agent: QueryN MetasearchDisallow: /User-agent: Openfind data gathereDisallow: /User-agent: OpenfindDisallow: /User-agent: Xenu's Link Sleuth 1.1c Disallow: /User-agent: Xenu'sDisallow: /User-agent: ZeusDisallow: /User-agent: RepoMonkey Bait & Tackle/v1.01 Disallow: /User-agent: RepoMonkeyDisallow: /User-agent: Zeus 32297 Webster Pro V2.9 Win32 Disallow: /User-agent: Webster ProDisallow: /User-agent: EroCrawlerDisallow: /User-agent: LinkScan/8.1a Unix Disallow: /User-agent: Kenjin SpiderDisallow: /User-agent: Keyword Density/0.9Disallow: /User-agent: Kenjin SpiderDisallow: /User-agent: CegbfeiehDisallow: /Different:User-agent: larbin Disallow: /User-agent: b2w/0.1 Disallow: /User-agent: Copernic Disallow: /User-agent: psbot Disallow: /User-agent: Python-urllib Disallow: /User-agent: NetMechanic Disallow: /User-agent: URL_Spider_Pro Disallow: /User-agent: CherryPicker Disallow: /User-agent: EmailCollector Disallow: /User-agent: EmailSiphon Disallow: /User-agent: WebBandit Disallow: /User-agent: EmailWolf Disallow: /User-agent: ExtractorPro Disallow: /User-agent: CopyRightCheck Disallow: /User-agent: Crescent Disallow: /User-agent: SiteSnagger Disallow: /User-agent: ProWebWalker Disallow: /User-agent: CheeseBot Disallow: /User-agent: LNSpiderguy Disallow: /User-agent: Mozilla Disallow: /User-agent: mozilla Disallow: /User-agent: mozilla/3 Disallow: /User-agent: mozilla/4 Disallow: /User-agent: mozilla/5 Disallow: /User-agent: WebAuto Disallow: /User-agent: TheNomad Disallow: /User-agent: WWW-Collector-E Disallow: /User-agent: RMADisallow: /User-agent: libWeb/clsHTTP Disallow: /User-agent: httplib Disallow: /Disallow: /User-agent: InfoNaviRobotDisallow: /User-agent: Harvest/1.5Disallow: /User-agent: Crescent Internet ToolPak HTTP OLE Control v.1.0 Disallow: /User-agent: CherryPickerSE/1.0Disallow: /User-agent: CherryPickerElite/1.0Disallow: /User-agent: WebBandit/3.50Disallow: /User-agent: NICErsPRODisallow: /User-agent: DittoSpyderDisallow: /User-agent: FoobotDisallow: /User-agent: BotALotDisallow: /User-agent: lwp-trivial/1.34Disallow: /User-agent: lwp-trivialDisallow: /User-agent: URLy WarningDisallow: /User-agent: hloaderDisallow: /Disallow: /User-agent: LinkextractorPro Disallow: /User-agent: Offline Explorer Disallow: /User-agent: Mata Hari Disallow: /User-agent: LexiBotDisallow: /User-agent: Web Image Collector Disallow: /User-agent: The Intraformant Disallow: /User-agent: True_Robot/1.0 Disallow: /User-agent: True_Robot Disallow: /User-agent: BlowFish/1.0 Disallow: /User-agent: JennyBotDisallow: /User-agent: MIIxpc/4.2 Disallow: /User-agent: BuiltBotTough Disallow: /User-agent: ProPowerBot/2.14 Disallow: /User-agent: BackDoorBot/1.0 Disallow: /User-agent: toCrawl/UrlDispatcherDisallow: /User-agent: WebEnhancerDisallow: /User-agent: suzuranDisallow: /User-agent: VCI WebViewer VCI WebViewer Win32 Disallow: /User-agent: VCIDisallow: /User-agent: Szukacz/1.4Disallow: /User-agent: QueryN MetasearchDisallow: /User-agent: Openfind data gathereDisallow: /User-agent: OpenfindDisallow: /User-agent: Xenu's Link Sleuth 1.1c Disallow: /User-agent: Xenu'sDisallow: /User-agent: ZeusDisallow: /User-agent: RepoMonkey Bait & Tackle/v1.01 Disallow: /User-agent: RepoMonkeyDisallow: /User-agent: OpenbotDisallow: /User-agent: URL ControlDisallow: /User-agent: Zeus Link ScoutDisallow: /User-agent: Zeus 32297 Webster Pro V2.9 Win32 Disallow: /User-agent: EroCrawlerDisallow: /User-agent: LinkScan/8.1a UnixDisallow: /User-agent: Keyword Density/0.9Disallow: /User-agent: Kenjin SpiderDisallow: /User-agent: Iron33/1.0.2Disallow: /User-agent: Bookmark search toolDisallow: /User-agent: GetRight/4.2Disallow: /User-agent: FairAd ClientDisallow: /User-agent: GaisbotDisallow: /User-agent: Aqua_ProductsDisallow: /User-agent: Radiation Retriever 1.1 Disallow: /User-agent: WebmasterWorld Extractor Disallow: /User-agent: Flaming AttackBot Disallow: /User-agent: Oracle Ultra Search Disallow: /User-agent: MSIECrawler Disallow: /User-agent: PerManDisallow: /User-agent: searchpreview Disallow: /User-agent: naverDisallow: /User-agent: dumbotDisallow: /User-agent: Hatena Antenna Disallow: /User-agent: grub-client Disallow: /User-agent: grubDisallow: /User-agent: larbinDisallow: /User-agent: b2w/0.1Disallow: /User-agent: CopernicDisallow: /User-agent: psbotDisallow: /User-agent: Python-urllib Disallow: /User-agent: EmailWolf Disallow: /User-agent: ExtractorPro Disallow: /User-agent: CopyRightCheck Disallow: /User-agent: Crescent Disallow: /User-agent: SiteSnagger Disallow: /User-agent: ProWebWalker Disallow: /User-agent: CheeseBot Disallow: /User-agent: LNSpiderguy Disallow: /User-agent: Mister PiX Disallow: /User-agent: WebAuto Disallow: /User-agent: TheNomad Disallow: /User-agent: WWW-Collector-E Disallow: /User-agent: RMADisallow: /User-agent: httplib Disallow: /User-agent: turingos Disallow: /User-agent: InfoNaviRobotDisallow: /User-agent: Harvest/1.5Disallow: /User-agent: Bullseye/1.0Disallow: /User-agent: Mozilla/4.0 (compatible; BullsEye; Windows 95) Disallow: /User-agent: Crescent Internet ToolPak HTTP OLE Control v.1.0 Disallow: /User-agent: CherryPickerSE/1.0Disallow: /User-agent: CherryPickerElite/1.0Disallow: /User-agent: NICErsPRODisallow: /User-agent: URLy WarningDisallow: /User-agent: humanlinksDisallow: /User-agent: Web Image CollectorDisallow: /User-agent: The IntraformantDisallow: /User-agent: True_Robot/1.0Disallow: /User-agent: True_RobotDisallow: /User-agent: BlowFish/1.0Disallow: /Disallow: /User-agent: MIIxpc/4.2Disallow: /User-agent: BuiltBotToughDisallow: /User-agent: ProPowerBot/2.14Disallow: /User-agent: BackDoorBot/1.0Disallow: /User-agent: toCrawl/UrlDispatcherDisallow: /User-agent: WebEnhancerDisallow: /User-agent: suzuranDisallow: /User-agent: VCI WebViewer VCI WebViewer Win32 Disallow: /User-agent: VCIDisallow: /User-agent: Szukacz/1.4Disallow: /User-agent: QueryN MetasearchDisallow: /User-agent: Openfind data gathereDisallow: /User-agent: OpenfindDisallow: /User-agent: Xenu's Link Sleuth 1.1c Disallow: /Disallow: /User-agent: ZeusDisallow: /User-agent: RepoMonkey Bait & Tackle/v1.01 Disallow: /User-agent: RepoMonkeyDisallow: /User-agent: Microsoft URL ControlDisallow: /User-agent: OpenbotDisallow: /User-agent: URL ControlDisallow: /User-agent: Zeus Link ScoutDisallow: /User-agent: Zeus 32297 Webster Pro V2.9 Win32 Disallow: /User-agent: Webster ProDisallow: /User-agent: EroCrawlerDisallow: /User-agent: LinkScan/8.1a UnixDisallow: /User-agent: Keyword Density/0.9Disallow: /User-agent: Kenjin SpiderDisallow: /User-agent: Iron33/1.0.2Disallow: /User-agent: Bookmark search tool Disallow: /User-agent: GetRight/4.2Disallow: /User-agent: FairAd ClientDisallow: /User-agent: GaisbotDisallow: /User-agent: Aqua_ProductsDisallow: /User-agent: Radiation Retriever 1.1 Disallow: /User-agent: WebmasterWorld Extractor Disallow: /User-agent: Flaming AttackBot Disallow: /User-agent: Oracle Ultra Search Disallow: /User-agent: MSIECrawlerDisallow: /User-agent: PerManDisallow: /User-agent: searchpreviewDisallow: /User-agent: sootleDisallow: /User-agent: esDisallow: /User-agent: Enterprise_Search/1.0 Disallow: /User-agent: Enterprise_SearchDisallow: /编辑:Windear首发:SEO、SEM密谋地址:Html地址:/seo-sem-info/Web-Venture-Capital-Article.html本文来自:SEO、SEM密谋BLOG,广州大为电子科技有限公司作者介绍:Windear(吴伟定)是专门从事研究网站分析,网络市场分析,网站优化,网站策划营销的爱好者!本BLOG将每两天进行发布一篇本人自己的心得!包含有SEO自己心得的教程及SEM网络行销心得!欢迎转载。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

1. 百度蜘蛛的构建的原理。

搜索引擎构建一个调度程序,来调度百度蜘蛛的工作,

让百度蜘蛛去和服务器建立连接下载网页,计算的过程都是通过调度来计算的,

百度蜘蛛只是负责下载网页,目前的搜索引擎普遍使用广布式多服务器多线程的

百度蜘蛛来达到多线程的目的。

2. 百度蜘蛛的运行原理。

百度蜘蛛程序

(1)通过百度蜘蛛下载回来的网页放到补充数据区,通过各种程序计算过后才放到检索区,才会形成稳定的排名,所以说只要下载回来的东西都可以通过指令找到,补充数据是不稳定的,有可能在各种计算的过程中给k掉,检索区的数据排名是相对比较稳定的,百度目前是缓存机制和补充数据相结合的,正在向补充数据转变,这也是目前百度收录困难的原因,也是很多站点今天给k了明天又放出来的原因。

(2)深度优先和权重优先,百度蜘蛛抓页面的时候从起始站点(即种子站点指的是一些门户站点)是百度优先抓取是为了抓取更多的网址,深度优先抓取的目的是为了抓取高质量的网页,这个策略是由调度来计算和分配的,百度蜘蛛只负责抓取,权重优先是指反向连接较多的页面的优先抓取,这也是调度的一种策略,一般情况下网页抓取抓到40%是正常范围,60%算很好,100%是不可能的,当然抓取的越多越好。

百度蜘蛛的工作要素。

百度蜘蛛在从首页登陆后抓取首页后调度会计算其中所有的连接,返回给百度蜘蛛进行下一步的抓取连接列表,百度蜘蛛再进行下一步的抓取,网址地图的作用是为了给百度蜘蛛提供一个抓取的方向,来左右百度蜘蛛去抓取重要页面,如何让百度蜘蛛知道哪个页面是重要页面?可以通过连接的构建来达到这个目的,越多的页面指向该页,网址首页的指向,副页面的指向等等都能提高该页的权重,地图的另外一个作用是给百度蜘蛛提供更多的连接来达到抓去更多页面的目的,地图其实就是一个连接的列表提供给百度蜘蛛,来计算你的目录结构,找到通过站内连接来构建的重要页面。

百度蜘蛛原理的应用。

补充数据到主检索区的转变:在不改变板块结构的情况下,增加相关连接来提高网页质量,通过增加其他页面对该页的反向连接来提高权重,通过外部连接增加权重。

如果改变了板块结构将导致seo的重新计算,所以一定不能改变板块结构的情况下来操作,增加连接要注意一个连接的质量和反向连接的数量的关系,短时间内增加大量的反向连接将导致k 站,连接的相关性越高,对排名越有利。