Repetier Z探测学习笔记

(完整版)机器学习知识点归纳

(完整版)机器学习知识点归纳机器研究知识点归纳机器研究是一门研究如何通过计算机利用数据来实现自动化研究的科学和艺术。

在机器研究中,我们使用算法和数学模型来让计算机从数据中研究并自动提取知识或进行预测。

以下是机器研究的一些重要知识点:1. 监督研究(Supervised Learning)- 监督研究是一种通过已标记的数据集来训练机器研究模型的方法。

模型根据输入数据和对应的正确输出进行研究,然后可以用于预测未知数据的输出。

2. 无监督研究(Unsupervised Learning)- 无监督研究是一种从无标记数据中研究的方法。

在无监督研究中,机器研究模型通过寻找数据中的模式和结构来发现隐藏的知识和信息。

3. 强化研究(Reinforcement Learning)- 强化研究是通过试错的方式研究如何做出决策的方法。

在强化研究中,机器研究模型通过与环境进行交互来研究最优的行为策略,以最大化累积奖励。

4. 特征工程(Feature Engineering)- 特征工程是指从原始数据中提取有用的特征以供机器研究模型使用的过程。

良好的特征工程可以显著提高模型的性能。

5. 模型评估与选择(Model Evaluation and Selection)- 在机器研究中,评估模型的性能是非常重要的,以便选择最合适的模型。

通过使用合适的评估指标和交叉验证技术,可以客观地比较不同模型的性能。

6. 过拟合与欠拟合(Overfitting and Underfitting)7. 数据预处理(Data Preprocessing)- 数据预处理是指在机器研究之前对原始数据进行处理和清洗的步骤。

常见的预处理技术包括数据清洗、缺失值处理、特征缩放等。

机器研究领域有很多知识点,上述内容只是其中的一部分。

随着机器研究的发展,新的理论和方法不断涌现。

掌握这些基本知识点可以帮助我们更好地理解和应用机器研究技术。

以上为机器学习知识点的简要归纳,希望对您有所帮助。

randomizesearchcv的用法 -回复

randomizesearchcv的用法-回复【RandomizedSearchCV的用法】:利用随机搜索进行超参数优化在机器学习中,模型的性能往往受到许多因素的影响。

其中,选择合适的超参数是一个非常关键的步骤。

然而,手动调整超参数既耗时又容易陷入局部最优解。

因此,使用自动化的超参数调优方法就显得尤为重要。

本文将介绍如何使用RandomizedSearchCV进行超参数优化。

一、理解RandomizedSearchCVRandomizedSearchCV是scikit-learn库中的一个类,用于实现随机搜索超参数优化。

它通过从给定的分布中随机采样超参数值来进行模型训练和验证,以找到最佳的超参数组合。

二、准备数据集在开始使用RandomizedSearchCV之前,我们需要准备一个数据集。

这里我们使用经典的鸢尾花(Iris)数据集作为示例:pythonfrom sklearn.datasets import load_irisfrom sklearn.model_selection import train_test_splitiris = load_iris()X, y = iris.data, iris.target# 划分训练集和测试集X_train, X_test, y_train, y_test = train_test_split(X, y, test_size=0.2, random_state=42)三、定义模型接下来,我们需要定义一个要进行超参数优化的模型。

这里我们选择K近邻算法(KNeighborsClassifier)作为示例:pythonfrom sklearn.neighbors import KNeighborsClassifiermodel = KNeighborsClassifier()四、确定超参数范围然后,我们需要确定要搜索的超参数范围。

对于K近邻算法,我们可以考虑调整以下两个超参数:1. n_neighbors:邻居的数量。

binarysearch使用方法

binarysearch使用方法Binary search是一种常见的查找算法,它能够在有序的数据集合中快速定位目标元素的位置。

本文将一步一步地介绍binary search的使用方法,帮助读者理解和掌握该算法。

第一步:了解binary search的原理首先,我们需要了解binary search的原理。

Binary search的基本思想是将有序集合分成两部分,然后判断目标元素位于哪个子集合中,再递归地在子集合中继续进行查找,直到找到目标元素或者确定目标元素不存在。

具体地说,如果要在一个已经按升序排列的数组中查找目标元素,那么可以选择数组的中间元素进行比较。

如果目标元素等于中间元素,则直接返回中间元素的位置;如果目标元素小于中间元素,则继续在前半部分子数组中查找;如果目标元素大于中间元素,则继续在后半部分子数组中查找。

通过每次将数组分成两部分,并根据目标元素与中间元素的比较结果确定下一步的查找方向,就可以快速定位目标元素。

第二步:实现binary search算法了解binary search的原理之后,我们需要实现该算法。

下面是一个基于递归的二分查找算法的示例代码(使用Python语言):def binary_search(arr, target):low = 0high = len(arr) - 1while low <= high:mid = (low + high) 2if arr[mid] == target:return midelif arr[mid] < target:low = mid + 1else:high = mid - 1return -1这段代码中,`binary_search`函数接受两个参数:一个有序的数组`arr`和目标元素`target`。

函数中的`low`和`high`分别表示当前子数组的起始和结束位置。

算法使用一个`while`循环来不断调整子数组的范围,直到找到目标元素或确定目标元素不存在。

turiniti ai查重原理

turiniti ai查重原理

Turiniti AI的查重原理是基于自然语言处理技术和机器学习算法。

具体来说,Turiniti AI会通过分析文本中的语法、词汇和

句子结构等特征来理解文本的含义。

然后,它会将文本转化为向量表示,以便进行比较和匹配。

Turiniti AI采用了一种称为"词袋模型"的方法来表示文本。

这

种方法将文本中的每个词语都视为一个独立的特征,并将其转化为一个向量。

然后,通过计算这些向量之间的相似度来判断文本之间的相似程度。

除了词袋模型,Turiniti AI还会利用一些其他的特征来进行比

较和匹配。

例如,它会考虑词语的位置、频率和上下文信息等。

通过综合考虑多个特征,Turiniti AI能够更准确地判断文本之

间的相似度。

此外,Turiniti AI还会使用机器学习算法来提高查重的准确性。

它会通过训练大量的数据来学习不同类型的文本之间的相似度模式,并根据这些模式来判断新的文本是否存在相似之处。

总的来说,Turiniti AI的查重原理是基于自然语言处理和机器

学习的技术,通过分析文本特征、计算相似度和训练模型来实现文本查重功能。

最近邻残差算法

最近邻残差算法

最近邻残差算法(Nearest Neighbor Residuals)是一种用于异常检测的算法。

它的基本思想是通过比较样本点与其最近邻点之间的残差(即差值)来判断样本点是否异常。

具体算法步骤如下:

1. 对于给定的数据集,计算每个样本点与其最近邻点之间的残差,即差值。

2. 根据残差的分布情况,确定一个阈值,将残差大于该阈值的样本点标记为异常点。

3. 可选地,可以使用迭代过程来逐步调整阈值,以获得更好的异常检测效果。

最近邻残差算法的优点是简单易实现,并且不需要事先对数据进行训练。

然而,它也存在一些局限性,比如对于高维数据和密集数据集的处理效果可能不佳,而且对于数据集中异常点密集分布的情况也可能无法有效检测。

因此,在实际应用中,最近邻残差算法通常作为其他异常检测方法的辅助手段,或者与其他方法进行组合使用,以提高异常检测的准确性和鲁棒性。

deep reinforcement learning a brief survey笔记

deep reinforcement learning a brief survey笔记Deep reinforcement learning (DRL) is a subfield of artificial intelligence (AI) that combines deep learning with reinforcement learning techniques. It involves training neural networks to make intelligent decisions in an environment, based on rewards provided for successful actions.In a brief survey on deep reinforcement learning, the following key points were discussed:1. Introduction: The survey started with an introduction to reinforcement learning (RL) and its key components, such as agents, actions, states, and rewards. It also highlighted the challenges faced by traditional RL methods, such as the "curse of dimensionality" and the need for manual feature engineering.2. Deep Q-Network (DQN): The survey discussed the DQN algorithm, which uses deep neural networks to approximate the Q-function in RL. It explained the components of DQN, such as experience replay and target networks, and highlighted its successful applications in various domains, including Atari games.3. Policy Gradient Methods: The survey explored the policy gradient approach, which directly learns a policy function using gradient optimization techniques. It discussed different policy gradient methods, such as REINFORCE, Proximal Policy Optimization (PPO), and Trust Region Policy Optimization (TRPO). The advantages and drawbacks of each method were highlighted.4. Model-based and Planning Methods: The survey explained how model-based RL methods utilize a learned model of the environment to plan future actions. It discussed model-based reinforcement learning algorithms, such as Monte Carlo Tree Search (MCTS) and AlphaGo, and their applications in games and robotics.5. Continuous Control: The survey covered deep reinforcement learning algorithms designed for continuous control tasks. It discussed methods like Deep Deterministic Policy Gradient (DDPG) and Soft Actor-Critic (SAC), which handle continuous action spaces effectively. The limitations and extensions of these algorithms were also discussed.6. Multi-Agent Reinforcement Learning: The survey briefly touched upon multi-agent reinforcement learning (MARL), where multiple agents interact in an environment. It discussed algorithms like Multi-Agent DQN (MADDPG) and AlphaGo Zero, and their applications in cooperative and competitive scenarios.7. Challenges and Future Directions: The survey concluded by discussing the challenges faced by deep reinforcement learning, such as sample inefficiency, robustness, and transfer learning. It also highlighted future research directions, including improved exploration strategies, meta-learning, and multi-task learning. Overall, the survey provided a comprehensive overview of deep reinforcement learning techniques, their applications, and potential research directions. It served as a valuable resource for gaining an understanding of the current state of the field.。

【点云知识点分享】2020.0403知识星球汇总

【点云知识点分享】2020.0403知识星球汇总话题:PCL可视化,最远点采样,配准与匹配来源:知识星球星球ID:每一位热爱分享,共同进步的小伙伴欢迎各位加入免费知识星球,获取更多技术分享,欢迎转发朋友圈分享快乐。

Q星主:pcl中提供了两种可视化的函数分别是PCLVisualizerCloudViewer1.请说出两者有什么区别,相比较之间的优劣。

2.在使用PCLVvisualizer可视化的时候,如图所示,有rgb三个不同颜色坐标系箭头,实际上和xyz是什么样的对应关系?比如r代表x轴正方向吗?3.可视化的时候使用这两句分别代表什么意思?viewer->addCoordinateSystem (1.0);viewer->initCameraParameters ();li鹏-点云配准:我来抛个砖,1.cloudviewer功能更简单,使用方便。

pclvisualizer功能会更强大,至于优劣,就不清楚了。

2.rgb 对应XYZ正方向,使用的是右手坐标系 3. viewer->addCoordinateSystem (1.0)是为了显示坐标系来增强方向感,viewer->initCameraParameters ()通过设置照相机参数使得从默认的角度和方向观察点云。

北理-otto-分类:1. pclvisualizer更强大,基本上都是在用这个3.好像是设置坐标系的大小,设置观察者的角度Leong:点云配准和点云匹配的区别是什么呢?我记得有朋友在群里问过,但是被刷掉了就不记得了。

想在这里问可以留住刘同学-武汉大学回复晨风、如左:点云匹配应该是找到同名特征(点,线,年),点云配准是将点云转换到同一坐标系下。

Q#pcl# 最邻近搜索使用。

王万里:刚刚在使用pcl自带的kd树最近邻搜索踩了一个坑,调用示例为:kdtree.nearestKSearch(searchPoint,K,pointIdxNKNSearch,pointNKNSquaredDistance)注意第四个参数只能是float类型的数组,否则会报错。

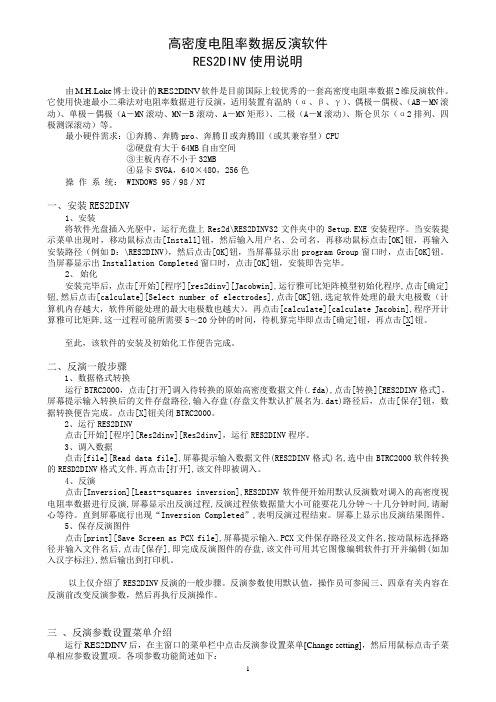

RES2DINV使用说明

○Yes⊙No

9、等值线间隔选项[Option for contour intervals]

缺省值:对数等值线间隔

在最小二乘法反演子程序中,当显示电阻率视剖面和模型电阻率断面时,在缺省状态下的程序是使用对数等值线间隔;在大多数情况下,这都会得出很好的结果。你可以使用线性或自己定义一个等值线间隔。

缺省值:纵横滤波比为1.00

如果在视阻率视剖面的纵方向的主要异常被拉伸了;可通过在纵方向使用更高的纵横滤波比(如2.0)就可以为纵向构造选择最优化的反演参数,然而,如果在视剖面中的主要异常是水平拉伸的,就得为垂向选择一个较小的纵横滤波比(如:0.5)。

请输入新的纵横比:

6、限制网格大小[Finite mesh grid size]

数据反演标准最小二乘法robust数据抑制输入robust截止系数模型反演标准最小二乘法robust模型抑制输入robust截止系数如果使用robust模型抑制你想允许模块数自动超过数据点数吗yesno11选择视电阻率对数chooselogarithmofapparentresistivity在反演中可以选择使用对数视电阻率值或使用视电阻率值使用对数视电阻率值使用视电阻率值12模型层的厚度增量thicknessofmodellayersincrease可以使模型层厚度沿深度方向以增加或以增加也可以指定模型的第一层厚度及沿深度方向层厚度增加系数

○线性等值线间隔

⊙对数等直线间隔

○定义线性等值线间隔

○定义对数等值线间隔

10、选择ROBUST反演[Select robust inversion]

可以选择标准的最小二乘法抑制,它能够减小观测电阻率与计算出的电阻率之间差的平方的值;或者选用ROBUST,而ROBUST抑制对干扰数据点很不敏感,但是会使视电阻率的RMS误差增大。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

Repetier Z-Probing

G31 显示Z_min探测限位开关状态。

Repetier下与其它(如marlin)有所不同,在M119命令下只会显示XYZ_max三个限位开关状态,需要查看Z_min限位开关状态需要使用此命令。

G30 执行一次Z_min探测。

比如在需要探测X=0,Y=0点高度时,可先将打印头移动到X=0,Y=0位置(G1 x0 y0 z10),然后执行G30。

G29 此命令在Repetier中也与其它(如marlin)有所不同,在Repetier中它不是自动高平命令,而只是根据固件中配置三个测点坐标测出三个点的高度值,方便我们进行手动调平而用。

参数:G29 S1 测量高度数值。

G29 S2 测量高度数值并保存到EEPROM中。

G32 自动调平。

三角洲(并联臂)比笛卡儿打印机需要更多的校准,首先要先校准XYZ_max限位开关。

改变eeprom 配置中“Tower X endstop offset [steps]”对应的Y和Z的值。

这很容易。

Endstops调整到最大值之后,固件会向下移动这些steps到extruder holder的正确的中心。

定义正确的中心位置至关重要,也就是说delta机器的非线性行为会导致错误的几何机构。

自己测量这些值几乎是不可能的,所以你需要使用一个简单的方法。

首先,使用下面的命令home(重置?)或删除所有的extruder偏移: G28 //回HOME位置

G131 //删除偏移量

现在定位3个滑块,使它们在同一高度。

为了实现这一目标,我使用了一个stick(棍子?)来定位所有的滑块,他们背对打印机顶端轻轻的压stick,据我所知,这样会居中。

更具你的打印机,从底部测量(不是床-这样会造成额外的拉伸)也许会更好。

困难的方法是移动sin x,y,z方向. 容易的方法是使用“M84”关闭马达,并手工滑动。

小心不要滑的太快。

移动产生了一个current (电流)在马达回流(motors flowing back to the electronics)。

一旦所有的滑块在正确的相同的高度,发送G132 S1:

M84 //关闭所有电机,降低噪音,可手动移动滑快。

G132 S1 //计算偏移量,并存与EEPROM

这会测量需要的偏移。

此外,S1 把结果保存在EEPROM,所以,你不必重复的校准。

Endstops校准之后

输入G32 S?进行自动调平,其中?参数说明:

0: 如果你没有XYZ_max限位开关。

你就需要第次启动打印机后或者每次打印之前运行这个命令。

1: 自动调平,并计算出高度,需要XYZ_max限位开关。

2:与1相同,并把计算出的高度数据存入EEPROM,以后就不需要每次启动机器都做调平了。

一旦运行自动水平G32,固件切换到自动电平模式。

如果你把它保存在EEPROM甚至生存打印机重新启动。

你可以改变这一点:

M320; 暂时激活自动水平

M320 S2; 永久激活自动水平

M321; 停用autolevel暂时

M321 S2; 永久停用自动电平

M322; 复位自动电平矩阵

M322 S3; 永久复位自动电平矩阵。