Vision-Based Mobile Robot Localization with Simple

智能空间辅助家庭服务机器人的定位方法

智能空间辅助家庭服务机器人的定位方法杨学永;孔令富;吴培良【期刊名称】《计算机仿真》【年(卷),期】2011(28)10【摘要】研究移动机器人智能定位优化问题,在分析传统的移动机器人定位的过程中,由于在定位时存在误匹配造成不准确,传统的移动机器人自身携带传感器对周围环境观测具有局限性.为了提高有效定位,提出利用智能空间中的单个全局摄像机作为外部传感器,可采用Monte Carlo方法解决移动机器人定位,并进行仿真,实验表明,全局摄像机能够有效地辅助移动机器人在全局环境中定位,Monte Carlo算法利用全局摄像机的观测信息,使定位有良好的性能效果.%The sensors carried by traditional mobile robot are limited in observing surrounding environment. Based on the explaining of traditional mobile robot localization process, this paper introduced the global camera of Smart Space as an external sensor and Monte Carlo algorithm based on the kernel ideal of sampling. Theoretical analysis and simulation experiments prove that global camera can effectively support the mobile robot positioning in the global environment, and by using the global camera observation information, Monte Carlo self-localization algorithm shows its robust global localization capability.【总页数】4页(P165-167,172)【作者】杨学永;孔令富;吴培良【作者单位】燕山大学信息科学与工程学院,河北秦皇岛066004;燕山大学信息科学与工程学院,河北秦皇岛066004;燕山大学信息科学与工程学院,河北秦皇岛066004【正文语种】中文【中图分类】TP242【相关文献】1.家庭服务机器人定位系统研究 [J], 李长勇;房爱青;袁亮;戴恩亮2.服务机器人智能空间中QR Code人工地标的设计、定位与识读 [J], 李国栋;田国会;王洪君;周风余;吴皓3.一种智能空间辅助的家庭服务机器人SLAM方法 [J], 孔令富;吴培良;杨学永4.家庭服务机器人自主定位控制 [J], 王刚;周军;苏晓明5.家庭服务机器人智能空间技术研究与进展 [J], 田国会;李晓磊;赵守鹏;路飞因版权原因,仅展示原文概要,查看原文内容请购买。

基于双目视觉机器人自定位与动态目标定位

基于双目视觉机器人自定位与动态目标定位卢洪军【摘要】Aiming at the fact that, the mobile robot based on binocular vision is very easy to be disturbed by the complex environment, such as the influence of noise, illumination change and the occlusion of the robot, which will seriously affect the positioning accuracy of the self localization and the moving objects, the color feature of the HSV model is proposed to accurately segment the artificial landmarks, and the robot position is determined according to the principle of parallax.A method was proposed based on Harris operator which is accurate to the position of a moving object in a complex environment.The dynamic object is detected by the frame difference method.Harris operator was used to extract the feature points on the moving objects, so as to obtain the disparity value, and then to calculate the position of the moving objects.The experimental results show that the self localization and target localization can overcome the external disturbance and have strong adaptability by using this method.The algorithm has good real-time performance.%针对基于双目视觉自定位与动态目标定位极易受复杂环境(如噪声、机器人发生遮挡、光照变化等)的干扰导致移动机器人定位精度低的问题,提出基于HSV颜色模型特征准确分割出人工路标,根据视差原理确定机器人位置.同时提出一种双目机器人基于Harris算子实现在复杂环境下对动态目标精确定位的方法,利用帧间差分法将运动目标检测出来,采用Harris算子在该运动目标上提取特征点,并获得视差值,从而精确的计算出运动目标的位置.实验结果表明,利用该方法进行自定位与目标定位能够克服外界干扰,具有较强的适应性,且算法的实时性好.【期刊名称】《沈阳大学学报》【年(卷),期】2017(029)001【总页数】6页(P37-42)【关键词】双目视觉;目标定位;Harris算子;帧间差分法;HSV模型【作者】卢洪军【作者单位】沈阳工业大学信息科学与工程学院, 辽宁沈阳 110870【正文语种】中文【中图分类】TP391.420世纪末,对目标定位技术主要有基于红外线的定位技术、基于超声波的定位技术和基于频射识别技术等[1].近年来,由于图像处理和计算机视觉的飞速发展,机器视觉的研究越来越受到广大专家和学者的青睐[2].双目立体视觉是机器视觉的一个重要分支,能够直接模仿人类双眼处理外界环境[3],可以代替人类完成危险的工作(如深海探测、火灾救援、核泄漏监测等)[4].而基于双目立体视觉对动态目标检测与定位也是机器视觉领域备受关注的前沿课题之一[5].双目立体视觉定位主要分为六个步骤[6]:①图像获取;②图像预处理;③摄像机标定;④特征点提取;⑤特征点的立体匹配获取视差值;⑥基于视差原理实现机器人定位.特征点提取和立体匹配是实现机器人定位的关键环节.通常的方法是依靠目标的形状、颜色等特征检测目标,并以运动物体的形心或中心作为特征点[7].该方法虽然计算简单,但极易受噪声干扰,只选择一个点作为特征点,一旦该特征点发生遮挡或光照变化等,都会严重影响定位精度.1977年,Moravec提出根据图像的灰度变化来提取图像角点,称为Moravec角点[8].该方法计算相对简单,但对于处于边缘上的点会存在误检,也极易受光照变化的影响.SIFT特征点[9]和CenSurE特征点[10]虽然对尺度、亮度变化不敏感,但在弱纹理等复杂情况下难以提取稳定的特征点,算法复杂度高,计算时间较长.不满足移动机器人对实时性的要求.针对以上缺陷,本文首先利用帧间差分法检测出运动目标,然后在运动目标上基于Harris算法提取多个特征点来实现移动机器人在复杂环境下实时的对运动目标精确定位.机器人整体定位流程如图1所示,移动机器人首先基于HSV颜色模型空间分割出人工路标,实现机器人自定位.然后利用帧间差分法检测出运动目标,根据Harris算法在左右两幅图像上提取特征点,根据区域匹配原理获取视差值,利用视差原理即可求出运动目标的世界坐标,即完成了对运动目标的定位.1.1 人工路标检测(1) HSV颜色模型.RGB色彩空间分别以红色、绿色、蓝色为三原色,通过适当的搭配可以合成成千上万种颜色,是一种常见的颜色表示法.但是RGB色彩空间与人眼的感知差异大,其空间的相似不代表实际颜色的相似.为了能够更准确分割出人工路标,本文采用HSV色彩空间颜色模型,如图2所示.RGB颜色空间转化到HSV色彩空间只是一个简单的非线性变换,计算简单.HSV模型中H代表色调,S代表饱和度,并且独立于亮度信息V.色调H代表颜色信息,取值范围为0~180°,对其设定阈值可以区分不同颜色的路标;饱和度S表示颜色中掺杂白色的程度,取值范围为0~1,S 越大,颜色越深;亮度V表示颜色的明暗程度,取值范围为0~1,V越大,物体亮度越高.(2) 基于颜色特征提取人工路标.由于本文是在室内环境下对移动机器人定位,所以本文设计的人工路标是由红黄蓝三种颜色组成的矩形纸板.如图3a所示为左摄像机拍摄到的带有人工路标的室内环境.根据HSV颜色模型对H、S、V三个分量进行阈值设置即可分割出人工路标,如图3b所示.然后利用图像处理中的形态学操作对分割出的路标进行完善使其效果最佳,如图3c所示.图3d为获取人工路标的中心点,利用视差原理即可得到当前帧机器人的位置.1.2 帧间差分法帧间差分法[11]的思想是对一段连续视频的相邻两帧进行差分运算,从差分运算的结果中得到运动目标的轮廓.该算法的优点是实现简单,对光照变化不敏感,稳定性好.适用于多目标或背景变化较快的场合.图4为在室内环境下用帧间差分法检测到运动物体.结果显示,帧间差分法能够有效的将运动目标检测出来.2.1 双目立体视觉测距原理双目立体视觉的视差原理[12]是利用两台摄像机从两个视点观察同一景物,以获取在不同视角下的感知图像,通过计算空间点在两幅图像中的视差来获取目标物体的三维坐标.2.2 Harris角点检测Harris角点[13]是在Moravec角点的基础进行改进的算法. Harris算子是用高斯函数代替二值窗口函数, 对离中心点越远的像素赋予越小的权重, 以减少噪声的影响. 高斯函数如式(1)所示.Moravec算子只考虑了四个方向的像素值,Harris算子则用Taylor展开式去近似任意方向.图像I(x,y)平移(Δx,Δy)可以一阶近似为在图像I(u,v)中,像点(u,v)平移(Δx,Δy)后的自相关函数为将式(2)代入式(3)可得:其中M如下所示:根据式(5)中矩阵M的特征值可以近似的表示函数C(x,y)的变化特征.矩阵M的特征值需要考虑以下三种情况,如图5所示.(1) 如果矩阵M的两个特征值都比较小,则表征图像灰度变化函数C(x,y)的值也较小,就说明该像素点的邻域内灰度差值不大,图像较平滑,无角点.(2) 如果矩阵M的两个特征值一个较大,一个较小,说明该像素点的曲率也是如此,则该点的窗口区域处于一条边界,无角点.(3) 如果矩阵M的两个特征值都比较大,则图像灰度变化的自相关函数值也较大,该点的窗函数沿任意方向都将引起灰度的剧烈变化,该点即为角点.根据这一准则,只要计算行列式的特征值就可以检测图像中的哪些点是角点.Harris 提出角点的响应函数:det(M)为行列式的值,trace(M)为行列式的迹.而k根据Harris的建议一般取0.04~0.06之间.若Harris角点响应大于阈值,则被认为是角点.Harris角点的生成只涉及到一阶导数,所以该角点对噪声影响、光照变化引起的灰度值变化都不敏感,是一种比较稳定的特征提取算子.3.1 实验环境本文使用的机器人是由北京博创兴盛技术有限公司开发的自主移动机器人旅行家Ⅱ号,如图6所示.该机器人上安装了由加拿大Point Grey Research公司生产的Bumblebee2双目摄像机,其性能参数如表1所示.3.2 传统移动机器人对运动目标定位实验环境为一间办公室,装有双目摄像机Bumblebee2的移动机器人为工作机器人,用于检测运动目标.将另一台机器人视为运动目标,运动速度为0.1 m/s.传统的方法是提取运动目标的中心点,获取视差值,从而给运动目标定位.传统方法仅获取图像中的一个点作为立体匹配的特征点,当该点受到环境的干扰时定位精度会受到极大的影响,图7为传统方法提取运动目标中心点.表2为传统方法对运动目标定位的实验数据,表3为改变光照后传统方法移动机器人对运动目标定位的实验数据.可以得出传统方法机器人定位误差相对较大,一旦光照发生改变,对运动物体定位误差会更加严重.3.3 基于Harris算子机器人对运动目标定位针对传统方法定位精度不足,极易受外界环境的干扰的问题,决定采用基于Harris角点特征提取,即在相机获得的左右两幅图像上基于Harris算子提取多对特征点,如图8所示.表4、表5为基于Harris方法机器人对运动目标定位的实验数据,可以得出基于该方法对运动目标定位误差很小,相对误差降低到1%左右,当光照发生变化时也能实现对运动目标精确定位.最后将每一帧的两幅图像根据区域匹配原理[14]和极限束准则找到正确的匹配点,排出易受噪声干扰的点,从而得到视差值,即可准确的对运动目标定位.(1) 本文研究了机器人基于双目立体视觉实现自定位与对运动目标定位,充分利用双目视差原理,并结合Harris算法和帧间差分法来实现运动目标的精确定位.从仿真结果可以看出,提取多个特征点可以避免只用一个点易受干扰的不足,实现更精确的运动目标定位.(2) 虽然本文在运动目标上提取多个特征点,有效的克服了传统方法的不足.但还存在问题需要改进.首先,需要找到一种更快更准确的特征点立体匹配算法;其次,本文只是将每一帧图像得到的多个视差值做平均值处理,如何有效的将多个视差值融合也是对运动目标精确定位的关键.【相关文献】[1] 李艳. 双视频目标定位技术[J]. 沈阳大学学报(自然科学版), 2016,28(4):302-305. (LI Y. Dual video target location technology[J]. Journal of Shenyang University(Natural Science), 2016,28(4):302-305.)[2] 李天健. 基于机器人视觉的汽车零配件表面缺陷检测算法研究与实现[J]. 沈阳大学学报(自然科学版), 2013,25(6):476-480. (LI T J. Research and implementation of auto parts surface defect detection algorithm bases on robot visio[J]. Journal of Shenyang University (Natural Science), 2013,25(6):476-480.)[3] 杜宇. 三维重建中双目立体视觉关键技术的研究[D]. 哈尔滨:哈尔滨理工大学, 2014:1-5. (DU Y. Research on key technology of binocular stereo vision in three-dimensional reconstruction[D]. Harbin:Harbin University of Science and Technology, 2004:1-5.)[4] 余俊. 基于双目视觉的机器人目标检测与控制研究[D]. 北京:北京交通大学, 2011:1-4. (YU J. Research on target detection and robot control based on binocular vision[D]. Beijing: Beijing Jiaotong University, 2011:1-4.)[5] DESOUZA G N, KAK A C. Vision for mobile robot navigation: A survey[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2002,24(2): 237-267.[6] 高栋栋. 基于双目立体视觉定位和识别技术的研究[D]. 秦皇岛:燕山大学, 2013:9-11. (GAO D D. Research on recognizing and locating binocular stereo vision technology[D]. Qinhuangdao:Yanshan University, 2013:9-11)[7] 崔宝侠,栾婷婷,张弛,等. 基于双目视觉的移动机器人运动目标检测与定位[J]. 沈阳工业大学学报, 2016,38(4):421-427. (CUI B X, LUAN T T, ZHANG C, et al. Moving object detection and positioning of robot based on binocular vision[J]. Journal of Shenyang University of Technology, 2016,38(4):421-427.)[8] 邓国栋. 基于多尺度特征的双目立体视觉目标定位[D]. 哈尔滨:哈尔滨工业大学, 2012: 21-22. (DENG G D. Object location of binocular stereo vision base on multi-scale feature[D]. Harbin: Harbin Institute of Technology, 2012:21-22.)[9] LOWE D G. Distinctive image feature from scale-invariant key point[J]. International Journal of Computer Vision, 2004,60(2):91-110.[10] KONOLIGE K, AGRAWAL M, SOLA J. Large-scale visual odometry for roughterrain[C]∥Robotics Research: The 13thInternational Symposium ISRR, 2011,66:201-212.[11] 熊英. 基于背景和帧间差分法的运动目标提取[J]. 计算机时代, 2014(3):38-41. (XIONG Y. Moving object extraction based on background difference and frame differencemethod[J]. Computer Era, 2014(3):38-41.)[12] 林琳. 机器人双目视觉定位技术研究[D]. 西安:西安电子科技大学, 2009:8-10. (LIN L. The research of visual positioning technology on the binocular robot[D]. Xi’an: Xi'an Electronic and Science University, 2009:8-10.)[13] 张从鹏,魏学光. 基于Harris角点的矩形检测[J]. 光学精密工程, 2014,22(8):2259-2266. (ZHANG C P, WEI X G. Rectangle detection base on Harris corner[J]. Optics and Precision Engineering, 2014,22(8):2259-2266.)[14] 罗桂娥. 双目立体视觉深度感知与三维重建若干问题研究[D]. 长沙:中南大学, 2012:48-53. (LUO G E. Some issues of depth perception and three dimension reconstruction from binocular stereo vision[D]. Changsha: Central South University, 2012:48-53.)。

文献检索与论文写作

文献检索与论文写作篇一:文献检索与论文写作讲义文献信息检索与论文写作讲义前言古今中外,凡学术研究之集大成者,都非常重视搜求和利用文献资料。

中国儒家经典之一《论语》的《八佾》篇中记载着我国古代思想家、教育家孔子的一段话:“夏礼吾能言之,杞不足徵也;殷礼吾能言之,宋不足徵也;文献不足故也。

足,则吾能徵之矣。

”(这段话的意思是:“夏朝的礼,我能说出来,(但是它的后代)杞国不足以证明我的话;殷朝的礼,我能说出来,(但它的后代)宋国不足以证明我的话。

这是由于文字资料及熟悉夏礼和殷礼的人不足的缘故造成的。

如果足够的话,我就可以得到证明了。

”)孔子论事有据、注重文献的治学精神由此可见一斑。

英国伟大的科学家牛顿说过:“如果说我比别人看得略为远些,那是因为我站在巨人们的肩膀上的缘故。

”(这句名言最初出现在牛顿给发明显微镜、提出胡克定律的英国力学家胡克(Robert Hooke, 1635–1703)的一封回信中。

) 牛顿所谓的“站在巨人肩膀上”,意思就是指他充分地占有和利用文献资料,从前人研究的“终点”中找出自己研究的“起点”,从而在学术研究工作中取得了突破性的成就。

上述孔子和牛顿的言论,充分说明文献资料在学术研究中的重要作用。

而文献信息检索方法是扩大资料来源的重要途径,它既是一门学科,也是一种学习方法。

《文献信息检索与论文写作》是为大四学生准备毕业论文而设的一门网上自修课,它淡化了学科的伦理研究和概念论述,侧重于实务和应用。

毕竟,探究文献信息是众人之事,须善于撷取他人之长,但学习文献信息检索技巧却是因人而异,须推陈出新,善于融汇一己心得。

因此,本课程融百家之言于一炉,但更求能为学生提供一些适合于本学科的新信息、新技能,传递文献信息检索的新思想、新观念。

文献信息检索的目的是应用,在应用之中我们一定还要注意拿来主义与学术创新之间的关系。

复旦教授俞吾金认为,学术规范的灵魂是学术创新。

他说:“任何一种学术研究活动,如果缺乏对它以前的研究史的必要的回应,本质上都是不合法的。

移动机器人路径规划和导航(英文)

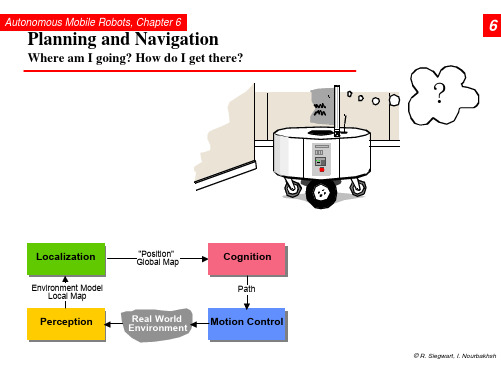

Autonomous Mobile Robots, Chapter 6

6.2.1

Road-Map Path Planning: Voronoi Diagram

• Easy executable: Maximize the sensor readings • Works also for map-building: Move on the Voronoi edges

© R. Siegwart, I. Nourbakhsh

Autonomous Mobile Robots, Chapter 6

6.2.1

Road-Map Path Planning: Adaptive Cell Decomposition

© R. Siegwart, I. Nourbakhsh

Autonomous Mobile Robots, Chapter 6

© R. Siegwart, I. Nourbakhsh

Autonomous Mobile Robots, Chapter 6

6.2.1

Road-Map Path Planning: Voronoi, Sysquake Demo

© R. Siegwart, I. Nourbakhsh

Autonomous Mobile Robots, Chapter 6

Ø Topological or metric or a mixture between both.

• First step:

Ø Representation of the environment by a road-map (graph), cells or a potential field. The resulting discrete locations or cells allow then to use standard planning algorithms.

未知环境下的机器人地图构建研究

未知环境下的机器人地图构建研究摘要地图构建技术是机器人自主导航研究中的一个关键问题。

为了实现机器人在未知环境下的自主导航,本文在分析当前普遍采用的一些环境构建方法及其缺点的基础上,提出一种基于多传感器信息融合的地图构建方法。

实验结果表明该方法有效地克服了传感器的累计误差,有效地提高了构建环境地图的准确性。

此方法的可行性和有效性通过pioneer3-dx移动机器人得到了实验验证。

关键字机器人;地图构建;多传感器信息融合;扩展卡尔曼滤波中图分类号tp24 文献标识码a 文章编号1674-6708(2011)54-0200-020 引言导航技术是自主移动机器人研究的核心,其关键在于建立一个合理有效的环境地图[1],用来描述机器人的工作环境,从而进行路径规划和避障,所以构建并维护一个环境地图是自主机器人能否顺利完成工作的前提和重要环节,构建环境地图的精确程度直接影响到机器人后续的工作状态。

典型的环境地图表示方法有尺度地图,拓扑地图。

但其准确性都受限于传感器的不确定性,无论何种环境地图都依赖于传感器提供的环境信息,即构建环境地图的精度取决于所采用的传感器。

机器人自身携带的传感器是其探索周围环境的重要手段。

当前,常用的传感器有视觉传感器、里程计和惯导系统、超声波传感器、激光测距仪、gps定位系统等。

针对不同的传感器,各有其使用优缺点及局限性[2][3],为此,经过分析比较,本文采用扩展卡尔曼滤波技术,将里程计和超声波传感器所提供的信息进行融合,实现构建准确的环境地图。

1 环境信息的检测与提取1.1 里程计模型的建立与信息处理通过里程计的测距工作原理,建立其位移数学模型:(1)其中,r为车轮半径,n为光码盘输出的脉冲数,p为光电码盘转数。

若机器人左右轮的移动距离分别为和,且两轮的间距为b,机器人从位姿运动到,则机器人运动的距离为,机器人转过的角度为。

1.2 超声波传感器模型的建立与信息处理通过超声波测距的工作原理,建立其测距数学模型:(2)其中,t为发射和接收声波所用的时间,c为声音传播速度。

移动机器人自主导航矩阵二维码辅助定位研究

移动机器人自主导航矩阵二维码辅助定位研究张安峰;吴涛;杨丛丛【摘要】移动机器人自主导航过程中,为机器人提供精确地位置信息十分重要,只有机器人有了精确地位置信息才能准确地导航到目标点.由于单纯的惯性和里程测量系统的相对定位方式都不能消除长时间的累计定位误差,因此需要一种绝对位置信息加以辅助修正累计误差.二维码是一种很好的可以存储绝对位置信息的方式,且信息获取简单易用,本文提出了一种将矩阵二维码作为绝对位置标签辅助修正里程和惯性测量系统导航过程中产生的累计误差的导航定位方法.通过实验对比验证了该方法的有效性.【期刊名称】《软件》【年(卷),期】2019(040)006【总页数】5页(P180-184)【关键词】移动机器人;二维码;自主导航;定位【作者】张安峰;吴涛;杨丛丛【作者单位】昆明理工大学机电工程学院,云南昆明 650500;昆明理工大学机电工程学院,云南昆明 650500;昆明理工大学机电工程学院,云南昆明 650500【正文语种】中文【中图分类】TP242.60 引言现代科技技术发展迅速,各类传感器产品技术稳定且精度不断提高,致使一些依赖各类传感器的新兴技术发展迅速。

其中移动机器人就是一个典型的代表,近几年,成为了国内外及各大高校的研究热点。

其中主要包括 SLAM(同时定位与建图)、自主导航、定位等[1]。

不同环境机器人的定位方法分为相对定位和绝对定位,相对定位主要通过里程测量和惯性导航技术[2],主要传感器为惯性测量(IMU)传感器和电机编码器等。

室外机器人的绝对定位主要通过GPS辅助机器人定位[3],而对于室内机器人,则需要借助绝对位置传感器如 RFID、RSSI、UWB、WIFI、激光、视觉等技术来辅助机器人获得绝对位姿,这类传感器不仅仅应用于机器人[4-6],在其他室内定位方面也同样适用[7-9]。

现如今,标签式辅助定位非常流行,因为相比于前面提到的室内绝对定位方式,标签式辅助定位其信息获取较为简单,且成本低。

码垛机器人毕业设计参考文献

码垛机器人毕业设计的参考文献1. 张华.码垛机器人的设计与实现[J].自动化技术与应用,2023,42(02):78-82.2. 王强.码垛机器人的控制算法研究[D].南京:南京理工大学,2021.3. 赵辉.基于机器视觉的码垛机器人定位系统设计[J].自动化与仪表,2020,35(07):43-47.4. 王军.工业机器人在码垛包装领域中的应用[J].包装工程,2019,40(16):149-153.5. 李峰.基于PLC的码垛机器人控制系统设计[J].自动化技术与应用,2019,38(07):139-143.6. 韩勇.基于ROS的码垛机器人路径规划研究[D].成都:西南交通大学,2022.7. 刘宁.码垛机器人的轨迹优化算法研究[J].机械工程与自动化,2021(04):6-8+11.8. 王艳红.基于ARM的码垛机器人运动控制器设计[J].制造业自动化,2018,40(12):99-102+106.9. 徐卫良.新型码垛机器人设计与研究[J].制造业自动化,2017,39(08):87-89+93.10. 郑文斌.基于ROS的码垛机器人控制系统设计与实现[D].武汉:武汉工程大学,2021.11. Liu Y, Zhang H, Wang L. Design and implementation of a palletizing robot control system based on ROS[J]. Robotics and Computer-Integrated Manufacturing, 2023, 67: 101952.12. Liang Y, Li Z, Wu H. Intelligent control algorithm for palletizing robot based on deep reinforcement learning[J]. Automation in Construction, 2023, 129: 104230.13. Zhao Z, Wu H, Chen G. Real-time path planning for palletizing robot based on improved A* algorithm[J]. Robotica, 2023.14. Zhang X, Wang C, Zhang J. Design and implementation of a palletizing robot based on the cloud platform[J]. Automation in Construction, 2023, 130: 104307.15. Wang Y, Liang Y, Wu H. Vision-based localization and navigation system for palletizing robot[J]. Robotics and Computer-Integrated Manufacturing, 2023, 68: 102047.16. Liang Y, Wu H, Chen G. Vision-guided palletizing robot system based on machine learning[J]. Robotics and Computer-Integrated Manufacturing, 2023, 69: 102098.17. Zhang H, Liu Y, Wang L. Design and implementation of a palletizing robot control system based on ROS[J]. Robotics and Computer-Integrated Manufacturing, 2023, 67: 101952.18. Liang Y, Wu H, Chen G. Vision-guided palletizing robot system based on machine learning[J]. Robotics and Computer-Integrated Manufacturing, 2023, 69: 102098.19. Wang Y, Liang Y, Wu H. Vision-based localization and navigation system for palletizing robot[J]. Robotics and Computer-Integrated Manufacturing, 2023, 68: 102047.20. Zhang X, Wang C, Zhang J. Design and implementation of a palletizing robot based on the cloud platform[J]. Automation in Construction, 2023, 130: 104307.21. Wang L, Zhang H, Liu Y. Application of machine learning in the intelligent control of palletizing robots[J]. Robotics and Computer-Integrated Manufacturing, 2023, 68: 102037.22. Liang Y, Wu H, Chen G. Real-time path planning for palletizing robot based on differential evolution algorithm[J]. Robotica, 2023.23. Wu H, Liang Y, Chen G. Vision-guided control system for palletizing robot using deep learning[J]. Robotics and Computer-Integrated Manufacturing, 2023, 69: 102105.24. Zhao Z, Wu H, Chen G. Design and implementation of a palletizing robot based on ROS[J]. Robotics and Computer-Integrated Manufacturing, 2023, 67: 101959.25. Liang Y, Wu H, Chen G. Intelligent control strategy for palletizing robot based on fuzzy logic[J]. Automation in Construction, 2023, 130: 104347.26. Wang Y, Liang Y, Wu H. Design and implementation of a palletizing robot using differentialdrive system[J]. Robotics and Computer-Integrated Manufacturing, 2023, 68: 102055.27. Zhang X, Wang C, Zhang J. Real-time tracking control system for palletizing robot based on adaptive PID[J]. Automation in Construction, 2023, 130: 104339.28. Liu Y, Zhang H, Wang L. Design and implementation of a palletizing robot based on the Internet of Things[J]. Automation in Construction, 2023, 130: 104317.29. Liang Y, Wu H, Chen G. Vision-guided navigation system for palletizing robot using image processing techniques[J]. Robotica, 2023.30. Zhao Z, Wu H, Chen G. Design and implementation of a palletizing robot based on the cloud platform[J]. Automation in Construction, 2023, 130: 104311.。

移动机器人坐标定位方案_张成

Y+=(sqrt(D_x×D_x+D_y×D_y))×sin (AngleArc)。

(五)双全向码盘加电子罗盘 双全向码盘加陀螺仪的方案在对全向轮行走方案的

支持上较为完整,但机器人行走角速度过大时陀螺仪 积分将出现误差。而本方案中,电子罗盘以地磁场作 为角度参考方向,具有固定的参照对象。在磁场干扰 不大的场合中,电子罗盘提供的方向信号可以很好的 解决前一方案转速过快时积分出错的情况。其定位算 法与前面所述方案算法一致。

参考文献 [1] 李群明,等.室内自主移动机器人定位方法研究综述 [J].

机器人,2003,(11). [2] 徐则中,庄燕滨.移动机器人定位方法对比研究 [J].系

统仿真学报,2009,(7). [3] 孙迪生,王炎.机器人控制技术 [M].北京:机械工业出

版社,1997. [4] Roumeliotis S,Bekey G.Bayesian estimation and kal-

(四)双全向码盘加陀螺仪 该套方案中仍然由陀螺仪提供角度方向,由成90度

垂直的一对全向轮编码盘提供两次计算间隔内机器人 行走轨迹长度。与前一方案相比较而言,在定位原理 上并没有很大区别。但是由于该方案中行走轨迹长度 信号由一对垂直的全向轮编码盘构成故能够完整的支 持全向轮行走方案,机器人可以以任意速度朝任意方 向行走以及加速减速。其定位行走算法如下:

三、结语

管网支架的设计是一项复杂的课题,且目前国内 尚无相应的管网支架设计规范出台,因此本文仅从概 念设计的角度并结合工程经验对管网支架的结构设计 进行简单分析。管网支架设计重点之一是荷载取值的

20

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

1. INTRODUCTION To navigate successfully in a large-scale environment, mobile robot should know where it is within this environment, i.e. it must localize itself. The pose of a wheeled robot (position and orientation in the global frame XR = [xr yr θr ]T ) is usually estimated by means of odometry. This method alone is insufficient, and the pose has to be corrected using measurements from external sensors. A number of approaches to the sensor-based localization are known from the literature. Many successful robotic systems utilize landmarks, which are distinct features that a robot can recognize from sensory data (Feng et al., 1996). Landmarks can be either natural or artificial. Natural landmarks are the features extracted from the sensory data without any changes being made in the environment. Artificial landmarks are the objects purposefully placed in the environment, such as visual patterns or reflecting tapes. In practice, recognition of natural landmarks by means of range sensors is limited to structured, office-like environments, which contain sufficient number of naturally occurring features (Skrzypczy´ nski, 1998). The ability to detect natural landmarks by computer vision methods is limited because of problems relLANDMARK RECOGNITION 2.1 Landmark design Landmark-based navigation relies on fast finding of landmarks, which are currently visible in the

field of view of the camera. This is done by segmentation of the available image. The segmentation criteria must be sufficiently reliable and independent on the geometrical deformation of the landmark appearance, due to the random position of the camera w.r.t. robot surrounding. On the other hand, precise determination of the landmark reference points on the image is critical for obtaining accurate enough coordinates, determining the pose of the camera fixed to the mobile robot. As there is a number of perceptually similar landmarks placed in the workspace of the robot, in order to determine robot position in unambiguous way, each landmark must carry its proper code. This is to enable the identification of particular landmarks, whose location in world-coordinates is a priori known. Mobile robot moves on the floor, so the following assumptions are justified: camera optical axis is parallel to the floor, center of the landmark is at its height (on contrary to (Kasi´ nski and B¸ aczyk, 2001)). As the camera moves in horizontal plane it is worth building the landmark patterns of vertical and horizontal features. To meet the above requirements landmarks have been designed as paper sheets (210 × 297 mm) printed in appropriate way. Within strong black orthogonal frame, filled with fluorescent green, there is a chessboard placed, made of 9 fields. Particular fields of chessboard are black or green according to the unique code, proper to the given landmark. Central field is always black. In this way one can place up to 256 unique landmarks in the workspace of the robot. Primary detection of landmarks on the current image is based on the segmentation in color-space. Landmark frame gives a strong luminance gradient with respect to its green filling. After thresholding one gets a quadrangle pattern on the output image, whose properties are a secondary criterion for the detection of the landmark. Internal corners of the black frame are treated as reference points and are used for pose evaluation. The particular layout of landmark-code area does not influence the positioning accuracy because this area is separated from reference points. 2.2 Image processing Robot vision system works on true-color images of 640x480 pixels. Landmark recognition process consists of two steps: (i) detection of ROIs (Regions Of Interest) on the available image, (ii) recognition of the landmark in particular ROI and determination of image-coordinates of their reference points. After Gaussian smoothing of the RGB image, it is transformed into the HSI-color space, in order to enable the following segmentation procedure.

illumination, occlusions, shadows, etc. However, the use of artificial landmarks as visual cues can improve operational characteristics of vision-based methods compared to the recognition of natural environment features (Yoon and Kweon, 2001). The disadvantage is, that the environment has to be engineered, what in turn limits the flexibility and adaptability to different operational sites. This problem can be avoided by using simple, cheap and unobtrusive landmarks, which can be easily attached to walls and furniture in virtually any environment. This article presents a mobile robot localization system which uses passive visual landmarks to enhance the recognition capabilities of the onboard camera. The focus is on the evaluation of the spatial localization uncertainty. Both theoretical analysis and presentation of experimental results are given.