Rittal数据中心制冷规划和小型数据中心整体解决方案

模块化数据中心解决方案

模块化数据中心解决方案模块化数据中心解决方案是一种通过将数据中心的各个组件模块化设计,以提高数据中心的可扩展性、灵活性和效率的解决方案。

这种解决方案能够满足不同规模和应用需求的数据中心,例如企业数据中心、云计算数据中心和边缘计算数据中心。

下面将详细介绍模块化数据中心解决方案的优势和实施方法。

1.可扩展性:模块化数据中心解决方案允许根据实际需求逐步扩展数据中心的规模,而不需要进行整体的重建或大规模的修改。

这种可扩展性可以提高数据中心的灵活性,并节约成本。

2.灵活性:模块化数据中心解决方案将数据中心的各个组件模块化设计,使得不同的组件可以独立运行和管理。

这种灵活性使得数据中心可以根据实际需求进行自定义配置和调整,适应不同的应用场景和工作负载。

3.效率提升:模块化数据中心解决方案通过优化设计和集成先进的技术,提供高效的能源利用率和计算资源利用率。

这种高效性可以显著降低能源消耗和维护成本,提高数据中心的运行效率。

4.简化部署和维护:模块化数据中心解决方案可以提供预先配置好的模块化组件,使得数据中心的部署过程更加简化和快速。

同时,模块化设计也使得数据中心的维护更加方便和高效,可以实现模块的独立维护和升级。

实施模块化数据中心解决方案的方法有:1.模块化硬件设计:通过将数据中心的硬件组件模块化设计,例如服务器、存储设备和网络设备,可以实现组件的独立扩展和管理。

这种模块化硬件设计可以通过标准化接口和模块化连接方式来实现。

2.软件定义的数据中心技术:软件定义的数据中心技术允许将数据中心的各个功能模块抽象为软件,通过软件定义的方式进行管理和调配。

这种技术可以实现数据中心的灵活性和可扩展性,并提高数据中心的自动化程度。

3.高度集成的解决方案:选择高度集成的解决方案可以简化数据中心的部署和维护过程。

这些解决方案通常提供预先配置好的模块化组件,例如预先集成的服务器和网络设备,可以减少配置错误和部署时间。

4.能源管理和热管理技术:模块化数据中心解决方案通常包括先进的能源管理和热管理技术,例如高效的制冷系统和智能能源监控系统。

模块化数据中心方案

模块化数据中心方案在当今数字化时代,数据中心作为企业和组织的核心基础设施,其重要性不言而喻。

随着业务的不断发展和技术的快速更新,传统的数据中心建设模式已经难以满足日益增长的需求。

模块化数据中心方案应运而生,为数据中心的建设和运营带来了全新的思路和方法。

一、什么是模块化数据中心模块化数据中心是一种将数据中心的基础设施(如机柜、制冷、供电、布线等)进行模块化设计和构建的解决方案。

它将整个数据中心分解为多个独立的模块,每个模块都具备完整的功能,并且可以根据需求进行灵活的组合和扩展。

与传统数据中心相比,模块化数据中心具有以下显著特点:1、快速部署模块化数据中心采用预制化的模块,在工厂完成生产和测试,现场只需进行简单的组装和调试,大大缩短了建设周期,从数月甚至数年缩短至数周。

2、灵活扩展可以根据业务的增长逐步增加模块,实现按需扩容,避免了一次性过度投资和资源浪费。

3、高可靠性每个模块都经过严格的质量检测和优化设计,确保了系统的稳定性和可靠性。

同时,模块化的架构也便于进行故障隔离和快速修复。

4、节能高效通过优化的制冷和供电设计,以及智能化的管理系统,提高能源利用效率,降低运营成本。

二、模块化数据中心的组成模块1、机柜模块机柜是数据中心用于安装服务器、存储设备等IT设备的基本单元。

模块化数据中心的机柜通常采用标准化设计,具备良好的散热性能、布线管理和承重能力。

2、制冷模块制冷系统是确保数据中心设备正常运行的关键。

模块化数据中心的制冷模块可以采用风冷、水冷或冷冻水等不同的制冷方式,根据实际环境和需求进行选择。

常见的制冷模块包括行间空调、机柜级空调等。

3、供电模块供电模块为数据中心提供稳定可靠的电力支持。

它包括UPS(不间断电源)、配电柜、变压器等设备。

模块化的供电系统可以实现电源的冗余配置,提高供电的可靠性。

4、布线模块布线模块负责数据中心内各类线缆的敷设和管理,包括网络线、电源线、光纤等。

采用模块化的布线系统可以提高布线的规范性和可维护性。

打造高效的数据中心制冷系统

打造高效的数据中心制冷系统作者:来源:《中国计算机报》2015年第15期2015年3月26日,国家相关部门发布了《关于印发国家绿色数据中心试点工作方案》。

方案指出,目前美国数据中心平均电能使用效率(PUE)已达1.9,先进数据中心PUE已达到1.2以下。

近年来,我国数据中心发展迅猛,总量已超过40万个,年耗电量超过全社会用电量的1.5%,其中大多数数据中心的PUE仍大于2.2,与国际先进水平相比有较大差距,节能潜力巨大。

这充分说明了建设低PUE的绿色数据中心的重要性,而建设绿色数据中心的关键之一在于打造高效的制冷系统。

深圳市英维克科技股份有限公司(以下简称英维克)副总经理王铁旺认为,打造高效绿色数据中心制冷系统的关键有两点:一是提升制冷系统本身的效率,二是利用好自然冷源。

英维克CyberMate系列高效机房专用空调,通过集成高效压缩机、高效EC风机、高效电子膨胀阀等高能效制冷器件,通过先进的EVO管理系统,实现制冷系统高能效比和科学能效管理;可集成多种直接、间接自然冷却方案,提高制冷系统的全年能效比(AEER)。

英维克XRow系列高效列间空调,靠近热源高效冷却,配合以采用封闭冷通道或封闭热通道的数据中心设计方案,可有效提高空调系统的回风温度,从而提高制冷系统的能效比和显热比,有效降低数据中心的PUE值。

不同规模的数据中心应采用不同的高效制冷方案:大型数据中心,可采用集采自然冷却的冷冻水型的制冷系统;中小型数据中心可采用集成直接、间接自然冷却方案的直接蒸发式的制冷系统。

英维克CyberMate高效制冷系统已经应用于中国联通华北基地、中国移动广东基地等多个超大型数据中心,XRow列间空调系统应用于腾讯、阿里巴巴微模块数据中心等多个模块化数据中心,iFreecooling自然冷却系统已经为中国联通、中国移动、中石油、中海油等多个数据中心大幅降低机房能耗。

针对企业级机房,英维克可以提供XRackTM微模块服务器机柜高效制冷解决方案。

Rittal数据中心制冷规划和小型数据中心整体解决方案

Rittal数据中心制冷规划和小型数据中心整体解决方案

Rittal数据中心制冷规划和小型数据中心整体解决方案

⒈引言

在当今信息技术迅猛发展的背景下,数据中心已成为许多组织处理和存储数据的核心设施。

为了确保数据中心的可靠性、高效性和可持续性,数据中心制冷规划和小型数据中心整体解决方案变得至关重要。

⒉制冷需求分析

⑴数据中心的热负荷评估

⑵环境要求和标准

⑶制冷技术选择(包括传统制冷设备、液冷技术、空气冷却技术等)

⒊制冷系统设计

⑴制冷系统组成部分(包括冷却塔、冷却机组、风冷却器等)

⑵冷却系统配置和布局

⑶制冷系统的能耗管理和监控

⒋小型数据中心整体解决方案

⑴数据中心布局规划

⑵系统集成和模块化设计

⑶电力供应和电气设备

⑷网络和通信设备

⑸灭火系统和安全设备

⑹监控和管理系统

⒌附件

附件一:数据中心热负荷评估表

附件二:制冷系统设计图纸

附件三:数据中心布局示意图

法律名词及注释:

⒈数据保护条例

数据保护条例是一种法律和法规框架,旨在保护个人的隐私和数据安全。

根据这一条例,组织在处理个人数据时必须遵守特定的规定和措施,以确保数据的机密性和完整性。

⒉知识产权法

知识产权法是一项法律体系,旨在保护创作者和创新者的知识

产权,包括专利、商标、著作权和商业秘密等。

它为创意和创新提

供了保护,促进经济和社会的发展。

⒊法律责任和赔偿

在数据中心运营过程中,如果违反了相关法律法规或合同约定,将承担相应的法律责任和赔偿责任。

这可能包括经济赔偿、行政处

罚或刑事责任等。

意大利RC Group X TYPE 绿色高效高水温IT制冷系统解决方案

意大利RC公司绿色高效高水温IT制冷系统解决方案XTYPE目录X 型大风量高温型大温差冷冻水系统 - 目录末端机组13冷水机组 26自控系统 34PUE 计算40研发背景 3PUE<1,15X 型大风量高温型大温差绿色数据机房系统XTYPE研发背景 -解决的问题大型数据中心在中国基本上采用冷冻水系统压缩机系统的室外机无处安放压缩机系统的制冷密度小,占地面积太大压缩机系统与间接自然冷却难以配合冷冻水系统轻松解决上述问题但采用传统7-12℃水温系统能效太低,同时数据中心采用气流遏制技术后回风温度上升最明显的提高系统能效方式是:冷冻水温提升很快从进出水温从 7-12℃ ------10-15 ℃------12-18℃大型数据冷冻水系统冷冻水温提高的优点-----冷源侧水温从7/12℃提高到12/18℃时:制冷量提高:提高10-15%能效比提高:提高10%自然能冷却大大加长:加长1250小时(每年8760小时,大约每度的小时长为250小时,根据各地点有差异)大型数据冷冻水系统冷冻水温提高的优缺点-----末端侧水温从7/12℃提高到12/18℃时:制冷量下降:约30-40%能效比下降:约30%制冷密度下降:约30%显冷比上升—除湿能力下降:SHR从0.89到1.00弥补措施:回风温度提高24℃--28℃--32℃需要按新的热交换参数新设计结构及参数匹配冷冻水温提高的下一步发展方向在哪里?为了进一步降低PUE值,肯定还需要提高水温许多项目在试点14-19℃,如果进一步提高水温,,,,,冷水机组:是否支持长时间高水温运行?厂家是否研发小众市场?时间如何?价格如何?末端空调:高水温后空调缺点如何避免?厂家支持程度?水温到底多少度合适?是否有标准支持?是否能形成成熟的产品规格?是否具备商业模式?用户、厂家、咨询、设计、总包谁来牵头做?风险谁承担?节点如何控制?Rcgroup 给出的成熟解决方案----18/28℃水温末端+主机全套成熟方案标准:美国ASHARE TC 9.9 2008 温度 18-27℃湿度 5.5℃DB-15℃DB 60%回风温度:35℃出风温度:25℃回水温度:28℃出水温度:18℃末端空调:X TYPE系列冷水主机:UNICO TR FREE CLA 系列已集成自然冷却系统从一个想法,变为一个成熟的完美的工程产品!完整的系统解决方案领导行业发展的标杆1963-为意大利银行提供首台空调1980-MRE/A 首台自由冷却风冷机组2003 -首台磁悬浮SILVER BULLET 冷水机组2015-首次高水温IT制冷系统解决方案XTYPE 简介新标准2015 : X 型大风量高温型大温差冷冻水系统的革新应用将大大提高用户收益25°C35°C 25°C35°C现在的系统设计送回风温度:•回风温度 35°C •送风温度 25°C回风温度35°C送风温度25°C冷冻水进口温度18°C冷冻水出口温度28°CX TYPEXTYPE 简介空气处理示意图35 °C35 °C25 °C25 °CXTYPE 简介水侧换热示意图28 °C23°C23°C18 °C28 °CXTYPE 简介系统 组成意大利RC 公司 XTYPE 高水温冷冻水IT 制冷系统图CHW ΔT = 10°C回风温度 35°C送风温度25°CX TYPE专用风冷机组变频水泵组18°C18°C28°C28°C出水温度自控系统回水温度PUE<1,15X 型大风量高温型大温差绿色数据机房系统XTYPE系统构成-高水温室内空调Unit suitablefor site assembly风机段换热控湿段独立电器控制及调节阀空间过滤段3段式下送风末端以降低风阻和水阻为目的的内部组件设计过滤段低压降G4 级袋式过滤器一年一换俯视图前视图换热控湿段Array前视图Air handling section with:•4排管2级冷却•2排管预冷,2排管再冷;•2通阀;•电器面板,调节阀,及接管安排在气流方向外独立的电器和阀门空间电器面板调节阀红色部分即为此独立接线配管段In/Out CHW connectionfrom the bottom气流道外设计,提高效率风机段前视图•风机段内可安装2,3,4个EC 风机:-大直径, 630 mm; -高效率 (特殊翅片形状).3维 CFD 分析选择140Kw , 8排管的传统设计末端与X 型设备末端进行3维CFD 分析CFD Analysis – X coil CFD Analysis – Traditional 8-row coilX 型CFD 分析前视图X型CFD 分析左视图4 x 4排盘管“X” 型布置的合理性4 x 4排盘管“X”型布置替代传统8排布置的原因:•风阻小;•气流均匀;•水阻合适;•满足TIER IV 要求两台独立运行盘管的设计标准.Nr. 4 x 4 row coils with “X” layoutX型机组冷量范围和特点3段式设计3 个型号: 从 100 - 190 kW •EER 很高• 3 个独立段• 2 级盘管•2通阀•EC 无蜗壳风机•袋式过滤器•冷冻水底部接管X TYPE适配不同机房设计TIER等级•TIER II设计要求: 单冷源:− 1 套x 2 级冷却方式处理全负荷•TIER IV设计要求: 双冷源:- 2 套x( 1 级冷却方式,满足一半负荷)调节阀设于风道外.COOLINGLOGIC TIER IICOOLINGLOGIC TIER IV TIER II TIER IV冷量kW140101风量m3/h3100022000输入功率kW4,51,92 EER kW/kW31,152,6TIER IV 冷却方案TIER IV - SCHEME 1 18°C28°CTIER IV - SCHEME 228°C18°C12LEGENDAMVMD – 中压主分配器LVMD – 低压主分配器UPS – 不间断电源STS – 静态转换开关SD – 二级分配器G – 发电机XTYPE – 末端TURBO FL G X chiller – 冷水机TURBOFL G Xchiller气流水流气流水流TURBOFL G XchillerPUE<1,15X 型大风量高温型大温差绿色数据机房系统XTYPE系统构成-高水温自然冷却主机专用冷水机组 高水温 大温差X 型末端的完美表现需要和专用冷水机组的配套来支持: RC 集团设计了一系列常规及带自由冷却冷水机组: • 回水温度: >=28°C ;•delta-T: >=10 °. (出水温度18 °C )UNICO TURBO FL X & FL G XUNICO TURBO FL X FREE & FL G XFREE磁悬浮冷水机组传统型及带自由冷却型风冷冷水机组R134a 及 HFO1234ze冷媒 :500 – 700 – 1000 – 1250 kW •EER (EUROVENT STD)高达3,51•EER 在28/18°C 高达5,25•ESEER (EUROVENT STD) 高达5,71•SEER at 28/18°C up to 7.20 (常规机组l) and20.00 (自由冷却)•单冷回路•R134a & HFO R1234ze 冷媒•磁悬浮无油离心压缩机•高温大温差满液壳管式蒸发器UNICO TURBO FL X &FL X FREE UNICO TURBO FL G X & FL G XFREE磁悬浮压缩机技术介绍特点变转速两级离心压缩机;•磁悬浮无油轴承;•适应现场对水温的精密调节需求;•压缩机内置变频可将启动电流降至5安培;•R134a 或 HFO1234ze 冷媒可选.益处•无需润滑;•无需功率因素校正电容器;•部分负荷EER 增高;•启动电流变小(LRA);•低噪音;•重量轻;•无震动.冷冻水进出口温度从传统的 15 / 10°C 调整到 28 / 18°C自由冷却冷水机组: 自由冷却时间延长;常规冷水机组: EER 增加及减小尺寸;泵组: 降低输入功率;管路: 降低管径,无需保温自由冷却时间延长差值%伦敦[h/y]+ 46 %巴黎[h/y]+ 66 %米兰[h/y]+ 92 %冷水机组 EER 增加及减小机组尺寸进出口水温15 / 10 °C 进出口水温28 / 18 °C差值%冷量[kW]10001000冷凝温度[°C]5050蒸发温度[°C]816输入功率[kW]272,47197,23- 28% EER[kW/kW]3,675,07+ 38%降低水泵功率及管径进出口水温15 / 10 °C 进出口水温28 / 18 °C差值%冷量[kW]10001000冷冻水量[m3/h]17286- 50%冷水机内压降(蒸发器+ 管路)[kPa]4040100 kPa外压时水泵输入功率[kW]8,54,8- 43,5 %管径(330 m 当量)[in]6”5”-16,7%管道保温YES NO-100%重量[kg/m]2016-20%PUE<1,15X 型大风量高温型大温差绿色数据机房系统XTYPE系统构成-自控系统软硬件配套控制系统人工智能---基于能效计算,异地联网,及远程监视应用基础的软件开发机房专用负荷分配软件: COOL NET机房群控: Master Plant SEQuencer机房监控: RC Cloud Platform能效计算软件: RC SpectrumCOOLNET 室内机组群控节能COOL NET:基于机房空调多机不同负荷工况的优化控制•通过局域网接入并管理多达15台设备;•避免了局部制冷局部制热的对冲损失制冷区域平均温度设定温度回风温度待机SEQuencer 是对用同一制冷水力系统中采用多台同型号或不同型号冷水机组来生产冷热水的机房系统进行统一管理的自控系统。

克莱门特数据中心空调解决方案

CMS-480/600系列模块化UPS CMS-480(480KVA) 1)静态开关模块、监控模块和 1-30个20KVA功率模块组成. 最 大容量600KVA 2)所有功率模块共享电池组, 输入直流为±384V. 3)模块内部具备整流、逆变、 充电和控制一体系统 4)系统可随需设定为1/1、1/3、 3/1或3/3进出线方式

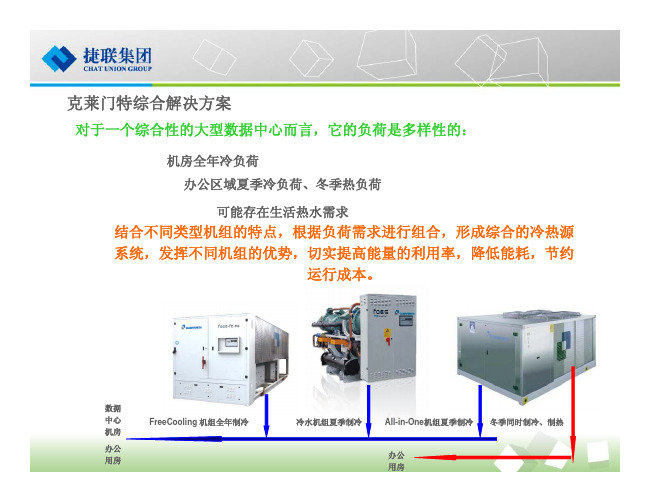

克莱门特综合解决方案

对于一个综合性的大型数据中心而言,它的负荷是多样性的:

机房全年冷负荷 办公区域夏季冷负荷、冬季热负荷 可能存在生活热水需求

结合不同类型机组的特点,根据负荷需求进行组合,形成综合的冷热源 系统,发挥不同机组的优势,切实提高能量的利用率,降低能耗,节约 运行成本。

数据 中心 机房 办公 用房

推荐方案一:模块机集中就近供电

集中就近配电优点: 1)有效减少功率损耗; 2)有效减少配电故障; 3)有效减小“零地”电压。

集中就近配电方案实际图

适用于中小型数据中心(200KVA以下负载供电),可完全取代传统 单机1+1并联的运行方式

Company Logo

推荐方案二:模块机双回路供电(1)

分电柜1 分电柜1 单电源负块机1 模块机2 模块机2 用户设备 静态开关 分电柜2 分电柜2

双 电 源 负 载

市电2 市电2

适用于中、小型数据中心(400KVA以下负载供电),可完全替代传统UPS双机双总线工作方式

Company Logo

推荐方案二:模块机双回路供电(2)

嵌入式ECMS系列模块化UPS电源

1)监控模块(含静态开关)和1到 6个功率模块(最大容量 3KVA×6=18KVA、 6KVA×6=36KVA) 组成。 2)所有功率模块共享电池组,输 入直流为±384V。 3)模块内部具备整流、逆变、充 电和控制一体系统。 4)系统可随需设定为1/1、1/3、 3/1或3/3进出线方式。

数据中心制冷方案

数据中心制冷方案数据中心是一个集中存储、管理和处理大量数据和信息的设施,而其中最重要的技术之一就是制冷技术。

数据中心中的服务器和IT设备运行时会产生大量的热量,如果不能有效地处理这些热量,将导致设备故障、性能下降甚至停机。

因此,如何在数据中心中实现高效而可靠的制冷成为了一个重要的问题。

目前,数据中心制冷方案主要有以下几种:1.传统的机械制冷系统机械制冷系统是目前最常见的数据中心制冷技术,它通过空调机组来调节室内温度和湿度。

空调机组通过蒸发冷却和压缩循环来实现制冷效果,能够有效地控制室内温度,并且具有稳定的性能。

然而,机械制冷系统的能耗较高,同时还需要大量的机械设备,增加了设备的成本和运维的难度。

2.可循环制冷系统可循环制冷系统是一种新型的制冷技术,其核心是利用冷凝器和蒸发器之间的热管循环来完成热量的转移。

这种制冷系统具有高度的可靠性和稳定性,同时能够提高数据中心的能效。

相比于传统的机械制冷系统,可循环制冷系统的成本更低,运维更方便,并且对环境的影响也更小。

3.直接液冷技术直接液冷技术是一种较为先进的数据中心制冷技术,它通过将冷却剂直接引入服务器设备的散热器中,实现对服务器的散热。

这种技术能够有效地提高散热效果,降低能耗,并且还能够减少数据中心的占地面积。

但是,直接液冷技术的实施成本较高,需要对服务器进行改造,同时对于冷却剂的选择和管理也有一定的要求。

4.自由冷却技术自由冷却技术是一种利用自然空气进行制冷的方法,它通过利用大自然的温度差异来实现制冷效果,并且不需要额外的能源消耗。

自由冷却技术适用于一些地理位置有利的数据中心,如北欧等地。

然而,在一些高温和高湿度的地区,自由冷却技术的效果可能会受到限制。

综上所述,不同的数据中心制冷方案各有优劣,选择适合的制冷方案需要考虑多个因素,如数据中心的规模、地理位置、能耗要求和成本预算等。

在未来,随着科技的进步和能源的需求,数据中心制冷技术将会不断发展和创新,以实现更高效、可靠和可持续的制冷效果。

集装箱式数据中心解决方案

2023-11-08CATALOGUE目录•引言•集装箱式数据中心解决方案的优势•集装箱式数据中心的架构与技术•集装箱式数据中心的实施步骤•集装箱式数据中心的应用场景与案例分析•总结与展望01引言随着云计算、大数据、人工智能等技术的快速发展,传统数据中心面临着诸多挑战,如高能耗、建设周期长、难以扩展等问题。

集装箱式数据中心解决方案应运而生,作为一种高度集成、可快速部署和灵活扩展的数据中心解决方案,得到了广泛关注和应用。

背景介绍集装箱式数据中心解决方案是由多个标准化集装箱组成,每个集装箱内都配备了计算、存储、网络等基础设施资源。

这种解决方案具有高效、灵活、可扩展等优点,能够快速满足不断增长的数据需求,同时降低了数据中心的能耗和成本。

集装箱式数据中心解决方案的提02集装箱式数据中心解决方案的优势提高数据中心的能效集装箱式数据中心通过智能监控系统,实时监测数据中心的温度、湿度和电力等参数,确保数据中心在最佳状态下运行,进一步降低能源消耗。

集装箱式数据中心还采用了先进的冷却技术和设备,如高效冷却塔、冷凝器等,能够更有效地散发热量,保持数据中心的稳定运行。

集装箱式数据中心采用高效节能设计和绿色建筑材料,能够显著降低能源消耗,提高能源利用效率。

快速部署与灵活扩展集装箱式数据中心采用预制化设计,能够快速部署和安装,缩短建设周期。

集装箱式数据中心的模块化设计使其具有灵活扩展的能力,可以根据业务需求增加模块或进行堆叠,方便扩展数据中心的规模和功能。

集装箱式数据中心的标准化设计使其易于维护和升级,可以根据需要进行设备替换或升级。

03集装箱式数据中心采用可回收材料和设备,能够减少废弃物处理成本。

减少数据中心的建设与运营成本01集装箱式数据中心采用预制化和模块化设计,能够降低建设和维护成本。

02集装箱式数据中心的节能设计和高效运营能够降低运营成本。

提高数据中心的可用性与可靠性集装箱式数据中心采用高可靠性设备、备份系统和容灾措施,能够提高数据中心的可用性和可靠性。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

Rittal / Henry Han / 17-09-2012

13

Tuning the CRAC with Cold Aisle Containment

68kW 49kW 110kW

49kW

Cold Aisle Standard Hot Aisle Containment Cold Aisle increases Delta T by Configuration 10o C5oC Delta T

240KW 1,471,680 367,920 2,207,520

40 120平米 11台 40KW LCP Inline

170KW 1,042,440 797,160 3,985,800

* PUE=2

Rittal / Henry Han / 17-09-2012

高效率冷却 – 机柜级制冷

密集安装的服务器系统以及高运算能力 的刀片式服务器产生了大量的热量,威 图创新的LCP液体冷却系统轻松应对单 个机柜高达55KW的热散耗。 LCP系统在解决机房过热问题的同时, 也大幅降低机房噪音至65dBA以下,更 可全面节能30%-50%。

传统精密空调 热密度(单机架) IT设备总功率 4KW 400KW 冷通道封闭 6KW 400KW 列级制冷 10KW 400KW

机架数量 机房面积 空调设备配置

空调设备总功耗 年度耗电(70%) 每年节省 5年节省

100 300平米 5台118KW CRAC

300KW* 1,839,600

70 210平米 5台118KW CRAC

6

Scaling the Data centre - Modular Infrastructure (N+1)

Year 4 12 3 – 140 56 98 28 Racks, Racks, Racks, 9 6 3 12 x x 40kW 40kW x 40kW UPS UPS UPS modules, modules, modules, 3 2 1x x 4PDR PDR x PDR Rack Rack Rack 0kW 100kW 200kW 300kW 400kW 500kW

数据中心制冷规划 小型数据中心整体解决方案

和

DCD Beijing 2012.12.11

Rittal / Henry Han / 02-08-2012

1

Rittal – The System.

IT Systems

Sensor network monitoring UPS systems

1-18 kVA, 1-phase 10 – 960 kW, 3-phase Optimum availability & transparency

15oC 15oC 15oC 20oC

49 kW 68 kW 110 kW 49 kW

3 kW 3 kW 3 kW 1.5 kW

Hot Aisle Cold Aisle

Cold Aisle Containment

Rittal / Henry Han / 17-09-2012

14

彻底节省空间和成本

机房级制冷和列级制冷的对比

Network enclosures Security room

Protection against a large number of physical hazards Network enclosures IT wall-mounted enclosures

Pipework

Optimum design

RiZone Monitoring software for the physical IT infrastructure Fully integrated containers for relocatable applications

Room, raised floor, rack cooling Power distribution

50%

Racks 30kW each ,CRAC’s 50kW, Chillers 265kW (4 x compressors)

Rittal / Henry Han / 17-09-2012

11

数据中心制冷规划

• 数据中心制冷概况 • 数据中心的热密度

• 空调节能的实践

小型数据中心解决方案

• 中小企业数据中心 • 集装箱数据中心 • 保险柜式数据中心

18℃ 10℃ 0℃

根据气象资料, 全年8760小时中,上海 气温低于18℃的时间有 5023小时, 气温低于10℃的时间有 2864小时,占32.7%。

-15℃

Hours

Rittal / Henry Han / 17-09-2012

IT Chiller

专为IT应用打造 -威图循环冷水机组为LCP提供不间断的冷冻水源(15℃)。 -循环冷水机组集成Free Cooling自然冷却技术,拥有杰出的节能效果。 -冷水机组内部关键组件使用冗余设计,双回路,双压缩机,双循环泵, 提高了安全性。

Fully wired and contact hazard proof Individual cooling concepts

Server racks

A large range with comprehensive accessories

IT recooling systems

Holistic solutions for IT cooling

Increased load up to 30kW Increased efficiency

– 35-45% reduction in required real estate – 10-20% reduction on total annual fan power consumption – 30-45% reduction in light related cost. – 12-14% reduction in power delivered to mechanical chilled water plant

Rittal / Henry Han / 17-09-2012

4

Rittal / Henry Han / 17-09-2012

5

数据中心制冷规划

• 数据中心制冷概况

•

数据中心的热密度Biblioteka • 空调节能的实践小型数据中心解决方案

• 中小企业数据中心 • 集装箱数据中心 • 保险柜式数据中心

Rittal / Henry Han / 17-09-2012

Rittal / Henry Han / 17-09-2012

12

Future proofing your cooling

General for rules Increasing Cooling efficiency:•

Separate hot and cold paths • Increase water temperatures • Reduce fan speeds • Reduce pump speeds

Rittal / Henry Han / 17-09-2012

彻底节省空间和成本

机房级制冷和机柜级制冷的对比

传统精密空调 热密度(单机架) IT设备总功率 机架数量 机房面积 空调设备配置 4KW 400KW 100 300平米 5台118KW CRAC 列级制冷 10KW 400KW 40 120平米 11台 40KW LCP Inline 机柜级制冷 25KW 400KW 16 50平米 10台 55KW LCP Rack

Fan Power Fan Power

Fan Power

DeltaT T Delta T Delta TDelta

Air Inlet Temperature

20oC 25oC 30oC 30oC

Fan Power

Delta T

Air Outlet Temperature

CRAC kW Rating

Fan Power

Rittal / Henry Han / 17-09-2012

8

Scaling the Data centre - Cold Aisle Containment (N+1)

Year 56 Racks, 12 3 – 98 56 28 15 Racks, Racks, x 40kW 9 6 3x x UPS 40kW 40kW modules, UPS UPS modules, modules, 3 x PDR 3 2 1Rack, x x PDR PDR 4Rack Rack x chillers (9oC out) 0kW 100kW 200kW 300kW 400kW 500kW

Racks 3kW each ,CRAC’s 50kW, Chillers 220kW (4 x compressors)

Rittal / Henry Han / 17-09-2012

7

Why are Containment Systems so popular

Cold Aisle Containment • Contains the cold air within the aisle • Increases cooling capacity to 10 kW+ per rack • Can either use CRACS or In Line cooling (60kW In line available) • Retro-fitable in most cases (uses existing CRACS) • Takes up less space than HACs (not In Line cooling) • In line Cooling or CRACs can be used