模型评价标准

主体评级预测模型评价标准

主体评级预测模型评价标准主体评级预测模型的评估标准主要包括准确性、稳定性、可靠性、透明性和可解释性。

1.准确性:预测模型是否能够准确地对主体进行评级,即模型预测的结果是否与实际情况相符。

可以通过计算模型的准确率、召回率、F1-Score等指标来评估模型的准确性。

准确率是指模型预测结果正确的样本数占总样本数的比例,召回率是指模型正确预测出的正样本数占所有正样本数的比例,F1-Score是准确率和召回率的调和均值,是综合评价模型好坏的重要指标。

2.稳定性:预测模型在时间序列上是否稳定。

如果模型在时间序列上表现出稳定性,那么模型的预测结果将更加可靠。

可以通过观察模型在不同时间点的预测结果,以及计算相关统计量如均方根误差(RMSE)等来评估模型的稳定性。

3.可靠性:预测模型是否能够处理各种异常情况,如异常值、缺失值等。

可以通过数据清洗、异常值处理、缺失值填充等方式来提高模型的可靠性。

4.透明性和可解释性:预测模型是否能够提供清晰的解释,使得决策者能够理解模型的工作原理和决策过程。

可以通过可视化技术、文本解释等方式来提高模型的透明性和可解释性。

此外,对于主体评级预测模型来说,还需要考虑以下几个方面:1.区分度:模型是否能够正确区分不同的主体,即正确分类患者/非患者、低/高风险等。

区分度体现了模型对不同主体特征的敏感程度。

2.校准度:模型对风险预测的准确性,也称为一致性或拟合优度。

校准度体现了模型对绝对风险预测的准确性。

3.泛化能力:模型在新数据集上的表现,即模型能否在未见过的数据上做出准确的预测。

可以通过交叉验证、调整超参数等方式来提高模型的泛化能力。

4.计算效率:模型的计算速度和效率,即模型能否在短时间内处理大量数据并给出预测结果。

可以通过优化算法、使用分布式计算等方式来提高模型的计算效率。

综上所述,主体评级预测模型的评估标准是多方面的,需要综合考虑准确性、稳定性、可靠性、透明性和可解释性等多个方面来评估模型的性能。

数学建模评价模型

数学建模评价模型1.准确性评价:这是评估模型与实际数据的契合程度。

准确性评价可以通过计算模型预测结果与实际数据之间的差异来实现。

常见的准确性评价指标有均方根误差(RMSE)、平均绝对误差(MAE)等。

均方根误差是模型预测值与真实值之间的差值的均方根,平均绝对误差是模型预测值与真实值之间的差值的平均值。

准确性评价越小,则模型准确性越高。

2.可靠性评价:可靠性评价是评估模型在不同数据集上的稳定性。

通过将模型应用于不同的数据集,观察模型预测结果的变化情况,可以评估模型的可靠性。

常见的可靠性评价方法包括交叉验证和蒙特卡洛模拟。

交叉验证将数据集分为训练集和测试集,通过多次重复实验,观察模型预测结果的稳定性。

蒙特卡洛模拟则是通过随机生成不同数据集,观察模型预测结果的分布情况。

3.灵敏度分析:灵敏度分析是评估模型对输入参数变化的敏感性。

建模时,经常需要设定各种参数值,而不同参数值可能导致不同的结果。

灵敏度分析可以帮助确定哪些参数对模型输出的影响最大。

常见的灵敏度分析方法包括单因素灵敏度分析和多因素灵敏度分析。

单因素灵敏度分析是将一个参数保持不变,观察模型结果的变化情况。

多因素灵敏度分析则是将多个参数同时变化,并观察模型结果的变化情况。

4.适用性评价:适用性评价是评估模型在特定问题上的适用性。

不同的问题可能需要不同的数学模型,评价模型的适用性可以帮助确定模型是否适用于特定问题。

适用性评价可以通过将模型应用于类似的问题,并进行验证来实现。

在实施数学建模评价模型时,需要根据具体问题的特点和需求来选择合适的评价指标和方法。

同时,在建立数学模型之前,需要确定评价指标的合理范围,以便在评估结果时进行比较和判断。

总之,数学建模评价模型是一种用于评估数学建模结果的方法。

通过准确性评价、可靠性评价、灵敏度分析和适用性评价,可以评估模型的优劣、准确性和可靠性,为实际问题的解决提供参考。

dea模型评价标准

dea模型评价标准

DEA模型(Data Envelopment Analysis)是一种用于评价各类

单位绩效的方法,它能够帮助决策者识别最有效率的单位,并确定

其他单位相对于最有效率单位的效率水平。

DEA模型评价标准主要

包括以下几个方面:

1. 输入和输出指标的选择,在使用DEA模型进行评价时,需要

确定用于衡量单位绩效的输入和输出指标。

输入指标通常包括资源

投入,如资金、人力、设备等,而输出指标则通常包括产出、服务、成果等。

选择合适的指标对于评价结果的准确性至关重要。

2. 数据的准备和清洗,在使用DEA模型进行评价之前,需要对数据进行准备和清洗,确保数据的准确性和完整性。

这包括处理缺

失值、异常值以及对数据进行标准化等操作,以确保评价结果的可

靠性。

3. 模型的建立和求解,DEA模型通常采用线性规划的方法进行

求解,通过建立一个包络面来评价各单位的效率水平。

在建立模型时,需要考虑各单位之间的相对效率,以及如何确定最有效率单位

的标准。

4. 结果的解释和分析,评价结果的解释和分析是DEA模型评价的重要环节。

通过对评价结果进行解释和分析,可以帮助决策者了解各单位的效率水平,并找出影响效率的关键因素,为进一步改进提供参考。

5. 结果的应用和反馈,最后,评价结果需要得到有效的应用和反馈。

决策者可以根据评价结果制定相应的改进措施,提高单位的效率水平,并不断优化绩效。

总之,DEA模型评价标准涵盖了指标选择、数据准备、模型建立、结果解释和应用反馈等多个方面,通过科学的评价方法,帮助决策者更好地了解单位的绩效水平,并制定合理的管理决策。

深度学习中的模型评估指标

深度学习中的模型评估指标在深度学习领域,模型评估是评估模型性能和效果的过程,是深度学习算法开发和优化的关键步骤之一。

模型评估指标是用来衡量模型在不同任务上的表现的标准,旨在帮助研究人员和开发者了解模型的性能,优化模型,并作出更准确的预测。

一、准确率(Accuracy)准确率是最常用的模型评估指标之一,它表示模型在所有样本中正确分类的比例,即正确分类的样本数与总样本数的比值。

准确率越高,说明模型的性能越好。

然而,准确率并不适合用于处理样本不平衡问题,因为即使模型过于“保守”,只预测出少数样本的类别而忽略了其他类别,准确率仍然可能很高。

二、精确率(Precision)精确率是指模型在预测为正样本中的真实正样本的比例。

它衡量了模型在所有预测为正样本的样本中的准确性。

精确率是评估模型预测为正样本的能力的重要指标,尤其适用于那些需要降低误报率的任务。

例如,在癌症预测中,精确率可以帮助我们确定哪些病例有可能是阳性。

三、召回率(Recall)召回率是指模型在所有真实正样本中成功预测为正样本的比例,也被称为灵敏度或真阳性率。

召回率用于衡量模型对正样本的查全率。

高召回率意味着模型能够准确地预测出更多的正样本,不会漏掉过多的真实正样本。

例如,在网络垃圾邮件分类中,我们更希望更多的垃圾邮件能够被准确地识别出来,而不是将其误判为正常邮件。

四、F1值(F1-Score)F1值是综合考虑精确率和召回率的指标,它是精确率和召回率的调和平均值。

F1值可以帮助研究人员和开发人员综合考虑模型预测的准确性和完整性,从而更全面地评估模型的性能。

当我们需要平衡精确率和召回率时,F1值是一个很有用的指标。

五、AUC(Area Under Curve)AUC是用于度量分类模型性能的重要指标之一,它表示ROC曲线下的面积。

ROC曲线是由真阳性率(TPR)和假阳性率(FPR)组成的曲线, TPR是指召回率,而FPR是指预测为负样本(实际为正样本)的样本中的比例。

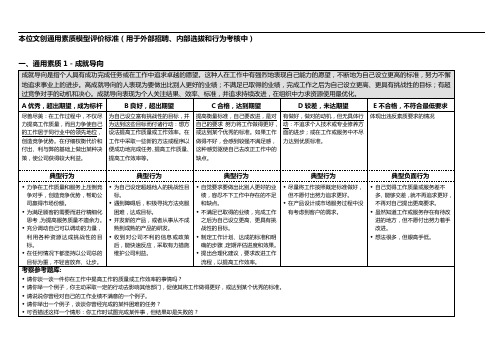

本位文创通用素质模型评价标准

体现出违反素质要求的情况

典型行为

典型行为

典型行为

典型行为

典型负面行为

面对外界压力仍能坚守道德底线。

当上级的指令和个人职业道德冲突时能不畏权威,坚持信念。

面对威胁、恐吓时能坚持正义。

坚决以职业道德约束自己的行为,不做任何违规之事。

在利益和金钱面前,不为所动,坚持原则。

工作中屈服于权威或上级,违背自己本应遵守的原则和信念。

明确个人应当遵守的职业道德和信念,但在行动中言行不一致,明知故犯。

考察参考题库:

请讲一个你曾经遇到的不忠于公司和主要客户利益的人,你是怎样对待他的?

讲一个你的正直受到挑战的经历。

请给我们描述一个你因为说了个谎言而使事情顺利完成的例子。(提示:说自己从没有遇到此类情形者一般是没有诚实的回答,建议继续考查其诚信度。)

请你描述一个情形,在该情形中,客户提出不合理的要求,并强烈要求你一定要满足他。

在工作中我们都要为别人做事或提供某种服务。请你讲一件你为别人提供服务并让对方感到满意的事件。

回答要点识别:

能设身处地的为客户着想,有想法,有行动。

三、通用素质3-诚实正直

指个人在从事职业时遵守人生信条及原则的愿望和能力。具体来说是行为与信念、原则一致,在与自己坚信的人生信条及原则相冲突、矛盾时能够坚持正义。

对于自己的岗位职责和所应具备的职业道德有明确的认识,并以此作为个人的行事原则。

公开表明自己的信念和立场,言行一致。

在工作中不弄虚作假,保证数据和信息的真实方面有待提高。

了解岗位职业道德,但没能很好据此要求自己。

未能完全按照公司程序和国家法规操作。

利用职权之便弄虚作假,欺上瞒下。

模型评价标准

模型评价标准

模型评价标准是用于评估和比较不同预测模型或机器学习算法性能的一组指标。

以下是常见的模型评价标准:

1. 准确率(Accuracy):模型预测结果与真实结果的匹配程度,即正确预测的样本数占总样本数的比例。

2. 精确率(Precision):模型预测为正样本中真正为正样本的比例,衡量了模型预测为正样本的准确性。

3. 召回率(Recall):真正的正样本中被模型正确预测为正样本的比例,衡量了模型对正样本的发现能力。

4. F1-Score:综合考虑了精确率和召回率的一个综合评价指标,用于衡量模型的综合性能。

5. ROC曲线(Receiver Operating Characteristic Curve):以模型的真正例率(True Positive Rate)为纵轴,假正例率(False Positive Rate)为横轴绘制的曲线,用于评估模型的分类性能。

6. AUC值(Area Under the ROC Curve):ROC曲线下的面积,用于度量模型分类的准确性。

7. 均方误差(Mean Squared Error):用于评估回归模型的预测误差大小,计算预测值与真实值之间差异的平方的平均值。

8. 相对误差(Relative Error):用于评估回归模型的预测误差相对于真实值的大小。

9. R2值(R-squared):用于评估回归模型的拟合程度,在0到1之间,越接近1表示模型越好。

除了以上列举的指标,具体的模型评价标准还会根据不同任务和数据特点而有所不同。

在选择评价标准时,需要综合考虑模型的应用场景、目标和数据特性,并选择适合的指标来评价模型的整体性能。

数学建模模型评价

数学建模模型评价

数学建模模型评价指对数学建模问题的建模过程和结果进行不同维度的评价。

其目的是验证模型的可行性、准确性和可用性,以推动数学建模的进一步发展。

评价标准主要包括以下几个方面:

1.模型准确性:即模型预测结果与实际情况的差距。

评价准确性的方法有误差分析、模拟实验等。

2.模型可行性:即模型输入数据是否可得、计算成本是否合理、计算难度是否合理等。

一般使用敏感度分析、论证分析等方法评价模型可行性。

3.模型稳定性:即模型在不同环境下是否具有稳定性,包括输入变化、参数变化、数据质量变化等。

评价模型稳定性主要使用鲁棒性分析、扰动分析等方法。

4.模型可解析性:即模型是否可以通过数学方法精确求解。

对于难以精确求解的模型,可以采用近似解法进行求解,评价模型可解析性的方法主要有数值分析、模拟实验等。

5.模型可用性:即模型是否符合实际使用需要,包括使用界面是否友好、使用方法是否便捷、可扩展性等。

评价模型可用性的方法主要有用户测试、专家评估等。

综合考虑上述评价标准,可以对数学建模模型进行全面的评价,并确定模型优化的方向和重点。

模型比赛评分标准

模型比赛评分标准评分标准概述模型比赛的评分标准是根据参赛模型的表现指标进行评价的。

评分标准可以帮助评委准确、公平地评判参赛模型的优劣,确定最终的获胜者。

总体评分标准参赛模型将根据以下几个方面进行评分:1. 准确性(Accuracy) - 参赛模型在给定测试数据集上的预测结果的准确性。

准确性(Accuracy) - 参赛模型在给定测试数据集上的预测结果的准确性。

3. 创新性(Innovation) - 参赛模型是否包含创新的思想、技术或方法。

创新性(Innovation) - 参赛模型是否包含创新的思想、技术或方法。

4. 可解释性(Interpretability) - 参赛模型的结果能否被人理解和解释,是否能提供对决策的洞察。

可解释性(Interpretability)- 参赛模型的结果能否被人理解和解释,是否能提供对决策的洞察。

5. 鲁棒性(Robustness) - 参赛模型对于噪声、异常值或其他不确定因素的处理能力。

鲁棒性(Robustness) - 参赛模型对于噪声、异常值或其他不确定因素的处理能力。

评分细则以下是每个评分指标的细则,用于评估参赛模型在不同方面的表现:准确性(Accuracy)- 预测结果正确率:参赛模型在测试数据集上的正确预测比例。

- 评分标准(10分满分):- 9-10分:预测结果准确率高于90%。

- 7-8分:预测结果准确率在80%-90%之间。

- 5-6分:预测结果准确率在70%-80%之间。

- 3-4分:预测结果准确率在60%-70%之间。

- 1-2分:预测结果准确率低于60%。

效率(Efficiency)- 训练时间和计算资源:参赛模型在训练过程中所需的时间和计算资源。

- 评分标准(10分满分):- 9-10分:训练时间和计算资源消耗较低。

- 7-8分:训练时间和计算资源消耗适中。

- 5-6分:训练时间和计算资源消耗较高。

- 3-4分:训练时间和计算资源消耗很高。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

模型评价标准

模型评价是指对某个模型的性能或效果进行量化和判断的过程,它直接影响到模型的可靠性和可应用性。

在各个领域的科学研究和实践应用中,模型评价标准是十分重要的工具。

本文将从模型准确性、数据拟合、稳定性和解释性四个方面,探讨模型评价的标准和方法。

一、模型准确性

模型准确性是评价一个模型优劣的重要指标之一。

通常来说,模型准确性是通过与实际观测值的比较来确定的。

在进行模型评价时,可以采用以下几种方法:

1. 平均绝对误差(MAE):计算预测值与实际观测值之间的差距的绝对值的平均值。

MAE值越小,说明模型的准确性越高。

2. 均方误差(MSE):计算预测值与实际观测值之间的差距的平方的平均值。

MSE值越小,说明模型的准确性越高。

3. 相对误差(RE):计算预测值与实际观测值之间的差距与实际观测值之比的平均值。

RE值越小,说明模型的准确性越高。

二、数据拟合

数据拟合是评价模型的适用性和预测能力的指标之一。

它是通过模型预测值与实际观测值之间的匹配程度来进行评价的。

以下是一些常用的数据拟合标准和方法:

1. 决定系数(R-squared):用于衡量模型拟合程度的常见指标。

其

取值范围为0到1,越接近1表示模型的拟合程度越好。

2. 残差分析:通过绘制残差图、Q-Q图等图表,来判断模型是否能

够很好地拟合数据。

如果残差分布符合正态分布,说明模型对数据的

拟合较好。

三、稳定性

模型稳定性是指模型在不同数据集下表现相似性的能力。

模型稳定

性的评价一般采用以下方法:

1. 交叉验证(Cross-validation):将数据集划分为训练集和验证集,通过验证集上的表现来评估模型的稳定性。

如果模型在不同的验证集

上表现一致,则说明模型具有良好的稳定性。

2. 自助法(Bootstrap):通过从原始数据集中有放回地重复抽样,

构建多个子样本集,然后评估模型在不同子样本集上的稳定性。

四、解释性

模型的解释性是指模型对问题的理解和解释能力。

通常来说,模型

的解释性与模型的可解释性直接相关。

以下是一些评价模型解释性的

指标和方法:

1. 变量重要性分析:通过分析模型中各个变量的重要性,来评估模

型对问题的解释能力。

2. 变量影响度量:通过计算模型中各个变量对模型预测结果的影响程度,来评估模型的解释能力。

总结:

模型评价标准是评估模型性能的重要指标,从模型准确性、数据拟合、稳定性和解释性四个方面入手,可以全面地评估模型的优劣。

在实际应用中,应根据具体问题和需求选择合适的评价标准和方法,以确保模型的可靠性和可应用性。