openstack双节点网络基本配置

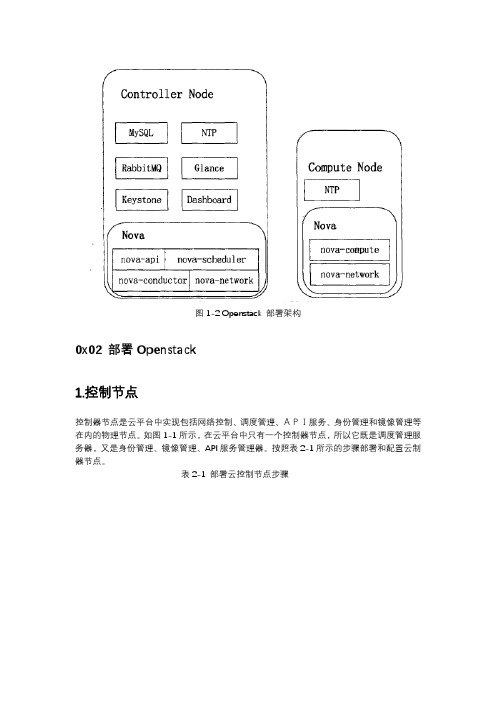

OpenStack详解

云主机类型主要是指一些虚拟硬件设施的模板,它通过定义内存、硬盘及CPU等参数大小来限制用户对硬件设施的使用,防止因为用户申请过多的资源。Openstack允许开发者或管理员自定义云主机类型,它提供了命令行工具和Web图形界面两种方式支持云主机类型的自定义。Openstack默认提供了常用的五种云主机类型,如图3-1所示。开发者可根据实际需求自定义云主机的大小。

(1)制作操作系统镜像:创建操作系统镜像要求本地环境支持KVM以及安装vncviewer组件。首先创建一个镜像盘,如"qemu -img create -f raw windows_xp.img 10G",该命令创建了一个容量为10G、raw格式的镜像盘;接着创建KVM镜像虚拟机,通过下面的命令启动系统安装W及建立引导启动系统,kvm -m 512 –cdrom windows_xp.iso –drivefile=windows_xp.img,if=scsi,index= 0-boot d –net nic -net user -nogrephic -vnc:0;最后使用vnc viewer登录引导界面安装系统;

图3-1 OpenStack中云主机类型

0x

1.虛拟机创建流程分析

后台创建虚拟机的过程实际上是为用户创建系统环境的过程,后台根据用户选择的云主机大小和系统环境模板为用户创建一个虚拟机,虚拟机提供了用户所需的操作系统和专业的软件环境。虚拟机创建过程如图4-1所示。

图4-1虚拟机创建过程

(1)当API服务器从User处接收到一个创建虚拟机的请求时,API服务器将会通过Keystone对User的权限进行验证,如果验证通过,就把送个虚拟机创建请求发送给(云控制器);

(2)主机权衡

权值是一个经过计算的数值,用来表示宿主主机与请求的符合度。经过主机过滤筛选出符合条件的计算节点集合Hosts,对Hosts集合中的每个主机进行主机权衡,权衡过程如图4-5所示。针对每个主机调用代价函数_weight_object()进行计算,将得到的值weight进行如下处理:

openstack安装、配置过程中常见问题及解决办法

openstack安装、配置过程中常见问题及解决办法:by-lilin== 问题一:由于网络节点只有2个物理网卡,当给网络节点配置虚拟子网(10.10.10.52,10.20.20.52)时,无法ping通计算节点网络(10.10.10.53/54/55,10.20.20.53/54/55)==解决方法:在网络节点其中一个物理网卡eth0安装虚拟网卡,构建虚拟vlan,实现同一个网卡分配2个不同网段的IP地址(10.10.10.52和10.20.20.52)。

安装步骤如下所示:**安装vlan(vconfig)和加载8021g模块:# aptitude install vlav# modprobe 8021g# lsmod |grep -i 8021q**使用linux cvonfig命令配置vlan(在eth0网卡上虚拟两个vlav端口,端口号为5、7): # vconfig add eth0 5Added VLAN with VID == 5 to IF -:eth0# vconfig add eth0 7Added VLAN with VID == 7 to IF -:eth0**设置VLAN的REORDER_HDR参数,默认就行了:# vconfig set_flag eth0.5 1 1Set flag on device -:eth0.5:- Should be visible in /proc/net/vlan/eth0.5# vconfig set_flag eth0.7 1 1Set flag on device -:eth0.7:- Should be visible in /proc/net/vlan/eth0.7**可以使用cat /proc/net/vlan/eth0.5查看eth0.5参数:# cat /proc/net/vlan/eth0.5eth0.5 VID: 5 REORDER_HDR: 1 dev->priv_flags: 1total frames received 623total bytes received 32353Broadcast/Multicast Rcvd 606total frames transmitted 71total bytes transmitted 9420Device: eth0INGRESS priority mappings: 0:0 1:0 2:0 3:0 4:0 5:0 6:0 7:0EGRESS priority mappings:**在/etc/network/interface中修改eth0网络配置信息:auto eth0.5iface eth0.5 inet staticaddress 10.20.20.52netmask 255.255.255.0vlan_raw_device eth0auto eth0.7iface eth0.7 inet staticaddress 10.10.10.52netmask 255.255.255.0vlan_raw_device eth0**重启网络:/etc/init.d/networking restart== 问题二:网络节点如何使用桥接模式访问外网?(外网IP:192.168.5.*,gateway:192.168.5.253) ==解决方法:在网络节点的eth1网卡上搭建桥接网络端口br-ex,并进行相关网络参数配置: **安装openvswitch-switch、openvswitch-datapath-dkms软件包# apt-get install openvswitch-switch openvswitch-datapath-dkms**创建桥接网络br-ex:# ovs-vsctl add-br br-ex**查看桥接端口br-ex是否启用# ovs-vsctl list-brbr-exbr-intbr-tun**将桥接端口br-ex添加到eth1上# ovs-vsctl add-port br-ex eth1**在/etc/network/interface中修改eth1网络配置信息:auto eth1iface eth1 inet manualup ifconfig $IFACE 0.0.0.0 upup ip link set $IFACE promiss ondown ip link set $IFACE promiss offdown ifconfig $IFACE downauto br-exiface br-ex inet staticaddress 192.168.5.52netmask 255.255.255.0gateway 192.168.5.253dns-nameservers 8.8.8.8**重启网络:/etc/init.d/networking restart== 问题三:在openstack里启动openvswitch-switch服务service openvswitch-switch start的时候,出现ovs-brcompatd is not running的错误 ==解决方法:**安装openvswitch-controller、openvswitch-switch、openvswitch-brcompat软件包# apt-get install openvswitch-controller openvswitch-switch、openvswitch-brcompat **在/etc/default/openvswitch-switch中修改如下配置文件:BRCOMPAT=yes**重启网络:/etc/nit.d/openvswitch-switch restart*如果有提示:Bad luck, the kernel headers for the target kernel version could not be found and you did not specify other valid kernel headers to use...*这是头文件的问题, the kernel generic headers is missing the version.h file. *解决方法如下:ln -s /usr/src/linux-headers-`uname-r`/include/generated/uapi/linux/version.h /lib/modules/`uname-r`/build/include/linux/**重启网络,如果有提示:bridge module is loaded,not loading brcompat*需要先卸载bridge模块# lsmod | grep bridge 查看bridge模块# rmmod bridge 移除网桥模块*强制加载brcompat内核模块# /etc/init.d/openvswitch-switch force-reload-kmod**重启网络查看ovs-brcompatd、ovs-vswitchd、ovsdb-server三个服务是否启动# /etc/nit.d/openvswitch-switch restartovsdb-server is running with pid 17119ovs-vswitchd is running with pid 17128ovs-brcompatd is running with pid 17131== 问题四:登陆openstack的horizon界面,无法看到image镜像,无法创建volumes。

OpenStack云计算平台搭建与管理教学教案(共17单元)4

更改了IP以后,其后的所有操作都可以通过SSH客户端远程连接主机进行操作了。

4.2 更改主机名我们发现登录以后两台虚拟机命令行前面都是“[root@localhost ~]”,从上面看出它们的主机名都是“localhost”,无法区分。

我们通常会给主机取一个名字(主机名),以后可以通过主机名实现对相应计算机的管理。

(1)查看主机名[root@localhost ~]# hostname得到结果:localhost.localdomain这里的“localhost.localdomain”就是该计算机默认的主机名。

(2)更改主机名本书介绍两种常用的更改主机名的方法,做实验时任选其一即可。

①方法一:更改“/etc/hostname”文件[root@localhost ~]# vi /etc/hostname删除原有的“localhost.localdomain”主机名,将控制节点的主机名更改为“controller”,将计算节点的主机名更改为“compute”。

更改完成后需要重新启动主机,使更改生效。

[root@localhost ~]# reboot②方法二:利用hostnamectl命令命令格式:hostnamectl set-hostname <主机名>这条命令会自动将“/etc/hostname”文件内容更改。

控制节点运行:[root@localhost ~]# hostnamectl set-hostname controller #给控制节点更名计算节点运行:[root@localhost ~]# hostnamectl set-hostname compute #给计算节点更名此方法会自动更改“/etc/hostname”文件,不需要重启系统,只需退出当前登录或者用SSH客户端重新连接一次就可以。

[root@localhost ~]# exit #退出当前登录重新进入系统后,可以看到控制节点命令模式最左边部分变成了“[root@controller ~]”,而计算节点最左边部分变成了“[root@compute ~]”。

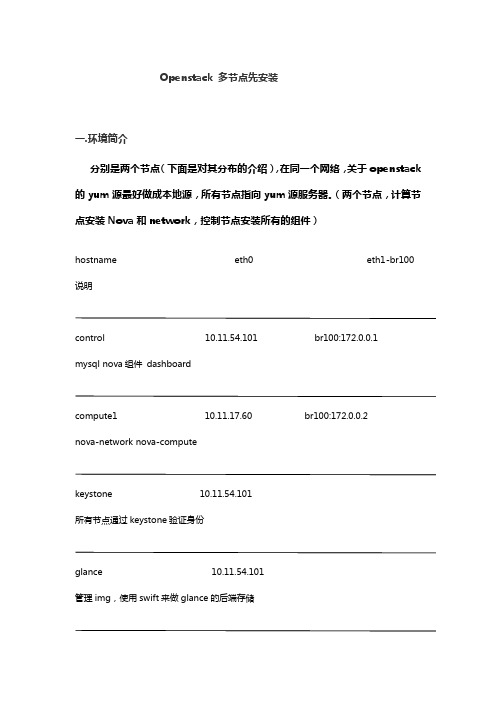

openstack多节点安装

Openstack 多节点先安装一.环境简介分别是两个节点(下面是对其分布的介绍),在同一个网络,关于openstack 的yum源最好做成本地源,所有节点指向yum源服务器。

(两个节点,计算节点安装Nova和network,控制节点安装所有的组件)hostname eth0 eth1-br100 说明control 10.11.54.101 br100:172.0.0.1mysql nova组件dashboardcompute1 10.11.17.60 br100:172.0.0.2nova-network nova-computekeystone 10.11.54.101所有节点通过keystone验证身份glance 10.11.54.101管理img,使用swift来做glance的后端存储swift-proxy 10.11.54.101swift代理节点swift 10.11.54.101提供swift对象存储2.epel的yum源配置cd /tmpwget/pub/epel/6/i386/epel-release-6-7.no arch.rpm/fedora/epel/6/x86_64/epel-release-6-8.noarc h.rpm# rpm -Uvh epel-release-6-7.noarch.rpmepel-release-6-7.noarch.rpm(rpm包)yum、nameserver、时间同步配置.txt(配置文档)/etc/hosts配置,解析控制和计算节点3、设置所有节点的基本环境(网络的设置,在这里主要是涉及到网桥,所以将外网的ip关闭,eth0配置内网的IP,eth1相当于另外的一层内网,br100是网桥)3.1.配置网络Bridge /etc/sysconfig/network-scripts/网络配置.txtcontrol和compute1的Bridgeifcfg-eth0DEVICE="eth0"NM_CONTROLLED="yes"ONBOOT="yes"BOOTPROTO="static"IPADDR=10.11.54.101 #compute1为10.11.17.60 NETMASK=255.255.255.0GATEWAY=10.11.54.254ifcfg-eth1DEVICE="eth1"NM_CONTROLLED="yes"ONBOOT="yes"BOOTPROTO="none"BRIDGE=br100RELAY=0ifcfg-br100DEVICE="br100"NM_CONTROLLED="yes"ONBOOT="yes"BOOTPROTO="static"TYPE=BridgeIPADDR=172.0.0.1 #compute1为172.0.0.2 NETMASK=255.255.255.0安装bridgeyum -y install bridge-utils/etc/init.d/network restart其他节点不用设置网桥,只需要配置eth0的ip,并修改所有节点的hosts使其互相直接可以域名解析。

双节点超融合方案

双节点超融合方案双节点超融合方案是一种将计算、存储、网络及管理功能整合到两个物理服务器节点中的解决方案,实现资源的高度整合与优化利用。

在双节点配置中,每个节点通常都配备高性能的处理器、大容量内存和本地存储,并通过高速互连技术(如InfiniBand、10/25/40/100GbE 等)进行连接,共同组成一个统一资源池。

以下是一个简化的双节点超融合系统设计方案:1. 硬件选型:-选择两台高可用、高扩展能力的超融合一体机作为基础硬件平台,确保设备具备足够的计算能力和冗余设计。

-每个节点应具备企业级的CPU、大量内存以及支持RAID的磁盘阵列或闪存存储,以满足应用对性能和数据安全的需求。

2. 软件定义层:-使用虚拟化平台,如VMware vSphere with vSAN、Microsoft Hyper-V、OpenStack等,实现计算和存储资源的虚拟化管理。

-部署超融合软件套件,用于构建分布式存储系统,将节点上的本地存储资源整合为一个共享的存储资源池。

3. 集群搭建:-将两个节点构建成一个高可用的集群,通过心跳机制和仲裁机制保证在单点故障时系统的稳定运行。

-实现存储层面的容错,例如使用纠删码或者镜像的方式保障数据安全性。

4. 网络规划:-设计内部存储网络和外部业务网络,可能采用端口复用或者独立网卡实现内外网隔离和负载均衡。

-根据业务需求,配置网络策略,包括VLAN划分、SDN(软件定义网络)管理等。

5. 监控运维:-配置集中式管理系统,提供对整个超融合环境的实时监控、报警通知和自动化运维能力。

-定义详细的备份和恢复策略,确保关键业务数据的安全性。

6. 高可用性和灾难恢复:-设置双节点间的HA(高可用性)策略,确保在单节点失效的情况下,业务能够迅速切换至另一节点。

-考虑部署异地灾备或云备份方案,以增强整体业务连续性。

总结来说,双节点超融合方案的核心是构建起高效、稳定、易于管理且具有成本效益的IT基础设施,为用户提供敏捷的IT服务交付能力,特别适合中小型企业或者分支机构场景下的IT建设需求。

云计算管理平台之OpenStack网络服务neutron

云计算管理平台之OpenStack⽹络服务neutron ⼀、简介 neutron的主要作⽤是在openstack中为启动虚拟机实例提供⽹络服务,对于neutron来讲,它可以提供两种类型的⽹络;第⼀种是provider network,这种⽹络就是我们常说的桥接⽹络,虚拟机内部⽹络通常是通过bridge的⽅式直接桥接到宿主机的某块物理⽹卡上,从⽽实现虚拟机可以正常的访问外部⽹络,同时虚拟机外部⽹络也可以访问虚拟机的内部⽹络;第⼆种是self-service networks,这种⽹络就是nat⽹络;nat⽹络的实现是通过在虚拟机和宿主机之间实现了虚拟路由器,在虚拟机内部可以是⼀个私有地址连接⾄虚拟路由器的⼀个接⼝上,⽽虚拟路由器的另外⼀端通过⽹桥桥接到宿主机的某⼀张物理⽹卡;所以nat⽹络很好的隐藏了虚拟机的地址,它能够实现虚拟机访问外部⽹络,⽽外⽹⽤户是不能够直接访问虚拟机的;但在openstack中,它能够实现虚拟机和外部的⽹络做⼀对⼀nat绑定,从⽽实现从虚拟机外部⽹络访问虚拟机; self-service network ⽰意图 提⽰:self-service network 和provide network最⼤的区别是⾃服务⽹络中有虚拟路由器;有路由器就意味着虚拟机要和外⽹通信,⽹络报⽂要⾛三层,⽽对于provide network 来讲,它的⽹络报⽂就可以直接⾛⼆层⽹络;所以在openstack上这两种类型的⽹络实现⽅式和对应的组件也有所不同; provide network 实现所需组件 Provider networks - Overview Provider networks 连接⽰意图 提⽰:桥接⽹络也叫共享⽹络,虚拟机实例⽹络是通过桥接的⽅式直接共享宿主机⽹络;虚拟机和宿主机通信,就类似宿主机同局域⽹的其他主机通信⼀样;所以虚拟机和宿主机通信报⽂都不会到三层,所以这⾥⾯就不涉及三层⽹络相关的操作和配置; self-service network实现所需组件 Self-service networks - Overview Self-service networks连接⽰意图 对⽐上⾯两种⽹络的实现所需组件,我们可以发现self-service network的实现要⽐provide network要多⼀个networking L3 Agent插件;这个插件⽤作实现3层⽹络功能,⽐如,提供或管理虚拟路由器;从上⾯的两种⽹络连接⽰意图也可以看出,self-service network是包含provide network,也就是说我们选择使⽤self-service network这种类型的⽹络结构,我们即可以创建⾃服务⽹络,也可以创建桥接⽹络;对于⾃服务⽹络来讲,我们在计算节点启动的虚拟机,虚拟机想要访问外部⽹络,它会通过计算节点的vxlan接⼝,这⾥的vxlan我们可以理解为在计算节点内部实现的虚拟交换机,各虚拟机实例通过连接不同的vni(⽹络标识符,类似vlan id⼀样)的vxlan来实现⽹络的隔离,同时vxlan这个虚拟接⼝通常是桥接在本地管理⽹络接⼝上,这个管理⽹络⼀般是不能够和外部⽹络通信;虚拟机访问外部⽹络,通过vxlan接⼝实现的vxlan隧道,这个隧道是⼀头是和计算节点的管理⽹络接⼝连接,⼀头是和控制节点的管理⽹络接⼝连接;虚拟机访问外部⽹络是通过vxlan隧道,再通过控制节点中的虚拟路由器,将请求通过路由规则,路由到控制节点能够上外⽹的接⼝上,然后发出去,从⽽实现虚拟机能够和外部⽹络进⾏交互;⽽对于外部⽹络要访问虚拟机,在openstack上是通过⼀对⼀nat绑定实现;也就说在控制节点能够上外⽹的接⼝上配置很多ip地址,这些IP地址都是可以正常访问外部⽹络的,在虚拟机访问外部⽹络时,在控制节点的虚拟机路由器上就固定的把计算节点的某个虚拟机的流量通过固定SNAT的⽅式进⾏数据发送,对于这个固定地址在控制节点上再做固定的DNAT,从⽽实现外部⽹络访问控制节点上的这个固定ip,通过DNAT规则把外部流量引⼊到虚拟机,从⽽实现外部⽹络和虚拟机通信; neutron⼯作流程 neutron服务主要由neutron-server、neutron agents、neutron plugins这三个组件组成,这三者都依赖消息队列服务;其中neutron server主要⽤来接收⽤户的请求,⽐如创建或管理⽹络;当neutron server接收到客户端(openstack其他服务,如nova,neutron专有客户端)请求后,它会把请求丢到消息队列中去,然后neutron agents负责从消息队列中取出客户端的请求,在本地完成⽹络创建或管理,并把对应的操作的结果写到neutron 数据库中进⾏保存;这⾥需要说明⼀点neutron agents是指很多agent,每个agent都负责完成⼀件事,⽐如DHCP agent负责分配ip地址,network manage agent负责管理⽹络;⽽对于neutron plugins 主要⽤来借助外部插件的⽅式提供某种服务;⽐如ML2 plugin ⽤来提供2层虚拟⽹络服务的;如果neutron agents在创建或管理⽹络需要⽤到某个插件服务时,它会把请求插件的消息丢到消息队列,然后neutron plugins 从消息队列取出消息,并响应请求,把结果丢到消息队列,同时也会写到数据库中; ⼆、neutron服务的安装、配置 1、准备neutron 数据库、⽤户以及授权⽤户对neutron数据库下的所有表有所有权限;[root@node02 ~]# mysqlWelcome to the MariaDB monitor. Commands end with ; or \g.Your MariaDB connection id is 184Server version: 10.1.20-MariaDB MariaDB ServerCopyright (c) 2000, 2016, Oracle, MariaDB Corporation Ab and others.Type 'help;' or '\h' for help. Type '\c' to clear the current input statement.MariaDB [(none)]> CREATE DATABASE neutron;Query OK, 1 row affected (0.00 sec)MariaDB [(none)]> GRANT ALL PRIVILEGES ON neutron.* TO 'neutron'@'%' IDENTIFIED BY 'neutron';Query OK, 0 rows affected (0.01 sec)MariaDB [(none)]> flush privileges;Query OK, 0 rows affected (0.00 sec)MariaDB [(none)]> 验证:⽤其他主机⽤neutron⽤户,看看是否可以正常连接数据库?[root@node01 ~]# mysql -uneutron -pneutron -hnode02Welcome to the MariaDB monitor. Commands end with ; or \g.Your MariaDB connection id is 185Server version: 10.1.20-MariaDB MariaDB ServerCopyright (c) 2000, 2016, Oracle, MariaDB Corporation Ab and others.Type 'help;' or '\h' for help. Type '\c' to clear the current input statement.MariaDB [(none)]> show databases;+--------------------+| Database |+--------------------+| information_schema || neutron || test |+--------------------+3 rows in set (0.00 sec)MariaDB [(none)]> 2、在控制节点安装配置neutron 导出admin环境变量,创建neutron⽤户,设置其密码为neutron[root@node01 ~]# source admin.sh[root@node01 ~]# openstack user create --domain default --password-prompt neutronUser Password:+---------------------+----------------------------------+| Field | Value |+---------------------+----------------------------------+| domain_id | 47c0915c914c49bb8670703e4315a80f || enabled | True || id | e7d0eae696914cc19fb8ebb24f4b5b0f || name | neutron || options | {} || password_expires_at | None |+---------------------+----------------------------------+[root@node01 ~]# 将neutron⽤户添加⾄service项⽬,并授权为admin⾓⾊[root@node01 ~]# openstack role add --project service --user neutron admin[root@node01 ~]# 创建neutron服务[root@node01 ~]# openstack service create --name neutron \> --description "OpenStack Networking" network+-------------+----------------------------------+| Field | Value |+-------------+----------------------------------+| description | OpenStack Networking || enabled | True || id | 3dc79e6a21e2484e8f92869e8745122c || name | neutron || type | network |+-------------+----------------------------------+[root@node01 ~]# 创建neutron服务端点(注册neutron服务) 公共端点[root@node01 ~]# openstack endpoint create --region RegionOne \> network public http://controller:9696+--------------+----------------------------------+| Field | Value |+--------------+----------------------------------+| enabled | True || id | 4a8c9c97417f4764a0e61b5a7a1f3a5f || interface | public || region | RegionOne || region_id | RegionOne || service_id | 3dc79e6a21e2484e8f92869e8745122c || service_name | neutron || service_type | network || url | http://controller:9696 |+--------------+----------------------------------+[root@node01 ~]# 私有端点[root@node01 ~]# openstack endpoint create --region RegionOne \> network internal http://controller:9696+--------------+----------------------------------+| Field | Value |+--------------+----------------------------------+| enabled | True || id | 1269653296e14406920bc43db65fd8af || interface | internal || region | RegionOne || region_id | RegionOne || service_id | 3dc79e6a21e2484e8f92869e8745122c || service_name | neutron || service_type | network || url | http://controller:9696 |+--------------+----------------------------------+[root@node01 ~]# 管理端点[root@node01 ~]# openstack endpoint create --region RegionOne \> network admin http://controller:9696+--------------+----------------------------------+| Field | Value |+--------------+----------------------------------+| enabled | True || id | 8bed1c51ed6d4f0185762edc2d5afd8a || interface | admin || region | RegionOne || region_id | RegionOne || service_id | 3dc79e6a21e2484e8f92869e8745122c || service_name | neutron || service_type | network || url | http://controller:9696 |+--------------+----------------------------------+[root@node01 ~]# 安装neutron服务组件包[root@node01 ~]# yum install openstack-neutron openstack-neutron-ml2 openstack-neutron-linuxbridge ebtables -y 编辑neutron服务的配置⽂件/etc/neutron/neutron.conf的【DEFAULT】配置段配置连接rabbitmq相关信息以及核⼼插件和⽹络插件等; 提⽰:我这⾥选择使⽤⾃服务⽹络类型;所以这⾥要配置service_plugins = router 并且启⽤叠加⽹络选项; 在【database】配置段配置连接neutron数据库相关信息 在【keystone_authtoken】配置段配置使⽤keystone做认证的相关信息 在【DEFAULT】配置段配置⽹络通知相关选项 在【nova】配置段配置nova服务相关信息 在【oslo_concurrency】配置段配置锁路径 neutron.conf的最终配置[root@node01 ~]# grep -i ^"[a-z\[]" /etc/neutron/neutron.conf[DEFAULT]transport_url = rabbit://openstack:openstack123@node02allow_overlapping_ips = trueauth_strategy = keystonenotify_nova_on_port_status_changes = truenotify_nova_on_port_data_changes = true[agent][cors][database]connection = mysql+pymysql://neutron:neutron@node02/neutron[keystone_authtoken]www_authenticate_uri = http://controller:5000auth_url = http://controller:5000memcached_servers = node02:11211auth_type = passwordproject_domain_name = defaultuser_domain_name = defaultproject_name = serviceusername = neutronpassword = neutron[matchmaker_redis][nova]auth_url = http://controller:5000auth_type = passwordproject_domain_name = defaultuser_domain_name = defaultregion_name = RegionOneproject_name = serviceusername = novapassword = nova[oslo_concurrency]lock_path = /var/lib/neutron/tmp[oslo_messaging_amqp][oslo_messaging_kafka][oslo_messaging_notifications][oslo_messaging_rabbit][oslo_messaging_zmq][oslo_middleware][oslo_policy][quotas][ssl][root@node01 ~]# 配置ML2插件 编辑配置⽂件/etc/neutron/plugins/ml2/ml2_conf.ini ,在【ml2】配置段配置⽀持flat(平⾯⽹络),vlan和vxlan 提⽰:配置ML2插件之后,删除type_drivers选项中的值可能会导致数据库不⼀致;意思是初始化数据库后,如果在删除上⾯的值,可能导致数据库不⼀致的情况; 在【ml2】配置段开启租户⽹络类型为vxlan 在【ml2】配置段启⽤Linux桥接和⼆层填充机制 在【ml2】配置段中启⽤端⼝安全扩展驱动程序 在【ml2_type_flat】配置段配置flat_networks = provider 提⽰:这⾥主要是指定平⾯⽹络的名称,就是虚拟机内部⽹络叫什么名,这个名称可以⾃定义,但后⾯会⽤到把该⽹络桥接到物理⽹卡中的配置,以及后续的创建⽹络都要⽤到这名称,请确保后续的名称和这⾥的名称保持⼀致; 在【ml2_type_vxlan】配置段中配置vxlan的标识范围 在【securitygroup】配置段启⽤ipset ml2_conf.ini的最终配置[root@node01 ~]# grep -i ^"[a-z\[]" /etc/neutron/plugins/ml2/ml2_conf.ini[DEFAULT][l2pop][ml2]type_drivers = flat,vlan,vxlantenant_network_types = vxlanmechanism_drivers = linuxbridge,l2populationextension_drivers = port_security[ml2_type_flat]flat_networks = provider[ml2_type_geneve][ml2_type_gre][ml2_type_vlan][ml2_type_vxlan]vni_ranges = 1:1000[securitygroup]enable_ipset = true[root@node01 ~]# 配置linux bridge agent 编辑/etc/neutron/plugins/ml2/linuxbridge_agent.ini,在【linux_bridge】配置段配置provider⽹络映射到物理的那个接⼝ 提⽰:这⾥主要是配置把把虚拟机内部的那个⽹络和物理接⼝的桥接映射,请确保虚拟机内部⽹络名称和这⾥配置的保持⼀致;冒号前指定虚拟机内部⽹络名称,冒号后⾯指定要桥接的物理⽹卡接⼝名称; 在【vxlan】配置段配置启⽤vxlan,并配置本地管理ip地址和开启l2_population 提⽰:local_ip写控制节点的管理ip地址(如果有多个ip地址的话); 在【securitygroup】配置段配置启⽤安全组并配置Linux bridge iptables防⽕墙驱动程序 linuxbridge_agent.ini的最终配置[root@node01 ~]# grep -i ^"[a-z\[]" /etc/neutron/plugins/ml2/linuxbridge_agent.ini[DEFAULT][agent][linux_bridge]physical_interface_mappings = provider:ens33[network_log][securitygroup]enable_security_group = truefirewall_driver = neutron.agent.linux.iptables_firewall.IptablesFirewallDriver[vxlan]l2_population = true[root@node01 ~]# 确定br_netfilter内核模块是加载启⽤,若没加载,加载内核模块并配置相关内核参数[root@node01 ~]# lsmod |grep br_netfilter[root@node01 ~]# modprobe br_netfilter[root@node01 ~]# lsmod |grep br_netfilterbr_netfilter 22209 0bridge 136173 1 br_netfilter[root@node01 ~]# 配置相关内核参数[root@node01 ~]# sysctl -pnet.bridge.bridge-nf-call-iptables = 1net.bridge.bridge-nf-call-ip6tables = 1[root@node01 ~]# 配置L3 agent 编辑/etc/neutron/l3_agent.ini配置⽂件,在【DEFAULT】配置段⽹络接⼝驱动为linuxbridge[DEFAULT]interface_driver = linuxbridge 配置DHCP agent 编辑/etc/neutron/dhcp_agent.ini配置⽂件,在【DEFAULT】配置段配置⽹络接⼝驱动为linuxbridge,启⽤元数据隔离,并配置dhcp驱动程序[DEFAULT]interface_driver = linuxbridgedhcp_driver = neutron.agent.linux.dhcp.Dnsmasqenable_isolated_metadata = true 配置metadata agent 编辑/etc/neutron/metadata_agent.ini配置⽂件,在【DEFAULT】配置段配置metadata server地址和共享密钥[DEFAULT]nova_metadata_host = controllermetadata_proxy_shared_secret = METADATA_SECRET 提⽰:metadata_proxy_shared_secret 这个是配置共享密钥的参数,后⾯的密钥可以随机⽣成,也可以设定任意字符串; 配置nova服务使⽤neutron服务 编辑/etc/nova/nova.conf配置⽂件,在【neutron】配置段配置neutron相关信息[neutron]url = http://controller:9696auth_url = http://controller:5000auth_type = passwordproject_domain_name = defaultuser_domain_name = defaultregion_name = RegionOneproject_name = serviceusername = neutronpassword = neutronservice_metadata_proxy = truemetadata_proxy_shared_secret = METADATA_SECRET 提⽰:这⾥的metadata_proxy_shared_secret要和上⾯配置的metadata agent中配置的密钥保持⼀致即可; 将ml2的配置⽂件软连接到/etc/neutron/plugin.ini[root@node01 ~]# ln -s /etc/neutron/plugins/ml2/ml2_conf.ini /etc/neutron/plugin.ini[root@node01 ~]# ll /etc/neutron/total 132drwxr-xr-x 11 root root 260 Oct 31 00:03 conf.d-rw-r----- 1 root neutron 10867 Oct 31 01:23 dhcp_agent.ini-rw-r----- 1 root neutron 14466 Oct 31 01:23 l3_agent.ini-rw-r----- 1 root neutron 11394 Oct 31 01:30 metadata_agent.ini-rw-r----- 1 root neutron 72285 Oct 31 00:25 neutron.conflrwxrwxrwx 1 root root 37 Oct 31 01:36 plugin.ini -> /etc/neutron/plugins/ml2/ml2_conf.inidrwxr-xr-x 3 root root 17 Oct 31 00:03 plugins-rw-r----- 1 root neutron 12689 Feb 28 2020 policy.json-rw-r--r-- 1 root root 1195 Feb 28 2020 rootwrap.conf[root@node01 ~]# 初始化neutron数据库[root@node01 ~]# su -s /bin/sh -c "neutron-db-manage --config-file /etc/neutron/neutron.conf \> --config-file /etc/neutron/plugins/ml2/ml2_conf.ini upgrade head" neutronINFO [alembic.runtime.migration] Context impl MySQLImpl.INFO [alembic.runtime.migration] Will assume non-transactional DDL.Running upgrade for neutron ...INFO [alembic.runtime.migration] Context impl MySQLImpl.INFO [alembic.runtime.migration] Will assume non-transactional DDL.INFO [alembic.runtime.migration] Running upgrade -> kiloINFO [alembic.runtime.migration] Running upgrade kilo -> 354db87e3225INFO [alembic.runtime.migration] Running upgrade 354db87e3225 -> 599c6a226151INFO [alembic.runtime.migration] Running upgrade 599c6a226151 -> 52c5312f6bafINFO [alembic.runtime.migration] Running upgrade 52c5312f6baf -> 313373c0ffeeINFO [alembic.runtime.migration] Running upgrade 313373c0ffee -> 8675309a5c4fINFO [alembic.runtime.migration] Running upgrade 8675309a5c4f -> 45f955889773INFO [alembic.runtime.migration] Running upgrade 45f955889773 -> 26c371498592INFO [alembic.runtime.migration] Running upgrade 26c371498592 -> 1c844d1677f7INFO [alembic.runtime.migration] Running upgrade 1c844d1677f7 -> 1b4c6e320f79INFO [alembic.runtime.migration] Running upgrade 1b4c6e320f79 -> 48153cb5f051INFO [alembic.runtime.migration] Running upgrade 48153cb5f051 -> 9859ac9c136INFO [alembic.runtime.migration] Running upgrade 9859ac9c136 -> 34af2b5c5a59INFO [alembic.runtime.migration] Running upgrade 34af2b5c5a59 -> 59cb5b6cf4dINFO [alembic.runtime.migration] Running upgrade 59cb5b6cf4d -> 13cfb89f881aINFO [alembic.runtime.migration] Running upgrade 13cfb89f881a -> 32e5974ada25INFO [alembic.runtime.migration] Running upgrade 32e5974ada25 -> ec7fcfbf72eeINFO [alembic.runtime.migration] Running upgrade ec7fcfbf72ee -> dce3ec7a25c9INFO [alembic.runtime.migration] Running upgrade dce3ec7a25c9 -> c3a73f615e4INFO [alembic.runtime.migration] Running upgrade c3a73f615e4 -> 659bf3d90664INFO [alembic.runtime.migration] Running upgrade 659bf3d90664 -> 1df244e556f5INFO [alembic.runtime.migration] Running upgrade 19f26505c74f -> 15be73214821INFO [alembic.runtime.migration] Running upgrade 15be73214821 -> b4caf27aae4INFO [alembic.runtime.migration] Running upgrade b4caf27aae4 -> 15e43b934f81INFO [alembic.runtime.migration] Running upgrade 15e43b934f81 -> 31ed664953e6INFO [alembic.runtime.migration] Running upgrade 31ed664953e6 -> 2f9e956e7532INFO [alembic.runtime.migration] Running upgrade 2f9e956e7532 -> 3894bccad37fINFO [alembic.runtime.migration] Running upgrade 3894bccad37f -> 0e66c5227a8aINFO [alembic.runtime.migration] Running upgrade 0e66c5227a8a -> 45f8dd33480bINFO [alembic.runtime.migration] Running upgrade 45f8dd33480b -> 5abc0278ca73INFO [alembic.runtime.migration] Running upgrade 5abc0278ca73 -> d3435b514502INFO [alembic.runtime.migration] Running upgrade d3435b514502 -> 30107ab6a3eeINFO [alembic.runtime.migration] Running upgrade 30107ab6a3ee -> c415aab1c048INFO [alembic.runtime.migration] Running upgrade c415aab1c048 -> a963b38d82f4INFO [alembic.runtime.migration] Running upgrade kilo -> 30018084ec99INFO [alembic.runtime.migration] Running upgrade 30018084ec99 -> 4ffceebfadaINFO [alembic.runtime.migration] Running upgrade 4ffceebfada -> 5498d17be016INFO [alembic.runtime.migration] Running upgrade 5498d17be016 -> 2a16083502f3INFO [alembic.runtime.migration] Running upgrade 2a16083502f3 -> 2e5352a0ad4dINFO [alembic.runtime.migration] Running upgrade 2e5352a0ad4d -> 11926bcfe72dINFO [alembic.runtime.migration] Running upgrade 11926bcfe72d -> 4af11ca47297INFO [alembic.runtime.migration] Running upgrade 4af11ca47297 -> 1b294093239cINFO [alembic.runtime.migration] Running upgrade 1b294093239c -> 8a6d8bdae39INFO [alembic.runtime.migration] Running upgrade 8a6d8bdae39 -> 2b4c2465d44bINFO [alembic.runtime.migration] Running upgrade 2b4c2465d44b -> e3278ee65050INFO [alembic.runtime.migration] Running upgrade e3278ee65050 -> c6c112992c9INFO [alembic.runtime.migration] Running upgrade c6c112992c9 -> 5ffceebfadaINFO [alembic.runtime.migration] Running upgrade 5ffceebfada -> 4ffceebfcdcINFO [alembic.runtime.migration] Running upgrade 4ffceebfcdc -> 7bbb25278f53INFO [alembic.runtime.migration] Running upgrade 7bbb25278f53 -> 89ab9a816d70INFO [alembic.runtime.migration] Running upgrade 89ab9a816d70 -> c879c5e1ee90INFO [alembic.runtime.migration] Running upgrade c879c5e1ee90 -> 8fd3918ef6f4INFO [alembic.runtime.migration] Running upgrade 8fd3918ef6f4 -> 4bcd4df1f426INFO [alembic.runtime.migration] Running upgrade 4bcd4df1f426 -> b67e765a3524INFO [alembic.runtime.migration] Running upgrade a963b38d82f4 -> 3d0e74aa7d37INFO [alembic.runtime.migration] Running upgrade 3d0e74aa7d37 -> 030a959ceafaINFO [alembic.runtime.migration] Running upgrade 030a959ceafa -> a5648cfeeadfINFO [alembic.runtime.migration] Running upgrade a5648cfeeadf -> 0f5bef0f87d4INFO [alembic.runtime.migration] Running upgrade 0f5bef0f87d4 -> 67daae611b6eINFO [alembic.runtime.migration] Running upgrade 67daae611b6e -> 6b461a21bcfcINFO [alembic.runtime.migration] Running upgrade 6b461a21bcfc -> 5cd92597d11dINFO [alembic.runtime.migration] Running upgrade 5cd92597d11d -> 929c968efe70INFO [alembic.runtime.migration] Running upgrade 929c968efe70 -> a9c43481023cINFO [alembic.runtime.migration] Running upgrade a9c43481023c -> 804a3c76314cINFO [alembic.runtime.migration] Running upgrade 804a3c76314c -> 2b42d90729daINFO [alembic.runtime.migration] Running upgrade 2b42d90729da -> 62c781cb6192INFO [alembic.runtime.migration] Running upgrade 62c781cb6192 -> c8c222d42aa9INFO [alembic.runtime.migration] Running upgrade c8c222d42aa9 -> 349b6fd605a6INFO [alembic.runtime.migration] Running upgrade 349b6fd605a6 -> 7d32f979895fINFO [alembic.runtime.migration] Running upgrade 7d32f979895f -> 594422d373eeINFO [alembic.runtime.migration] Running upgrade 594422d373ee -> 61663558142cINFO [alembic.runtime.migration] Running upgrade 61663558142c -> 867d39095bf4, port forwarding INFO [alembic.runtime.migration] Running upgrade b67e765a3524 -> a84ccf28f06aINFO [alembic.runtime.migration] Running upgrade a84ccf28f06a -> 7d9d8eeec6adINFO [alembic.runtime.migration] Running upgrade 7d9d8eeec6ad -> a8b517cff8abINFO [alembic.runtime.migration] Running upgrade a8b517cff8ab -> 3b935b28e7a0INFO [alembic.runtime.migration] Running upgrade 3b935b28e7a0 -> b12a3ef66e62INFO [alembic.runtime.migration] Running upgrade b12a3ef66e62 -> 97c25b0d2353INFO [alembic.runtime.migration] Running upgrade 97c25b0d2353 -> 2e0d7a8a1586INFO [alembic.runtime.migration] Running upgrade 2e0d7a8a1586 -> 5c85685d616dOK[root@node01 ~]# 验证:连接neutron数据库中是否有表⽣成?MariaDB [(none)]> use neutronReading table information for completion of table and column namesYou can turn off this feature to get a quicker startup with -ADatabase changedMariaDB [neutron]> show tables;+-----------------------------------------+| Tables_in_neutron |+-----------------------------------------+| address_scopes || agents || alembic_version || allowedaddresspairs || arista_provisioned_nets || arista_provisioned_tenants || arista_provisioned_vms || auto_allocated_topologies || bgp_peers || bgp_speaker_dragent_bindings || bgp_speaker_network_bindings || bgp_speaker_peer_bindings || bgp_speakers || brocadenetworks || brocadeports || cisco_csr_identifier_map || cisco_hosting_devices || cisco_ml2_apic_contracts || cisco_ml2_apic_host_links || cisco_ml2_apic_names || cisco_ml2_n1kv_network_bindings || cisco_ml2_n1kv_network_profiles || cisco_ml2_n1kv_policy_profiles || cisco_ml2_n1kv_port_bindings || cisco_ml2_n1kv_profile_bindings || cisco_ml2_n1kv_vlan_allocations || cisco_ml2_n1kv_vxlan_allocations || cisco_ml2_nexus_nve || cisco_ml2_nexusport_bindings || cisco_port_mappings || cisco_router_mappings || consistencyhashes || default_security_group || dnsnameservers || dvr_host_macs || externalnetworks || extradhcpopts || firewall_policies || firewall_rules || firewalls || flavors || flavorserviceprofilebindings || floatingipdnses || floatingips || ha_router_agent_port_bindings || ha_router_networks || ha_router_vrid_allocations || healthmonitors || ipallocations || ipamallocationpools || ipamallocations || ipamsubnets || ipsec_site_connections || ipsecpeercidrs || ipsecpolicies || logs || lsn || lsn_port || maclearningstates || members || meteringlabelrules || meteringlabels || ml2_brocadenetworks || ml2_brocadeports || ml2_distributed_port_bindings || ml2_flat_allocations || ml2_geneve_allocations || ml2_geneve_endpoints || ml2_gre_allocations || ml2_gre_endpoints || ml2_nexus_vxlan_allocations || ml2_nexus_vxlan_mcast_groups || ml2_port_binding_levels || ml2_port_bindings || ml2_ucsm_port_profiles || ml2_vlan_allocations || ml2_vxlan_allocations || ml2_vxlan_endpoints || multi_provider_networks || networkconnections || networkdhcpagentbindings || networkdnsdomains || networkgatewaydevicereferences || networkgatewaydevices || networkgateways || networkqueuemappings || networkrbacs || networks || networksecuritybindings || networksegments || neutron_nsx_network_mappings || neutron_nsx_port_mappings || neutron_nsx_router_mappings || neutron_nsx_security_group_mappings | | nexthops || nsxv_edge_dhcp_static_bindings || nsxv_edge_vnic_bindings || nsxv_firewall_rule_bindings || nsxv_internal_edges || nsxv_internal_networks || nsxv_port_index_mappings || nsxv_port_vnic_mappings || nsxv_router_bindings || nsxv_router_ext_attributes || nsxv_rule_mappings || nsxv_security_group_section_mappings | | nsxv_spoofguard_policy_network_mappings | | nsxv_tz_network_bindings || nsxv_vdr_dhcp_bindings || nuage_net_partition_router_mapping || nuage_net_partitions || nuage_provider_net_bindings || nuage_subnet_l2dom_mapping || poolloadbalanceragentbindings || poolmonitorassociations || pools || poolstatisticss || portbindingports || portdataplanestatuses || portdnses || portforwardings || portqueuemappings || ports || portsecuritybindings || providerresourceassociations || provisioningblocks || qos_bandwidth_limit_rules || qos_dscp_marking_rules || qos_fip_policy_bindings || qos_minimum_bandwidth_rules || qos_network_policy_bindings || qos_policies || qos_policies_default || qos_port_policy_bindings || qospolicyrbacs || qosqueues || quotas || quotausages || reservations || resourcedeltas || router_extra_attributes || routerl3agentbindings || routerports || routerroutes || routerrules || routers || securitygroupportbindings || securitygrouprules || securitygroups || segmenthostmappings || serviceprofiles || sessionpersistences || standardattributes || subnet_service_types || subnetpoolprefixes || subnetpools || subnetroutes || subnets || subports || tags || trunks || tz_network_bindings || vcns_router_bindings || vips || vpnservices |+-----------------------------------------+167 rows in set (0.00 sec)MariaDB [neutron]>[root@node01 ~]# systemctl restart openstack-nova-api.service[root@node01 ~]# ss -tnlState Recv-Q Send-Q Local Address:Port Peer Address:PortLISTEN 0 128 *:9292 *:*LISTEN 0 128 *:22 *:*LISTEN 0 100 127.0.0.1:25 *:*LISTEN 0 100 *:6080 *:*LISTEN 0 128 *:8774 *:*LISTEN 0 128 *:8775 *:*LISTEN 0 128 *:9191 *:*LISTEN 0 128 :::80 :::*LISTEN 0 128 :::22 :::*LISTEN 0 100 ::1:25 :::*LISTEN 0 128 :::5000 :::*LISTEN 0 128 :::8778 :::*[root@node01 ~]# 提⽰:重启确保nova-api服务的8774和8775端⼝正常监听; 启动neutron相关服务,并将其设置为开机启动[root@node01 ~]# systemctl start neutron-server.service \> neutron-linuxbridge-agent.service neutron-dhcp-agent.service \> neutron-metadata-agent.service[root@node01 ~]# systemctl enable neutron-server.service neutron-linuxbridge-agent.service neutron-dhcp-agent.service neutron-metadata-agent.serviceCreated symlink from /etc/systemd/system/multi-user.target.wants/neutron-server.service to /usr/lib/systemd/system/neutron-server.service.Created symlink from /etc/systemd/system/multi-user.target.wants/neutron-linuxbridge-agent.service to /usr/lib/systemd/system/neutron-linuxbridge-agent.service.Created symlink from /etc/systemd/system/multi-user.target.wants/neutron-dhcp-agent.service to /usr/lib/systemd/system/neutron-dhcp-agent.service.Created symlink from /etc/systemd/system/multi-user.target.wants/neutron-metadata-agent.service to /usr/lib/systemd/system/neutron-metadata-agent.service.[root@node01 ~]# ss -tnlState Recv-Q Send-Q Local Address:Port Peer Address:PortLISTEN 0 128 *:9292 *:*LISTEN 0 128 *:22 *:*LISTEN 0 100 127.0.0.1:25 *:*LISTEN 0 128 *:9696 *:*LISTEN 0 100 *:6080 *:*LISTEN 0 128 *:8774 *:*LISTEN 0 128 *:8775 *:*LISTEN 0 128 *:9191 *:*LISTEN 0 128 :::80 :::*LISTEN 0 128 :::22 :::*LISTEN 0 100 ::1:25 :::*LISTEN 0 128 :::5000 :::*LISTEN 0 128 :::8778 :::*[root@node01 ~]# 提⽰:请确保9696端⼝正常监听; 如果我们选⽤的是self-service network 我们还需要启动L3 agent 服务,并将其设置为开机启动[root@node01 ~]# systemctl start neutron-l3-agent.service[root@node01 ~]# systemctl enable neutron-l3-agent.serviceCreated symlink from /etc/systemd/system/multi-user.target.wants/neutron-l3-agent.service to /usr/lib/systemd/system/neutron-l3-agent.service.[root@node01 ~]# 到此控制节点的neutron服务就配置好了 3、在计算节点安装配置neutron服务 安装neutron相关服务包[root@node03 ~]# yum install openstack-neutron-linuxbridge ebtables ipset -y 编辑/etc/neutron/neutron.conf,在【DEFAULT】配置段配置连接rabbitmq相关信息,以及配置认证策略为keystone 在【keystone_authtoken】配置段配置keystone认证相关信息 在【oslo_concurrency】配置段配置锁路径 neutron.conf最终配置[root@node03 ~]# grep -i ^"[a-z\[]" /etc/neutron/neutron.conf[DEFAULT]transport_url = rabbit://openstack:openstack123@node02auth_strategy = keystone[agent][cors][database][keystone_authtoken]www_authenticate_uri = http://controller:5000auth_url = http://controller:5000memcached_servers = node02:11211auth_type = passwordproject_domain_name = defaultuser_domain_name = defaultproject_name = serviceusername = neutronpassword = neutron[matchmaker_redis][nova][oslo_concurrency]lock_path = /var/lib/neutron/tmp[oslo_messaging_amqp][oslo_messaging_kafka][oslo_messaging_notifications][oslo_messaging_rabbit][oslo_messaging_zmq][oslo_middleware][oslo_policy][quotas][ssl][root@node03 ~]# 配置linux bridge agent 编辑/etc/neutron/plugins/ml2/linuxbridge_agent.ini配置⽂件,在【linux_bridge】配置段配置provider⽹络映射到物理的那个接⼝ 提⽰:这⾥冒号前边的是虚拟机内部⽹络名称,这个名称请确保和控制节点上配置的虚拟机内部⽹络名称相同;冒号后⾯的是配置要桥接的物理接⼝名称; 在【vxlan】配置段配置启⽤vxlan,并配置本地管理ip地址和开启l2_population 在【securitygroup】配置段配置启⽤安全组并配置Linux bridge iptables防⽕墙驱动程序。

openstack 单网卡安装多节点

一.准备系统 操作系统:ubunt12.04 server 64(桌面也 ok)1.将你的系统升级到最新1 2sudo apt-get update sudo aptitude uograde下面的这些操作大家最好都用 root 用户来操作, sudo passwd root 这个可以设置 ubuntu root su 2.设置本机的 ip1sudo vim /etc/network/interfaces将下面的设置复制进去 这个 ip 是可以更改的,如果改变亦需要保持后续的 ip 都跟着更改1 2 3 4 5 6 7 8 9 10 11auto lo iface lo inet loopback# The primary network interface auto eth0 iface eth0 inet static address 192.168.1.2 netmask 255.255.255.0 broadcast 192.168.1.255 gateway 192.168.1.1 dns-nameservers 202.117.128.2 #根据自己的环境设置好然后重启网络,让配置生效:1/etc/init.d/networking restart2.安装 bridge1apt-get install bridge-utils重启网络1/etc/init.d/networking restart3.设置 NTP1 2 3 4 5 6 7apt-get install ntp编辑 /etc/ntp.conf 在末尾添加下面 3 行#server iburst 这个是 ubuntu 默认的同步 server 127.127.1.0 fudge 127.127.1.0 stratum 10重启服务1sudo /etc/init.d/ntp restart4.设置 Iscsi1apt-get install tgt重启服务1sudo /etc/init.d/tgt start安装 iscsi 客户端1apt-get install open-iscsi open-iscsi-utils5:安装 rabbitmq1 2 3apt-get install rabbitmq-server memcached python-memcacheapt-get install kvm libvirt-bin第二步:安装 mysql,创建相关数据库Openstack 的组件:nova,keystone,glance,都需要数据库。

openstack生产集群部署

openstack生产集群部署OpenStack是一种开源的云计算软件平台,它允许用户在私有云环境中构建和管理弹性和可扩展的云基础设施。

在生产环境中进行OpenStack 集群部署是一个复杂的过程,需要仔细规划和准备。

以下是一个关于OpenStack生产集群部署的详细解释,超过1200字。

第一步是规划和准备。

在开始OpenStack集群部署之前,您需要先进行规划并准备好所需的硬件和软件环境。

您需要评估您的需求,并选择合适的硬件来支持您的OpenStack集群。

这包括服务器、存储设备和网络设备。

您还需要选择一个适合您的操作系统来运行OpenStack,如CentOS、Ubuntu等。

同时,您需要确保硬件和软件环境的可靠性和稳定性。

第二步是安装和配置OpenStack服务。

在部署之前,您需要选择一种OpenStack的发行版来使用,如Red Hat OpenStack、Canonical OpenStack等。

在选择发行版后,您需要按照其提供的文档和指南来安装和配置OpenStack服务。

这包括设置控制节点和计算节点、配置网络和存储等。

您可能还需要安装和配置一些额外的服务和工具来增强OpenStack 的功能和性能,如容器管理工具Docker、大数据处理工具Hadoop等。

第三步是测试和调优。

在完成OpenStack集群的安装和配置后,您需要进行测试和调优来确保其稳定运行和性能。

您可以使用一些测试工具和负载生成器来模拟实际使用情况,并进行性能测试。

根据测试结果,您可以调整和优化OpenStack的配置和参数来提高其性能和可靠性。

此外,您还可以监控OpenStack集群的运行状态和资源使用情况,并根据需要进行调整和优化。

第四步是部署和管理应用程序。

一旦您成功地部署和配置了OpenStack集群,您可以开始部署和管理您的应用程序。

OpenStack提供了一些服务和工具来帮助您部署和管理应用程序,如虚拟机管理工具Nova、容器管理工具Magnum等。