Hadoop入门课程有哪些

《Hadoop大数据技术与应用》课程教学大纲 - 20190422

Hadoop大数据技术与应用(含实验)教学大纲前言一、大纲编写依据《Hadoop大数据技术与应用》是数据科学、大数据方向本科生的一门必修课。

通过该课程的学习,使学生系统的学习当前广泛使用的大数据Hadoop平台及其主要组件的作用及使用。

课程由理论及实践两部分组成,课程理论部分的内容以介绍Hadoop平台主要组件的作用、结构、工作流程为主,让学生对Hadoop平台组件的作用及其工作原理有比较深入的了解;课程同时为各组件设计有若干实验,帮助学生在学习理论知识的同时,提高学生的实践能力,系统的掌握Hadoop主要组件的原理及应用,为其他相关课程的学习提供必要的帮助。

二、课程目的1、知识目标学习Hadoop平台框架,学会手动搭建Hadoop环境,掌握Hadoop平台上存储及计算的原理、结构、工作流程,掌握基础的MapReduce编程,掌握Hadoop生态圈常用组件的作用、结构、配置和工作流程,并具备一定的动手及问题分析能力,使用掌握的知识应用到实际的项目实践中。

2、能力目标(1) 工程师思维方式通过本课程的学习,引导学生养成工程师逻辑思维、系统思维的思维方式及习惯。

(2) 分析及解决问题的能力课程中实验由浅及深,有一定的步骤及难度,操作不当可能会遇到问题;遇到问题时老师会给出引导,但不会直接告诉解决方法,因此,如何分析、分析完成后实施具体的解决步骤,都需要学生摸索完成,在这个摸索实践过程中,学生的分析及解决问题的能力得到培养。

三、教学方法1、课堂教学(1) 讲授本课程的理论教学内容以讲授为主、辅以操作演示,讲授的主要内容有:Hadoop概述,Hadoop安装部署,分布式文件系统HDFS,分布式计算MapReduce,资源管理调度组件YARN,列式存储HBase,数据仓库组件Hive,数据分析引擎Pig,日志采集组件Flume等。

根据教学大纲的要求,突出重点和难点。

(2) 教师指导下的学生自学实践课程由若干实验组成,每个实验都包含实验目的、实验原理、实验环境等,需要学生结合理论知识,充分发挥自主学习的能力来完成实验,老师在这个过程中更多起到辅导的作用。

Hadoop集群配置与数据处理入门

Hadoop集群配置与数据处理入门1. 引言Hadoop是一个开源的分布式计算框架,被广泛应用于大规模数据处理和存储。

在本文中,我们将介绍Hadoop集群的配置和数据处理的基本概念与入门知识。

2. Hadoop集群配置2.1 硬件要求架设Hadoop集群需要一定的硬件资源支持。

通常,集群中包含主节点和若干个从节点。

主节点负责整个集群的管理,而从节点负责执行具体的计算任务。

在硬件要求方面,主节点需要具备较高的计算能力和存储空间。

从节点需要具备较低的计算能力和存储空间,但数量较多。

此外,网络带宽也是一个关键因素。

较高的网络带宽可以加快数据的传输速度,提升集群的效率。

2.2 软件要求Hadoop运行在Java虚拟机上,所以首先需要确保每台主机都安装了适当版本的Java。

其次,需要安装Hadoop分发版本,如Apache Hadoop或Cloudera等。

针对集群管理,可以选择安装Hadoop的主节点管理工具,如Apache Ambari或Cloudera Manager。

这些工具可以帮助用户轻松管理集群的配置和状态。

2.3 配置文件Hadoop集群部署需要配置多个文件。

其中,最重要的是核心配置文件core-site.xml、hdfs-site.xml和yarn-site.xml。

core-site.xml配置Hadoop的核心参数,如文件系统和输入输出配置等;hdfs-site.xml用于配置Hadoop分布式文件系统;yarn-site.xml配置Hadoop资源管理器和任务调度器相关的参数。

3. 数据处理入门3.1 数据存储与处理Hadoop的核心之一是分布式文件系统(HDFS),它是Hadoop集群的文件系统,能够在集群中存储海量数据。

用户可以通过Hadoop的命令行工具或API进行文件的读取、写入和删除操作。

3.2 数据处理模型MapReduce是Hadoop的编程模型。

它将大规模的数据集拆分成小的数据块,并分配给集群中的多个计算节点进行并行处理。

《Hadoop大数据技术》课程理论教学大纲

《Hadoop大数据技术》课程教学大纲一、课程基本情况课程代码:1041139083课程名称(中/英文):Hadoop大数据技术/Hadoop Big Data Technology课程类别:专业必修课学分:3.5总学时:56理论学时:32实验/实践学时:24适用专业:数据科学与大数据技术适用对象:本科先修课程:JA V A程序设计、Linux基础教学环境:课堂、多媒体、实验机房二、课程简介《Hadoop大数据技术》课程是数据科学与大数据技术专业的专业必修课程。

《Hadoop大数据技术》主要学习当前广泛使用的大数据Hadoop平台及其主要组件的作用及使用。

通过学习Hadoop 平台框架,学会手动搭建Hadoop环境,掌握Hadoop平台上存储及计算的原理、结构、工作流程,掌握基础的MapReduce编程,掌握Hadoop生态圈常用组件的作用、结构、配置和工作流程,并具备大数据的动手及问题分析能力,使用掌握的知识应用到实际的项目实践中。

课程由理论及实践两部分组成,课程理论部分的内容以介绍Hadoop平台主要组件的作用、结构、工作流程为主,对Hadoop 平台组件的作用及其工作原理有比较深入的了解;课程同时为各组件设计有若干实验,使学生在学习理论知识的同时,提高实践动手能力,做到在Hadoop的大数据平台上进行大数据项目开发。

三、课程教学目标2.课程教学目标及其与毕业要求指标点、主要教学内容的对应关系四、教学内容(一)初识Hadoop大数据技术1.主要内容:掌握大数据的基本概念、大数据简史、大数据的类型和特征、大数据对于企业带来的挑战。

了解对于大数据问题,传统方法、Google的解决方案、Hadoop框架下的解决方案,重点了解Google的三篇论文。

掌握Hadoop核心构成、Hadoop生态系统的主要组件、Hadoop发行版本的差异及如何选择;了解Hadoop典型应用场景;了解本课程内容涉及到的Java语言基础;了解本课程实验涉及到的Linux基础。

最详细的Hadoop入门教程

最详细的Hadoop⼊门教程前⾔Hadoop 在⼤数据技术体系中的地位⾄关重要,Hadoop 是⼤数据技术的基础,对Hadoop基础知识的掌握的扎实程度,会决定在⼤数据技术道路上⾛多远。

这是⼀篇⼊门⽂章,Hadoop 的学习⽅法很多,⽹上也有很多学习路线图。

本⽂的思路是:以安装部署 Apache Hadoop2.x 版本为主线,来介绍 Hadoop2.x 的架构组成、各模块协同⼯作原理、技术细节。

安装不是⽬的,通过安装认识Hadoop才是⽬的。

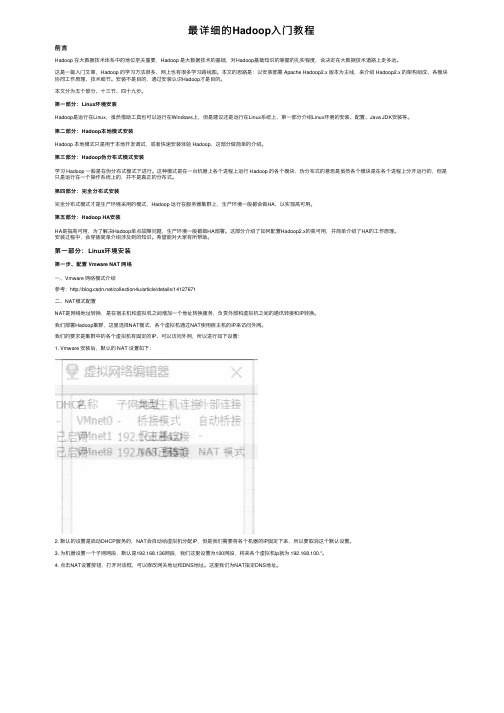

本⽂分为五个部分、⼗三节、四⼗九步。

第⼀部分:Linux环境安装Hadoop是运⾏在Linux,虽然借助⼯具也可以运⾏在Windows上,但是建议还是运⾏在Linux系统上,第⼀部分介绍Linux环境的安装、配置、Java JDK安装等。

第⼆部分:Hadoop本地模式安装Hadoop 本地模式只是⽤于本地开发调试,或者快速安装体验 Hadoop,这部分做简单的介绍。

第三部分:Hadoop伪分布式模式安装学习 Hadoop ⼀般是在伪分布式模式下进⾏。

这种模式是在⼀台机器上各个进程上运⾏ Hadoop 的各个模块,伪分布式的意思是虽然各个模块是在各个进程上分开运⾏的,但是只是运⾏在⼀个操作系统上的,并不是真正的分布式。

第四部分:完全分布式安装完全分布式模式才是⽣产环境采⽤的模式,Hadoop 运⾏在服务器集群上,⽣产环境⼀般都会做HA,以实现⾼可⽤。

第五部分:Hadoop HA安装HA是指⾼可⽤,为了解决Hadoop单点故障问题,⽣产环境⼀般都做HA部署。

这部分介绍了如何配置Hadoop2.x的⾼可⽤,并简单介绍了HA的⼯作原理。

安装过程中,会穿插简单介绍涉及到的知识。

希望能对⼤家有所帮助。

第⼀部分:Linux环境安装第⼀步、配置 Vmware NAT ⽹络⼀、Vmware ⽹络模式介绍参考:/collection4u/article/details/14127671⼆、NAT模式配置NAT是⽹络地址转换,是在宿主机和虚拟机之间增加⼀个地址转换服务,负责外部和虚拟机之间的通讯转接和IP转换。

Hadoop基础知识培训

存储+计算(HDFS2+Yarn)

集中存储和计算的主要瓶颈

Oracle IBM

EMC存储

scale-up(纵向扩展)

➢计算能力和机器数量成正比 ➢IO能力和机器数量成非正比

多,Intel,Cloudera,hortonworks,MapR • 硬件基于X86服务器,价格低,厂商多 • 可以自行维护,降低维护成本 • 在互联网有大规模成功案例(BAT)

总 结

• Hadoop平台在构建数据云(DAAS)平台有天 然的架构和成本的优势

成本投资估算:从存储要求计算所需硬件及系统软件资源(5000万用户 为例)

往HDFS中写入文件

• 首要的目标当然是数 据快速的并行处理。 为了实现这个目标, 我们需要竟可能多的 机器同时工作。

• Cient会和名称节点达 成协议(通常是TCP 协议)然后得到将要 拷贝数据的3个数据节 点列表。然后Client将 会把每块数据直接写 入数据节点中(通常 是TCP 协议)。名称 节点只负责提供数据 的位置和数据在族群 中的去处(文件系统 元数据)。

• 第二个和第三个数据 节点运输在同一个机 架中,这样他们之间 的传输就获得了高带 宽和低延时。只到这 个数据块被成功的写 入3个节点中,下一 个就才会开始。

• 如果名称节点死亡, 二级名称节点保留的 文件可用于恢复名称 节点。

• 每个数据节点既扮演者数据存储的角色又 冲当与他们主节点通信的守护进程。守护 进程隶属于Job Tracker,数据节点归属于 名称节点。

大数据培训方案

大数据培训方案一、方案背景随着信息时代的到来,数据已经成为了企业的重要资源之一。

大数据技术的应用已经逐渐普及,对于企业来说,拥有专业的大数据技术人才已经成为了必不可少的条件。

因此,大数据培训方案应运而生。

二、培训目标1.掌握大数据相关技术和工具,如Hadoop、Spark等;2.熟悉大数据处理流程和方法;3.能够独立完成大数据项目开发和实现;4.具备良好的团队合作能力和沟通能力。

三、培训内容1.基础课程:包括Linux操作系统基础、Java编程语言基础等;2.Hadoop课程:包括HDFS、MapReduce、YARN等核心模块的学习;3.Spark课程:包括Spark核心原理、Spark SQL等相关知识的学习;4.实战项目:通过实际项目演练,加深对于所学知识点的理解和掌握。

四、培训方式1.线下教学:采用面授方式进行教学,每周安排固定时间上课;2.在线教学:采用网络直播方式进行教学,学员可以随时随地进行学习。

五、培训周期1.线下教学:为期3个月,每周2-3次课程;2.在线教学:为期4个月,每周1-2次课程。

六、培训师资1.专业师资:拥有多年大数据开发经验的专业人士授课;2.企业导师:根据实际项目需求,提供实战指导和技术支持。

七、培训评估1.考试评估:每个阶段结束后进行考试,通过率达到80%以上方可晋级下一阶段;2.项目评估:通过实际项目演练,对学员的综合能力进行评估。

八、培训证书1.结业证书:完成全部培训课程并通过考试者颁发结业证书;2.实战证书:在实际项目中表现优秀者颁发实战证书。

九、总结与展望大数据技术已经成为了企业的重要资源之一,拥有专业的大数据技术人才已经成为了必不可少的条件。

本方案通过系统的课程设置和严格的考核机制,旨在培养出具备良好的大数据技术和团队合作能力的专业人才,为企业的发展提供有力的支持。

「大数据技术」大数据技术入门课程

「大数据技术」大数据技术入门课程随着互联网的发展,数据逐渐成为了许多公司重要的资源。

然而,海量的数据如何处理是业界面临的难题。

答案便是大数据技术。

这种技术可以处理海量而复杂的数据集,帮助公司更好地理解和利用它们所拥有的数据。

大数据技术是一个相对较新的领域,因此有很多人还不了解这种技术。

如果你也对大数据技术感到好奇,打算深入了解这个领域,可以先从入门课程开始。

本文将介绍一些大数据入门课程,以帮助你更好地了解大数据技术。

1. Coursera的大数据入门课程Coursera是一家在线教育平台,提供了许多的在线课程。

其中有一个大数据入门课程,由UC San Diego的教授组织。

这门课程教授大数据的一个基本知识,包括大数据的定义、应用场景、分析方法和工具等等。

这门课程适合那些从未学习过大数据技术的人,它为学生提供了一个很好的入门机会。

2. 大数据分析课程大数据分析课程由IBM Cloud提供,它是IBM公司提供的培训计划的一部分,旨在帮助培训学生成为具有大数据知识和技能的专业人员。

学生将学习如何使用IBM的大数据分析工具,在处理和分析大数据方面具有很好的实践经验。

3. 大数据分析和计算课程大数据分析和计算课程由Databricks提供,这家公司是Apache Spark项目的主要开发者。

该课程概述了大数据分析和计算的基础知识,并教授了如何使用Databricks平台来进行大数据分析和计算。

这门课程的特点是由业内专家领导,教学内容实用而深入。

4. 大数据挖掘与数据分析大数据挖掘与数据分析课程由哈佛大学提供,旨在帮助学生学习如何在大数据的背景下进行数据挖掘和数据分析。

学生将学到如何使用Hadoop、Hive、Pig和其他大数据技术工具,以掌握数据挖掘和分析的基本概念和技巧。

这些大数据入门课程有不同的教学方式和内容,可以选择适合自己的课程进行学习。

无论哪门课程,它们都提供了一个很好的机会来学习大数据技术,帮助学生开启大数据分析的大门。

hadoop大数据技术基础 python版

Hadoop大数据技术基础 python版随着互联网技术的不断发展和数据量的爆炸式增长,大数据技术成为了当前互联网行业的热门话题之一。

Hadoop作为一种开源的大数据处理评台,其在大数据领域的应用日益广泛。

而Python作为一种简洁、易读、易学的编程语言,也在大数据分析与处理中扮演着不可或缺的角色。

本文将介绍Hadoop大数据技术的基础知识,并结合Python编程语言,分析其在大数据处理中的应用。

一、Hadoop大数据技术基础1. Hadoop简介Hadoop是一种用于存储和处理大规模数据的开源框架,它主要包括Hadoop分布式文件系统(HDFS)和MapReduce计算框架。

Hadoop分布式文件系统用于存储大规模数据,而MapReduce计算框架则用于分布式数据处理。

2. Hadoop生态系统除了HDFS和MapReduce之外,Hadoop生态系统还包括了许多其他组件,例如HBase、Hive、Pig、ZooKeeper等。

这些组件形成了一个完整的大数据处理评台,能够满足各种不同的大数据处理需求。

3. Hadoop集群Hadoop通过在多台服务器上构建集群来实现数据的存储和处理。

集群中的各个计算节点共同参与数据的存储和计算,从而实现了大规模数据的分布式处理。

二、Python在Hadoop大数据处理中的应用1. Hadoop StreamingHadoop Streaming是Hadoop提供的一个用于在MapReduce中使用任意编程语言的工具。

通过Hadoop Streaming,用户可以借助Python编写Map和Reduce的程序,从而实现对大规模数据的处理和分析。

2. Hadoop连接Python除了Hadoop Streaming外,Python还可以通过Hadoop提供的第三方库和接口来连接Hadoop集群,实现对Hadoop集群中数据的读取、存储和计算。

这为Python程序员在大数据处理领域提供了更多的可能性。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

Hadoop入门课程有哪些

随着大数据的发展,Hadoop的名声也越来越大了,Hadoop作为一个大数据处理的软件框架,一直以可靠,高效,可伸缩的方式处理着诸多的数据。

Hadoop是可靠的,它会假设存储失败,因此维护多个数据的副本,确保失败后重新处理。

Hadoop是高效的,并行的方式工作,加快了处理的速度。

Hadoop也是可伸缩的,能够处理PB级别的数据。

Hadoop最大的优势是成本低,任何人都可以使用。

柠檬学院大数据。

Hadoop的组成

1,Hadoop Common:Hadoop体系最底层的一个模块,为子项目提供各种工具,

2,HDFS:分布式文件系统,吞吐量高,可创建,删除,移动和重命名文件等,

3,MapReduce :分布式海量数据处理的软件框架集计算集群。

4.Avro:doug cutting主持的RPC项目,主要负责数据的序列化。

有点类似Google的protobuf和Facebook的thrift。

avro用来做以后hadoop的RPC,使hadoop的RPC模块通信速度更快、数据结构更紧凑。

5、Hive :类似CloudBase,也是基于hadoop分布式计算平台上的提供data warehouse 的sql功能的一套软件。

使得存储在hadoop里面的海量数据的汇总,即席查询简单化。

hive 提供了一套QL的查询语言,以sql为基础,使用起来很方便。

6、HBase :基于Hadoop Distributed File System,是一个开源的,基于列存储模型的可扩展的分布式数据库,支持大型表的存储结构化数据。

7、Pig :是一个并行计算的高级的数据流语言和执行框架,SQL-like语言,是在MapReduce上构建的一种高级查询语言,把一些运算编译进MapReduce模型的Map和Reduce中,并且用户可以定义自己的功能。

8、ZooKeeper :Google的Chubby一个开源的实现。

它是一个针对大型分布式系统的可靠协调系统,提供的功能包括:配置维护、名字服务、分布式同步、组服务等。

ZooKeeper 的目标就是封装好复杂易出错的关键服务,将简单易用的接口和性能高效、功能稳定的系统提供给用户。

9、Chukwa :一个管理大型分布式系统的数据采集系统由yahoo贡献。

10、Cassandra :无单点故障的可扩展的多主数据库

11、Mahout :一个可扩展的机器学习和数据挖掘库。