常用无约束最优化方法(一)

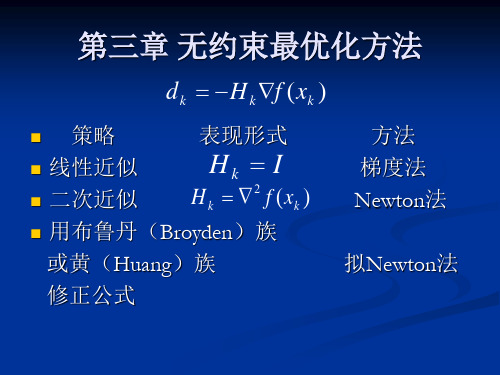

第三章 无约束最优化方法

f x f x

*

所以函数f(x)在 x * 处取得局部极小值,称x *为

局部极小点。 而优化问题一般是要求目标函数在某一区域内 的全局极小点。 函数的局部极小点是不是一定是全局极小点呢?

5

第三章 无约束最优化方法

下凸的一元函数

可以证明凸规划问题的局部最小点就是其全局最小点。

6

第三章 无约束最优化方法

f x 0

x Rn

的问题。一般地,这是一个非线性方程组, 17 可对其采用迭代法求解之。

第三章 无约束最优化方法

下降迭代算法

算法:给定目标函数 f x 的极小点的一个初始估计点 x0 , 然后按一定的规则产生一个序列 xk ,这种规则通常称 为算法。如果这个序列的极限恰好是问题(3-1)的极 小点 x* ,即

正定矩阵 设 Q是n×n 阶对称矩阵。

若 x Rn 且 x 0 都有 x T Q x 0 ,则称矩阵Q 是正定的 若 x R

n n

T x 都有 Q x 0 ,则称矩阵Q 是半正定的

若 x R 且 x 0 都有 xT Q x 0 ,则称矩阵Q 是负定的 若 x Rn 都有 x T Q x 0 ,则称矩阵Q 是半负定的

为正定的定义是:若对任何向量d (d!=0),有

d T 2 f x* d 0

对称正定方阵 2 f x* 的检验方法是所有主子式均大于零。 二、迭代方法 求解 无约束最优化问题 T f x min x x1, x2 , , xn 的问题可以转变为求解n 元方程组

26

3-2

一维搜索(0.618法)

设给定一个较小的步长δ,从α=0开始,先计算φ(0),然 后计算在 (1.618)0 的函数值φ(δ);如果φ(δ)<φ(0), 则讲步长δ增大1.618倍,得到一个新点 1.618 2.618 , 计算φ(2.618δ);如果φ(2.618δ)仍小于φ(δ),再继续增加 步长为原步长的1.618倍,如下图所示,从而得到一系列 j 点的αj的值为 '

无约束问题的最优化条件

f

(x)

f

(xk ) f

(xk )T

(x

xk )

1 (x 2

xk )T 2

f

(xk )(x

xk )

Q(k) (x)

f

(xk ) f

(xk )T (x xk )

1 2

(

x

xk

)T

2

f

(xk )(x xk )

令

Q(k) (x) x

0

f

( xk

)

2

f

(

xk

)(

x

xk

)

0

x xk (2 f (xk ))1f (xk ) xk Gk1gk

k 满足:

f (xk

dk ) 0

T f (xk k dk )gdk 0

ห้องสมุดไป่ตู้

d

T k 1

gd

k

0

14

a

5.3 牛顿法

自动化学院

15

a

一、牛顿迭代公式

牛顿法的基本思想是利用目标函数在当前迭代点 xk 处 的二次近似的极小点作为 f (x) 的近似极小点。

16

a

设 xk 是当前迭代点, 2 f (xk ) 正定,

5.1 无约束问题的 最优性条件

自动化学院

1

a

一、极小点的概念

1.局部极小点 2.严格局部极小点 3.全局(总体)极小点 4.严格全局(总体)极小点。 注:在非线性规划中,大多数算法都致力于求最优化 问题的局部极小点,一般求全局极小点极为困难,仅 当问题为凸规划时,局部极小为全局极小。

2

a

二、无约束问题最优性条件

的极小值,0.01,x(0)(0,0)T ,只迭代一次

第三章 无约束最优化--梯度方法(1)

2 做直线搜索 zk 1 LS( zk , - gk ), 计算f k 1 f ( zk 1 ), gk 1 g ( zk 1 ); 3 判定终止准则H是否满足,若满足则打印最优解 z k+1 , f k+1, 终止。否则转2。 将最速下降法用于具有对称正定矩阵Q的二次函数: 1 T f ( z ) z Qz bT z c,可以推出步长公式来 : 2 设第 k 次迭代点为zk 。下面求zk 1的表达式:

f z k f z k 1 f z k f z k f zk

但λ到底取多大,没有统一的标准, λ取小了,收敛太慢,而λ取大 了,又会漏掉极小点。

1 T f ( z ) z Qz , 定理:对于二次函数 2

四 用于二次函数时的收敛速度

为了清除最优步长最速下降法中两个搜索方向正交的不良 后果,人们发明了不少方法,如: (1)选择不同初始点。

例如:对问题: min

取初点

为求 z1 ,沿 f z0 方向从 z0 出发求 f z 的极点,即在线 搜索 min f ( z0 tf z0 )

f ( z) x 25x T z0 2,2 f z0 104 , f z0 4,100T

2 T

* T z ( 0 , 0 ) z 然后再从 1开始迭代,经过10次迭代,近似得最优解

f ( z1 ) 3.686164 .

计算中可以发现,开始几次迭代,步长比较大,函数值下将降 较快但当接近最优点时,步长很小,目标函数值下降很慢。如 T ,0)T虽然后一初点较前一 果不取初点为 z0 (2,2) 而取 z0 (100 初点离最优点 z * (0,0)T 远,但迭代中不出现锯齿现象。这时:

第3章 无约束最优化方法 3-1 最速下降法 3-2 牛顿法

1

u f ( x)u m u

T 2

2

u R

n

则从任意的初始点 x 0 出发,阻尼牛顿法产 生的迭代点列 满足: (1)当 x k 为有穷点列时,其最后一个点 为 f ( x) 的唯一极小点。 (2)当 x k 为无穷点列时,收敛到 f ( x) 的

第3.2节 Newton法及其改进

第3.1节 最速下降法(Steepest Method)

对于最速下降法的几点说明 (1)第2.6节中介绍的关于下降算法的收敛 性定理对最速下降法都是成立的 。 (2)目标函数在负梯度方向下降得最快只 是局部性质。 (3)锯齿现象 (4)改进策略:在计算的开始阶段使用最 速下降法,在迭代数次后,改用其他算法。

本节的主要内容:

(1)牛顿法的基本思想

(2)阻尼牛顿法

(3)带保护措施的阻尼牛顿法

(4)吉尔-默里稳定牛顿法

(5)信赖域方法(一)

第3.2节 Newton法及其改进

(1)牛顿法的基本思想: * 在目标函数f ( x)的极小点 x 的近似点 x k 附近将 f ( x) 二阶Tayler展开,用展开的二次 函数去逼近 f ( x),将这个二次函数的极小点 * x 作为 的一个新的近似点 x k 1 ,依次下去, 用一系列二次函数的极小点 xk 1 去逼近 f ( x) 的极小点 x * 。

第3.2节 Newton法及其改进

设 f ( x)二次连续可微,则 f ( x) 在 x k 处的二次 近似为: 1 T f ( x) qk ( x) f ( xk ) f ( xk ) ( x xk ) ( x xk )T 2 f ( xk )( x xk ) 2 令

第3章 无约束最优化方法 3-1 最速下降法 3-2 牛顿法

是局部性质。 n (3)锯齿现象 n (4)改进策略:在计算的开始阶段使用最

速下降法,在迭代数次后,改用其他算法。

第3.1节 最速下降法(Steepest Method)

n [引理3.2](康德洛维奇Kntorovich不等式)

第3.2节 Newton法及其改进

n [推论3.8]设 且对任意的 在水平集

在开凸集D上二阶连续可微, ,存在常数 ,使得

上满足

则从任意的初始点 出发,牛顿法产生的迭

代点列 满足

,且收敛到

的唯一极小点。

第3.2节 Newton法及其改进

n 阻尼牛顿法的优点与缺点: 阻尼牛顿法克服了牛顿法要求初始点充分靠

n

,则d是下降方向;

n

,则 是下降方向。

第3.2.4节 吉尔-默里稳定牛顿法

n Gill-Murray稳定牛顿法的基本思想: n 当Hesse矩阵 在迭代点

处为不定矩阵时,对其进行强迫正 定的 分解;当 趋于零时, 采用负曲率方向使函数值下降。

第3.2.4节 吉尔-默里稳定牛顿法

n [算法3.15](求负曲率方向的算法)

得到方向 ,令

。

n (6)精确线性搜索求 ,且令

n (7)若

,则进行步(8);否则,

令

,转步(2)。

n (8)输出

,停止计算。

第3.2.4节 吉尔-默里稳定牛顿法

n [定理3.18]设 二阶连续可微,且存在

,使得

为有界闭

凸集。假定在吉尔-默里稳定牛顿法中取

,且初始点

,则吉尔-默里稳

定牛顿法产生的迭代序列 满足:

运筹学第15讲 约束最优化方法 (1)

第六章 约束最优化方法

6.1 Kuhn-Tucker 条件

一、等式约束性问题的最优性条件: 考虑 min f(x) s.t. h(x)=0 回顾高等数学中所学的条件极值: 问题 求z=f(x,y) 在ф(x,y)=0 条件下的极 值。 即 min f(x,y) S.t. ф(x,y)=0 引入Lagrange乘子:λ

充要条件是

⎧ min ∇ f ( x ) T d ⎪ A 1d ≥ 0 ⎪ ⎨ Ed = 0 ⎪ ⎪ | d j |≤ 1 , j = 1 , L n ⎩ 0。

的目标函数最优值为

第六章

6.2 既约梯度法

显 然 d = 0 是 可 行 解 , 所 以 P1的 最 优 值 必 ≤ 0 。 1 o 若 目 标 函 数 的 最 优 值 < 0 , 则 d 为 ( P )的 下 降 可 行 方 向 ; 2 o 若 目 标 函 数 的 最 优 值 = 0, 则 x 为 K − T 点 。 < 确定一维搜索的步长: 设 x( k )是 可 行 解 , d ( k ) 为 下 降 可 行 方 向 , 求 λ k 使 x( k + 1 ) = x( k ) + λ k d ( k ) . ⎧ m in f ( x( k ) + λ d ( k ) ) ⎪ ⎪ s .t . A ( x( k ) + λ d ( k ) ) ≥ b λk满 足 : ⎨ ⎪ E ( x( k ) + λ d ( k ) ) = e ⎪ ⎩ λ ≥ 0 $ = b − A x( k ) , d $ = A d (k), 显 然 b $ < 0. 令b 2 2 2 利 用 定 理 1可 得 λ 的 上 限 λ m a x $i ⎧ b $ i < 0} ⎪ m in { $ | d = ⎨ di ⎪ +∞ ⎩ $< 0 d $≥ 0 d

最优化方法第六讲 无约束(多维)最优化

step4. 若 || f ( xk1) || ,停止,x* xk1 ;

否则,令 k : k 1, 转step 2 。

14

➢算法框图

给定初始点x0和精度 || f ( x0 ) ||

停止,输出x1

否

是

| x1 x0 |

是 停止,输出x0

否 否

2 f (x0) 0

计算x1

x0

f ( x0 ) 2 f (x0)

1

13 62

x2

x1

1d 1

(

36 , 31

8 31

)T

7

三、最速下降法的特点

1.性质. 设 f ( x) 有一阶连续偏导数,若 步长 满足 k

f ( xk d k ) min f ( xk d k )

k

则有 f ( xk d k )T d k 0。 k

证明:令 ( ) f ( xk d k ),所以

5

一、梯度法(最速下降法):

1. 搜索方向:d k f ( xk ) ,也称为最速下降方向;

2. 搜 索 步 长: k 取 最 优 步 长, 即 满 足

f (xk

kd k )

min

f

(xk

d k ) 。

二、梯度法算法步骤:

1. 给定初始点 x1 Rn ,允许误差 0, 令k 1。

2. 计算搜索方向 d k f ( xk ) ;

Step3. 令 xk 1 xk kd k , 其中tk : f ( xk kd k ) min f ( xk d k )。

24

Step 4. 判断 xk 1 是否满足终止准则: yes: 计算 stop, 则x* : xk1

No : 转 step 5 。

非线性规划-无约束问题的最优化方法

f x( ) + l e1 = 3( + l ) + 2? 22 1

1

(

)

2

32 = 3( + l ) + 17 1

2

fl ' = 0 ? l 1

- 1

轾 轾 1 1 犏 犏 2 1 x( ) = x( ) + l e1 = 犏 + (- 1)犏 = 2 0 犏 犏 犏 犏 3 0 臌 臌

轾 0 犏 犏 ? f x(2) 2 犏 犏 3 臌

第 二 节 最

二、最速下降法的算法步骤

速 下

降 法

第1步:给定初始点 x(0),及终止误差 e > 0 ,令k =0 第2步:求梯度向量的范数 Ñ f (x(k )) 若 ? f (x(k )) 停止计算,输出x e ,停止计算,输出 (k)作为极小点的近

p( ) = - f x( )

k k

似值,否则转到下一步。 似值,否则转到下一步。 第3步:构造负梯度方向

第 一 节

一、基本思想

变

量

轮 换

法

认为最有利的搜索方向是各坐标轴的方向, 认为最有利的搜索方向是各坐标轴的方向,因此它轮流 按各坐标的方向搜索最优点。 按各坐标的方向搜索最优点。 过程:从某一个给定点出发,按第 个坐标轴 个坐标轴x 过程:从某一个给定点出发,按第i个坐标轴 i的方向搜 索时,假定有 个变量 则只有x 在变化,其余(n-1)个变量 个变量, 索时,假定有n个变量,则只有 i在变化,其余 个变量 都取给定点的值保持不变。这样依次从 做了n次单变 都取给定点的值保持不变。这样依次从x1到xn做了 次单变 量的一维搜索,完成了变量轮换法的一次迭代。 量的一维搜索,完成了变量轮换法的一次迭代。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

项目三 常用无约束最优化方法(一)

[实验目的]

编写最速下降法、Newton 法(修正Newton 法)的程序。

[实验学时]

2学时

[实验准备]

1.掌握最速下降法的思想及迭代步骤。

2.掌握Newton 法的思想及迭代步骤;

3.掌握修正Newton 法的思想及迭代步骤。

[实验内容及步骤]

编程解决以下问题:【选作一个】

1.用最速下降法求

22120min ()25[22]0.01T f X x x X ε=+==,,,.

2.用Newton 法求

22121212min ()60104f X x x x x x x =--++-,

初始点

0[00]0.01T X ε==,,.

最速下降法

Matlab 程序:

clc;clear;

syms x1 x2;

X=[x1,x2];

fx=X(1)^2+X(2)^2-4*X(1)-6*X(2)+17;

fxd1=[diff(fx,x1) diff(fx,x2)];

x=[2 3];

g=0;

e=0.0005;

a=1;

fan=subs(fxd1,[x1 x2],[x(1) x(2)]);

g=0;

for i=1:length(fan)

g=g+fan(i)^2;

end

g=sqrt(g);

step=0;

while g>e

step=step+1;

dk=-fan;

%点x(k)处的搜索步长

ak=((2*x(1)-4)*dk(1)+(2*x(2)-6)*dk(2))/(dk(1)*dk(2)-2*dk(1)^2-2*dk(2)^2);

xu=x+ak*dk;

x=xu;

%输出结果

optim_fx=subs(fx,[x1 x2],[x(1) x(2)]);

fprintf(' x=[ %d %d ] optim_fx=%d\n',x(1),x(2),optim_fx);

%计算目标函数点x(k+1)处一阶导数值

fan=subs(fxd1,[x1 x2],[x(1) x(2)]);

g=0;

for i=1:length(fan)

g=g+fan(i)^2;

end

g=sqrt(g);

end

%输出结果

optim_fx=subs(fx,[x1 x2],[x(1) x(2)]);

fprintf('\n最速下降法\n结果:\n x=[ %d %d ] optim_fx=%d\n',x(1),x(2),optim_fx); c++程序

#include<stdio.h>

#include<iostream.h>

#include<iomanip.h>

#include<math.h>

float goldena(float x[2],float p[2])

{float a;

a=-1*(x[0]*p[0]+4*x[1]*p[1])/(p[0]*p[0]+4*p[1]*p[1]);

return a;

}

void main()

{float a=0,x[2],p[2],g[2]={0,0},e=0.001,t;

int i=0;

x[0]=1.0;

x[1]=1.0;

p[0]=2*x[0];

p[1]=8*x[1];

g[0]=-p[0];

g[1]=-p[1];

printf("\n\n");

while(sqrt(g[0]*g[0]+g[1]*g[1])>e&&i<=100)

{

i=i+1;

a=goldena(x,g);

x[0]=x[0]+a*g[0];

x[1]=x[1]+a*g[1];

p[0]=2*x[0];

p[1]=8*x[1];

g[0]=-p[0];

g[1]=-p[1];

t=float(sqrt(g[0]*g[0]+g[1]*g[1]));

printf("第%d次t=%f x1=%f\tx2=%f\ta=%f\n",i,sqrt(g[0]*g[0]+g[1]*g[1]),x[0],x[1],a);

}

printf("\n最优解为:x1=%f,x2=%f\n最优值为y=%f\n",x[0],x[1],x[0]*x[0]+4*x[1]*x[1]); }。