最新2019-梯度下降法-PPT课件

梯度下降

05

梯度下降算法在机器学 习中的应用

线性回归模型参数优化

01

02

03

04

初始化参数

为线性回归模型的参数设定初 始值。

计算梯度

根据损失函数计算参数的梯度 。

更新参数

沿着梯度的反方向更新参数, 以减小损失函数的值。

迭代优化

重复计算梯度和更新参数的过 程,直到达到预设的迭代次数

或损失函数收敛。

逻辑回归模型参数优化

小批量梯度下降法适用于大 多数机器学习问题,特别是 数据集较大且需要高效优化 模型的情况。同时,该方法 也适用于需要在线学习和实 时更新的场景。

03

梯度下降算法实现步骤

数据预处理与特征选择

01

02

03

数据清洗

去除或填充缺失值、处理 异常值、删除重复数据等 。

特征缩放

通过标准化或归一化等方 法,使不同特征具有相同 的尺度,提高梯度下降算 法的收敛速度。

引入动量因子,使得梯度下降过程具有一定 的惯性,有助于逃离局部最小值。

鞍点问题及其影响分析

鞍点问题

梯度下降算法在优化过程中可能会遇 到鞍点,即某些方向上是局部最小值 ,而其他方向上是局部最大值,导致 优化过程停滞不前。

影响分析

鞍点会使得梯度下降算法在优化过程 中陷入局部区域,难以继续搜索更优 的解,从而影响优化结果和算法收敛 速度。

初始化参数

为逻辑回归模型的参数设定初始值。

更新参数

使用梯度下降算法更新参数,以最小化对数 似然损失函数的值。

计算梯度

根据对数似然损失函数计算参数的梯度。

迭代优化与正则化

通过迭代优化算法不断调整参数,同时引入 正则化项以防止过拟合。

《梯度下降法》课件

随机梯度下降法(Stochastic Gradient Descent)

总结词

计算量最小,收敛速度最快,适用于小数据集

详细描述

由于每次迭代只使用一个样本计算梯度,计算量最小,因 此随机梯度下降法的收敛速度最快。

详细描述

停止条件

迭代更新会一直进行直到满足某个停止条件,如达到预设的最大迭代次数、达到预设的精度要求或者梯度值足够 小等。

03

梯度下降法的分类

批量梯度下降法(Batch Gradient Descent)

总结词

计算量大,收敛速度慢,适用于大数据集

详细描述

由于每次迭代都需要使用整个数据集,计算量大,导致收 敛速度较慢。

发展方向:

在此添加您的文本16字

结合其他优化算法: 研究如何将梯度下降法与其他优化 算法(如牛顿法、拟牛顿法等)结合,以提高搜索效率。

在此添加您的文本16字

自适应学习率: 研究如何设计自适应学习率策略,以更 好地处理不同阶段的优化问题。

在此添加您的文本16字

挑战:

在此添加您的文本16字

高维优化: 在高维参数空间中,梯度下降法可能会遇到 维度诅咒问题,需要研究有效的降维或正则化策略。

利用前一次的梯度方向来指导当前步的搜索方向 ,加速收敛并减少震荡。

公式表达

v = μ * v - lr * gradient

参数解释

v是动量,μ是动量系数,lr是学习率,gradient是 当前点的梯度。

Adagrad、RMSprop和Adam优化算法

Adagrad

针对不同参数自适应调整学习率,对稀疏数据有较好 的效果。

5月班第3课课件:梯度下降法与反向传播 (1)

损失函数可视化

第二个栗子

我们给两个方向W1和W2,那么我们可以确定一 个平面,我们再取不同值的a和b,计算 L(W+aW1+bW2)的值。

损失函数可视化

假定训练集里面有3个样本,都是1维的,同 时总共有3个类别。其SVM损失:

损失函数可视化

损失函数往往定义在非常高维的空间

比如CIFAR-10的例子里一个线性分类器的权重 矩阵W是10 x 3073维的,总共有30730个参数

曲线救国

我们可以把高维投射到一个向量/方向(1维)或者 一个面(2维)上,从而能直观地『观察』到一些 变化

损失函数可视化

举个栗子

我们找到一个方 向W1(维度要和W 一样),

Sigmoid例子

Sigmoid神经网络的例子

Sigmoid神经网络的例子

Sigmoid神经网络的例子

Sigmoid神经网络的例子

74行代码实现手写数字识别

关于效率问题:

这个计算方法的复杂度,基本是和我们的参数 个数成线性关系的。

在CIFAR-10例子中,我们总共有30730个参数 这个问题在神经网络中更为严重,很可能两层

神经元之间就有百万级别的参数权重。 人也要等结果等到哭瞎…

计算梯度

解析法计算梯度:

速度非常快 但是容出错

反倒之前的数值法就显出优势。

梯度下降法与反向传播

主要内容

梯度下降法

1.损失函数可视化 2.最优化 3.梯度下降

反向传播

1.梯度与偏导 2.链式法则 3.直观理解 4.Sigmoid例子

预备知识

两个重要函数

得分函数 损失函数

核心目标

梯度下降法详解

梯度下降法详解在学习、⽣活、科研以及⼯程应⽤中,⼈们经常要求解⼀个问题的最优解,通常做法是对该问题进⾏数学建模,转换成⼀个⽬标函数,然后通过⼀定的算法寻求该函数的最⼩值,最终寻求到最⼩值时的输⼊参数就是问题的最优解。

⼀个简单的例⼦,就是求解y=x2的最优解,也就是求当y取得最⼩值时x的取值。

这个问题初中⽣都会解,谁都知道,直接对函数求导得到导数y=2x,令y=2x=0解得x=0,这就是最优解。

然⽽,很多实际问题的⽬标函数是很复杂的,很难求出其导数表达式,这种情况下如果还想通过求导数表达式并令其等于0来求最优解就很困难了。

不过虽然导数表达式求解困难,但某⼀确定点的近似导数值还是⽐较容易求出来的,所以⼈们通常利⽤某⼀确定点的近似导数值来逼近最优解。

梯度下降法就是这样的⼀种算法,在⼀步⼀步逼近的过程中,⽬标函数值呈下降趋势,输⼊参数的值也⼀步⼀步逼近最优解,其整个迭代逼近过程如下图所⽰:下⾯将从数学的⾓度解释其原理。

假设函数f具有n个输⼊参数:x1,x2,…,x n,第k次逼近的⽬标函数值可以表达如下:对第k+1次逼近的⽬标函数进⾏泰勒展开,并忽略余项,得到下式:其中▽f为梯度向量,也即在该点处所有输⼊参数的偏导数组成的向量,△x为从第k次到第k+1次逼近时输⼊参数的变化向量。

我们知道,多维函数的偏导数的定义为:所以可以取⼀个很⼩的△x i值(⽐如0.0001)来近似计算x i的偏导数:向量的点乘可以转换为向量模与向量夹⾓的相乘:于是有:由上式可知,当向量夹⾓cosθ=-1时向量的点乘结果最⼩,也即函数值下降最多,此时向量夹⾓为180度,说明梯度向量与输⼊参数的变化向量⽅向相反。

所以要使下⼀次逼近时⽬标函数值尽可能地相对于当前次降低,也就是使⽬标函数值下降最快,就应该沿着梯度(偏导数)的负⽅向寻找下⼀个逼近点。

即:上式中,α为沿梯度负⽅向前进的步长,α取值过⼩会使逼近最优解的速度很慢,从⽽迭代次数增加,反之如果取值过⼤,则容易跳过最优解。

几种常见的优化方法ppt课件

required for integration is usually trivial in comparison to

the time required for the force calculations.

Example of integrator for MD simulation

• One of the most popular and widely used integrators is

the Verlet leapfrog method: positions and velocities of

7

Continuous time molecular dynamics

1. By calculating the derivative of a macromolecular force

field, we can find the forces on each atom

as a function of its position.

11

Choosing the correct time step…

1. The choice of time step is crucial: too short and

phase space is sampled inefficiently, too long and the

energy will fluctuate wildly and the simulation may

– Rigid body dynamics

– Multiple time step algorithms

梯度下降法——精选推荐

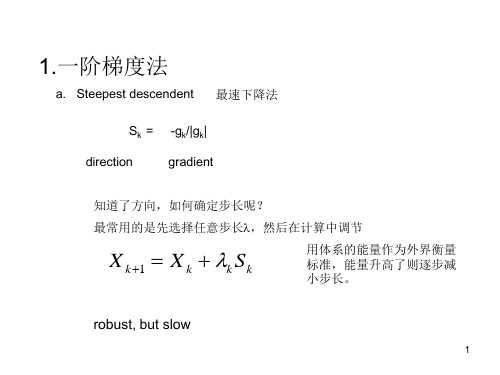

梯度下降法

梯度下降法(gradient descent)或最速下降法(steepest descent)是求解⽆约束最优化问题的⼀种最常⽤的⽅法。

梯度下降法是迭代算法,每⼀步需要求解⽬标函数的梯度向量。

假设f(x)是R n上具有⼀阶连续偏导数的函数,要求解的⽆约束最优化问题是

x*表⽰⽬标函数f(x)的极⼩点。

提梯度下降法是⼀种迭代算法。

选取适当的初值x(0),不断迭代,更新x值,进⾏⽬标函数的极⼩化,直到收敛。

由于负梯度⽅向是使函数值下降最快的⽅向,在迭代的每⼀步,以负梯度⽅向更新x的值,从⽽达到减少函数值的⽬的。

由于f(x)具有⼀阶连续偏导数,若第k次迭代值为x(k),则可将f(x)在x(k)附近进⾏⼀阶展泰勒开:

这⾥,为f(x)在x(k)的梯度。

求出第k+1次迭代值x(k+1):

其中,p k是搜索⽅向,取负梯度⽅向,λk是步长,由⼀维搜索确定,即λk使得:

梯度下降算法如下:

输⼊:⽬标函数f(x),梯度函数,计算精度ε;

输出:f(x)的极⼩点x*

(1)取初值x(0)∈R n ,置k=0

(2)计算f(x(k))

(3)计算梯度g k=g(x(k)),当||g k||<ε时,停⽌迭代,令x*=x k;否则,令p k=-g(x(k)),求λk,使

(4)置x(k+1)=x(k)+λk p k,计算f(x(k+1))

当||f(x(k+1))-f(x(k))||<ε或||x(k+1)-x(k)||<ε时,停⽌迭代,令x*=x(k+1)

(5)否则,置k=k+1,转(3)。

梯度下降公式

梯度下降公式梯度下降法公式,是在求解线性代数方程组时常用的一种简单有效的方法。

它的原理就像电路中电流随着电压而改变的规律一样。

这里,我们假设初始条件不变,方程组的所有系数矩阵都不相同。

我们把通过原点 O 的每一个矢量的梯度记作+ cosθ或-sinθ,并称之为加速度的正梯度(也可以写成δ);相反地,我们则把通过每个不同的标准方向的正梯度记作- cosθ或- sinθ,并称之为减速度的负梯度(也可以写成δ)。

梯度下降公式有许多推广,例如广义梯度下降、广义梯度下降等。

在此只介绍前两者。

梯度下降法适合于研究一些未知量随某个已知量变化的情况。

当题目比较复杂时,需要考虑使用其他方法来处理问题。

梯度下降法的基本思想是:对某一微小扰动,给予足够大的正(或负)梯度,将会使被研究的变量的值增大,从而达到预期的结果。

因此,当某一研究对象受到外界影响时,往往采取增大正梯度的办法,以便收到良好的效果。

如果将该微小扰动的作用看做是无穷小的,那么正梯度就是它的加速度。

而且,梯度越大,则该物体运动得越快。

为了更形象地说明梯度方向与加速度的关系,我们举个例子来说明。

有一块金属片,其上刻画着几条曲线。

你拿一支铅笔放在金属片的边缘上移动,发现金属片会沿着铅笔走过的痕迹向左偏转,这表示铅笔的作用力大小为 A,方向是从左到右。

然后你又拿起另一支铅笔在金属片上移动,发现金属片仍然按照刚才的轨迹偏转,但是移动方向却和第一次相反,这表示铅笔的作用力大小为 B,方向是从右到左。

最后你再拿起第三支铅笔在金属片上移动,发现金属片还是按照刚才的轨迹偏转,但是移动方向却和第二次相反,这表示铅笔的作用力大小为 C,方向是从左到右。

这时候你很容易发现:这四支铅笔对金属片产生的作用力大小均为 A,但是由于方向的不同,造成了它们的加速度不同,因此它们对金属片产生的作用力大小也不同。

即 A+ A= A,而 A+ B= A, A+ C= A, A+ D= A。

根据梯度的定义, A 的方向应该向左, B 的方向应该向右, A+ B+ C+ D= A。

各种梯度下降法及其特点

各种梯度下降法及其特点原文链接文章目录•全量梯度下降/批梯度下降(BGD, Batch Gradient Descent)•o特点•随机梯度下降(SGD, Stochastic Gradient Descent)•o特点•小批量梯度下降(Mini-Batch Gradient Descent)•o特点•Momentum梯度下降法(动量梯度下降)•o特点•Adagrad梯度下降法•o特点o Adadeltao特点•Adam•o特点全量梯度下降/批梯度下降(BGD, Batch Gradient Descent) 就是正常的梯度下降ω = ω −λ∂ J ∂ω \omega = \omega-\lambda\frac{\partial J}{\partial\omega} ω=ω−λ∂ω∂J特点•每次更新都会朝着正确的方向进行, 最后收敛于极值点, 凸函数收敛于全局极值点, 非凸函数可能会收敛于局部极值点•缺点: 学习时间长, 消耗内存大随机梯度下降(SGD, Stochastic Gradient Descent) SGD每一轮只用一条随机选取的数据特点优点•每一次的学习时间很快•如果目标函数有盆地区域, SGD会使优化的方向从当前局部极小值点跳到另一个更好的局部最小值点•最终收敛于一个较好的极值店甚至是全局极值点缺点•每次更新可能并不会按照正确的方向进行, 参数具有高方差, 从而导致损害函数剧烈波动小批量梯度下降(Mini-Batch Gradient Descent)小批量梯度下降指的是从所有数据中选择一部分进行迭代特点优点•收敛速度比SGD更快, 更稳定•在最优解附近跳动不会太大, 容易得到更好的解Momentum梯度下降法(动量梯度下降)v = λ ∂ J ∂ω + v ∗ m o m e m t u m ω = ω− v m o m e m t u m 介于 0 和 1 之间 v = \lambda\frac{\partial J}{\partial\omega} +v * momemtum\\ \omega = \omega-v\\ momemtum介于0和1之间v=λ∂ω∂J+v∗momemtumω=ω−vmomemtum介于0和1之间特点•减少震荡, 大方向不变, 从而保证了效率和正确的收敛Adagrad梯度下降法d w = ∂ J ∂ω g r a d _ s q u a re d + = d w 2 ω = ω−λ ∗ dw g r a d _ s q u a r e d dw = \frac{\partial J}{\partial\omega}\\ grad\_squared += dw^2\\ \omega = \omega - \lambda * \frac{dw}{\sqrt{grad\_squared}} dw=∂ω∂Jgrad_squared+=dw2ω=ω−λ∗grad_squared dw特点•把每一维度的梯度的平方和记录下来,每次学习率都除以这个和•每一维度的学习率不一样,而且都在不断减小•在梯度大的维度,减小下降速度.在梯度小的维度, 加快下降速度•让学习率适应参数•无需手动调整学习率•缺点: 在训练过程中, 累加的和会持续增长, 这回导致学习率变小以至于最终变得无限小, 那么Adagrad将无法取得额外的信息Adadeltad w = ∂ J ∂ω g r a d _ s q u a re d = α∗ g r a d _ s q u a r e d + ( 1 −α ) ∗ d w 2 ω = ω−λ∗ d w g r a d _ s q u a r e d dw = \frac{\partial J}{\partial\omega}\\ grad\_squared = \alpha * grad\_squared + (1 - \alpha) * dw^2\\ \omega = \omega - \lambda * \frac{dw}{\sqrt{grad\_squared}} dw=∂ω∂Jgrad_squared=α∗grad_squared+(1−α)∗dw2ω=ω−λ∗grad_squared dw特点•在Adagrad的基础上进行扩展, 以处理Adagrad学习率单调递减的问题Adam特点d w = ∂ J ∂ω m o me n t 1 = β 1 ∗ m o m e n t 1 + ( 1 −β1 ) ∗ d w m o m e n t2 = β 2 ∗ m o m e n t 2 + ( 1 −β 2 ) ∗ d w2 b i a s 1 = m o m e n t 1 ÷ ( 1 −β 1 t ) b i a s 2 = m o m e n t 2 ÷ ( 1 −β 2 t ) w −= λ ∗ b i a s 1 ÷ b i s a 2 b i a s 为偏差 dw = \frac{\partial J}{\partial \omega}\\ moment_1 = \beta_1 *moment_1 + (1-\beta_1) * dw\\ moment_2 = \beta_2 * moment_2 + (1-\beta_2) * dw^2\\ bias_1 = moment_1 \div (1-\beta_1^t)\\ bias_2=moment_2 \div (1-\beta_2^t)\\ w -= \lambda * bias_1\div\sqrt{bisa_2}\\ bias为偏差dw=∂ω∂Jmoment1=β1∗moment1+(1−β1)∗dwmoment2=β2∗moment2+(1−β2)∗dw2bias1=mome nt1÷(1−β1t)bias2=moment2÷(1−β2t)w−=λ∗bias1÷bisa2bias为偏差•结合了Momentum和RMSprop的特点•自适应学习率b e t a 1 = 0.9 , b e t a 2 = 0.999 , λ =1 e − 3 或 5 e − 4 beta_1=0.9,beta_2=0.999, \lambda=1e-3或5e-4beta1=0.9,beta2=0.999,λ=1e−3或5e−4是许多模型的一个很好的起点本人博客:。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

50

初始状态2

51

初始状态2

52

搜索寻优--梯度下降

53

搜索寻优--梯度下降

54

搜索寻优--梯度下降

55

搜索寻优--梯度下降

56

搜索寻优--梯度下降

57

目标函数局部极小点2

58

目标函数局部极小点2

59

目标函数局部极小点2

60

目标函数局部极小点2

61

目标函数局部极小点2

Байду номын сангаас

62

结束

12

目标函数曲面J(W) --连续、可微

13

全局极小点

14

全局极小点

15

局部极小点1

16

局部极小点1

17

局部极小点2

18

局部极小点2

19

目标函数曲面J(W)

20

目标函数曲面J(W) --连续

21

目标函数曲面J(W) --连续、可微

22

由初始状态1起

23

由初始状态1起 搜索

24

63

结束

64

37

搜索寻优--梯度下降

38

搜索寻优--梯度下降

39

搜索寻优--梯度下降

40

搜索寻优--梯度下降

41

搜索寻优--梯度下降

42

目标函数全局极小点

43

目标函数全局极小点

44

目标函数全局极小点

45

目标函数全局极小点

46

目标函数曲面

47

由初始状态2起

48

由初始状态2起 寻优

49

初始状态2

梯度下降法

1

梯度下降法

搜索寻优原理

2

搜索寻优

3

搜索寻优 由初始状态

4

搜索寻优 由初始状态 到

5

搜索寻优 由初始状态 到 目标函数极小点

6

梯度下降法

7

梯度下降法 搜索寻优特点

8

梯度下降法 搜索寻优特点 一点寻优

9

目标函数曲面J(W)

10

目标函数曲面J(W)

11

目标函数曲面J(W)--连续

由初始状态1起 搜索 寻优

25

初始状态1

26

初始状态1

27

搜索寻优--梯度下降

28

搜索寻优--梯度下降

29

搜索寻优--梯度下降

30

搜索寻优--梯度下降

31

搜索寻优--梯度下降

32

搜索寻优--梯度下降

33

搜索寻优--梯度下降

34

搜索寻优--梯度下降

35

搜索寻优--梯度下降

36

搜索寻优--梯度下降