用软件nicexpress实现双网卡负载平衡

配置双网卡的机器本身的网速会不会也慢了_百度知道

qq头像怎么换不了s软件的安装包NIC4.rar解压缩得到安装文件“NICExpressW2KEE.exe”,双击它启动安装程序,一路NEXT,软件提示输入unlock key(注册码),如果没有注册码,就只好点击Demo,选择试用,这样可以获得30天的免费试用期,在这30天里如果觉得不错,你可以想办法去弄一个注册码(怎么弄?找小编问,他可能有,哈哈)。

图片点击可在新窗口打开查看

:》眼看累了吧,去。,去,快一点叫一个MM来,一起看,:》

第三部分:“虚拟网卡”设定

最后还要看看网卡的设置,用鼠标在桌面“网上邻居”上点击右键弹出“网络和拨号连接”窗口,可以看到原来的两个网卡连接图标已经变成了三个,多出来的一个图标就是“NIC Express Virtual Adapter”,这个就是绑定后的网卡组,这个网卡组的使用和使用单一网卡完全一样,相当于一个单一的“虚拟网卡”。

到了下图所示界面,就到了真正绑定网卡的时候了:

图片点击可在新窗口打开查看

大家看到这个界面一共分为上、中、下,三个窗口,上面的是空白,中间的写着8139-2,这个8139-2是我自己起的绑定之后的网卡组的名称,原来这里默认写的是New array,也可以不修改,你也可以根据自己喜好,写成别的名字。在最下面的窗口里列出了目前服务器上安装的两块网卡的名字。我们下一步就是要用鼠标选中下面的两块网卡名字,然后点击界面中间的Add键,把两块网卡加入上面的窗口里,这样两块网卡就这样被加入了网卡组里,初步绑定成一块“网卡”了,今后可以使用同一个IP地址了。

图片点击可在新窗口打开查看

用鼠标在这个图标上点击右键选择属性,可以为这个“虚拟网卡”设定IP地址、子网掩码、网关等等,其实在安装“NIC Express”过程中,如果服务器原来的单一网卡已经设置了这些,那么“虚拟网卡”就会自动设定和原来的网卡一样。在这里选择“NIC Express Transport for Ethernet”还可以自由对网卡绑定组进行调整,例如,减少或者加入一块网卡,这个较之Intel PROSET要方便许多,Intel PROSET在增加或者减少绑定组里的网卡之前必须删除原来的绑定组然后重新创建。

多网卡绑定构建负载均衡服务器

1 引 言

随 着 信 息 技 术 的 快 速 发 展 , 来 越 多 的 电脑 用 户 不 再 满 足 于 越

当 前 的 网络 速 度 。特 别 是 一 些 涉 及 局 域 网应 用 的 用 户 , 中 小 型 如

打 开 服务 器 机 箱 , 两 块 网 卡安 装 在 主板 P 插 槽 上 。如 果 把 CI

维普资讯

网 络 技 术

责 编 姚 翌 任 辑:

多 网卡绑定构 建 负载 均衡 服务器

张 延 红 王 康 平 程 国斌

( 1平顶 山工 学院 河 南平顶 山 4 7 0 ) 6 0 1

( 平顶 山学 院 河 南平顶 山 4 70 ) 2 60 1

E me 和 AS Te / o d o 4 0 0 1 0 Itga d Co tolr  ̄e t US k Br ̄ c m 4 x 1/ 0 ne re nr l 。 t e

性” 的“ 备管理器 ”如果两块 网卡有硬件 冲突 , 会在 “ 中 设 , 就 网络 适配器” 的位 置 出现 一 个 醒 目的惊 叹号 。 击 带 有 惊 叹 号 的 网 卡 , 双 切 换 到 “ 源 ” 项 卡 , 里 可 以看 到 究 竟 是 哪 些 参 数 产 生 的硬 件 资 选 这 冲突, 以及 是 跟 哪 些 设 备 发 生 的冲 突 。 在 , 要 做 的 是 将 “ 现 您 先 使 用 自动 设 置 ” 选 框 里 的小 勾 消 去 , 后 再 双 击 有 红 色 标 志 的 参 复 然 数 , 对 它 的 数 值 进 行 强 制 指 定 , 到 “ 突 设 备 列 表 ” 口中 出 并 直 冲 窗 现“ 有 冲突” 提示为止 。 没 的

【 摘 要 】文 章 论 述 了利 用 NI x rs E trre网卡 绑 定 功 能进 行 双 网卡 绑 定 构 建 负栽 均衡 服 务 器 的 具 体 方 法 和 步 C E pes ne i ps

双网卡绑定实现负载,冗余及内外网设置

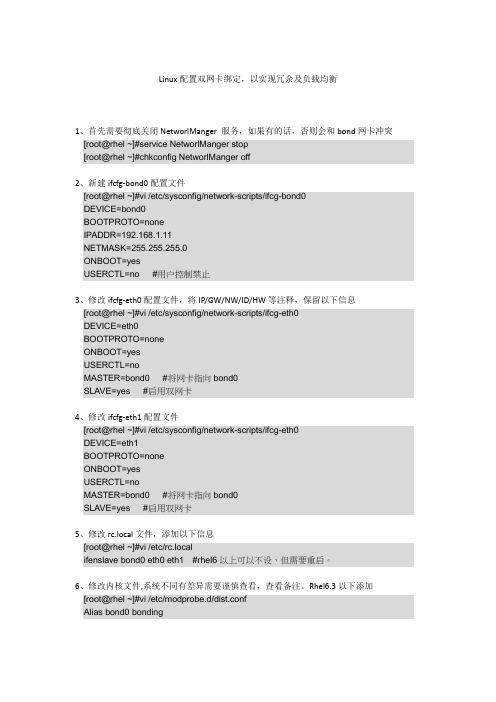

Linux配置双网卡绑定,以实现冗余及负载均衡1、首先需要彻底关闭NetworlManger 服务,如果有的话,否则会和bond网卡冲突[root@rhel ~]#service NetworlManger stop[root@rhel ~]#chkconfig NetworlManger off2、新建ifcfg-bond0配置文件[root@rhel ~]#vi /etc/sysconfig/network-scripts/ifcg-bond0DEVICE=bond0BOOTPROTO=noneIPADDR=192.168.1.11NETMASK=255.255.255.0ONBOOT=yesUSERCTL=no #用户控制禁止3、修改ifcfg-eth0配置文件,将IP/GW/NW/ID/HW等注释,保留以下信息[root@rhel ~]#vi /etc/sysconfig/network-scripts/ifcg-eth0DEVICE=eth0BOOTPROTO=noneONBOOT=yesUSERCTL=noMASTER=bond0 #将网卡指向bond0SLAVE=yes #启用双网卡4、修改ifcfg-eth1配置文件[root@rhel ~]#vi /etc/sysconfig/network-scripts/ifcg-eth0DEVICE=eth1BOOTPROTO=noneONBOOT=yesUSERCTL=noMASTER=bond0 #将网卡指向bond0SLAVE=yes #启用双网卡5、修改rc.local文件,添加以下信息[root@rhel ~]#vi /etc/rc.localifenslave bond0 eth0 eth1 #rhel6以上可以不设,但需要重启。

6、修改内核文件,系统不同有差异需要谨慎查看,查看备注。

Rhel6.3以下添加[root@rhel ~]#vi /etc/modprobe.d/dist.confAlias bond0 bondingOptions bond0 mode=1 miimon=50 #可在ifcfg-bond0中添加用BONDING_OPT=””连接。

双网卡网卡冗余服务器

双网卡网卡冗余服务器文档信息内容范围本文档的目的是帮助高维信诚技术人员做双网卡的冗余和网卡的负载均衡设计思路,主要针对上海企业建站的介入,本文档作为实施的依据。

适用的对象本文档仅适用高维信诚所有技术人员及相关应用人员。

所谓双网卡,就是通过软件将双网卡绑定为一个IP地址,多网卡绑定的优点不少,首先,可以增大带宽,假如一个网卡的带宽是100M,理论上两块网卡就是200M,三块就是300M,当然实际上的效果是不会是这样简单的增加的,不过经实际测试使用多个网卡对于增加带宽,保持带宽的稳定性肯定是有裨益的,如果交换机等相关条件不错的话,这个效果还是很能令人满意;其次,可以形成网卡冗余阵列、分担负载,双网卡被绑定成“一块网卡”之后,同步一起工作,对服务器的访问流量被均衡分担到两块网卡上,这样每块网卡的负载压力就小多了,抗并发访问的能力提高,保证了服务器访问的稳定和畅快,当其中一块发生故障的时候,另一块立刻接管全部负载,过程是无缝的,服务不会中断。

但是千万注意,最好用于绑定的网卡是完全相同的,至少也是基于同一芯片的,这样多块网卡才能合作得比较好。

但是不要把10M网卡和100M网卡绑定在一起,那样根本起不到提升作用。

这里我们采用NICExpressW2KEE4.0来做网卡的绑定,软件的兼容性已经做得很好,支持win98/Me/2000/XP/2003。

首先来看一下安装:1.点击NICExpressW2KEE,一路NEXT,软件提示输入unlock key(注册码),到下图所示界面,软件提示选择是否开启LOAD Balancing 功能?LOAD Balancing的意思可以翻译为负载均衡,在这里就是网络负载均衡。

也就是当多块网卡被绑定合一之后,当数据流量很大的时候,软件会自动调整,将数据流量负载均衡地分配到各个网卡上,以减轻单块网卡的压力,达到畅快的访问效果。

我们绑定双网卡,其中目的之一就是为了实现负载均衡,我们自然要开启这个功能,所以,在这里一定要选择“Enabled”。

在linu下双网卡负载均衡(lacp)

(一)linux 配置#cat/boot/config-kernel-version |grep -ibondingCONFIG_BONDING=m返回CONFIG_BONDING表示支持,否则需要编译内核使它支持bonding 也可以用:查看一下内核是否已经支持bonding :modinfo bonding第一步:创建一个ifcfg-bondX# touch/etc/sysconfig/network-scripts/ifcfg-bond0 新建一个bond0配置文件# cat/etc/sysconfig/network-scripts/ifcfg-bond0DEVICE=bond0BOOTPROTO=staticIPADDR=1.1.1.2NETMASK=255.255.255.0BROADCAST=1.1.1.255NETWORK=1.1.1.0GATEWAY=1.1.1.1ONBOOT=yesTYPE=Ethernet 编辑ifcfg-bond0 如上第二步:修改/etc/sysconfig/network-scripts/ifcfg-ethX 这个实验中把网卡 1 和 2 绑定,修改/etc/sysconfig/network-scripts/ifcfg-ethX 相应网卡配置如下:# cat/etc/sysconfig/network-scripts/ifcfg-eth1TYPE=EthernetDEVICE=eth1HWADDR=00:d0:f8:40:f1:a0 网卡1macBOOTPROTO=noneONBOOT=yesUSERCTL=no MASTER=bond0SLAVE=yes# cat /etc/sysconfig/network-scripts/ifcfg-eth2 TYPE=Ethernet DEVICE=eth2 HWADDR=00:d0:f8:00:0c:0c 网卡2mac BOOTPROTO=none ONBOOT=yesUSERCTL=no MASTER=bond0SLAVE=yes-r lacp 只要再加上下面两条配置 绑定 mode=4 是 lacp第三步: 配置/etc/modprobe.conf ,添加 alias bondO bonding# cat /etc/modprobe.conf alias ethO e1OO alias snd-card-O snd-intel8xOoptions snd-card-O index=O options snd-intel8xO index=O remove snd-intel8xO { /usr/sbin/alsactl store O >/dev/null 2>&1 || : ; }; /sbin/modprobe --ignore-remove snd-intel8xOalias eth1 8139too options 3c5O1 irq=3 alias eth2 tulip 上面是三网卡本身的配置如果要绑定和做 alias bondO bondingoptions bondO miimon=1OO mode=4第四步:配置 /etc/rc.d/rc.local ,添加需要绑定的网卡# cat /etc/rc.d/rc.localtouch /var/lock/subsys/local 配置本身就有这条命令ifenslave bondO eth1 eth2 这条命令是添加需要绑定的网卡 1 和 2到这里就完成 bonding 的配置了可以查看一下 第五步:重启网络服务和重启 pc#service network restart重启网络服务# shutdown -r now重启 pc重启后可以查看 bonding 情况:网卡 1 和 2 都绑定上了,模式为 8O2.3ad# cat /proc/net/bonding/bondOEthernet Channel Bonding Driver: v3.O.3 (March 23, 2OO6) Bonding Mode: IEEE 8O2.3ad Dynamic link aggregation Transmit Hash Policy: layer2 (O) MII Status: upMII Polling Interval (ms): 1OO Up Delay (ms): O Down Delay (ms): O8O2.3ad info LACP rate: slowActive Aggregator Info:Aggregator ID: 1 Number of ports: 2 Actor Key: 9 Partner Key: 1Partner Mac Address: 00:d0:f8:22:33:ba Slave Interface: eth1 MII Status: up Link Failure Count: 0Permanent HW addr: 00:d0:f8:40:f1:a0 Aggregator ID: 1 Slave Interface: eth2 MII Status: upLink Failure Count: 0Permanent HW addr: 00:d0:f8:00:0c:0cAggregator ID: 1接口配置信息:新增了bond0的配置信息,接口bondO和ethl , eth2,绑定后三个接口使用的mac 都是同一个:00:D0:F8:40:F1:A0# ifconfigbondO Link encap:Ethernet HWaddr OO:DO:F8:4O:F1:AOinet addr:1.1.1.2 Bcast:1.1.1.255 Mask:255.255.255.Oinet6 addr: fe8O::2dO:f8ff:fe4O:f1aO/64 Scope:LinkUP BROADCAST RUNNING MASTER MULTICASTMTU:15OO Metric:1RX packets:128 errors:O dropped:O overruns:O frame:OTX packets:259 errors:O dropped:O overruns:O carrier:Ocollisions:O txqueuelen:ORX bytes:15466 (15.1 KiB) TX bytes:39679 (38.7 KiB)ethO Link encap:Ethernet HWaddr OO:11:11:EB:71:E2inet addr:192.168.18O.8 Bcast:192.168.18O.15 Mask:255.255.255.24Oinet6 addr: fe8O::211:11ff:feeb:71e2/64 Scope:LinkUP BROADCAST RUNNING MULTICASTMTU:15OO Metric:1RX packets:311 errors:O dropped:O overruns:O frame:OTX packets:228 errors:O dropped:O overruns:O carrier:Ocollisions:O txqueuelen:1OOORX bytes:3O565 (29.8 KiB) TX bytes:35958 (35.1 KiB)eth1 Link encap:Ethernet HWaddr OO:DO:F8:4O:F1:AOinet6 addr: fe8O::2dO:f8ff:fe4O:f1aO/64 Scope:LinkUP BROADCAST RUNNING SLAVE MULTICASMTTU: 1 5OO Metric:1RX packets:54 errors:O dropped:O overruns:O frame:OTX packets:97 errors:O dropped:O overruns:O carrier:Ocollisions:O txqueuelen:1OOORX bytes:6696 (6.5 KiB) TX bytes:13821 (13.4 KiB)Interrupt:2O9 Base address:Ox2eOOeth2 Link encap:Ethernet HWaddr OO:DO:F8:4O:F1:AO inet6 addr: fe8O::2dO:f8ff:fe4O:f1aO/64 Scope:LinkUP BROADCAST RUNNING SLAVE MULTICASMTTU: 1 5OO Metric:1RX packets:74 errors:O dropped:O overruns:O frame:OTX packets:162 errors:O dropped:O overruns:O carrier:Ocollisions:O txqueuelen:1OOOlacp system-priority 100 interface GigabitEthernet 0/23 no switchport lacp port-priority 100 port-group 1 mode active interface GigabitEthernet 0/24 no switchport lacp port-priority 100 port-group 1 mode active interface AggregatePort 1 全局配置lacp 优先级接口的lacp 优先级接口下开启lacp 主动模式RX bytes:8770 (8.5 KiB) TX bytes:25858 (25.2 KiB) Interrupt:201 Base address:0x2f00 lo Link encap:Local Loopbackinet addr:127.0.0.1 Mask:255.0.0.0 inet6 addr: ::1/128 Scope:Host UP LOOPBACKRUNNING MTU:16436 Metric:1RX packets:6283 errors:0 dropped:0 overruns:0 frame:0TX packets:6283 errors:0 dropped:0 overruns:0 carrier:0 collisions:0 txqueuelen:0RX bytes:9783674 (9.3 MiB) TX bytes:9783674 (9.3 MiB)二)锐捷交换机配置:no switchportno ip proxy-arpip address 1.1.1.1 255.255.255.0和linux 成功建立lacp 后状态信息如下:Show lacp summarySystem Id:100, 00d0.f822.33baFlags: S - Device is requesting Slow LACPDUs F - Device is requesting Fast LACPDUs.A - Device is in active mode. P - Device is in passive mode.Aggregate port 1:Local information:Port Flags StateLACP portPriorityOperKeyPortNumberPortStateGi0/23 SA bndl 100 0x1 0x17 0x3d Gi0/24 SA bndl 100 0x1 0x18 0x3d Partner information:PortLACP port OperKeyPortNumberPortState Flags Priority Dev IDGi0/23 SA 255 00d0.f840.f1a0 0x9 0x2 0x3d Gi0/24 SA 255 00d0.f840.f1a0 0x9 0x1 0x3d State 表示状态信息:bndl 表示lacp 建立成功,sup 表示不成功。

使用NIC Express打造双网卡负载均衡服务器(最全)word资料

使用NIC Express打造双网卡负载均衡服务器(最全)word资料使用NIC Express打造双网卡负载均衡服务器注册码是 381567 软件应用 2020 -03-14 21:19:53 阅读397 评论0 字号:大中小首先当然是下载NIC Express咯..双击它启动安装程序,一路NEXT,软件提示输入unlock key(注册码),如果没有注册码,就只好点击Demo,选择试用,这样可以获得30天的免费试用期,在这30天里如果觉得不错,你可以想办法去弄一个注册码。

到下图所示界面,软件提示选择是否开启LOAD Balancing 功能?什么是LOAD Balancing 功能呢?LOAD Balancing的中文意思可以翻译为负载均衡,在这里就是网络负载均衡。

也就是当多块网卡被绑定合一之后,当数据流量很大的时候,软件会自动调整,将数据流量负载均衡地分配到各个网卡上,以减轻单块网卡的压力,达到畅快的访问效果。

我们绑定双网卡,其中目的之一就是为了实现负载均衡,我们自然要开启这个功能,所以,在这里一定要选择“Enabled”。

当然,如果你在这里选择错了也没关系,今后也可以通过NIC Express软件管理界面开启。

继续一路NEXT,在Windows XP里安装时如果遇到提示“NIC Express Virtual Miniport”没有通过Windows测试,无法验证它同Windows XP的相容性,不要理会,选择“仍然继续”就行了。

到了下图所示界面,就到了真正绑定网卡的时候了:大家看到这个界面一共分为上、中、下,三个窗口,上面的是空白,中间的写着8139-2,这个8139-2是我自己起的绑定之后的网卡组的名称,原来这里默认写的是New array,也可以不修改,你也可以根据自己喜好,写成别的名字。

在最下面的窗口里列出了目前服务器上安装的两块网卡的名字。

我们下一步就是要用鼠标选中下面的两块网卡名字,然后点击界面中间的Add键,把两块网卡加入上面的窗口里,这样两块网卡就这样被加入了网卡组里,初步绑定成一块“网卡”了,今后可以使用同一个IP地址了。

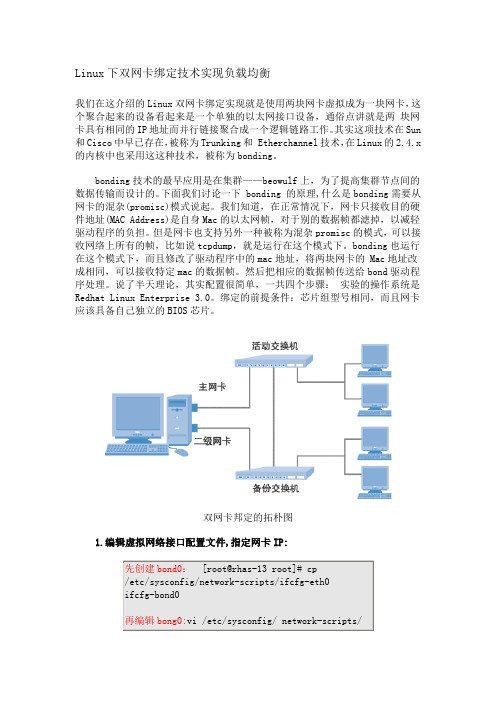

Linux下双网卡绑定技术实现负载均衡

Linux下双网卡绑定技术实现负载均衡我们在这介绍的Linux双网卡绑定实现就是使用两块网卡虚拟成为一块网卡,这个聚合起来的设备看起来是一个单独的以太网接口设备,通俗点讲就是两块网卡具有相同的IP地址而并行链接聚合成一个逻辑链路工作。

其实这项技术在Sun 和Cisco中早已存在,被称为Trunking和 Etherchannel技术,在Linux的2.4.x 的内核中也采用这这种技术,被称为bonding。

bonding技术的最早应用是在集群——beowulf上,为了提高集群节点间的数据传输而设计的。

下面我们讨论一下 bonding 的原理,什么是bonding需要从网卡的混杂(promisc)模式说起。

我们知道,在正常情况下,网卡只接收目的硬件地址(MAC Address)是自身Mac的以太网帧,对于别的数据帧都滤掉,以减轻驱动程序的负担。

但是网卡也支持另外一种被称为混杂promisc的模式,可以接收网络上所有的帧,比如说tcpdump,就是运行在这个模式下。

bonding也运行在这个模式下,而且修改了驱动程序中的mac地址,将两块网卡的 Mac地址改成相同,可以接收特定mac的数据帧。

然后把相应的数据帧传送给bond驱动程序处理。

说了半天理论,其实配置很简单,一共四个步骤:实验的操作系统是Redhat Linux Enterprise 3.0。

绑定的前提条件:芯片组型号相同,而且网卡应该具备自己独立的BIOS芯片。

双网卡邦定的拓朴图1.编辑虚拟网络接口配置文件,指定网卡IP:2、#vi ifcfg-bond0将第一行改成 DEVICE=bond0:这里要主意,不要指定单个网卡的IP 地址、子网掩码或网卡 ID。

将上述信息指定到虚拟适配器(bonding)中即可。

3、编辑 /etc/modprobe.conf 文件,加入如下一行内容,以使系统在启动时加载bonding模块,对外虚拟网络接口设备为 bond0.加入下列两行:说明:miimon是用来进行链路监测的。

nic负载平衡模式

nic负载平衡模式1.引言1.1 概述概述部分的内容可以从以下角度展开:概述部分主要介绍文章要讨论的主题,即NIC负载平衡模式。

NIC负载平衡模式是一种网络技术,用于在多个网络接口卡(NIC)之间分配和管理数据流量,以实现网络负载的平衡和优化。

首先,可以简要介绍NIC(Network Interface Card)的定义和作用。

NIC是计算机与网络之间的接口设备,它允许计算机与网络之间进行数据传输。

NIC负载平衡模式就是基于这样的设备,通过合理地分配和管理数据流量,实现网络负载的均衡。

接下来,可以介绍NIC负载平衡模式的工作原理。

在一个拥有多个NIC的系统中,NIC负载平衡模式可以根据预设的算法和策略,将传入的数据流量均匀地分配给各个NIC,从而实现负载均衡。

这种负载均衡的方式可以提高网络的整体性能和可靠性,同时避免了某个NIC因为过高的负载而导致的性能瓶颈或故障。

另外,可以提及NIC负载平衡模式的应用场景。

NIC负载平衡模式被广泛应用于大规模的网络环境和高负载的服务器系统中。

例如,云计算平台、大型数据中心、高性能计算集群等都需要处理大量的数据流量,通过使用NIC负载平衡模式,可以合理地分配和管理这些数据流量,提高整体的网络性能和数据处理能力。

综上所述,本文将围绕NIC负载平衡模式展开讨论,介绍其工作原理、优点和应用场景等方面的内容。

通过深入了解和掌握NIC负载平衡模式的作用和优势,我们可以更好地利用这一网络技术,提升网络的性能和稳定性,满足不同应用场景下的需求。

1.2文章结构1.2 文章结构本文将围绕NIC负载平衡模式展开讨论,从引言、正文和结论三个部分展开。

具体结构如下:引言部分介绍了本文的背景和目的。

在概述中,将简要介绍NIC负载平衡模式的基本概念和作用。

随后,说明了本文的整体结构,以便读者能够清楚地了解各个章节的主要内容和组织结构。

最后,明确了撰写本文的目的,为读者提供关于NIC负载平衡模式的全面理解。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

用软件nicexpress实现双网卡负载平衡为什么要用双网卡呢?用双网卡有什么好处?所谓双网卡,就是通过软件将双网卡绑定为一个IP地址,这个技术对于许多朋友来说并不陌生,许多高档服务器网卡(例如intel8255x系列、3COM服务器网卡等)都具有多网卡绑定功能,可以通过软硬件设置将两块或者多块网卡绑定在同一个IP地址上,使用起来就好象在使用一块网卡。

多网卡绑定的优点不少,首先,可以增大带宽,假如一个网卡的带宽是100M,理论上两块网卡就是200M,三块就是300M,当然实际上的效果是不会是这样简单的增加的,不过经实际测试使用多个网卡对于增加带宽,保持带宽的稳定性肯定是有裨益的,如果交换机等相关条件不错的话,这个效果还是很能令人满意;其次,可以形成网卡冗余阵列、分担负载,双网卡被绑定成“一块网卡”之后,同步一起工作,对服务器的访问流量被均衡分担到两块网卡上,这样每块网卡的负载压力就小多了,抗并发访问的能力提高,保证了服务器访问的稳定和畅快,当其中一块发生故障的时候,另一块立刻接管全部负载,过程是无缝的,服务不会中断,直到维修人员到来。

OK,现在就手把手的教大家如何用50元来打造出双网卡的效果!先下载软件(点击这里下载),这是最新版本4.0,只有2.15M,软件的兼容性已经做得很好,支持win98/Me/2000/XP/2003。

基本上支持目前市场上常见的各种网卡,百兆和千兆网卡都可以用来绑定,但是千万注意,最好用于绑定的网卡是完全相同的,至少也是基于同一芯片的,这样多块网卡才能合作得比较好。

切记不要把10M网卡和100M网卡绑定在一起,那样根本起不到提升作用。

下载完软件,先不忙安装,咱们还是先准备好硬件。

第一部分:硬件安装虽然,理论上讲绑定越多网卡在一起,最终效果提升就越明显,但是考虑到复杂程度,这里就以绑定双网卡为例进行说明,如果读者觉得好玩,兴致很高的话,按照下面方法愿意绑定多少就绑定多少个网卡,其实一般同一台服务器,绑定2-3块网卡也就够了,太多了,据说因为链路聚合的先天缺点,会过多占用服务器资源,反过来会影响服务器速度(关于这个我没实验,不过我觉得凡事都离不开物极必反的道理,适度最好)。

我取出“珍藏”的一对市场上随处可见的8139D10M/100M自适应网卡,市场价格25元一个,北京某厂的产品,做工还算精细,总成本50元人民币。

然后,抱出笔者的一台私有服务器,呵呵,虽然破旧一点,不过可是立功不小啊,上面现在运行着FTP、MAIL等服务,几百个朋友的EMAIL都是通过它来传递的啊。

配置情况为intel810主板(集成显卡)+256MSD内存+10GIDE硬盘(系统盘)+120GIDE硬盘(存放互联网^^)。

系统软件是windows2000高级服务器版。

废话少说,开干,打开服务器机箱,把两块网卡拧在主板PCI插槽上,拧好了,看看还不错。

再从后面看看效果。

拿出珍藏的10M-8口集线器,哈哈,别笑话,我手头只有这个,能说清楚方法就可以了,如果是读者自己DIY,请务必选一台好的交换机,至少要10/100M自适应的,这是网络通畅的关键,别象我把100M网卡连在10M集线器上,那速度怎么也好不了啊。

做几条网线,把集线器、网卡连接起来,集线器连入上级交换机,因为是在家里实验,所以,我就把集线器的Uplink口连入家用路由器的任意一个网口里,路由器则连入我家ADSL“大猫”。

至此,硬件部分安装完毕。

就这么简单。

第二部分:设置调试下面要进行设置及调试了,也就是要将这两块8139D廉价网卡,如同高档服务器网卡那样绑定在一起,使用同一个IP地址,同时同步工作。

其过程并不复杂,估计20分钟足够了。

将刚刚下载的NIC Express软件的安装包NIC4.rar解压缩得到安装文件“NICExpressW2KEE.exe”,双击它启动安装程序,一路NEXT,软件提示输入unlock key(注册码),如果没有注册码,就只好点击Demo,选择试用,这样可以获得30天的免费试用期,在这30天里如果觉得不错,你可以想办法去弄一个注册码(怎么弄?找小编问,他可能有,哈哈)。

到下图所示界面,软件提示选择是否开启LOAD Balancing 功能?什么是LOAD Balancing 功能呢?LOAD Balancing的中文意思可以翻译为负载均衡,在这里就是网络负载均衡。

也就是当多块网卡被绑定合一之后,当数据流量很大的时候,软件会自动调整,将数据流量负载均衡地分配到各个网卡上,以减轻单块网卡的压力,达到畅快的访问效果。

我们绑定双网卡,其中目的之一就是为了实现负载均衡,我们自然要开启这个功能,所以,在这里一定要选择“Enabled”。

当然,如果你在这里选择错了也没关系,今后也可以通过NIC Express软件管理界面开启。

继续一路NEXT,在Windows XP里安装时如果遇到提示“NIC Express Virtual Miniport”没有通过Windows测试,无法验证它同Windows XP的相容性,不要理会,选择“仍然继续”就行了。

到了下图所示界面,就到了真正绑定网卡的时候了:大家看到这个界面一共分为上、中、下,三个窗口,上面的是空白,中间的写着8139-2,这个8139-2是我自己起的绑定之后的网卡组的名称,原来这里默认写的是New array,也可以不修改,你也可以根据自己喜好,写成别的名字。

在最下面的窗口里列出了目前服务器上安装的两块网卡的名字。

我们下一步就是要用鼠标选中下面的两块网卡名字,然后点击界面中间的Add键,把两块网卡加入上面的窗口里,这样两块网卡就这样被加入了网卡组里,初步绑定成一块“网卡”了,今后可以使用同一个IP地址了。

点击OK继续,NIC Express出现一个配置界面,选项很多,但是不必太操心,因为这些配置都不必修改,使用默认值就可以了,直接点击OK、点击Finish完成安装进程。

至此软件安装基本结束,剩下就需要对软件和网卡进行一些必要的设置工作。

点击桌面“开始”菜单,选择执行菜单里的“NIC Express Enterprise Edition”选项,这是NIC Express软件自带的一个监控程序,首先点击“setting”选项,在这里可以设置网卡流量计量单位,可以按照Packets/Sec、Mbits/Sec、Kbits/Sec三种单位来计算,一般都是使用默认的Mbits/Sec来计算,也就是兆/每秒,其实在这里只需要修改一下“Graph Detail(图形显示)”即可,将默认的“By Protocol”改成“By Incoming/Outgoing”,别的不需要改。

如果你想分别观察绑定组中每块网卡的流量或者整个组的流量,只需在“Select Device”选项中选择一下设备即可。

最后点击“Advanced”选项,设定网卡绑定的工作模式,在这里也可以点击“Load Balancing Disable”来关闭网卡负载均衡功能。

使用NIC Express绑定的双网卡组默认工作于“NIC Express ELB”模式下,这是NIC Express所特有的一种工作模式,实际效果很好。

我们都知道利用昂贵的Intel PROSET绑定的Intel 8255x的组合是运行在“802.3ad”工作模式下的,这一模式在NIC Express中也可以选择,但是多数使用者在实际使用后都认为“NIC Express ELB”模式的效果优于“802.3ad”模式,大家今后可以自己实践测试比较一下。

如果你也使用默认的“NIC Express ELB”模式,那么“Advanced”选项里也就不用改什么,一切默认即可。

至此NIC Express的设置结束。

第三部分:“虚拟网卡”设定最后还要看看网卡的设置,用鼠标在桌面“网上邻居”上点击右键弹出“网络和拨号连接”窗口,可以看到原来的两个网卡连接图标已经变成了三个,多出来的一个图标就是“NIC Express Virtual Adapter”,这个就是绑定后的网卡组,这个网卡组的使用和使用单一网卡完全一样,相当于一个单一的“虚拟网卡”。

用鼠标在这个图标上点击右键选择属性,可以为这个“虚拟网卡”设定IP地址、子网掩码、网关等等,其实在安装“NIC Express”过程中,如果服务器原来的单一网卡已经设置了这些,那么“虚拟网卡”就会自动设定和原来的网卡一样。

在这里选择“NIC Express Transport for Ethernet”还可以自由对网卡绑定组进行调整,例如,减少或者加入一块网卡,这个较之Intel PROSET要方便许多,Intel PROSET在增加或者减少绑定组里的网卡之前必须删除原来的绑定组然后重新创建。

好了,至此一切都已经做好,我们的服务器已经成为一台地地道道的“双网卡冗余服务器”了,我们来运行一下,看看表现。

第四部分:测试双网卡绑定后的效果检查一下线路,前面说过两块网卡已经用网线连入10M集线器(这就相当于机房机柜里的百兆交换机),集线器的Uplink口连入了家用路由器的任意一个网口,路由器通过ADSL大猫接入互联网(北京512K包月ADSL),这样服务器就已经和互联网连通了,按下Power键启动服务器,由于服务器里面已经安装了动态域名软件,服务器启动之后,很快与国际域名连接到一起(具体过程请看不久前发表在太平洋网站的《绝对疯狂!1G容量的邮件服务器自己打造》),这时只要访问域名,即可从世界各地访问到我的服务器了,我让上海的一个朋友用FTP软件登陆这台“双网卡冗余服务器”,下载一个50M的压缩文件包。

嚯,只见服务器上的两块8139D网卡的指示灯同时闪烁起来,闪烁的频率完全同步,煞是好看!再看那台古董级10M集线器,两个接上网卡的接口指示灯也是飞快同步闪烁,说明两块网卡在同步工作,同时分担访问的流量。

上海的朋友说感觉速度不错,毕竟只是512K的ADSL,也仅能看看网卡同步闪烁的美丽效果了。

然后,我又在局域网里进行了传输实验,因为有那个10M集线器的瓶颈,所以效果不是很好,但是也能看出一些明显改善。

从局域网另一台使用单个杂牌10M8029网卡的电脑上通过网上邻居访问已经用NIC Express绑定了双8139D网卡的服务器,传输200M文件,通过“NIC Express Enterprise Edition”中的曲线监控图观察到,双网卡绑定组的传输速率从8M/s起步,最高达到8.2M/s,两机之间平均传输速率比较稳定,偶尔有大幅度的波动,是软件正在调整两块网卡的负载均衡,只有零点几秒就恢复正常,基本稳定在7.5-8M/s左右,已经接近那个10M集线器的最大传输极限。

之后,从服务器上删除一块网卡,再进行两机传输实验,发现传输最高速率已经骤然减少到5M/s,而且传输过程中速率上下波动很大,平均传输速率也就3M/s左右,可见前后差异还是很明显的。