Puma与数据高速公路——实时数据流与分析

实时计算,流数据处理系统简介与简单分析

实时计算,流数据处理系统简介与简单分析发表于2014-06-12 14:19| 4350次阅读| 来源CSDN博客| 8条评论| 作者va_key大数据实时计算流计算摘要:实时计算一般都是针对海量数据进行的,一般要求为秒级。

实时计算主要分为两块:数据的实时入库、数据的实时计算。

今天这篇文章详细介绍了实时计算,流数据处理系统简介与简单分析。

编者按:互联网领域的实时计算一般都是针对海量数据进行的,除了像非实时计算的需求(如计算结果准确)以外,实时计算最重要的一个需求是能够实时响应计算结果,一般要求为秒级。

实时计算的今天,业界都没有一个准确的定义,什么叫实时计算?什么不是?今天这篇文章详细介绍了实时计算,流数据处理系统简介与简单分析。

以下为作者原文:一.实时计算的概念实时计算一般都是针对海量数据进行的,一般要求为秒级。

实时计算主要分为两块:数据的实时入库、数据的实时计算。

主要应用的场景:1) 数据源是实时的不间断的,要求用户的响应时间也是实时的(比如对于大型网站的流式数据:网站的访问PV/UV、用户访问了什么内容、搜索了什么内容等,实时的数据计算和分析可以动态实时地刷新用户访问数据,展示网站实时流量的变化情况,分析每天各小时的流量和用户分布情况)2) 数据量大且无法或没必要预算,但要求对用户的响应时间是实时的。

比如说:昨天来自每个省份不同性别的访问量分布,昨天来自每个省份不同性别不同年龄不同职业不同名族的访问量分布。

二.实时计算的相关技术主要分为三个阶段(大多是日志流):数据的产生与收集阶段、传输与分析处理阶段、存储对对外提供服务阶段下面具体针对上面三个阶段详细介绍下1)数据实时采集:需求:功能上保证可以完整的收集到所有日志数据,为实时应用提供实时数据;响应时间上要保证实时性、低延迟在1秒左右;配置简单,部署容易;系统稳定可靠等。

目前的产品:Facebook的Scribe、LinkedIn的Kafka、Cloudera的Flume,淘宝开源的TimeTunnel、Hadoop的Chukwa等,均可以满足每秒数百MB的日志数据采集和传输需求。

体育行业中的运动数据分析技术的使用方法

体育行业中的运动数据分析技术的使用方法随着科技的快速发展,运动数据分析技术在体育行业中扮演着越来越重要的角色。

运动数据分析技术可以帮助体育界的教练、运动员和球队做出更加明智的决策,优化训练计划,提高竞技表现。

本文将介绍体育行业中常用的运动数据分析技术及其使用方法。

一、运动数据采集与存储技术在体育行业中,运动数据的采集和存储是运动数据分析的基础。

常见的运动数据采集设备包括传感器、摄像机、智能手表等。

这些设备可以记录运动员的运动轨迹、速度、心率、加速度等关键指标。

在获取运动数据之后,需要将数据进行存储和整理。

云计算技术可以帮助体育机构建立大规模的数据库,方便数据的存储和管理。

此外,数据采集和存储技术还可以与物联网技术相结合,实现设备之间的无线互联,提高数据的实时性和准确性。

二、运动数据分析方法1. 数据可视化分析运动数据可视化分析方法可以将复杂的数据转化为直观、易懂的图表和图像,方便教练员和运动员理解和分析。

常见的数据可视化工具包括数据可视化软件、统计图表、动态平台等。

例如,通过绘制运动员的移动热图和速度分布图,教练员可以了解比赛或训练中运动员的运动路径和速度变化,从而改进训练计划和战术安排。

2. 数据挖掘与模式识别数据挖掘和模式识别技术可以帮助体育机构从庞大的运动数据中发现隐藏的规律和模式,提取有价值的信息。

例如,可以通过分析大量比赛数据,挖掘出不同球队或运动员的比赛策略、弱点和优势,为教练制定战术和训练计划提供参考。

此外,数据挖掘和模式识别技术还可用于身体素质评估和运动员选拔。

通过对大量运动员的身体数据和成绩进行分析,可以建立起科学合理的身体素质评估模型,辅助教练员进行选拔和训练。

3. 数据驱动的预测模型数据驱动的预测模型是根据历史数据和统计分析建立起来的模型。

该模型可以预测未来比赛或训练中的运动员表现和比赛结果。

例如,基于运动员过去的比赛数据和赛前训练数据,可以通过模型预测出运动员在某个特定环境下的表现和适应能力。

大数据平台的软件有哪些

大数据平台的软件有哪些查询引擎一、Phoenix简介:这是一个Java中间层,可以让开发者在Apache HBase上执行SQL查询。

Phoenix完全使用Java编写,代码位于GitHub上,并且提供了一个客户端可嵌入的JDBC驱动。

Phoenix查询引擎会将SQL查询转换为一个或多个HBase scan,并编排执行以生成标准的JDBC 结果集。

直接使用HBase API、协同处理器与自定义过滤器,对于简单查询来说,其性能量级是毫秒,对于百万级别的行数来说,其性能量级是秒。

Phoenix最值得关注的一些特性有:嵌入式的JDBC驱动,实现了大部分的接口,包括元数据API可以通过多部行键或是键/值单元对列进行建模完善的查询支持,可以使用多个谓词以及优化的扫描键DDL支持:通过CREATE TABLE、DROP TABLE及ALTER TABLE来添加/删除列版本化的模式仓库:当写入数据时,快照查询会使用恰当的模式DML支持:用于逐行插入的UPSERT VALUES、用于相同或不同表之间大量数据传输的UPSERT SELECT、用于删除行的DELETE通过客户端的批处理实现的有限的事务支持单表——还没有连接,同时二级索引也在开发当中紧跟ANSI SQL标准二、Stinger简介:原叫Tez,下一代Hive,Hortonworks主导开发,运行在YARN上的DAG计算框架。

某些测试下,Stinger能提升10倍左右的性能,同时会让Hive支持更多的SQL,其主要优点包括:让用户在Hadoop 获得更多的查询匹配。

其中包括类似OVER的字句分析功能,支持WHERE查询,让Hive的样式系统更符合SQL模型。

优化了Hive请求执行计划,优化后请求时间减少90%。

改动了Hive执行引擎,增加单Hive任务的被秒处理记录数。

在Hive 社区中引入了新的列式文件格式(如ORC文件),提供一种更现代、高效和高性能的方式来储存Hive数据。

AVL台架使用 介绍PO CHN

Puma o pen

2

–系统体系结构

–PUMA 软件应用程序

–PUMA 操作用户界面(POI)–PUMA 资源管理器

–试验程序编辑器(BSQ -SSQ)–参数管理器(PAM)–标准名编辑器(NED)

–Puma Concerto 数据处理软件(PUC)

重要信息

5

6

–数据采集–监视功能

–手动或自动输出设定值–子系统、子设备的控制–公式计算–数据后处理

PUMA 功能简介

8

测量部分

发动机&测功机控制部分

9

-图形显示-字母数字显示

–在同一时间可以激活5个记录仪

–针对通道的采样频率设置

–在线分析

–手动/ 自动操作

–在线更改记录仪设置

–自动(试验程序)–POI 手动

–操作面板

–控制窗口

PUMA Explorer:–易于使用

–易于学习

–用户向导

15

BSQ:

–拖放式编程

–参数库/ 工具条

–流程图式试验程序

16

SSQ:

–以图形方式编辑试验程序步骤

–试验步骤序列可视化

18

19

哪些通道被定义?哪些参数要被保存?

–系统参数

(SYS)–Test Field Param.

(TFP)哪一发动机在何种条件下被测试?

–被测试单元参数(UUT)–试验参数

(TST)

参数从何处装载?

–主机数据库或本地数据库

参数综述

–INIT 公式–记录仪触发–内含的–实时公式解释程序

–参数库功能

–根据需要

23

24。

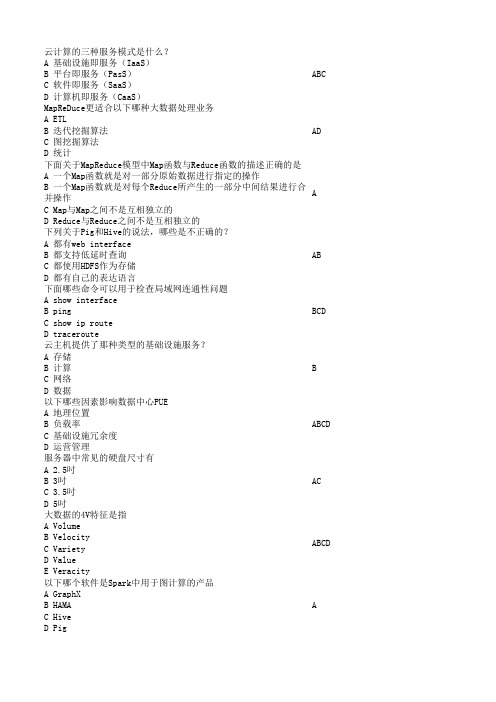

互联网新技术知识竞赛复习题-云

BCD ABCD ABC D ABC ABC ABCD D ABC

此题为单 选题,但 是却给了 两个答 案,我个 人认为应 该选C

大数据量的单位PB和ZP分布表示多少字节数 A 2的50次方和2的70次方 B 2的50次方和2的70次方 C 2的50次方和2的60次方 D 2的50次方和2的100次方 在数据仓库领域中,元数据按用途一般分成哪几类 A 技术元数据 B 应用元数据 C 程序元数据 D 业务元数据 桌面虚拟化系统一般应支持以下哪些功能 A 端口重定向 B 打印机重定向 C 语音设备重定向 D 文件重定向 虚拟机创建时vCPU核数量的上限是多少 A 32个 B 64个 C 物理主机CPU核总数 D 可以超过物理主机CPU核数 某个传统二层域可以用的VLAN数是 A 4093 B 4094 C 4095 D 4096 数据分成很多小部分并把它们分别存储到不同磁盘上的不同文件 中去。这句话描述的技术是 A RAID技术 B 负载均衡技术 C 多副本技术 D 条带化技术 NoSQL数据库的共同特征是什么 A 不需要预定义模式 B 无共享构架 C 弹性可扩展 D 分区 云计算平台需要达到的安全能力有哪些 A 抵御针对租户所部属应用共计的能力 B 抵御来至外部攻击的能力 C 证明自身无法破坏数据和应用安全的能力 D 提供差异化服务的能力 微软的Office365属于哪种服务模式的服务 A 基础设施即服务(IaaS) B 平台即服务(PasS) C 软件即服务(SaaS) D 计算机即服务(CaaS) 非结构化数据经过哪些处理才能加载到传统数据库中 A Extract B Compress C Transform D Load

B 元数据最为重要的特征和功能是为数字化信息资源建立一种机

器可理解框架 C 元数据也是数据,可以用类似数据的方法在数据库中进行存储

数据交换方案

数据交换方案R E S U M E REPORT CATALOG DATE ANALYSIS SUMMARY目录CONTENTS •数据交换概述•数据交换技术•数据交换安全•数据交换流程•数据交换案例分析•数据交换的未来发展REPORT CATALOG DATE ANALYSIS SUMMAR Y R E S U M E 01数据交换概述数据交换的定义数据交换是指不同系统、应用程序或组织之间传输和共享数据的过程。

数据交换的必要性随着企业规模的扩大和业务范围的拓展,不同部门、业务系统之间需要进行数据共享和交互,以支持决策分析、业务流程优化等需求。

数据交换能够消除信息孤岛,提高数据一致性和准确性,提升企业运营效率和决策水平。

数据交换的标准和协议常见的标准有XML、JSON、CSV等,协议包括HTTP、FTP、SFTP等。

数据交换的标准和协议是实现不同系统间数据交换的基础,它们规定了数据格式、传输协议、安全控制等方面的规范。

企业可以根据自身需求选择合适的标准和协议,以实现高效、安全的数据交换。

REPORT CATALOG DATE ANALYSIS SUMMAR Y R E S U M E 02数据交换技术简单易用,适用于不同系统之间的数据传输。

文件交换优点数据库交换优点数据结构化,易于管理和查询。

缺点需要数据库连接和访问权限,可能存在安全风险。

API交换优点高效、灵活、可扩展性强。

缺点需要开发和维护API接口,技术门槛较高。

消息队列交换优点异步、解耦、高可用性、高扩展性。

缺点需要消息队列中间件的支持,技术门槛较高。

REPORTCATALOG DATE ANALYSISSUMMAR YR E S U M E03数据交换安全数据加密对称加密使用相同的密钥进行加密和解密,常见的算法有AES、DES等。

非对称加密使用不同的密钥进行加密和解密,常见的算法有RSA、ECC等。

混合加密结合对称加密和非对称加密,以提高数据传输安全性。

AVL台架使用 介绍PO CHN

Puma o pen

2

–系统体系结构

–PUMA 软件应用程序

–PUMA 操作用户界面(POI)–PUMA 资源管理器

–试验程序编辑器(BSQ -SSQ)–参数管理器(PAM)–标准名编辑器(NED)

–Puma Concerto 数据处理软件(PUC)

重要信息

5

6

–数据采集–监视功能

–手动或自动输出设定值–子系统、子设备的控制–公式计算–数据后处理

PUMA 功能简介

8

测量部分

发动机&测功机控制部分

9

-图形显示-字母数字显示

–在同一时间可以激活5个记录仪

–针对通道的采样频率设置

–在线分析

–手动/ 自动操作

–在线更改记录仪设置

–自动(试验程序)–POI 手动

–操作面板

–控制窗口

PUMA Explorer:–易于使用

–易于学习

–用户向导

15

BSQ:

–拖放式编程

–参数库/ 工具条

–流程图式试验程序

16

SSQ:

–以图形方式编辑试验程序步骤

–试验步骤序列可视化

18

19

哪些通道被定义?哪些参数要被保存?

–系统参数

(SYS)–Test Field Param.

(TFP)哪一发动机在何种条件下被测试?

–被测试单元参数(UUT)–试验参数

(TST)

参数从何处装载?

–主机数据库或本地数据库

参数综述

–INIT 公式–记录仪触发–内含的–实时公式解释程序

–参数库功能

–根据需要

23

24。

prom 指标 -回复

prom 指标-回复标题:深入理解Prometheus指标:一种系统监控的强大工具Prometheus,作为一个开源的系统监控和报警工具,已经在众多企业和组织中得到了广泛应用。

其核心特性之一就是其强大的指标系统,使得用户能够对系统的各种状态和行为进行精细的监控和分析。

本文将详细解析Prometheus的指标系统,帮助读者更好地理解和使用这一工具。

一、Prometheus指标的基本概念在Prometheus中,指标(Metric)是系统状态的基本单位。

每个指标都由一个名字和一系列的标签(Label)组成,用于描述特定的测量值。

这些测量值可以是任何可以被量化的事物,如CPU利用率、网络带宽、数据库查询次数等。

二、Prometheus指标的类型Prometheus支持四种主要的指标类型:1. Counter:计数器,表示只增不减的数值,通常用于记录事件的数量,如请求总数、错误总数等。

2. Gauge:仪表盘,表示任意的数值,可以增加也可以减少,通常用于表示瞬时状态,如CPU利用率、内存使用量等。

3. Histogram:直方图,用于记录数据分布的情况,如请求响应时间的分布。

4. Summary:摘要,类似于直方图,但提供更灵活的计算方式,如百分位数。

三、Prometheus指标的命名和标签在Prometheus中,每个指标都有一个唯一的名称,并且可以附带一组标签。

这些标签用于区分同一类型的指标在不同环境或条件下的表现。

例如,一个名为"http_requests_total"的Counter指标,可以带有以下标签:"method"(HTTP方法)、"handler"(处理程序)、"status_code"(HTTP状态码)。

这样,我们就可以分别统计GET、POST等不同HTTP 方法的请求总数,或者200、404等不同状态码的请求总数。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

Puma2: Pros and Cons

• Pros

▪ ▪

Puma2 code is very simple. Puma2 service is very easy to maintain.

• Cons

▪ ▪ ▪ ▪

“Increment” operation is expensive. Do not support complex aggregations. Hacky implementation of “most frequent elements”. Can cause small data duplicates.

Improvements in Puma2

• Puma2

▪

Batching of requests. Didn‟t work well because of long-tail distribution.

• HBase

▪ ▪ ▪

“Increment” operation optimized by reducing locks. HBase region/HDFS file locality; short-circuited read. Reliability improvements under high load.

• Puma3 needs a lot of memory

▪ ▪

Use 60GB of memory per box for the hashmap SSD can scale to 10x per box.

PTail

Puma3

HBase

• Join

▪ ▪ ▪

Static join table in HBase. Distributed hash lookup in user-defined function (udf). Local cache improves the throughput of the udf a lot. Serving

• HBase as persistent key-value storage.

Serving

Puma3 Architecture

PTail

Puma3

HBase

• Write workflow

▪ ▪

Serving

For each log line, extract the columns for key and value.

▪ ▪ ▪

Checkpoints inserted into the data stream Can roll back to tail from any data checkpoints No data loss/duplicates

Channel Comparison

Push / RPC Latency 1-2 sec Loss/Dups Few Robustness Low Complexity Low Pull / FS 10 sec None High High

Look up in the hashmap and call user-defined aggregation

Puma3 Architecture

PTail

Puma3

HBase

• Checkpoint workflow

▪

Every 5 min, save modified hashmap entries, PTail checkpoint to HBase

▪

Serving Read uncommitted: directly serve from the in-memory hashmap; load from Hbase on miss. Read committed: read from HBase and serve.

▪

Puma3 Architecture

• ~ 1M log lines per second, but light read • Multiple Group-By operations per log line

• The first key in Group By is always time/date-related

• Complex aggregations: Unique user count, most frequent elements

Serving

▪

▪

On startup (after node failure), load from HBase

Get rid of items in memory once the time window has passed

Puma3 ArchitectureFra bibliotekPTail

Puma3

HBase

• Read workflow

▪

How do we reduce per-batch overhead?

Decisions

• Stream Processing wins!

• Data Freeway

▪

Scalable Data Stream Framework

• Puma

▪

Reliable Stream Aggregation Engine

Puma2 / Puma3 comparison

• Puma3 is much better in write throughput

▪ ▪

Use 25% of the boxes to handle the same load. HBase is really good at write throughput.

▪ ▪

Application buckets are application-defined shards. Infrastructure buckets allows log streams from x B/s to x GB/s

• Performance

▪ ▪

Latency: Call sync every 7 seconds Throughput: Easily saturate 1Gbit NIC

MySQL and HBase: one page

Parallel Fail-over Read efficiency Write efficiency Columnar support MySQL Manual sharding Manual master/slave switch High Medium No HBase Automatic load balancing Automatic Low High Yes

Puma2 Architecture

PTail

Puma2

HBase

Serving

• PTail provide parallel data streams • For each log line, Puma2 issue “increment” operations to HBase. Puma2 is symmetric (no sharding). • HBase: single increment on multiple columns

Scribe

Push / RPC Calligraphus

PT ail + ScribeSend

Pull / FS Continuous Copier

Puma real-time aggregation/storage

Overview

Log Stream

Aggregations

Storage

Serving

C1

C2

DataNode

Scribe Clients

Calligraphus Mid-tier

Calligraphus Writers

PTail

HDFS

HDFS PTail (in the plan) Log Consumer

Zookeeper

• 9GB/sec at peak, 10 sec latency, 2500 log categories

Real-time Analytics at Facebook: Data Freeway and Puma

Agenda

1 2 3 4

Analytics and Real-time Data Freeway Puma Future Works

Analytics and Real-time what and why

• Still not good enough!

Puma3 Architecture

PTail

Puma3

HBase

• Puma3 is sharded by aggregation key. • Each shard is a hashmap in memory.

• Each entry in hashmap is a pair of an aggregation key and a user-defined aggregation.

Analytics based on Hadoop/Hive

seconds seconds

Hourly Copier/Loader

Daily Pipeline Jobs

HTTP

Scribe

NFS

Hive Hadoop

MySQL

• 3000-node Hadoop cluster

• Copier/Loader: Map-Reduce hides machine failures • Pipeline Jobs: Hive allows SQL-like syntax • Good scalability, but poor latency! 24 – 48 hours.