基于加权系数寻优的回归型加权支持向量机

基于系数平均的混合地理加权回归模型的估计及其系数类型辨识

基于系数平均的混合地理加权回归模型的估计及其系数类型辨识1.引言1.1 概述混合地理加权回归模型是一种用于解决空间分析和回归建模问题的重要方法。

它结合了地理加权回归模型和混合模型的优势,旨在提高回归模型的预测精度和解释能力。

该模型在广泛的领域中被广泛应用,包括城市规划、环境科学、社会经济学等。

地理加权回归模型是一种考虑了空间依赖性的回归建模方法。

它通过引入地理权重来反映不同地理位置样本之间的空间相关性,从而改善回归模型对空间异质性的建模能力。

然而,在某些情况下,地理加权回归模型的预测效果可能受到一些列影响因素的制约,如样本不平衡、非线性关系等。

为了克服这些限制,研究人员提出了系数平均的混合地理加权回归模型。

该模型在传统的地理加权回归模型的基础上,引入了系数平均的思想,通过对不同加权回归模型的系数进行平均,得到更稳健和准确的估计结果。

这种模型能够更好地应对数据的异质性,并提高预测模型的精度和解释能力。

本文旨在对基于系数平均的混合地理加权回归模型的估计方法及其系数类型辨识进行详细介绍。

在第2节中,我们将详细介绍该模型的建模方法和估计过程。

第3节将总结模型的实证结果,并对系数类型辨识的方法进行分析。

通过本文的研究,我们希望能够提供一个有效的分析工具和方法,为相关领域的研究者和决策者提供有益的参考和借鉴。

1.2文章结构1.2 文章结构本文将分为以下几个部分进行论述。

第一部分为引言部分。

在引言部分,首先对基于系数平均的混合地理加权回归模型进行概述,介绍其背景和意义。

接着,说明文章的结构和内容安排,并介绍本文的目的和意义。

第二部分为正文部分。

正文部分将详细讲解系数平均的混合地理加权回归模型及其估计方法。

首先,介绍混合地理加权回归模型的基本原理和假设条件。

然后,详细介绍系数平均的混合地理加权回归模型的构建方法和步骤。

接着,说明估计方法的选择和应用,包括参数估计和模型拟合等方面的内容。

最后,通过实例分析来验证该模型在实际问题中的应用价值和效果。

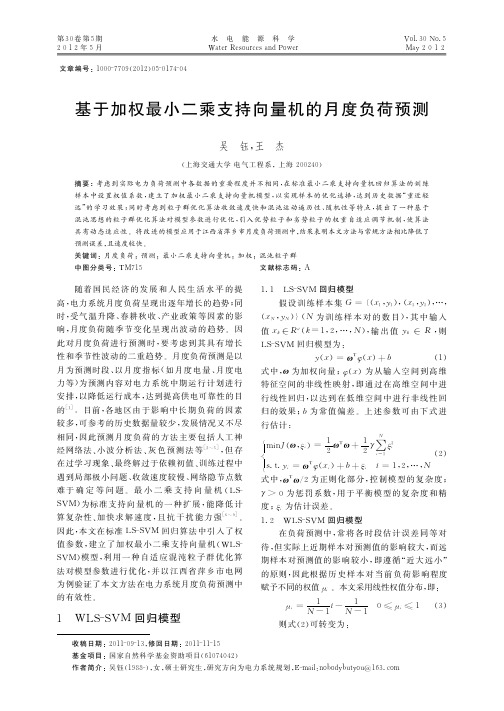

基于加权最小二乘支持向量机的月度负荷预测

基于加权最小二乘支持向量机的月度负荷预测

吴 钰, 王 杰

( ) 上海交通大学 电气工程系 ,上海 2 0 0 2 4 0 摘要 :考虑到实际电力负荷预测中各数据的重要程度并不相同 , 在标准最小二乘支持向量机回 归 算 法 的 训 练 样本中设置 权 值 系 数 , 建立了加权最小二乘支持向量机模型, 以实现样本的优化选择, 达到历史数据“ 重近轻 远” 的学 习 效 果 ; 同时考虑到粒子群优化算法收敛速度快和混沌运动遍历性、 随机性等特点, 提出了一种基于 混沌思想的粒子群优化算法对模型参数进行优化 , 引入优 势 粒 子 和 劣 势 粒 子 的 权 重 自 适 应 调 节 机 制 , 使算法 结果表明本文方法与常规方法相比降低了 具有动态适应性 。 将改进的模型应用于江西省萍乡市月度负荷预测中 , 预测误差 , 且速度较快 。 关键词 :月度负荷 ;预测 ;最小二乘支持向量机 ;加权 ;混沌粒子群 中图分类号 : TM 7 1 5 文献标志码 :A

第3 0 卷第 5 期

吴 钰等 : 基于加权最小二乘支持向量机的月度负荷预测

N

·1 7 5·

1 T 1 2 烄 m i n J* ( ω, = ω ω + γ∑ i) i i ξ ξ 2 2 i=1μ 烅 ( ) 4 T ( …, s . t . x i = 1, 2, N +b+ξ y i =ω φ i) i 烆 ) , 通过建立 L 即: a r a n e方程求解式 ( 4 g g

随着 国 民 经 济 的 发 展 和 人 民 生 活 水 平 的 提 高, 电力系统月度负荷呈现出逐年增长的趋势 ; 同 时, 受 气 温 升 降、 春 耕 秋 收、 产业政策等因素的影 响, 月度负荷 随 季 节 变 化 呈 现 出 波 动 的 趋 势 。 因 此对月度负荷进 行 预 测 时 , 要考虑到其具有增长 性和季节性波动的二重趋势 。 月度负荷预测是以 月为预测时段 、 以月度指标( 如 月 度 电 量、 月度电 为预测内容 对 电 力 系 统 中 期 运 行 计 划 进 行 力等 ) 安排 , 以降低运行成本 , 达到提高供电可靠性的目

加权逻辑回归

加权逻辑回归一、背景介绍逻辑回归是一种常见的分类算法,它可以用来预测二元变量的结果。

在实际应用中,我们经常需要对不同的特征进行加权处理,以更好地反映它们对结果的影响程度。

这就引出了加权逻辑回归。

二、基本原理加权逻辑回归是在普通逻辑回归的基础上引入了特征权重的概念。

具体来说,我们可以为每个特征赋予一个权重系数,这个系数可以正负,表示该特征对结果是正面影响还是负面影响。

在进行模型训练时,我们将这些权重系数纳入到损失函数中,以更好地优化模型。

三、加权逻辑回归的公式在加权逻辑回归中,假设有m个样本和n个特征,则模型可以表示为:$$h_{\theta}(x)=\frac{1}{1+e^{-\theta^{T} x}}$$其中$\theta$表示模型参数向量,$x$表示单个样本的特征向量。

为了引入特征权重,我们可以将每个样本的特征向量乘以一个相应的权重系数$w_i$:$$h_{\theta}(x)=\frac{1}{1+e^{-\theta^{T} w^{T} x}}$$其中$w$表示权重系数向量,其长度为n。

在训练模型时,我们需要定义一个损失函数来衡量模型的拟合程度。

常用的损失函数是交叉熵损失函数:$$J(\theta)=-\frac{1}{m}\sum_{i=1}^{m}[y^{(i)}log(h_{\theta}(x^{(i)}))+(1-y^{(i)})log(1-h_{\theta}(x^{(i)}))]$$其中$y$表示样本的真实标签,$h_{\theta}(x)$表示模型对该样本属于正类的预测概率。

为了引入特征权重,我们可以将特征向量中每个元素乘以相应的权重系数:$$J(\theta)=-\frac{1}{m}\sum_{i=1}^{m}[y^{(i)}log(h_{\theta}(w^{T} x^{(i)}))+(1-y^{(i)})log(1-h_{\theta}(w^{T} x^{(i)}))]$$四、求解过程在求解加权逻辑回归模型时,我们可以使用梯度下降算法来最小化损失函数。

毕业论文:基于支持向量机(SVM)的蘑菇毒性检测系统(终稿)-精品

目录摘要........................................................................................................................................ I I 关键词........................................................................................................................................ I I Abstract ...................................................................................................................................... I I Key Words .................................................................................................................................. I I 1引言.. (1)1.1研究意义 (1)1.2国内外研究情况 (1)2支持向量机理论 (3)2.1支持向量机基础理论 (3)2.2C-SVM算法及其变形算法 (7)2.3 V-SVM算法 (9)3 LIBSVM软件 (12)3.1LIBSVM软件简介 (12)3.2LIBSVM软件的使用方法 (12)3.3LIBSVM的工具包 (15)4 Qt图形库 (18)5 系统的设计与实现 (19)5.1分类问题的提出及SVM分类原理 (19)5.2支持向量机与蘑菇毒性分析相结合 (21)5.2.1 蘑菇毒性检测系统总体框架 (21)5.2.2 蘑菇物理属性的数据描述 (21)5.2.3 蘑菇属性数据学习模型的建立 (23)5.2.4 蘑菇毒性预测部分 (26)6 总结 (27)6.1结论 (27)6.2下一步工作 (28)参考文献 (29)致谢 (30)基于支持向量机(SVM)的蘑菇毒性检测系统摘要本文根据模式识别理论,对支持向量机的分类机制,核函数算法和松弛变量的定义进行了研究,采用了LIBSVM工具结合蘑菇毒性样本数据在linux下开发出了蘑菇毒性检测系统,该系统着重分析了样本数据的分割和参数变量的定义对分类精确率的影响。

基于优化多核支持向量回归的制造过程均值偏移幅度估计

基于优化多核支持向量回归的制造过程均值偏移幅度估计朱波;刘飞

【期刊名称】《中国机械工程》

【年(卷),期】2014(025)005

【摘要】为更加准确地估计制造过程均值偏移幅度,提出了一种基于多核函数支持向量回归(SVR)的估计方法.多核函数由线性核、多项式核和径向基核3种基本核函数凸组合而成,并通过粒子群优化算法(PSO)对核参数、组合权重系数以及SVR的惩罚系数C进行联合优化,以五折交叉验证求得训练样本的决定系数均值作为粒子适应度值,使生成的多核SVR获得良好的泛化能力.将该多核SVR与累积和(CUSUM)控制图集成构建了过程均值偏移监测模型,仿真实验结果表明,该方法相对人工神经网络(ANN)方法估计精度明显提高,比采用单一径向基核函数的SVR更为优越;在实际齿轮加工过程中进行应用验证,进一步证实了该方法的有效性和实用性.【总页数】7页(P630-635,641)

【作者】朱波;刘飞

【作者单位】重庆大学机械传动国家重点实验室,重庆400030;重庆大学机械传动国家重点实验室,重庆400030

【正文语种】中文

【中图分类】TP391.4;TH165.4

【相关文献】

1.基于优化有向无环图支持向量机的多变量过程均值异常识别 [J], 朱波;刘飞;李顺江

2.基于粗差判别的参数优化自适应加权最小二乘支持向量机在PX氧化过程参数估计中的应用 [J], 陶莉莉;钟伟民;罗娜;钱锋

3.基于支持向量回归模型的间歇过程优化 [J], 刘毅;阳宪惠;熊智华

4.基于支持向量回归模型的间歇过程优化 [J], 刘毅;阳宪惠;熊智华

5.基于改进灰狼算法优化多核支持向量回归机及其应用 [J], 王颖;朱刘涛;童勤;张强

因版权原因,仅展示原文概要,查看原文内容请购买。

基于加权支持向量机的网络入侵检测研究

(ol e fnoma o n i e n ,S uhr agz nvri , x 1 12 C i ) C l g Ifr t nE g er g o te Y n t U i sy Wu i 4 2 , hn e o i n i n e e t 2 a

e u l  ̄Weg tds p ot e tr c ie r lsic t nwh r e at f s lsi c t nfr a ht iigs pei i ee t a d q al y ihe u p r co hn s a sf ai ee n l o mi a sf ai c a n a l df rn, n v ma o f c i o p y c i o o e rn m s

中图法分类号 : P 9 . T 330 8

文献标识 码Βιβλιοθήκη A文章编 号 :007 2 20 ) 257.4 10 .04(07 2.340

N ewo ki tu in d tcin b s do eg td s p o t co c n t r r so ee to a e nw ih e u p r trma hie n ve

惩 罚 系 数 是 相 等 的 。 加 权 支持 向量 机 对 每 个 错 误 分 类 样 本 的 惩 罚 系 数 是 不 一 样 的 ,这 对 小样 本 来 说 提 高 了 分 类 精 度 ,克 服 了 常规 S M 算 法 不 能 灵 活 处 理 样 本 的 缺 陷 。 但 这 是 以 大样 本 分 类 精 度 的 降低 以及 总 分 类精 度 的 下 降 为 代 价 的 。 实验 结 果 V 证 明 , 加 权 支持 向 量 机 用 于 网络 入 侵 检 测 中 是 可 行 的 、 将 高效 的 。 关 键 词 :支持 向 量 机 ; 加 权 系 数 ; 网 络 入 侵 检 测 ; 分 类 ; 不 均衡 训 练 集

基于灰色特征加权支持向量机的二维函数拟合

.

( )规 范 性 : 1 0< rx , 三 1, ( 0z )一 1 ( 0z )三 三 rx , ㈢ 0一

T i。

R) ,其 中 : ∈ e l

, M∈R , 一 1… , ,支持 向量 回归机 i , z

权 重的特征加权 支持 向量回归机 算法 ,并推 广运用 于二维 函数较 传统 支持

向 量 回 归机 ,具 有 更 好 的 回 归拟 合 能 力 。 关 键 词 :支 持 向 量 回 归机 ;灰 色 关联 度 ;特 征 ;加 权 ;拟 合 中 图 法 分 类 号 :T 3 1 4 文 献 标 识 号 : 文 章 编 号 :10 —0 4 ( 0 2 03 7—4 P 9 . A 0 07 2 2 1 )1 —9 50

I r c ied e t h r n o s n s lt n o r i i g s mp e ,t e r s ls o it g f n t n o t n d o e h e u r — n p a t u o i e e t ie a d io a i ft an n a ls h e u t ff i u ci fe o n tme tt e r q ie c n n o tn o

0 引 言

支持向量机是 Va nk在统计学习理论 的基础上 提 出并 pi 发展起来 的 ,它是监 督式 的学 习方 法之一 ,它 的理论基 础 是统计学 习 VC维 理论与 结构 风 险最小 化 ,通 过有 限 的样

基 提 出 了 基 于 特 征 加权 的 支 持 向 量 回归 机 ( - V WF S R)l 2 ],

lssvm回归原理

lssvm回归原理LSSVM回归原理引言:支持向量机(Support Vector Machine,SVM)是一种广泛应用于分类和回归问题的机器学习算法。

其中,线性支持向量机(Linear SVM)在处理线性可分问题时表现出色,但在处理非线性问题时效果不佳。

因此,为了解决非线性回归问题,基于线性支持向量机发展出了一种改进算法,即Least Squares Support Vector Machine(LSSVM)。

LSSVM回归原理:LSSVM回归是一种非参数化模型,它使用支持向量机的思想进行回归分析。

与传统的线性回归模型不同,LSSVM回归通过引入核函数来将数据映射到高维特征空间,从而实现非线性回归。

其基本原理如下:1. 核函数选择:LSSVM回归的核心在于选择合适的核函数。

常用的核函数有线性核函数、多项式核函数、高斯核函数等。

不同的核函数对应不同的特征映射,因此核函数的选择需要根据具体问题的特点进行。

2. 模型建立:LSSVM回归的目标是在给定的训练数据集上,通过寻找最优的超平面来拟合数据。

具体而言,LSSVM回归的目标是最小化误差的平方和,并引入正则化项来控制模型的复杂度,防止过拟合。

因此,LSSVM回归的优化目标可以表示为一个二次规划问题。

3. 模型求解:求解LSSVM回归模型可以采用多种方法,常见的有序列最小最优化(Sequential Minimal Optimization, SMO)算法和坐标下降法。

这些算法可以高效地求解LSSVM回归模型的参数,从而得到最优的超平面。

4. 模型评估:为了评估LSSVM回归模型的性能,常用的指标包括均方误差(Mean Squared Error,MSE)、均方根误差(Root Mean Squared Error,RMSE)和决定系数(Coefficient of Determination,R-squared)等。

这些指标可以用来衡量模型的拟合程度和预测能力。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

基金项目:高等学校博士学科点专项科研基金项目(20040251010);

上海市自然科学基金项目(04ZR14034);国家重点基础研究发展规划项目(2002CB312200)收稿日期:2005-06-06

第23卷 第7期计 算 机 仿 真2006年7月 文章编号:1006-9348(2006)07-0111-04

基于加权系数寻优的回归型加权支持向量机

王浩,王行愚,牛玉刚(华东理工大学信息科学与工程学院,上海200237)摘要:在加权回归型支持向量机中,由于考虑到不同数据对预测函数贡献程度的差异性,其预测效果往往优于标准的回归型支持向量机,该文针对现有回归型加权支持向量机使用中直接选择加权系数法存在的不足,提出了一种对加权系数进行优化的新方法。该方法通过选取曲率变化大、形式简单的幂函数作为候选加权函数,并采用格子搜索法寻找最优参数,从而可以确定出最优加权系数。仿真实验表明:在利用加权支持向量机训练时间序列数据集时,采用该方法确定最优加权系数,比目前常用选择加权系数的方法效果好。关键词:支持向量机;回归;加权系数中图分类号:TP181 文献标识码:A

WeightedSupportVectorRegressionBasedonWeightingFactorOptimization

WANGHao,WANGXing-yu,NIUYu-gang(EastChinaUniversityofScienceandTechnology,Shanghai200237,China)ABSTRACT:Theweightedsupportvectorregressionoutperformsthestandardsupportvectorregressionwhenappliedintimesequencedataset,forthemeritsthatdifferentinputpointscanmakedifferentcontributionstothelearningofpredictivefunction.Inthispaper,theselectionproblemofweightingfactorsinweightedsupportvectorregressionisconsidered.Basedontheoptimizationtechnique,anewselectingapproachisproposedtoovercometheshortcomingofconventionalmethods.Inthepresentmethod,aproperweightingfactorischosenascandidateweightingfunctionbeingsuitedforsuitcertaintimesequencedataset.Andthen,agridsearchapproachisadoptedtoadaptivelydeter2minethesuitableweightingfactors.Theexperimentresultsshowthatthepresentmethodhasabetterperformancethanusualweightingfactorselectionmethod.KEYWORDS:Supportvectormachine(SVM);Regression;Weightingfactor

1 引言作为统计学习理论中结构风险最小化准则的具体实现,

支持向量机(SVM)具有结构简单、全局最优,泛化能力较好的优点,近几年得到了广泛的研究。SVM方法最早是针对模式识别问题提出来的,随着不敏感损失函数的引入,SVM己推广到非线性系统的回归函数估计,并展现出较好的学习性能。在标准回归型支持向量机(SVR)中,所有样本对应的C

(惩罚参数)和ε(误差要求参数)是相同的,即对不同样本的

精度和偏离精度的惩罚是相同的。但在实际应用中,对某些重要的样本数据,常常要求有小的训练误差,而对那些重要

性相对较低的样本数据,则可以容许一定大小的训练误差,

如股市预测、期货预测、电力负荷预测等动态变化比较剧烈的时间序列预测问题,近期数据的重要性要远远高于早期数据的重要性。也就是说,不同的样本数据,其精度要求也会不同。因此,在描述优化问题时,每个样本数据应具有不同的误差要求和惩罚系数,即各样本对应的ε和C是不同的,

从而得到更准确的回归估计。基于上述考虑,研究人员提出了加权支持向量机[1][5]。由于考虑到了各训练样本重要性的差异,并通过给不同样本的C和ε赋予不同权重,使得加权支持向量机方法可以显著改善系统的泛化能力[1][5]。值得注意的是,目前在加权SVR的具体应用中,人们通常是直接选用一组递增数列作为加权系数。然而,众所周知,不同样本重要性的递增程度通常不可能完全一致,因此,

上述直接对所有样本赋予相同加权系数的方法,势必会影响加权SVR的预测效果。基于这样的考虑,本文提出了一种—111—对加权系数进行优化的新方法。通过在候选加权系数集中进行格子搜索,找出最好的加权系数,从而构成一种预测效果很好的加权SVR。实验表明:在加权SVR训练时间序列数据集时,采用本方法确定最优加权系数,比目前常用选择加权系数的方法效果好。2 加权SVR方法2.1 标准SVR设训练样本集为{(xi,yi),i=1,2,…m},其中xi∈RN为输入值,yi∈R为对应的目标值,m为样本数。定义ε不敏感损失函数为y-f(x,ω)|ε=0 |y-f(x,ω)|0为设计参数,它规定了估计函数在样本数据上的误差要求。在采用支持向量机研究非线性样本集时,通过非线性函数Ф(・)将训练集数据映射到一个具有高维线性的特征空间,在这个维数可能为无穷大的特征空间中构造估计函数,支持向量机存在对偶表现形式,数据仅作为Gram矩阵的项出现,而不需要通过单个属性出现,预测函数f(x)有如下形式[9]:f(x)=ω・Ф(x)+b(2)式中:ω・Ф(x)表示向量ω与Ф(x)的内积,ω的维数为特征空间维数(可能为无穷维),b∈R。根据统计学习理论[3]预测函数f(x)的估计转换成如下的最优化问题:minω,b,ξ,ξ312‖ω‖2+C∑mi=1(ξi+ξ3i),s.t.yi-ω・<(xi)-b≤ε+ξi,ω・<(xi)+b-yi≤ε+ξ3i,ξi≥0,ξ3i≥0;i=1,2...m(3)式中:C>0为惩罚系数,C越大表示对训练误差|f(xi)-yi|(i=1,2...,m)大于ε的样本的惩罚越大。如何选择参数C和ε是回归型支持向量机的关键,由于C表示了对训练误差超过ε管道的样本的惩罚,C越小,惩罚越小,从而使训练误差变大。另一方面,C取得大,由式(3),与置信范围值相关的ε的权重相应地变小,即置信范围值的权重变小,从而使系统的泛化能力变差,因此参数C的选择对系统泛化能力影响比较大,ε的大小与是否会得到惩罚相关,ε选小,回归估计精度要求高,但支持向量数量增多,ε选大,回归估计精度降低,支持向量数据少,SVM的稀疏性大,如何合理选择参数C和ε,目前还没有有效的方法。在式(3)的回归型支持向量机方法中,参数C和ε对任何样本都相同,也就是说,尽管C和ε可以自由选择,但一旦选定,对于所有的样本数据,对它的精度要求以及偏离精度的惩罚是一样的,但是在实际应用中,如利用股市的股价时间序列进行股价走势的预测中,距离测试样本较近的训练样本,它的重要性要高于与测试样本相距较远的训练样本,针对样本重要性的不同,应选择不同的误差要求参数和对偏离误差进行惩罚的惩罚参数C和ε,这就是提出加权支持向量机方法的初衷。对式(3)的最优化问题,一般采用拉格朗日乘子法转换成对偶最优化问题,然后根据KKT条件进行最优化计算,得到的预测函数可以由(3)式写为如下具体的形式[3]

f(x)=∑mi=1(ai-a3i)k(xi,x)+b(4)2.2 加权SVR标准SVR在时间序列预测以及其它领域的应用中,对不同样本的惩罚参数C和误差要求参数ε是不同的,因此在标准SVR的基础上,提出了加权支持向量机,参数C和ε是针对各个样本来选择的,其最优化问题为

minm,b,ξ,ξ3

1

2‖w‖2+C∑li=1Si(ξi+ξ3i),

s.t. yi-w・Φ(xi)-b≤εti+ξi

w・Φ(xi)+b-yi≤εti+ξ3iξi≥0

ξ3i≥0;i=1,2,...,1.(5)

式中si,ti分别表示第i个训练样本对参数C和ε的加权系数,对于式(5),一般采用拉格朗日乘子法求解这个具有线性不等于约束的二次规划问题,得到类似式(4)的预测函数。由于考虑到了各训练样本重要性的差异,给不同样本的惩罚参数C和误差要求参数ε赋予不同权重的加权支持向量机方法可以显著改善系统的泛化能力[1][5]。

3 基于加权系数寻优的回归型加权支持向量机目前在加权SVR的研究中,加权系数的选取通常采用在a到1(1>a≥0)之间的线性插值法确定[1][4][5],或采用时间的二次函数作为加权系数的函数(加权函数)[5]。在对时间序列数据的具体实验中,最不重要的数据加权系数通常直接选择为S

1=0,t1=1,最重要的数据加权系数Sm=1,t

m

=0,使用线性插值法求出其余数据的加权系数[1][5]。

在本文研究中,考虑到当训练样本比较少时,每一个样本所提供的信息都很重要,此时S1值应较大(当S1为1时,加权函数成为一个所有函数值为1的常值函数,所有样本重要程度相等,对应的加权SVR就成为标准SVR了),当训练样本越大,早期样本所包含的"陈旧"信息越多,最小加权系数S1

越趋于零,同样大小而不同领域的时间序列,可能包含的"

陈旧"信息数量是不一样的,因此应该对S1寻优,找出最适合特定训练集的S1。同理,虽然加权系数是递增的,但对于不同时间序列数据集,其样本重要程度的增加可能是不一样的,加权函数可能为线性函数,也可能是不同形状的二次曲线或其它增函数,当没有相关先验知识的情况下,直接指定一个固定的加权函数[1][4][5]很可能遗漏最优的加权系数。在后面的实验—211—