最大最小距离算法以及实例

fréchet距离优化算法

fréchet距离优化算法【实用版】目录1.算法概述2.算法原理3.算法应用4.算法优缺点正文【算法概述】Fréchet 距离优化算法是一种用于计算多维空间中两个样本集之间最短距离的算法。

这种算法被广泛应用于数据挖掘、机器学习以及模式识别等领域,以比较不同样本集之间的相似度。

Fréchet 距离优化算法的基本思想是寻找一个合适的矩阵,使得该矩阵与两个样本集的矩阵之间具有最小的 Fréchet 距离。

【算法原理】Fréchet 距离优化算法的原理基于 Fréchet 距离的定义。

Fréchet 距离是指两个矩阵之间的最大列向量距离。

对于两个 n×m 的矩阵 A 和B,它们的 Fréchet 距离定义为:d(A, B) = max(max(∥a_i - b_i∥)),其中 i=1,2,...,n算法的基本流程如下:1.对两个样本集进行特征提取,得到两个矩阵 A 和 B。

2.计算矩阵 A 和 B 的 Fréchet 距离。

3.寻找一个合适的矩阵 C,使得矩阵 A 和 B 经过矩阵变换后得到的矩阵与 C 的 Fréchet 距离最小。

【算法应用】Fréchet 距离优化算法在许多领域都有广泛的应用,例如:1.在数据挖掘领域,该算法可以用于聚类分析,通过计算不同数据集之间的 Fréchet 距离,可以评估聚类的效果。

2.在机器学习领域,该算法可以用于评估模型的性能,通过比较不同模型预测结果与真实结果之间的 Fréchet 距离,可以评估模型的准确性。

3.在模式识别领域,该算法可以用于图像识别,通过计算两张图片之间的 Fréchet 距离,可以评估图片的相似度。

【算法优缺点】Fréchet 距离优化算法的优点有:1.可以处理高维数据。

2.计算速度快,复杂度较低。

最短距离法

最短距离法最短距离法是最近年来在分类学习和数据挖掘领域中较为流行的一种机器学习方法。

它的目的是从训练数据集中学习,并形成一种可以从新观察中推断出未知数据的判断方法。

本文介绍了最短距离法的基本概念、原理及其应用,结合例子进一步剖析了这种机器学习方法的核心思想。

一、什么是最短距离法最短距离法(k-nearest neighbors algorithm, k-NN)是一种基本分类算法,它通过测量不同特征值之间的距离来确定实例标签(类别)。

它的工作思路是:先从训练集中找出与当前实例(测试数据)最相似的k个实例,然后统计这k个实例中属于每一类别的实例数目,最后把当前实例分类到实例数目最多的类别中。

最短距离法的计算过程可以概括为:给定一个由N个特征表示的实例X,首先求出它到训练集中每个实例的距离,然后取出距离最小的k个实例,统计这k个实例中各类别的实例数,把X分类到实例数最多的类别中。

二、最短距离法的原理最短距离法的思想是,给定一个实例X,将它与训练集中的实例进行对比,利用距离的大小(越小越相似,越大越不相似)来判断X 的类别。

即:“物以类聚,人以群分”的思想。

最短距离法主要有两种距离计算方式:欧几里得距离(Euclidean Distance)和曼哈顿距离(Manhattan Distance),两者的计算方式不同,欧几里得距离适用于连续型变量,曼哈顿距离适用于离散型变量。

三、最短距离法的应用最短距离法的应用是模式分析的一个重要的挖掘工具,其主要用于分类任务。

它可以用于赛车、机器人、运动视觉系统等多种应用中。

由于最短距离法的简单性和高效的计算,它也被广泛应用于对用户行为分析、文档分类、图像分类、文字处理、计算生物学研究和金融研究等领域。

四、例子分析下面以一个简单的例子来说明最短距离法实例分类的过程:假设我们有一组三维数据,其中存在两类,[A类:[10,20,30], [20,30,40], [30,40,50]],[B类:[50,60,70], [60,70,80], [70,80,90]],现有一个需要分类的新实例:[40,50,60],我们使用最短距离法来确定其类别。

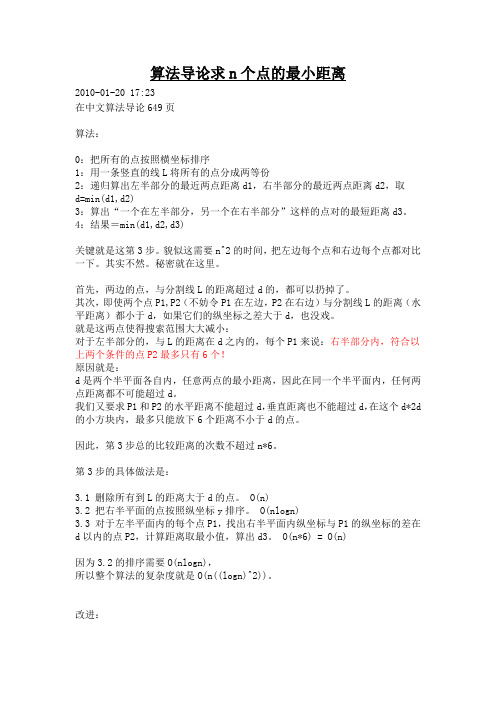

算法导论求n个点的最小距离

算法导论求n个点的最小距离2010-01-20 17:23在中文算法导论649页算法:0:把所有的点按照横坐标排序1:用一条竖直的线L将所有的点分成两等份2:递归算出左半部分的最近两点距离d1,右半部分的最近两点距离d2,取d=min(d1,d2)3:算出“一个在左半部分,另一个在右半部分”这样的点对的最短距离d3。

4:结果=min(d1,d2,d3)关键就是这第3步。

貌似这需要n^2的时间,把左边每个点和右边每个点都对比一下。

其实不然。

秘密就在这里。

首先,两边的点,与分割线L的距离超过d的,都可以扔掉了。

其次,即使两个点P1,P2(不妨令P1在左边,P2在右边)与分割线L的距离(水平距离)都小于d,如果它们的纵坐标之差大于d,也没戏。

就是这两点使得搜索范围大大减小:对于左半部分的,与L的距离在d之内的,每个P1来说:右半部分内,符合以上两个条件的点P2最多只有6个!原因就是:d是两个半平面各自内,任意两点的最小距离,因此在同一个半平面内,任何两点距离都不可能超过d。

我们又要求P1和P2的水平距离不能超过d,垂直距离也不能超过d,在这个d*2d 的小方块内,最多只能放下6个距离不小于d的点。

因此,第3步总的比较距离的次数不超过n*6。

第3步的具体做法是:3.1 删除所有到L的距离大于d的点。

O(n)3.2 把右半平面的点按照纵坐标y排序。

O(nlogn)3.3 对于左半平面内的每个点P1,找出右半平面内纵坐标与P1的纵坐标的差在d以内的点P2,计算距离取最小值,算出d3。

O(n*6) = O(n)因为3.2的排序需要O(nlogn),所以整个算法的复杂度就是O(n((logn)^2))。

改进:我们对3.2这个排序的O(nlogn)不太满意。

既然整个算法是递归的,我们可以利用第2步的子递归中已经排好序的序列,在第3.2部归并这两个子列,这样3.2的复杂度变成了O(n)。

这样,整个算法就是O(nlogn)的。

最大最小距离聚类算法

最大最小距离聚类算法最大最小距离聚类算法,也称为MM 算法(Maximum Minimum distance clustering algorithm),是一种经典的聚类算法。

该算法的核心思想是找到具有最大最小距离的数据点作为初始的聚类中心,然后根据所有数据点与聚类中心的距离重新对数据点进行划分,直到满足停止条件为止。

本文将详细介绍最大最小距离聚类算法的原理、步骤和优缺点。

最大最小距离聚类算法的原理是基于数据点之间的距离来进行聚类。

算法首先计算所有数据点对之间的距离,并选择具有最大最小距离的数据点作为初始聚类中心。

然后,根据计算得到的聚类中心,将数据点分配到离它们最近的中心点所属的簇。

接着,重新计算每个簇的中心点,并重复步骤二,直到满足停止条件。

1.计算所有数据点之间的距离,并找到具有最大最小距离的数据点。

2.将找到的数据点作为初始的聚类中心。

3.根据聚类中心,计算每个数据点到聚类中心的距离,并将数据点分配给离它们最近的中心的簇。

4.更新每个簇的中心点,计算簇内所有数据点的均值,并将其作为新的聚类中心。

5.重复步骤3和4,直到达到停止条件。

停止条件可以是聚类中心不再发生变化或达到预定的迭代次数。

1.算法简单直观,易于理解和实现。

2.不需要事先指定簇的数量,而是通过分析数据点之间的距离来自动确定将数据点聚类成的簇的数量。

3.算法的计算复杂度较低,适用于处理大规模数据集。

1.算法对初始聚类中心的选择很敏感。

不同的初始聚类中心可能会导致不同的聚类结果。

2.算法的聚类结果可能会受到异常值的影响。

3.由于算法在每次迭代中只更新一个聚类中心,可能会陷入局部最优的情况,而无法得到全局最优的聚类结果。

最大最小距离聚类算法是一种经典的聚类算法,具有简单直观、计算复杂度低的特点。

它在实际应用中被广泛使用,例如在图像分割、模式识别和数据挖掘等领域。

然而,该算法也存在着一些不足之处,例如对初值选择敏感和易受异常值的影响。

直线上一点到直线外两点的最小值-概述说明以及解释

直线上一点到直线外两点的最小值-概述说明以及解释1.引言1.1 概述引言部分概述了本篇长文的主要内容和结构。

本文将研究直线上一点到直线外两点的最小值的概念和计算方法,并总结其实际应用和意义。

在几何学中,直线是最基本的图形之一,而直线上的点到直线外的两点的最小值问题,是几何学中的一个经典问题。

它涉及到直线上的一个点到直线外两个点的最短距离,具有一定的研究价值和实际意义。

本文将首先详细阐述直线上一点到直线外两点的最小值的概念和定义,深入探讨其几何特征和性质。

其次,将介绍计算直线上一点到直线外两点的最小值的方法,包括相关公式和算法。

通过具体的数学推导和实例分析,将详细解释计算过程和步骤。

在最后的结论部分,将对直线上一点到直线外两点的最小值进行总结和概括。

通过对所研究问题的整体回顾,总结其特点和规律。

同时,本文还将探讨直线上一点到直线外两点的最小值的实际应用和意义,如在几何测量、路径规划等领域的具体应用。

通过本篇长文的详细介绍和分析,读者将能够更加深入地了解直线上一点到直线外两点的最小值问题,并掌握相关的计算方法。

同时,通过对实际应用和意义的讨论,读者将能够进一步认识到这一问题在实际中的重要性和实用价值。

1.2文章结构1.2 文章结构本文将按照以下结构进行讨论直线上一点到直线外两点的最小值的概念、计算方法、结论以及实际应用和意义。

首先,我们将在引言中概述本文的主题和问题,并介绍文章的结构。

接着,我们将在正文部分详细阐述直线上一点到直线外两点的最小值的概念。

这将包括对直线上一点到直线外两点距离最小值的定义和解释,以及相关的数学原理和特性。

我们将通过具体的示例和图表来理解这个概念。

然后,我们将介绍计算直线上一点到直线外两点的最小值的方法。

我们将涵盖基本的计算公式和算法,并讨论它们的优劣。

我们还将介绍可能出现的特殊情况和处理方法。

接下来,我们将在结论部分总结直线上一点到直线外两点的最小值的重要性和应用。

我们将讨论这个概念在实际生活和科学研究中的应用,并探讨其带来的意义和影响。

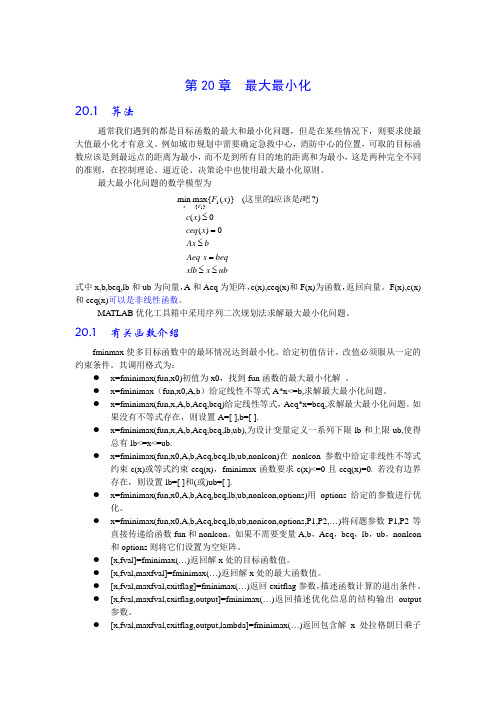

ch20-最大最小化

第20章 最大最小化20.1 算法通常我们遇到的都是目标函数的最大和最小化问题,但是在某些情况下,则要求使最 大值最小化才有意义。

例如城市规划中需要确定急救中心,消防中心的位置,可取的目标函数应该是到最远点的距离为最小,而不是到所有目的地的距离和为最小,这是两种完全不同的准则,在控制理论、逼近论、决策论中也使用最大最小化原则。

最大最小化问题的数学模型为ub x xlb beqx Aeq bAx x ceq x c i x F F x ≤≤=≤=≤0)(0)(?)1()}({max min 1}{1吧应该是这里的式中x,b,beq,lb 和ub 为向量,A 和Aeq 为矩阵,c(x),ceq(x)和F(x)为函数,返回向量。

F(x),c(x)和ceq(x)可以是非线性函数。

MATLAB 优化工具箱中采用序列二次规划法求解最大最小化问题。

20.1 有关函数介绍fminmax 使多目标函数中的最坏情况达到最小化。

给定初值估计,改值必须服从一定的约束条件。

其调用格式为:● x=fminimax(fun,x0)初值为x0,找到fun 函数的最大最小化解 。

● x=fminimax (fun,x0,A,b )给定线性不等式A*x<=b,求解最大最小化问题。

● x=fminimax(fun,x,A,b,Aeq,beq)给定线性等式,Aeq*x=beq,求解最大最小化问题。

如果没有不等式存在,则设置A=[ ],b=[ ].● x=fminimax(fun,x,A,b,Aeq,beq,lb,ub),为设计变量定义一系列下限lb 和上限ub,使得总有lb<=x<=ub.● x=fminimax(fun,x0,A,b,Aeq,beq,lb,ub,nonlcon)在nonlcon 参数中给定非线性不等式约束c(x)或等式约束ceq(x),fminimax 函数要求c(x)<=0且ceq(x)=0. 若没有边界存在,则设置lb=[ ]和(或)ub=[ ].● x=fminimax(fun,x0,A,b,Aeq,beq,lb,ub,nonlcon,options)用options 给定的参数进行优化。

实验一 最大最小距离法

实验 一 最大最小距离法一.实验目的本实验的目的是使学生了解最大最小距离法聚类方法,掌握最大最小距离聚类分析法的基本原理,培养学生实际动手和思考能力,为数据分析和处理打下牢固基础。

二.最大最小距离聚类算法该算法以欧氏距离为基础,首先辨识最远的聚类中心,然后确定其他的聚类中心,直到无新的聚类中心产生。

最后将样本按最小距离原则归入最近的类。

例:样本分布如图所示。

样本 1x2x3x4x5x6x7x8x9x10x第一分量 0 3 2 1 5 4 6 5 6 7 第二分量 0 8213 834 45到1Z 的距离73 8 2804552 74到2Z 的距离80 14058262917 2218),min(21i i D D0 1 8 22629172218最大最小距离聚类算法步骤如下:① 给定θ,10<<θ,并且任取一个样本作为第一个聚合中心,11x Z =。

② 寻找新的集合中心:计算其它所有样本到1Z 的距离1i D :若}{max 11i ik D D =,则取k x 为第二个聚合中心2Z ,62x Z =。

计算所有样本到1Z 和2Z 的距离1i D 和2i D :若)},max{min(21i i l D D D =,n i ,....,2,1=,并且12D D l ⋅>θ,12D 为1Z 和2Z 间距离,则取l x 为第三个集合中心3Z ,73x Z =。

【注意:∑=-=-=di ii i zx Z x D 12111||||||,||||22Z x D i i -=】如果3Z 存在,则计算)},,max{min(321i i i j D D D D =,n i ,....,2,1=,若12D D j ⋅>θ,则建立第四个聚合中心。

依次类推,直到最大最小距离不大于12D ⋅θ时,结束寻找聚合中心的计算。

注意7x 所在第列,29在),min(21i i D D 中为最大的,而且8029⋅>=θl D ,一般取21=θ。

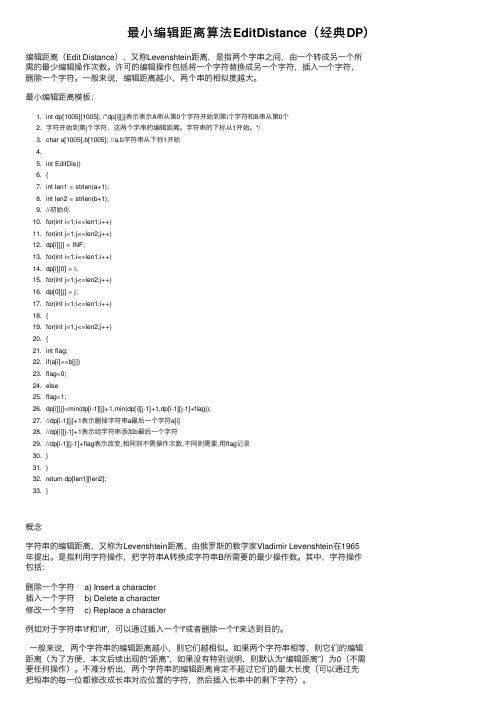

最小编辑距离算法EditDistance(经典DP)

最⼩编辑距离算法EditDistance(经典DP)编辑距离(Edit Distance),⼜称Levenshtein距离,是指两个字串之间,由⼀个转成另⼀个所需的最少编辑操作次数。

许可的编辑操作包括将⼀个字符替换成另⼀个字符,插⼊⼀个字符,删除⼀个字符。

⼀般来说,编辑距离越⼩,两个串的相似度越⼤。

最⼩编辑距离模板:1. int dp[1005][1005]; /*dp[i][j]表⽰表⽰A串从第0个字符开始到第i个字符和B串从第0个2. 字符开始到第j个字符,这两个字串的编辑距离。

字符串的下标从1开始。

*/3. char a[1005],b[1005]; //a,b字符串从下标1开始4.5. int EditDis()6. {7. int len1 = strlen(a+1);8. int len2 = strlen(b+1);9. //初始化10. for(int i=1;i<=len1;i++)11. for(int j=1;j<=len2;j++)12. dp[i][j] = INF;13. for(int i=1;i<=len1;i++)14. dp[i][0] = i;15. for(int j=1;j<=len2;j++)16. dp[0][j] = j;17. for(int i=1;i<=len1;i++)18. {19. for(int j=1;j<=len2;j++)20. {21. int flag;22. if(a[i]==b[j])23. flag=0;24. else25. flag=1;26. dp[i][j]=min(dp[i-1][j]+1,min(dp[i][j-1]+1,dp[i-1][j-1]+flag));27. //dp[i-1][j]+1表⽰删掉字符串a最后⼀个字符a[i]28. //dp[i][j-1]+1表⽰给字符串添加b最后⼀个字符29. //dp[i-1][j-1]+flag表⽰改变,相同则不需操作次数,不同则需要,⽤flag记录30. }31. }32. return dp[len1][len2];33. }概念字符串的编辑距离,⼜称为Levenshtein距离,由俄罗斯的数学家Vladimir Levenshtein在1965年提出。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

最大最小距离算法实例

10个模式样本点{x1(0 0), x2(3 8), x3(2 2), x4(1 1), x5(5 3), x6(4 8), x7(6 3), x8(5 4), x9(6 4), x10(7 5)}

第一步:选任意一个模式样本作为第一个聚类中心,如z1 = x1;

第二步:选距离z1最远的样本作为第二个聚类中心。

经计算,|| x6 - z1 ||最大,所以z2 = x6;

第三步:逐个计算各模式样本{x i, i = 1,2,…,N}与{z1, z2}之间的距离,即

D i1 = || x i - z1 ||

D i2 = || x i – z2 ||

并选出其中的最小距离min(D i1, D i2),i =

1,2,…,N

第四步:在所有模式样本的最小值中选出最大距

离,若该最大值达到||z1 - z2 ||的一定比例以

上,则相应的样本点取为第三个聚类中心

z3,即:若max{min(D i1, D i2), i = 1,2,…,N} >

θ||z1 - z2 ||,则z3 = x i

否则,若找不到适合要求的样本作为新的

聚类中心,则找聚类中心的过程结束。

这里,θ可用试探法取一固定分数,如1/2。

在此例中,当i=7时,符合上述条件,故

z3 = x7

第五步:若有z3存在,则计算max{min(D i1, D i2, D i3),

i = 1,2,…,N}。

若该值超过||z1 - z2 ||的一定

比例,则存在z4,否则找聚类中心的过程

结束。

在此例中,无z4满足条件。

第六步:将模式样本{x i, i = 1,2,…,N}按最近距离分到最近的聚类中心:

z1 = x1:{x1, x3, x4}为第一类

z2 = x6:{x2, x6}为第二类

z3 = x7:{x5, x7, x8, x9, x10}为第三类最后,还可在每一类中计算各样本的均值,得到更具代表性的聚类中心。