基于规则的中文地址分 词与匹配方法

211173142_中文地名地址成分信息识别

于记忆,并能帮助运用者能联想起地名与地理实体之间

稳定的联想关系。那些容易与特定地理实体建立起关联,

能生动地反映当地特点、体现地域文化特征的地名,因 指位效能强而受到社会的青睐 [7]。地名用字是地名构成

的重要部分,根据不同的目的和原则 , 可以采用不同的 地名分类法 [8]。因此本文想要通过缩减地名中地址要素

随着地理信息和大数据的快速发展,如何准确的识 别出我们需要的信息成为现在研究的关键,中文地名地 址的命名实体识别是自然语言处理的一项重要任务 [1]。 命名实体识别是进行信息匹配的前提,命名实体识别是 对文本中的重要名词和专有名词进行定位和分类的问题, 地名和我们的生活紧密结合在了一起,所以如何准确并 快速的检索到我们需要的地名成为了现在研究的关键。 1 国内外研究现状

引用 [1] 徐兵,石少青,陈超.基于自然语言的中文地址匹配研究[J].电 子设计工程,2020,28(16):7-10+16. [2] 梁南元.汉语自动分词知识[J].北京航空学院学报,1988(4):2933. [3] 于滨,程昌秀,左廷英.面向全国经济普查需求的专家系统地理 编码方法[J].计算机应用研究,2010,27(8):2976-2979. [4] 钱晶,张杰,张涛.基于最大熵的汉语人名地名识别方法研究 [J].小型微型计算机系统,2006(9):1761-1765. [5] 孙存群,周顺平,杨林.基于分级地名库的中文地理编码[J].计 算机应用,2010,30(7):1953-1955+1958. [6] 邬伦,刘磊,李浩然.基于条件随机场的中文地名识别方法[J]. 武汉大学学报(信息科学版),2017,42(2):150-156. [7] 刘连安.地名命名的分类以及影响地名生命力的因素[J].中国 地名,2020(2):4-5. [8] 尹钧科.浅谈区域地名研究[J].中国历史地理论丛,2003(3):6771+158-159. [9] YUAN Z.An Adaptive Chinese Word Segmentation Method [C]//International Conference on Automation, Mechanical Control and Computational Engineering,2018:556-561. [10] POWERS D M.Evaluation:From Precision,Recall and F-measure to ROC,Informedness,Markedness and Correlation[J]. 2020.

中文分词相关技术简介

中文分词相关技术简介目前对汉语分词方法的研究主要有三个方面:基于规则的分词方法、基于统计的分词方法和基于理解的分词方法。

基于规则的分词方法基于规则的分词方法,这种方法又叫做机械分词方法,它是按照一定的策略将待分析的汉字串与一个"充分大的"机器词典中的词条进行匹配,若在词典中找到某个字符串,则匹配成功(识别出一个词)。

常用的方法:最小匹配算法(Minimum Matching),正向(逆向)最大匹配法(Maximum Matching),逐字匹配算法,神经网络法、联想一回溯法,基于N-最短路径分词算法,以及可以相互组合,例如,可以将正向最大匹配方法和逆向最大匹配方法结合起来构成双向匹配法等。

目前机械式分词占主流地位的是正向最大匹配法和逆向最大匹配法。

◆最小匹配算法在所有的分词算法中,最早研究的是最小匹配算法(Minimum Matching),该算法从待比较字符串左边开始比较,先取前两个字符组成的字段与词典中的词进行比较,如果词典中有该词,则分出此词,继续从第三个字符开始取两个字符组成的字段进行比较,如果没有匹配到,则取前3个字符串组成的字段进行比较,依次类推,直到取的字符串的长度等于预先设定的阈值,如果还没有匹配成功,则从待处理字串的第二个字符开始比较,如此循环。

例如,"如果还没有匹配成功",取出左边两个字组成的字段与词典进行比较,分出"如果";再从"还"开始,取"还没",字典中没有此词,继续取"还没有",依次取到字段"还没有匹配"(假设阈值为5),然后从"没"开始,取"没有",如此循环直到字符串末尾为止。

这种方法的优点是速度快,但是准确率却不是很高,比如待处理字符串为"中华人民共和国",此匹配算法分出的结果为:中华、人民、共和国,因此该方法基本上已经不被采用。

中文分词错误纠正算法与优化

中文分词错误纠正算法与优化中文分词是自然语言处理中的重要任务之一,它将连续的中文文本切分成有意义的词语,为后续的文本处理和语义分析提供基础。

然而,由于中文的特殊性,分词中经常出现错误,如歧义词的切分、未登录词的处理等。

因此,研究中文分词错误纠正算法与优化成为了一个热门的研究方向。

一、中文分词错误的原因分析中文分词错误主要源于以下几个方面:1. 歧义词切分:中文中存在大量的歧义词,即同一组汉字可以有多种不同的切分方式,例如“北京大学生喝进口红酒”。

正确的切分应该是“北京/大学生/喝/进口/红酒”,而错误的切分可能是“北京/大学/生/喝/进口/红酒”。

2. 未登录词处理:未登录词是指分词词典中没有收录的新词或专有名词。

由于中文的词汇量庞大且不断更新,分词词典无法及时收录所有的新词,因此会出现未登录词的情况。

例如,“微信红包”在分词词典中可能无法找到对应的切分规则。

3. 语料库不完备:中文分词算法通常依赖于大规模的语料库进行训练和模型构建。

然而,由于语料库的不完备性,某些特殊领域或方言的词语可能无法被准确地切分。

二、中文分词错误纠正算法为了解决中文分词中的错误问题,研究者们提出了一系列的算法和方法:1. 基于规则的方法:基于规则的方法通过事先定义一系列的切分规则来进行分词,例如最大匹配法和最短路径法。

这些方法简单易懂,但对于歧义词和未登录词的处理效果较差。

2. 基于统计的方法:基于统计的方法通过统计语料库中的词频和词组频率来进行分词。

这些方法可以较好地处理歧义词和未登录词,但对于语料库不完备的情况下会有一定的限制。

3. 基于机器学习的方法:基于机器学习的方法通过建立分类器或序列标注模型来进行分词。

这些方法可以通过训练大规模的语料库来提高分词的准确性和泛化能力,但需要较多的训练数据和计算资源。

三、中文分词错误纠正的优化除了算法层面的优化,还可以从以下几个方面对中文分词错误进行优化:1. 词典的更新:及时更新分词词典,收录新词和专有名词,以提高分词的准确性。

给予规则的分词方法

给予规则的分词方法一、简介分词是自然语言处理中的重要任务之一,其目的是将连续的文本序列切分成词语序列。

为了达到准确的分词效果,人们提出了许多基于规则的分词方法。

这些方法基于各种规则和规则模板,通过匹配和替换的方式实现分词。

本文将介绍几种常见的给予规则的分词方法。

二、正向最大匹配法(Maximum Matching)正向最大匹配法是一种基于规则的分词方法。

其基本思想是从左到右按词典中最长的词开始匹配,直到无法继续匹配为止。

具体步骤如下:1. 从左到右取出文本中的一个词。

2. 从词典中找出以该词开头的最长词。

3. 如果找到了最长词,则将该词作为分词结果;如果没有找到最长词,则将该词作为单字分词结果。

4. 继续从文本中取出下一个词,重复上述步骤,直到文本全部分词完成。

三、逆向最大匹配法(Reverse Maximum Matching)逆向最大匹配法与正向最大匹配法相似,不同之处在于匹配方向。

逆向最大匹配法是从右到左按词典中最长的词开始匹配,直到无法继续匹配为止。

具体步骤如下:1. 从右到左取出文本中的一个词。

2. 从词典中找出以该词结尾的最长词。

3. 如果找到了最长词,则将该词作为分词结果;如果没有找到最长词,则将该词作为单字分词结果。

4. 继续从文本中取出下一个词,重复上述步骤,直到文本全部分词完成。

四、双向最大匹配法(Bidirectional Maximum Matching)双向最大匹配法是综合了正向最大匹配法和逆向最大匹配法的特点,将两种方法的结果进行比较,选择分词数量较少的一种作为最终结果。

具体步骤如下:1. 分别使用正向最大匹配法和逆向最大匹配法对文本进行分词。

2. 比较两种方法的分词结果,选择分词数量较少的一种作为最终结果。

五、基于规则的分词方法的优缺点1. 优点:a. 简单易实现:基于规则的分词方法不需要语料库训练,只需要构建好规则即可。

b. 分词速度快:由于基于规则的分词方法不需要进行复杂的计算,因此分词速度相对较快。

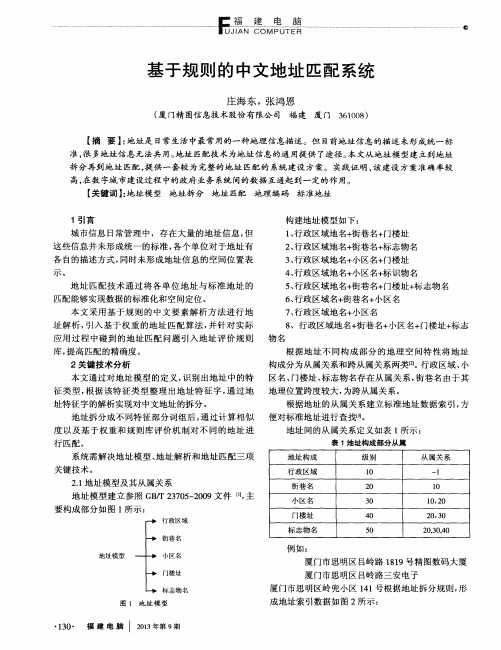

基于规则的中文地址匹配系统

对 现存 的标准 地 址 数据 进行 地 址解 析 , 根据 地 址

模 型 中 的地 址 从 属关 系 构 建地 址 索 引 数据 库 , 为后 续

的地 址 匹配 服务 提 供基 础数 据 。

为 验证 两个 地址 的匹配 程度 , 引入 地 址 不 同构 成 部分 的权 重 设置 ( 参 见表 3 ) 。

【 关键词 】 : 地址模型 地址拆分 地址 匹配 地理编码 标准地址

构 建地 址模 型 如下 : 1 、 行政 区域 地 名+ 街巷 名 + 门楼址 2 、 行政 区域 地 名+ 街巷 名 + 标 志物 名 3 、 行 政区域 地 名+ 小 区名 + 门楼址 4 、 行 政 区域 地 名+ 小 区名+ 标 识物 名 5 、 行 政 区域 地 名+ 街巷 名 + f - j 楼 址+ 标 志物 名 6 、 行 政 区域 名 + 街 巷 名+ 小 区名

在 线 支付 是一 种 通 过 第 三 方 提 供 的与 银 行 之 间 生 活 中 , 依 托 大数 据 技术 的成 熟运 用 将烟 草 的线 下销 的支 付接 口进 行 支付 的方 式 。由于 烟草 专卖 品 属于特 售 平 台化渐 成 ‘ 平 台经济 ’ ’ 趋 势 发展 的方 向。本 文 正是 殊商品, 需 要 在 线 支 付 的 安全 等级 相 对 较 高 , 因 此 本 利 用平 台经 济概 念 、 大 数据 技 术提 出 了烟 草流 通 平 台 平 台 门户 网站 选取 信誉 较 好 , 规 模 较 大 的第 三方 支 付 的架构 设想 与 实现 方法 , 未 来市 场前 景十 分 看好 。 平 台作 为合 作 方 , 包括 支 付 宝 、 财付 通 、 快 钱 。通 过 调

根 据地 址构 成 , 同时对大 量样 例数 据进 行分 析 , 增 加“ 方位 ” 构 成 部分 , 提 取 出不 同构 成 部 分对 应 的特殊 字( 参 见表 2 ) 。 地 址解析 过 程 中通 过 对特 征字 的解 析 ,

匹配汉字的正则

匹配汉字的正则匹配汉字的正则表达式是一种用于在文本中查找和匹配汉字的模式。

在中文文本处理和信息提取中,使用正则表达式可以方便地找到所需的汉字内容,实现各种文本处理任务。

首先,我们需要了解汉字的Unicode编码范围。

汉字的Unicode编码范围是从U+4E00到U+9FFF,这个范围包含了常用的汉字字符。

因此,我们可以使用正则表达式来匹配这个范围内的汉字。

在正则表达式中,我们可以使用Unicode编码的表示方式来匹配汉字。

例如,要匹配一个汉字,可以使用\u4E00来表示U+4E00这个Unicode编码。

如果要匹配多个汉字,可以使用\u4E00-\u9FFF来表示从U+4E00到U+9FFF的范围。

下面是一个示例的正则表达式,用于匹配一个或多个汉字:[\u4E00-\u9FFF]+这个正则表达式使用了方括号[]来表示一个字符集合,其中包含了从U+4E00到U+9FFF的范围。

加号+表示匹配前面的字符集合一次或多次。

使用这个正则表达式,我们可以方便地在文本中查找和匹配汉字。

例如,如果我们有一个字符串"我爱中文",我们可以使用这个正则表达式来匹配其中的汉字:import retext = "我爱中文"pattern = "[\u4E00-\u9FFF]+"result = re.findall(pattern, text)print(result)运行这段代码,我们会得到一个列表,其中包含了匹配到的汉字:"['我', '爱', '中文']"。

除了匹配汉字,我们还可以使用正则表达式来匹配其他汉字相关的内容,例如汉字的拼音。

在拼音的表示中,我们可以使用[a-zA-Z]来匹配英文字母,使用\u4E00-\u9FFF来匹配汉字。

例如,要匹配一个汉字和它的拼音,可以使用下面的正则表达式:([\u4E00-\u9FFF]+)\s+([a-zA-Z]+)这个正则表达式使用了圆括号()来表示一个分组,其中第一个分组用于匹配汉字,第二个分组用于匹配拼音。

分词规则设计

分词规则设计一、引言分词是自然语言处理中的重要任务之一,它将连续的文本序列切分成有意义的词语,对于后续的文本处理和分析具有重要意义。

本文将以分词规则设计为主题,探讨分词规则的设计原则和方法。

二、分词规则设计原则1. 最大匹配原则:优先选择最长匹配的词语作为切分结果,以尽可能保留词语的完整含义。

2. 正向最大匹配原则:从左到右进行匹配,尽可能选择最长的匹配结果。

3. 逆向最大匹配原则:从右到左进行匹配,尽可能选择最长的匹配结果。

4. 双向最大匹配原则:同时从左到右和从右到左进行匹配,选择匹配结果较少的一方作为最终切分结果。

三、分词规则设计方法1. 基于词典的分词规则设计:通过构建词典,将词语按照一定的规则进行切分。

可以根据词频、词性等信息进行切分结果的选择。

2. 基于统计的分词规则设计:通过统计大量的语料库数据,分析词语的共现关系和上下文信息,确定切分位置。

3. 基于规则的分词规则设计:根据语言的特点和语法规则,设计一系列切分规则,对文本进行切分。

四、分词规则设计实例1. 基于词典的分词规则设计实例:- 词典中包含单个词语,按照最大匹配原则进行切分。

- 词典中包含词语和词组,按照最大匹配原则进行切分,优先选择词语切分结果。

- 词典中包含同义词和近义词,根据上下文进行切分结果选择。

2. 基于统计的分词规则设计实例:- 利用统计方法确定词语的切分位置,如基于互信息和左右邻字频次进行切分。

- 利用隐马尔可夫模型进行分词,根据观测序列和状态转移概率确定切分结果。

3. 基于规则的分词规则设计实例:- 利用正则表达式进行分词,根据词语的特定模式进行切分。

- 利用语法规则进行分词,根据词性和句法结构进行切分。

五、分词规则设计的挑战和发展方向1. 歧义问题:同一个词语可能有多种不同的切分结果,如何选择最合适的切分结果是一个挑战。

2. 未登录词问题:对于未在词典中出现的词语,如何进行切分是一个难点。

3. 多语言分词问题:不同语言的分词规则存在差异,如何进行多语言的分词是一个发展方向。

基于规则的中文地址要素解析方法

划 、管理决 策 服 务… 。地 理 编 码 ( ecdn ) G oo ig ,将 地理 对象在 确 定 的参 考 系 中按 一定 的规 则 赋 予 唯

一

城市规 划 、公 安 、邮 政 、税 收 、电讯 和 公 共 卫 生

等领域 具有很 好的应 用前景 。

和可识别 的代码 ,建 立地 理 对象 与地 址 的映 射 ,

张雪英, 闾国年, 李伯秋,陈文君

( 南京师范大学虚拟地理环境教 育部重点实验 室,南京 2 04 ) 10 6

摘要 :在 日常生产与生活 中,地址是最常见的使用 自然语言描述地理位置 的参考系统之一。地址地理编码技术被

认 为是 大 量 业 务 数据 的 G S实 现 可视 化 定 位 和 空 间分 析 的桥 梁 ,在房 地 产 管 理 、土地 管 理 、城 市 规 划 、公 安 、邮 I 政 、税 收 、 电讯 和公 共 卫 生 等 领 域 中具 有 十 分 重 要 的应 用前 景 。地 址 要 素 解 析 是 中 文 地 址 编 码 的 核 心 技 术 之 一 。 它 是将 自然 语 言 描述 的地 址 拆 分 为 在某 一 限定 区域 内 ,可 以指 定 某 一 地理 范 围 的地 址 要 素 的过 程 。实 际 上 ,这 个 过 程 可 以被 看 作 是 一种 特 定 的 中文 分 词 任务 。 由于 语 言 和文 化 的原 因 ,中 文地 址 描 述 采 用 连续 的字 符 串 ,而 且 普

E mal z a g n wy 1 3 c m — i: h n s o @ 6 . o

l 0

地 球 信 息 科 学 学 报

21 0 0年

以及 地理 对象 与坐 标 系 统 的 映射 ,从 而将 地 理 位

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

二零一一年四月论文题目:基于规则的中文地址分词与匹配方法作者姓名:谭侃侃入学时间:2008年9月专业名称:地图学与研究方向:3S技术集成地理信息系统与应用指导教师:刘文宝职称:教授指导教师:牟乃夏职称:副教授论文提交日期:2011年4月论文答辩日期:2011年6月授予学位日期:Rule-based Chinese Address Segmentation and Matching MethodsA Dissertation submitted in fulfillment of the requirements of the degree ofMASTER OF SCIENCEfromShandong University of Science and Technologyb yTan KankanSupervisor:Professor Liu WenbaoSupervisor:Professor Mu NaixiaGeomatics CollegeApril2011声明本人呈交给山东科技大学的这篇硕士学位论文,除了所列参考文献和世所公认的文献外,全部是本人在导师指导下的研究成果。

该论文资料尚没有呈交于其它任何学术机关作鉴定。

硕士生签名:日期:AFFIRMATIONI declare that this dissertation,submitted in fulfillment of the requirements for the award of Master of Philosophy in Shandong University of Science and Technology,is wholly my own work unless referenced of acknowledge.The document has not been submitted for qualification at any other academic institute.Signature:Date:摘要在信息时代的今天,城市各部门都存有大量与地址有关的地理位置信息,这些数据大多是非空间信息,无法通过地理信息系统来实现行业之间的数据共享。

因此,城市地址信息空间化是数字城市建设的重要组成部分。

地理编码技术正是实现城市地址信息空间化的方法,它提供了一种将文本描述的地址信息转换为地理坐标的方式,通过编码技术和地址匹配来确定此地址数据在电子地图上对应的地理实体位置。

通过地理编码技术,大量的社会经济数据将变成坐标化的空间信息,从而进行更快速有效的空间分析,为政府决策提供支持。

论文以武汉市的地址研究为项目背景,进行中文地址分词与地址匹配研究。

利用地理编码技术实现地址的快速查询匹配和社会经济数据的空间化,建立数据库统一管理,从而实现城市各部门、行业数据的共享。

主要研究内容和取得的成果如下:(1)改进了现有的地址模型,并根据此地址模型将地址数据规范化,建设完备的标准地址数据库。

(2)在研究了几种地址分词及匹配方法的基础上,提出一种基于规则的地址分词匹配方法,加入了规则树和歧义存储等机制,通过算法改进,提高了地址残缺和歧义这两类模糊地址的匹配成功率。

(3)建立了知识学习机制,通过地址补录模块,将匹配失败和数据库中缺少的地址补录入库,从而不断完善标准地址数据库。

关键词:地理编码,地址标准化,中文地址分词,地址数据库,规则库,地址匹配ABSTRACTIn the information age of today,there are a large number of address information in the city departments.Most of the datas are non-spatial information,we can not share them by Geographic information system.So it’s a main part of digital city build ing to informationize the city address information.Geocoding is a method to informationize the city address information,which provides a way of translating the text address to geographic coordinates.By geocoding technology,a large number of socio-economic data will become spatial information in the form of coordinates,data sharing can be achieved between the city departments and the industry,so there will be a more rapid and effective spatial analysis and decision-making.The paper takes the research of the WuHan addresses as the project background,using the address Geocoding technology to achieve address rapid query and socio-economic data spatialization,and build address database.Then we can share information in the city departments.The main contents of the research are:(1)Improving the existing address model,then we made address standardization by the new model,and build the standard address database.(2)Research some address segmentation and geocoding methods,and propose a rule-based Chinese address geoeoding method.We add rule tree and ambiguity storage mechanism to improve the success rate of fuzzy address matching.(3)The paper creates a learning system,so we can add database with fail-matching address by address adding module.Keywords:Geocoding,Address standardization,Chinese address segmentation, Address database,Rule database,Address matching目录1绪论 (1)1.1研究背景及意义 (1)1.2国内外研究现状 (2)1.3研究内容 (7)1.4论文的组织结构 (8)1.5本章小结 (8)地址编码与中文地址分词的关键技术 (9)2地址编码与中文地址分词的关键技术2.1地址标准化 (10)2.2中文地址分词 (15)2.3地址数据库匹配 (19)2.4本章小结 (21)3基于规则的中文地址分词与匹配基于规则的中文地址分词与匹配 (22)3.1地址模型研究 (22)3.2标准地址库的创建 (23)3.3规则库与规则树 (24)3.4模糊地址分析处理 (25)3.5基于规则的模糊中文地址分词与匹配算法 (26)3.6论文算法的改进 (29)3.7本章小结 (30)地址编码系统的设计 (31)4地址编码系统的设计4.1系统开发工具与实验平台 (31)4.2系统设计方案 (33)4.3本章小结 (36)地址编码系统的实现 (36)5地址编码系统的实现5.1系统主控模块 (36)5.2标准地址库创建 (38)5.3标准地址库管理 (39)5.4批量地址匹配 (40)5.5标准地址库补录 (42)5.6实验结果分析 (43)5.7本章小结 (45)总结与展望 (46)6总结与展望6.1总结 (46)6.2展望 (46)致谢 (47)致谢参考文献 (48)参考文献攻读硕士学位期间主要学术成果 (51)攻读硕士学位期间主要学术成果Contents1Introduction (1)1.1Background of the Research (1)1.2Current Research Home and Abroad (2)1.3The Contents of the Research (7)1.4Paper Structure (8)1.5Chapter Summary (8)2The key technology of Geocoding (9)2.1Address Standardization (10)2.2Chinese Address Segmentation (15)2.3Matching in Database (19)2.4Chapter Summary (21)3Rule-based Chinese Address Segmentation and Matching (22)3.1Address Model Research (22)3.2Building the Standard Address Database (23)3.3The Rule-base and Rule-tree (24)3.4Fuzzy Address Analysis (25)3.5Rule-based Chinese Address Segmentation and Matching Arithmetic (26)3.6Advantage of the Arithmetic (30)3.7Chapter Summary (30)4Design of the Geocoding System (32)4.1Development Tools and Platform of the System (32)4.2System Design (33)4.3Chapter Summary (36)5Implementation of the Geocoding System (36)5.1Main module of the system (36)5.2Building standard address database (37)5.3Standard address database management (38)5.4Batch address Matching (39)5.5Standard address database additional (42)5.6Results Analysis (43)5.7Chapter Summary (45)6Conclusions and Prospects (46)6.1Conclusions (46)6.2Prospects (46)Acknowledgements (47)Main Reference Document (48)Main Work Achievement of the Author during the Master (52)1绪论1.1研究背景及意义随着地理信息系统(GIS)的不断发展和其在各行业的广泛应用,人们对信息共享的要求也越来越迫切。