AI Fabric智能无损数据中心网络解决方案

数据中心的综合布线解决方案

数据中心的综合布线解决方案数据中心的综合布线解决方案可以帮助组织实现高效、可靠和安全的数据传输,以支持其日常运营和业务需求。

这个解决方案不仅考虑了数据中心的物理布线,还包括了网络设备、机柜和机房环境等因素,以提供综合的解决方案。

在设计和实施数据中心的综合布线解决方案时,需要考虑以下几个方面:1.布线规划与设计:在布线规划与设计阶段,需要先了解数据中心的结构、大小和需求,以确定布线的类型和长度。

在布线设计中,传统的铜缆和光纤都可以考虑,具体选择可以根据带宽需求、可靠性和成本等因素进行决策。

2.网络设备选择:网络设备是数据中心综合布线解决方案中的重要组成部分。

选择高性能、可靠且兼容性强的网络设备可以确保数据传输的高效和稳定性。

考虑到数据中心的规模和需求,可以选择交换机、路由器和防火墙等设备。

3.机柜和机房环境:机柜和机房环境的设计对于数据中心的性能和可靠性也非常重要。

机柜的选用要考虑到布线的便利性和空间利用率,同时还要注意散热和防尘等因素。

机房的温度,湿度和通风情况等也需要进行仔细的规划和监控。

4.管理与维护:数据中心的综合布线解决方案不仅包括设计和实施,还需要进行有效的管理和维护。

这包括对布线和网络设备进行定期的检查和维护,以确保其正常运行。

此外,对于数据中心的不同区域和设备,还需要进行标识和记录,以方便日常管理。

5.安全性和可扩展性:数据中心是组织存储和处理重要数据的关键场所,因此安全性是综合布线解决方案中必须考虑的因素。

在设计数据中心时,需要考虑到数据安全、物理安全和网络安全等方面。

此外,还需要确保布线的可扩展性,以适应未来的业务增长和技术变化。

综上所述,数据中心的综合布线解决方案是一个综合的系统工程,需要从多个角度进行考虑和规划。

只有在合理的布线规划和设计、高性能和可靠的网络设备、优化的机柜和机房环境以及有效的管理和维护措施的支持下,才能实现数据中心的高效运行和业务需求的满足。

IDC智能机房整体解决方案

IDC智能机房整体解决方案随着科技的飞速发展,数据中心的运维和管理已经进入了智能化时代。

IDC智能机房整体解决方案,以其高效、安全、绿色的特点,日益受到业界的和重视。

一、IDC智能机房的必要性传统的IDC机房管理主要依赖人工,这种方式在信息化时代已经显得力不从心。

数据量的快速增长使得人工管理变得低效且易错;数据中心的高能耗、高成本、高风险等问题也需要更加智能、绿色的解决方案。

因此,IDC智能机房的出现,成为了一种必然的选择。

二、IDC智能机房的整体解决方案1、智能化监控管理IDC智能机房通过安装智能监控系统,可以实时监控机房的各项指标,如温度、湿度、空气质量、电力供应等,确保机房的运行环境始终保持在最佳状态。

同时,智能监控系统还可以对服务器、网络设备等关键设备进行实时监测,提前发现并解决潜在的问题,减少设备故障率。

2、自动化运维通过自动化运维,IDC智能机房可以大大提高设备的运行效率。

自动化运维系统可以根据预设规则,自动进行设备的开关机、重启、软件更新等操作,减少人工干预的错误,提高设备运行的安全性和稳定性。

3、绿色节能IDC智能机房采用高效UPS、节能空调等设备,以及智能电源管理系统,可以大大降低数据中心的能耗。

同时,智能机房还会采用一系列的绿色节能策略,如动态功率管理、智能冷却等,进一步提高数据中心的能源利用效率。

4、安全防护IDC智能机房的安全防护包括物理安全和网络安全两部分。

物理安全方面,智能机房采用人脸识别、指纹识别等技术手段进行进出管理,确保机房的安全。

网络安全方面,智能机房会建立完善的安全防护体系,包括防火墙、入侵检测系统、数据加密等,确保数据的安全性和完整性。

三、总结IDC智能机房是数据中心发展的必然趋势。

通过智能化监控管理、自动化运维、绿色节能和安全防护等方面的整体解决方案,IDC智能机房可以大大提高数据中心的运行效率和管理水平,降低能耗和成本,提高服务质量和客户满意度。

IDC智能机房还可以为企业的数字化转型提供强大的支持,推动信息产业的持续发展。

iMaster NCE-Fabric数据中心网解决方案及应用

20%

运维精力

网络工程师用于检查和验证网络时间占比70% 因路由变更消耗的时间占比约30% 消耗20%运维精力校验网络连通性、路由配置及变更

典型举例1:【路由配置故障】新配置1条路由,导致原有路由被激活,形成路由环路

设备已有静态路由如下,到达10.200.0.0/21有2条静态路由, 其中,10.17.43.21不可达 ip route-static 10.200.0.0 255.255.248.0 10.17.43.21 ip route-static 10.200.0.0 255.255.248.0 10.17.43.28 现配置1条静态路由如下: ip route-static 10.17.0.0 255.255.0.0 10.17.43.33 新配置的路由使用10.17.43.21可达,下一跳为10.17.43.33,导致形成路由环路

提供数据中心网络全生命生期极简自动化体验 北向抽象网络资源和服务,南向适配不同设备和网络实现

网络E2E自动部署,部署“零”等待

极速网络发放:图形化拖拽式操作,极简业务逻辑,部署效率 是业界3倍

极速容器上线:容器上线10K/min,业界领先性能 多云互联:MDC统一编排,多DC互通自动化

变更风险预评估,配置“零”差错

华为iMaster NCE全新启航(运营商版)

数据中心 NCE-Fabric *

NEW

企业园区 NCE-Campus *

SD-WAN NCE-WAN *

家庭宽带

NCE-FAN

广域传输

NCE-T

广域IP

NCE-IP

跨域

NCE-Super

iMaster NCE-Fabric提供数据中心网络全生命周期管控的极简体验

数据中心解决方案(5篇)

数据中心解决方案(5篇)数据中心解决方案(5篇)数据中心解决方案范文第1篇20世纪60年月,大型机时期开头消失数据中心的雏形,1996年IDC(互联网数据中心)的概念正式提出并开头实施这一系统,主要为企业用户供应机房设施和带宽服务。

随着互联网的爆炸性进展,数据中心已经得到了蓬勃进展,并成为各种机构和企业网络的核心。

一般来说,数据中心是为单个或多个企业的数据处理、存储、通信设施供应存放空间的一个或联网的一组区域。

通常有两大类型的数据中心:企业型和主机托管型的数据中心。

数据中心的目的是为各种数据设施供应满意供电、空气调整、通信、冗余与平安需求的存放环境。

数据中心中的设施包括各种安装在机架或机柜中的有源设备及连接它们的结构化布线系统。

最近,美国康普SYSTIMAX Solution托付AMI Partners进行的一项讨论表明:到2021年,亚太地区的综合布线市场将达到15.3亿美元,2021年至2021年之间,复合年增长率将达到11%,而数据中心综合布线业务将占据全部剩余的市场份额。

同时,依据AMI的讨论,2021年亚太地区只有13.8%的综合布线业务来自数据中心市场。

而到2021年,数据中心将占该地区综合布线业务市场32%的份额。

在数据中心综合布线市场中,估计中国的复合年增长率将达到37.5%,而其整体综合布线市场的复合年增长率将达到13.6%。

这对综合布线系统这样的基础设施来说,即是契机又是挑战。

那些能够真正供应高性能的端到端解决方案的供应商将给数据中心应用带来新的展望。

让我们来看一下大家熟识的“Google”的流量:每月3.8亿个用户每月30亿次的搜寻查询全球50多万台服务器服务器到本地交换机之间传输100Mbit/s,交换机之间传输千兆面对这样的巨大流量,物理层基础设施必需具有足够的耐用性及全面的适用性,以应对24/7小时的可用性及监测工作、“99.999%”的牢靠性、备份使用、平安、防火、环境掌握、快速配置、重新部署,以及业务连续性的管理。

AI-Fabric智能无损数据中心网络解决方案

归一为TCP/IP CSMA/CD

TCP/IPFCoE

TCP/IPFCoE RoCE

传统以太网(标准)2008之前10M/100M/1000M

融合增强以太网(CEE)2008~20181GE/10GE/40GE

新一代以太网?2018之后25GE/100GE/400GE

问题1:拥塞引起动态时延急剧升高问 题2:限制发送速度使得吞吐量极低

S零丢包 低时延 高吞吐

云盘服务vDsik vDsik

AI Fabric Spine 21万IOP

分布式云存储集群(12台SSD服务器)

AI Fabric加速分布式云存储,IOPS提升25.3%

IOPS性能决定商业收益和成本

$0.065

每IOPS/月按实际使用时间折算

公有云:IOPS按需收费 私有云:更低成本获得同等IOPS

HDSSD SCM介质访问时延降低100倍

存储型服务器

存储创新

计算创新

CPUGPU AI Chip 计算速度x100倍 计算型服务器

GPU通信等待时间超任务总时长50%

通信时延占总存储访问时延50%以上

AI业务发展对技术带来挑战,通信成为新的瓶颈

AI时代,网络成为AI性能提升的主要瓶颈

存储

计算

无人驾驶

人脸识别

数据挖掘

生命科学

人工智能

FabricInsight

Switch Chip

CE8850-64CQ-EICE6865-48S8CQ-EI

CE8861-4C-EI

CPU core

NP core

FPGA

FPGA

AI Fabric为DC构建统一融合网络,总拥有成本比降低53%

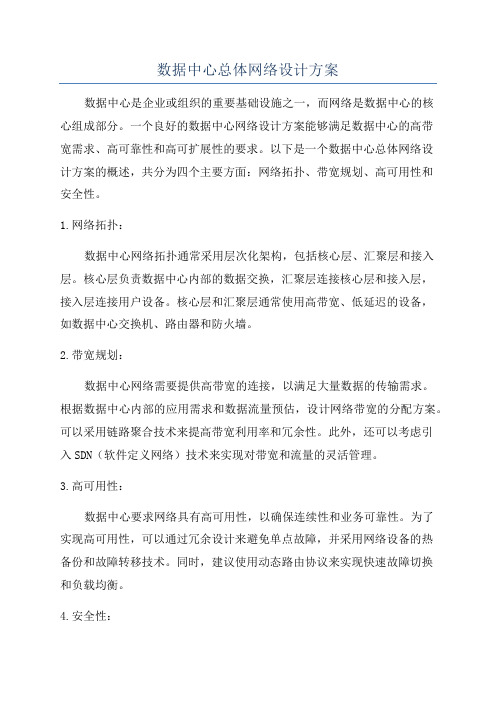

数据中心总体网络设计方案

数据中心总体网络设计方案数据中心是企业或组织的重要基础设施之一,而网络是数据中心的核心组成部分。

一个良好的数据中心网络设计方案能够满足数据中心的高带宽需求、高可靠性和高可扩展性的要求。

以下是一个数据中心总体网络设计方案的概述,共分为四个主要方面:网络拓扑、带宽规划、高可用性和安全性。

1.网络拓扑:数据中心网络拓扑通常采用层次化架构,包括核心层、汇聚层和接入层。

核心层负责数据中心内部的数据交换,汇聚层连接核心层和接入层,接入层连接用户设备。

核心层和汇聚层通常使用高带宽、低延迟的设备,如数据中心交换机、路由器和防火墙。

2.带宽规划:数据中心网络需要提供高带宽的连接,以满足大量数据的传输需求。

根据数据中心内部的应用需求和数据流量预估,设计网络带宽的分配方案。

可以采用链路聚合技术来提高带宽利用率和冗余性。

此外,还可以考虑引入SDN(软件定义网络)技术来实现对带宽和流量的灵活管理。

3.高可用性:数据中心要求网络具有高可用性,以确保连续性和业务可靠性。

为了实现高可用性,可以通过冗余设计来避免单点故障,并采用网络设备的热备份和故障转移技术。

同时,建议使用动态路由协议来实现快速故障切换和负载均衡。

4.安全性:数据中心的网络安全至关重要,应采取多种措施来保护数据的机密性和完整性。

可以使用入侵检测和防火墙等安全设备来监控和过滤网络流量。

同时,还可以采用虚拟专用网络(VPN)和访问控制策略来限制服务器和用户之间的访问。

此外,还可以考虑引入网络流量监视和分析工具,用于实时监测网络性能和故障诊断。

另外,在设计数据中心网络时,应考虑未来的扩展需求,并留有余地进行新设备添加和网络带宽扩展。

最后,为了保证网络的稳定性和高效性,应定期进行网络性能测试和优化。

总体而言,一个合理的数据中心总体网络设计方案应该基于业务需求和技术趋势,并综合考虑网络拓扑、带宽规划、高可用性和安全性等方面的需求。

华为Cloud Fabric云数据中心网络解决方案

华为Cloud Fabric云数据中心网络解决方案华为Cloud Fabric网络解决方案2012年5月的美国Interop国际通信展上,华为公司震撼推出面向下一代数据中心的云级交换机CloudEngine系列。

包括全球最高配置的旗舰级核心交换机CloudEngine 12800系列,以及高性能的盒式交换机CloudEngine 6800 /5800(10GE/GE接入)系列。

同时,基于CloudEngine(以下简称CE)系列交换机和齐全的传输、路由、安全及网管产品,华为公司全球发布面向下一代云计算数据中心的Cloud Fabric解决方案,旨在为客户打造未来十年的稳定网络架构。

华为Cloud Fabric网络方案优势Cloud Fabric解决方案帮助企业用户和运营商构建高达360T的无阻塞交换平台,可提供高达数万个10GE/GE服务器的接入能力,具备Scalable Fabric、Virtualized Fabric和Converged Fabric三大核心优势。

弹性云网络(Scalable Fabric)承载未来十年的弹性网络:CloudEngine系列交换机可提供高达360T的无阻塞交换网络,满足从GE/10GE到40GE/100GE的4代服务器演进需求,网络架构长期稳定,轻松迎接10GE服务器潮流的到来。

全球最高配置核心交换机:CE12800单槽位支持2Tbps带宽(单向),整机最大支持48Tbps 的交换能力;同时支持8*100GE,24*40GE/96*10GE等超高性能板卡,整机最大可支持96个100GE、288个40GE或1152个10GE全线速接口,成为当之无愧的核心交换机工业标杆。

全系列TOR支持40GE:CE6800和CE5800提供超高密度的10GE和GE服务器接入能力,全系列支持40GE上行接口,转发性能业界领先。

无阻塞CLOS交换架构:CE12800核心交换机采用无阻塞CLOS交换架构,配合动态的分。

超融合数据中心网络解决方案

超融合数据中心网络解决方案介绍了数据中心网络对于算力的意义,归纳出影响数据中心全以太化演进的因素,以及超融合数据中心网络架构的典型特征与价值。

结合业界在超融合数据中心网络技术中的实践与探索,对超融合数据中心网络架构的未来发展进行了展望。

数据中心内数据处理包括数据的存储、计算和应用三个环节,分别对应三大资源区:数据存储区:存储服务器内置不同的存储介质,如机械硬盘、闪存盘(SSD)、蓝光等,对于数据进行存储、读写与备份,存储节点间通过存储网络互联。

高性能计算区:服务器较少虚拟化,配置CPU、GPU 等计算单元进行高性能计算或 AI 训练,服务器节点间通过高性能计算网络互联。

通用计算区:服务器大量使用 VM或容器等虚拟化技术,通过通用计算网络(又称为应用网络、业务网络、前端网络),与外部用户终端对接提供服务。

在这个持续循环的过程中,网络就像联接计算和存储资源的中枢神经,贯穿数据处理的全生命周期。

数据中心算力水平不仅取决于计算服务器和存储服务器的性能,很大程度上也受到网络性能的影响。

如果网络算力水平无法满足要求,则会引发“木桶效应”拉低整个数据中心的实际算力水平。

数据中心算力是数据中心的服务器通过对数据进行处理后实现结果输出的一种能力。

在服务器主板上,数据传输的顺序依次为 CPU、内存、硬盘和网卡,若针对图形则需要 GPU。

所以,从广义上讲,数据中心算力是一个包含计算、存储、传输(网络)等多个内涵的综合概念,是衡量数据中心计算能力的一个综合指标。

提升网络性能可显著改进数据中心算力能效比定义数据中心算效(CE,Computational Efficiency)为数据中心算力与所有 IT 设备功耗的比值,即“数据中心 IT 设备每瓦功耗所产生的算力”(单位:FLOPS/W):在服务器规模不变的情况下,提升网络能力可显著改善数据中心单位能耗下的算力水平。

ODCC2019 年针对基于以太的网算一体交换机的测试数据表明,在 HPC场景同等服务器规模下,相对于传统 RoCE(基于融合以太的远程内存直接访问协议)网络,网算一体技术可大幅度降低HPC 的任务完成时间,平均降幅超过 20%。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

AI分布式训练带来的挑战

如:机器翻译训练,105ExaFlops 采用传统架构, 一次训练需半年

存储创新

HDSSD SCM 介质访问时延降低100倍

计算创新

CPUGPU AI Chip 计算速度x100倍

存储型服务器

计算型服务器

节点间通信瓶颈凸显

通信时延占总存储访问时延50%以上

GPU通信等待时间超任务总时长50%

框式交换机

业界首款面向AI时代的数ቤተ መጻሕፍቲ ባይዱ中心交换机

内嵌AI芯片;高密48*400GE;使能自动驾驶网络 CE9860-4C-EI 128*100G高密 CE8861-4C-EI 10G/25/40G/100G灵活插卡

盒式交换机

CloudEngine 16800

CE8850-64CQ-EI 64*100G高密 TOR交换机

AI Fabric

低成本

Ethernet

低成本 无丢包

NIC HBA HCA

NIC HBA HCA

低时延

10G Eth IPC Infiniba nd 低时延 SAN FC 无丢包 8G FC Infiniband ( 56G ) 100G Eth

FabricInsight

硬件架构

CPU core NP core

Spine

…

CPU

Switch Chip FPGA

leaf

CE8861-4C-EI

FPGA

智能网卡

CE8850-64CQ-EI CE6865-48S8CQ-EI

AI Fabric为DC构建统一融合网络,总拥有成本比降低53%

LAN/SAN/IPC独立三张网

HDSSD SCM 介质访问时延降低100倍

人工智能

AI分布式计算

CPUGPU AI Chip

计算速度x100倍

AI业务发展对技术带来挑战,通信成为新的瓶颈

分布式存储&RDMA带来的挑战

如:XX ESSD云盘,提出了百万IOPS的目 标,以满足大型OLTP存储数据库诉求;传 统分布式存储只有2万,招行Azurepack分 布式存储30万 IOPS

华为AI Fabric,开创AI极速未来

AI Fabric智能无损数据中心网络解决方案

企业DC走过虚拟化时代、云时代,正在迈入AI时代

资源池化共享 提升利用率 虚拟化时代 实现云化服务 优化 发放效率 云时代 挖掘数据价值 释放数据的潜能 AI时代

互联网+

中石油大二层架构

服务器利用率 20%60%

RDMA快启动+多打一:拥塞为常态

问题1:拥塞引起动态时延急剧升高问 题2:限制发送速度使得吞吐量极低

限制发送速度来保证不丢包

业界首个面向AI时代的AI Fabric,专网的性能、以太的价格

HPC高性能计算 分布式存储 AI计算

AI Fabric智能无损数据中心网络

Spine

…

向业务A的源端发送反压信号 业务A所属虚拟队列拥塞告警 ▼

业务驱动

协议变化

以太网诞生于LAN 诉求:低成本

归一为TCP/IP CSMA/CD

TCP/IPFCoE

TCP/IPFCoE RoCE

关键技术

载波侦听多路访问/冲突检测 • 拥塞导致动态时延急剧升高 • 经常发生丢包

PFC(优先级流量控制) ETS( 传 输 选 择 ) ECN(拥塞控制)

流量模型变化

Waterline

与传统以太网相比,性能提升显著:

AI训练场景:

分布式存储场景:

40% 训练效率

25% IOPS

Leaf 1

Leaf 2

Leaf 3

与Infiniband专网性能相当,成本大幅降低:

智能网卡

53% TCO

华为独有iLosslessTM智能无损算法

AI Fabric智能无损数据中心网络解决方案主打产品

Fast Data

数据实时处理 存取要求快

2015

数据

单位容量价值越来极低 基于AI挖掘是关键

2025年新增的数据量(180ZB)将远超人 类处理能力,95%的数据将依赖AI处理 提供载体 提供算法

平台

16%

2015 2025 企业对AI的采用率

Source: Huawei GIV

高速存储 Fast数据分布式存储

现有以太网技术不能满足AI诉求,呼吁新的技术创新

传统以太网(标准)

2008之前

融合增强以太网(CEE)

2008~2018

新一代以太网?

2018之后

10M/100M/1000M

1GE/10GE/40GE

以太网扩展至SAN 诉求:无丢包

25GE/100GE/400GE

以太网正在向AI/HPC扩展 诉求:高吞吐,低时延,无丢包

AI时代,网络成为AI性能提升的主要瓶颈

计算

存储

网络

传统以太网:性能低下 拥塞100%丢包,ms级E2E时延

专用网络:TCO居高不下 专人运维,2x CAPEX

CPUGPUAI chip 计算速度 x100倍

HDDSSD SCM 存储速度x100倍

通信时延400ms 导致空闲等待

AI时代,RoCE正在成为主流

CE6865-48S8CQ-EI 25GE TOR交换机

新一代AI Fabric:高吞吐,低时延,零丢包

人脸识别 无人驾驶 生命科学 数据挖掘

虚拟多队列:精准定位拥塞流反压,正常流不受影响

人工智能

动态水线:水线动态设置,保证不丢包情况下最高吞吐 主动控制:主动与网卡协同,最大配额调度,彻底避免拥塞

网络成本高:FC专网和IB专网价格昂贵 运维代价高:FC的SAN和IB的IPC需要专人运维,且无法云网协同

AS-IS

AI Fabric融合网络

降低网络成本:开放以太网同时承载SAN和IPC流量,CAPEX降低50% 降低运维成本:无需专人运维,支持SDN云网自动化,OPEX降低60%

TO-BE

LAN Eth

大数据

建行新一代系统

1千10万笔/秒 分钟级弹性伸缩

AI营销

微信:游戏下载提升38% 金融:获客率提升40倍

2010

2015

2020

AI时代从数据中获得智慧,实现商业价值变现

业务

+20

倍

机器人

人脸识别

无人驾驶

客户画像

罪犯追踪

精准营销

8.6 ZB

全年产生并存储的数据量

Big Data

2025

Source: Huawei GIV

RDMA over Infiniband(IB)

• 私有技术,运维复杂,需要专门 运维团队

Vs.

RDMA over Ethernet( RoCE )

• 公开技术,运维简单,统一运维 团队 • • 开放系统,云业务成熟 建网成本低

•

•

封闭系统,无法提供云业务

建网成本高

互联网企业转向开放以太网承载RDMA