特征描述算子评测

特征检测和特征描述符综述_概述及解释说明

特征检测和特征描述符综述概述及解释说明1. 引言1.1 概述特征检测和特征描述符是计算机视觉领域中非常重要的技术。

它们在图像识别、物体跟踪、三维重建等应用中起着关键性的作用。

特征检测是指从图像或视频中找到显著的局部结构,如角点、边缘等。

而特征描述符则是将这些特征点转化为数值描述,以便于后续的匹配和识别。

1.2 文章结构本文将对特征检测和特征描述符进行全面综述,主要包括以下几个方面内容:引言、特征检测、特征描述符以及它们之间的关系。

具体来说,我们将首先介绍引言部分,然后详细讨论特征检测和特征描述符的定义、作用以及常见方法。

接着,我们会探讨它们在计算机视觉领域中的应用,并深入研究它们之间的相互依赖关系。

最后,我们将总结文章内容,并展望未来发展趋势。

1.3 目的本文旨在全面了解和掌握特征检测和特征描述符这两个重要技术的概念、原理和应用。

通过对现有算法和方法的综述,我们希望读者能够深入理解特征检测和特征描述符之间的关系,并能够根据具体应用选择合适的方法。

同时,我们也希望通过分析现有技术问题和未来发展方向,为进一步研究提供参考和启示。

2. 特征检测:特征检测是计算机视觉领域的一个重要研究方向,它主要通过分析图像或视频中的局部区域来找到具有显著性或独特性的图像特征。

这些特征通常是物体边缘、角点、斑点等在不同图像之间有稳定性和可区分性的区域。

2.1 特征检测的定义与作用:特征检测旨在识别出具有唯一性和可描述性的局部结构,并对其进行定量描述。

其定义包括两个关键概念:唯一性和可描述性。

唯一性是指每个特征点都应该具有其他任何点所没有的某种属性,使其能够在各个图像帧或场景中被准确地匹配。

可描述性则要求我们能对每个特征进行准确而有效地量化描述,以便于后续的处理和识别任务。

特征检测在计算机视觉中起着至关重要的作用。

首先,它可以用于实现目标识别、跟踪和姿态估计等高级视觉任务。

其次,对于基于内容的图像搜索、相册管理和三维重建等应用,特征检测也是不可或缺的。

特征点检测与特征描述子

特征点检测与特征描述子SIFT特征:SIFT特征(Scale invariant feature transform)是一种局部特征检测的方法。

算法可以搜索出图像中的特征点,并且对特征点计算出一个128维的特征描述子以进行图像特征点匹配。

他具有尺度不变性,旋转不变性等优良性质,并且在一定程度上不受光照的影响。

原理介绍:在介绍SIFT之前,先引入LoG (Laplacian of Gaussian)算子的概念。

LoG算子实际就是在高斯滤波的基础上再求一个二阶导(拉普拉斯算子)。

图像经过与LoG的卷积,得到的新矩阵,我们通过寻找过0点就可以得到边缘角点等像素点。

并且使用归一化的LoG算子可以得到尺度不变性(无论图像的尺度大小,其极值点永远存在)。

之前曾经有人证明过,如果想要算子能够产生稳定的图像特征,可以使用尺度归一化的LoG算子。

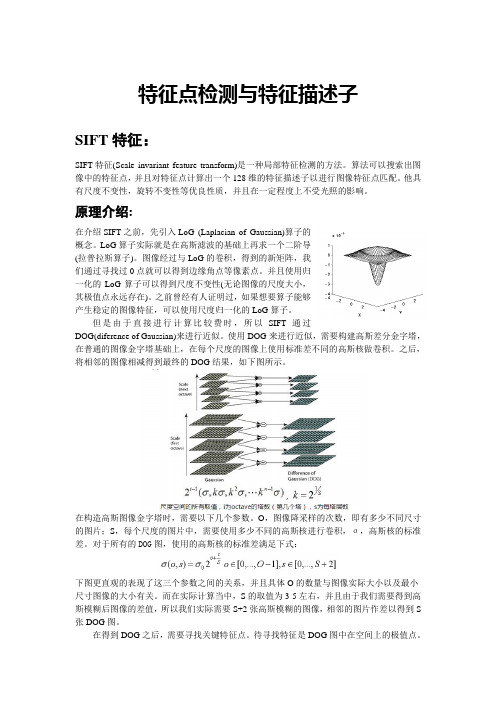

但是由于直接进行计算比较费时,所以SIFT通过DOG(diference of Gaussian)来进行近似。

使用DOG来进行近似,需要构建高斯差分金字塔,在普通的图像金字塔基础上,在每个尺度的图像上使用标准差不同的高斯核做卷积。

之后,将相邻的图像相减得到最终的DOG结果,如下图所示。

在构造高斯图像金字塔时,需要以下几个参数。

O,图像降采样的次数,即有多少不同尺寸的图片;S,每个尺度的图片中,需要使用多少不同的高斯核进行卷积,σ,高斯核的标准差。

对于所有的DOG图,使用的高斯核的标准差满足下式:下图更直观的表现了这三个参数之间的关系,并且具体O的数量与图像实际大小以及最小尺寸图像的大小有关。

而在实际计算当中,S的取值为3-5左右,并且由于我们需要得到高斯模糊后图像的差值,所以我们实际需要S+2张高斯模糊的图像,相邻的图片作差以得到S 张DOG图。

在得到DOG之后,需要寻找关键特征点。

待寻找特征是DOG图中在空间上的极值点。

这样对于每个像素,在他周围有8个像素点,并且和他同图片大小但是高斯核标准差不同的两个相邻的图片间,他们在空间上也有相邻关系。

算子理论中的谱理论及其算子刻画

算子理论中的谱理论及其算子刻画算子理论是数学中一个重要的研究领域,它主要研究线性算子的性质和特征。

其中,谱理论是算子理论的一个重要分支,用于描述算子的特征值分布和性质。

本文将介绍算子理论中的谱理论,并探讨谱理论在算子刻画中的应用。

一、谱理论概述在算子理论中,谱是指算子的特征值的集合。

而谱理论则是研究算子谱的分布和性质的数学理论。

根据算子的不同性质,谱可以分为点谱、连续谱和剩余谱三类。

点谱由算子的特征值组成,连续谱则是特征值形成的连续集合,而剩余谱则是特征值无法分类到点谱或连续谱中的特征值。

谱理论的核心工具是谱分解,它将算子分解为谱测度和谱分布的形式。

谱测度描述了算子特征值的分布情况,而谱分布则给出了算子在不同点上的特征值大小。

通过对算子的谱进行分析,可以得到算子的重要特征信息,并通过谱理论的应用来解决实际问题。

二、算子刻画中的谱理论应用谱理论在算子刻画中有着广泛的应用。

以下是几个常见的应用领域:1. 量子力学中的谱理论量子力学是谱理论的一个重要应用领域。

在量子力学中,算子被用来描述物理系统的性质,而谱理论则提供了分析量子系统特征值和特征向量的数学工具。

通过谱理论的应用,可以研究量子系统的能量级数、能量分布和态的演化等关键问题。

2. 偏微分方程中的谱理论在偏微分方程中,算子通常用来描述方程中的微分操作。

谱理论的应用可以帮助我们研究偏微分方程的解的性质和行为。

通过谱理论的分析,可以推导出方程的稳定性、收敛性以及解的存在性等关键特征,为解决实际问题提供了有力的工具。

3. 图论中的谱理论图论是研究图结构和网络的数学分支,而谱理论在图论中有着重要的应用。

通过对图的邻接矩阵进行谱分析,可以得到图的谱结构和特征信息,进而研究网络的连通性、社区结构、聚类等关键问题。

谱理论在图论中的应用不仅有理论意义,还有重要的实际应用价值,如社交网络分析和图像分割等领域。

4. 控制理论中的谱理论在控制理论中,算子通常用来描述控制系统的性质和行为。

具有高斯噪声不变性的特征描述算子

鲁棒性。通过人脸图片识别实验表明特征描述算子具有比L P L Q等著名的特征描述算子具有更好的性能。 B 、P 关键词 : 小波 ; 二进 量化特征; 方图特征 ; 直 人脸识别

D I1. 7/in10.31 01 1 0 文章编号 :02 3 12 1)1 040 文献标识码 : 中图分类号 :P 1 O : 3 8 .s. 283. 1- . 2 0 7 js 0 2 30 10. 3 (0 13- 0.3 8 0 A T 31

通过对图像进行二进小波变换得到图像4个尺度的横向和纵向滤波系数在每个像素点排列这些系数然后量化为一个8维的空间并通过二进制编码变成一个整数

4

C m ue n ier ga d p l ain  ̄ 算机工程与应用 o p t E gn ei n A pi t s' r n c o ] "

具有高斯 噪声不 变性 的特 征描 述算子

GAO Zh s e g, E ih n XI Ch z i un h . u sa n ie n e st e ma e e t r d s rp o . m p t r Ga s i n o s i s n i v i g f a u e e c i t r i Co u e En i e rng n App i a g n e i a d l - c

T e fu clsh r o t i -as cmp n ns ad vrclhg -as cmp nnso g e e t ce y d ai w v - h o sa oi na hg p s o o et n et a i ps o o et fi e a xr td b y dc a e r e z l h i h ma r a -

lt r so m. e e o e t n a f r T s c mp n n s r e ra g d t a h p x l i i g , d t e n f r l q a t e i eg td me so a h o e t a a r n e a e c i e n ma e a n u io n h m y u ni d n a z n ih - i n i n l s a , e r s n e a a it g r u i g i ay o i g At a t a i o r m s q e c i o u e b c n a e ae h so r m p ce r p e e td s n n e e sn b n r c dn . ls , h s g a t eun e s c mp t d y o c tn t d it g a r m a h r g o i h s t e c it r o e i g . e o l s g t e i h fe u n y c e ce t , e e c p o s m o e fo e c e i n wh c i he d s rp o f t ma eDu n y u i h h g — q e c o f in s t d s r t r i h n r i h i r r b s o o u t t Ga s i n ieE p r n n a e ma e e o n t n h ws t a h meh d h s a ta t e f a u e t a L n u sa n o s . x e me t o f c i g r c g i o s o t t e i i h to a t ci e trs hn r v BP a d

几种特征点提取算子的分析和比较

几种特征点提取算子的分析和比较特征点提取是计算机视觉中的一个重要任务,用于定位和描述图像中的重要局部特征,如角点、边缘、斑点等。

通过提取图像的特征点,可以实现目标识别、图像配准、图像检索等任务。

常用的特征点提取算子包括Harris角点检测算子、SIFT(尺度不变特征变换)算子、SURF(加速稳健特征)算子和FAST(快速特征点)算子。

下面对这几种算子进行分析和比较。

1. Harris角点检测算子:Harris角点检测算子是一种基于图像亮度变化的角点检测方法。

它通过计算图像每个像素的Harris响应函数来判断是否为角点。

Harris算子具有旋转不变性和尺度不变性的优点,但对于光照变化比较敏感。

2.SIFT算子:SIFT算子是一种局部特征描述算子,通过尺度空间的不变性和局部光度不变性来提取特征点。

SIFT算子对旋转、尺度、光照和仿射变化具有较好的不变性,适用于一些复杂场景下的目标识别和图像匹配任务。

3.SURF算子:SURF算子是一种基于SIFT算子的加速算法,它通过使用积分图像和快速Hessian矩阵的计算方法,提高了特征点提取的效率。

SURF算子在保持SIFT算子的不变性的基础上,显著提升了运算速度。

4.FAST算子:FAST算子是一种基于灰度阈值的快速特征点提取算子。

FAST算子速度快,适用于实时应用和大规模图像处理任务。

但FAST算子对于尺度和旋转变化较为敏感,不适用于复杂场景下的图像处理任务。

综上所述,不同的特征点提取算子适用于不同的图像处理任务。

如果要求高精度、高稳定性和较好的不变性,可以选择SIFT或SURF算子;如果要求处理速度较快,可以选择FAST算子。

实际应用中,可以根据具体需求选择适合的算子或者结合多个算子进行特征点提取,以达到更好的效果。

siftsurf检测关键点及描述子

siftsurf检测关键点及描述⼦1、sift介绍SIFT全称Scale-Invariant Feature Transform(尺度不变特征转换)。

它⽤来侦测与描述影像中的局部性特征,它在空间尺度中寻找极值点,并提取出其位置、尺度、旋转不变量,此算法由 David Lowe在1999年所发表,2004年完善总结。

SIFT算法分解为如下四步:(1)构建尺度空间搜索所有尺度上的图像位置,通过⾼斯微分函数来识别潜在的对于尺度和旋转不变的兴趣点,具体的过程如下。

A、采⽤⾼斯函数对图像进⾏模糊以及降采样处理得到⾼斯⾦字塔B、采⽤DOG(Difference of Gaussian)即在⾼斯⾦⼦塔中的每组中相邻两层相减(“下⼀层减上⼀层”)⽣成⾼斯差分⾦字塔(2)关键点定位A、找到局部极值点B、剔除极值点通过Taylor展开式(插值函数)精确定位关键点,通过Hessian矩阵消除边缘响应点。

(3)⽅向确定对关键点进⾏梯度计算⽣成梯度直⽅图统计领域内像素的梯度和⽅向,从⽽确定⽅向。

(4)关键点特征描述⼦取特征点周围44个区域块,统计每⼩块内8个梯度⽅向,⽤这448=128维向量作为Sift特征的描述⼦。

2、surf介绍SURF全称Speeded Up Robust Features,为SIFT的加速版本。

它改进了特征的提取和描述⽅式,⽤⼀种更为⾼效的⽅式完成特征的提取和描述。

SURF跟SIFT⼀样分四步⾛:(1)构建尺度空间A、使⽤box filter滤波,然后使⽤Hessian矩阵获取⼆阶梯度特征(相当于LoG算⼦或SIFT⾥的DOG)从左到右分别表⽰在y⽅向LoG算⼦(),xy⽅向的LoG算⼦,y⽅向近似的LoG算⼦,xy⽅向近似的LoG算⼦(2)构建Hessian矩阵塔surf在建塔的时候每层图像⼤⼩不变,只是对模板的尺度不断增⼤,相当于⼀个上采样的过程。

第⼀塔中size分别为,⽽以后每塔中size边长差距逐塔翻倍。

hog特征算子

hog特征算子HOG特征算子是一种用于图像处理和物体识别的特征提取方法。

它可以从图像中提取出物体的边缘和纹理等重要特征,从而实现对图像中物体的识别和分类。

HOG特征算子的原理是将图像分割成小的局部区域,然后计算每个区域内的梯度方向直方图。

这些局部区域的梯度方向直方图可以描述图像中的纹理和形状等信息。

在计算梯度方向直方图时,可以使用不同的权重函数来加强对不同尺度和方向的响应。

为了更好地描述图像中的物体,HOG特征算子还引入了块和细胞的概念。

块是由多个局部区域组成的,而细胞是每个局部区域内的梯度方向直方图。

通过将块和细胞结合起来,可以获得更加丰富和稳定的特征表示。

在使用HOG特征算子进行物体识别时,首先需要对输入图像进行预处理,如灰度化和归一化等。

然后,将图像分割成小的局部区域,并计算每个区域内的梯度方向直方图。

接下来,将这些局部区域的特征进行组合,形成最终的特征向量。

最后,使用分类器对这些特征向量进行训练和分类。

HOG特征算子在物体识别和行人检测等领域有着广泛的应用。

它能够有效地提取图像中的纹理和形状等特征,从而实现对物体的准确识别和分类。

与其他特征提取方法相比,HOG特征算子具有计算简单、鲁棒性强等优点,因此受到了研究者和工程师的广泛关注。

总结起来,HOG特征算子是一种用于图像处理和物体识别的重要方法。

它通过计算图像中局部区域的梯度方向直方图,可以提取出物体的纹理和形状等重要特征。

在实际应用中,我们可以使用HOG特征算子对图像进行处理,从而实现对物体的准确识别和分类。

通过深入理解和应用HOG特征算子,我们可以更好地处理图像数据,并开发出更加先进和有效的图像处理和物体识别算法。

常用的特征描绘子

常用的特征描绘子在计算机视觉和图像处理领域,特征描绘子是用于描述图像中的特定属性或纹理信息的数学表示。

特征描绘子对于图像匹配、对象识别和图像检索等任务非常重要。

下面将介绍一些常用的特征描绘子。

1.SIFT(尺度不变特征变换):SIFT是一种用于在不同尺度上检测和描述局部特征的算法。

它通过应用高斯滤波器来寻找具有高灵敏度的关键点,并使用关键点周围的局部图像区域来构建描述子。

SIFT特征具有尺度不变性和旋转不变性,因此在大规模图像检索和对象识别中广泛应用。

2. SURF(加速稳健特征):SURF是一种基于Hessian矩阵的局部特征描述子。

它通过计算图像中的灰度变化率来检测特征点,并构建了一种基于梯度直方图的描述子。

SURF特征具有尺度不变性、旋转不变性和光照不变性,且计算速度比SIFT更快,因此适用于实时图像处理任务。

3.ORB(方向鲁棒特征):ORB是一种结合了FAST角点检测器和BRIEF特征描述子的特征描绘子。

它通过检测图像中的角点,并使用二进制描述子来描述这些角点的特征。

ORB特征具有尺度不变性、旋转不变性和仿射不变性,且计算速度比SIFT和SURF都更快,因此适用于实时图像处理应用。

4.HOG(方向梯度直方图):HOG是一种用于物体检测和人体姿态估计的特征描述子。

它通过计算图像中局部区域的梯度直方图来描述图像的形状和纹理信息。

HOG特征在人体检测和行人识别等任务中表现出色,并且对于图像的尺度和旋转变化具有一定的鲁棒性。

5.LBP(局部二值模式):LBP是一种用于纹理分析和表情识别的特征描述子。

它通过将局部图像区域与其周围像素比较,并将比较结果编码为二进制数来描述纹理特征。

LBP特征在纹理分类和人脸识别等任务中表现出色,并且对于光照变化和噪声干扰具有一定的鲁棒性。

除了上述特征描绘子,还有许多其他的常用特征描绘子,如GIST(总体图像特征)、BRISK(加速旋转不变特征)、FREAK(快速稳定特征)等。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

Feature descriptor comparison reportSharing my research work of behavior of several types of feature descriptors. This article is an update of old "Comparison of feature descriptors" post. I've added a brand new ORB feature descriptor to the test suite, also SIFT descriptor included as well. And a new version of LAZY descriptor present in this test too.For this test i have written special test framework, which allows me to easily add the new kind of descriptors and test cases and generate report data in CSV-like format. Than i upload it in Google docs and create this awesome charts. Five quality and one performance test was done for each kind of descriptor.o Rotation test - this test shows how the feature descriptor depends on feature orientation.o Scaling test - this test shows how the feature descriptor depends on feature size.o Blur test - this test shows how the feature descriptor is robust against blur.o Lighting test - this test shows how the feature descriptor is robust against lighting.o Pattern detection test - this test performs detection of planar平面object (image) on the real video. In contrast to the synthetic综合tests, this test givesa real picture of the overall stability of the particular descriptor.o Performance test is a measurement of description extraction time.All quality tests works in similar way. Using a given source image we generate a synthetic test data: transformed images corresponding feature points. The transformation algorithm depends on the particular test. For the rotation test case, it's the rotation of the source image around it's center for 360 degrees, for scaling - it's resizing of image from 0.25X to 2x size of original. Blur test uses gaussian blur with several steps and the lighting test changes the overall picture brightness.The pattern detection test deserves a special attention. This test is done on very complex and noisy video sequence. So it's challenging task for any feature descriptor algorithm to demonstrate a good results in this test.The metric for all quality tests is the percent of correct matches between the source image and the transformed one. Since we use planar object, we can easily select the inliers from all matches using the homography estimation. I use OpenCV's function cvFindHomography for this. This metric gives very good and stable results. I do no outlier detection of matches before homography estimation because this will affect the results in unexpected way. The matching of descriptors is done via brute-force matching from the OpenCV.In this test i obtain pretty expectable results, because all descriptors are rotation invariant expect the BRIEF. Slight changes in stability can be explained by the feature orientation calculation algorithm and descriptor nature. A detailed study of why the descriptor behaves exactly as it is, takes time and effort. It's a topic for another article. Maybe later on....SURF and SIFT descriptors demonstrate us very good stability in this test because they do expensive keypoint size calculation. Other descriptors uses fixed-size descriptor and youcan see what it leads to. Currently for LAZY descriptor i do not have separate LAZY feature detector (i use ORB detector for tests) but I'm thinking on lightweight feature detector with feature size calculation, because it's a must-have feature. Actually, scale invariance is much more important rather than precise orientation calculation.In this test i tried to simulate the motion blur which can occurs if camera moves suddenly. All descriptors demonstrate good results in this test. By “good” I mean that the more blur size is applied the less percent of correct matches is obtained. Which is expected behavior.In lighting test the transformed images differs only in overall image brightness. All kinds of descriptors works well in this case. The major reason is that all descriptors extracted normalized, e.g the norm_2 of the descriptor vector equals 1. This normalization makes descriptor invariant to brightness changes.Detection of the object on real video is the most complex task since ground truth contains rotation, scaling a nd motion blur. Also other objects are also present. And finally, it’s notHD quality. These conditions are dictated by the actual conditions of application of computer vision.As you can see on diagram, the SIFT and SURF descriptors gives the best results, nevertheless they are far away from ideal, it’s quite enough for such challenging video. Unfortunately, scale-covariant descriptors show very bad results in this test because pattern image appears in 1:1 scale only at the beginning of the video (The “spike” near frame 20). On the rest of the video sequence target object moves from the camera back and scale-covariant descriptors can’t handle this situation.This chart shows the extraction time for N features. I made Y-axis as logarithm scale to make it more readable. For all descriptor extraction algorithm the extraction time depends on number of features linearly. Local spikes is probably caused by some vector resizing or L2 cache misses. This performance test was done on Mac Book Pro 2.2 with Core 2 Duo 2.13 Ghz.Add new quality test cases. One additional test i know for sure - affine transformations. Your ideas for other tests are welcome!o Add new kind of descriptors. Definitely will add an A-SIFT implementation.o Create an LAZY detector with feature size and orientation estimation.o Improve the LAZY descriptor extraction procedure. Expect at least 20% performance gain.o Generate matching video for each test to demonstrate the behavior of each descriptor algorithm.。