BP神经网络测试例子(附数据)

BP神经网络步骤及应用实例

1、数据归一化2、数据分类,主要包括打乱数据顺序,抽取正常训练用数据、变量数据、测试数据3、建立神经网络,包括设置多少层网络(一般3层以内既可以,每层的节点数(具体节点数,尚无科学的模型和公式方法确定,可采用试凑法,但输出层的节点数应和需要输出的量个数相等),设置隐含层的传输函数等。

关于网络具体建立使用方法,在后几节的例子中将会说到。

4、指定训练参数进行训练,这步非常重要,在例子中,将详细进行说明5、完成训练后,就可以调用训练结果,输入测试数据,进行测试6、数据进行反归一化7、误差分析、结果预测或分类,作图等数据归一化问题归一化的意义:首先说一下,在工程应用领域中,应用BP网络的好坏最关键的仍然是输入特征选择和训练样本集的准备,若样本集代表性差、矛盾样本多、数据归一化存在问题,那么,使用多复杂的综合算法、多精致的网络结构,建立起来的模型预测效果不会多好。

若想取得实际有价值的应用效果,从最基础的数据整理工作做起吧,会少走弯路的。

归一化是为了加快训练网络的收敛性,具体做法是:1 把数变为(0,1)之间的小数主要是为了数据处理方便提出来的,把数据映射到0~1范围之内处理,更加便捷快速,应该归到数字信号处理范畴之内。

2 把有量纲表达式变为无量纲表达式归一化是一种简化计算的方式,即将有量纲的表达式,经过变换,化为无量纲的表达式,成为纯量比如,复数阻抗可以归一化书写:Z = R + jωL = R(1 + jωL/R) ,复数部分变成了纯数量了,没有量纲。

另外,微波之中也就是电路分析、信号系统、电磁波传输等,有很多运算都可以如此处理,既保证了运算的便捷,又能凸现出物理量的本质含义。

神经网络归一化方法:由于采集的各数据单位不一致,因而须对数据进行[-1,1]归一化处理,归一化方法主要有如下几种,供大家参考:1、线性函数转换,表达式如下:复制内容到剪贴板代码:y=(x-MinVal ue)/(MaxVal ue-MinVal ue)说明:x、y分别为转换前、后的值,MaxVal ue、MinVal ue分别为样本的最大值和最小值。

bp神经网络实例分析

数据集划分

01

02

03

训练集

用于训练神经网络,占总 数据的70%-90%。

验证集

用于调整超参数和选择最 佳模型,占估模型的性能,占 总数据的10%-30%。

03

BP神经网络模型构建

神经元模型

神经元模型

神经元是神经网络的基本单元, 它模拟了生物神经元的基本功能,

误差计算

根据实际输出与期望输出计算误差。

权值调整

根据误差反向传播算法调整各层的权值和阈值。

迭代训练

重复前向传播和权值调整过程,直到达到预设的迭代次 数或误差要求。

02

BP神经网络实例选择与数据准备

实例选择

选择一个具有代表性的问题

为了展示BP神经网络的应用,选择一个具有代表性的问题,例如 分类、回归或聚类等。

成。

节点数量

02

每一层的节点数量需要根据具体问题来确定,过多的节点可能

导致过拟合,而节点过少则可能无法充分提取数据特征。

连接权重

03

连接权重是神经网络中非常重要的参数,它决定了神经元之间

的连接强度和信息传递方式。

激活函数选择

激活函数的作用

激活函数用于引入非线性特性,使得神经网络能够更好地处理复 杂的非线性问题。

误差反向传播

当实际输出与期望输出不符时,进入 误差反向传播阶段,误差信号从输出 层开始逐层向输入层传播,并根据误 差调整各层的权值和阈值。

训练过程

数据准备

准备训练数据和测试数据,并对数据进行预 处理,如归一化等。

网络初始化

为各层神经元设置初始权值和阈值。

前向传播

输入样本数据,通过正向传播计算每一层的输出 值。

3

BP神经网络模型应用实例

BP神经网络模型第1节基本原理简介近年来全球性的神经网络研究热潮的再度兴起,不仅仅是因为神经科学本身取得了巨大的进展.更主要的原因在于发展新型计算机和人工智能新途径的迫切需要.迄今为止在需要人工智能解决的许多问题中,人脑远比计算机聪明的多,要开创具有智能的新一代计算机,就必须了解人脑,研究人脑神经网络系统信息处理的机制.另一方面,基于神经科学研究成果基础上发展出来的人工神经网络模型,反映了人脑功能的若干基本特性,开拓了神经网络用于计算机的新途径.它对传统的计算机结构和人工智能是一个有力的挑战,引起了各方面专家的极大关注.目前,已发展了几十种神经网络,例如Hopficld模型,Feldmann等的连接型网络模型,Hinton等的玻尔茨曼机模型,以及Rumelhart等的多层感知机模型和Kohonen的自组织网络模型等等。

在这众多神经网络模型中,应用最广泛的是多层感知机神经网络。

多层感知机神经网络的研究始于50年代,但一直进展不大。

直到1985年,Rumelhart等人提出了误差反向传递学习算法(即BP算),实现了Minsky的多层网络设想,如图34-1所示。

BP 算法不仅有输入层节点、输出层节点,还可有1个或多个隐含层节点。

对于输入信号,要先向前传播到隐含层节点,经作用函数后,再把隐节点的输出信号传播到输出节点,最后给出输出结果。

节点的作用的激励函数通常选取S 型函数,如Qx e x f /11)(-+=式中Q 为调整激励函数形式的Sigmoid 参数。

该算法的学习过程由正向传播和反向传播组成。

在正向传播过程中,输入信息从输入层经隐含层逐层处理,并传向输出层。

每一层神经元的状态只影响下一层神经输入层 中间层 输出层 图34-1 BP 神经网络模型元的状态。

如果输出层得不到期望的输出,则转入反向传播,将误差信号沿原来的连接通道返回,通过修改各层神经元的权值,使得误差信号最小。

社含有n 个节点的任意网络,各节点之特性为Sigmoid 型。

神经网络的BP算法实验报告

计算智能基础实验报告实验名称:BP神经网络算法实验班级名称:341521班专业:探测制导与控制技术姓名:***学号:********一、 实验目的1)编程实现BP 神经网络算法;2)探究BP 算法中学习因子算法收敛趋势、收敛速度之间的关系;3)修改训练后BP 神经网络部分连接权值,分析连接权值修改前和修改后对相同测试样本测试结果,理解神经网络分布存储等特点。

二、 实验要求按照下面的要求操作,然后分析不同操作后网络输出结果。

1)可修改学习因子2)可任意指定隐单元层数3)可任意指定输入层、隐含层、输出层的单元数4)可指定最大允许误差ε5)可输入学习样本(增加样本)6)可存储训练后的网络各神经元之间的连接权值矩阵;7)修改训练后的BP 神经网络部分连接权值,分析连接权值修改前和修改后对相同测试样本测试结果 。

三、 实验原理1BP 神经网络算法的基本思想误差逆传播(back propagation, BP)算法是一种计算单个权值变化引起网络性能变化的较为简单的方法。

由于BP 算法过程包含从输出节点开始,反向地向第一隐含层(即最接近输入层的隐含层)传播由总误差引起的权值修正,所以称为“反向传播”。

BP 神经网络是有教师指导训练方式的多层前馈网络,其基本思想是:从网络输入节点输入的样本信号向前传播,经隐含层节点和输出层节点处的非线性函数作用后,从输出节点获得输出。

若在输出节点得不到样本的期望输出,则建立样本的网络输出与其期望输出的误差信号,并将此误差信号沿原连接路径逆向传播,去逐层修改网络的权值和节点处阈值,这种信号正向传播与误差信号逆向传播修改权值和阈值的过程反复进行,直训练样本集的网络输出误差满足一定精度要求为止。

2 BP 神经网络算法步骤和流程BP 神经网络步骤和流程如下:1) 初始化,给各连接权{},{}ij jt W V 及阈值{},{}j t θγ赋予(-1,1)间的随机值;2) 随机选取一学习模式对1212(,),(,,)k k k k k k k n k n A a a a Y y y y ==提供给网络;3) 计算隐含层各单元的输入、输出;1n j ij i j i s w a θ==⋅-∑,()1,2,,j j b f s j p ==4) 计算输出层各单元的输入、输出;1t t jt j t j l V b γ==⋅-∑,()1,2,,t t c f l t q ==5) 计算输出层各单元的一般化误差;()(1)1,2,,k k t t tt t t d y c c c t q =-⋅-=6) 计算中间层各单元的一般化误差;1[](1)1,2,,q kk jt jt j j t e d V b b j p ==⋅⋅-=∑7) 修正中间层至输出层连接权值和输出层各单元阈值;(1)()k jt jt t j V iter V iter d b α+=+⋅⋅(1)()k t t t iter iter d γγα+=+⋅8) 修正输入层至中间层连接权值和中间层各单元阈值;(1)()kk ij ij j i W iter W iter e a β+=+⋅⋅(1)()kj j j iter iter e θθβ+=+⋅9) 随机选取下一个学习模式对提供给网络,返回步骤3),直至全部m 个模式训练完毕;10) 重新从m 个学习模式对中随机选取一个模式对,返回步骤3),直至网络全局误差函数E 小于预先设定的一个极小值,即网络收敛;或者,当训练次数大于预先设定值,强制网络停止学习(网络可能无法收敛)。

BP神经网络详解与实例

(Artificial Neural Netwroks -----ANN)

-----HZAU 数模基地

引言

❖ 利用机器模仿人类的智能是长期以来人们认识自 然、改造自然和认识自身的理想。

❖ 研究ANN目的: ❖ (1)探索和模拟人的感觉、思维和行为的规律,

设计具有人类智能的计算机系统。 ❖ (2)探讨人脑的智能活动,用物化了的智能来

二、神经元与神经网络

❖ 大脑可视作为1000多亿神经元组成的神经网络

• 图3 神经元的解剖图

❖ 神经元的信息传递和处理是一种电化学活 动.树突由于电化学作用接受外界的刺激;通 过胞体内的活动体现为轴突电位,当轴突电位 达到一定的值则形成神经脉冲或动作电位;再 通过轴突末梢传递给其它的神经元.从控制论 的观点来看;这一过程可以看作一个多输入单 输出非线性系统的动态过程

输出层LC

W11 Wi1

Wij

Wiq Wpq W

… b1 Vn1

Vh1 V11

V1i bi Vhi

… Vni

V1p bp Vhp Vnp

隐含层LB V

… a1

… ah

an 输入层LA

a1k

a

k h

a

k n

基本BP网络的拓扑结构

ANN类型与功能

一般而言, ANN与经典计算方法相比并非优越, 只有当常规 方法解决不了或效果不佳时ANN方法才能显示出其优越性。尤 其对问题的机理不甚了解或不能用数学模型表示的系统,如故障 诊断、特征提取和预测等问题,ANN往往是最有利的工具。另 一方面, ANN对处理大量原始数据而不能用规则或公式描述的 问题, 表现出极大的灵活性和自适应性。

i 1

(p=1,…,P)

数据挖掘实验(一)bp神经网络实验指导书48

数据挖掘实验(一)BP神经网络实验吴诗乐通信7班20123100053一、实验目的初步熟悉MATLAB 工作环境,熟悉命令窗口,学会使用帮助窗口查找帮助信息。

二、实验内容1、网络设计,包括输入层、隐含层、输出层节点个数的设计。

2、算法步骤3、编程,注意原始数据的通用化,数据输入的随机性。

4、网络训练,注意训练数据与验证数据分开。

5、网络验证6、结果分析,修改隐含层节点个数,修改学习率,分别对结果的影响。

三、实验数据本实验以Fisher的Iris数据集作为神经网络程序的测试数据集。

Iris数据集可以在/wiki/Iris_flower_data_set 找到。

也可以在UCI数据集中下载。

Iris数据集中Iris花可分为3个品种,现需要对其进行分类。

不同品种的Iris 花的花萼长度、花萼宽度、花瓣长度、花瓣宽度会有差异。

现有一批已知品种的Iris花的花萼长度、花萼宽度、花瓣长度、花瓣宽度的数据。

要求用已有的数据训练一个神经网络用作分类器。

四、神经网络实现1. 数据预处理在训练神经网络前一般需要对数据进行预处理,一种重要的预处理手段是归一化处理。

下面简要介绍归一化处理的原理与方法。

(1) 什么是归一化?数据归一化,就是将数据映射到[0,1]或[-1,1]区间或更小的区间,比如(0.1,0.9) 。

(2) 为什么要归一化处理?<1>输入数据的单位不一样,有些数据的范围可能特别大,导致的结果是神经网络收敛慢、训练时间长。

<2>数据范围大的输入在模式分类中的作用可能会偏大,而数据范围小的输入作用就可能会偏小。

<3>由于神经网络输出层的激活函数的值域是有限制的,因此需要将网络训练的目标数据映射到激活函数的值域。

例如神经网络的输出层若采用S形激活函数,由于S形函数的值域限制在(0,1),也就是说神经网络的输出只能限制在(0,1),所以训练数据的输出就要归一化到[0,1]区间。

神经网络BP算法案例

的记录是被我们所忽略的。

所有满足最小支持度3的1项频繁集如下 (其中巧克力、 香蕉、葡萄的支持度为1,不满足条件)

支持度

销售内容

3

4 4 5 7

冰淇淋

咖啡 果酱 牛奶 面包

所有满足最小支持度3的2项频繁集 如下 :

支持度 3 销售内容 面包 咖啡 面包 冰淇淋 面包 牛奶 面包 果酱

递 归 执 行

的,比如在一个超市中会存在这样的概念 层次:蒙牛牌牛奶是牛奶,伊利牌牛奶是 牛奶,王子牌饼干是饼干,康师傅牌饼干 是饼干等。

• 可以用有向无环图 (directed acyclic graph ) 表示概念层次,如下:

从有向无环图 (directed acyclic graph )可以 看出—— 如果我们只是在数据基本层发掘关系, {蒙牛牌牛奶,王子牌饼干},{蒙牛牌牛 奶,康师傅牌饼干},{伊利牌牛奶,王子 牌饼干},{伊利牌牛奶,康师傅牌饼干} 都不符合最小支持度。不过如果我们上升一 个层级,可能会发现{牛奶,饼干} 的关 联规则是有一定支持度的。这样我们就可以 在较高的概念层次上发现关联规则。

w14 4 w46 6 5 w35

. . ..

w34

w56

. . .

3

图1 两层前馈神经网络

2

神经网络BP算法案例

• 首先算出单元4、5、6的输入、输出,具体结果见 表1,然后计算4、5、6的误差,见表2;NT中每条 有向加权边的新权重、每个隐藏层与输出层单元 的新偏置见表3。

图2 两层前馈神经网络

W35

0.2+0.9×(-0.0065)×1=0.194

0.1+0.9×0.1311=0.218 0.2+0.9×(-0.0065)=0.194

(完整版)BP神经网络matlab实例(简单而经典)

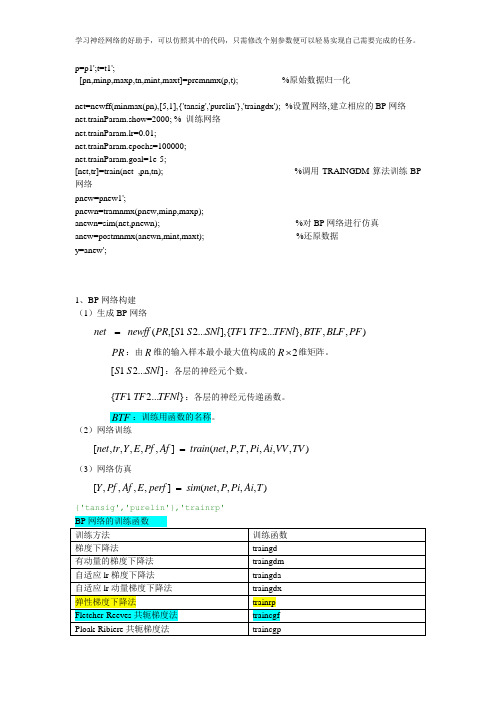

p=p1';t=t1';[pn,minp,maxp,tn,mint,maxt]=premnmx(p,t); %原始数据归一化net=newff(minmax(pn),[5,1],{'tansig','purelin'},'traingdx');%设置网络,建立相应的BP网络net.trainParam.show=2000; % 训练网络net.trainParam.lr=0.01;net.trainParam.epochs=100000;net.trainParam.goal=1e-5;[net,tr]=train(net ,pn,tn); %调用TRAINGDM算法训练BP 网络pnew=pnew1';pnewn=tramnmx(pnew,minp,maxp);anewn=sim(net,pnewn); %对BP网络进行仿真anew=postmnmx(anewn,mint,maxt); %还原数据y=anew';1、BP网络构建(1)生成BP网络=net newff PR S S SNl TF TF TFNl BTF BLF PF(,[1 2...],{ 1 2...},,,)PR:由R维的输入样本最小最大值构成的2R⨯维矩阵。

S S SNl:各层的神经元个数。

[ 1 2...]{ 1 2...}TF TF TFNl:各层的神经元传递函数。

BTF:训练用函数的名称。

(2)网络训练[,,,,,] (,,,,,,)=net tr Y E Pf Af train net P T Pi Ai VV TV(3)网络仿真=[,,,,] (,,,,)Y Pf Af E perf sim net P Pi Ai T{'tansig','purelin'},'trainrp'2、BP网络举例举例1、%traingdclear;clc;P=[-1 -1 2 2 4;0 5 0 5 7];T=[-1 -1 1 1 -1];%利用minmax函数求输入样本范围net = newff(minmax(P),T,[5,1],{'tansig','purelin'},'trainrp');net.trainParam.show=50;%net.trainParam.lr=0.05;net.trainParam.epochs=300;net.trainParam.goal=1e-5;[net,tr]=train(net,P,T);net.iw{1,1}%隐层权值net.b{1}%隐层阈值net.lw{2,1}%输出层权值net.b{2}%输出层阈值sim(net,P)举例2、利用三层BP神经网络来完成非线性函数的逼近任务,其中隐层神经元个数为五个。