11-第三篇 第4章 如何组织神经网络

强化学习中的神经网络模型构建与训练

强化学习中的神经网络模型构建与训练第一章强化学习中的基本概念1.1 强化学习简介强化学习是机器学习领域的一个重要分支,旨在让智能体通过与环境的交互来学习最优行为策略。

强化学习的核心思想是智能体通过与环境的交互来获得反馈信号,根据这些反馈来调整自己的行为。

1.2 强化学习的基本元素在强化学习中,主要涉及的三个基本元素为:智能体、环境和奖励信号。

智能体是进行学习的主体,它根据当前的状态选择动作,并与环境进行交互。

环境代表了智能体所处的实际场景,它会根据智能体的动作返回下一个状态和奖励信号。

奖励信号是环境根据智能体的动作返回的一个评估指标,用来反映该动作的好坏程度。

1.3 基于模型和无模型的强化学习在强化学习中,智能体可以基于模型或者无模型进行学习。

基于模型的强化学习是指智能体通过学习环境的模型来预测下一个状态和奖励信号,并根据这些预测来选择动作。

而无模型的强化学习则是直接通过与环境的交互来学习最优策略,无需对环境的模型进行预测。

第二章强化学习中的神经网络模型2.1 神经网络模型的基本原理神经网络是一种模拟生物神经网络的计算模型,它由多个神经元互相连接而成。

每个神经元接收到来自其他神经元的输入,并通过激活函数来产生输出。

神经网络通过训练来调整神经元之间的连接权重,从而实现对输入数据的非线性建模。

2.2 强化学习中的神经网络模型在强化学习中,神经网络模型可以用于近似值函数或策略函数。

值函数用于评估一个状态或状态-动作对的好坏程度,而策略函数用于选择最优动作。

神经网络模型可以通过学习环境的反馈信号来调整神经元之间的连接权重,从而实现对值函数或策略函数的逼近。

2.3 神经网络模型的训练方法神经网络模型的训练通常采用反向传播算法和梯度下降法。

反向传播算法通过将误差从输出层向输入层传递,并根据误差对连接权重进行调整。

梯度下降法则是一种通过寻找最小化损失函数的方法来调整连接权重的优化算法。

第三章强化学习中的神经网络模型构建与训练3.1 强化学习问题的建模在使用神经网络模型解决强化学习问题时,首先需要将问题进行建模。

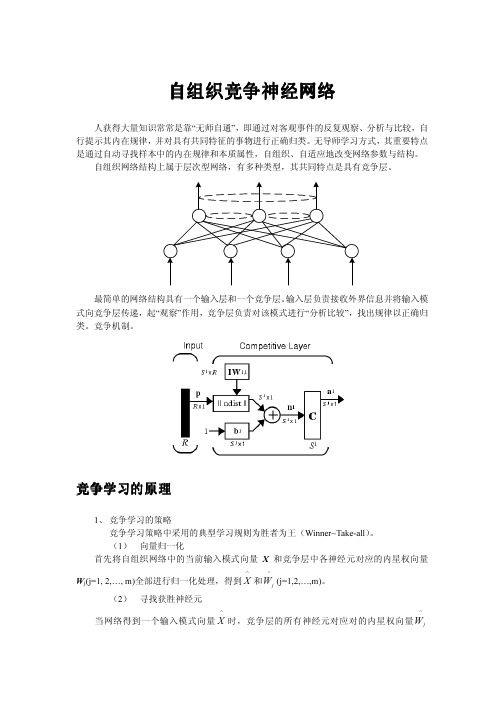

自组织竞争神经网络

第23页

3.搜索阶段:

由Reset信号置获胜阶段无效开始,网络进入搜索 阶段。此时R为全0,G1=1 ,在C层输出端又得到了此 次输入模式X。所以,网络又进入识别及比较阶段,得 到新获胜节点(以前获胜节点不参加竞争)。这么重 复直至搜索到某一个获胜节点K,它与输入向量X充分 匹配到达满足要求为止。模式X编制到R层K节点所连 模式类别中,即按一定方法修改K节点自下而上和自上 而下权向量,使网络以后再碰到X或与X相近模式时, R层K节点能很快取得竞争胜利。若搜索了全部R层输 出节点而没有发觉有与X充分靠近模式,则增设一个R 层节点以表示X或与X相近模式。

⑥ 警戒线检测。设向量X中不为0个数用||X||表示,可

有 n || X || xi

n

||C'|| w' j *iXi i1

(5.3.1)

i 1

n

||C'|| w' j *iXi

(5.3.2)

i1

若||C||/||X||>成立,则接收j*为获胜节点,转⑦。

不然发Reset信号,置j*为0(不允许其再参加竞争),

信号1:输入X第i个分量Xi。 信号2:R层第j个单元自上而下返回信号Rj。 信号3:G1控制信号。 设C层第i个单元输出为Ci。 Ci依据“2/3规则”产 生,即Ci含有三个信号中多数相同值。 网络开始运行时, G1 =1,R层反馈信号为0。

自组织竞争神经网络

第18页

2.R 层结构:

R层功效结构相当于一个前向竞争网络,假设输出 层有m个节点,m类输入模式。输出层节点能动态增加, 以满足设置新模式类需要。设由C层自下而上连接到R 层第j个节点权向量用Wj={w1j,w2j,..,wnj} 表示。C层输出向量C沿Wj向前馈送,经过竞争在R层 输出端产生获胜节点,指示此次输入向量类别。

自组织竞争神经网络SOM

本章主要介绍自组织竞争型神经网络的结构 学习算法;及相关理论

1

第四章自组织竞争型神经网络

§4 1 前言 §4 2 竞争学习的概念和原理 §4 3自组织特征映射神经网络 §4 4自组织特征映射神经网络的设计 §4 5 对偶传播神经网络 §4 6小结

2

§4 1 前言

在生物神经系统中;存在着一种侧抑制现象;即一 个神经细胞兴奋以后;会对周围其他神经细胞产生 抑制作用 这种抑制作用会使神经细胞之间出现竞 争;其结果是某些获胜;而另一些则失败 表现形式 是获胜神经细胞兴奋;失败神经细胞抑制

在网络结构上;它一般是由输入层和竞争层构成的 两层网络 两层之间各神经元实现双向连接;而且网 络没有隐含层 有时竞争层各神经元之间还存在横 向连接

4

在学习算法上;它模拟生物神经元之间的兴奋 协调 与抑制 竞争作用的信息处理的动力学原理来指导 网络的学习与工作;而不像大多数神经网络那样是 以网络的误差或能量函数作为算法的准则

X1

0.8 0.6

X2

00.1.9783468

X3

00..770077

X4

00..3943297

X5

0.6 0.8

解:为作图方便;将上述模式转换成极坐标形式 :

X113.68o9X2180oX314.4 5X4170oX515.31o3

竞争层设两个权向量;随机初始化为单位向量:

W1(0)1010o W2(0)01118o0

7

24 -130

8

34 -130

w2

9

34 -100

10

44 -100

11

40.5 -100

12

40.5 -90

神经网络基础精选

第一讲 神经网络基础

突触:突触是神经元的树突末梢连接另一神经元的突触 后膜 (postsynaptic membrane)的部分。它是神经元之 间相联系并进行信息传送的结构,是神经元之间连接的 接口。两个神经元的细胞质并不直接连通,两者彼此联 系是通过突触这种结构接口的。

膜电位:神经元细胞膜内外之间存在电位差,称为膜电 位。膜外为正,膜内为负。膜电压接受神经其它神经元 的输入后,电位上升或下降。当传入冲动的时空整合结 果,使膜电位上升,而且当超过叫做动作电位的阈值时, 细胞进入兴奋状态,产生神经冲动,由轴突输出,这个 过程称为兴奋。

•9

第一讲 神经网络基础

2 突触传递信息动作原理

膜电位(mv)

兴奋期, 大于动作阈值

动 作

绝对不应期:不响应任何刺激 阈

值

相对不应期:很难相应

t (ms)

根据突触传递信息的动作过 -55

程可以分为两种类型:兴奋型 -70

12

3

和抑制型。神经冲动使得细胞 膜电压升高超过动作电压进入

1ms 1ms 3ms

•5

树突

细胞体

细胞核 轴突

轴突末梢

图1-1a 神经元的解剖

•6

图1-1b 神经元的解剖

•7

第一讲 神经网络基础

细胞体:细胞体是由很多分子形成的综合体,内部含有 一个细胞核、核糖体、原生质网状结构等,它是神经元 活动的能量供应地,在这里进行新陈代谢等各种生化过 程。包括细胞核,细胞膜和细胞质。

n

Ii W ijXj为 第 i个 神 经 元 的 净 输 入

j1

•12

第一讲 神经网络基础

四 人工神经元与生物神经元区别 (1)模型传递的是模拟信号,生物输入输出均

自组织竞争神经网络

dj =

n

∑ (x

i =1

i

− wi j ) 2

∆wi j = η h( j , j*)( xi − wi j )

j − j*2 h ( j , j *) = exp − σ2

自组织竞争神经网络算法能够进行有效的自适应分类,但它仍存在一些问题: 学习速度的选择使其不得不在学习速度和最终权值向量的稳定性之间进行折中。 有时有一个神经元的初始权值向量离输入向量太远以至于它从未在竞争中获胜, 因 此也从未得到学习,这将形成毫无用处的“死”神经元。

网络结构

%1.ÎÊÌâÌá³ö X=[0 1;0 1]; clusters=8; points=10; std_dev=0.05; P=nngenc(X,clusters,points,std_dev); plot(P(1,:),P(2,:),'+r'); title('ÊäÈëÏòÁ¿'); xlabel('P(1)'); ylabel('P(2)'); %2.ÍøÂçÉè¼Æ net=newc([0 1;0 1],8,.1) w=net.IW{1}; plot(P(1,:),P(2,:),'+r'); hold on; circle=plot(w(:,1),w(:,2),'ob') %3.ÍøÂçѵÁ· net.trainParam.epochs=7; net=train(net,P) w=net.IW{1}; delete(circle); plot(w(:,1),w(:,2),'ob'); %4.ÍøÂç²âÊÔ p=[0.5;0.2]; a=sim(net,p)

第四章 自组织竞争神经网络(第14周课)PPT课件

30

SOM网的拓扑结构

SOM网共有两层,输入层模拟感知外界输入信 息的视网膜,输出层模拟做出响应的大脑皮层。

…… (a)一维线阵

…… (b)二维平面线阵

31

SOM网的权值调整域

19

43.5 -75

20

48.5 -75

x5

训练 次数

1

W1

W2

18.43 -180

x3

2

-30.8 -180

3

7 -180

x1

4

-32 -180

5

11 -180

6

24 -180

7

24 -130

8

34 -130

w2

9

34 -100

10

44 -100

11

40.5 -100

12

40.5 -90

w1

13 14

Kohonen认为:一个神经网络接受外界输 入模式时,将会分为不同的对应区域,各区域 对输入模式具有不同的响应特征,而且这个过 程是自动完成的。自组织特征映射正是根据这 一看法提出来的,其特点与人脑的自组织特性 相类似。

29

SOM网的生物学基础

生物学研究的事实表明,在人脑的感觉通道上, 神经元的组织原理是有序排列。因此当人脑通过感官 接受外界的特定时空信息时,大脑皮层的特定区域兴 奋,而且类似的外界信息在对应区域是连续映象的。

x3

2

-30.8 -180

3

7 -180

x1

4

-32 -180

5

11 -180

神经网络方法-PPT课件精选全文完整版

信号和导师信号构成,分别对应网络的输入层和输出层。输

入层信号 INPi (i 1,根2,3据) 多传感器对标准试验火和各种环境条件

下的测试信号经预处理整合后确定,导师信号

Tk (k 1,2)

即上述已知条件下定义的明火和阴燃火判决结果,由此我们

确定了54个训练模式对,判决表1为其中的示例。

15

基于神经网络的融合算法

11

局部决策

局部决策采用单传感器探测的分析算法,如速率持续 法,即通过检测信号的变化速率是否持续超过一定数值来 判别火情。 设采样信号原始序列为

X(n) x1 (n), x2 (n), x3 (n)

式中,xi (n) (i 1,2,3) 分别为温度、烟雾和温度采样信号。

12

局部决策

定义一累加函数 ai (m为) 多次累加相邻采样值 的xi (差n) 值之和

样板和对应的应识别的结果输入人工神经网络,网络就会通过

自学习功能,慢慢学会识别类似的图像。

第二,具有联想存储功能。人的大脑是具有联想功能的。用人

工神经网络的反馈网络就可以实现这种联想。

第三,具有容错性。神经网络可以从不完善的数据图形进行学

习和作出决定。由于知识存在于整个系统而不是一个存储单元

中,一些结点不参与运算,对整个系统性能不会产生重大影响。

18

仿真结果

19

仿真结果

20

2

7.2 人工神经元模型—神经组织的基本特征

3

7.2 人工神经元模型—MP模型

从全局看,多个神经元构成一个网络,因此神经元模型的定义 要考虑整体,包含如下要素: (1)对单个人工神经元给出某种形式定义; (2)决定网络中神经元的数量及彼此间的联结方式; (3)元与元之间的联结强度(加权值)。

BP神经网络ppt

人工神经网络 是生物神经网络的某种模型(数学模型) 是对生物神经网络的模仿 基本处理单元为人工神经元

1. 生物神经系统与生物神经元

大量生物神经元的广泛、复杂连接,形成生

物神经网络 (Biological Neural Network, BNN)。

实现各种智能活动

生物神经元(neuron)是基本的信息处理单元

(1)生物神经系统

生物神经元(neuron)是基本的信息处理单元, 其组成:

➢ 树突(dendrites), 接收来自外接的信息 ➢ 细胞体(cell body), 神经细胞主体,信息加工 ➢ 轴突(axon), 细胞的输出装置,将信号向外传递,

与多个神经元连接 ➢突触 (synapsse), 神经元经突触向其它神经元(胞体 或树突)传递信号

2 1m =

2 j1

dj f

net

L1 j

2

样本集内所有样本关于该网络的总输出误差

Etotal E

输出层l L 1节点j的净输入

实际输出

nL2

net

L1 j

O L1 L2

ij i

i 1

O L1 j

1

1+e-

net

L1 j

II

输出层的权值iLj 1调整

隐含层 L 2 输出层 L 1

nL2

net

L1 j

=

O L1 L2 ij i

i 1

权值iLj 1对误差E的影响

E

iLj 1

E

net

L1 j

net

L1 j

iLj 1

O L1 L2

j

i

输出层的权值iLj 1调整 iLj 1修正应使误差E最快减小

SOM神经网络

第4章 SOM自组织特征映射神经网络生物学研究表明,在人脑的感觉通道上,神经元的组织原理是有序排列的。

当外界的特定时空信息输入时,大脑皮层的特定区域兴奋,而且类似的外界信息在对应的区域是连续映像的。

生物视网膜中有许多特定的细胞对特定的图形比较敏感,当视网膜中有若干个接收单元同时受特定模式刺激时,就使大脑皮层中的特定神经元开始兴奋,输入模式接近,与之对应的兴奋神经元也接近;在听觉通道上,神经元在结构排列上与频率的关系十分密切,对于某个频率,特定的神经元具有最大的响应,位置相邻的神经元具有相近的频率特征,而远离的神经元具有的频率特征差别也较大。

大脑皮层中神经元的这种响应特点不是先天安排好的,而是通过后天的学习自组织形成的。

据此芬兰Helsinki大学的Kohonen T.教授提出了一种自组织特征映射网络(Self-organizing feature Map,SOM),又称Kohonen网络[1-5]。

Kohonen认为,一个神经网络接受外界输入模式时,将会分为不同的对应区域,各区域对输入模式有不同的响应特征,而这个过程是自动完成的。

SOM网络正是根据这一看法提出的,其特点与人脑的自组织特性相类似。

4.1 竞争学习算法基础[6]4.1.1 自组织神经网络结构1.定义自组织神经网络是无导师学习网络。

它通过自动寻找样本中的内在规律和本质属性,自组织、自适应地改变网络参数与结构。

2.结构层次型结构,具有竞争层。

典型结构:输入层+竞争层。

如图4-1所示。

竞争层图4-1 自组织神经网络结构输入层:接受外界信息,将输入模式向竞争层传递,起“观察”作用。

竞争层:负责对输入模式进行“分析比较”,寻找规律,并归类。

4.1.2 自组织神经网络的原理1.分类与输入模式的相似性分类是在类别知识等导师信号的指导下,将待识别的输入模式分配到各自的模式类中,无导师指导的分类称为聚类,聚类的目的是将相似的模式样本划归一类,而将不相似的分离开来,实现模式样本的类内相似性和类间分离性。

神经网络ppt课件

通常,人们较多地考虑神经网络的互连结构。本 节将按照神经网络连接模式,对神经网络的几种 典型结构分别进行介绍

12

2.2.1 单层感知器网络

单层感知器是最早使用的,也是最简单的神经 网络结构,由一个或多个线性阈值单元组成

这种神经网络的输入层不仅 接受外界的输入信号,同时 接受网络自身的输出信号。 输出反馈信号可以是原始输 出信号,也可以是经过转化 的输出信号;可以是本时刻 的输出信号,也可以是经过 一定延迟的输出信号

此种网络经常用于系统控制、 实时信号处理等需要根据系 统当前状态进行调节的场合

x1

…… …… ……

…… yi …… …… …… …… xi

再励学习

再励学习是介于上述两者之间的一种学习方法

19

2.3.2 学习规则

Hebb学习规则

这个规则是由Donald Hebb在1949年提出的 他的基本规则可以简单归纳为:如果处理单元从另一个处

理单元接受到一个输入,并且如果两个单元都处于高度活 动状态,这时两单元间的连接权重就要被加强 Hebb学习规则是一种没有指导的学习方法,它只根据神经 元连接间的激活水平改变权重,因此这种方法又称为相关 学习或并联学习

9

2.1.2 研究进展

重要学术会议

International Joint Conference on Neural Networks

IEEE International Conference on Systems, Man, and Cybernetics

World Congress on Computational Intelligence

复兴发展时期 1980s至1990s

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

第四章 如何组织神经网络使用人工神经网络时,将面临神经网络结构参数的选择及样本数据的预备等问题。

尽管对人工神经网络作了大量研究工作,但至今仍没有一个通用的理论公式来指导这些参数的选择,这里对一些基本方法加以介绍。

4.1 输入和输出层的设计问题4.1.1 网络信息容量与训练样本数的匹配在用ANN 解决实际问题时,训练样本的数量在众多要求中往往难于确定,特别它还与网络参数相关,网络参数指输入层、隐层及输出层结点数。

对于确定的样本数,网络参数太少则不足以表达样本中蕴涵的全部规律;而网络参数太多,则由于样本信息少而得不到充分的训练。

多层前馈网络的分类逼近能力与网络的信息容量相关,如网络信息容量用网络的权值和阈值总数n w 表示,则训练样本数P 与给定的训练误差ε之间满足下面关系:εωn P ≈ 上式表明,网络的信息容量与训练样本数之间存在着合理匹配关系:当实际问题不能提供较多的样本时,为了使训练误差ε不至于过大,则需设法减少n w ,换言之,网络的权值和阈值总数不能太多,这等价于输入层、隐层及输出层结点数不能太多。

就输入层、输出层结点数不能太多而言,当问题的输入输出变量较多时,必须剔除那些相对不太重要的参数而选择那些重要的参数作为研究对象。

4.1.2 训练样本数据设计训练样本的合理选择,对网络具有重要的影响。

样本数据的准备工作是网络设计与训练的基础。

1、训练样本数据的要求及数量样本数据的多少与网络的训练时间有明显关系,除了考虑样本的数量外,还要考虑以下问题:(1)训练样本数据必须包括要研究问题的全部模式。

神经网络是靠样本数据来训练的,样本越全面,网络性能就越好。

(2)训练样本数据之间尽可能不相关或相关性小,否则网络没有泛化能力。

(3)输入变量必须选择那些对输出影响大,且能够控制或提取训练数据的变量。

(4)在训练样本数据中,还应适当地考虑随机噪声的影响。

例如在加工线上,用神经网络识别不合格零件,在训练网络时,必须用各种不合格尺寸及不合格形状的数据来训练网络。

(5)应注意在靠近分类边界处训练样本数据的选择。

在靠近边界的地方,噪声的影响容易造成网络的错误判断,因此要选用较多的训练样本数据。

(6)训练样本数据量较大时可避免过度训练,或称过度拟合。

(7)训练样本要进行筛选并避免人为因素的干扰,同时应注意训练样本中各种可能模式的平衡,不能偏重于某种类型。

1另外,为使网络学习到训练样本中蕴涵的知识,一般要采用大量的训练样本,使网络不至于只学到少量样本中不重要的特征。

训练样本数据量最好是网络的权重总数乘以2,这里不包括训练之后用于检验训练效果的检验样本数据。

2、输入变量的类型在设计网络之前,必须整理好训练样本数据,这些数据一般是无法直接获得,常常需要用信号处理与特征提取技术从原始数据中提取能反映其特征的参数作为网络输入数据。

一般的数据分为以下两种变量:(1)语言变量这类变量没有具体的数据,其测量值之间没有“大于”或“小于”等量的关系,赋予这类唯一的数学关系是“属于”还是“不属于”,“相同”或是“不相同”某一类别。

语言变量有性别、职业、形状、颜色,成绩等。

判别是否为语言变量,根据能否给此变量的值赋予顺序关系,如果能赋予就不属于这类变量。

例如,红、黄、蓝、黑四种颜色类别,可分别用0001,0010,0100,1000四个二进制代码表示,换言之,神经网络的输入变量有四个分量[x1,x2,x3,x4],当[x1,x2,x3,x4]=[0,0,0,1]时,输出变量y表示红色,其余类推。

语言变量实质上就是无顺序的离散变量。

(2)数值变量这类变量的数值具有一定的顺序关系,变量也具有顺序关系。

例如,产品质量用四等级来描述:差、较差,中等、好,可以用1、2、3、4分别表示。

状态是从小(差)到大(好),对应的数值也要保持由小到大的渐进关系。

数值变量实质上就是有顺序的离散变量。

3、输出量的表示:输出量指的是网络的输出,代表系统要实现的功能目标,其选择相对容易些。

输出量对网络的精度和时间影响不大,可以是数值或语言变量。

对于数值变量可以直接用数值表示,由于网络实际输出只能是0~1或-1~1之间的数,所以需将输出值进行标准化处理或称归一化处理。

对于语言变量直接采用二进制数表示法。

4.2 网络数据的准备数据准备是否得当,直接影响训练时间和网络的性能,下面对有共性的数据准备问题进行讨论。

4.2.1 数据的标准化数据的标准化,或叫归一化,是指网络的输入、输出各数值变量值都要限制在[0、1]或[-1、1]之间的意思。

当输入变量幅度很大,一个数据变量为106级而另一个数据变量为10-6级,从网络上通过调整权值的大小,针对变量重要程度,那么网络应该学会使前者的权值很小,而使后者的权值很大,但实际上很难办到。

因为要跨越这样大的范围,这对学习算法的要求是太高了。

事实上,许多学习算法对权值范围都有限制,不能适应如此宽的数据变化范围。

为此,我们通过将输入数据归一化到能使网络所有权值调整都在一个不大的范围之内,以此来减轻网络训练时的难度。

让各分量都在0~1或-1~1之间变化,也就是说从网络训练的开始,就给各输入分量以同等的地位。

标准化的另一个原因是,比如一个物品的重量以公斤计而另一物品的重量以市斤计,很明显这2两件物品所用的数据不同。

然而经过标准化处理后,数据就与所用的计量单位无关了。

对于BP 网络的神经元采用Sigmoid 转移函数,标准化后可防止因净输入的绝对值过大而使神经元输出饱和,继而使权值调整进入误差曲面的平坦区。

在Sigmoid 转移函数的输出在0~1或-1~1之间,作为导师信号的输出数据如不标准化处理,势必数值大的输出分量绝对误差也大,数值小的输出分量绝对误差也小。

网络训练时,只针对输出总误差凋整权值,其结果是在总误差中占份额小的量绝对误差小,而输出分量相对误差较大。

碰到这样的问题,只要对输出进行标准化处理就可解决了。

在输入与输出向量的各分量量纲不同时,应对不同分量在其取值范围内分别进行标准化。

当各个物意义相同,且为同一个量纲时,应在整个数据范围内确定最大值和最小值进行统一的变换处理。

将输入输出数据变换为[0,1]区间的值,常用以下方式变换:max x min x minmax min x x x x x i i −−= 其中,代表输入或输出数据,代表数据变化的最小值,代表数据的最大值。

i x min x max x 若将输入输出数据变换[-1,1]区间的值,常用以下方式变换)(212min max minmax x x x x x x x x m i i m −−=+=式中代表数据变化范围的中间值。

按上述方法变换后,处于中间值的原始数据转化为零,而最大值与最小值分别转换1和-1。

当输入或输出向量中的某个分量取值过于密集时,对其进行以上处理可将数据点拉开距离。

m x 4.2.2 数据的分布变换若某变量的分布是非正常的,那么标准化是一种线性变换,但不能改变其分布规律,也会给网络带来很多困难。

我们希望输入网络的样本尽量满足下列条件:(1)参数变化范围的一致性。

网络各输入参数的变化幅度应大致相同,而一般情况是,当某变量的数值较大时,它的变化也大,这样是不好的。

(2)样本分布的正常性。

由分析可知,具有平坦分布规律的样本更容易学习。

因此,要没法使样本的分布尽量匀称。

若将某变量样本分布画成曲线,便得知该变量是否需要作变换。

图4-1所示的样本分布曲线,就表明需要对该变量进行压缩性变换,以确保样本分布的正常性。

最常用的压缩变换是对数变换。

这里应该指出,变换可能为零值的情况下,应先对变量进行偏移处理,然后再进行压缩。

其它常用的压缩变换有平方根、立方根方法等。

设某变量x在1~10000间变化,若取其自然对数,则变化范围就压缩到0~6.9之间,若取立方根,使压缩到1~10之间,变换的目的在于压缩变化的幅度。

图4-1需要变换的样本分布曲线 34.3 网络初始权值的选择网络具有改变权值的能力,可对网络系统进行调节。

即使网络初始状态相同,在不同的训练期,由于网络权值不同,也会给出不同的结果。

由于权值的初始值是随机设定的,因此训练后得到的具有同样功能网络的权值也不尽相同,使其寻找输入变量对输出的影响变得更加困难。

欲判断输入因素对输出的影响,不要误以为绝对值大的输入因素就重要,而接近于零的因素不重要;也不要认为大权值所连接的输入因素就重要,而小权值所连接的因素就不一定重要。

即使某输入通过一个较大的权值连至隐结点,也不能肯定说明变量就是重要因素,因为有可能该隐结点与输出神经单元相连的权值小,也可能某输入与多个隐神经元间的权值均较大,但那些隐神经元以兴奋(正权值)和抑值(负权值)相互抵消的方法连到了输出结点,致使该输入因素对输出影响不大。

为啥较小的权值所连的输入因素不一定重要呢?因为同一输入经若干较小权值分别连至不同的隐神经元,而这些隐神经元的输出虽然其值都不大,但有可能相加起来形成一个可观的输出。

从神经元的转移函数来看,它是与零点对称的,如果每一个结点的净输入均在零点的附近,则其输出在转移函数的中点,这个位置不仅远离转移函数的两个饱和区,而且是变化最灵敏的区域,必然会使网络学习速度较快。

从净输入X j j W =s 可以看出,为了使各结点的初始净输入在零点附近,可采用两种方法:一种办法是使初始权值足够小;另一种办法是使初始值为+1和-1的权值数相等。

在应用中对隐层权值可采用前者方法,而对输出层可采用后者方法。

因为从隐层权值调整公式来看,如果输出层权值太小,会使隐层初期的调整量变小。

按以上方法设置的初始权值,可保证每个神经元一开始都工作在其转移函数变化最大的位置。

初始权重确定以后,相互连接的权值如何改变,是随学习的规则变化的,目的是调整权值以减小输出误差。

4.4 隐层数及隐层结点设计虽然对隐层数及隐层结点数等网络参数设计无通用规则指导,但在设计多层前馈网络时,经过大量的实践一般归纳了以下几点结论:(1) 对任何实际问题首先只用一个隐层;(2) 使用很少的隐层结点数;(3) 不断增加隐层结点数,直到获得满意性能为止,否则再考虑用两个隐层。

下面对隐层数与隐层结点数分别叙述。

4.4.1 隐层数的确定在设计多层神经网络时,首先考虑要采用几个隐层。

经学者研究证明,任意一个连续函数都可用只有一个隐层的网络以任意精度进行逼近,但由于某些先决条件难以满足,致使在应用时造成困难。

图4-2 锯齿波函数学者们通过分析研究曾得出过这样的结论:两个隐层的网络可以获得要求输入与输出是任意连续的函数关系,下面以连续锯齿形函数作为例子来说明。

将该曲线分成30个等距分开的点来训练隐层数及单元数不同的网络,其结果如表4-1。

4从表4-1可看出:当只有一个隐层时,隐层单元数从3增加到4时,出现一个跳跃,网络性能有明显改善,即各种误差均大幅下降。