信息论与编码考试试题

信息论与编码试题集

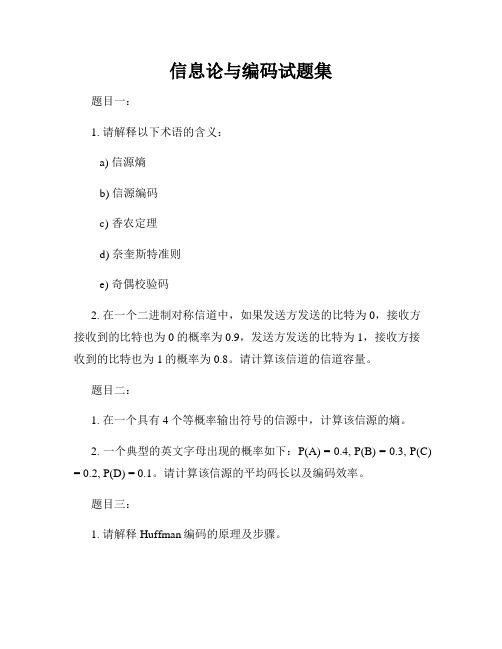

信息论与编码试题集题目一:1. 请解释以下术语的含义:a) 信源熵b) 信源编码c) 香农定理d) 奈奎斯特准则e) 奇偶校验码2. 在一个二进制对称信道中,如果发送方发送的比特为0,接收方接收到的比特也为0的概率为0.9,发送方发送的比特为1,接收方接收到的比特也为1的概率为0.8。

请计算该信道的信道容量。

题目二:1. 在一个具有4个等概率输出符号的信源中,计算该信源的熵。

2. 一个典型的英文字母出现的概率如下:P(A) = 0.4, P(B) = 0.3, P(C) = 0.2, P(D) = 0.1。

请计算该信源的平均码长以及编码效率。

题目三:1. 请解释Huffman编码的原理及步骤。

2. 使用Huffman编码对以下信源的输出编码:A: 0.3,B: 0.2,C: 0.15,D: 0.1,E: 0.1,F: 0.05,G: 0.05,H: 0.05。

计算编码的平均码长和编码效率。

题目四:1. 请解释线性分组码和卷积码的区别。

2. 针对一个二进制码串11001011,使用以下生成矩阵计算该码串的卷积码:G = [1 1 0 1; 1 0 1 0]。

给出计算过程和最终编码结果。

题目五:1. 请解释码激励方法。

2. 针对一个码激励线性分组码,当收到的码字为101010时,给出该码字的输入和输出码字。

题目六:1. 请解释BCH编码的原理及应用场景。

2. 对一个BCH(n, k)码,当n=15,k=11时,请给出该BCH码的生成矩阵。

题目七:1. 请解释LDPC码以及LDPC码的译码方法。

2. 对于一个n=7,k=4的LDPC码,给出该LDPC码的校验矩阵。

题目八:1. 请比较分组密码与流密码的特点和应用场景。

2. 使用RC4流密码算法对明文"HELLO"进行加密,已知初始密钥为"KEY",给出加密后的密文。

题目九:1. 请解释区块密码与流密码的工作原理和区别。

信息论与编码试卷及答案

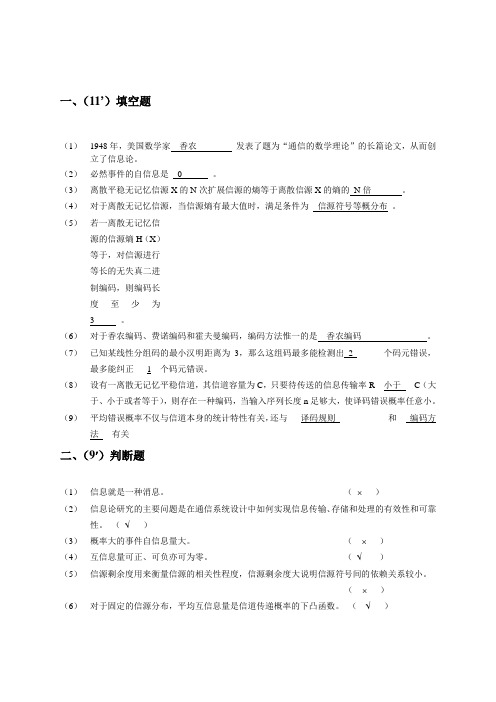

一、(11’)填空题(1)1948年,美国数学家香农发表了题为“通信的数学理论”的长篇论文,从而创立了信息论。

(2)必然事件的自信息是0 。

(3)离散平稳无记忆信源X的N次扩展信源的熵等于离散信源X的熵的N倍。

(4)对于离散无记忆信源,当信源熵有最大值时,满足条件为__信源符号等概分布_。

(5)若一离散无记忆信源的信源熵H(X)等于,对信源进行等长的无失真二进制编码,则编码长度至少为3 。

(6)对于香农编码、费诺编码和霍夫曼编码,编码方法惟一的是香农编码。

(7)已知某线性分组码的最小汉明距离为3,那么这组码最多能检测出_2_______个码元错误,最多能纠正___1__个码元错误。

(8)设有一离散无记忆平稳信道,其信道容量为C,只要待传送的信息传输率R__小于___C(大于、小于或者等于),则存在一种编码,当输入序列长度n足够大,使译码错误概率任意小。

(9)平均错误概率不仅与信道本身的统计特性有关,还与___译码规则____________和___编码方法___有关二、(9')判断题(1)信息就是一种消息。

(⨯)(2)信息论研究的主要问题是在通信系统设计中如何实现信息传输、存储和处理的有效性和可靠性。

(√)(3)概率大的事件自信息量大。

(⨯)(4)互信息量可正、可负亦可为零。

(√)(5)信源剩余度用来衡量信源的相关性程度,信源剩余度大说明信源符号间的依赖关系较小。

(⨯)(6)对于固定的信源分布,平均互信息量是信道传递概率的下凸函数。

(√)(7) 非奇异码一定是唯一可译码,唯一可译码不一定是非奇异码。

( ⨯ ) (8) 信源变长编码的核心问题是寻找紧致码(或最佳码),霍夫曼编码方法构造的是最佳码。

( √ )(9)信息率失真函数R(D)是关于平均失真度D 的上凸函数. ( ⨯ )三、(5')居住在某地区的女孩中有25%是大学生,在女大学生中有75%是身高1.6米以上的,而女孩中身高1.6米以上的占总数的一半。

信息论与编码期末考试题(全套)

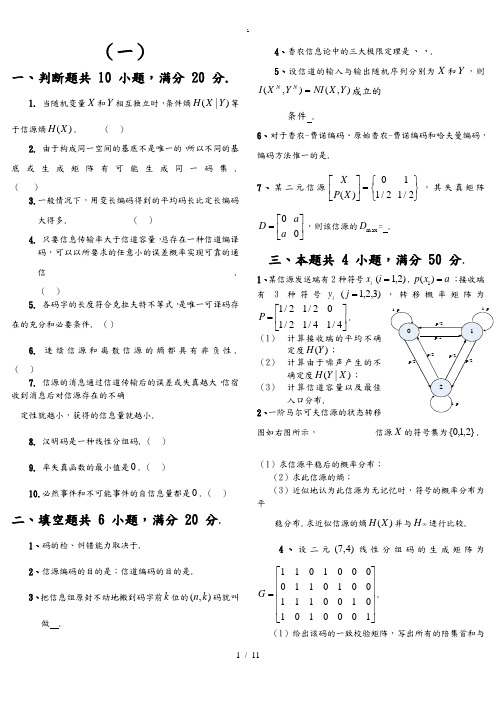

三、(16分)已知信源

(1)用霍夫曼编码法编成二进制变长码;(6分)

(2)计算平均码长 ;(4分)

(3)计算编码信息率 ;(2分)

(4)计算编码后信息传输率 ;(2分)

(5)计算编码效率 。(2分)

四、(10分)某信源输出A、B、C、D、E五种符号,每一个符号独立出现,出现概率分别为1/8、1/8、1/8、1/2、1/8。如果符号的码元宽度为0.5 。计算:

(1)信息就是一种消息。()

(2)信息论研究的主要问题是在通信系统设计中如何实现信息传输、存储和处理的有效性和可靠性。()

(3)概率大的事件自信息量大。()

(4)互信息量可正、可负亦可为零。()

(5)信源剩余度用来衡量信源的相关性程度,信源剩余度大说明信源符号间的依赖关系较小。()

(6)对于固定的信源分布,平均互信息量是信道传递概率的下凸函数。()

7、根据是否允许失真,信源编码可分为和。

8、若连续信源输出信号的平均功率为 ,则输出信号幅度的概率密度是时,信源具有最大熵,其值为值。

9、在下面空格中选择填入数学符号“ ”或“ ”

(1)当X和Y相互独立时,H(XY)H(X)+H(X/Y)H(Y)+H(X)。

(2)

(3)假设信道输入用X表示,信道输出用Y表示。在无噪有损信道中,H(X/Y) 0,

5.各码字的长度符合克拉夫特不等式,是唯一可译码存在的充分和必要条件.()

6.连续信源和离散信源的熵都具有非负性.()

7.信源的消息通过信道传输后的误差或失真越大,信宿收到消息后对信源存在的不确

定性就越小,获得的信息量就越小.

8.汉明码是一种线性分组码.()

信息论与编码试题与答案

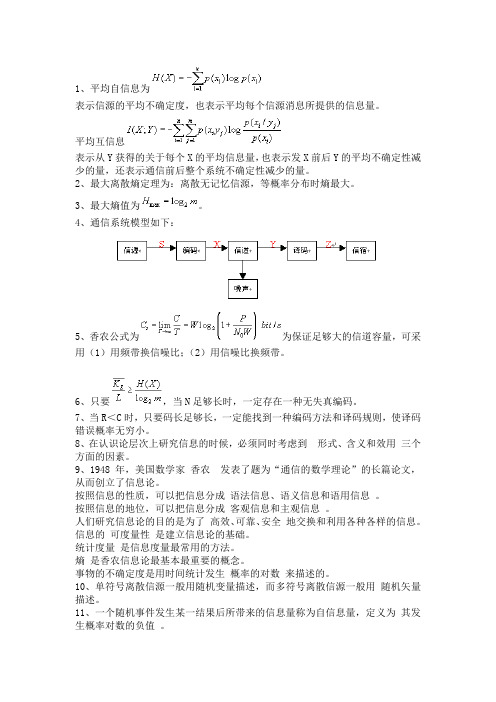

1、平均自信息为表示信源的平均不确定度,也表示平均每个信源消息所提供的信息量。

平均互信息表示从Y获得的关于每个X的平均信息量,也表示发X前后Y的平均不确定性减少的量,还表示通信前后整个系统不确定性减少的量。

2、最大离散熵定理为:离散无记忆信源,等概率分布时熵最大。

3、最大熵值为。

4、通信系统模型如下:5、香农公式为为保证足够大的信道容量,可采用(1)用频带换信噪比;(2)用信噪比换频带。

6、只要,当N足够长时,一定存在一种无失真编码。

7、当R<C时,只要码长足够长,一定能找到一种编码方法和译码规则,使译码错误概率无穷小。

8、在认识论层次上研究信息的时候,必须同时考虑到形式、含义和效用三个方面的因素。

9、1948年,美国数学家香农发表了题为“通信的数学理论”的长篇论文,从而创立了信息论。

按照信息的性质,可以把信息分成语法信息、语义信息和语用信息。

按照信息的地位,可以把信息分成客观信息和主观信息。

人们研究信息论的目的是为了高效、可靠、安全地交换和利用各种各样的信息。

信息的可度量性是建立信息论的基础。

统计度量是信息度量最常用的方法。

熵是香农信息论最基本最重要的概念。

事物的不确定度是用时间统计发生概率的对数来描述的。

10、单符号离散信源一般用随机变量描述,而多符号离散信源一般用随机矢量描述。

11、一个随机事件发生某一结果后所带来的信息量称为自信息量,定义为其发生概率对数的负值。

12、自信息量的单位一般有 比特、奈特和哈特 。

13、必然事件的自信息是 0 。

14、不可能事件的自信息量是 ∞ 。

15、两个相互独立的随机变量的联合自信息量等于 两个自信息量之和 。

16、数据处理定理:当消息经过多级处理后,随着处理器数目的增多,输入消息与输出消息之间的平均互信息量 趋于变小 。

17、离散平稳无记忆信源X 的N 次扩展信源的熵等于离散信源X 的熵的 N 倍 。

18、离散平稳有记忆信源的极限熵,=∞H )/(lim 121-∞→N N N X X X X H 。

最新信息论与编码考试试题

精品文档精品文档3、(12分)已知(7,3)分组码的生成矩阵为100111001001111010011G ⎡⎤⎢⎥=⎢⎥⎢⎥⎣⎦(1)、写出所有许用码组,并求出监督矩阵。

(2)、该码的编码效率为多少?(3)、若译码器输入的码组为l010001,请计算其校正子,并指出此接收码组中是否包含错误。

4、(12分)设有信源12345678()0.40.140.10.10.070.060.050.04X a a a a a a a a P X ⎛⎫⎡⎤=⎪⎢⎥⎝⎭⎣⎦(1) 求信源熵)(X H 和信源的冗余度;(2) 完成二进制费诺编码,并计算其平均码长及编码效率。

(3) 完成二进制霍夫曼编码,并计算其平均码长及编码效率。

精品文档5、(12分)信源分布123911()102020xx x X P X ⎡⎤⎡⎤⎢⎥=⎢⎥⎢⎥⎣⎦⎣⎦,信道转移概率矩阵511682415124681158246P ⎡⎤⎢⎥⎢⎥⎢⎥=⎢⎥⎢⎥⎢⎥⎢⎥⎣⎦, 信道输出符号Y = {y 1, y 2, y 3}。

(1) 若信源等概分布,对其按最大后验概率准则译码,并求平均错误概率。

(2) 若信源等概分布,对其按最大似然准则译码,并求平均错误概率。

6、(18分) 已知(7,3)循环码的生成矩阵为⎥⎥⎥⎦⎤⎢⎢⎢⎣⎡=100110111011101010001G(1)、试写出该(7,3)循环码的生成多项式g (x )。

(2)、若输入信息码为101,试写出对应的循环码码组。

(3)、若接收到的码组为1010100,试恢复出正确的信息位。

(4)、该码能纠正几位错。

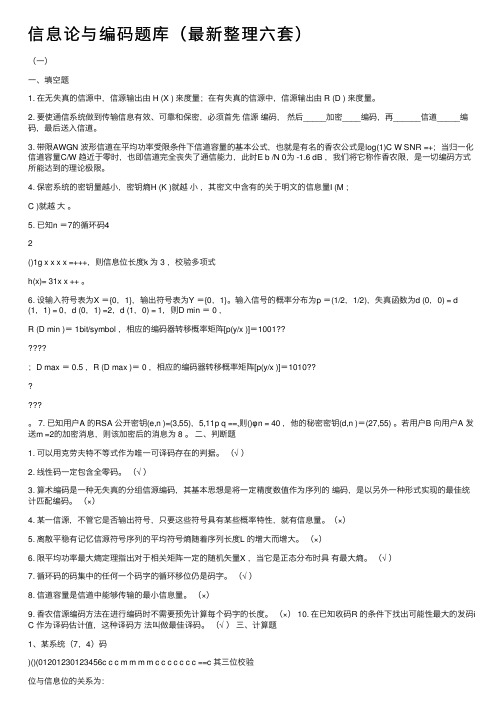

信息论与编码题库(最新整理六套)

信息论与编码题库(最新整理六套)(⼀)⼀、填空题1. 在⽆失真的信源中,信源输出由 H (X ) 来度量;在有失真的信源中,信源输出由 R (D ) 来度量。

2. 要使通信系统做到传输信息有效、可靠和保密,必须⾸先信源编码,然后_____加密____编码,再______信道_____编码,最后送⼊信道。

3. 带限AWGN 波形信道在平均功率受限条件下信道容量的基本公式,也就是有名的⾹农公式是log(1)C W SNR =+;当归⼀化信道容量C/W 趋近于零时,也即信道完全丧失了通信能⼒,此时E b /N 0为 -1.6 dB ,我们将它称作⾹农限,是⼀切编码⽅式所能达到的理论极限。

4. 保密系统的密钥量越⼩,密钥熵H (K )就越⼩,其密⽂中含有的关于明⽂的信息量I (M ;C )就越⼤。

5. 已知n =7的循环码42()1g x x x x =+++,则信息位长度k 为 3 ,校验多项式h(x)= 31x x ++ 。

6. 设输⼊符号表为X ={0,1},输出符号表为Y ={0,1}。

输⼊信号的概率分布为p =(1/2,1/2),失真函数为d (0,0) = d (1,1) = 0,d (0,1) =2,d (1,0) = 1,则D min = 0 ,R (D min )= 1bit/symbol ,相应的编码器转移概率矩阵[p(y/x )]=1001??;D max = 0.5 ,R (D max )= 0 ,相应的编码器转移概率矩阵[p(y/x )]=1010??。

7. 已知⽤户A 的RSA 公开密钥(e,n )=(3,55),5,11p q ==,则()φn = 40 ,他的秘密密钥(d,n )=(27,55) 。

若⽤户B 向⽤户A 发送m =2的加密消息,则该加密后的消息为 8 。

⼆、判断题1. 可以⽤克劳夫特不等式作为唯⼀可译码存在的判据。

(√ )2. 线性码⼀定包含全零码。

(√ )3. 算术编码是⼀种⽆失真的分组信源编码,其基本思想是将⼀定精度数值作为序列的编码,是以另外⼀种形式实现的最佳统计匹配编码。

信息论与编码 试卷

一、填空题(30分、每空2分)1、信息论的三大要素是: 、 、 。

2、一个随机事件的不确定度是指: 。

3、某事件发生的概率是0.5,则这个事件的信息量是: 。

4、编码调制的两条基本途径是: 、 。

5、一个全损离散信道的信道容量是: 。

6、已知一个离散信源有8个符号,每个符号出现的概率均一样,则该信源的信源熵是: 。

7、信息表达可通过哪三层实现: 、 、 。

8、(N 、K )线性码的任意一个码字C 与校验矩阵H 的关系是: 。

9、若(7、4)循环码的生成多项式为g(x)=x +x+1,当信息元为(1101)时其码字为: ,信息元为(0110)时其码字为: 。

二、选择题(20分、每空2分)1、 下列几种离散信源最佳编码方法中编码效率最高的是:A 、香农编码B 、哈夫曼编码C 、费诺编码D 、游程编码2、已知信道模型如下,其信道容量是:A 、 4bitB 、2bitC 、0D 、8bit3、下列离散信道,信道容量最大的是:A 、(1)B 、(2)C 、(3)D 、(4)4、某离散信源的概率空间为{0,0,0,0,0,0,1,0},其信源熵是:A 、0B 、1bitC 、log8bitD 、log7bit5、已知线性分组码的生成矩阵G= 1 1 1 0 1 0 ,下列哪个码字是禁用码: 1 1 0 0 0 10 1 1 1 0 1A 、000000B 、011101C 、 010110D 、 1110006、(5、2)系统线性码的生成距阵是G = 1 0 1 1 1 ,如果错误图案E=(01000),0 1 1 0 1伴随式是:A 、101B 、110C 、100D 、0117、(7、3)线性分组码有 个伴随式。

A 、 8B 、4C 、16D 、328、最小距离为3的线性分组码,其检错能力为 ,纠错能力是 。

A 、1B 、2C 、 3D 、49、H=(1/6、1/6、1/6、1/6、1/6、1/6)=A 、6bitB 、log6bitC 、2bitD 、4bit三、设随机变量X 和Y 的联合分布如下所示,随机变量Z=X+Y (模2加)试求:(共10分,每题5分)四、有一个9个符号的信源,概率分别为1/4、 1/4 、1/8 、1/8、1/16、 1/16、 1/16 、1/32 、1/32,用二元符号0、1编出费诺码字和哈夫曼码字,并分别求出各码字的平均码长。

信息论与编码考试题(附答案版)

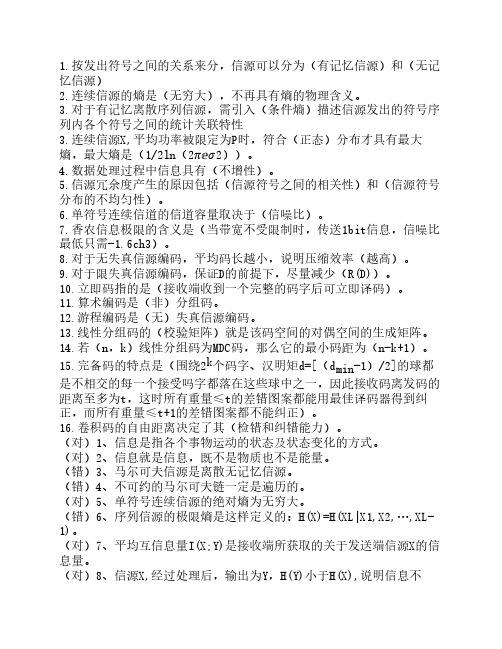

1.按发出符号之间的关系来分,信源可以分为(有记忆信源)和(无记忆信源)2.连续信源的熵是(无穷大),不再具有熵的物理含义。

3.对于有记忆离散序列信源,需引入(条件熵)描述信源发出的符号序列内各个符号之间的统计关联特性3.连续信源X,平均功率被限定为P时,符合(正态)分布才具有最大熵,最大熵是(1/2ln(2 ⅇ 2))。

4.数据处理过程中信息具有(不增性)。

5.信源冗余度产生的原因包括(信源符号之间的相关性)和(信源符号分布的不均匀性)。

6.单符号连续信道的信道容量取决于(信噪比)。

7.香农信息极限的含义是(当带宽不受限制时,传送1bit信息,信噪比最低只需-1.6ch3)。

8.对于无失真信源编码,平均码长越小,说明压缩效率(越高)。

9.对于限失真信源编码,保证D的前提下,尽量减少(R(D))。

10.立即码指的是(接收端收到一个完整的码字后可立即译码)。

11.算术编码是(非)分组码。

12.游程编码是(无)失真信源编码。

13.线性分组码的(校验矩阵)就是该码空间的对偶空间的生成矩阵。

14.若(n,k)线性分组码为MDC码,那么它的最小码距为(n-k+1)。

15.完备码的特点是(围绕2k个码字、汉明矩d=[(d min-1)/2]的球都是不相交的每一个接受吗字都落在这些球中之一,因此接收码离发码的距离至多为t,这时所有重量≤t的差错图案都能用最佳译码器得到纠正,而所有重量≤t+1的差错图案都不能纠正)。

16.卷积码的自由距离决定了其(检错和纠错能力)。

(对)1、信息是指各个事物运动的状态及状态变化的方式。

(对)2、信息就是信息,既不是物质也不是能量。

(错)3、马尔可夫信源是离散无记忆信源。

(错)4、不可约的马尔可夫链一定是遍历的。

(对)5、单符号连续信源的绝对熵为无穷大。

(错)6、序列信源的极限熵是这样定义的:H(X)=H(XL|X1,X2,…,XL-1)。

(对)7、平均互信息量I(X;Y)是接收端所获取的关于发送端信源X的信息量。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

3、(12分)已知(7,3)分组码的生成矩阵为

100111001001111010011G ⎡⎤

⎢⎥=⎢⎥

⎢⎥⎣⎦

(1)、写出所有许用码组,并求出监督矩阵。

(2)、该码的编码效率为多少?

(3)、若译码器输入的码组为l010001,请计算其校正子,并指出此接收码组中是否包含错误。

4、(12分)设有信源12

345678()0.40.140.10.10.070.060.050.04X a a a a a a a a P X ⎛⎫⎡⎤=

⎪⎢⎥⎝⎭⎣⎦

(1) 求信源熵)(X H 和信源的冗余度;

(2) 完成二进制费诺编码,并计算其平均码长及编码效率。

(3) 完成二进制霍夫曼编码,并计算其平均码长及编码效率。

5、(12分)信源分布1

23911()10

2020x

x x X P X ⎡⎤

⎡⎤⎢⎥=⎢⎥⎢⎥⎣⎦

⎣⎦

,信道转移概率矩阵51

1682415124681158

24

6P ⎡⎤

⎢⎥⎢⎥⎢

⎥

=⎢⎥⎢⎥⎢⎥⎢⎥⎣⎦

, 信道输出符号Y = {y 1, y 2, y 3}。

(1) 若信源等概分布,对其按最大后验概率准则译码,并求平均错误概

率。

(2) 若信源等概分布,对其按最大似然准则译码,并求平均错误概率。

6、(18分) 已知(7,3)循环码的生成矩阵为

⎥⎥

⎥⎦⎤

⎢⎢⎢⎣⎡=100110111011101010001G

(1)、试写出该(7,3)循环码的生成多项式g (x )。

(2)、若输入信息码为101,试写出对应的循环码码组。

(3)、若接收到的码组为1010100,试恢复出正确的信息位。

(4)、该码能纠正几位错。