信息论汉字熵

中文信息熵的计算

中文信息熵的计算

中文信息熵的计算可以通过以下步骤实现:

1. 统计中文文本中每个汉字出现的次数,得到一个频率分布表。

2. 计算每个汉字的概率,即该汉字出现次数除以总汉字数。

3. 根据每个汉字的概率计算信息量,即I(x) = -log2(p(x)),其中x为某个汉字,p(x)为该汉字出现的概率。

4. 将所有汉字的信息量相加,得到中文文本的信息熵。

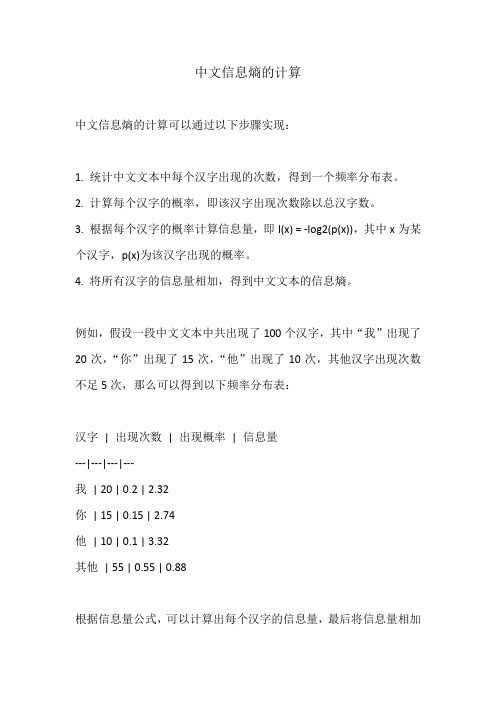

例如,假设一段中文文本中共出现了100个汉字,其中“我”出现了20次,“你”出现了15次,“他”出现了10次,其他汉字出现次数不足5次,那么可以得到以下频率分布表:

汉字| 出现次数| 出现概率| 信息量

---|---|---|---

我| 20 | 0.2 | 2.32

你| 15 | 0.15 | 2.74

他| 10 | 0.1 | 3.32

其他| 55 | 0.55 | 0.88

根据信息量公式,可以计算出每个汉字的信息量,最后将信息量相加

得到中文文本的信息熵:

H = 2.32 * 0.2 + 2.74 * 0.15 + 3.32 * 0.1 + 0.88 * 0.55 = 1.54因此,这段中文文本的信息熵为1.54。

信息论汉字熵

对于信息论的认识二十世纪四十年代末C E SHANNON建立了一套计算信息数量的方法。

我们可以根据事情发生概率的大小,用下式计算信息量 I :I=-log2P (1)式中P是收到的消息中所指的事件的概率。

信息量的单位简称‘比特’bit(它来自英语binary的 b和 digit的it,笔者注) 。

有了(1)式,我们就可以对信息进行定量计算。

例如,通常中文电报是四位阿拉伯数字。

假定每个阿拉伯数字出现的可能性是相同的,即每个数字出现的概率为十分之一。

那么我们 可以计算出收到每个阿拉伯数字所含的信息量为I=-log21/10=3.3比特,因而每个汉字是4×3.3=13.2比特。

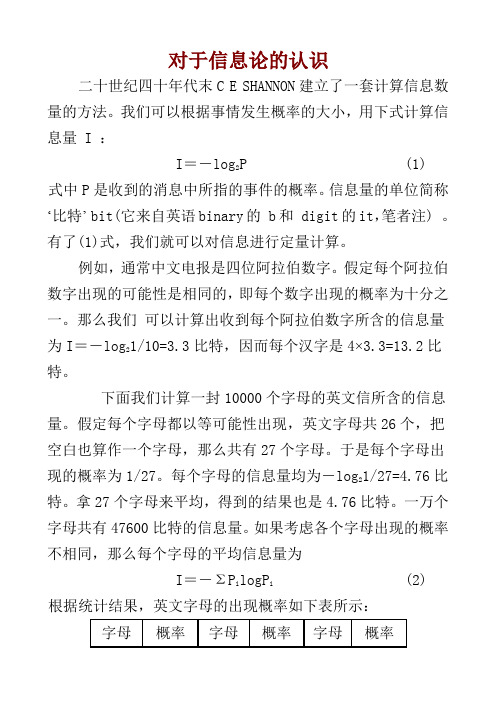

下面我们计算一封10000个字母的英文信所含的信息量。

假定每个字母都以等可能性出现,英文字母共26个,把空白也算作一个字母,那么共有27个字母。

于是每个字母出现的概率为1/27。

每个字母的信息量均为-log21/27=4.76比特。

拿27个字母来平均,得到的结果也是4.76比特。

一万个字母共有47600比特的信息量。

如果考虑各个字母出现的概率不相同,那么每个字母的平均信息量为I=-ΣP i logP i (2)根据统计结果,英文字母的出现概率如下表所示:字母概率字母概率字母概率空格0.2S0.052Y,W0.012E0.105H0.047G0.011T0.072D0.035B0.0105O0.0654L0.029V0.008A0.063C0.023K0.003N0.059F,U0.0225X0.002I0.055M0.021J,Q,Z0.001R0.054P0.0175把它们代入(2)式可以算出每个字母的平均信息量为4.03比特。

由此可见,字母的出现概率愈均匀,信息量愈大,反之就愈小。

在极端情况下,假设27个字母中有26个出现的概率为零,一个字母出现的概率为1,则信息量为零。

从上述的例子可以看到,字母以等概率出现时,每个字母所含的信息量最大。

信息论汉字熵

对于信息论的认识二十世纪四十年代末C E SHANNON建立了一套计算信息数量的方法。

我们可以根据事情发生概率的大小,用下式计算信息量 I :I=-log2P (1)式中P是收到的消息中所指的事件的概率。

信息量的单位简称‘比特’bit(它来自英语binary的 b和 digit的it,笔者注) 。

有了(1)式,我们就可以对信息进行定量计算。

例如,通常中文电报是四位阿拉伯数字。

假定每个阿拉伯数字出现的可能性是相同的,即每个数字出现的概率为十分之一。

那么我们可以计算出收到每个阿拉伯数字所含的信息量为I=-log21/10=3.3比特,因而每个汉字是4×3.3=13.2比特。

下面我们计算一封10000个字母的英文信所含的信息量。

假定每个字母都以等可能性出现,英文字母共26个,把空白也算作一个字母,那么共有27个字母。

于是每个字母出现的概率为1/27。

每个字母的信息量均为-log21/27=4.76比特。

拿27个字母来平均,得到的结果也是4.76比特。

一万个字母共有47600比特的信息量。

如果考虑各个字母出现的概率不相同,那么每个字母的平均信息量为I=-ΣP i logP i (2)根据统计结果,英文字母的出现概率如下表所示:把它们代入(2)式可以算出每个字母的平均信息量为4.03比特。

由此可见,字母的出现概率愈均匀,信息量愈大,反之就愈小。

在极端情况下,假设27个字母中有26个出现的概率为零,一个字母出现的概率为1,则信息量为零。

从上述的例子可以看到,字母以等概率出现时,每个字母所含的信息量最大。

要传输同样的信息量,字母以等概率出现时所需的长度(即字母个数)最短。

从传输信息量的角度来看,这是最理想的情况。

因为可以用最少的字母传递最多的信息量。

然而,实际的语言或文字总是达不到上述的极限。

就是说,传输同样的信息量需要较多的字母,具有一定的多余性。

从信息量的角度来看,这似乎是不利的。

但是,我们将会看到,由有了多余性,使人类的语言或文字具有一定的抗干扰能力。

汉字信息熵

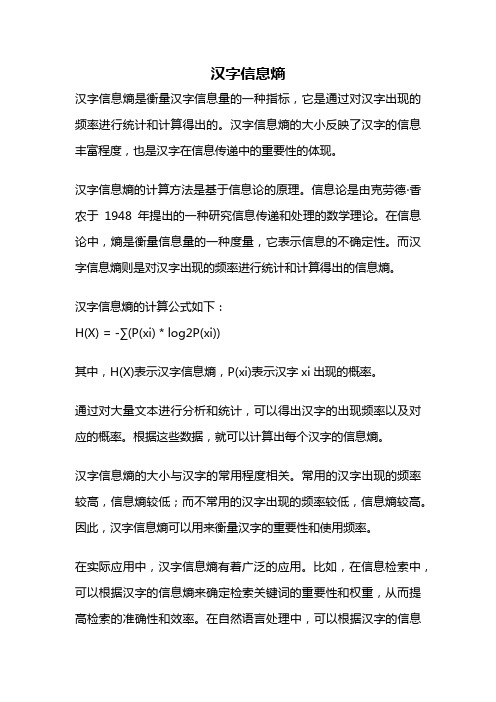

汉字信息熵汉字信息熵是衡量汉字信息量的一种指标,它是通过对汉字出现的频率进行统计和计算得出的。

汉字信息熵的大小反映了汉字的信息丰富程度,也是汉字在信息传递中的重要性的体现。

汉字信息熵的计算方法是基于信息论的原理。

信息论是由克劳德·香农于1948年提出的一种研究信息传递和处理的数学理论。

在信息论中,熵是衡量信息量的一种度量,它表示信息的不确定性。

而汉字信息熵则是对汉字出现的频率进行统计和计算得出的信息熵。

汉字信息熵的计算公式如下:H(X) = -∑(P(xi) * log2P(xi))其中,H(X)表示汉字信息熵,P(xi)表示汉字xi出现的概率。

通过对大量文本进行分析和统计,可以得出汉字的出现频率以及对应的概率。

根据这些数据,就可以计算出每个汉字的信息熵。

汉字信息熵的大小与汉字的常用程度相关。

常用的汉字出现的频率较高,信息熵较低;而不常用的汉字出现的频率较低,信息熵较高。

因此,汉字信息熵可以用来衡量汉字的重要性和使用频率。

在实际应用中,汉字信息熵有着广泛的应用。

比如,在信息检索中,可以根据汉字的信息熵来确定检索关键词的重要性和权重,从而提高检索的准确性和效率。

在自然语言处理中,可以根据汉字的信息熵来进行文本分类和语义分析,从而实现智能化的文本处理和理解。

汉字信息熵还可以用来研究汉字的演化和变异规律。

通过对不同时期和不同地域的汉字信息熵进行比较,可以了解汉字的变化和发展规律,从而推测汉字的起源和演化过程。

汉字信息熵是衡量汉字信息量的一种重要指标,它可以用来衡量汉字的重要性和使用频率,也可以用来进行文本处理和语义分析。

汉字信息熵的研究对于汉字的保护、发展和应用都具有重要的意义。

通过对汉字信息熵的深入研究,可以更好地理解和利用汉字这一独特的文化符号。

汉字的熵及熵率计算(信息论课堂论文)

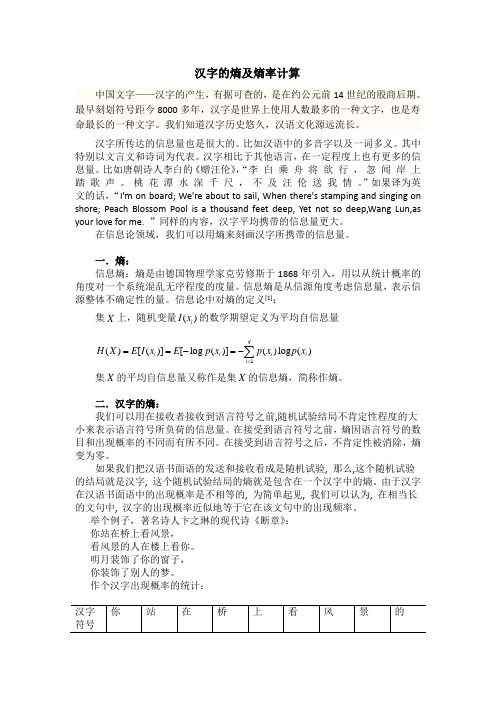

汉字的熵及熵率计算中国文字——汉字的产生,有据可查的,是在约公元前14世纪的殷商后期。

最早刻划符号距今8000多年,汉字是世界上使用人数最多的一种文字,也是寿命最长的一种文字。

我们知道汉字历史悠久,汉语文化源远流长。

汉字所传达的信息量也是很大的。

比如汉语中的多音字以及一词多义。

其中特别以文言文和诗词为代表。

汉字相比于其他语言,在一定程度上也有更多的信息量。

比如唐朝诗人李白的《赠汪伦》,“李 白 乘 舟 将 欲 行 , 忽 闻 岸 上 踏 歌 声 。

桃 花 潭 水 深 千 尺 , 不 及 汪 伦 送 我 情 。

”如果译为英文的话,“I'm on board; We're about to sail, When there's stamping and singing on shore; Peach Blossom Pool is a thousand feet deep, Yet not so deep,Wang Lun,as your love for me. ”同样的内容,汉字平均携带的信息量更大。

在信息论领域,我们可以用熵来刻画汉字所携带的信息量。

一.熵:信息熵:熵是由德国物理学家克劳修斯于1868年引入,用以从统计概率的角度对一个系统混乱无序程度的度量。

信息熵是从信源角度考虑信息量,表示信源整体不确定性的量。

信息论中对熵的定义[1]:集X 上,随机变量()i I x 的数学期望定义为平均自信息量1()[()][log ()]()log ()qi i i i i H X E I x E p x p x p x ===-=-∑集X 的平均自信息量又称作是集X 的信息熵,简称作熵。

二.汉字的熵:我们可以用在接收者接收到语言符号之前,随机试验结局不肯定性程度的大小来表示语言符号所负荷的信息量。

在接受到语言符号之前,熵因语言符号的数目和出现概率的不同而有所不同。

在接受到语言符号之后,不肯定性被消除,熵变为零。

熵简单解释

熵简单解释熵(entropy)是一个非常重要的概念,在热力学、信息论、统计物理学等领域都有广泛的应用。

然而,对于普通人来说,熵是一个非常抽象的概念,很难理解。

本文将尝试用尽可能简单的语言,解释熵的概念和意义。

1. 熵的定义熵最早是由德国物理学家克劳修斯(Rudolf Clausius)在19世纪提出的。

他把熵定义为一个系统的无序程度,也就是系统的混乱程度。

熵越大,系统越混乱,熵越小,系统越有序。

这个定义非常直观,但是也有一些问题,因为它没有明确说明“无序”和“有序”是什么意思。

后来,美国物理学家布里丹(Ludwig Boltzmann)提出了更加精确的定义。

他把熵定义为系统的微观状态数的对数。

也就是说,如果一个系统有N个微观状态,那么它的熵就是lnN(其中ln是自然对数,以e为底的对数)。

这个定义比较抽象,但是它更加准确地描述了熵的本质。

2. 熵的意义熵的意义非常重要,因为它涉及到了自然界的基本规律。

熵是一个系统的混乱程度,也就是说,它描述了系统的无序程度。

这个无序程度与能量转化的效率有关系。

例如,如果一个发动机的熵越小,那么它的能量转化效率就越高。

这是因为熵越小,系统越有序,能量转化的过程就越容易进行。

相反,如果熵越大,系统越混乱,能量转化的效率就越低。

熵的意义还涉及到了自然界的趋势。

根据热力学第二定律,一个孤立系统的熵总是趋向于增加。

也就是说,自然界的趋势是朝着混乱和无序的方向发展的。

这个趋势是不可逆转的,因为熵的增加是一个热力学过程,它需要能量的输入才能逆转。

3. 熵的计算熵的计算需要知道系统的微观状态数。

微观状态是指系统中每一个粒子的状态,包括它的位置、速度、自旋等等。

对于一个大的系统来说,微观状态数是非常巨大的,通常是以指数形式增长的。

因此,熵的计算非常困难,需要借助于统计物理学的方法。

统计物理学是一门研究系统微观状态和宏观性质之间关系的学科。

它的基本假设是,一个系统的微观状态是随机的,所有可能的微观状态出现的概率是相等的。

信息论举例信息量熵和互信息量

第二次测量取得旳信息量:

I ( p2 (x))

I ( p3(x))

log

1 p2 (x)

log

1 p3 ( x)

2

1 1(bit)

第三次测量取得旳信息量:

1

1

I ( p3(x)) I ( p4 (x)) log p3(x) log p4 (x) 1 0 1(bit)

故共需要3bit信息量.

信源熵

显然,H(X)>>H(Y),这表达信源X旳平均不稳 定性远远不小于信源Y旳平均不稳定性。

条件自信息量

前面我们引入自信息量以及熵旳概念,用

以描述信源或信宿,实际上,信宿收到旳消息

是与信源发出旳消息亲密有关。而且接受信息

与发送信息之间旳关系往往是鉴定一种信道旳

好坏旳最佳原则。所以,我们需要引入互信息

量。在学习互信息量之前我们先来了解条件信

码字

000 001 010 011 100 101 110 111

先验概率

1/4 1/4 1/8 1/8 1/16 1/16 1/16 1/16

收到0后 1/3 1/3 1/6 1/6 0 0 0 0

消息后验概率 收到01后 0 0 1/2 1/2 0 0 0 0

收到011后 0 0 0 1 0 0 0 0

[解]由定义有:

H

(X)源自214log

1 4

2

1 8

log

1 8

4

116log

1 16

2.75(比特/符号)

我们再回过头来看一下例3中两个信源熵分

别是多少, 成果反应了一种怎样旳事实? [例3解答]由定义有:

HX 0.5log0.5 0.5log0.5 1 HY 0.99log0.99 0.01log0.01 0.08

汉字的熵及熵率计算(信息论课堂论文)

汉字的熵及熵率计算中国文字——汉字的产生,有据可查的,是在约公元前14世纪的殷商后期。

最早刻划符号距今8000多年,汉字是世界上使用人数最多的一种文字,也是寿命最长的一种文字。

我们知道汉字历史悠久,汉语文化源远流长。

汉字所传达的信息量也是很大的。

比如汉语中的多音字以及一词多义。

其中特别以文言文和诗词为代表。

汉字相比于其他语言,在一定程度上也有更多的信息量。

比如唐朝诗人李白的《赠汪伦》,“李 白 乘 舟 将 欲 行 , 忽 闻 岸 上 踏 歌 声 。

桃 花 潭 水 深 千 尺 , 不 及 汪 伦 送 我 情 。

”如果译为英文的话,“I'm on board; We're about to sail, When there's stamping and singing on shore; Peach Blossom Pool is a thousand feet deep, Yet not so deep,Wang Lun,as your love for me. ”同样的内容,汉字平均携带的信息量更大。

在信息论领域,我们可以用熵来刻画汉字所携带的信息量。

一.熵:信息熵:熵是由德国物理学家克劳修斯于1868年引入,用以从统计概率的角度对一个系统混乱无序程度的度量。

信息熵是从信源角度考虑信息量,表示信源整体不确定性的量。

信息论中对熵的定义[1]:集X 上,随机变量()i I x 的数学期望定义为平均自信息量1()[()][log ()]()log ()qi i i i i H X E I x E p x p x p x ===-=-∑集X 的平均自信息量又称作是集X 的信息熵,简称作熵。

二.汉字的熵:我们可以用在接收者接收到语言符号之前,随机试验结局不肯定性程度的大小来表示语言符号所负荷的信息量。

在接受到语言符号之前,熵因语言符号的数目和出现概率的不同而有所不同。

在接受到语言符号之后,不肯定性被消除,熵变为零。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

对于信息论的认识二十世纪四十年代末C E SHANNON建立了一套计算信息数量的方法。

我们可以根据事情发生概率的大小,用下式计算信息量 I :I=-log2P (1)式中P是收到的消息中所指的事件的概率。

信息量的单位简称‘比特’bit(它来自英语binary的 b和 digit的it,笔者注) 。

有了(1)式,我们就可以对信息进行定量计算。

例如,通常中文电报是四位阿拉伯数字。

假定每个阿拉伯数字出现的可能性是相同的,即每个数字出现的概率为十分之一。

那么我们可以计算出收到每个阿拉伯数字所含的信息量为I=-log21/10=3.3比特,因而每个汉字是4×3.3=13.2比特。

下面我们计算一封10000个字母的英文信所含的信息量。

假定每个字母都以等可能性出现,英文字母共26个,把空白也算作一个字母,那么共有27个字母。

于是每个字母出现的概率为1/27。

每个字母的信息量均为-log21/27=4.76比特。

拿27个字母来平均,得到的结果也是4.76比特。

一万个字母共有47600比特的信息量。

如果考虑各个字母出现的概率不相同,那么每个字母的平均信息量为I=-ΣP i logP i (2)根据统计结果,英文字母的出现概率如下表所示:把它们代入(2)式可以算出每个字母的平均信息量为4.03比特。

由此可见,字母的出现概率愈均匀,信息量愈大,反之就愈小。

在极端情况下,假设27个字母中有26个出现的概率为零,一个字母出现的概率为1,则信息量为零。

从上述的例子可以看到,字母以等概率出现时,每个字母所含的信息量最大。

要传输同样的信息量,字母以等概率出现时所需的长度(即字母个数)最短。

从传输信息量的角度来看,这是最理想的情况。

因为可以用最少的字母传递最多的信息量。

然而,实际的语言或文字总是达不到上述的极限。

就是说,传输同样的信息量需要较多的字母,具有一定的多余性。

从信息量的角度来看,这似乎是不利的。

但是,我们将会看到,由有了多余性,使人类的语言或文字具有一定的抗干扰能力。

有时候,我们甚至人为地加入一些多余性以换取较强的抗干扰能力。

所谓抗干扰编码就是这样做的。

英文的多余性,不但表现在字母出现的概率不相等,而且还表现在字母前后之间有一定的相关性。

例如,前一个字母是T,跟着的字母是H的可能性就比较大。

T后面跟着Q几乎是不可能的。

同样,IN后面是G的可能性较大,而后面是Y的可能性较小。

如果考虑英文中的两个字母、三个字母或多个字母同时出现的概率,那么英文的多余性更大,也就是每个字母平均含的信息量更少。

SHANNON用实验方法测定了英文句子里每个字母所含的信息量约为1.9比特左右。

比起字母等概率的情况(4.76比特),常用英语的多余性是很大的。

SHANNON的实验是先写一个英文句子,包括空白在内共103个字母。

找一个人来猜这个句子。

从第一个字母猜起,直到把整个句子猜出来为止。

把对每个字母猜测的次数记录下来。

整个句子总共要猜198次。

把猜测次数除以字母数就得到每个字母的信息量为1.94。

用不同的实验方法测定英文字母所含的信息量,发现出入不大,都是1.9比特左右。

信息论将无始无终的信息理出了头绪,有一点像笛卡尔为无限的空间设立了坐标。

将信息量定义为I=-log2P是因为在计算信息的时候需要将每个个体信息与整体信息同时对比、考虑,P已经将个体与整体联系在一起了。

所谓的信息量并不是真正代表信息的数量,而是各个符号之间相互区别的能力。

也可以认为是将整个人类的知识划分成多少份的一个指标。

汉字熵熵,是物理名字,在信息论里则叫信息量。

从控制论的角度来看,应叫不确定性。

当我们不知道某事物具体状态,却知道它有几种可能性时,显然,可能性种类愈多,不确定性愈大。

不确定性愈大的事物,我们最后确定了、知道了,这就是说我们从中得到了愈多的信息,也就是信息量大。

所以,熵、不确定性、信息量,这三者是同一个数值。

事情好像很简单,其实不然。

试考虑还没有发明数字的远古人,他用刻画来记数,用刻n画的方法记数目n。

10以内的数平均每个数要刻(1+10)/2=5.5画,每画的平均信息量是3.32/5.5=0.604,而100以内的数平均每个数(1+100)/2=50.5画,每画的平均信息量只有6.64/50. 5=0.132。

因为古人刻的每一画是没有次序或位置的区别的,所以每一画的信息量随画的数量增加而快速减小。

次序或位置非常重要,罗马字和我国古代的数码,也是短画,但要讲究位置组合,每画所含的信息量就大大提高了。

我们讨论的文字信号,都是有次序的。

英文有26个字母,每个字母的信息量H=㏒(26)/㏒(2)=4.700。

汉字个数不定,算1000个时等于3*3.32=9.96,算作一万、十万时则分别为13.28、16.60。

我们是否能随意增加大量一辈子也用不到的汉字,来无限地增加每个汉字的信息量?按这个公式计算汉字的信息量时,汉字的平均信息量在字数达到1000时很快增至9.00,字数达到5000时就达到9.65,以后几乎不再增加。

学者冯志伟有一个“汉字容量极限定律”,认为字数达到12366后,信息量不再增加。

以下是各种语言的字母的平均信息量:法文 3.98比特意大利文 4.00比特西班牙文 4.01比特英文 4.03比特德文 4.10比特罗马尼亚文 4.12比特俄文 4.35比特中文9.65比特有人用小样本统计数据,计算得英文的信息量是4.16。

这个数值稍大些,是因加了一个特殊字符“空格”,㏒(27)=4.755就比㏒(26)大0.055。

可见平均信息量是很稳定的。

多余度由上可知,有n个符号的文字,每个字符最大的信息量(最大熵)H0=㏒(n)(即-㏒(1/n)),当概率不相等时,其平均信息量(平均熵)H=-∑p i㏒(p i)总小于最大信息量H0。

例如英文的最大信息量等于4.7,就要用5个二进制数码来编码和传输。

但它的平均信息量近于4.03,表示实际上可用比4个多一点点的二进制位就可以了。

方法是用不等长的编码,概率小的用长码(多于4位),概率大的用短码(少于4位)。

信息量的计算就可指导我们编码设计,减小码长,提高通信效率。

文字符号除了一定的概率分布包含了一部分信息外,文字的上下文关系,包含了更多的信息。

因为已知一定的前文,且已知前文愈长,其后的文字符号分布将更确定。

计算条件信息达到的最小的信息量,称为极限信息量(极限熵)H L。

我们可以进一步研制使传输更快的编码,即不是对个别文字符号,而是对文字串进行编码,就可使平均码长减小,逼近极限熵。

这就像我们直接对中文词或句子编码可以提高输入速度一样,因为许多汉字组合是不可能出现的。

据研究,英文和中文的极限熵为:英文:0.93~1.56比特中文:3.45~5.78比特一个汉字相当于3.7个英文字母。

极限熵H L比最大熵H0小得多,它们之间的差很大,说明这一部分熵是多余的,被浪费了。

信息论研究这样的多余度:R=(1-H L/H0)×100﹪把以上数据代入公式,可以算得多余度如下:英文:1-0.93/4.7=80﹪~1-1.56/4.7=67﹪中文:1-3.45/13.29=74﹪~1-5.78/13.29=56﹪(注:汉字的最大熵以1万个汉字计,即H0=㏒2(10000)=13.29)可见中文的多余度略小。

“一个汉字相当于3.7个英文字母”,若按此计算,中文比英文的效率高一倍左右(因为无论存储还是传输,每个汉字都占2个字节,印刷也是每个汉字占两个字母的位置,却相当于3.7个字节的作用,故3.7/2=1.85倍)。

中文比英文简洁,联合国的5种文件以中文的最薄,则是事实。

信息论上研究多余度,是为了用编码方法提高传输速度,多余度高时作用更大。

但计算机上每个字符都是用等长码,没有使用提高速度的编码方法,在这种情况下,文字的多余度小即浪费小,反而有利。

在通讯上,有时会有意增加多余度,提高纠错能力,保证可靠性。

最常见的是奇偶效验和冗余和。

冗余和是发送的一组码的和。

多余度高,信息字符有缺损时,就有可能恢复。

在计算机上研制这样的软件,利用条件概率的统计规律进行恢复,并不容易。

而印刷或手写文字的恢复,由于汉字的二维结构信息大,则更容易些,所以汉字的计算机识别也比英文好。

目前信息界,“汉字优越论”者不恰当地把汉字熵远大于英文熵当作优点,实际上这却是问题的根源所在。

作为阅读对象,汉字信息量确实大,是优点。

但作为信息化(数字化)的对象,汉字信息量(熵)大却是坏事。

熵是通讯理论用来估算被编码对象的平均码长的。

被编码的元素必须有限,有定数,大概还没有在几万个汉字上应用这一理论。

集合元素多,熵必然大。

如果对汉字笔画编码,相应的熵反而小,见下表:编码对象元素数目x 最大熵lg(x ) 平均熵极限熵英文字母 26 4.70 4.03 0.93-1.56 汉字笔画 25 4.64 3.43英文字 3900(实际100万) 11.93 9.35汉字 6759(实际13万) 12.72 9.65 3.45-5.78 最后两行最大熵和平均熵的计算,是对6759个汉字和仅3900英文字(一本英文书)进行的。

实际上汉字数可达13万,英文字达50万甚至有说100万以上。

这里用的英文字统计量是太小了,但平均熵已达9.35,如果统计英文字数超过1万,达10万以上,其平均熵必大于汉字熵。

而以汉字笔画为基础计算的笔画平均熵为3.43,远小于英文字母的4.03。

这是在取笔画数目为25个,与英文字母数相近时取得的,如果笔画种类分得更少,熵将更小。

最常用的一万个英文单词的词频表,我们计算一下,平均每个英文单词的熵值是8.83,可是每个单词的平均字母数是7.16,加上空格是8.16, 动态平均码长是4.12,加上空格是5.12个字母。