用c++对感兴趣区域的提取

形状标记图和Gabor小波的交通标志识别

i in sta so me n o v r u r n ai n n c l v l ti g sb he Ga o v lt n he man f a tc sg swa r n fr d i t a o so e tto sa d s a ewa ee ma e y t b rwa e e ,a d t i e . i i

Tr f c sg e o n to a e n s a e sg a u e a d Ga o v lt a i i n r c g ii n b s d o h p i n t r n b r wa e e s

GU i g i M n q n,CAIZii g,HE Fe f n xn ne

p r vco ahn a p l dt jdetet e frfcs n .E p r etleu s hw ta t rp sda o ot et m c ie sapi g p a i i s x e m na rsl o th po oe l - r w e ou h y o t f g i ts h e g

i e db rhlg a i aepo es .2)T es n t eo erg no trs R I a xrc da ft e ymop ooi l m g rcsig lr c n h i a r ft ei f neet( o )w set t sa g u h o i ae

foc算法原理

foc算法原理

在计算机视觉和图像处理中,FOC(Focus of Attention)算法是一种用于确定图像中感兴趣区域的算法。

FOC算法旨在模拟人眼对视觉场景的关注点,以便集中处理和分析最相关的信息。

以下是FOC算法的一般原理:

1. 图像特征提取:FOC算法首先对图像进行特征提取,以识别可能的感兴趣区域。

这些特征可能包括颜色、纹理、边缘等。

2. 区域分割:基于提取到的图像特征,算法会对图像进行区域分割,将图像划分为不同的区域。

这些区域代表了图像中具有相似特征的部分。

3. 关注度计算:对每个区域进行关注度计算,以确定该区域在整个图像中的重要性。

关注度计算可以根据不同的规则和算法进行,其中可能包括颜色强度、纹理对比度、边缘密度等因素。

4. 生成关注图:将计算得到的关注度映射到原始图像上,生成关注图。

在关注图中,亮度或颜色较高的区域表示在FOC算法中被认为是重要的区域。

5. 感兴趣区域提取:基于生成的关注图,FOC算法确定最终的感兴趣区域,这些区域在图像分析或处理中可能会受到重点关注。

FOC算法的实现可以采用各种技术和方法,包括机器学习、模型训练、图像处理等。

这使得FOC算法能够根据特定的应用场景和需求进行调整和优化。

总体而言,FOC算法的目标是通过模拟人眼的注意机制,自动确定图像中最引人注目的区域,从而提高计算效率和系统性能。

智能制造中的机器视觉检测技术考核试卷

A.使用稳定的硬件平台

B.优化算法减少计算时间

C.环境控制减少光照变化

D.定期维护和校准设备

17.在机器视觉中,以下哪些技术可用于动态场景的检测?()

A.高速摄像

B.连续自动对焦

C.运动估计和补偿

D.静态图像处理

18.以下哪些是机器视觉系统中的图像处理步骤?()

1.机器视觉检测技术只能应用于静态场景的检测。()

2.在机器视觉系统中,光源的选择对图像质量没有影响。()

3.深度学习模型在机器视觉中可以替代传统的人工特征提取方法。()

4.机器视觉检测系统中,镜头的畸变可以通过软件校正完全消除。()

5.机器视觉系统中的图像传感器分辨率越高,检测速度越快。()

6.在机器视觉中,使用结构光技术可以实现高精度的三维测量。()

()

标准答案

一、单项选择题

1. C

2. C

3. C

4. B

5. C

6. D

7. D

8. D

9. D

10. C

11. B

12. D

13. A

14. D

15. D

16. D

17. C

18. A

19. C

20. C

二、多选题

1. ABCD

2. ABC

3. ABCD

4. ABCD

5. ABC

6. ABC

7. ABCD

()

2.描述深度学习在机器视觉检测中的具体应用,并分析其相较于传统图像处理技术的优势。

()

3.论述机器视觉系统在设计和实施过程中需要考虑的主要因素,以及这些因素如何影响系统的性能。

晶圆缺陷检测原理

晶圆缺陷检测原理晶圆缺陷检测(Wafer defect inspection)是半导体制造过程中不可或缺的一环。

它是将一个晶圆上的所有芯片边缘和表面进行精细扫描,寻找潜在或已存在的缺陷,以便于制造商确定晶圆是否合格,以及确定是否需要进行后续操作或废弃。

晶圆缺陷可能来源于很多方面,例如:在晶圆制造的各个环节中出现了污染或机器设备故障,或者手动处理等过程中人为因素造成的人为因素。

因此,精确检测是否存在缺陷非常重要。

晶圆缺陷检测的原理是基于模式比较。

其过程往往采用多种技术,包括光学、实际测量、声学等。

这些技术可以分类为两类:一种是基于表面的,另外一种是基于体积的。

基于表面的方法可以检测晶圆上的缺陷,而基于体积的技术则可以检测晶圆内部的缺陷。

下面我们对晶圆缺陷检测的原理进行更详细的解释。

基于表面缺陷的检测方法通常,晶圆缺陷检测主要采用光学技术。

它使用各种光源和摄像机,通过照明和影像来检测晶圆上的表面缺陷。

这些缺陷可能包括瑕疵、污染、芯片的附加元件、沟槽、斑点等。

这些缺陷有时会很微小,甚至小于芯片的尺寸,必须进行高精度的检测。

1. 感兴趣区域(ROI)选择在进行检测的时候,晶圆通常会被分成很多区域。

每个感兴趣的区域需要被设计出来。

这些区域通常包括芯片区域和其他的一些区域。

2. 检测器矫正通常,使用的检测器都要经过矫正,以获得准确的信号和像素计数。

在使用检测器之前,通常需要进行检测器的矮化(噪声降低)、平坦化和校正。

3. 图像分析图像分析,是晶圆缺陷检测的关键环节。

在这一步骤中,应该尽可能利用图像处理算法,提取出各个区域内的缺陷。

这些算法通常包括过滤器、数字卷积、边界检测器等。

检测到的缺陷通常被标记为无用、可疑、或是警告。

对于基于体积缺陷的检测方法,常常使用的技术是透射率和声波技术。

1. 透射率该方法通过测量透射率和反射率,使将被测试的物体放在光源旁边,并检测透射率和反射率,从而检测物体的厚度、密度和构造状况。

用VC编程实现BMP图像裁切

5.5 用VC编程实现BMP图像裁切随着计算电子技术和计算机技术的发展,数字图像处理进入高速发展时期,许多成熟的图像处理软件如雨后春笋般层出不穷。

在大多数图像处理软件中都有图像裁切功能,用它能够快速提取感兴趣区域,去掉多余的图像内容。

那么怎样编程实现图像裁切呢,下面以BMP图像为例介绍一下如何用VC实现图像裁切。

先介绍第一种方法,将图像数据全部读入内存,然后将感兴趣区域裁切下来。

在许多数字图像处理的书中都有关于BMP图像存储结构的章节,这里就不再详细介绍了。

BMP文件一般分为四个部分:位图头文件、位图信息头、调色板和图像数据。

图像裁切要用到位图信息头中的几个参数值:biWidth(图像宽度)、biHeight(图像高度)、biBitCount(每个像素的位数)、biSizeImage(图像长度)。

图像裁切首先要确定裁切区域内每个像素在整幅图像中的位置,我们以裁切区域中心点像素位置起算,要注意的是图像数据的存储是从最下面一行的左边开始的。

如下图,Height是图像高,Width是图像宽,ctPoint是裁切区域中心点坐标,dwX和dwY分别是裁切区域的宽和高。

以256色图像为例(每个像素占一个字节),裁切区域左下角像素(也就是裁切后图像的第一个像素)位置为(Height-ctPoint.y-dwY/2-1)×Width+ctPoint.x-dwX/2,左下角像素位置确定了,裁切区域内的其他像素位置就很容易确定。

确定了裁切区域内每个像素的位置后,就可以把这些像素的值赋给裁切后图像的相应像素。

裁切后图像的位图信息头和调色板只要从原图像数据中拷贝就可以了,修改信息头中图像宽、高和长度值为裁切后的值。

按照上面的思路笔者用VC++ 6.0编写了一个图像裁切函数ClipDIB(),该函数首先计算裁切区域图像数据的大小,为裁切后的图像分配内存,然后将原图像的信息头、调色板拷贝给裁切后的图像,最后将原图像中裁切区域内的像素值赋给裁切后影像。

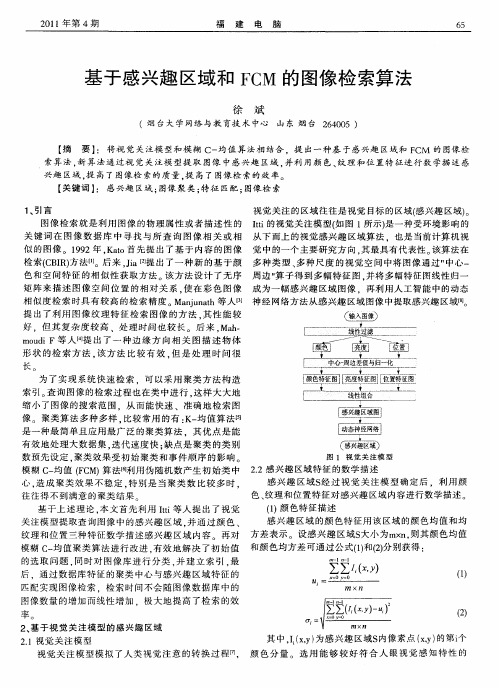

基于感兴趣区域和FCM的图像检索算法

粥

如 存 j使 d:则 := 对≠u 0 果 在r 得 o 令u l i,= , , , :且 r 。 ¨

() 下述公式 计算V ’ 3用 :

,

取 ,因此 合理选取 初始 类 中心 是聚类 算法 中最 重要 的 步 。本 文采用 了一 种 自适 应 的初 始聚类 中心 选取 方

感兴 趣 区域 的 颜 色特 征用 该区域 的颜 色均值 和均 方差 表示 。设 感 兴趣 区域S 大小 为m× , 其颜 色均 值 n则 纹理 和位 置三种 特 征数学 描 述感 兴趣 区域 内容 再对 1和( ) 模糊 C 均 值 聚类 算法 进行 改进 . 一 有效 地 解 决 了初 始值 和颜色 均方差 可通 过公 式() 2分别获 得 : 的选取 问题 , 时对 图像 库 进 行分 类 , 建 立 索 引 , 同 并 最 后 .通过 数 据库特 征 的聚类 中心与感 兴 趣 区域 特 征 的

21视觉关 注模型 .

其 中, x ) I , 为感 兴 趣 区域S ; Y 内像素 点 x ) , 的第i y 个

视 觉 关注 模 型模 拟 了 人类 视觉 注 意 的转 换 过 程[ 颜 色 分 量 。选 用 能 够 较 好 符 合 人 眼 视觉 感 知 特 性 的 7 1 ,

6 6

图 1 视 觉 关 注 模 型

. 模 糊 C 均值 (C 算法 『 一 F M) 句 利用 伪 随机数 产 生初 始 类 中 22感 兴趣 区域 特征 的数 学描 述 感 兴 趣 区域 S 过 视 觉 关 注模 型确 定 后 .利 用 颜 经 心 , 成 聚类 效 果 不稳 定 . 造 特别 是 当 聚类 数 比较 多 时 . 色、 纹理 和位置 特征对 感 兴趣 区域 内容进行数 学描述 。 往 往 得 不 到 满 意 的 聚 类 结 果 基 于上 述理 论 . 本文 首 先利用 Ii t 等人 提 出 了 视觉 t 关注模 型 提取查 询 图像 中 的感兴趣 区域 , 并通 过 颜 色 、 f1 色特 征描 述 1颜

CT旋转中心的精确确定方法

预备知识

预备知识

CT成像的基本原理是利用X射线穿透人体组织,不同组织对X射线的吸收程度 不同,导致探测器接收到的信号强度有所改变。通过对这些信号进行处理和计算, 可以重建出人体内部的二维图像。为了获得完整的三维图像,需要围绕人体旋转 CT设备,并从多个角度采集数据。

方法与步骤

1、选择合适的定位方法

基于特征定位的方法则是通过提取图像中的特征来确定旋转中心。这些特征 可以是病变区域、器官或特定的骨骼结构等。医生可以通过手动或自动的方式提 取这些特征,并计算出旋转中心的位置。

2、提取感兴趣区域

2、提取感兴趣区域

确定CT旋转中心需要先提取感兴趣区域,即需要进行定位的特定区域。这个 区域可以是病变区域或感兴趣的器官。为了提取感兴趣区域,医生需要先对原始 图像进行预处理,如去噪、平滑等,以突出显示目标区域。然后,医生可以利用 图像处理技术(如边缘检测、阈值分割等)来提取感兴趣区域。

3、确定CT旋转中心

3、确定CT旋转中心

提取到感兴趣区域后,医生需要根据该区域的特征来计算CT旋转中心的位置。 通常情况下,旋转中心被定义为感兴趣区域的重心或形心。医生可以通过以下步 骤来确定旋转中心形心, 确定旋转中心的位置

2、根据计算得到的质心或形心,确定旋转中心的位置

一、背景与问题

一、背景与问题

工业CT系统是一种用于检测物体内部结构及物理特性的无损检测技术。该技 术利用X射线源和探测器对物体进行多角度的扫描,并通过计算机断层扫描技术 重建物体内部的3D结构。然而,准确地确定转台的旋转中心是一个重要的问题。 如果旋转中心的位置不准确,那么重建的3D结构可能会出现偏差,影响检测结果 的准确性。

内容摘要

接下来,利用计算机视觉中的模板匹配技术,将这些特征与预先定义的模板 进行匹配,以确定旋转中心的位置。通过不断调整模板的位置和大小,直到找到 最佳匹配的位置,即可以确定出旋转中心。

C语言实现opencv提取直线、轮廓及ROI实例详解

C语⾔实现opencv提取直线、轮廓及ROI实例详解⼀、Canny检测轮廓在上⼀篇⽂章中有提到sobel边缘检测,并重写了soble的C++代码让其与matlab中算法效果⼀致,⽽soble边缘检测是基于单⼀阈值的,我们不能兼顾到低阈值的丰富边缘和⾼阈值时的边缘缺失这两个问题。

⽽canny算⼦则很好的弥补了这⼀不⾜,从⽬前看来,canny边缘检测在做图像轮廓提取⽅⾯是最优秀的边缘检测算法。

canny边缘检测采⽤双阈值值法,⾼阈值⽤来检测图像中重要的、显著的线条、轮廓等,⽽低阈值⽤来保证不丢失细节部分,低阈值检测出来的边缘更丰富,但是很多边缘并不是我们关⼼的。

最后采⽤⼀种查找算法,将低阈值中与⾼阈值的边缘有重叠的线条保留,其他的线条都删除。

本篇⽂章中不对canny的算法原理作进⼀步说明,稍后会在图像处理算法相关的⽂章中详细介绍。

下⾯我们⽤OpenCV中的Canny函数来检测图像边缘int main(){Mat I=imread("../cat.png");cvtColor(I,I,CV_BGR2GRAY);Mat contours;Canny(I,contours,125,350);threshold(contours,contours,128,255,THRESH_BINARY);namedWindow("Canny");imshow("Canny",contours);waitKey();return 0;}显⽰效果如下:⼆、直线检测⽤到的是霍夫变换检测直线的算法直线在图像中出现的频率⾮常之⾼,⽽直线作为图像的特征对于基本内容的图像分析有着很重要的作⽤,本⽂通过OpenCV中的hough变换来检测图像中的线条。

我们先看最基本的Hough变换函数HoughLines,它的原型如下:void HoughLines(InputArray image, OutputArray lines, double rho, double theta, int threshold, double srn=0, double stn=0 );它的输⼊是⼀个⼆值的轮廓图像,往往是边缘检测得到的结果图像;它的输出是⼀个包含多个Vec2f点的数组,数组中的每个元素是⼀个⼆元浮点数据对<rou,theta>,rou代表直线离坐标原点的距离,theta代表⾓度。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

一. 设计目的和意义通过设计,较全面地掌握各种图像提取算法的基本理论、原理和实现手段,并能分析感兴趣区域(ROI)提取效果及对进一步处理的影响,使学生具有一定综合分析问题和解决问题的能力。

二.设计内容和要求原始数据:所获取二值图像。

技术要求:(1)完成题目所要求技术:全面掌握与区域提取算法相关的基本理论、原理和实现手段;(2)通过仿真(实验)验证,编程实现对处理实景图像进行感兴趣区域提取的算法和实现手段,并进行结果分析。

设计要求:课程设计的目的在于培养学生的综合素质,要求学生做到:(1)根据题目要求查阅有关资料,确定方案,写出设计方案;(2)根据对选题的理解,消化查阅资料,给出相关的实现算法和理论根据;(3) 在Matlab或C++或VC环境下,实现算法,并给出仿真结果;(4) 对结果进行分析总结三.设计工作任务每个成员单独用一种方法,在Matlab或VC环境下运行程序,达到对图像感兴趣区域的提取的目的。

四.每种特征提取的代码和运行结果1 通过腐蚀实现轮廓提取(1)程序代码// DibImage.cpp: implementation of the CDibImage class.// DIB(Independent Bitmap) 函数://// PaintDIB() - 绘制DIB对象// CreateDIBPalette() - 创建DIB对象调色板// FindDIBBits() - 返回DIB图像象素起始位置// DIBWidth() - 返回DIB宽度// DIBHeight() - 返回DIB高度// PaletteSize() - 返回DIB调色板大小// DIBNumColors() - 计算DIB调色板颜色数目// CopyHandle() - 拷贝内存块//// SaveDIB() - 将DIB保存到指定文件中// ReadDIBFile() - 重指定文件中读取DIB对象//////////////////////////////////////////////////////////////////////#include "stdafx.h"#include "TemplateTrans.h"#include "DibImage.h"#include "math.h"#ifdef _DEBUG#undef THIS_FILEstatic char THIS_FILE[]=__FILE__;#define new DEBUG_NEW#endif//////////////////////////////////////////////////////////////////////// Construction/Destruction////////////////////////////////////////////////////////////////////// CDibImage::CDibImage(){}CDibImage::~CDibImage(){}//////////////////////////////////////////////////////////////////////// function////////////////////////////////////////////////////////////////////// BOOL CDibImage::Enhance(LPSTR lpDIBBits,LONG lWidth,LONG lHeight) {//边缘检测LPSTR lpSrc;LPSTR lpDst;LPSTR lpNewDIBBits;HLOCAL hNewDIBBits;long i,j;unsigned char n,e,s,w,ne,se,nw,sw;unsigned char pixel;hNewDIBBits=LocalAlloc(LHND,lWidth*lHeight);if(hNewDIBBits==NULL){return FALSE;}lpNewDIBBits=(char *)LocalLock(hNewDIBBits);lpDst=(char *)lpNewDIBBits;memset(lpDst,(BYTE)255,lWidth*lHeight);for(j=1;j<lHeight-1;j++){for(i=1;i<lWidth-1;i++){lpSrc=(char*)lpDIBBits+lWidth*j+i;lpDst=(char*)lpNewDIBBits+lWidth*j+i;pixel=(unsigned char)*lpSrc;if(pixel!=255&&pixel!=0)return FALSE;if(pixel==0){*lpDst=(unsigned char)0;nw=(unsigned char)*(lpSrc+lWidth-1);n=(unsigned char)*(lpSrc+lWidth);ne=(unsigned char)*(lpSrc+lWidth+1);w=(unsigned char)*(lpSrc-1);e=(unsigned char)*(lpSrc+1);sw=(unsigned char)*(lpSrc-lWidth-1);s=(unsigned char)*(lpSrc-lWidth);se=(unsigned char)*(lpSrc-lWidth+1);if(nw+n+ne+w+e+sw+s+se==0){*lpDst=(unsigned char)255;}} } }memcpy(lpDIBBits,lpNewDIBBits,lWidth*lHeight);LocalUnlock(hNewDIBBits);LocalFree(hNewDIBBits);return TRUE; }(2)运行结果源图像处理后的图像2自定义FCm函数对图片进行提取(1)程序代码data=imread('cameraman.tif'); %读入图片的像素矩阵 %data=ima();data=double(data);data=data/1000.0;%由于函数的需要,需将data矩阵中的数值转换格式,否则出错figure,imshow(data)%显示原始图片title ('原始图像')%将图片的像素矩阵转换为样本矩阵,该样本矩阵有65536行(把每个像素点作为一个样本% ,65536个样本值);%有1列(把像素点的灰度值作为样本的特征值)A=zeros(65536,1);%初始化A,为其分配空间A(1:65536)=data(1:65536);%将256*256的矩阵转化成为65536*1的矩阵data=A;% 转换结束后得到样本矩阵cluster_n=2;%标量,表示聚合中心数目,即类别数options=[2;257;1e-5;1]%初始化操作参数y=FCMClust(data, cluster_n, options)%调用模糊C子函数 FCMClust.m子程序1:% FCMClust.m 采用模糊C均值对数据集data聚为cluster_n类function [center, U, obj_fcn] = FCMClust(data, cluster_n, options) % 用法:% 1、[center,U,obj_fcn] = FCMClust(Data,N_cluster,options);% 2、 [center,U,obj_fcn] = FCMClust(Data,N_cluster);% 输入:% data ---- nxm矩阵,表示n个样本,每个样本具有m维特征值% N_cluster ---- 标量,表示聚合中心数目,即类别数% options ---- 4x1矩阵,其中% options(1): 隶属度矩阵U的指数,>1 (缺省值: 2.0)% options(2): 最大迭代次数 (缺省值: 100)% options(3): 隶属度最小变化量,迭代终止条件 (缺省值: 1e-5)% options(4): 每次迭代是否输出信息标志 (缺省值: 1)% 输出:% center ---- 聚类中心% U ---- 隶属度矩阵% obj_fcn ---- 目标函数值if nargin ~= 2 & nargin ~= 3, %判断输入参数个数只能是2个或3个error('Too many or too few input arguments!');enddata_n = size(data, 1); % 求出data的第一维(rows)数,即样本个数in_n = size(data, 2); % 求出data的第二维(columns)数,即特征值长度% 默认操作参数default_options = [2; % 隶属度矩阵U的指数257; % 最大迭代次数1e-5; % 隶属度最小变化量,迭代终止条件1]; % 每次迭代是否输出信息标志if nargin == 2,options = default_options;else%分析有options做参数时候的情况% 如果输入参数个数是二那么就调用默认的option;if length(options) < 4, %如果用户给的opition数少于4个那么其他用默认值; tmp = default_options;tmp(1:length(options)) = options;options = tmp;end% 返回options中是数的值为0(如NaN),不是数时为1nan_index = find(isnan(options)==1);%将denfault_options中对应位置的参数赋值给options中不是数的位置.options(nan_index) = default_options(nan_index);if options(1) <= 1, %如果模糊矩阵的指数小于等于1error('The exponent should be greater than 1!');endend%将options 中的分量分别赋值给四个变量;expo = options(1); % 隶属度矩阵U的指数max_iter = options(2); % 最大迭代次数min_impro = options(3); % 隶属度最小变化量,迭代终止条件display = options(4); % 每次迭代是否输出信息标志obj_fcn = zeros(max_iter, 1); % 初始化输出参数obj_fcn ,将其初始化为max_iter 行矩阵U = initfcm(cluster_n, data_n); % 初始化模糊分配矩阵即隶属矩阵,使U满足列上相加为1% Main loop 主要循环for i = 1:max_iter,%在第k步循环中改变聚类中心ceneter,和分配函数U的隶属度值;[U, center, obj_fcn(i)] = stepfcm(data, U, cluster_n, expo);if display,fprintf('FCM:Iteration count = %d, obj. fcn = %f\n', i, obj_fcn(i));end% 终止条件判别if i > 1,if abs(obj_fcn(i) - obj_fcn(i-1)) < min_impro,break;end,endenditer_n = i; % 实际迭代次数obj_fcn(iter_n+1:max_iter) = [];center;%显示最后的C值矩阵U;%显示最后的隶属度矩阵%通过隶属度矩阵和聚类中心实现图像的二值化,首先将图像的样本点的特征值聚类成两类for i=1:65536if (U(1,i)>U(2,i))data(i)=center(1);elsedata(i)=center(2);endend%恢复图像的像素矩阵---即由二值化后的样本矩阵回归像素矩阵b=zeros(256,256);b(1:65536)=data(1:65536);data=b;figure,imshow(data)%显示模糊C均值处理后的二值化图像title ('模糊C均值后的二值化图像')子程序2:% 子函数function U = initfcm(cluster_n, data_n)% 初始化fcm的隶属度函数矩阵% 输入:% cluster_n ---- 聚类中心个数% data_n ---- 样本点数% 输出:% U ---- 初始化的隶属度矩阵U = rand(cluster_n, data_n); %产生一个cluster_n*data_n的矩阵,其产生0-1之间的随机数col_sum = sum(U);% 返回包含A各列元素之和的一行,data_n列矩阵U = U./(ones(cluster_n,1)*col_sum);;%U点除以sum(U)为行向量的%cluster-n行矩阵以实现每列的元素之和为1即对其进行归一化处理子程序3:% 子函数function [U_new, center, obj_fcn] = stepfcm(data, U, cluster_n, expo)% 模糊C均值聚类时迭代的一步% 输入:% data ---- nxm矩阵,表示n个样本,每个样本具有m的维特征值% U ---- 隶属度矩阵% cluster_n ---- 标量,表示聚合中心数目,即类别数% expo ---- 隶属度矩阵U的指数% 输出:% U_new ---- 迭代计算出的新的隶属度矩阵% center ---- 迭代计算出的新的聚类中心% obj_fcn ---- 目标函数值mf = U.^expo; % 隶属度矩阵进行指数运算结果center = mf*data./((ones(size(data, 2), 1)*sum(mf'))') ;% 新聚类中心dist = distfcm(center, data); % 计算距离矩阵obj_fcn = sum(sum((dist.^2).*mf)); % 计算目标函数值tmp = dist.^(-2/(expo-1));U_new = tmp./(ones(cluster_n, 1)*sum(tmp)); % 计算新的隶属度矩阵子程序4:% 子函数function out = distfcm(center, data)% 计算样本点距离聚类中心的距离% 输入:% center ---- 聚类中心% data ---- 样本点% 输出:% out ---- 距离out = zeros(size(center, 1), size(data, 1));for k = 1:size(center, 1), % 对每一个聚类中心% 每一次循环求得所有样本点到一个聚类中心的距离out(k, :)=sqrt(sum(((data-ones(size(data,1),1)*center(k,:)).^2)',1)); end(2)运行结果源图像处理后的图像3通过调用FCM函数,采用模糊C均值处理对图像进行提取(1)程序代码data=imread('1.jpg'); %读入图片像素矩阵 %data=ima();data=double(data);data=data/1000.0; %由于函数的需要,需将data矩阵中的数值转换格式,否则出错figure,imshow(data)%显示原始图片title ('原始图像')%将图片的像素矩阵转换为样本矩阵,该样本矩阵有19600行(把每个像素点作为一个样本% ,19600个样本值);%有1列(把像素点的灰度值作为样本的特征值)A=zeros(19600,1);%初始化A,为其分配空间A(1:19600)=data(1:19600);%将140*140的矩阵转化成为19600*1的矩阵data=A;% 转换结束后得到样本矩阵[center,U,obj_fcn]=fcm(data,2);%调用fcm函数center;%显示最后的C值矩阵U;%显示最后的隶属度矩阵%通过隶属度矩阵和聚类中心实现图像的二值化,首先将图像的样本点的特征值聚类成两类for i=1:19600if (U(1,i)>U(2,i))data(i)=center(1);elsedata(i)=center(2);endend%恢复图像的像素矩阵---即由二值化后的样本矩阵回归像素矩阵b=zeros(140,140);b(1:19600)=data(1:19600);data=b;figure,imshow(data)%显示模糊C均值处理后的二值化图像title ('模糊C均值后的二值化图像')(2)运行结果源图像处理后的图像4通过设置门限进行二值化处理对图像进行提取(1)程序代码data=imread('cameraman.tif');%读入图片的像素矩阵 %data=ima(); data=double(data);data=data/1000.0;%由于函数的需要,需将data矩阵中的数值转换格式,否则出错imshow(data)%显示原始图片title ('原始图像')data%通过设置门限值对它进行二值化处理for i=1:65536if (data(i)>0.1)data(i)=1;elsedata(i)=0;endendfigure,imshow(data)%二值化图像title ('二值化图像')(2)运行结果源图像处理后的图像五. 实习总结及心得“多维信息处理实践”是电子技术课程的实践性教学环节,是对我们学习电子技术的综合性训练。