正向最大匹配分词算法的分析与改进

一种改进的中文分词正向最大匹配算法

21 0 1年 3月

计 算机 应 用与软 件

Co utr Ap lc to sa d S f r mp e p i ai n n o wae t

V0 _ l28 No. 3

M a . 01 r2 l

一

种 改 进 的 中 文 分 词 正 向 最 大 匹 配 算 法

t e s e d a d e ce c fC ie e W o e me tt n ag r h h v e n o vo sy i r v d h p e n f in y o h n s r s g n ai lo i m a e b e b iu l mp o e . i d o t Ke wo d y rs C i e e w r e me tt n W o a k F r r n x mu mac i g ag rt m h n s o d s g n ai o d r b n o wa d la i m t hn l o i h

p t fr a d a d a f ri r vn MM lo i m h ti o a sg h xmu tx 一 n t o b ra e y a c l a e n t e w r - u s o r n i e o mp o i g F w ag r h t a s t s in t e ma i m e t1 g h t e t td d n mi al b s d o 同 的 统 计 , 8—1 因 3字 的 词 所 占 比 例 较 小

0 引 言

中文 自动 分 词 是 中文 信 息 处 理 中 最 为 基 础 、 为重 要 的 问 最 题 , 汉语 文 本 自动 标 注 、 索 引擎 、 器 翻 译 等工 作 中 的 关 键 是 搜 机

正向最大字数分词法

正向最大字数分词法【实用版】目录1.介绍正向最大字数分词法2.解释分词原理3.分析正向最大字数分词法的优缺点4.举例说明正向最大字数分词法的应用5.总结正向最大字数分词法正文一、介绍正向最大字数分词法正向最大字数分词法,是一种常用的中文分词方法。

其原理是,从左到右扫描句子,将连续的文本分割成独立的词汇。

在这个过程中,每个词汇都以最大字数为单位进行分割,以保证词汇的完整性和准确性。

二、解释分词原理正向最大字数分词法的分词原理是基于字典的。

在分词过程中,程序会根据已有的字典库,对文本进行逐一匹配。

当遇到匹配的字典中的词汇时,便将该词汇作为分词结果提取出来。

同时,为了保证词汇的完整性,该方法规定每个词汇的字数必须达到最大字数,否则就不断提取词汇。

三、分析正向最大字数分词法的优缺点正向最大字数分词法具有以下优点:1.准确性高:基于字典库的分词方法,可以保证词汇的准确性。

2.效率高:从左到右扫描句子,分词速度快。

然而,正向最大字数分词法也存在以下缺点:1.不能处理未登录词:对于字典中没有的词汇,该方法无法进行处理。

2.词库限制:分词效果受到词库的影响,词库的质量直接关系到分词结果的质量。

四、举例说明正向最大字数分词法的应用假设有一个句子:“小明去公园打篮球。

”,采用正向最大字数分词法进行分词,结果为:“小明【2】去【1】公园【2】打【1】篮球【2】。

”可以看到,该方法将句子准确地分割成了独立的词汇。

五、总结正向最大字数分词法总的来说,正向最大字数分词法是一种准确性高、效率高的分词方法。

正向最大匹配分词算法的分析与改进

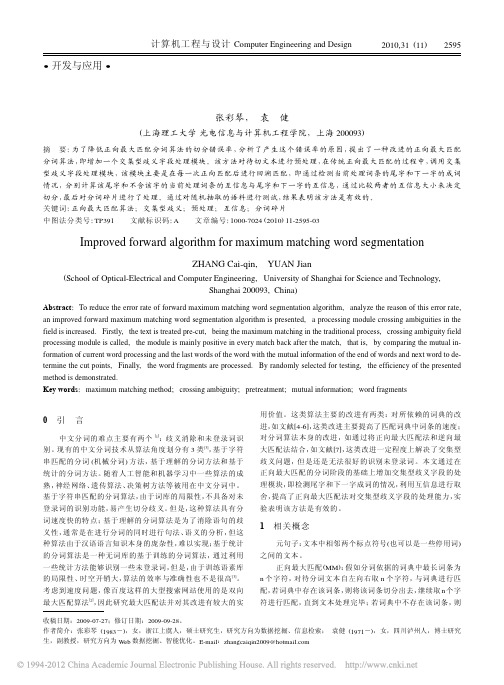

正向最大匹配分词算法的分析与改进摘要:本文主要通过对影响正向最大匹配算法效率的因素的分析,提出对该算法的一点改进,以及设计了相应的词典结构,以期在匹配过程中尽可能的减少比较次数,提高分词效率。

关键词:中文分词;最大匹配算法;词典机制0引言在自然语言处理中,“词是最小的能够独立活动的有意义的语言成分”[1],而汉语和英语等其它西文比起来,有着自身的特点。

英语、法语等欧美语言在书写时就以词为基本构成单位,以空格作为分词的依据;而汉语在书写时是一大串汉字的字符串,从形式上根本没有词的概念。

中文分词指的就是将一个汉字序列切分成一个一个单独的具有实际意义的词,它是中文信息处理的基础。

中文自动分词的现有的分词算法可分为三大类:基于字符串匹配的分词方法、基于理解的分词方法和基于统计的分词方法[2]。

在基于字符串匹配的分词算法中,词典的设计往往对分词算法的效率有很大的影响。

本文通过对影响正向最大匹配算法效率因素的分析,设计一种带词长信息的分词词典,同时在该词典基础上,对正向最大匹配算法做出一些改进,以提高分词的效率。

1正向最大匹配分词算法介绍和分析1.1 正向最大匹配分词算法介绍最大匹配算法是最基本的字符串匹配算法之一,它能够保证将词典中存在的最长复合词切分出来。

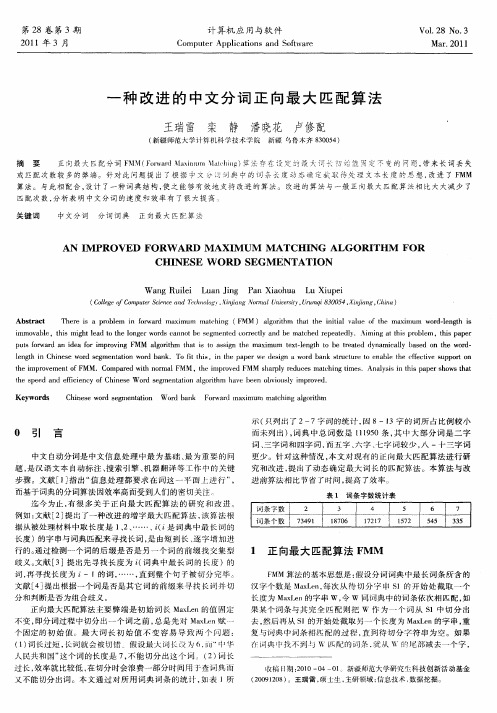

传统的正向最大匹配分词算法(Maximum Matching,简称MM算法)的算法流程如图1所示。

图1 MM 算法流程图假设分词词典中的最长词的字数为M,令其作为最大匹配系数。

假设读取的汉字序列字数为L,判断L是否小于最大匹配系数M。

如果L大于最大匹配系数M,则截取前M个汉字作为待匹配字段进行匹配,否则取整个汉字序列作为待匹配字段直接在分词词典中进行匹配。

若字典中存在这样一个字数为M的词,则匹配成功,匹配字段被作为一个词切分出来;若词典中找不到这样的词,则匹配失败,将待匹配字段中的最后一个字去掉,将剩下的汉字序列作为待匹配字段重新在字典中进行匹配处理……如此进行下去,直到匹配成功,即切分出一个词,或者直到剩余字串的长度为1为止,即为一个单字。

改进的正向最大匹配分词算法

(n-1,2),将 term3 与词表进行匹配: ①如果分词词典不包含 term3,将 term1 从待切元句子

中 切 分 出 去 ,继 续 步 骤 (1); ②如果分词词典包含 term3,转入交集型歧义处理模块。

2.3.3 交 集 型 歧 义 处 理 模块 比 如 对 如 下 例 子 “中 国 人 / 口 / 众 多”:Term1= 中 国 人 ;

本 文 提 出 改 进 的 最 大 匹 配 算 法 解 决 上 述 两 个 问 题 :通 过 互 信 息 的 比 较 ,来 提 高 未 登 录 词 识 别 ;通 过 回 溯 的 过 程 来 解 决 交集型歧义。 2.2 Improved- MM 算 法的 主 要 流 程

(1) 分词预处理; (2) 用正向最大匹配算法进行分词; (3) 通过回溯的过程,结合互信息消除交集型歧义; (4) 碎片检查。 2.3 算 法 详 细 步 骤 2.3.1 分 词 预 处 理 第 一 扫 描 首 先 将“,”、“;”、“!”等 标 点 符 号 用 标 签 隔 开 如“/”,第 二 遍 扫 描 在 比 如 英 文 字 符 ,标 点 符 号 ,数 字 ,其 它 非 汉 字 符 号 等 左 右 两 侧 插 入“/”,称 得 到 的 两 个 斜 杠 之 间 最 小 的 切分单元为元句子。 2.3.2 分 词 与 词 典 的 匹 配 机 制 取 决 于 词 典 本 身 的 数 据 结 构 、索 引 机 制 以 及 查 询 策 略 ,本 算 法 不 展 开 讨 论 。可 以 参 考 文 献 [4-6]。扫 描词典,读取最长词条的字符数设为 n。 (1)对当前处理元句子 Sentence,从一个字符起依次读取 n 个字符 ,若当 前 Sentence.length<n, 则取整 个元句 子,记 作 term1,term1=Sentence.substring(0,min(n, Sentence.length))。 (2) 如果分词词典不包含 term1,取 term1 的前 n-1 个字串 term2,用 term2 与词典进行匹配,若匹配成功,转入步骤(4);若

最大正向匹配分词算法

最大正向匹配分词算法简介分词是自然语言处理中的重要任务之一,它将连续的文本切分成有意义的词语或词组。

在中文分词中,最大正向匹配分词算法是一种常见的分词方法。

该算法基于词典,通过从左到右依次匹配最长的词进行分词。

优点•算法简单、效率高,适用于大规模文本的分词任务。

•对于常见词汇的分词效果较好。

缺点•对于歧义词汇的分词效果较差。

由于该算法只依次匹配最长的词,因此可能会将歧义词汇按错误的方式进行分词。

•无法处理未登录词。

如果分词的文本中存在词典中未包含的词汇,该算法将无法正确地进行分词。

算法步骤最大正向匹配分词算法的步骤如下:1.定义一个词典,包含常见的词汇。

2.从待分词的文本的左侧开始,选择词典中最长的词作为候选词。

3.判断候选词是否存在于词典中。

4.如果候选词存在于词典中,将该词作为分词结果的一部分,然后从待分词文本的右侧继续进行分词。

5.如果候选词不存在于词典中,将候选词的最后一个字去除,然后将剩余的部分作为新的候选词。

6.重复步骤3和步骤4,直到待分词的文本为空。

算法示例假设我们有一个词典:[“最大”, “正向”, “匹配”, “分词”, “算法”]。

我们要对文本”最大正向匹配分词算法”进行分词。

1.从文本的左侧开始,选择最长的词”最大正向”作为候选词。

2.判断候选词”最大正向”存在于词典中。

3.将候选词”最大正向”作为分词结果的一部分。

4.从待分词的文本的右侧继续进行分词,此时待分词的文本为”匹配分词算法”。

5.从文本的左侧开始,选择最长的词”匹配”作为候选词。

6.判断候选词”匹配”存在于词典中。

7.将候选词”匹配”作为分词结果的一部分。

8.从待分词的文本的右侧继续进行分词,此时待分词的文本为”分词算法”。

9.从文本的左侧开始,选择最长的词”分词”作为候选词。

10.判断候选词”分词”存在于词典中。

11.将候选词”分词”作为分词结果的一部分。

12.从待分词的文本的右侧继续进行分词,此时待分词的文本为”算法”。

基于改进的正向最大匹配中文分词算法研究

基 于 理解 的分 词 方法 不 仅 要求 有 很好 的分 词 词典 , 而且还 需要 加进 语义 和句 法 的分 析 。通过 获

文文本 中词与词之间却没有很明显的标记 , 都是连 续 的字符串, 因而中文信息处理的首要解决的问题 就是 怎样进 行 中 文分 词 。 正 向最 大 匹 配 法是 一 种

文章编号

10 5 6 (0 10 0 1 0 0 0— 2 9 2 1 )5— 12— 4

基 于 改进 的 正 向最 大 匹配 中文 分 词 算 法研 究

王 惠仙 , 龙 华

( 昆明理工大学信息工程与 自动化学 院 , 云南 昆明 6 05 ) 50 1

摘

要: 中文 自动 分词技 术在 中文信 息 处 理 、 b文 档 挖 掘 等 处理 文 档 类研 究 中是 一 项 关键 技 We

第 5期

王惠仙 等 : 于改进 的正向最大匹配 中文分词算法研究 基

文本 进行 分 词操作 , 到准 确有 效 的切分 中文 文档 达

的 目标 。

的词 时 , 只能 取 出其 中 的 5个 字去 词 典 里 匹 配 , 例 如“ 共产 主 义 接 ” 显 然 词典 里 不 可 能 存 在 像 这 样 , 的词 。因此 就 无 法 准 确 的 划 分 出 像 “ 产 主 义 接 共 班人 ” 这样 长 度大 于 5的 词 。如果 词 长 过 长 , 率 效

词 方法 ¨ 。 J 1 1 基于词 典 的分词方 法 . 基 于 词典 的分 词 法是 广 泛 应用 的一 种 的机 械

基 于统 计 的 分词 方 法 主要 是 用来 消 除 分词 过 程 中产生 的歧 义现 象 , 即消歧 。此方 法 主要靠 一个 或者 多个 具有 代表 性 的规 模 相对 小 的训 练语 料 库

中文分词:正向匹配最大算法(FMM)

中⽂分词:正向匹配最⼤算法(FMM)中⽂分词:正向匹配最⼤算法正向最⼤匹配法,对于输⼊的⼀段⽂本从左⾄右、以贪⼼的⽅式切出当前位置上长度最⼤的词。

正向最⼤匹配法是基于词典的分词⽅,其分词原理是:单词的颗粒度越⼤,所能表⽰的含义越确切。

该算法主要分两个步骤:1、⼀般从⼀个字符串的开始位置,选择⼀个最⼤长度的词长的⽚段,如果序列不⾜最⼤词长,则选择全部序列。

2、⾸先看该⽚段是否在词典中,如果是,则算为⼀个分出来的,如果不是,则从右边开始,减少⼀个字符,然后看短⼀点的这个⽚段是否在词典中,依次循环,逐到只剩下⼀个字。

3、序列变为第2步骤截取分词后,剩下的部分序列代码实现#使⽤正向最⼤匹配算法实现中⽂分词words_dic = []def init():'''读取词典⽂件载⼊词典:return:'''with open(r"C:\Users\lenovo\PycharmProjects\fenci\venv\dic\dic.txt","r",encoding="utf-8") as dic_input:for word in dic_input:words_dic.append(word.strip())#列表#实现正向匹配算法中的切词⽅法def cut_words(raw_sentence,word_dict):#统计词典中最长的词max_length = max(len(word) for word in words_dic)sentence = raw_sentence.strip()#统计序列长度word_length = len(sentence)#存储切分好的词语cut_word_list = []while word_length > 0:max_cut_length = min(max_length,word_length)#判断最长词语与句⼦的长度subsentence = sentence[0:max_cut_length] #⼦句与就是最⼤的长度while max_cut_length > 0:if subsentence in word_dict:#如果句⼦是长的,那么从头便取最⼤词的长度,如果在,⾸词便框住cut_word_list.append(subsentence) #如果不在词典岂不是完蛋了breakelif max_cut_length == 1:cut_word_list.append(subsentence)breakelse:max_cut_length = max_cut_length-1 #⼤概率是不在的,因此切得长度减1subsentence = subsentence[0:max_cut_length]sentence = sentence[max_cut_length:]words_length = word_length - max_cut_lengthif words_length == 0:breakwords = "/".join(cut_word_list)return wordsdef main():'''与⽤户交互接⼝:return:'''init()while True:print("请输⼊要分词序列:")input_str = input()if not input_str:breakresult = cut_words(input_str,words_dic)print("分词结果")print(result)if __name__=="__main__":main()。

一种改进的中文分词正向最大匹配算法

一种改进的中文分词正向最大匹配算法改进的中文分词正向最大匹配算法可以通过以下几个步骤来实现:

1.预处理文本:对待分词的文本进行预处理,包括去除换行符、标点

符号等。

2.构建词典:将用于分词的词汇整理成一个词典,可以使用常见的词

库或者根据具体需求自定义词典。

3.正向最大匹配算法:首先确定最大匹配的长度,可以根据预设的最

大词长或者根据词典中最长词的长度来确定。

从文本的首字开始,依次向

后匹配,每次匹配到一个词时就将它作为一个词组输出。

如果当前位置未

匹配到词,则将该字作为单字输出。

4.逆向扫描策略:在正向最大匹配算法的基础上,加入逆向扫描策略。

当正向匹配结束后,再对未匹配的部分进行逆向匹配。

逆向匹配时,从文

本的末尾开始,依次向前匹配,可以将匹配到的词组或单字插入到正向匹

配的结果中。

5.歧义消解:在进行正向和逆向匹配时,可能会出现多个匹配结果的

情况。

例如,对于词组"中央大街",在正向匹配时可以匹配到"中央"和"

大街",在逆向匹配时可以匹配到"中央大"和"街"。

可以通过一些启发式

规则来进行歧义消解,例如根据词频信息以及语法规则进行判断。

以上是一种改进的中文分词正向最大匹配算法的基本步骤。

具体实现

时可以根据需要进行优化,例如引入其他的匹配策略或者结合统计模型进

行分词,以提高分词效果。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

正向最大匹配分词算法的分析与改进摘要:本文主要通过对影响正向最大匹配算法效率的因素的分析,提出对该算法的一点改进,以及设计了相应的词典结构,以期在匹配过程中尽可能的减少比较次数,提高分词效率。

关键词:中文分词;最大匹配算法;词典机制

中图分类号tp39 文献标识码a 文章编号 1674-6708(2011)53-0164-02

0引言

在自然语言处理中,“词是最小的能够独立活动的有意义的语言成分”[1],而汉语和英语等其它西文比起来,有着自身的特点。

英语、法语等欧美语言在书写时就以词为基本构成单位,以空格作为分词的依据;而汉语在书写时是一大串汉字的字符串,从形式上根本没有词的概念。

中文分词指的就是将一个汉字序列切分成一个一个单独的具有实际意义的词,它是中文信息处理的基础。

中文自动分词的现有的分词算法可分为三大类:基于字符串匹配的分词方法、基于理解的分词方法和基于统计的分词方法[2]。

在基于字符串匹配的分词算法中,词典的设计往往对分词算法的效率有很大的影响。

本文通过对影响正向最大匹配算法效率因素的分析,设计一种带词长信息的分词词典,同时在该词典基础上,对正向最大匹配算法做出一些改进,以提高分词的效率。

1正向最大匹配分词算法介绍和分析

1.1 正向最大匹配分词算法介绍

最大匹配算法是最基本的字符串匹配算法之一,它能够保证将词典中存在的最长复合词切分出来。

传统的正向最大匹配分词算法(maximum matching,简称mm算法)的算法流程如图1所示。

图1 mm 算法流程图

假设分词词典中的最长词的字数为m,令其作为最大匹配系数。

假设读取的汉字序列字数为l,判断l是否小于最大匹配系数m。

如果l大于最大匹配系数m,则截取前m个汉字作为待匹配字段进行匹配,否则取整个汉字序列作为待匹配字段直接在分词词典中进行匹配。

若字典中存在这样一个字数为m的词,则匹配成功,匹配字段被作为一个词切分出来;若词典中找不到这样的词,则匹配失败,将待匹配字段中的最后一个字去掉,将剩下的汉字序列作为待匹配字段重新在字典中进行匹配处理……如此进行下去,直到匹配成功,即切分出一个词,或者直到剩余字串的长度为1为止,即为一个单字。

这样就完成了一轮查找匹配,然后取剩下的汉字序列以同样的方法进行匹配处理,直到文档被扫描完为止。

1.2算法分析

正向最大分词算法有个弊端,就是在算法开始前必须先预设一个匹配词长的初始值,而一般这个值是词典中最长词的长度,这个长度限制是最大匹配算法在效率与词长之间的一种折中。

词长过长效率就比较低,词典中各个词的长度都不一致,有点较长,而有的

却只是二字词或三字词。

如果词长过长,在查找短字词时,将会出现许多无效的匹配,这在很大程度上影响了分词的效率。

而如果初始值选取的过小,那么长词就不能得到有效的切分,达不到最大分词的目的。

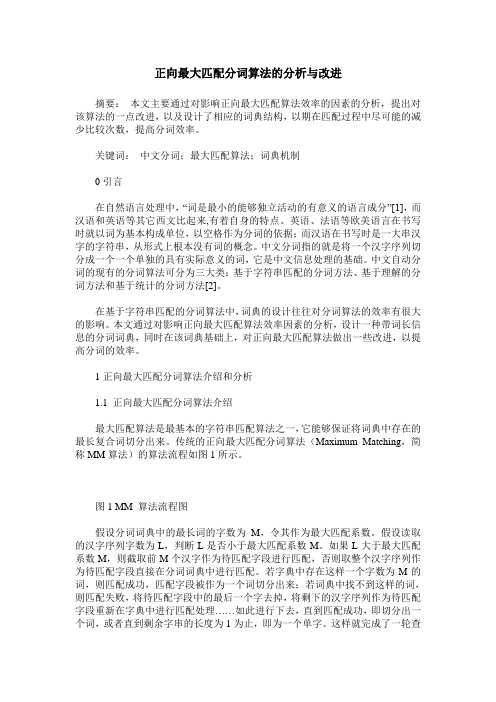

根据汉语中词条的分布情况统计,在汉语中双字词语最多,而4字以上的词则比较少,如下表所示。

可见,当初始值设置过长时,无效匹配的次数将在很大程度上消耗算法的效率。

表1 词条分布情况表

同时,在确定了词首字,在字典开始查找后,在以该词首字为前缀的词语中,词的长度一般都不是逐字减少的。

比方说该字可能包含一个10字长的词语,但是并不含有9字,8字长的词语,而这时如果还是采用逐字减一的方法去匹配,又将增加无效匹配的次数,影响算法的效率。

2 改进的正向最大匹配分词算法

针对如上对正向最大匹配分词算法的分析,得出该算法在效率上存在的缺陷主要有:一固定最大匹配系数,二逐字递减的匹配。

算法改进时将在这两方面做文章,使最大匹配系数能以词首字的改变而动态改变,同时在减字匹配过程中,不是每次都逐字减一再去字典匹配,而是利用词首字中包含的词长信息,来不定长的减字,以减少无效匹配的次数,从而在一定程度上提高算法的效率。

2.1分词词典的设计

词典的组织结构为首字索引结构,所有以同一个字为首的词条都组织在一起。

词典由两部分组成,一部分是首字索引,另一部分是词典的正文。

索引部分由字和以该字为前缀的词条的词长信息两部分组成。

正文部分为词条内容和词条长度两部分信息组成。

其中词条长度是用来给词条排序的,以词长从大到小来组织词典的正文,同时在匹配过程中,先用词长比较来代替直接比较字符串的方法,在词长相等的情况下再比较字符序列,来提高匹配的效率,而且词长信息能有效的记录已查询列表的索应信息,从而在改变词长继续查找时,能高效地减少匹配次数。

其机构如图所示。

图2 词典结构

2.2分词算法

step1:取出待处理的汉字序列的首字,在首字hash表中查找,如果存在该字,则转step3;

step2:不存在则是单字,分出该单字word,转step6;

step3:取出该字的信息,包含词长信息和词典信息,转step4;

step4:遍历词长列表,按序分别取出词长设为匹配词长,然后在词典中查找,词典包含了词长值,在查找时先比较词长,若相等则再比较字符序列,转step5;

step5:如果存在某一词长匹配成功,则分出该词word,转step7;

step6:如果全部词长匹配都不成功,则说明是单字,分出该单字word,转step7;

step7:从待分词序列中去掉已分出的词word,若汉字序列没有分词结束,转step1,否则结束。

例如:对语料“中华人民共和国是一个强大的国家”,使用本算法的处理过程如下:

1)取序列首字“中”在首字hash表中查询,存在该字则取出该首字信息,遍历词长信息列表得到,以该字为前缀的最长词长为14,则再取序列中余下的13个字“华人民共和国是一个强大的国”,在词典中匹配,发现匹配不成功;再取下一个词长得到词长为10,取序列为“华人民共和国是一个”,还是不成功……直到词长为7时,匹配“中华人民共和国”成功,取出该词。

在匹配过程中,充分利用词长信息,在字符比较之前,先通过比较词长来筛选,在词长相等的情况下,才比较字符序列;

2)然后再取首字“是”,查找首字hash表,不存在以该字为前缀的词,分出单字“是”;

3)接着处理首字“强”,按照上述方法依次处理余下的字串;

4)最后得到的分词结果为:中华人民共和国/是/一个/强大/的/国家。

由以上的一次分词过程可以看出,动态设置最长匹配词长的方法,有效的避免和减少了传统mm算法(静态设置匹配词长的方法)的比较次数,大大的提高了长词匹配的效率。

同时,利用比较先词长再比较字符的方法,也在一定程度上提高的算法的效率。

3 结论

本文主要通过对影响正向最大匹配算法效率的因素的分析,提出对该算法的一些改进,以及设计了相应的词典结构,以在匹配过程中尽可能的减少了比较的次数,在一定程度上提高了分词的效率。

本文没有提供对歧义和未登录词的处理,而这是影响基于词典分词算法准确率的重要因素,这将是今后需要解决和处理的方向。

参考文献

[1]朱德熙.语法讲义[m].商务印书馆,1982.

[2]张启宇,朱玲,张雅萍.中文分词算法研究综述情报探索,2008,l1.

[3]胡锡衡.正向最大匹配法在中文分词技术中的应用[j].鞍山师范学院学报,2008,10(2):42-45.

[4]孙茂松,左正平,黄昌宁.汉语自动分词词典机制的实验研究[j].中文信息学报,2000,14(1):1-7.。