微信文章采集器使用方法详解

微信文章自动阅读软件使用说明

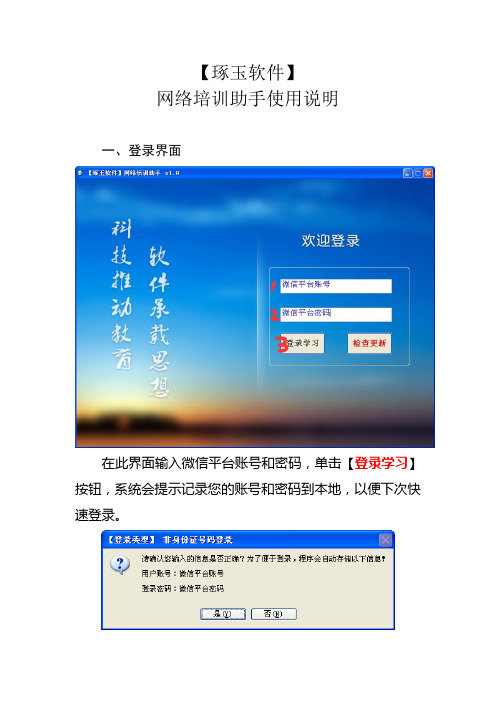

【琢玉软件】网络培训助手使用说明一、登录界面在此界面输入微信平台账号和密码,单击【登录学习】按钮,系统会提示记录您的账号和密码到本地,以便下次快速登录。

请确认您输入的账号和密码是否正确?正确:单击【是】,程序将自动完成账号和密码存储工作,并进入学习界面。

不正确:单击【否】,程序会提示您“请输入正确的【账号】和【密码】!”。

二、检查更新单击【检查更新】按钮,检查更新!没有新版本时,会提示:有新版本时,会提示如下信息:单击【是】将自动下载新版本!三、学习界面限于微信平台【阅读频率】时间限制,阅读时间过短,阅读过快将会提示“您的阅读过于频繁!”,导致阅读失败!因此,软件设定每120秒(即2分钟)阅读1篇文章!至此,程序已进入【自动阅读】模式,此时,无需手动干预,挂机运行直到出现全部阅读完成提示为止!如果阅读成功后不断有【已阅成功】消息提示框,则说明程序运行异常,请单击【确定】按钮,然后在任务栏右下角【右键】单击程序图标,会弹出菜单,选择【Exit】退出程序,并重新运行即可!在运行过程中,2.0以前版本每阅读1篇文章,会在任务栏右下角多出一个这样的图标,这是自动确认网页消息的插件运行后在任务栏上遗留的图标,鼠标轻移动过去就会消失!2.0及以后版本现已修复这个问题,任务栏上不会再出现这样的图标!四、全部阅读完成后的提示当所有加分项文章均已阅读完毕,系统会提示如上图所示信息,并会播放一段短暂的提示音乐,表明阅读已完成,您可以关闭软件。

等过几天网上又有新发布的文章时再次登录学习即可!五、软件注册本软件属于共享软件,会有一定时间的【试用期】,试用期间没有任何功能限制,试用版与注册版一模一样,区别只是在软件界面广告区域显示【试用版】字样,过期后,需要【注册】才能继续使用!未注册版每次登录只能阅读【1】篇文章,注册后则无任何功能限制。

未注册版本注册提示:单击【是】进入注册页面,单击【否】则退出程序。

六、注册方法软件提示注册时,单击【是】进入注册页面,根据需求填写订单,并在【备注栏】内填写需要开通的【账号】(无需密码),多账号开通请用竖线【|】隔开,提交订单后等待我们后台确认,确认无误后我们将会开通您的账号,一般情况下当天即可注册开通。

文章采集软件使用方法

对于站长以及新媒体运营人员来说,文章采集是必须要掌握的一项功能。

通过文章采集一个是能很清楚的掌握自身行业中哪些类型的文章受用户的喜爱,其实是合理的采集高质量的爆款文章,建立自己的资料库,从而生产出优质的文章。

目前来说,有很多自媒体平台都是可以采集文章的,比如今日头条、百家号、搜狗微信、新浪微博等等,这些平台基本都有搜索功能,你可以根据关键词去采集自己需要的文章。

下面具体为大家介绍八爪鱼文章采集软件的使用方法。

步骤1:创建采集任务1)进入主界面选择,选择“自定义模式”文章采集软件使用步骤12)将上面网址的网址复制粘贴到网站输入框中,点击“保存网址”文章采集软件使用步骤23)保存网址后,页面将在八爪鱼采集器中打开,红色方框中的信息是这次演示要采集的内容,即为今日头条最新发布的热点新闻。

文章采集软件使用步骤3步骤2:设置ajax页面加载时间●设置打开网页步骤的ajax滚动加载时间●找到翻页按钮,设置翻页循环●设置翻页步骤ajax下拉加载时间1)网页打开后,需要进行以下设置:打开流程图,点击“打开网页”步骤,在右侧的高级选项框中,勾选“页面加载完成向下滚动”,设置滚动次数,每次滚动间隔时间,一般设置2秒,这个页面的滚动方式,选择直接滚动到底部;最后点击确定文章采集软件使用步骤4注意:今日头条的网站属于瀑布流网站,没有翻页按钮,这里的滚动次数设置将影响采集的数据量。

文章采集软件使用步骤5步骤3:采集新闻内容创建数据提取列表1)如图,移动鼠标选中评论列表的方框,右键点击,方框底色会变成绿色 然后点击“选中子元素”文章采集软件使用步骤6注意:点击右上角的“流程”按钮,即可展现出可视化流程图。

2)然后点击“选中全部”,将页面中需要需要采集的信息添加到列表中文章采集软件使用步骤7注意:在提示框中的字段上会出现一个“X”标识,点击即可删除该字段。

文章采集软件使用步骤83)点击“采集以下数据”文章采集软件使用步骤9 4)修改采集字段名称,点击下方红色方框中的“保存并开始采集”文章采集软件使用步骤10步骤4:数据采集及导出1)根据采集的情况选择合适的采集方式,这里选择“启动本地采集”文章采集软件使用步骤11说明:本地采集占用当前电脑资源进行采集,如果存在采集时间要求或当前电脑无法长时间进行采集可以使用云采集功能,云采集在网络中进行采集,无需当前电脑支持,电脑可以关机,可以设置多个云节点分摊任务,10个节点相当于10台电脑分配任务帮你采集,速度降低为原来的十分之一;采集到的数据可以在云上保存三个月,可以随时进行导出操作。

微信公众号内容采集方法详解

微信已成为大多数人每天生活工作的一部分,所以会花不少的时间浏览微信公众号的文章内容,里面的精品以及爆款文章不少,如果想把这些文章都采集下来,怎么办在手机上一篇一篇下载有不方便,这是不得不用一下科学高效的采集方法了。

下面介绍一个微信公众号内容采集的神奇方法。

很多时候,我们有采集网页文章正文的需求。

本文以搜狗微信文章为例,介绍使用八爪鱼采集网页文章正文的方法。

文章正文里一般包括文本和图片两种。

本文仅演示采集正文中本文的方法,图文采集会在另一篇教程中讲到。

本文将采集以下字段:文章标题、时间、来源和正文(正文中的所有文本,将合并到一个excel单元格中,将使用到“自定义数据合并方式”功能,请大家注意)。

以下为“自定义数据合并方式”详解教程,大家可先了解一下:/tutorialdetail-1/zdyhb_7.html采集网站:/使用功能点:分页列表信息采集 1)进入主界面,选择“自定义模式”微信公众号文章正文采集步骤12)将要采集的网址URL复制粘贴到网站输入框中,点击“保存网址” 微信公众号文章正文采集步骤2步骤2:创建翻页循环1)在页面右上角,打开“流程”,以展现出“流程设计器”和“定制当前操作”两个板块。

网页打开后,默认显示“热门”文章。

下拉页面,找到并点击“加载更多内容”按钮,在操作提示框中,选择“更多操作”微信公众号文章正文采集步骤32)选择“循环点击单个元素”,以创建一个翻页循环微信公众号文章正文采集步骤4由于此网页涉及Ajax技术,我们需要进行一些高级选项的设置。

选中“点击元素”步骤,打开“高级选项”,勾选“Ajax加载数据”,设置时间为“2秒”微信公众号文章正文采集步骤5注:AJAX即延时加载、异步更新的一种脚本技术,通过在后台与服务器进行少量数据交换,可以在不重新加载整个网页的情况下,对网页的某部分进行更新。

表现特征:a、点击网页中某个选项时,大部分网站的网址不会改变;b、网页不是完全加载,只是局部进行了数据加载,有所变化。

数据采集器配置及使用教程

数据采集器配置及使用教程数据采集器是一种用于收集和存储数据的设备,常用于科学研究、工业控制、环境监测等领域。

它可以通过不同的传感器收集各种类型的数据,并将其存储在内存中或传输到计算机进行进一步处理和分析。

本文将介绍数据采集器的配置和使用步骤。

1.选择合适的数据采集器:首先需要根据应用场景选择适合的数据采集器。

常见的数据采集器有独立设备和计算机配套设备两种形式,可以根据实际需求进行选择。

2.连接传感器:根据要采集的数据类型,选择合适的传感器,并通过接口将其连接到数据采集器上。

常见的传感器有温度传感器、湿度传感器、压力传感器等,根据需要进行选择。

3.设置采样参数:在进行数据采集之前,需要设置采样参数,包括采样频率、采样时长等。

这些参数的设置将影响数据采集的准确性和效率,需要根据实际需求进行调整。

4.配置数据存储方式:数据采集器通常提供多种数据存储方式,包括内存存储、外部存储设备存储等。

根据实际需求选择合适的存储方式,并对其进行配置。

5.设置数据传输方式:如果需要将采集的数据传输到计算机或其他设备进行处理和分析,需要设置数据传输方式。

数据传输可以通过有线或无线方式进行,根据实际需求选择合适的传输方式。

1.连接传感器:首先将传感器通过接口连接到数据采集器上。

确保连接的稳定和正确,避免数据采集过程中出现故障。

2.设置采样参数:根据实际需求设置采样参数。

可以根据需要选择不同的采样频率和采样时长,以获取所需的数据。

3.开始数据采集:在设置好采样参数后,点击开始按钮开始数据采集。

数据采集器将按照设置的参数进行采样和存储。

4.监控数据采集:在数据采集过程中,可以实时监控采集到的数据。

数据采集器通常提供实时数据显示界面,可以通过界面观察数据的变化和趋势。

5.停止数据采集:当需要停止数据采集时,点击停止按钮停止数据采集。

数据采集器将停止采集数据,并进入待机状态。

6.数据处理和分析:采集完成后,可以将数据传输到计算机进行进一步处理和分析。

微信文章抓取工具详细使用方法

微信文章抓取工具详细使用方法如今越来越多的优质内容发布在微信公众号中,面对这些内容,有些朋友就有采集下来的需求,下面为大家介绍使用八爪鱼抓取工具去抓取采集微信文章信息。

抓取的内容包括:微信文章标题、微信文章关键词、微信文章部分内容展示、微信所属公众号、微信文章发布时间、微信文章URL等字段数据。

采集网站:/步骤1:创建采集任务1)进入主界面,选择“自定义模式”微信文章抓取工具详细使用步骤12)将要采集的网址URL复制粘贴到网站输入框中,点击“保存网址”微信文章抓取工具详细使用步骤2步骤2:创建翻页循环1)在页面右上角,打开“流程”,以展现出“流程设计器”和“定制当前操作”两个板块。

点击页面中的文章搜索框,在右侧的操作提示框中,选择“输入文字”微信文章抓取工具详细使用步骤32)输入要搜索的文章信息,这里以搜索“八爪鱼大数据”为例,输入完成后,点击“确定”按钮微信文章抓取工具详细使用步骤43)“八爪鱼大数据”会自动填充到搜索框,点击“搜文章”按钮,在操作提示框中,选择“点击该按钮” 微信文章抓取工具详细使用步骤54)页面中出现了“八爪鱼大数据”的文章搜索结果。

将结果页面下拉到底部,点击“下一页”按钮,在右侧的操作提示框中,选择“循环点击下一页”微信文章抓取工具详细使用步骤6步骤3:创建列表循环并提取数据1)移动鼠标,选中页面里第一篇文章的区块。

系统会识别此区块中的子元素,在操作提示框中,选择“选中子元素”微信文章抓取工具详细使用步骤72)继续选中页面中第二篇文章的区块,系统会自动选中第二篇文章中的子元素,并识别出页面中的其他10组同类元素,在操作提示框中,选择“选中全部”微信文章抓取工具详细使用步骤8 3)我们可以看到,页面中文章区块里的所有元素均被选中,变为绿色。

右侧操作提示框中,出现字段预览表,将鼠标移到表头,点击垃圾桶图标,可删除不需要的字段。

字段选择完成后,选择“采集以下数据” 微信文章抓取工具详细使用步骤9 4)由于我们还想要采集每篇文章的URL,因而还需要提取一个字段。

自媒体免费爆文采集器如何使用

自媒体免费爆文采集器如何使用创造出来一篇爆文对于众多做自媒体的朋友而言,无疑是件欢欣鼓舞的事。

感觉升职加薪,分分钟走上人生巅峰!然,即使自己暂时不能写出一篇爆文,那也不可阻拦自己去收集别人的。

他山之石,可以攻玉,更何况本来就是玉呢!而如何快速又免费收集到在自媒体爆文,这就有技巧了!要不然时间都花在文章收集上,还写啥文章!以下介绍使用八爪鱼7.0采集自媒体文章采集方法,以今日头条为例。

注:软件内还支持判断条件的设置,判断筛选出哪些是爆文,而这些都可以自定义设置。

采集网站:使用功能点:●Ajax滚动加载设置●列表内容提取步骤1:创建采集任务1)进入主界面选择,选择“自定义模式”自媒体文章采集步骤12)将上面网址的网址复制粘贴到网站输入框中,点击“保存网址”自媒体文章采集步骤23)保存网址后,页面将在八爪鱼采集器中打开,红色方框中的信息是这次演示要采集的内容,即为今日头条最新发布的热点新闻。

自媒体文章采集步骤3步骤2:设置ajax页面加载时间●设置打开网页步骤的ajax滚动加载时间●找到翻页按钮,设置翻页循环●设置翻页步骤ajax下拉加载时间1)网页打开后,需要进行以下设置:打开流程图,点击“打开网页”步骤,在右侧的高级选项框中,勾选“页面加载完成向下滚动”,设置滚动次数,每次滚动间隔时间,一般设置2秒,这个页面的滚动方式,选择直接滚动到底部;最后点击确定自媒体文章采集步骤4注意:今日头条的网站属于瀑布流网站,没有翻页按钮,这里的滚动次数设置将影响采集的数据量。

自媒体文章采集步骤5步骤3:采集新闻内容创建数据提取列表1)如图,移动鼠标选中评论列表的方框,右键点击,方框底色会变成绿色然后点击“选中子元素”自媒体文章采集步骤6注意:点击右上角的“流程”按钮,即可展现出可视化流程图。

2)然后点击“选中全部”,将页面中需要需要采集的信息添加到列表中自媒体文章采集步骤7注意:在提示框中的字段上会出现一个“X”标识,点击即可删除该字段。

Python如何爬取微信公众号文章和评论(基于Fiddler抓包分析)

Python如何爬取微信公众号⽂章和评论(基于Fiddler抓包分析)背景说明感觉微信公众号算得是⽐较难爬的平台之⼀,不过⼀番折腾之后还是⼩有收获的。

没有⽤Scrapy(估计爬太快也有反爬限制),但后⾯会开始整理写⼀些实战出来。

简单介绍下本次的开发环境:python3requestspsycopg2 (操作postgres数据库)抓包分析本次实战对抓取的公众号没有限制,但不同公众号每次抓取之前都要进⾏分析。

打开Fiddler,将⼿机配置好相关代理,为避免⼲扰过多,这⾥给Fiddler加个过滤规则,只需要指定微信域名就好:Fiddler配置Filter规则平时关注的公众号也⽐较多,本次实战以“36氪”公众号为例,继续往下看:“36氪”公众号公众号右上⾓ -> 全部消息在公众号主页,右上⾓有三个实⼼圆点,点击进⼊消息界⾯,下滑找到并点击“全部消息”,往下请求加载⼏次历史⽂章,然后回到Fiddler界⾯,不出意外的话应该可以看到这⼏次请求,可以看到返回的数据是json格式的,同时⽂章数据是以json字符串的形式定义在general_msg_list字段中:公众号⽂章列表抓包请求分析⽂章列表接⼝把请求URL和Cookie贴上来进⾏分析:https:///mp/profile_ext?action=getmsg&__biz=MzI2NDk5NzA0Mw==&f=json&offset=10&count=10&is_ok=1&scene=126&uin=777&key=777&pass_ticket=QhOypNwH5dAr5w6UgMjyBrTSOdMEUT86vWc73GANoziWFl8xJd1hIMbMZ82KgCpN& Cookie: pgv_pvid=2027337976; pgv_info=ssid=s3015512850; rewardsn=; wxtokenkey=777; wxuin=2089823341; devicetype=android-26; version=26070237; lang=zh_CN;pass_ticket=NDndxxaZ7p6Z9PYulWpLqMbI0i3ULFeCPIHBFu1sf5pX2IhkGfyxZ6b9JieSYR 下⾯把重要的参数说明⼀下,没提到的说明就不那么重要了:__biz:相当于是当前公众号的id(唯⼀固定标志)offset:⽂章数据接⼝请求偏移量标志(从0开始),每次返回的json数据中会有下⼀次请求的offset,注意这⾥并不是按某些规则递增的count:每次请求的数据量(亲测最多可以是10)pass_ticket:可以理解是请求票据,⽽且隔⼀段时间后(⼤概⼏个⼩时)就会过期,这也是为什么微信公众号⽐较难按固定规则进⾏抓取的原因appmsg_token:同样理解为⾮固定有过期策略的票据Cookie:使⽤的时候可以把整段贴上去,但最少仅需要wap_sid2这部分是不是感觉有点⿇烦,毕竟不是要搞⼤规模专业的爬⾍,所以单就⼀个公众号这么分析下来,还是可以往下继续的,贴上截取的⼀段json数据,⽤于设计⽂章数据表:{"ret": 0,"errmsg": "ok","msg_count": 10,"can_msg_continue": 1,"general_msg_list": "{\"list\":[{\"comm_msg_info\":{\"id\":1000005700,\"type\":49,\"datetime\":1535100943,\"fakeid\":\"3264997043\",\"status\":2,\"content\":\"\"},\"app_msg_ext_info\":{\"title\":\"⾦融危机⼜⼗年:钱荒之下,⼆⼿基⾦迎来⾼光时刻\",\"digest\":\"退出"next_offset": 20,"video_count": 1,"use_video_tab": 1,"real_type": 0}可以简单抽取想要的数据,这⾥将⽂章表结构定义如下,顺便贴上建表的SQL语句:⽂章数据表-- ------------------------------ Table structure for tb_article-- ----------------------------DROP TABLE IF EXISTS "public"."tb_article";CREATE TABLE "public"."tb_article" ("id" serial4 PRIMARY KEY,"msg_id" int8 NOT NULL,"title" varchar(200) COLLATE "pg_catalog"."default" NOT NULL,"author" varchar(20) COLLATE "pg_catalog"."default","cover" varchar(500) COLLATE "pg_catalog"."default","digest" varchar(200) COLLATE "pg_catalog"."default","source_url" varchar(800) COLLATE "pg_catalog"."default","content_url" varchar(600) COLLATE "pg_catalog"."default" NOT NULL,"post_time" timestamp(6),"create_time" timestamp(6) NOT NULL);COMMENT ON COLUMN "public"."tb_article"."id" IS '⾃增主键';COMMENT ON COLUMN "public"."tb_article"."msg_id" IS '消息id (唯⼀)';COMMENT ON COLUMN "public"."tb_article"."title" IS '标题';COMMENT ON COLUMN "public"."tb_article"."author" IS '作者';COMMENT ON COLUMN "public"."tb_article"."cover" IS '封⾯图';COMMENT ON COLUMN "public"."tb_article"."digest" IS '关键字';COMMENT ON COLUMN "public"."tb_article"."source_url" IS '原⽂地址';COMMENT ON COLUMN "public"."tb_article"."content_url" IS '⽂章地址';COMMENT ON COLUMN "public"."tb_article"."post_time" IS '发布时间';COMMENT ON COLUMN "public"."tb_article"."create_time" IS '⼊库时间';COMMENT ON TABLE "public"."tb_article" IS '公众号⽂章表';-- ------------------------------ Indexes structure for table tb_article-- ----------------------------CREATE UNIQUE INDEX "unique_msg_id" ON "public"."tb_article" USING btree ("msg_id" "pg_catalog"."int8_ops" ASC NULLS LAST);附请求⽂章接⼝并解析数据保存到数据库的相关代码:class WxMps(object):"""微信公众号⽂章、评论抓取爬⾍"""def __init__(self, _biz, _pass_ticket, _app_msg_token, _cookie, _offset=0):self.offset = _offset = _biz # 公众号标志self.msg_token = _app_msg_token # 票据(⾮固定)self.pass_ticket = _pass_ticket # 票据(⾮固定)self.headers = {'Cookie': _cookie, # Cookie(⾮固定)'User-Agent': 'Mozilla/5.0 AppleWebKit/537.36 (KHTML, like Gecko) Version/4.0 Chrome/57.0.2987.132 '}wx_mps = 'wxmps' # 这⾥数据库、⽤户、密码⼀致(需替换成实际的)self.postgres = pgs.Pgs(host='localhost', port='5432', db_name=wx_mps, user=wx_mps, password=wx_mps)def start(self):"""请求获取公众号的⽂章接⼝"""offset = self.offsetwhile True:api = 'https:///mp/profile_ext?action=getmsg&__biz={0}&f=json&offset={1}' \'&count=10&is_ok=1&scene=124&uin=777&key=777&pass_ticket={2}&wxtoken=&appmsg_token' \'={3}&x5=1&f=json'.format(, offset, self.pass_ticket, self.msg_token)resp = requests.get(api, headers=self.headers).json()ret, status = resp.get('ret'), resp.get('errmsg') # 状态信息if ret == 0 or status == 'ok':print('Crawl article: ' + api)offset = resp['next_offset'] # 下⼀次请求偏移量general_msg_list = resp['general_msg_list']msg_list = json.loads(general_msg_list)['list'] # 获取⽂章列表for msg in msg_list:comm_msg_info = msg['comm_msg_info'] # 该数据是本次推送多篇⽂章公共的msg_id = comm_msg_info['id'] # ⽂章idpost_time = datetime.fromtimestamp(comm_msg_info['datetime']) # 发布时间# msg_type = comm_msg_info['type'] # ⽂章类型# msg_data = json.dumps(comm_msg_info, ensure_ascii=False) # msg原数据app_msg_ext_info = msg.get('app_msg_ext_info') # article原数据if app_msg_ext_info:# 本次推送的⾸条⽂章self._parse_articles(app_msg_ext_info, msg_id, post_time)# 本次推送的其余⽂章multi_app_msg_item_list = app_msg_ext_info.get('multi_app_msg_item_list')if multi_app_msg_item_list:for item in multi_app_msg_item_list:msg_id = item['fileid'] # ⽂章idif msg_id == 0:msg_id = int(time.time() * 1000) # 设置唯⼀id,解决部分⽂章id=0出现唯⼀索引冲突的情况self._parse_articles(item, msg_id, post_time)print('next offset is %d' % offset)else:print('Before break , Current offset is %d' % offset)breakdef _parse_articles(self, info, msg_id, post_time):"""解析嵌套⽂章数据并保存⼊库"""title = info.get('title') # 标题cover = info.get('cover') # 封⾯图author = info.get('author') # 作者digest = info.get('digest') # 关键字source_url = info.get('source_url') # 原⽂地址content_url = info.get('content_url') # 微信地址# ext_data = json.dumps(info, ensure_ascii=False) # 原始数据self.postgres.handler(self._save_article(), (msg_id, title, author, cover, digest,source_url, content_url, post_time,datetime.now()), fetch=True)@staticmethoddef _save_article():sql = 'insert into tb_article(msg_id,title,author,cover,digest,source_url,content_url,post_time,create_time) ' \'values(%s,%s,%s,%s,%s,%s,%s,%s,%s)'return sqlif __name__ == '__main__':biz = 'MzI2NDk5NzA0Mw==' # "36氪"pass_ticket = 'NDndxxaZ7p6Z9PYulWpLqMbI0i3ULFeCPIHBFu1sf5pX2IhkGfyxZ6b9JieSYRUy'app_msg_token = '971_Z0lVNQBcGsWColSubRO9H13ZjrPhjuljyxLtiQ~~'cookie = 'wap_sid2=CO3YwOQHEogBQnN4VTNhNmxQWmc3UHI2U3kteWhUeVExZHFVMnN0QXlsbzVJRUJKc1pkdVFUU2Y5UzhSVEtOZmt1VVlYTkR4SEllQ2huejlTTThJWndMQzZfYUw2SldLVGVMQUthUjc3QWdVMUdoaGN0Nml2SU05cXR1dTN2RkhRUVd # 以上信息不同公众号每次抓取都需要借助抓包⼯具做修改wxMps = WxMps(biz, pass_ticket, app_msg_token, cookie)wxMps.start() # 开始爬取⽂章分析⽂章评论接⼝获取评论的思路⼤致是⼀样的,只是会更加⿇烦⼀点。

微信爬虫如何采集数据

微信爬虫如何采集数据微信公众号已经成为我们日常获取信息的一个非常重要的方式,很多人也希望能把优质的信息抓取出来,却苦于不会使用爬虫软件。

下面教大家一个不用会打代码也能轻松采集数据的软件工具:八爪鱼是如何采集微信文章信息的抓取的内容包括:微信文章标题、微信文章关键词、微信文章部分内容展示、微信所属公众号、微信文章发布时间、微信文章URL等字段数据。

采集网站:/步骤1:创建采集任务1)进入主界面,选择“自定义模式”微信爬虫采集数据步骤12)将要采集的网址URL复制粘贴到网站输入框中,点击“保存网址” 微信爬虫采集数据步骤2步骤2:创建翻页循环1)在页面右上角,打开“流程”,以展现出“流程设计器”和“定制当前操作”两个板块。

点击页面中的文章搜索框,在右侧的操作提示框中,选择“输入文字”微信爬虫采集数据步骤32)输入要搜索的文章信息,这里以搜索“八爪鱼大数据”为例,输入完成后,点击“确定”按钮微信爬虫采集数据步骤43)“八爪鱼大数据”会自动填充到搜索框,点击“搜文章”按钮,在操作提示框中,选择“点击该按钮”微信爬虫采集数据步骤54)页面中出现了“八爪鱼大数据”的文章搜索结果。

将结果页面下拉到底部,点击“下一页”按钮,在右侧的操作提示框中,选择“循环点击下一页”微信爬虫采集数据步骤6步骤3:创建列表循环并提取数据1)移动鼠标,选中页面里第一篇文章的区块。

系统会识别此区块中的子元素,在操作提示框中,选择“选中子元素”微信爬虫采集数据步骤72)继续选中页面中第二篇文章的区块,系统会自动选中第二篇文章中的子元素,并识别出页面中的其他10组同类元素,在操作提示框中,选择“选中全部”微信爬虫采集数据步骤83)我们可以看到,页面中文章区块里的所有元素均被选中,变为绿色。

右侧操作提示框中,出现字段预览表,将鼠标移到表头,点击垃圾桶图标,可删除不需要的字段。

字段选择完成后,选择“采集以下数据”微信爬虫采集数据步骤94)由于我们还想要采集每篇文章的URL,因而还需要提取一个字段。

使用fiddler抓取微信公众号文章的阅读数、点赞数、评论数

使⽤fiddler抓取微信公众号⽂章的阅读数、点赞数、评论数1 设置fiddler⽀持https打开fiddler,在菜单栏中依次选择 [Tools]->[Options]->[HTTPS],勾上如下图的选项:单击Actions,选择Export Root Certificate to Desktop(导出证书到桌⾯)选项:安装证书:在桌⾯上找到FiddlerRoot.cer⽂件,双击进⾏安装直到导⼊成功。

2 配置fiddler抓取规则在菜单栏中依次选择 [Rules]->[Customize Rules] 弹出Fiddler ScriptEditor界⾯找到OnBeforeRequest⽅法和OnBeforeResponse⽅法修改OnBeforeRequest⽅法内容如下:static function OnBeforeRequest(oSession: Session) {//加在⽅法末尾if (oSession.fullUrl.Contains("")){var fso;var file;fso = new ActiveXObject("Scripting.FileSystemObject");//⽂件保存路径,可⾃定义file = fso.OpenTextFile("c:\\Sessions.txt",8 ,true, true);file.writeLine("Request url: " + oSession.url);file.writeLine("Request header:" + "\n" + oSession.oRequest.headers);file.writeLine("Request body: " + oSession.GetRequestBodyAsString());file.writeLine("\n");file.close();}}修改OnBeforeResponse⽅法内容如下:static function OnBeforeResponse(oSession: Session) {//加在⽅法末尾if (oSession.HostnameIs("") && oSession.uriContains("https:///mp/getappmsgext")){var filename = "C:/fiddler-token.log";var curDate = new Date();var logContent = "[" + curDate.toLocaleString() + "] " + oSession.PathAndQuery + "\r\n"+oSession.GetResponseBodyAsString()+"\r\n";var sw : System.IO.StreamWriter;if (System.IO.File.Exists(filename)){sw = System.IO.File.AppendText(filename);sw.Write(logContent);}else{sw = System.IO.File.CreateText(filename);sw.Write(logContent);}sw.Close();sw.Dispose();}}修改后保存⽂件。

万能文章采集器

万能文章采集器在信息爆炸的时代,获取有效的文章资源成为了一项重要的任务。

而万能文章采集器应运而生,它是一种能够自动搜索、收集、整理各类文章资源的工具。

无论是新闻报道、学术论文、行业资讯还是社会热点,万能文章采集器都能够帮助用户快速获取所需的文章内容。

首先,万能文章采集器具有强大的搜索功能。

它能够通过关键词搜索引擎,自动检索各大网站、论坛、博客、新闻媒体等平台,找到与用户需求相关的文章资源。

用户只需输入相关的关键词,万能文章采集器就能够快速定位到相关的文章信息,大大节省了用户的时间成本。

其次,万能文章采集器拥有智能的筛选和分类功能。

它能够根据用户的需求,对搜索结果进行智能筛选和分类,将相关性较高的文章资源呈现给用户。

用户可以根据时间、来源、关键词等多种条件对搜索结果进行过滤和排序,找到最符合自己需求的文章内容。

此外,万能文章采集器还具有定制化的采集功能。

用户可以根据自己的需求,定制化采集规则,设定采集的深度和范围,以及采集的频率和时间段。

这样一来,用户可以实现定时定量地获取所需的文章资源,保证信息的及时性和全面性。

最后,万能文章采集器还支持多种输出格式。

用户可以将采集到的文章资源以文本、图片、链接等形式进行输出,方便用户进行保存、整理和分享。

同时,万能文章采集器还支持将采集到的文章资源进行自动化处理,比如去重、去杂、去水印等操作,提高了文章资源的质量和可用性。

综上所述,万能文章采集器是一种功能强大、操作简便的工具,它能够帮助用户快速获取各类文章资源,提高信息的获取效率和质量。

在信息化的今天,万能文章采集器无疑是一种不可或缺的利器,为用户的工作和学习带来了极大的便利和帮助。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

微信文章采集器使用方法详解

对于某些用户来说,直接自定义规则可能有难度,所以在这种情况下,我们提供了网页简易模式,本文介绍八爪鱼简易采集模式下“微信文章采集”的使用教程以及注意要点。

微信公众号文章采集使用步骤

步骤一、下载八爪鱼软件并登陆

1、打开/download,即八爪鱼软件官方下载页面,点击图中的下载按钮。

2、软件下载好了之后,双击安装,安装完毕之后打开软件,输入八爪鱼用户名密码,然后点击登陆

步骤二、设置微信文章爬虫规则任务

1、进入登陆界面之后就可以看到主页上的网站简易采集了,选择立即使用即可。

2、进去之后便可以看到目前网页简易模式里面内置的所有主流网站了,需要采集微信公众号内容的,这里选择搜狗即可。

3、找到搜狗公众号这条爬虫规则,点击即可使用。

4、搜狗公众号简易采集模式任务界面介绍

查看详情:点开可以看到示例网址

任务名:自定义任务名,默认为搜狗公众号

任务组:给任务划分一个保存任务的组,如果不设置会有一个默认组

公众号URL列表填写注意事项:提供要采集的网页网址,即搜狗微信中相关公众号的链接。

多个公众号输入多个网址即可。

采集数目:输入希望采集的数据条数

示例数据:这个规则采集的所有字段信息。

5、微信文章爬虫规则设置示例

例如要采集相关旅游、美食的公众号文章

在设置里如下图所示:

任务名:自定义任务名,也可以不设置按照默认的就行

任务组:自定义任务组,也可以不设置按照默认的就行

商品评论URL列表:

/weixin?type=1&s_from=input&query=电影&ie=utf8&_sug_=n&_sug_type_=

/weixin?type=1&s_from=input&query=美食&ie=utf8&_sug_=n&_sug_type_=

一行一个,使用回车(Enter)进行换行。

采集数目:可根据自身需求选填(当前默认)

注意事项:URL列表中建议不超过2万条

步骤三、保存并运行微信文章爬虫规则

1、设置好爬虫规则之后点击保存。

2、保存之后,点击会出现开始采集的按钮。

3、选择开始采集之后系统将会弹出运行任务的界面,可以选择启动本地采集(本地执行采集流程)或者启动云采集(由云服务器执行采集流程),这里以启动本地采集为例,我们选择启动本地采集按钮。

4、选择本地采集按钮之后,系统将会在本地执行这个采集流程来采集数据,下图为本地采集的效果。

5、采集完毕之后选择导出数据按钮即可,这里以导出excel2007为例,选择这个选项之后点击确定。

6、然后选择文件存放在电脑上的路径,路径选择好之后选择保存。

7、这样微信文章数据就被完整的采集导出到自己的电脑上来了。

相关采集教程:

网页抓取工具新手入门

/tutorial/xsksrm

八爪鱼爬虫软件入门准备

/tutorial/xsksrm/rmzb

八爪鱼数据爬取入门基础操作

/tutorial/xsksrm/rmjccz

八爪鱼网站抓取入门功能介绍

/tutorial/xsksrm/rmgnjs

八爪鱼爬虫软件功能使用教程

/tutorial/gnd

循环翻页爬取网页数据

/tutorial/gnd/xunhuan

Ajax网页数据抓取

/tutorial/gnd/ajaxlabel

特殊翻页操作

/tutorial/gnd/teshufanye

模拟登录并识别验证码抓取数据

/tutorial/gnd/dlyzm

八爪鱼——90万用户选择的网页数据采集器。

1、操作简单,任何人都可以用:无需技术背景,会上网就能采集。

完全可视化流程,点击鼠标完成操作,2分钟即可快速入门。

2、功能强大,任何网站都可以采:对于点击、登陆、翻页、识别验证码、瀑布流、Ajax脚本异步加载数据的网页,均可经过简单设置进行采集。

3、云采集,关机也可以。

配置好采集任务后可关机,任务可在云端执行。

庞大云采集集群24*7不间断运行,不用担心IP被封,网络中断。

4、功能免费+增值服务,可按需选择。

免费版具备所有功能,能够满足用户的基本采集需求。

同时设置了一些增值服务(如私有云),满足高端付费企业用户的需要。