第2讲 普通最小二乘法

第三讲普通最小二乘法

在满足基本假设条件下,对一元线性回归模型:

Yi 0 1 X i i

随机抽取n组样本观测值(Xi, Yi)(i=1,2,…n)。

假如模型的参数估计量已经求得,为 那么Yi服从如下的正态分布: 于是,Y的概率函数为

2 ˆ ˆ Yi ~ N ( 0 1 X i , )

② 用最小二乘法拟合的直线来代表 x 与 y 之间的 关系与实际数据的误差比其他任何直线都小

2. 正规方程和估计量

取偏导数并令其为0,可得正规方程 ( ei2 ) ˆ ˆ X )0 2 (Yi 1 2 i ˆ

( ei2 ) ˆ ˆ X )X 0 2 (Yi 1 2 i i ˆ

普通最小二乘法(OLS) (Ordinary Least Squares) 高斯被认为是历史上 最重要的数学家之一,并 享有“数学王子”之称。 高斯和阿基米德、牛顿并 列为世界三大数学家。一 生成就极为丰硕,以他名 字“高斯”命名的成果达 110个,属数学家中之最。

C.F.Gauss 1777-1855

解得模型的参数估计量为:

ˆ X i2 Yi X i Yi X i 0 nX i2 (X i ) 2 ˆ nYi X i Yi X i 1 2 2 n X ( X ) i i

可见,在满足一系列基本假设的情况下,模型 结构参数的 最大或然估计量 与 普通最小

6

在家庭可支配收入-消费支出例中,对于所抽出的一组样 本数,参数估计的计算可通过下面的表进行。

表 2.2.1 参数估计的计算表

Xi

Yi

xi

yi

xi y i

xi2

y i2

X i2

Yi 2

最小二乘法行列式和特征值

左零空间 dim N(AT)=m-r

图中绘制空间成 90 度角,这是表示这两个空间正交。这张图是 GS 最得意的作 品之一,它反映了四个子空间的关系,在后面的课程中可以看到其两两形成正交补, 在 Rn 空间中的向量会向两个子空间射影,并向 Rm 空间形成映射,反之亦然。

正交向量 Orthogonal vectors

所以将两个方程式写成矩阵形式即为 AT(b- Axˆ )=0。这与一维投影的方程形式相同。

向量 e=b- Axˆ 存在于矩阵 AT 的零空间 N(AT)里,从上一讲讨论子空间的正交

性可知,向量 e 与矩阵 A 的列空间正交,这也正是方程的意义。

将方程 AT(b- Axˆ )=0 改写,可得 AT Axˆ =ATb。两侧左乘(ATA)-1,得到:

A 的列空间 p

b

e A 的左零空间

p+e=b,说明 b 由两部分组成: p=P b 为 A 的列空间中的部分; e=(I-P )b 为 A 的左零空间中的部分。 I-P 为左零空间的投影矩阵,可以验证 (I-P )T=(I-P ),并且(I-P )2=(I-P )。

最小二乘法 Least Squares 应用投影矩阵求方程组最优解的方法,最常用于“最小二乘法”拟合曲线。

题在于向量 Ax 一定在矩阵 A 的列空间之内,但是 b 不一定,因此我们希望将 b 投 影到 A 的列空间得到 p,将问题转化为求解 A =p。 在高维投影 Projection in higher dimensions

在 R3 空间内,如何将向量 b 投影到它距离平面最近的一点 p? b

p

如果 a1 和 a2 构成了平面的一组基,则平面就是矩阵 A=[a1a2]的列空间。

=

计量经济学讲义第二讲(共十讲)

第二讲 普通最小二乘估计量 一、基本概念:估计量与估计值对总体参数的一种估计法则就是估计量。

例如,为了估计总体均值为u ,我们可以抽取一个容量为N 的样本,令Y i 为第i 次观测值,则u 的一个很自然的估计量就是ˆiY uY N==∑。

A 、B 两同学都利用了这种估计方法,但手中所掌握的样本分别是12(,,...,)A A AN y y y 与12(,,...,)B B B N y y y 。

A 、B 两同学分别计算出估计值ˆAiA y uN=∑与ˆBiB y uN=∑。

因此,在上例中,估计量ˆu是随机的,而ˆˆ,A B u u 是该随机变量可能的取值。

估计量所服从的分布称为抽样分布。

如果真实模型是:01y x ββε=++,其中01,ββ是待估计的参数,而相应的OLS 估计量就是:1012()ˆˆˆ;()iiix x yy x x x βββ-==--∑∑ 我们现在的任务就是,基于一些重要的假定,来考察上述OLS 估计量所具有的一些性质。

二、高斯-马尔科夫假定●假定一:真实模型是:01y x ββε=++。

有三种情况属于对该假定的违背:(1)遗漏了相关的解释变量或者增加了无关的解释变量;(2)y 与x 间的关系是非线性的;(3)01,ββ并不是常数。

●假定二:在重复抽样中,12(,,...,)N x x x 被预先固定下来,即12(,,...,)N x x x 是非随机的(进一步的阐释见附录),显然,如果解释变量含有随机的测量误差,那么该假定被违背。

还存其他的违背该假定的情况。

笔记:12(,,...,)N x x x 是随机的情况更一般化,此时,高斯-马尔科夫假定二被更改为:对任意,i j ,i x 与j ε不相关,此即所谓的解释变量具有严格外生性。

显然,当12(,,...,)N x x x 非随机时,i x 与j ε必定不相关,这是因为j ε是随机的。

●假定三:误差项期望值为0,即()0,1,2i E i N ε==。

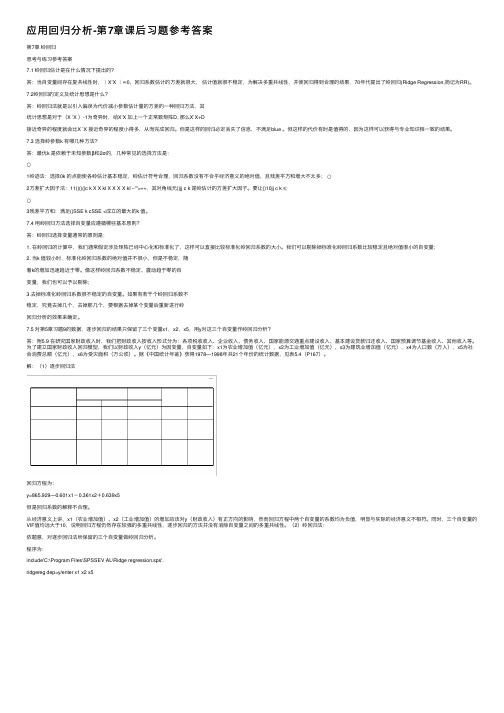

应用回归分析-第7章课后习题参考答案

应⽤回归分析-第7章课后习题参考答案第7章岭回归思考与练习参考答案7.1 岭回归估计是在什么情况下提出的?答:当⾃变量间存在复共线性时,|X’X |≈0,回归系数估计的⽅差就很⼤,估计值就很不稳定,为解决多重共线性,并使回归得到合理的结果,70年代提出了岭回归(Ridge Regression,简记为RR)。

7.2岭回归的定义及统计思想是什么?答:岭回归法就是以引⼊偏误为代价减⼩参数估计量的⽅差的⼀种回归⽅法,其统计思想是对于(X ’X )-1为奇异时,给X’X 加上⼀个正常数矩阵D, 那么X’X+D接近奇异的程度就会⽐X ′X 接近奇异的程度⼩得多,从⽽完成回归。

但是这样的回归必定丢失了信息,不满⾜blue 。

但这样的代价有时是值得的,因为这样可以获得与专业知识相⼀致的结果。

7.3 选择岭参数k 有哪⼏种⽅法?答:最优k 是依赖于未知参数β和2σ的,⼏种常见的选择⽅法是:○1岭迹法:选择0k 的点能使各岭估计基本稳定,岭估计符号合理,回归系数没有不合乎经济意义的绝对值,且残差平⽅和增⼤不太多;○2⽅差扩⼤因⼦法:11()()()c k X X kI X X X X kI --'''=++,其对⾓线元()jj c k 是岭估计的⽅差扩⼤因⼦。

要让()10jj c k ≤;○3残差平⽅和:满⾜()SSE k cSSE <成⽴的最⼤的k 值。

7.4 ⽤岭回归⽅法选择⾃变量应遵循哪些基本原则?答:岭回归选择变量通常的原则是:1. 在岭回归的计算中,我们通常假定涉及矩阵已经中⼼化和标准化了,这样可以直接⽐较标准化岭回归系数的⼤⼩。

我们可以剔除掉标准化岭回归系数⽐较稳定且绝对值很⼩的⾃变量;2. 当k 值较⼩时,标准化岭回归系数的绝对值并不很⼩,但是不稳定,随着k的增加迅速趋近于零。

像这样岭回归系数不稳定、震动趋于零的⾃变量,我们也可以予以剔除;3.去掉标准化岭回归系数很不稳定的⾃变量。

最小二乘法圆拟合资料讲解

最小二乘法圆拟合最小二乘法拟合圆公式推导及vc实现[r]最小二乘法(least squares analysis)是一种数学优化技术,它通过最小化误差的平方和找到一组数据的最佳函数匹配。

最小二乘法是用最简的方法求得一些绝对不可知的真值,而令误差平方之和为最小。

最小二乘法通常用于曲线拟合 (least squares fitting) 。

这里有拟合圆曲线的公式推导过程和 vc实现。

此处使用平方差与最小二乘法差的平方不一样,但是仍然具有实用估计价值,并且可以化简公式。

VC实现的代码:C++类void CViewActionImageTool::LeastSquaresFitting() {if (m_nNum<3){return;}int i=0;double X1=0;double Y1=0;double X2=0;double Y2=0;double Y3=0;double X1Y1=0;double X1Y2=0;double X2Y1=0;for (i=0;i<m_nNum;i++){X1 = X1 + m_points[i].x;//使用对象数组Y1 = Y1 + m_points[i].y;X2 = X2 + m_points[i].x*m_points[i].x;Y2 = Y2 + m_points[i].y*m_points[i].y;X3 = X3 + m_points[i].x*m_points[i].x*m_points[i].x;Y3 = Y3 + m_points[i].y*m_points[i].y*m_points[i].y;X1Y1 = X1Y1 + m_points[i].x*m_points[i].y;X1Y2 = X1Y2 + m_points[i].x*m_points[i].y*m_points[i].y; X2Y1 = X2Y1 + m_points[i].x*m_points[i].x*m_points[i].y; }double C,D,E,G,H,N;double a,b,c;N = m_nNum;C = N*X2 - X1*X1;D = N*X1Y1 - X1*Y1;E = N*X3 + N*X1Y2 - (X2+Y2)*X1;G = N*Y2 - Y1*Y1;H = N*X2Y1 + N*Y3 - (X2+Y2)*Y1;a = (H*D-E*G)/(C*G-D*D);b = (H*C-E*D)/(D*D-G*C);c = -(a*X1 + b*Y1 + X2 + Y2)/N;double A,B,R;A = a/(-2);B = b/(-2);R = sqrt(a*a+b*b-4*c)/2;m_fCenterX = A;m_fCenterY = B;return; }。

最小二乘参数辨识方法

《系统辨识基础》第17讲要点第5章 最小二乘参数辨识方法5.9 最小二乘递推算法的逆问题辨识是在状态可测的情况下讨论模型的参数估计问题,滤波是在模型参数已知的情况下讨论状态估计问题,两者互为逆问题。

5.10 最小二乘递推算法的几种变形最小二乘递推算法有多种不同的变形,常用的有七种情况:① 基于数据所含的信息内容不同,对数据进行有选择性的加权; ② 在认为新近的数据更有价值的假设下,逐步丢弃过去的数据; ③ 只用有限长度的数据;④ 加权方式既考虑平均特性又考虑跟综能力; ⑤ 在不同的时刻,重调协方差阵P (k ); ⑥ 设法防止协方差阵P (k )趋于零; 5.10.1 选择性加权最小二乘法 把加权最小二乘递推算法改写成[]⎪⎪⎩⎪⎪⎨⎧--=+--=--+-=-)1()]()([)(1)()1()()()()1()()()]1(ˆ)()()[()1(ˆ)(ˆ1k k k k k k k k k k k k k k k z k k k P h K P h P h h P K h K τττθθθI ΛΛ算法中引进加权因子,其目的是便于考虑观测数据的可信度.选择不同的加权方式对算法的性质会有影响,下面是几种特殊的选择:① 一种有趣的情况是Λ()k 取得很大,在极限情况下,算法就退化成正交投影算法。

也就是说,当选择⎩⎨⎧=-≠-∞=0)()1()(,00)()1()(,)(k k k k k k k h P h h P h ττΛ 构成了正交投影算法⎪⎪⎩⎪⎪⎨⎧--=--=--+-=)1()]()([)()()1()()()1()()]1(ˆ)()()[()1(ˆ)(ˆk k k k k k k k k k k k k z k k k P h K P h P h h P K h K τττθθθI 算法初始值取P ()0=I 及 ()θε0=(任定值),且当0)()1()(=-k k k h P h τ时,令K ()k =0。

1.2教案《误差理论与测量平差》第二章平差数学模型与最小二乘原理

授课题目:第二章 平差数学模型与最小二乘原理教学方法:理论讲授 教学手段:多媒体课件教学;以电子课件为主,投影及板书相结合为辅,使学生能够充分利用课堂有效的时间了解尽可能多的相关知识。

本章教学时数:4学时内容提要:主要介绍必要观测、多余观测、不符值、独立参数概念;测量平差的函数模型及两种平差的基本方程:条件方程和误差方程式;其它函数模型:附有参数的条件平差、附有限制条件的间接平差,以及平差的随机模型的概念及形态;平差基本方程的线性化,最小二乘原理。

教学要求:理解必要观测、多余观测、不符值、独立参数概念,掌握条件方程和误差方程式含义和最小二乘原理,会进行平差基本方程--条件方程和误差方程式的线性化。

本章重点:重点掌握测量平差数学模型的类型、建立方法,平差随机模型的意义和形态,以及最小二乘原理在测量平差中的应用。

教学难点:教学难点是对平差函数与随机模型含义与建立方法的理解。

本章教学总的思路:地理空间几何图形内部存在着严格的数学关系,测绘获得的是地理空间几何图形的基本元素,如角度(或方向值)、边长、高差的最佳估值,必须满足地理空间几何图形的基本数学关系,这是建立测量平差基本方程--条件方程和误差方程式的基础,在讲清楚这一点的基础上讲解基础方程的建立,进而推开讲解附有参数的条件方程、附有限制条件误差方程模型,并说明平差的随机模型的概念。

为解算的需要必须线性化条件方程式和误差方程式,其基本方法是利用泰勒级数展开基本方程并取其至一次项,从而完成线性化;在解释天然的平差模型为什么没有唯一解的原因基础上,讲解最小二乘原理,并举例验证,以此突破本课程难点内容的教学。

最后对教学重点内容作概括性总结,使学生加深理解与认知的程度。

§1测量平差概述本节教学时数:0.5学时本节重点:(1)测量元素-—角度(方向)、长度、高差、几何图的数学关系(2)观测值个数、必要观测数、多余观测数及其作用;(3)观测值、改正数、最优改正数、最优估值,平差的概念本节教学思路:以日常生活中最常见到的简单几何图三角形为例,说明测量观测值、平差值、几何图数学关系,平差模型与平差的概念,为下一节的讲讲解作好知识铺垫。

第2讲 简单回归模型

SST = SSE = SSR =

∑

n

n

i =1

(Y i − Y ) 2 (Y i − Y ) 2

∧ 2 i ∧

∑

n i =1

i=1

7

总体回归函数

o 总体回归函数(population regression function, PRF) 总体回归函数( )

在零条件均值假定下, 在零条件均值假定下, E (Y | X ) = E [( β 0 + β 1 X + u ) | X ] = β 0 + β 1 X

β 0 + β 1 X表示 X取某一确定值时 Y的均值,称为系统性成 分; 的均值,

ˆ ˆ ˆ 定义Yi = β 0 + β 1 X i 为X = X i 时Y的拟合值 ˆ ˆ ˆ ˆ 定义u = Y − Y = Y − β − β X 为X = X 时的残差

i i i i 0 1 i i

ˆ ˆ ˆ 定义Y = β 0 + β 1 X为总体回归函数 E (Y | X ) = β 0 + β 1 X 的样本回归函数 ˆ ∆Y ˆ ˆ ,表示 X变化一个单位时 Y的变化量 β1 = ∆X ˆ ˆ β 表示X = 0时Y的值

第二讲 简单回归模型

Simple Regression Model

一、基本概念 二、普通最小二乘法(OLS) 普通最小二乘法( ) 三、几个问题 四、OLS估计量的性质 估计量的性质

一、基本概念

1. 回归的涵义 2. 一个基本假定 3. 总体回归函数

回归的涵义

o 最初的涵义:回归(regress)一词最早由英国生理学家高 最初的涵义:回归( ) 尔顿( 尔顿(Galton)提出,用以指给定父母的身高后,儿女的 )提出,用以指给定父母的身高后, 身高有回复到人口总体平均身高的趋势, 身高有回复到人口总体平均身高的趋势,即“回归到中等 ”(regression to mediocrity) ) o 回归分析:在其他条件不变的情况下,考察一个变量对另 回归分析:在其他条件不变的情况下, 一个变量的影响。 一个变量的影响。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

列满秩的经济含义是什么?

第二讲 普通最小二乘法

思考题

ˆ 最小二乘估计量 是随机变量吗?为什么?

判断一个估计量好坏的标准是什么?

© School of Management and Economics, 2010

第二讲 普通最小二乘法

普通最小二乘估计

普通最小二乘估计法(OLS)

2、估计方法优劣的评判

一致性:

ˆ p lim

在有限样本情形中,经典回归模型假定数据X 是固定变量,否则最小二乘估计量可能是有偏 的。但在大样本情况下,即便X是随机的,只 要X满足一些条件,最小二乘估计量将依概率 收敛于真实值。

1. X的每一列xk不退化。 2. 随着样本量的增加,个体观测值变得不重要。

3. X列满秩。

Y2 1 2 X 22 3 X 32 k X k 2 2

Yn 1 2 X 2 n 3 X 3n k X kn n

© School of Management and Economics, 2010

第二讲 普通最小二乘法

第二讲 普通最小二乘法

普通最小二乘估计

普通最小二乘估计法(OLS)

1、原理:残差平方和最小

( y X )( y X ) yy yX X y X X

乘出来是 什么?

怎样估计 ?

© School of Management and Economics, 2010

第二讲 普通最小二乘法

普通最小二乘估计

普通最小二乘估计法(OLS)

3.最小二乘估计系数的特征

回归超平面通过数据的均值点,回归拟合值的均值等于 实际值的均值。 若一个多元回归中的变量是无关的,则多元回归的斜率 与在多个简单回归中的斜率相同。

© School of Management and Economics, 2010

无偏性

ˆ ( X X )1 X y ( X X )1 X ( X ) ( X X ) 1 X

© School of Management and Economics, 2010

估计值的均值为

ˆ E[ ] ( X X ) 1 E[ X ]

若无偏,则有

假定3是什么意思?

假定3:E[ | X ] 0

因在假定1之下有

E[ | X ] 0 cov[ X , E[ | X ]] cov[ X , ] 0 E[ X ] 0

有效性

ˆ ˆ ˆ var[ ] E[( )( )] E[( X X ) 1 X X ( X X ) 1 ]

ˆ 2 ( X 2 M1 X 2 )1 ( X 2 M1 y )

* * * ( X 2 X 2 ) 1 X 2 y*

* 其中 X 2 M 1 X 2 , * M 1 y 。 y

解释: y 是y对X1进行 X 回归后的残差变量。这个过程排除了或筛掉了的影响, 所以叫偏回归系数。

© School of Management and Economics, 2010

需要填入的变量

回归结果

回归曲线图

第二讲 普通最小二乘法

思考题

影响一个家庭消费决策的仅仅是收入因素吗? 除了身高,你认为还有哪些因素会影响一个人的 体重? ……

©10

注意两个特殊矩阵M和P ˆ e y X

y X ( X X ) 1 X y ( I X ( X X ) 1 X ) y My

M:用它乘以任一向量y,都将产生y对x回归的残差向量。

ˆ 令拟合值 y X ,则有 ˆ ˆ y y e [ I M ] y Py

P X ( X X )1 X

P(射影矩阵,投影矩阵):用它乘以任一向量y, 都将产生y对x回归的最小二乘拟合值。

偏回归系数

多元回归方程的妙用:

y X 11 X加什么,去什么。 2 2

ˆ ˆ 1 ( X 1X 1 )1 X 1( y X 2 2 )

偏回归系数的解释:当其它变量相同(保持其他变量不变) 时,特定变量对解释变量的边际影响(贡献)。

* 2是X2对X1进行回归后的残差变量,

*

第二讲 普通最小二乘法

思考题

一个超市的老总准备根据销售经理的能力来确定 其工资水平?他能实现吗? 如果某经理在春节期间卖出了大量的商品,他的 能力真的很强吗? 怎样才能解决超市老总的困扰呢?

第二讲 普通最小二乘法

多元回归模型的OLS估计

最简单的多元线性回归是三变量模型

三变量模型,即含有一个因变量和两个解释变量,其 总体回归函数PRF为:

Yi 0 1 X1i 2 X 2i i X 2i 表示什么意思?

© School of Management and Economics, 2010

对β 求导并令其等于0可得 k×k

X X X y

满足什么条件,这 个方程才有解? 满足什么条件, X X 才可逆?

若矩阵 X 的逆存在,则上述方程有解 X

ˆ ( X X )1 X y

X 假定2:数据矩阵X列满秩,即矩阵 X 的逆存在。

列满秩的隐含意思是各个自变量之间相互独立。

第二讲 普通最小二乘法

计 量 经 济 学

Econometrics

© School of Management and Economics, 2010

第二讲 普通最小二乘法

第二讲 普通最小二乘法 (教材第2章、第3章)

© School of Management and Economics, 2010

ˆ 是实际值 Yi与其估计值 Yi 之差。

© School of Management and Economics, 2010

第二讲 普通最小二乘法

普通最小二乘法

(1)采用“残差和最小” 确定直线位置?

et

(2)采用“残差绝对值 和最小”确定直线位置? (3)最小二乘法的原则 是以“残差平方和最小” 确定直线位置。

多元线性回归的基本概念

以矩阵形式表示,有

Y1 1 X 21 Y 1 X 22 Y 2 Yn 1 X 2 n

n×k

X 31 X k1 1 1 X 32 X k 2 2 2 X 3n X kn k n

2 i

2

正 规 方 程

2 ei ˆ 2 Y i 0 1 X i 0 ˆ 1 2 ei ˆ 2 Y i 0 1 X i X i 0 1 ˆ Y n 0 1 X i i 2 ˆ Y i X i 0 X i 1 X i

e

i 1

n

2

i

ˆ f ( 0 , 1 )

ˆ 1

x y x

i 2 i

i

ˆ ˆ 0 Y 2 X

怎样得到的?

其中, xi ( X i X ) ,yi (Yi Y )

© School of Management and Economics, 2010

最小二乘估计量的数学推导: ˆ min e Y i X i 0 1

样本回归线通过Y和X的样本均值 残差之和为0 OLS是“最优”的估计方法

© School of Management and Economics, 2010

第二讲 普通最小二乘法

一个例子:Eviews演示

收入-消费问题( data_2.1 ):Y是消费,X是 收入。

回归方程:

Y =0 1 X

若有 则有

( X X )1 X E[ ] X ( X X ) 1

假定4:E[ ] 2 I

假定4是什么意思?

ˆ ] 2 ( X X )1 var[

可以证明这就是最小方差。 高斯—马尔可夫定理:若前述假定条件成立, OLS估计量是最佳线性无偏估计量(BLUE)。

© School of Management and Economics, 2010

第二讲 普通最小二乘法

一元回归模型的估计问题

最小二乘法采用残差平方和最小的准则:

ˆ ˆ ) (Y X ) 2 ei (Yi Yi i 0 1 i

n n n 2 2 i 1 i 1 i 1

第二讲 普通最小二乘法

经典模型的基本假设

经典回归模型的基本假设:

假定1: E[ ] 0

X 假定2:数据矩阵X列满秩,即矩阵 X 的逆存在。

假定3:E[ | X ] 0 假定4:E[ ] 2 I

© School of Management and Economics, 2010

第二讲 普通最小二乘法

多元线性回归的基本概念

多个自变量的回归模型

假定多元线性回归模型

Y 1 2 X 2 3 X 3 k X k

那么对被解释变量Y与解释变量X2,X3,…,Xk作了 n次观测后,将所得的n组样本代入上式有 Y1 1 2 X 21 3 X 31 k X k1 1

© School of Management and Economics, 2010

第二讲 普通最小二乘法 一个例子:美国国防预算支出(data_2.2)

为了说明美国的经济实力对其国防预算的影响, 现考虑如下模型:

Yi =1 2 X 2t 3 X 3t 4 X 4t t

第二讲 普通最小二乘法