遗传算法优化BP神经网络的实现代码-共6页

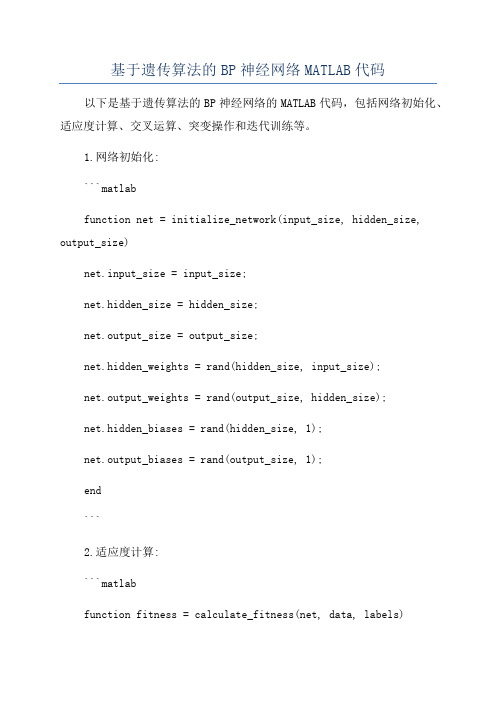

基于遗传算法的BP神经网络MATLAB代码

基于遗传算法的BP神经网络MATLAB代码以下是基于遗传算法的BP神经网络的MATLAB代码,包括网络初始化、适应度计算、交叉运算、突变操作和迭代训练等。

1.网络初始化:```matlabfunction net = initialize_network(input_size, hidden_size, output_size)net.input_size = input_size;net.hidden_size = hidden_size;net.output_size = output_size;net.hidden_weights = rand(hidden_size, input_size);net.output_weights = rand(output_size, hidden_size);net.hidden_biases = rand(hidden_size, 1);net.output_biases = rand(output_size, 1);end```2.适应度计算:```matlabfunction fitness = calculate_fitness(net, data, labels)output = forward_propagation(net, data);fitness = sum(sum(abs(output - labels)));end```3.前向传播:```matlabfunction output = forward_propagation(net, data)hidden_input = net.hidden_weights * data + net.hidden_biases;hidden_output = sigmoid(hidden_input);output_input = net.output_weights * hidden_output +net.output_biases;output = sigmoid(output_input);endfunction result = sigmoid(x)result = 1 ./ (1 + exp(-x));end```4.交叉运算:```matlabfunction offspring = crossover(parent1, parent2)point = randi([1 numel(parent1)]);offspring = [parent1(1:point) parent2((point + 1):end)]; end```5.突变操作:```matlabfunction mutated = mutation(individual, mutation_rate) for i = 1:numel(individual)if rand < mutation_ratemutated(i) = rand;elsemutated(i) = individual(i);endendend```6.迭代训练:```matlabfunction [best_individual, best_fitness] =train_network(data, labels, population_size, generations, mutation_rate)input_size = size(data, 1);hidden_size = round((input_size + size(labels, 1)) / 2);output_size = size(labels, 1);population = cell(population_size, 1);for i = 1:population_sizepopulation{i} = initialize_network(input_size, hidden_size, output_size);endbest_individual = population{1};best_fitness = calculate_fitness(best_individual, data, labels);for i = 1:generationsfor j = 1:population_sizefitness = calculate_fitness(population{j}, data, labels);if fitness < best_fitnessbest_individual = population{j};best_fitness = fitness;endendselected = selection(population, data, labels);for j = 1:population_sizeparent1 = selected{randi([1 numel(selected)])};parent2 = selected{randi([1 numel(selected)])};offspring = crossover(parent1, parent2);mutated_offspring = mutation(offspring, mutation_rate);population{j} = mutated_offspring;endendendfunction selected = selection(population, data, labels) fitnesses = zeros(length(population), 1);for i = 1:length(population)fitnesses(i) = calculate_fitness(population{i}, data, labels);end[~, indices] = sort(fitnesses);selected = population(indices(1:floor(length(population) / 2)));end```这是一个基于遗传算法的简化版BP神经网络的MATLAB代码,使用该代码可以初始化神经网络并进行迭代训练,以获得最佳适应度的网络参数。

BP算法代码实现

BP算法代码实现BP算法(Backpropagation Algorithm)是一种常用的神经网络训练算法,它主要用于监督式学习任务中的模型训练。

BP算法的核心思想是通过反向传播来更新神经网络的权重和偏差,以使得神经网络的输出逼近目标输出。

在反向传播的过程中,通过求解梯度来更新每个连接权重和偏置的值,从而最小化损失函数。

以下是BP算法的代码实现示例:```pythonimport numpy as npclass NeuralNetwork:def __init__(self, layers):yers = layersself.weights = []self.biases = []self.activations = []#初始化权重和偏置for i in range(1, len(layers)):self.weights.append(np.random.randn(layers[i], layers[i-1])) self.biases.append(np.random.randn(layers[i]))def sigmoid(self, z):return 1 / (1 + np.exp(-z))def sigmoid_derivative(self, z):return self.sigmoid(z) * (1 - self.sigmoid(z))def forward_propagate(self, X):self.activations = []activation = X#前向传播计算每一层的激活值for w, b in zip(self.weights, self.biases):z = np.dot(w, activation) + bactivation = self.sigmoid(z)self.activations.append(activation)return activationdef backward_propagate(self, X, y, output):deltas = [None] * len(yers)deltas[-1] = output - y#反向传播计算每一层的误差(梯度)for i in reversed(range(len(yers)-1)):delta = np.dot(self.weights[i].T, deltas[i+1]) * self.sigmoid_derivative(self.activations[i])deltas[i] = delta#更新权重和偏置for i in range(len(yers)-1):self.weights[i] -= 0.1 * np.dot(deltas[i+1],self.activations[i].T)self.biases[i] -= 0.1 * np.sum(deltas[i+1], axis=1)def train(self, X, y, epochs):for epoch in range(epochs):output = self.forward_propagate(X)self.backward_propagate(X, y, output)def predict(self, X):output = self.forward_propagate(X)return np.round(output)```上述代码使用numpy实现了一个简单的多层神经网络,支持任意层数和任意神经元个数的构建。

遗传算法及遗传算法优化BP神经网络实现代码

遗传算法开放分类:编程、程序、数学、计算机、算法目录• 遗传算法定义• 遗传算法特点• 遗传算法的应用• 遗传算法的现状• 遗传算法的一般算法• 遗传算法实例遗传算法定义[编辑本段]遗传算法(Genetic Algorithm)是模拟达尔文的遗传选择和自然淘汰的生物进化过程的计算模型,是一种通过模拟自然进化过程搜索最优解的方法,它是有美国Michigan 大学J.Holland教授于1975年首先提出来的,并出版了颇有影响的专著《Adaptation in Natural and Artificial Systems》,GA这个名称才逐渐为人所知,J.Hilland教授所提出的GA通常为简单遗传算法(SGA)。

遗传算法是从代表问题可能潜在的解集的一个种群(population)开始的,而一个种群则由经过基因(gene)编码的一定数目的个体(individual)组成。

每个个体实际上是染色体(chromosome)带有特征的实体。

染色体作为遗传物质的主要载体,即多个基因的集合,其内部表现(即基因型)是某种基因组合,它决定了个体的形状的外部表现,如黑头发的特征是由染色体中控制这一特征的某种基因组合决定的。

因此,在一开始需要实现从表现型到基因型的映射即编码工作。

由于仿照基因编码的工作很复杂,我们往往进行简化,如二进制编码,初代种群产生之后,按照适者生存和优胜劣汰的原理,逐代(generation)演化产生出越来越好的近似解,在每一代,根据问题域中个体的适应度(fitness)大小挑选(selection)个体,并借助于自然遗传学的遗传算子(genetic operators)进行组合交叉(crossover)和变异(mutation),产生出代表新的解集的种群。

这个过程将导致种群像自然进化一样的后生代种群比前代更加适应于环境,末代种群中的最优个体经过解码(decoding),可以作为问题近似最优解。

遗传算法特点[编辑本段] 遗传算法是一类可用于复杂系统优化的具有鲁棒性的搜索算法,与传统的优化算法相比,主要有以下特点:1、遗传算法以决策变量的编码作为运算对象。

C++实现的BP神经网络代码

#pragma hdrstop#include <stdio.h>#include <iostream.h>const A=30.0;const B=10.0;const MAX=500;//最大训练次数const COEF=0.0035; //网络的学习效率const BCOEF=0.001;//网络的阀值调整效率const ERROR=0.002; // 网络训练中的允许误差const ACCURACY=0.0005;//网络要求精度double sample[41][4]={{0,0,0,0},{5,1,4,19.020},{5,3,3,14.150},{5,5,2,14.360},{5,3,3,14.150},{5,3,2,15.390},{5,3,2,15.390},{5,5,1,19.680},{5,1,2,21.060},{5,3,3,14.150},{5,5,4,12.680},{5,5,2,14.360},{5,1,3,19.610},{5,3,4,13.650},{5,5,5,12.430},{5,1,4,19.020},{5,1,4,19.020},{5,3,5,13.390},{5,5,4,12.680},{5,1,3,19.610},{5,3,2,15.390},{1,3,1,11.110},{1,5,2,6.521},{1,1,3,10.190},{1,3,4,6.043},{1,5,5,5.242},{1,5,3,5.724},{1,1,4,9.766},{1,3,5,5.870},{1,5,4,5.406},{1,1,3,10.190},{1,1,5,9.545},{1,3,4,6.043},{1,5,3,5.724},{1,1,2,11.250},{1,3,1,11.110},{1,3,3,6.380},{1,5,2,6.521},{1,1,1,16.000},{1,3,2,7.219},{1,5,3,5.724}};double w[4][10][10],wc[4][10][10],b[4][10],bc[4][10];double o[4][10],netin[4][10],d[4][10],differ;//单个样本的误差double is; //全体样本均方差int count,a;void netout(int m, int n);//计算网络隐含层和输出层的输出void calculd(int m,int n); //计算网络的反向传播误差void calcalwc(int m,int n);//计算网络权值的调整量void calcaulbc(int m,int n); //计算网络阀值的调整量void changew(int m,int n); //调整网络权值void changeb(int m,int n);//调整网络阀值void clearwc(int m,int n);//清除网络权值变化量wcvoid clearbc(int m,int n);//清除网络阀值变化量bc-void initialw(void);//初始化NN网络权值Wvoid initialb(void); //初始化NN网络阀值void calculdiffer(void);//计算NN网络单个样本误差void calculis(void);//计算NN网络全体样本误差void trainNN(void);//训练NN网络//------------------------------------------------------------------------------------------------- ---------------// //------------------------------------------------------------------------------------------------- ---------------// //------------------------------------------------------------------------------------------------- ---------------///*计算NN网络隐含层和输出层的输出*/void netout(int m,int n){int i,j,k;//隐含层各节点的的输出for (j=1,i=2;j<=m;j++) //m为隐含层节点个数{netin[i][j]=0.0;for(k=1;k<=3;k++)//隐含层的每个节点均有三个输入变量netin[i][j]=netin[i][j]+o[i-1][k]*w[i][k][j];netin[i][j]=netin[i][j]-b[i][j];o[i][j]=A/(1+exp(-netin[i][j]/B));}//------------------------------------------------------------------------------------------------- ---------------// //------------------------------------------------------------------------------------------------- ---------------// //------------------------------------------------------------------------------------------------- ---------------////输出层各节点的输出for (j=1,i=3;j<=n;j++){netin[i][j]=0.0;for (k=1;k<=m;k++)netin[i][j]=netin[i][j]+o[i-1][k]*w[i][k][j];netin[i][j]=netin[i][j]-b[i][j];o[i][j]=A/(1+exp(-netin[i][j]/B)) ;}}//------------------------------------------------------------------------------------------------- ---------------// //------------------------------------------------------------------------------------------------- ---------------// //------------------------------------------------------------------------------------------------- ---------------///*计算NN网络的反向传播误差*/void calculd(int m,int n){int i,j,k;double t;a=count-1;d[3][1]=(o[3][1]-sample[a][3])*(A/B)*exp(-netin[3][1]/B)/pow(1+exp(-netin[3][1]/B),2);//隐含层的误差for (j=1,i=2;j<=m;j++){t=0.00;for (k=1;k<=n;k++)t=t+w[i+1][j][k]*d[i+1][k];d[i][j]=t*(A/B)*exp(-netin[i][j]/B)/pow(1+exp(-netin[i][j]/B),2);}}/*计算网络权值W的调整量*/void calculwc(int m,int n){int i,j,k;// 输出层(第三层)与隐含层(第二层)之间的连接权值的调整for (i=1,k=3;i<=m;i++){for (j=1;j<=n;j++){wc[k][i][j]=-COEF*d[k][j]*o[k-1][i]+0.5*wc[k][i][j];}// printf("\n");}//隐含层与输入层之间的连接权值的调整for (i=1,k=2;i<=m;i++){for (j=1;j<=m;j++){wc[k][i][j]=-COEF*d[k][j]*o[k-1][i]+0.5*wc[k][i][j];}//printf("\n");}}//------------------------------------------------------------------------------------------------- ---------------// //------------------------------------------------------------------------------------------------- ---------------// //------------------------------------------------------------------------------------------------- ---------------///*计算网络阀值的调整量*/void calculbc(int m,int n){int j;for (j=1;j<=m;j++){bc[2][j]=BCOEF*d[2][j];}for (j=1;j<=n;j++){bc[3][j]=BCOEF*d[3][j];}}//------------------------------------------------------------------------------------------------- ---------------// //------------------------------------------------------------------------------------------------- ---------------// //------------------------------------------------------------------------------------------------- ---------------///*调整网络权值*/void changw(int m,int n){int i,j;for (i=1;i<=3;i++)for (j=1;j<=m;j++){w[2][i][j]=0.9*w[2][i][j]+wc[2][i][j];//为了保证系统有较好的鲁棒性,计算权值时乘惯性系数0.9printf("w[2][%d][%d]=%f\n",i,j,w[2][i][j]);}for (i=1;i<=m;i++)for (j=1;j<=n;j++){w[3][i][j]=0.9*w[3][i][j]+wc[3][i][j];printf("w[3][%d][%d]=%f\n",i,j,w[3][i][j]);}}//------------------------------------------------------------------------------------------------- ---------------// //------------------------------------------------------------------------------------------------- ---------------// //------------------------------------------------------------------------------------------------- ---------------///*调整网络阀值*/void changb(int m,int n){int j;for (j=1;j<=m;j++)b[2][j]=b[2][j]+bc[2][j];for (j=1;j<=n;j++)b[3][j]=b[3][j]+bc[3][j];}//------------------------------------------------------------------------------------------------- ---------------////------------------------------------------------------------------------------------------------- ---------------// //------------------------------------------------------------------------------------------------- ---------------///*清除网络权值变化量wc*/void clearwc(void){for (int i=0;i<4;i++)for (int j=0;j<10;j++)for (int k=0;k<10;k++)wc[i][j][k]=0.00;}//------------------------------------------------------------------------------------------------- ---------------// //------------------------------------------------------------------------------------------------- ---------------// //------------------------------------------------------------------------------------------------- ---------------///*清除网络阀值变化量*/void clearbc(void){for (int i=0;i<4;i++)for (int j=0;j<10;j++)bc[i][j]=0.00;}//------------------------------------------------------------------------------------------------- ---------------// //------------------------------------------------------------------------------------------------- ---------------// //------------------------------------------------------------------------------------------------- ---------------///*初始化网络权值W*/void initialw(void){int i,j,k,x;double weight;for (i=0;i<4;i++)for (j=0;j<10;j++)for (k=0;k<10;k++){randomize();x=100+random(400);weight=(double)x/5000.00;w[i][j][k]=weight;}}//------------------------------------------------------------------------------------------------- ---------------// //------------------------------------------------------------------------------------------------- ---------------// //------------------------------------------------------------------------------------------------- ---------------///*初始化网络阀值*/void initialb(void){int i,j,x;double fazhi;for (i=0;i<4;i++)for (j=0;j<10;j++){randomize();for (int k=0;k<12;k++){x=100+random(400);}fazhi=(double)x/50000.00;b[i][j]=fazhi;}}//------------------------------------------------------------------------------------------------- ---------------// //------------------------------------------------------------------------------------------------- ---------------// //------------------------------------------------------------------------------------------------- ---------------///*计算网络单个样本误差*/void calculdiffer(void){a=count-1;differ=0.5*(o[3][1]-sample[a][3])*(o[3][1]-sample[a][3]);}void calculis(void){is=0.0;for (i=0;i<=19;i++){o[1][1]=sample[i][0];o[1][2]=sample[i][1];o[1][3]=sample[i][2];netout(8,1);is=is+(o[3][1]-sample[i][3])*(o[3][1]-sample[i][3]);}is=is/20;}//------------------------------------------------------------------------------------------------- ---------------// //------------------------------------------------------------------------------------------------- ---------------// //------------------------------------------------------------------------------------------------- ---------------///*训练网络*/void trainNN(void){long int time;initialw();initialb();for (time=1;time<=MAX;time++){count=0;while(count<=40){o[1][1]=sample[count][0];o[1][2]=sample[count][1];o[1][3]=sample[count][2];count=count+1;clearwc();clearbc();netout(8,1);calculdiffer();while(differ>ERROR)calculd(8,1);calculwc(8,1);calculbc(8,1);changw(8,1);changb(8,1);netout(8,1);calculdiffer();}}printf("This is %d times training NN...\n",time);calculis();printf("is==%f\n",is);if (is<ACCURACY) break;}}//------------------------------------------------------------------------------------------------- ---------------// //------------------------------------------------------------------------------------------------- ---------------// //------------------------------------------------------------------------------------------------- ---------------// #pragma argsusedint main(int argc, char* argv[]){double result;int m,test[4];char ch='y';cout<<"Please wait for the train of NN:"<<endl;trainNN();cout<<"Now,this modular network can work for you."<<endl;while(ch=='y' || ch=='Y'){cout<<"Please input data to be tested."<<endl;for (m=1;m<=3;m++)cin>>test[m];ch=getchar();o[1][1]=test[1];o[1][2]=test[2];o[1][3]=test[3];netout(8,1);result=o[3][1];printf("Final result is %f.\n",result); printf("Still test?[Yes] or [No]\n"); ch=getchar();}return 0;}。

GA优化BP网络代码

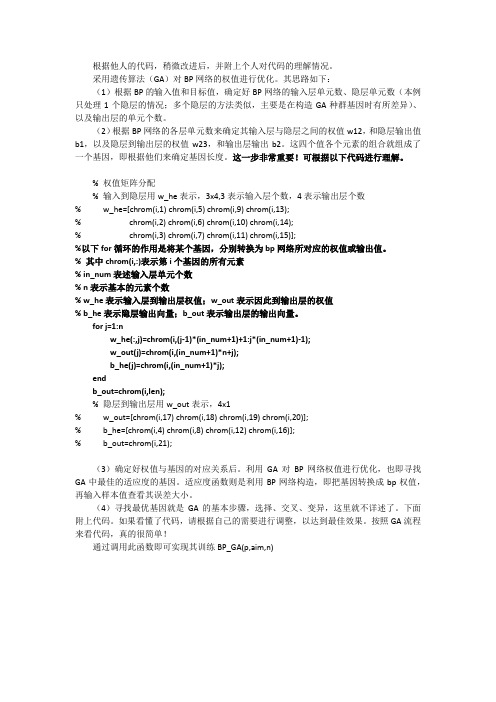

根据他人的代码,稍微改进后,并附上个人对代码的理解情况。

采用遗传算法(GA)对BP网络的权值进行优化。

其思路如下:(1)根据BP的输入值和目标值,确定好BP网络的输入层单元数、隐层单元数(本例只处理1个隐层的情况;多个隐层的方法类似,主要是在构造GA种群基因时有所差异)、以及输出层的单元个数。

(2)根据BP网络的各层单元数来确定其输入层与隐层之间的权值w12,和隐层输出值b1,以及隐层到输出层的权值w23,和输出层输出b2。

这四个值各个元素的组合就组成了一个基因,即根据他们来确定基因长度。

这一步非常重要!可根据以下代码进行理解。

% 权值矩阵分配% 输入到隐层用w_he表示,3x4,3表示输入层个数,4表示输出层个数% w_he=[chrom(i,1) chrom(i,5) chrom(i,9) chrom(i,13);% chrom(i,2) chrom(i,6) chrom(i,10) chrom(i,14);% chrom(i,3) chrom(i,7) chrom(i,11) chrom(i,15)];%以下for循环的作用是将某个基因,分别转换为bp网络所对应的权值或输出值。

% 其中chrom(i,:)表示第i个基因的所有元素% in_num表述输入层单元个数% n表示基本的元素个数% w_he表示输入层到输出层权值;w_out表示因此到输出层的权值% b_he表示隐层输出向量;b_out表示输出层的输出向量。

for j=1:nw_he(:,j)=chrom(i,(j-1)*(in_num+1)+1:j*(in_num+1)-1);w_out(j)=chrom(i,(in_num+1)*n+j);b_he(j)=chrom(i,(in_num+1)*j);endb_out=chrom(i,len);% 隐层到输出层用w_out表示,4x1% w_out=[chrom(i,17) chrom(i,18) chrom(i,19) chrom(i,20)];% b_he=[chrom(i,4) chrom(i,8) chrom(i,12) chrom(i,16)];% b_out=chrom(i,21);(3)确定好权值与基因的对应关系后。

遗传算法优化BP神经网络权值和阈值(完整版)

/viewthread.php?tid= 50653&extra=&highlight=%E9%81%97%E4%BC%A0%E7% AE%97%E6%B3%95&page=1Matlab遗传算法优化神经网络的例子(已调试成功)最近论坛里问到用遗传算法优化神经网络问题的人很多,而且论坛里有很多这方面的代码。

但可惜的是所有代码都或多或少有些错误!最郁闷的莫过于只有发帖寻求问题答案的探索者,却很少有对问题进行解答的victor。

本人在论坛里看到不少会员对能运行成功的遗传算法优化神经网络例子的需求是多么急切,我也深有感触!现把调试成功的一个例子贴出来,供大家参考!(本例子是基于一篇硕士论文里的代码为蓝本改编的,此处就不再注明作者了。

)遗传算法优化bp.rar (3.34 KB)注:该代码是由会员“书童”耗费了一整天的时间调试成功的,在此再次对我们的“书童”同学乐于助人的高尚品德致敬,并对其深表感谢!PS:参考会员“ilovexyq”意见,先对其做以补充。

该网络为遗传算法优化bp的一个典型例子,输入为7,输出为7,隐层为25。

该网络输入输出数据就是为了说明问题而随便加的,没有实际意义。

如用于自己的实际问题,把数据替换并根据需要改一下网络结构就行了。

PS:如有问题,请先阅读此贴:/thread-52587-1-1.html###[本帖最后由 yuthreestone 于 2009-10-15 10:52 编辑]搜索更多相关主题的帖子: 调试例子算法Matlab神经网络/thread-52587-1-1.html遗传算法优化BP神经网络权值和阈值(完整版)会员renjia前一段时间分享的程序,地址如下:/viewthread.php?tid=50653&extra=&highlight=% E9%81%97%E4%BC%A0%E7%AE%97%E6%B3%95&page=1:(1)renjia提供的程序存在一些小错误,主要是设计的bp网络是两个隐含层,但编码的时候只有一个隐含层。

基于遗传算法的BP神经网络优化算法

案例3:基于遗传算法的BP神经网络优化算法******************************************************************************* ****论坛申明:1 案例为原创案例,论坛拥有帖子的版权,转载请注明出处(MATLABSKY论坛,《MATLAB智能算法30个案例分析》2 案例内容为书籍原创内容,内容为案例的提纲和主要内容。

3 作者长期驻扎在板块,对读者和会员问题有问必答。

4 案例配套有教学视频和完整的MATLAB程序,MATLAB程序在购买书籍后可以自由下载,教学视频需要另外购买。

MATLAB书籍预定方法和优惠服务:/thread-9258-1-1.html点击这里,预览该案例程序:/znsf/view/s3/GABPMain.html 已经预定的朋友点此下载程序源代码:/thread-11921-1-1.html ******************************************************************************** **1、案例背景BP网络是一类多层的前馈神经网络。

它的名字源于在网络训练的过程中,调整网络的权值的算法是误差的反向传播的学习算法,即为BP学习算法。

BP算法是Rumelhart等人在1986年提出来的。

由于它的结构简单,可调整的参数多,训练算法也多,而且可操作性好,BP 神经网络获得了非常广泛的应用。

据统计,有80%~90%的神经网络模型都是采用了BP网络或者是它的变形。

BP网络是前向网络的核心部分,是神经网络中最精华、最完美的部分。

BP神经网络虽然是人工神经网络中应用最广泛的算法,但是也存在着一些缺陷,例如:①、学习收敛速度太慢;②、不能保证收敛到全局最小点;③、网络结构不易确定。

另外,网络结构、初始连接权值和阈值的选择对网络训练的影响很大,但是又无法准确获得,针对这些特点可以采用遗传算法对神经网络进行优化。

pso优化bp算法python代码

pso优化bp算法python代码PSO优化BP算法Python代码是基于粒子群算法(PSO)和BP(反向传播)神经网络算法的优化算法,用于解决分类和回归问题。

以下是一些关键的Python代码段来实现此算法:1. 导入必要的库```pythonimport numpy as npimport random```2. 定义神经网络类```pythonclass NeuralNetwork:def __init__(self, inputs, hidden, outputs):self.input_nodes = inputsself.hidden_nodes = hiddenself.output_nodes = outputsself.weights_ih = np.random.randn(self.hidden_nodes, self.input_nodes)self.weights_ho = np.random.randn(self.output_nodes, self.hidden_nodes)self.bias_h = np.random.randn(self.hidden_nodes, 1)self.bias_o = np.random.randn(self.output_nodes, 1)```3. 定义激活函数sigmoid```pythondef sigmoid(x):return 1 / (1 + np.exp(-x))```4. 定义前向传播函数```pythondef feedforward(self, input_array):inputs = np.array(input_array, ndmin=2).Thidden_inputs = np.dot(self.weights_ih, inputs) +self.bias_hhidden_outputs = sigmoid(hidden_inputs)final_inputs = np.dot(self.weights_ho, hidden_outputs) + self.bias_ofinal_outputs = sigmoid(final_inputs)return final_outputs```5. 定义损失函数```pythondef mse_loss(self, input_array, target):inputs = np.array(input_array, ndmin=2).Ttargets = np.array(target, ndmin=2).Toutputs = self.feedforward(inputs)return np.mean((targets - outputs)**2)```6. 定义粒子类```pythonclass Particle:def __init__(self, dim):self.position = np.random.randn(dim, 1)self.velocity = np.random.randn(dim, 1)self.best_position = self.positionself.best_cost = float('inf')```7. 定义PSO算法类```pythonclass PSO:def __init__(self, cost_function, dimension, swarm_size, max_iter):self.cf = cost_functionself.dim = dimensionself.swarm_size = swarm_sizeself.max_iter = max_iterself.swarm = [Particle(self.dim) for i inrange(self.swarm_size)]self.best_swarm_position = self.swarm[0].positionself.best_swarm_cost = float('inf')```8. 定义更新粒子位置和速度的函数```pythondef update_particle(self, particle):w = 0.729c1 = 1.49445c2 = 1.49445r1 = random.random()r2 = random.random()new_velocity = w * particle.velocity + c1 * r1 * (particle.best_position - particle.position) + c2 * r2 * (self.best_swarm_position - particle.position)new_position = particle.position + new_velocityparticle.velocity = new_velocityparticle.position = new_position```9. 定义运行PSO算法的函数```pythondef run(self):for i in range(self.max_iter):for particle in self.swarm:cost = self.cf(particle.position)if cost < particle.best_cost:particle.best_position = particle.positionparticle.best_cost = costif cost < self.best_swarm_cost:self.best_swarm_position = particle.positionself.best_swarm_cost = costfor particle in self.swarm:self.update_particle(particle)```10. 实例化神经网络和PSO算法,运行PSO优化BP算法```pythonnn = NeuralNetwork(2, 3, 1)pso = PSO(nn.mse_loss, nn.weights_ih.size +nn.weights_ho.size + nn.bias_h.size + nn.bias_o.size, 20, 100) pso.run()```以上是使用Python实现PSO优化BP算法的主要代码段。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

%读取数据data=xlsread('data.xls');%训练预测数据data_train=data(1:113,:);data_test=data(118:123,:);input_train=data_train(:,1:9)';output_train=data_train(:,10)';input_test=data_test(:,1:9)';output_test=data_test(:,10)';%数据归一化[inputn,mininput,maxinput,outputn,minoutput,maxoutput]=premnmx(input_tr ain,output_train); %对p和t进行字标准化预处理net=newff(minmax(inputn),[10,1],{'tansig','purelin'},'trainlm');net.trainParam.epochs=100;net.trainParam.lr=0.1;net.trainParam.goal=0.00001;%net.trainParam.show=NaN%网络训练net=train(net,inputn,outputn);%数据归一化inputn_test = tramnmx(input_test,mininput,maxinput);an=sim(net,inputn);test_simu=postmnmx(an,minoutput,maxoutput);error=test_simu-output_train;plot(error)k=error./output_trainfunction ret=Cross(pcross,lenchrom,chrom,sizepop,bound)%本函数完成交叉操作% pcorss input : 交叉概率% lenchrom input : 染色体的长度% chrom input : 染色体群% sizepop input : 种群规模% ret output : 交叉后的染色体for i=1:sizepop %每一轮for循环中,可能会进行一次交叉操作,染色体是随机选择的,交叉位置也是随机选择的,%但该轮for循环中是否进行交叉操作则由交叉概率决定(continue控制)% 随机选择两个染色体进行交叉pick=rand(1,2);while prod(pick)==0pick=rand(1,2);endindex=ceil(pick.*sizepop);% 交叉概率决定是否进行交叉pick=rand;while pick==0pick=rand;endif pick>pcrosscontinue;endflag=0;while flag==0% 随机选择交叉位pick=rand;while pick==0pick=rand;endpos=ceil(pick.*sum(lenchrom)); %随机选择进行交叉的位置,即选择第几个变量进行交叉,注意:两个染色体交叉的位置相同pick=rand; %交叉开始v1=chrom(index(1),pos);v2=chrom(index(2),pos);chrom(index(1),pos)=pick*v2+(1-pick)*v1;chrom(index(2),pos)=pick*v1+(1-pick)*v2; %交叉结束flag1=test(lenchrom,bound,chrom(index(1),:)); %检验染色体1的可行性 flag2=test(lenchrom,bound,chrom(index(2),:)); %检验染色体2的可行性if flag1*flag2==0flag=0;else flag=1;end%如果两个染色体不是都可行,则重新交叉endendret=chrom;% 清空环境变量clcclear%%% 网络结构建立%读取数据load data input output%节点个数inputnum=2;hiddennum=5;outputnum=1;%训练数据和预测数据input_train=input(1:1900,:)';input_test=input(1901:2019,:)';output_train=output(1:1900)';output_test=output(1901:2019)';%选连样本输入输出数据归一化[inputn,inputps]=mapminmax(input_train);[outputn,outputps]=mapminmax(output_train);%构建网络net=newff(inputn,outputn,hiddennum);%% 遗传算法参数初始化maxgen=10; %进化代数,即迭代次数sizepop=10; %种群规模pcross=[0.3]; %交叉概率选择,0和1之间pmutation=[0.1]; %变异概率选择,0和1之间%节点总数numsum=inputnum*hiddennum+hiddennum+hiddennum*outputnum+outputnum;lenchrom=ones(1,numsum);bound=[-3*ones(numsum,1) 3*ones(numsum,1)]; %数据范围%------------------------------------------------------种群初始化--------------------------------------------------------individuals=struct('fitness',zeros(1,sizepop), 'chrom',[]); %将种群信息定义为一个结构体avgfitness=[]; %每一代种群的平均适应度bestfitness=[]; %每一代种群的最佳适应度bestchrom=[]; %适应度最好的染色体%初始化种群for i=1:sizepop%随机产生一个种群individuals.chrom(i,:)=Code(lenchrom,bound); %编码(binary和grey的编码结果为一个实数,float的编码结果为一个实数向量)x=individuals.chrom(i,:);%计算适应度individuals.fitness(i)=fun(x,inputnum,hiddennum,outputnum,net,inputn,ou tputn); %染色体的适应度end%找最好的染色体[bestfitness bestindex]=min(individuals.fitness);bestchrom=individuals.chrom(bestindex,:); %最好的染色体avgfitness=sum(individuals.fitness)/sizepop; %染色体的平均适应度% 记录每一代进化中最好的适应度和平均适应度trace=[avgfitness bestfitness];%% 迭代求解最佳初始阀值和权值% 进化开始for i=1:maxgeni% 选择individuals=Select(individuals,sizepop);avgfitness=sum(individuals.fitness)/sizepop;%交叉individuals.chrom=Cross(pcross,lenchrom,individuals.chrom,sizepop,bound );% 变异individuals.chrom=Mutation(pmutation,lenchrom,individuals.chrom,sizepop ,i,maxgen,bound);% 计算适应度for j=1:sizepopx=individuals.chrom(j,:); %解码individuals.fitness(j)=fun(x,inputnum,hiddennum,outputnum,net,inputn,ou tputn);end%找到最小和最大适应度的染色体及它们在种群中的位置[newbestfitness,newbestindex]=min(individuals.fitness);[worestfitness,worestindex]=max(individuals.fitness);% 代替上一次进化中最好的染色体if bestfitness>newbestfitnessbestfitness=newbestfitness;bestchrom=individuals.chrom(newbestindex,:);endindividuals.chrom(worestindex,:)=bestchrom;individuals.fitness(worestindex)=bestfitness;avgfitness=sum(individuals.fitness)/sizepop;trace=[trace;avgfitness bestfitness]; %记录每一代进化中最好的适应度和平均适应度end%% 遗传算法结果分析figure(1)[r c]=size(trace);plot([1:r]',trace(:,2),'b--');title(['适应度曲线 ''终止代数=' num2str(maxgen)]);xlabel('进化代数');ylabel('适应度');legend('平均适应度','最佳适应度');disp('适应度变量');x=bestchrom;%% 把最优初始阀值权值赋予网络预测% %用遗传算法优化的BP网络进行值预测w1=x(1:inputnum*hiddennum);B1=x(inputnum*hiddennum+1:inputnum*hiddennum+hiddennum);w2=x(inputnum*hiddennum+hiddennum+1:inputnum*hiddennum+hiddennum+hidden num*outputnum);B2=x(inputnum*hiddennum+hiddennum+hiddennum*outputnum+1:inputnum*hidden num+hiddennum+hiddennum*outputnum+outputnum);net.iw{1,1}=reshape(w1,hiddennum,inputnum);net.lw{2,1}=reshape(w2,outputnum,hiddennum);net.b{1}=reshape(B1,hiddennum,1);net.b{2}=B2;%% BP网络训练%网络进化参数net.trainParam.epochs=100;net.trainParam.lr=0.1;%net.trainParam.goal=0.00001;%网络训练[net,per2]=train(net,inputn,outputn);%% BP网络预测%数据归一化inputn_test=mapminmax('apply',input_test,inputps);an=sim(net,inputn_test);test_simu=mapminmax('reverse',an,outputps);error=test_simu-output_test;。