第四讲 多维无约束最优化Newton法、最速下降法

第四章—牛顿法求解无约束问题

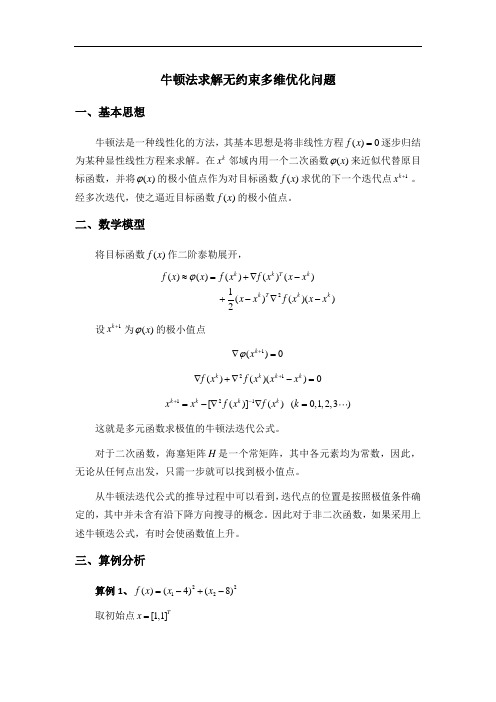

牛顿法求解无约束多维优化问题一、基本思想牛顿法是一种线性化的方法,其基本思想是将非线性方程()0f x =逐步归结为某种显性线性方程来求解。

在k x 邻域内用一个二次函数()x ϕ来近似代替原目标函数,并将()x ϕ的极小值点作为对目标函数()f x 求优的下一个迭代点1k x +。

经多次迭代,使之逼近目标函数()f x 的极小值点。

二、数学模型将目标函数()f x 作二阶泰勒展开,设1k x +为()x ϕ的极小值点1()0k x ϕ+∇=21()()()0k k k k f x f x x x +∇+∇-=121[()]()(0,1,2,3)k k k k x x f x f x k +-=-∇∇= 这就是多元函数求极值的牛顿法迭代公式。

对于二次函数,海塞矩阵H 是一个常矩阵,其中各元素均为常数,因此,无论从任何点出发,只需一步就可以找到极小值点。

从牛顿法迭代公式的推导过程中可以看到,迭代点的位置是按照极值条件确定的,其中并未含有沿下降方向搜寻的概念。

因此对于非二次函数,如果采用上述牛顿迭公式,有时会使函数值上升。

三、算例分析算例1、2212()(4)(8)f x x x =-+-取初始点[1,1]T x =2()()()()()1()()()2k k T k k T k k f x x f x f x x x x x f x x x ϕ≈=+∇-+-∇-初步分析,目标函数为二次函数,经过一次迭代即可得到。

编制程序及计算结果如下:syms x1 x2;f=(x1-4)^2+(x2-8)^2;v=[x1,x2];df=jacobian(f,v);df=df.';G=jacobian(df,v);e = 1e-12;x0=[1,1]';g1=subs(df,{x1,x2},{x0(1,1),x0(2,1)});G1=subs(G,{x1,x2},{x0(1,1),x0(2,1)});k=0;while(norm(g1)>e)p=-G1\g1;x0=x0+p;g1=subs(df,{x1,x2},{x0(1,1),x0(2,1)});G1=subs(G,{x1,x2},{x0(1,1),x0(2,1)});k=k+1;end;kx0结果:k =1x0 =48正如分析所得,迭代一次即可得出极小值点。

无约束优化方法

无约束优化方法1. 最速下降法(Gradient Descent Method)最速下降法是一种基于梯度信息的迭代优化算法。

其基本思想是从任意初始点开始,沿着目标函数的梯度方向进行迭代,直到达到收敛条件。

最速下降法的迭代更新公式如下:x_{k+1}=x_k-t_k*∇f(x_k)其中,x_k是第k次迭代的解向量,t_k是第k次迭代的步长(也称为学习率),∇f(x_k)是目标函数在x_k处的梯度向量。

最速下降法的步骤如下:1)选取初始点x_0。

2)计算目标函数的梯度∇f(x_k)。

3)计算步长t_k。

4)更新解向量x_{k+1}。

5)判断迭代终止条件,如果满足则停止迭代;否则返回第2步。

最速下降法的优点是易于实现和理解,收敛性较好。

然而,最速下降法存在的问题是收敛速度较慢,特别是对于目标函数呈现狭长或弯曲形状的情况下。

这导致了在高维优化问题中,最速下降法的性能较差。

2. 牛顿法(Newton's Method)牛顿法是一种基于二阶导数信息的迭代优化算法。

它使用目标函数的一阶和二阶导数信息构造一个二次近似模型,然后求解该模型的最小值。

牛顿法的迭代更新公式如下:x_{k+1}=x_k-H_k^{-1}*∇f(x_k)其中,H_k是目标函数在x_k处的海森矩阵,∇f(x_k)是目标函数在x_k处的梯度向量。

牛顿法的步骤如下:1)选取初始点x_0。

2)计算目标函数的梯度∇f(x_k)和海森矩阵H_k。

3)计算更新方向H_k^{-1}*∇f(x_k)。

4)更新解向量x_{k+1}。

5)判断迭代终止条件,如果满足则停止迭代;否则返回第2步。

牛顿法的优点是收敛速度快,尤其是在目标函数曲率大的地方。

然而,牛顿法也存在一些问题。

首先,计算海森矩阵需要大量的计算资源,特别是在高维空间中。

其次,当海森矩阵不可逆或近似不可逆时,牛顿法可能会失效。

综上所述,最速下降法和牛顿法是两种常用的无约束优化方法。

最速下降法简单易实现,但收敛速度较慢;牛顿法收敛速度快,但计算量大且可能遇到海森矩阵不可逆的问题。

工程优化 第4章-4

优点:计算量较少,而且总能收敛到一个局部极小点。 缺点:收敛速度较慢

牛顿法(Newton)---基本思想

牛顿法是一种函数逼近法,基本思想是:在极小点附近用 函数的二阶泰勒多项式近似代替目标函数,从而求得目标函数 的极小点的近似值。 对 f (x) 在 x k 点二阶泰勒展开:

f ( x) f ( xk ) f '( xk )( x xk )

从极值的必要条件 P x a1 2a2 x 0

求得

x a1 / 2a2

求出系数 a1 和 a2 ,就可得到极小点的表达式。

x a1 / 2a2

1 x 2 x

2 2 2

2 x3 f1 x32 x12 f 2 x12 x22 f 3

P x1 a0 a1 x1 a2 x12 f1 f x1

(1) (2) (3)

P x2 a0 a1 x2 a2 x22 f2 f x2

P x3 a0 a1 x3 a2 x32 f3 f x3

插值法---求二次插值多项式的极小点

0, 令 k 1 。 步骤1:给定初始点 x1 R,

步骤2:计算 f '( xk ), f ''( xk ) 。

步骤3:若 f '( xk ) ,停止,x* xk ,否则转步骤4。 步骤4:计算

f '( xk ) xk 1 =xk f ''( xk )

令 k k 1,转步骤2。 特点:收敛速度快,局部二阶收敛。 缺点:须计算二次导数,工作量大;对初始点要求高,要求初 始点离极小点不太远,否则有可能使极小化发散或收敛到非极 小点;局部收敛。

无约束优化算法--最速下降法

无约束优化算法无约束优化算法问题,是指优化问题的可行集为nR ,无约束的标准形式为: min ():n f x f R R →1. 最优性条件(1) 极小值点的一阶必要条件设():n f x R R →为连续可微函数,如果*x 为局部极小值点,则*x 为驻点,即梯度*()0f x ∇=。

(2) 极小值的二阶必要条件设():n f x R R →为二阶连续可微函数,如果*x 为局部极小值点,则*x 为驻点,即梯度*()0f x ∇=,二阶hesse 2*()f x ∇半正定。

(3) 极小值点的二阶充分条件设():n f x R R →为二阶连续可微函数,如果梯度*()0f x ∇=,二阶h e s s e 2*()f x ∇正定,则*x 为f 的局部极小值点,*n x R ∈。

以上三个定理为搜索最优点以及判断一个点是否为最优点的基本依据。

经典的优化算法的停止条件为*()0f x ∇=,例如在程序中*8()110f x -∇≤⨯ ,即在导数范数小于某特定误差限时停止。

误差限较大,则算法迭代次数减少,计算时间缩短,但解得质量降低;误差限较小,则算法迭代次数增加,计算时间增加,但解的质量提高;误差限一般为8110-⨯,可以根据实际情况设定合适的误差限。

当然,还有极小值点的二阶必要条件与极小值点的二阶充分条件,对2*()f x ∇的判断,由于目标函数比较复杂,二阶导数矩阵的计算量极大,所以一般算法都在迭代过程中对2()()k f x∇进行修正,得到2(1)()k f x +∇,在修正的过程中始终保持2*()f x ∇的正定性,以此方法解决极小值点的二阶条件问题。

2. 最速下降法2.1 算法原理最速下降法是早期的优化算法,其理论根据函数的一阶泰勒展开: 由()()()()Tf x d f x f x d d ααοα+=+∇+ 得到()()()()T f x d f x f x d d ααοα+-=∇+根据下降要求()()0f x d f x α+-≤ 故()()0Tf x d d αοα∇+≤实际中要求()0T f x d α∇≤根据上式选取合适的d ,得()0T f x d α∇≤。

无约束常用优化方法

步长 ,作前进(或后退)试探.如试探成功(目

标函数值有所减小),则按步长序列

,加

大步长(注意每次加大步长都是由初始点算起),直

至试探失败(目标函数值比前一次的有所增加)时,

则取其前一次的步长作为沿这个坐标轴方向搜索的最

优步长,并计算出该方向上的终止点,而后以这个终

止点为始点再进行下一坐标轴方向的搜索,并重复上

处

显然 是二次函数,并且还是正定二次函数,所以 是凸函数且存在唯一全局极小点.为求此极小点,令

即可解得

即

(5.9)

对照基本迭代公式,易知,式(5.9)中的搜索方向

步长因子

方向

是直指点 处近似二次函数

的极小点的方向.此时称此方向为从点 出发的

Newton方向.从初始点开始,每一轮从当前迭代点出发,

沿Newton方向并取步长 的算法称为Newton法.

另外,共轭梯度法不要求精确的直线搜 索.但是,不精确的直线搜索可能导致迭代 出来的向量不再共轭,从而降低方法的效 能.克服的办法是,重设初始点,即把经过 n次迭代得到的Xn作为初始点重新迭代.

五、坐标轮换法

在坐标轮换法中,沿各个坐标轴方向进行一维搜索

时,常选用最优步长法或加速步长法.加速步长法从

初始点出发,沿搜索(坐标轴)方向先取一个较小的

三、共轭方向法

1、概念

通常,我们把从任意点

出发,依次沿某组共轭

方向进行一维搜索的求解最优化问题的方法,叫做共

轭方向法.

2、特点

• 一般地,在n维空间中可以找出n个互相共轭的方向,对于n元正 定二次函数,从任意初始点出发,顺次沿这n个共轭方向最多作n 次直线搜索就可以求得目标函数的极小点.这就是共轭方向法的 算法形成的基本思想.

西南交大运筹学《无约束最优化方法》

运筹学Operations Research无约束最优化方法西南交通大学经济管理学院§1.最速下降法§2.Newton法§3.共轭梯度法§4.变尺度法§5.直接法)()()()(0)(,,1,P o P X f X f P X f X f X f P E P T k k k k kn λλλ+∇+=+≠∇=∈非零:处的梯度它在是连续可微的函数即是单位向量设P X f o P X f X f P X f P f P X X f T k T k k k k)()()(lim )()(lim )(00∇=+∇=−+=∂∂→→λλλλλλλ的方向导数为:处关于方向在点k k k k T k kk T k X f P X f P X f P X f P P X f θθθcos )(cos )()()()(∇=⋅∇=∇∇∇之间的夹角,则和为。

记就是使下降最快的方向取最小的使处的最速下降方向。

在点通常把它叫做下降最快的方向。

出发使是从点时,上式最小,所以可知,当k kk k k X f f X X f P )(:−∇==πθ下降的搜索方向。

再去寻找使处不需要在点这时的点局部最优解的必要条件的已是满足的驻点。

是,则若f X X f X X f k k k k ,,)NP (0)(=∇:,)(,,,;,,,,,1的最佳步长,即作为点最小的确定使来的一维搜索即通过在负梯度方向上最佳步长方法采用振荡的情况。

所以一般在极值点附近出现来回则若步长选得大计算次数较多则收敛慢长选得小若步。

选择用固定步长时还要确定步长方向之后在选定了搜索得到下一个近似点为了由点+kk k k X X f X X λλ))((min ))((0kk k k k X f X f X f X f ∇−=∇−>λλλ§1.最速下降法)()()()()(0)()()()()())(()()()(21)()()())((2k k T k k T k k k k T k k T k k k k k T k kT k k k k X f X H X f X f X f X f X H X f X f X f d X f X df X f X H X f X f X f X f X f X f ∇∇∇∇==∇∇+∇−∇=∇−∇∇+∇∇−≈∇−λλλλλλλλ得:求导并令其等于零,则对§1.最速下降法Step1.。

第四讲 多维无约束最优化Newton法、最速下降法

最速下降法流程图

x(1), ε >0, k=1

k=k+1 || ▽f(x(k) ) ||< ε? No

Yes

stop. x(k) –解

d(k)= -▽f(x(k) )

解 min f(x(k)+λ d(k)) s.t. λ >0 得 x(k+1)=x(k)+λkd(k)

Goldste ε >0 d(1)=-▽ f(x(1)),k=1

k=k+1 ||▽ f(x(k))||< ε? k=1

y

Stop.x(k)—解

N

解 min f(x(k)+λ d(k)) s.t. λ >0

得 λk x(k+1)=x(k)+λk d(k) 求β k d(k+1)= -▽ f(x(k+1))+β kd(k)

共轭梯度法的特点

全局收敛(下降算法);线性收敛; 每步迭代只需存储若干向量(适用于大 规模问题); 有二次终结性(对于正定二次函数,至 多n次迭代可达opt.) 对不同的βk 公式,对于正定二次函数是 相等的,对非正定二次函数,有不同的 效果,经验上PRP效果较好。

例子

例1

3 1 2 2 f ( x) ( x1 ) ( x2 ) x1 x2 2 x1 2 2

重新开始

N k=n?

y

x(1)=x(n+1) d(1)=-▽ f(x(1)),k=1

共轭梯度法的几种形式

k有下列三种等价形式:

f ( x ( k 1) )T f ( x ( k 1) ) k f ( x ( k ) )T f ( x ( k ) ) f ( x ( k 1) )T [f ( x ( k 1) ) f ( x ( k ) )] k f ( x ( k ) )T f ( x ( k ) ) f ( x ( k 1) )T f ( x ( k 1) ) k f ( x ( k ) )T d ( k ) (q1) FR法 (q 2) PRP法 (q3) 共轭下降法

四常用无约束最优化方法(精品PPT)

解 X k 1 ,f ( X k1 ) ,结束;否则,置 k k 1,转

(2).

,

最速下降法算法流程如图4.2所示.

Company Logo

最速下降法算 法流程如图所 示.

图4.2

开始 选定X0

f0 f (X0) g0 g(X0)

X ls(X 0 ,g0 )

Company Logo

§4.1 最速下降法

对于问题(4.1)为了求其最优解,按最优化算法的基

本思想是从一个给定的初始点

X

出发,通过基本迭代公

0

式 X k1 X k tk Pk,按照特定的算法产生一串

点列{X k } ,如果点列收敛,则该点列的极限点为问题

(4.1)的最优解.

一、最速下降法基本原理

1个迭代点

X

k

,即

1

X k1 X k tk f ( X k ) ,

其中步长因子 tk 按下式确定

也可记为

fin

t

f

(Xk

tf

(Xk

))

,

X k1 ls( X k , f ( X k )) . (4.3)

显然,令k 0, 1, 2, 就可以得到一个点列 X0, X1, X2 ,

g( X ) AX b ,(4.5)

因此,

gk g( X k ) AX k b.(4.6)

现在从X k 出发沿 g k 作直线搜索以确定 X k1 ,于是

X k1 X k tk gk , (4.7) 其中tk 是最优步长因子.

Company Logo

又因式(4.2),有 g( X k1 )T gk 0 ,再利用式

05工程优化第4章-1无约束最优化方法解析精品PPT课件

利用精确一维搜索,可得

' (k ) f (xk k d k )T d k 0

由此得出

f (xk ) d k

0=f (xk k d k )T d k =f (xk +1)T d k = (d k +1)T d k

最速下降法在两个相邻点之间的搜索方向是正交的。

最速下降法向极小点逼近是曲折前进的,这种现象称为锯齿 现象。

然后再从 x1 开始新的迭代,经过10次迭代,得最优解 x* (0, 0)T

计算中可以发现,开始几次迭代,步长比较大,函数值下 降将较快,但当接近最优点时,步长很小,目标函数值下降很 慢。

如果不取初点为 x0 (2, 2)T 而取 x0 (100, 0)T

令 f x 0, 即:

利用一阶条件 求驻点

利用二阶条件 判断驻点是否 是极小点

x12 x22

10 2x2

0

得到驻点: 1 1 1 1

x1

0

,

x2

2

,

x3

0

,

x4

2

.

无约束优化的最优性条件

函数 f x 的Hesse阵:

2

f

x

2x1 0

0

2x2

2

利用二阶条件 判断驻点是否 是极小点

假设 f 连续可微,

d k f (xk )

f

(xk

k d k )

min 0

f

(xk

பைடு நூலகம்

dk )

步长 k由精确一维搜索得到。

从而得到第 k+1次迭代点,即

xk1 xk +k d k xk kf (xk )

最速下降法 负梯度方向d k f (xk )是函数值减少最快的方向 ?

无约束最优化方法最速下降法牛顿法优秀课件

最速下降法至少具有线性的收敛速度,并且满足

下面的界:

f (xk1 )

f (x*)

( (

1) 2 1)2

(1 (1

n )2 n )2

[ f (xk )

f (x* )]

xk 1 x*

( 1)2 ( 1)2

最优解,f (x*) 0 ,2 f (xk ) 正定,Hesse矩阵 2 f (x) 满足Lipschitz条件:即存在 0 ,使 得对所有的i,j,有

2 f (x)(i, j) 2 f (y)(i, j) x y , x, y Rn

其中2 f (x)(i, j) 是Hesse矩阵2 f (x) 的 i, j 元素。

1 n

1 1

n n

2

xk

x*

第3.1节 最速下降法(Steepest Method)

[对于定理的说明] (1)在上面定理中,如果考虑的是如下一

般 n阶二对次称目正标定函矩数阵f,(x)则 12有xT类Gx似 b的T x证,明其方中法G证是 明定理同样成立。 (2)当目标函数是二阶连续可微的一致凸 函数时,由上章的推导可知,采用精确线 性搜索的最速下降法产生的迭代点列至少 是线性收敛的。

第3.1节 最速下降法(Steepest Method)

[引理3.4]设 k 0由精确线性搜索确定,

2 f (xk k dk ) M

对一切 0 均成立,其中M是某个正常数,

则有:

f (xk )

f (xk

k

dk

)

1 2M

f (xk ) 2 cos2

dk ,f (xk )

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

共轭梯度法的特点

全局收敛(下降算法);线性收敛; 每步迭代只需存储若干向量(适用于大 规模问题); 有二次终结性(对于正定二次函数,至 多n次迭代可达opt.) 对不同的βk 公式,对于正定二次函数是 相等的,对非正定二次函数,有不同的 效果,经验上PRP效果较好。

例子

例1

3 1 2 2 f ( x) ( x1 ) ( x2 ) x1 x2 2 x1 2 2

Rosenbrock function

拟Newton法(变尺度法)

统一的迭代格式

x

k 1

x B(k )f ( x )

k k

) 尺度矩阵 B(k是变化的,k=0时为单位矩阵I,k 趋向于无穷时极限为H-1,Hessen矩阵的逆。 尺度矩阵 B(k )满足如下的拟Newton方程 k 1 k k 1 k x x B(k 1)(f ( x ) f ( x )) B(k )的构造: (k 1) B(k ) E(k ) B B(k ) 的不同选取构成了不同的拟Newton方法族

综合使用最速下降法和Newton法

Goldstein-Price算法流程图(I)

给定r>0,0< ɗ < 1/2, Ii是单位阵的第I列,b0=r, k=1

f ( x k bk I i ) f ( x k ) Qi ( x k ) , i 1,...n bk bk r || ( x k ) ||, k 1, 2...,而 由下式给出 f ( x k),当k=0,或Qi ( x k )奇异或 f ( x k )T [Qi ( x k )]1 f ( x k ) 0 x k)= ( [Qi ( x k )]1 f ( x k ) ,否则

例子

例

3 1 2 2 f ( x) ( x1 ) ( x2 ) x1 x2 2 x1 2 2

算法对严格凸函数具有超线性收敛性 Q是Hessen阵的近似

共轭梯度法

共轭方向法具有二次收敛性。 如果能利用梯度来构造共轭方向,可以 预计算法更简便、收敛更快。 缺点是依赖于一维搜索的精度。

STOP.x(k+1)—l.opt

改进Newton法

ห้องสมุดไป่ตู้

限步长Newton法:

k 1 k 2 k 1 k

x x [ f ( x )] f ( x ) 其中选 ɘ 使f(xk+1) < f(xk) 从而不需要Hessen矩阵是正定的。 信赖域法 x k 1 x k [2 f ( x k ) I ]1 f ( x k )

最速下降法

沿着梯度方向,函数值改变最大 最速下降法:

x

k 1

x f ( x )

k * k k

* f ( x k k f ( x k )) min f ( x k k f ( x k ))

k 0

特点:全局收敛,线性收敛,易产生扭摆现象而 造成早停。(当x(k)距最优点较远时,速度快, 而接近最优点时,速度下降),现已较少单独 使用。

重新开始

N k=n?

y

x(1)=x(n+1) d(1)=-▽ f(x(1)),k=1

共轭梯度法的几种形式

k有下列三种等价形式:

f ( x ( k 1) )T f ( x ( k 1) ) k f ( x ( k ) )T f ( x ( k ) ) f ( x ( k 1) )T [f ( x ( k 1) ) f ( x ( k ) )] k f ( x ( k ) )T f ( x ( k ) ) f ( x ( k 1) )T f ( x ( k 1) ) k f ( x ( k ) )T d ( k ) (q1) FR法 (q 2) PRP法 (q3) 共轭下降法

共轭梯度法流程图

x(1), ε >0 d(1)=-▽ f(x(1)),k=1

k=k+1 ||▽ f(x(k))||< ε? k=1

y

Stop.x(k)—解

N

解 min f(x(k)+λ d(k)) s.t. λ >0

得 λk x(k+1)=x(k)+λk d(k) 求β k d(k+1)= -▽ f(x(k+1))+β kd(k)

k

Lk Dk LT p g k k

k

k

k 1

二次型目标函数的Newton法

1 f ( x) x ' Ax b ' x c, A 0(正定),则 2 f ( x) A 2 极小点x*满足 Ax* b 0, 而在任意点x 0 , f ( x 0 ) Ax 0 b, 综合这两个方程,得 x* x 0 A1f ( x 0 ) 因此,Newton 法一步就能从任意初始点求得极小点。 例 f ( x1 , x2 , x3 ) ( x1 x2 x3 ) 2 ( x1 x2 x3 ) 2 ( x1 x2 x3 ) 2

k 2 k k

1

f(xk+1) < f(xk)

Newton法流程图

x(1), ε >0, k=1 k=k+1

实用中,判断 若▽2f(x(k)) 非正定时

▽2f(x(k)) S= -▽f(x(k)) 得 s(k) , x(k+1)=x(k)+s(k)

No || Yes

进行相应处理

s(k)

||< ε?

Goldstein-Price算法流程图(II)

f ( x k ) f ( x k ( x k )) g ( x k , ) f ( x k )T ( x k )

g ( x ,1)

k

n

取k满足 g ( x , k ) 1

k

y

k 1

如果||f(x k )|| ,迭代终止。否则x k+1 =x k k (x k )

最速下降法流程图

x(1), ε >0, k=1

k=k+1 || ▽f(x(k) ) ||< ε? No

Yes

stop. x(k) –解

d(k)= -▽f(x(k) )

解 min f(x(k)+λ d(k)) s.t. λ >0 得 x(k+1)=x(k)+λkd(k)

Goldstein-Price算法

多维最优化的Newton法

令梯度函数的线性化主部为0:

f ( x ) f ( x )( x x ) 0

k 2 k k

优点:具有二次终结性,收敛快 缺点:计算量大(求导数和解方程组) 要求Hessen 阵正定, Hessen 阵病态时 更糟糕;非下降算法不保证

x

k 1

x [ f ( x )] f ( x )

其中, 足够大使得上式中的逆矩阵存在。

改进Newton法

Gill-Murray方法:在 X 处 计算 g k f ( xk ) ,如果 g =0,停止,否则 Gk 2 f ( xk ),作强迫正定Cholesky分解 计算

k

k

Gk Lk Dk LT k

解方程组 得下降方向 p 从 X 出发沿方向 p 作一维搜索,得 X 。 Rosenbrock function