最速下降法求解这一无约束的最优化问题

Matlab中的最优化问题求解方法

Matlab中的最优化问题求解方法近年来,最优化问题在各个领域中都扮演着重要的角色。

无论是在工程、经济学还是科学研究中,我们都需要找到最优解来满足特定的需求。

而Matlab作为一种强大的数值计算软件,在解决最优化问题方面有着广泛的应用。

本文将介绍一些Matlab中常用的最优化问题求解方法,并探讨其优缺点以及适用范围。

一. 无约束问题求解方法1. 最速下降法最速下降法是最简单且直观的无约束问题求解方法之一。

其基本思想是沿着梯度的反方向迭代求解,直到达到所需的精度要求。

然而,最速下降法的收敛速度通常很慢,特别是在局部极小值点附近。

2. 共轭梯度法共轭梯度法是一种改进的最速下降法。

它利用了无约束问题的二次函数特性,通过选择一组相互共轭的搜索方向来提高收敛速度。

相比于最速下降法,共轭梯度法的收敛速度更快,尤其适用于大规模优化问题。

3. 牛顿法牛顿法是一种基于二阶导数信息的优化方法。

它通过构建并求解特定的二次逼近模型来求解无约束问题。

然而,牛顿法在高维问题中的计算复杂度较高,并且需要矩阵求逆运算,可能导致数值不稳定。

二. 线性规划问题求解方法1. 单纯形法单纯形法是一种经典的线性规划问题求解方法。

它通过在可行域内进行边界移动来寻找最优解。

然而,当问题规模较大时,单纯形法的计算复杂度会大幅增加,导致求解效率低下。

2. 内点法内点法是一种改进的线性规划问题求解方法。

与单纯形法不同,内点法通过将问题转化为一系列等价的非线性问题来求解。

内点法的优势在于其计算复杂度相对较低,尤其适用于大规模线性规划问题。

三. 非线性规划问题求解方法1. 信赖域算法信赖域算法是一种常用的非线性规划问题求解方法。

它通过构建局部模型,并通过逐步调整信赖域半径来寻找最优解。

信赖域算法既考虑了收敛速度,又保持了数值稳定性。

2. 遗传算法遗传算法是一种基于自然进化过程的优化算法。

它模拟遗传操作,并通过选择、交叉和变异等操作来搜索最优解。

遗传算法的优势在于其适用于复杂的非线性规划问题,但可能需要较长的计算时间。

最速下降法解题步骤

最速下降法(Steepest Descent Method)是一种数值优化算法,用于求解无约束优化问题的最小值。

下面是最速下降法的一般解题步骤:

1.定义目标函数:首先,需要明确要优化的目标函数。

这个函数通常表示为f(x),其中

x 是优化变量。

2.初始化起始点:选择一个合适的起始点x0,作为最速下降法的初始点。

3.计算梯度:计算目标函数在当前点的梯度,即∇f(x)。

这可以通过对目标函数进行偏

导数计算得到。

4.确定搜索方向:将梯度反向取负作为搜索方向d,即d = -∇f(x)。

5.确定步长:确定沿着搜索方向移动的步长,也称为学习率或步长因子。

常见的选择

方法有固定步长、线性搜索和精确线搜索等。

6.更新当前点:根据步长和搜索方向,更新当前点x,即x = x + αd,其中α 表示步

长。

7.判断终止条件:判断是否满足终止条件,可以是达到预定的迭代次数、目标函数值

变化很小或梯度变化很小等。

8.若不满足终止条件,则返回第3步,重新计算梯度,并重复3-7步骤,直到满足终

止条件。

最速下降法的关键在于选择合适的步长和搜索方向。

步长过大可能导致无法收敛,步长过小可能导致收敛速度慢。

搜索方向的选择应该保证在当前点能够使目标函数值下降最快。

需要注意的是,最速下降法可能会陷入局部最小值,而无法达到全局最小值。

为了克服这个问题,可以考虑使用其他优化算法,如共轭梯度法、牛顿法等。

用最速下降法求解无约束非线性规划问题

运筹学实习报告姓名: xxxxxxxxxx 学号: xxxxxxxxxxx 专业班级: xxxxxxxxxxxx 2 0 1 3年 7 月 0 4 日题目:用最速下降法求解无约束非线性规划问题 摘要:无约束最优化问题的求解方法分为解析法和直接法两大类。

解析法需要计算函数的梯度,其中最速下降法就属于解析法中的一种。

对于一个无约束非线性规划利用最速下降法求解,首先需要确定其优化方向,此优化方向应该选择为f 在当前点处的负梯度方向,利用一维搜索法找出沿此方向上的最小值及其对应点,此后将该点作为新的出发点重复上述过程,直到达到允许的误差为止。

本文通过理论的计算方法,进一步分析,最后用c++编程实现求出允许误差内的最优解。

此编程可用于计算符合下列形式的函数求最优解过程:f(x)=a[0]x1*x1+a[1]x2*x2+a[2]x1*x2+a[3]x1+a[4]x2+a[5]其中:a[i] (i=0,1,2,3,4,5) 为函数的系数。

本文以“ 李占利 主编,中国矿业大学出版社出版”的《最优化理论与方法》 第五章 “无约束最优化方法,5.1 最速下降法 ”例5—1为实例,首先利用上述迭代的方法,计算出各迭代点的函数值,梯度及其模。

然后应用c++语言编程,得到在精度范围内的精确最优解。

C++编程计算的最优解为 : T x x ]0329218.0,00823045.0[)3(*-==。

即转化为分数结果为:⎥⎦⎤⎢⎣⎡-==412432)3(*x x 。

满足精度要求的模为:1010736154.0||||)3(=<=εp 。

关键词:无约束非线性规划 解析法 最速下降法 梯度 模 最优解一、算法思想无约束最优化方法中的最速下降法首先需要确定其优化方向,此优化方向应该选择为f 在当前点处的负梯度方向,利用一维搜索法找出沿此方向上的最小值及其对应点,此后将该点作为新的出发点重复上述过程,直到达到允许的误差为止。

无约束常用优化方法

步长 ,作前进(或后退)试探.如试探成功(目

标函数值有所减小),则按步长序列

,加

大步长(注意每次加大步长都是由初始点算起),直

至试探失败(目标函数值比前一次的有所增加)时,

则取其前一次的步长作为沿这个坐标轴方向搜索的最

优步长,并计算出该方向上的终止点,而后以这个终

止点为始点再进行下一坐标轴方向的搜索,并重复上

处

显然 是二次函数,并且还是正定二次函数,所以 是凸函数且存在唯一全局极小点.为求此极小点,令

即可解得

即

(5.9)

对照基本迭代公式,易知,式(5.9)中的搜索方向

步长因子

方向

是直指点 处近似二次函数

的极小点的方向.此时称此方向为从点 出发的

Newton方向.从初始点开始,每一轮从当前迭代点出发,

沿Newton方向并取步长 的算法称为Newton法.

另外,共轭梯度法不要求精确的直线搜 索.但是,不精确的直线搜索可能导致迭代 出来的向量不再共轭,从而降低方法的效 能.克服的办法是,重设初始点,即把经过 n次迭代得到的Xn作为初始点重新迭代.

五、坐标轮换法

在坐标轮换法中,沿各个坐标轴方向进行一维搜索

时,常选用最优步长法或加速步长法.加速步长法从

初始点出发,沿搜索(坐标轴)方向先取一个较小的

三、共轭方向法

1、概念

通常,我们把从任意点

出发,依次沿某组共轭

方向进行一维搜索的求解最优化问题的方法,叫做共

轭方向法.

2、特点

• 一般地,在n维空间中可以找出n个互相共轭的方向,对于n元正 定二次函数,从任意初始点出发,顺次沿这n个共轭方向最多作n 次直线搜索就可以求得目标函数的极小点.这就是共轭方向法的 算法形成的基本思想.

最速下降法例题

最速下降法例题

最速下降法(Steepest Descent Method)是一种用于求解无约

束优化问题的数值方法,也称为最陡下降法或梯度下降法,其基本思

想是在每一次迭代中,选择当前点到目标函数值下降最快的方向进行

搜索,从而不断逼近极小值点。

下面,我们将通过一个简单的例题来

介绍最速下降法的应用。

假设有一个二次函数 f(x,y) = x^2 + 2y^2 - 2x - 8y + 8 ,

我们希望使用最速下降法求解该函数的极小值点。

首先,我们需要计

算该函数的梯度向量:

grad(f(x,y)) = (2x - 2, 4y - 8)

接着,我们随机选择一个初始点 (x0, y0) = (0, 0) ,并设置

一个精度要求ϵ = 0.001 。

然后,按照以下步骤进行迭代:

1. 计算当前点的梯度向量 grad(f(xk,yk)) ;

2. 计算当前点到极小值点的最速下降方向 dk = -grad(f(xk,yk)) ;

3. 沿着最速下降方向 dk 移动一定的步长 tk ,得到新的点 (xk+1,

yk+1) = (xk,yk) + tk*dk ;

4. 如果目标函数值的下降量Δk = f(xk+1,yk+1) - f(xk,yk) < ϵ,则停止迭代,否则返回步骤 1 。

通过不断迭代,最终可以得到该二次函数的极小值点(x,y) ≈ (1,2) ,函数值为f(x,y) ≈ 2 。

这就是最速下降法找到极小值点的

基本流程。

值得注意的是,最速下降法有时会因为其“最陡”下降方向不够

精准而表现出较慢或者振荡的特点,因此在实际应用中需要结合其他

优化算法来提高求解速度和准确性。

最速下降法原理及例题实例

−1 1

=

G

αk

=

g1d1 + g2d2 3d12 + d22 − 2d1d2

[ ] [ ] 取 X (1) = (0, 0)T ,则 ∇f ( X (1) ) = −2, 0 T ,所以 d (1) = −∇f ( X (1) ) = 2, 0 T ,

因此

α1

=

22 3× 22

=

1 3

[ ] [ ] X (2) = X (1) + α1d (1) =

=

1 + 4x1 + 2x2 −1+ 2x1 + 2x2

∂(x2 )

∇f

(X

(1) )

=

1 −1

令搜索方向 d (1)

=

−∇f

(X

(1) )

=

−1 1

再从

X

(1) 出发,沿

d (1) 方向作一维寻优,令

步长变量为 λ

,最优步长为 λ1 ,则有

X

(1)

+

λd (1)

=

0 0

+

λ

−1 1

min f ( X ) = (x1 − 2)4 + (x1 − 2x2 )2

其中 X = (x1, x2 )T ,要求选取初始点 X 0 = (0, 3)T ,终止误差 ε = 0.1.

解:因

∇f ( X ) = [4(x1 − 2)3 + 2(x1 − 2x2 ), −4(x1 − 2x2 )]T

∇f (x∗ ) = 0源自(二)最速下降法的基本思想和迭代步骤

最速下降法又称为梯度法,是 1847 年由著名数学家 Cauchy 给出的。他是解析法中最古老的一 种,其他解析方法或是它的变形,或是受它的启发而得到的,因此它是最优化方法的基础。

最速下降曲线

最速下降曲线最速下降曲线是最大似然估计的一种重要形式,它可以在极少的计算代价下尽可能快地求出最大似然参数。

它是一种具有普适性的方法,用于估计未知的参数,广泛应用于统计学、机器学习、模式识别和深度学习中。

最速下降曲线也被称为梯度下降法,它的目的是用来求解无约束的最优化问题,它是根据梯度方法而得到的一种算法。

梯度方法是在求解最优化问题时通常使用的一种方法,它可以在非线性函数中有效地求解最优化问题。

最速下降曲线是基于梯度下降方法得到的,它可以有效地求解最大似然估计。

最大似然估计就是要从一堆测量数据中发现未知概率过程的参数,这些参数可以用于描述概率过程。

最大似然估计的结果可以用最速下降曲线来表示,最速下降曲线的直线是梯度的反方向,即最大似然估计的梯度方向。

最速下降曲线是基于梯度下降方法,梯度下降方法是求解无约束最优化问题的一种算法,它是基于参数的梯度(偏导数),而最速下降曲线是一条梯度下降曲线,它的方向是最大似然估计的梯度的反方向。

最速下降曲线的目的是找到最大似然参数,即求解最大似然参数,它把最大似然目标函数变换为一个凸函数,通过最速下降曲线,可以以最小的代价求出最大的似然参数。

在实际应用中,最速下降曲线可以用来估计参数,主要用于最大似然估计和贝叶斯估计,它们都是用来解决参数估计问题的有效方法。

最速下降曲线也被广泛应用于统计学、机器学习、模式识别和深度学习等领域,它可以非常快速准确地估计出参数,对于求解复杂问题,最速下降曲线可以提供有效的优化方法。

综上所述,最速下降曲线是一种重要的统计方法,用来估计参数,它在机器学习、模式识别、深度学习和统计学等领域都有着重要的作用,它的主要目的是求解最大似然参数,可以以最小的代价求出最大似然参数。

最速下降曲线的优点是求解时间短,精度高,可以非常有效的求解复杂的优化问题,它有助于提高估计模型的精度。

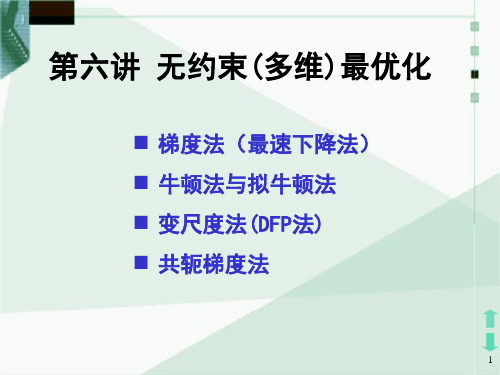

最优化方法第六讲 无约束(多维)最优化

step4. 若 || f ( xk1) || ,停止,x* xk1 ;

否则,令 k : k 1, 转step 2 。

14

➢算法框图

给定初始点x0和精度 || f ( x0 ) ||

停止,输出x1

否

是

| x1 x0 |

是 停止,输出x0

否 否

2 f (x0) 0

计算x1

x0

f ( x0 ) 2 f (x0)

1

13 62

x2

x1

1d 1

(

36 , 31

8 31

)T

7

三、最速下降法的特点

1.性质. 设 f ( x) 有一阶连续偏导数,若 步长 满足 k

f ( xk d k ) min f ( xk d k )

k

则有 f ( xk d k )T d k 0。 k

证明:令 ( ) f ( xk d k ),所以

5

一、梯度法(最速下降法):

1. 搜索方向:d k f ( xk ) ,也称为最速下降方向;

2. 搜 索 步 长: k 取 最 优 步 长, 即 满 足

f (xk

kd k )

min

f

(xk

d k ) 。

二、梯度法算法步骤:

1. 给定初始点 x1 Rn ,允许误差 0, 令k 1。

2. 计算搜索方向 d k f ( xk ) ;

Step3. 令 xk 1 xk kd k , 其中tk : f ( xk kd k ) min f ( xk d k )。

24

Step 4. 判断 xk 1 是否满足终止准则: yes: 计算 stop, 则x* : xk1

No : 转 step 5 。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

第五题:

解:选择类型为:

2/13()x t

y t x e

x =+

其中123,,x x x 是待求参数。

根据最小二乘原理,参数123,,x x x 是下面优化问题的解。

[]2

8

1231

m in (,,)()i i i f x x x y t y ==

-å

用最速下降法求解这一无约束的最优化问题。

zuiyouhua.m

function sh=zuiyouhua(x0) % x0为初始猜测值 syms x y z a al;

%====================================== t=[0.2,1,2,3,5,7,11,16];

r1=[5.05,8.88,11.63,12.93,14.15,14.73,15.30,15.60]; minf=0; for i=1:8

r(i)=x*exp(y/t(i))+z-r1(i); %构造最小二乘最优化的目标函数 minf=r(i)^2+minf;

end

%====================================== f1=diff(minf,x); f2=diff(minf,y);

f3=diff(minf,z); %求目标函数的梯度 F=[f1,f2,f3];

%====================================== Fx1= -subs(F,{x,y,z},x0); Fx=Fx1/norm(Fx1); k=0;

%====================================== %最速下降法核心迭代程序 while 1 x1=x0+a*Fx;

P=subs(minf,{x,y,z},x1);

xx1=xianxing(P); %调用线性搜索函数 al=huangjing(P,xx1); %调用黄金分割法函数; x0=x0+al*Fx;

Fx1= -subs(F,{x,y,z},x0); Fx=Fx1/norm(Fx1); if norm(Fx1)<5e-4 sh=x0;

return; end end

%====================================== function xx=xianxing(Pa) %一维搜索法线性搜索函数 aa=findsym(Pa); a1=1; h=0.5; k=0; t1=2; while 1 a2=a1+h;

Pa1=subs(Pa,aa,a1); Pa2=subs(Pa,aa,a2); if Pa2< Pa1 h=t1*h; a0=a1; a1=a2; k=k+1;

if k>1000

disp('迭代步数太多,可能不收敛!'); end else if k==0 h=-h; a0=a2; else

c1=min(a0,a2); d1=max(a0,a2); xx=[c1,d1]; return; end end

end

%====================================== function al1=huangjing(Pb,xx2)

%黄金分割法函数 ab=findsym(Pb); c=xx2(1); d=xx2(2);

lamda=0.618;

eps1=1e-3; u=d-lamda*(d-c); v=c+lamda*(d-c); N=1000; pu=subs(Pb,ab,u); pv=subs(Pb,ab,v); for K=1:N

if abs(v-u)<eps1 g=(u+v)/2; al1=g; return; end

if pu <= pv c=c; d=v; v=u; pv=pu;

u=d-lamda*(d-c); pu=subs(Pb,ab,u); else c=u; d=d; u=v; pu=pv;

v=c+lamda*(d-c); pv=subs(Pb,ab,v); end if K==N

disp('迭代次数过多,不收敛!'); end end

%==================================== >> x0=[0,0,0]; >> zuiyouhua(x0) ans =

11.3459 -1.0730 4.9972

所以:

12311.3459, 1.0730, 4.9972x x x ==-=

%=====================================================================================

画图程序:

x=[11.3459,-1.0730,4.9972];

tdata=[0.2,1,2,3,5,7,11,16];

ydata=[5.05,8.88,11.63,12.93,14.15,14.73,15.30,15.60];

f=x(1)*exp(x(2)./tdata)+x(3); plot(tdata,ydata,'o',tdata,f,'r-')

计算所得得图为:。